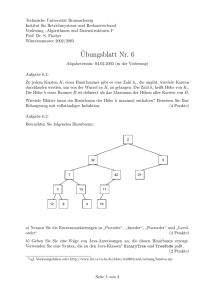

Datenstrukturen und Algorithmen in C/C++

Werbung