ComplettiumDB1.7 - Downloads für den Studiengang WI

Werbung

DB-ZWO

zusammengefasst von

Felizitas Ottemeier,

Christian Pfeiffer

1

Inhalt

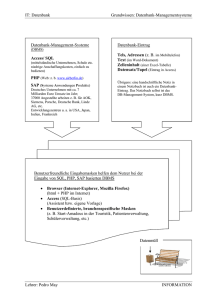

1. DATENBANKEN – WOZU? ............................................................................................... 9

Geschichtliche Entwicklung:................................................................................................................. 9

Einsatzarten: .......................................................................................................................................... 9

Anforderungen seit der relationalen Phase: ...................................................................................... 10

Anforderungen an Relationale Datenbank Management Systeme ................................................. 10

Standardisierungen: ............................................................................................................................ 11

Entwicklungen (RDBMS): .................................................................................................................. 11

Begriffe: ................................................................................................................................................ 12

Retrieval: Wiedergewinnung / Wiederherstellung von Daten ........................................................... 12

2. DATENBANKMODELLE ................................................................................................. 13

Das hierarchische Modell: ................................................................................................................... 13

IMS ........................................................................................................................................................ 14

Die ANSI/SPARC – Architektur: ....................................................................................................... 16

Datenbank – Administrator (DBA) .................................................................................................... 18

Tupel-Identifier .................................................................................................................................... 21

Cluster ................................................................................................................................................... 22

Index ...................................................................................................................................................... 22

Index über Feldkombinationen .......................................................................................................... 23

Pointerketten ...................................................................................................................................... 24

Der Optimierer (Optimizer)................................................................................................................ 27

Datenkompression.............................................................................................................................. 30

Speicherung von Daten (Beispiel: MS SQL Server) ........................................................................ 31

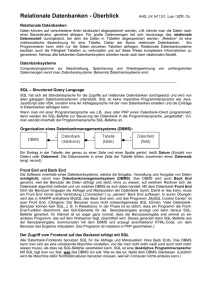

3. RELATIONALE DBMS .................................................................................................... 32

Anforderungen ..................................................................................................................................... 32

Basisregeln ............................................................................................................................................ 33

Strukturregeln: .................................................................................................................................... 34

Manipulationsregeln ............................................................................................................................ 34

2

Integritätsregeln ................................................................................................................................... 35

SQL Standard....................................................................................................................................... 35

Entry-Level, ....................................................................................................................................... 35

Intermediate-Level ............................................................................................................................. 35

Full-Level. .......................................................................................................................................... 35

Aufteilung der Dokumentation: ......................................................................................................... 36

SQL92 ................................................................................................................................................ 36

SQL Standard ..................................................................................................................................... 36

Sprachelemente: ................................................................................................................................. 37

Datenbankstruktur: ............................................................................................................................. 38

Zeichensätze:...................................................................................................................................... 40

Constraints: ........................................................................................................................................ 40

DDL - Data Definition Language: ..................................................................................................... 42

permamente Tabellen (Basis-Tabellen): ............................................................................................ 45

Entzug von Rechten: .......................................................................................................................... 49

DML – Datenretrieval: ....................................................................................................................... 51

DCL - Datenkontrolle ........................................................................................................................ 53

Transaktionen ..................................................................................................................................... 53

Besonderheiten von DB2 ..................................................................................................................... 55

Besonderheiten von Oracle ................................................................................................................. 55

4. SCHNITTSTELLEN.......................................................................................................... 56

Grundlagen:.......................................................................................................................................... 57

Schnittstellen - Cursor-Konzept:........................................................................................................ 57

Schnittstellen – Status: ....................................................................................................................... 60

Schnittstellen - Indikator-Variable:.................................................................................................... 62

Schnittstellen - Module-Schnittstelle: ................................................................................................ 63

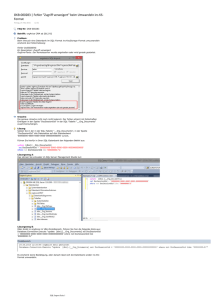

Embedded SQL .................................................................................................................................... 65

konkretes Beispiel: ............................................................................................................................. 65

Embedded SQL Beispiel: ................................................................................................................... 65

Aufgaben des Precompilers: .............................................................................................................. 67

Ausnahmebedingungen: ..................................................................................................................... 69

Statische SQL-Anweisungen:.............................................................................................................. 70

Vorteile: ............................................................................................................................................. 70

Dynamisches SQL: ............................................................................................................................... 72

Problem: einmaliger Zugriff oder wiederholter Zugriff?................................................................... 72

CLI: ....................................................................................................................................................... 76

Sprach- und DBMS-unabhängige Schnittstelle von Prozeduraufrufen ............................................. 77

Nachteile gegenüber Embedded SQL: ............................................................................................... 77

Typische Verarbeitung: ...................................................................................................................... 78

Initialisierung: .................................................................................................................................... 78

Noch ein Beispiel: .............................................................................................................................. 79

Transaktionsverarbeitung:.................................................................................................................. 80

Terminierung: .................................................................................................................................... 80

3

Innerhalb der Transaktionsverarbeitung: ........................................................................................... 81

ODBC .................................................................................................................................................... 82

JDBC = Java Data Base Connectivity ................................................................................................ 82

Vorteile Java im Hinblick auf Vereinfachung der Anwendungsentwicklung: .................................. 82

Eigenschaften von Java: ..................................................................................................................... 83

Anbindungsmöglichkeiten an (relationale) Datenbanken:................................................................. 83

JDBC besteht aus Klassen und Interfaces. Die wichtigsten sind: ...................................................... 84

Schritte zur Verbindung JDBC und DB............................................................................................. 84

JDBC 2.0 ............................................................................................................................................... 94

java.sql .................................................................................................................................. 94

javax.sql ............................................................................................................................... 98

5. OPTIMIERUNG .............................................................................................................. 102

Optimierung eines Knotens ............................................................................................................... 102

Installation des DBMS ..................................................................................................................... 102

Bereitstellung von physischem Speicherplatz ................................................................................. 104

Denormalisierung ............................................................................................................................. 104

Partitionierung von Tabellen............................................................................................................ 105

Clustern ............................................................................................................................................ 105

Indexierung ...................................................................................................................................... 106

Knotenübergreifend ........................................................................................................................... 106

Verteilung ........................................................................................................................................ 106

Replikation ....................................................................................................................................... 107

6. DATENBANKEN ENTWURF ......................................................................................... 108

1. Analyse ............................................................................................................................................ 109

2. Konzeptuelle Phase ........................................................................................................................ 112

Redundanzen und Anomalien: ......................................................................................................... 112

Funktionale Abhängigkeiten: ........................................................................................................... 113

Normalformen: ................................................................................................................................. 114

ER-Modell: ...................................................................................................................................... 117

Objektorientierung ........................................................................................................................... 119

3. Logischer Entwurf ......................................................................................................................... 123

4. physikalischer Entwurf ................................................................................................................. 123

Entwurf und Integration ................................................................................................................... 124

Phase 2: Zusammenführung der Teilmodelle .................................................................................. 124

7. SYNCHRONISATION UND REPLIKATION................................................................... 128

Gründe für die Schaffung eines verteilten Informationssystems sind: ......................................... 128

Probleme bei verteilten Informationssystemen: ............................................................................. 129

Auf Grund der Probleme bei verteilten Informationssystemen gilt: ................................................ 129

4

Transaktion ........................................................................................................................................ 129

Anschauliche Darstellung: .............................................................................................................. 130

Globale Transaktionsunterstützung: ................................................................................................ 130

Zwei-Phasen-Commit ...................................................................................................................... 130

Synchronisation .................................................................................................................................. 134

Verlorene Änderungen (lost updates): ............................................................................................. 134

Schmutziges Lesen (dirty read): ...................................................................................................... 134

Inkonsistentes Lesen (inconsistent reads): ....................................................................................... 134

Lesen von Phantomen (phantom reads): .......................................................................................... 134

Sperrverfahren.................................................................................................................................. 135

Zwei-Phasen-Sperrprotokoll ............................................................................................................ 136

Zeitstempelverfahren ....................................................................................................................... 137

Optimistische Synchronisationsverfahren ....................................................................................... 138

Replikation.......................................................................................................................................... 141

Korrektheit ....................................................................................................................................... 142

Replikationsverfahren ...................................................................................................................... 142

Oracle: .............................................................................................................................................. 146

DB2: ................................................................................................................................................. 147

8. DRDA: DISTRIBUTED RELATIONAL DATABASE ARCHITECTURE ......................... 149

RDA (Remote Database Access) (ISO, ANSI-Standard Komitee) ................................................ 149

Remote Database Access RDA ........................................................................................................ 149

DRDA unterstützt unter anderem .................................................................................................... 150

Application Requester ...................................................................................................................... 150

Application Server ........................................................................................................................... 150

Kommunikation zwischen Application Requester und Application Server .................................... 151

Database Server ............................................................................................................................... 151

Rückgabe nach kompletter Bearbeitung der Anforderung .............................................................. 152

Limited Block Protocol: ................................................................................................................... 152

Es gibt noch weitere Standards, auf denen DRDA aufsetzt: ........................................................... 152

DRDA bietet 5 unterschiedliche Ebenen für die Unterstützung von Verteilung ............................. 153

Übersicht über die DRDA-Ebenen .................................................................................................. 153

DRDA Managers ............................................................................................................................. 153

SNA- bzw. TCP/IP-Manager ........................................................................................................... 154

Agent ................................................................................................................................................ 154

Supervisor ........................................................................................................................................ 154

Security Manager ............................................................................................................................. 154

Directory .......................................................................................................................................... 154

Dictionary ........................................................................................................................................ 154

Resynchronization Manager ............................................................................................................ 154

Sync Point Manager ......................................................................................................................... 154

SQL Application Manager ............................................................................................................... 154

Relational Database Manager .......................................................................................................... 155

DRDA Kommando-Fluss................................................................................................................. 155

Distributed Database: viel Aufwand und wenig Nutzen COMPUTERWOCHE Nr. 50 vom

16.12.1994 ......................................................................................................................................... 156

9. DATAWAREHOUSE ...................................................................................................... 159

5

Stärken und Schwächen Data Warehouse ....................................................................................... 159

Woher kommt der Ansatz? ............................................................................................................... 160

Mögliche Aus- und Aufgaben eines DSS sind z.B.: ........................................................................ 160

Wie ist der Zusammenhang zwischen Datenbanken und DSS zu sehen? ....................................... 160

Datenbank (Data Warehouse) mit folgenden Eigenschaften: ........................................................ 161

OLAP vs. OLTP ................................................................................................................................. 161

Vergleich OLTP - Data Warehouse ................................................................................................. 162

OLTP .................................................................................................................................. 162

DATA WAREHOUSE ......................................................................................................... 162

Generelle Struktur ............................................................................................................................. 164

Entwurf eines Data Warehouse ........................................................................................................ 164

Betrieb eines Data Warehouse .......................................................................................................... 165

Was ist eine Data Mart? ................................................................................................................... 166

Gründe für Data Marts ..................................................................................................................... 166

Probleme .......................................................................................................................................... 166

Typische Methoden beim Einsatz eines RDBMS ............................................................................ 166

Laden eines DataWareHouse ............................................................................................................ 167

Ueberlegungen hinsichtlich der Einführung von Redundanz ....................................................... 167

STAR-Schema .................................................................................................................................... 167

SNOWFLAKE-Schema:.................................................................................................................... 169

Multidimensionale Datenbanken (typisch unter Einbeziehung der Zeit) .................................... 171

MOLAP: multidimensionale DBS ............................................................................................... 171

ROLAP: relationales DBS .......................................................................................................... 171

Multidimensionale Daten: ................................................................................................................. 173

Spezielle multidimensionale Datenbank-Architektur ...................................................................... 173

RDBMS mit Aufsatz ........................................................................................................................ 174

Anlegen und Laden eines Data Warehouses vom OLTP ............................................................... 174

SQL-Anweisungen während off-Zeit des OLTP ............................................................................. 175

Snapshot ........................................................................................................................................... 175

Log sniffing ...................................................................................................................................... 175

Insert-, Update-, Delete-Trigger ...................................................................................................... 175

spezielle Data Extract Programme während off-Zeit des OLTP ..................................................... 176

10. OBJEKT-RELATIONALE DBMS ................................................................................. 177

Was sind objekt-relationale Datenbanken ??? ................................................................................. 177

Wieso braucht man objekt-relationale Datenbanken ??? ................................................................. 177

6

Was ist so toll an objekt-relationalen DBMS ??? ............................................................................ 177

Wie wird das umgesetzt ??? ............................................................................................................. 177

OODB-Manifesto: .............................................................................................................................. 178

notwendige Anforderungen ............................................................................................................. 178

optionale Anforderungen ................................................................................................................. 178

Erweiterung von RDBMS ................................................................................................................. 179

Beispiel Oracle 8 .............................................................................................................................. 179

SQL3-Standard: ............................................................................................................................... 179

Einordnung von Oracle8 .................................................................................................................. 179

User-Defined Datatypes (UDT): ....................................................................................................... 180

Object Types - Objekttypen .............................................................................................................. 180

Object Types - Vereinbarung: .......................................................................................................... 180

Object Types in Tabellen ................................................................................................................. 181

Verwendung Abstrakter Datentypen bei der Einrichtung eines komplexen Objekttyps ... ............. 181

Methoden für Objekttypen ............................................................................................................... 183

Einsatz von Methoden...................................................................................................................... 184

Get- und Set-Methoden .................................................................................................................... 184

Vergleichsmethoden ........................................................................................................................ 184

Kollektionstypen .............................................................................................................................. 185

Referenzen ....................................................................................................................................... 185

noch ausstehend auf dem Wege zur Objektorientierung: ................................................................ 186

11. OBJEKT-ORIENTIERTE DBMS .................................................................................. 187

Definition eines OODBS .................................................................................................................... 189

OOPL OODBS ............................................................................................................................ 190

System-Eigenschaften eines OO-DBMS .......................................................................................... 190

Persistenz ............................................................................................................................................ 191

Nebenläufigkeit .................................................................................................................................. 192

Transaktionen, Concurrency Control ............................................................................................... 192

Das OODBMS POET ........................................................................................................................ 197

Datenbankmodell: ............................................................................................................................ 197

Anfragen: ......................................................................................................................................... 197

Weitere Komponenten: .................................................................................................................... 198

Poet in Form von Beispielen ............................................................................................................ 198

Das OODBS Versant.......................................................................................................................... 203

Grundprinzip: ................................................................................................................................... 203

Datenbankmodell: ............................................................................................................................ 203

Schema-Evolution: ........................................................................................................................... 203

Schnittstellen und Werkzeuge: ........................................................................................................ 203

Weitere Komponenten: .................................................................................................................... 204

Versant ............................................................................................................................................. 204

Versant "Architektur" ...................................................................................................................... 204

Performance ..................................................................................................................................... 205

7

Availability ...................................................................................................................................... 205

Flexibilität ........................................................................................................................................ 205

Installationsvoraussetzungen ........................................................................................................... 205

Persistenz hinzufügen: ..................................................................................................................... 209

Datenbank anlegen: .......................................................................................................................... 210

Übersetzen und Ausführen:.............................................................................................................. 210

Was passiert bei einer Referenz? ..................................................................................................... 211

Verändern von Objekten: ................................................................................................................. 212

Schemaveränderungen ..................................................................................................................... 215

Default Locking Strategie: ............................................................................................................... 216

12. GLOSSAR .................................................................................................................... 219

Cluster .............................................................................................................................................. 219

Commit ............................................................................................................................................ 219

Datenbank ........................................................................................................................................ 219

Datenbanksystem ............................................................................................................................. 219

DCL.................................................................................................................................................. 219

DDL ................................................................................................................................................. 219

Dirty Read, Dirty Write ................................................................................................................... 219

DML................................................................................................................................................. 220

EOT .................................................................................................................................................. 220

Hashing ............................................................................................................................................ 220

Index ................................................................................................................................................ 220

JDBC ................................................................................................................................................ 220

Katalog ............................................................................................................................................. 220

Knoten .............................................................................................................................................. 220

Kreuzprodukt (zweier Tabellen) ...................................................................................................... 220

Objektorientiertes Datenbanksystem ............................................................................................... 220

Objekt-relationales Datenbanksystem ............................................................................................. 221

ODBC .............................................................................................................................................. 221

Replikation ....................................................................................................................................... 221

Transaktion ...................................................................................................................................... 221

Trigger.............................................................................................................................................. 221

Verklemmung, Deadlock ................................................................................................................. 221

Verteiltes DBMS .............................................................................................................................. 221

Virtuelle Tabelle .............................................................................................................................. 221

Vorübersetzer / Precompiler ............................................................................................................ 222

Zwei-Phasen-Commit ...................................................................................................................... 222

8

1. Datenbanken – Wozu?

Geschichtliche Entwicklung:

Datei – System: In einem Dateisystem ist die Struktur des Programms eng mit der

Datenstruktur verknüpft. Dadurch entsteht sich logische Datenabhängigkeit.

Daraus folgt, dass bei Änderung an den Strukturen einer Datei sämtliche Programme, die

mit dieser Datei arbeiten, geändert, bzw. neu programmiert werden müssen.

Z.B. Änderung an einer Artikel – Datei.

Eine Abteilung benötigt bestimmte Daten eines Artikels, die bislang noch nicht in der

Artikeldatei vorhanden sind. Dazu muss diese geändert werden.

Allerdings müssen auch ebenso alle Programme die auf diese Datei zugreifen geändert

werden, auch wenn sie die neuen Daten nicht benötigen.

Ebenso müssen sämtliche Programme geändert werden, wenn die Art der Speicherung der

Daten geändert werden soll oder bei Einführung neuer Hardware.

physikalische Datenabhängigkeit

Zur Wahrung der Konsistenz der Daten sind Abgleichprogramme eingesetzt worden, die die

Daten überprüft haben.

Prä-relationale DBMS: invertierte Listen, hierarchische DBMS, Netzwerk DBMS

Relationale DBMS: DB2, Oracle, MySQL, MSSQL ...

Post-Relationale DBMS: Objekt-Relational, Objekt-Orientiert

Einsatzarten:

- "traditionelle" Einsatzarten: kleine bis mittlere Komplexität der Datenstruktur,

geringe Transaktionsrate,

kleines bis mittleres Transaktionsvolumen,

kleines bis großes Datenvolumen,

"formatierte Daten"

Beispiele: Lagerhaltung, Personalverwaltung, Geschäftsvorgänge

- "neue" Anwendungen: mittlere bis hohe Komplexität der Datenstruktur,

viele lesende Zugriffe pro Zeiteinheit:

Datenvolumen oder Zahl der lesenden Transaktionen

geringe schreibende Transaktionsrate,

sehr geringes Transaktionsvolumen,

mittleres bis sehr großes Datenvolumen

Beispiele: Data Warehouse, Web-Anwendungen

geringe bis mittlere Komplexität der Datenstruktur,

geringe lesende Zugriffe pro Zeiteinheit,

extrem hohe Transaktionsraten,

extrem hohes Transaktionsvolumen,

mittleres bis sehr großes Datenvolumen

Beispiele: Daten für Energieversorger, Daten für Telefonabrechnung (insb. Handy)

9

geringe bis sehr hohe Komplexität der Datenstruktur,

geringe lesende Zugriffe pro Zeiteinheit,

geringe Transaktionsraten,

ggf. sehr lange Transaktionsdauern,

extrem hohes Transaktionsvolumen,

mittleres bis sehr großes Datenvolumen

Beispiele: Dokumentenretrieval-Systeme, CAD/CAMSysteme, geographische Datenbanken

Anforderungen seit der relationalen Phase:

Programmierung unabhängig von Datenhaltung

Adressierung logisch über Eigenschaften

Sichern der Integrität

Kontrolle der Zugriffe

Transaktionsunterstützung

Backup und Recovery

Verteilung

Anforderungen an Relationale Datenbank Management Systeme

Anforderungen nach Codd:

Basis Regeln:

Daten werden in Tabellenform dargestellt

jeder gespeicherte Wert ist logisch durch die Kombination von Tabellenname,

Primärschlüssel und Spaltenname erreichbar

Der Null – Wert wird unterstützt, er ist von allen anderen Werten verschieden

Der Systemkatalog (Data-Dictionary) ist wie alle anderen Daten auch in Tabellen

gespeichert

es muss eine Datenbank-Sprache geben, die

Datendefinition

Datenmanipulation

Datenretrieval

Integritätsbeschränkungen

Autorisierungen

Transaktionen

unterstützt.

theoretisch änderbare virtuelle Tabellen müssen auch vom System geändert werden

Relationen können als Operanden behandelt werden

Anwendungsprogramme

bleiben

logisch

unberührt

von

Änderung

der

Datenspeicherung

Anwendungsprogramme bleiben logisch unberührt von Änderung der Datenstruktur

Integritätsregeln werden in relationaler DB-Sprache definiert und im Systemkatalog

gespeichert. Das DBMS überwacht sie eigenständig und unabhängig vom

Anwendungsprogramm

Das DBMS ist verteilungsunabhängig

10

falls eine "low level" – Schnittstelle existiert, können damit nicht Integritäts- und

Autorisierungsregeln umgangen werden

Strukturregeln:

Beziehungen zwischen Feldern und Tabellen nur über benannte Spalten und

unnummerierte Zeilen

alle gespeicherten Daten sind in Basistabellen enthalten

Ergebnis einer Abfrage ist wiederum eine Tabelle

Daten einer virtuellen Tabelle werden bei Ausführung dynamisch erzeugt

gespeicherte Tabellenkopien erhalten einen Eintrag im Katalog

das Konzept der Domänen wird unterstützt

jede Tabelle hat einen Primärschlüssel

stammt eine Spaltenkombination aus der gleichen Domäne, wie der Primärschlüssel

einer anderen Tabelle, so handelt es sich um einen Fremdschlüssel zu der Tabelle

Manipulationsregeln:

folgende Operationen werden zumindest unterstützt:

Selektion von Zeilen bezüglich Vergleichsoperatoren = /<= / >= / < / > / <>

Projektion auf Spalten

Join von Tabellen / Outer Join

Division

Mengenorientierte Operationen (Union, Intersect, set Difference)

Integritätsregeln:

Primärschlüssel darf nicht Null sein

für jeden Fremdschlüssel, der nicht Null ist, muss ein Primärschlüssel existieren

Anwendungsbezogene Integritätsregeln müssen in der DB-Sprache unterstützt und im

Systemkatalog eingetragen werden

Standardisierungen:

CODASYL

ANSI/SQL, ISO

NIST

X/Open

ODMG

Entwicklungen (RDBMS):

Trigger

Verteilung

Objekt – Relational

11

Begriffe:

virtuelle Tabelle: Views werden aus existierenden Basis – Tabellen abgeleitet. Das

System trägt die Eigenschaften eines Views in die Systemtabellen ein. Lediglich die Einträge

in Systemtabellen existieren physisch von einem View, deshalb werden Views auch virtuelle

Tabellen genannt.

Domäne: Attribute beziehen ihre Werte aus abgegrenzten Wertebereichen, die Domänen

gennnt werden, z.B. ganze Zahlen / Boolean usw.

Diese Wertebereiche lassen sich eingrenzen / einschränken, z.B. Notenwerte (1.0, 1.3, 1.7,

2.0, ..., 5.0).

Projektion: Bei der Projektion wählt man aus der relationalen Struktur einer Relation nur

einige, besonders interessante Attribute aus (die Tabelle wird auf wenige, besonders

interessante Spalten beschränkt). Man kann mit der Projektion aber auch die Struktur einer

Tabelle durch umsortieren verändern.

Die Auswahl der Spalten in einer Select-Anweisung wird "Projektion" und die Auswahl der

Reihen "Selektion" genannt.

Retrieval: Wiedergewinnung / Wiederherstellung von Daten

low-level-Schnittstelle: Unterscheiden muss man zwischen Low-Level- und HighLevel-Schnittstellen. ODBC, OLEDB und ADO.NET bieten Low-Level-Techniken mit

direktem Zugriff auf die Schnittstellen der Datenbank. Jeder dieser drei Low-LevelTechniken verwendet ein Treiber-Konzept, um auf eine Vielzahl von Datenbanken

zugreifen zu können.

Diese Treiber heißen:

- ODBC Driver für ODBC

- OLEDB Provider für OLE DB

- Managed Data Provider für ADO.NET (.NET Data Provi-der)

High-Level-Schnittstellen

RDO, DAO und ADO sind High-Level-Schnittstellen, die auf den Low-LevelSchnittstellen basieren. Die Remote Data Object (RDO) und die Data Access Objects

(DAO) gelten dabei als veraltert.

12

2. Datenbankmodelle

Das hierarchische Modell:

Im hierarchieschen Modell nimmt der Benutzer die Daten hierarchisch wahr. Die Daten

haben eine hierarchische Beziehung untereinander. Eine hierarchische Struktur lässt sich in

Form eines Baumes darstellen.

Die Eigenschaften des hierarchischen Modells sind:

- es ist zyklenfrei

- es gibt genau einen speziellen Knoten, die Wurzel. Dieser Knoten hat keinen

Vorgänger

- jeder andere Knoten hat genau einen Vorgänger

Definition des hierarchischen Modells:

- es gibt eine Menge benannter Entitätstypen (Segmente) und eine Menge von

unbenannten Beziehungen.

- Jede Entität (Segment Occurence) gehört zu einem Entitäts-Typ

- Alle Entitäten innerhalb der Datenbankstruktur sind total (hierarchisch) geordnet

- Jede Entität ist nur über das Wurzelsegment erreichbar

Beispiel: Modellierung Student

Problem: 1. Ebene Student oder Prüfung?

Entscheidung für die Ebenen:

1. Student mit Matrikelnummer, Name, Anschrift

2. Grundstudium - Hauptstudium

3. Fächer mit Nr., Dozent, Semester, Ergebnis

Besonderheiten im Hauptstudium: Projekt, Arbeit, Kolloquium

in IMS Strukturbeschreibung in Assembler-Datei

durch die Übersetzung werden ausführbare Dateien und Bibliotheken erzeugt:

zum physischen Anlegen der Datenspeicher

zum Erzeugen von Zugriffsmethoden,

mit deren Hilfe kann aus einem Programm heraus auf die Daten

zugegriffen werden

13

graphische Darstellung

IMS

Kurzbeschreibung der DB-Struktur von IMS

IMS besteht in der Regel nicht aus einer einzigen, sondern aus mehreren Datenbanken. IMS

erlaubt den Aufbau hierarchisch strukturierter Datenbestände, die für das System in 3

verschiedenen Stufen beschrieben werden. Man unterscheidet zwischen der Beschreibung

des hierarchischen Datenbankaufbaus, der Beschreibung des Zugriffs für ein bestimmtes

Programm und der Beschreibung der Segmente mit den Datenfeldern. Als Segment

bezeichnet man die kleinste Zugriffseinheit, das ist die kleinste Menge an Daten, die durch

DL/1-Operationen transportiert werden kann (DL/1 ist die Sprache (DDL, DML)) von IMS.

Zur Beschreibung des hierarchischen Aufbaus einer physischen Datenbank dient die „Data

Base Description (DBD)“. Eine physische Datenbank ist die tatsächlich gespeicherte

Datenbank, im Gegensatz zum Datenbankausschnitt (program communication block, PCB),

der dem Benutzer zur Verfügung gestellt wird. Die Beschreibung des speziellen DatenbankZugriffs für ein Programm erfolgt im "program specification block (PSP)". Felder und Struktur

eines Segments werden im Programm selbst beschrieben, sie entsprechen den

Konventionen der jeweiligen Wirtsprache.

(Sauer, Datenbanken – Skript SS2002, Uni Regensburg)

Skizzierung des DD-Files (Datendefinition)

DBD NAME=STUDIES

SEGM NAME=STUDENT,BYTES=100

FIELD NAME=(MATRNR#,SEQ),BYTES=7,START=1

FIELD NAME=NAME,BYTES=30,START=8

FIELD NAME=ADDRESS,BYTES=63,START=38

SEGM NAME=GRUNDST,PARENT=STUDENT;BYTES=2

FIELD NAME=(NR#,SEQ),BYTES=1,START=1

FIELD NAME=DONE,BYTES=1,START=2

SEGM NAME=VORLES,BYTES=35

FIELD NAME=(NR#,SEQ),BYTES=2,START=1

FIELD NAME=CODE,BYTES=7,START=3

FIELD NAME=DOZENT,BYTES=20,START=10

14

FIELD NAME=SEMSTR,BYTES=2,START=30

FIELD NAME=RESULT,BYTES=3,START=32

...

Skizzierung des PCB-Files (Sicht)

PCB DBDNAME=STUDIES

SENSEG NAME=STUDENT,PROGOPT=G

SENFLD NAME=MATRNR,START=1

SENFLD NAME=NAME,START=8

SENSEG NAME=GRUNDST,PROGOPT=G

Damit wird festgelegt,

welche Felder der Benutzer sieht

wie er auf die Felder zugreifen darf

Skizzierung der Operationen

Verwendet werden Funktionsaufrufe (z.B. in PL/I), deren Parameter die

entsprechende Aktion angeben:

GU

GN

GNP

GHU

REPL

ISRT

DLET

REPL

Get Unique

Get Next

Get Next under current Parent

wie GU mit der Möglichkeit eines anschließenden DLET oder

entsprechend GHN und GHNP

InSeRT new segment

DeLETe existing segment

REPLace existing segment

GU dient auch der Initialisierung (initial position).

Navigierender Zugriff (Pseudo-Code):

GU STUDENT WHERE MATRNR# = ' ... ' ;

do until no more GRUNDST ;

GN GRUNDST ;

do until no more VORLES ;

GNP VORLES ;

/* mach was damit */

end ;

end ;

15

Besonderheiten

Logical Database

Secondary Indexes

Recovery

Concurrency: Record (Segment) locking

Security (via PCB)

Integrity: Uniqueness (seq), Regeln für logische Datenbanken

Die ANSI/SPARC – Architektur:

Die ANSI/SPARC - Architektur sieht 3 Ebenen vor:

1. Eine mittlere konzeptuelle Ebene, die alle drei Anwendersichten zu einer Art

gemeinschaftlichen Sicht vereinigt

1. Eine interne Ebene, die es gestattet, unter Kenntnis von Anwenderprofilen und

verfügbarer Hard- und Grundsoftware die leistungsfähigsten Speicher- und

Zugriffsmethoden zu wählen

3. Eine externe Ebene mit beliebig vielen Anwendersichten

Im Mittelpunkt der verschiedenen Betrachtungen (Sichten) steht das allumfassende Konzept

für die Anwendung der Daten. Datenbanken stellen auf der einen Seite die Mittel zur

Verfügung, die die jeweiligen Dateien für die spezifischen Anwendungen bereitstellen. Auf

der anderen Seite sorgen sie für die Speicherung der Daten (internes Schema,

Speicherschema). Entscheidend ist in beiden Fällen das Datenmodell, das der allgemeinen

Beschreibung zugrunde liegt. Das Datenmodell soll möglichst genau die realen Verhältnisse

(die reale Welt) wiedergeben, d.h. die unterschiedlichen Objekte (Entitäten) und ihre

Beziehungen. Ein Datenmodell ist dann das Muster (das Schema), nach dem die Daten

logisch organisiert werden. Im Hinblick zu den Anwenderprogrammen ist auf

Datenneutralität und mit Blickrichtung auf die physische Datenbank auf

Datenunabhängigkeit zu achten.

Datenneutralität bedeutet:

Neue Anwendungen und neue Benutzersichten sollen keinen Einfluss auf existierende

Anwendungen und Sichten ausüben.

Datenunabhängigkeit bedeutet:

Neue Geräte, verbesserte Speichertechnologien, veränderte Zugriffspfade sollen sich in

Anwendungen nur durch Leistungsverbesserung, nicht durch Funktionsänderung bemerkbar

machen.

Bei vollständiger Datenneutralität ist es möglich, durch unterschiedliche Benutzersichten

(Netze, Hierarchien, Relationen) das Basis-Schema zu betrachten. Eine Sicht (view) wird

mit Hilfe der Datenmanipulationssprache (DML) aus der Basis, deren Struktur durch eine

Datendefinitionssprache (DDL) festgelegt wurde, bestimmt.

Auf der anderen Seite sollte eine Reihe von Abbildungen das "Interne Schema" zur

Beschreibung physischer Strukturen erzeugen. Sie enthalten mit ihren Katalogen die Details

zu Zugriffspfaden und zur physischen Speicherung. Eine Speicherstrukturierungssprache

(SSL) unterstützt die verschiedenen Alternativen zur physischen Speicherung.

16

Ein hohes Maß an Datenunabhängigkeit und -neutralität ist mit hierarchischen und auch mit

netzwerkorientierten Datenbanken nicht zu erreichen.

(Sauer, Datenbanken – Skript SS2002)

Vereinfacht ausgedrückt:

Ein Vorteil eines einheitlichen Datenbestandes für alle Anwendungen ist es, dass die

Datenbearbeitung und die Verarbeitung der Daten voneinander getrennt sind.

Man spricht dann auch von Datenunabhängigkeit.

Dies erreicht man dadurch, dass man bei der Datenbankentwicklung ein Konzept heranzieht,

dass von vornherein Datenunabhängigkeit garantieren soll.

Drei Ebenen Konzept

In der Konzeptionellen Ebene werden sämtliche Daten, die in der Datenbank gespeichert

werden sollen, beschrieben. Es wird also die Struktur der Daten beschrieben. Die externen

Schemata beschreiben die Ausschnitte, die für die einzelnen Benutzergruppen relevant sind.

Die interne Ebene beschäftigt sich mit der physischen Speicherung der Daten.

Ziel ist es, bei Änderungen auf einer Ebene die nächsthöhere Ebene nicht ebenfalls ändern

zu müssen.

ANSI/SPARC - Architektur: drei Ebenen-Architektur:

17

Wie eine Anfrage bearbeitet wird:

Datenbank – Administrator (DBA)

Die hauptsächlichen Aufgaben eines Datenbank – Administrators sind:

- Erstellen der konzeptionellen Sicht (also Erstellen der Datenstruktur):

Alle Aspekte der zu modellierenden Welt werden erfasst und eindeutig und

redundanzfrei modelliert

- Erstellen der internen Sicht (Speicherung der Daten):

Damit wird wesentlich die Performance des Systems beeinflusst: Daten werden in

einer Form gespeichert, die für einen effizienten Zugriff geeignet ist. Zusätzlich

werden ggf. Hilfsstrukturen zur Unterstützung des Zugriffs angelegt

- Erstellen der externen Sichten, insbesondere Zugriffsrechte für die Anwender:

Die so entstehenden Ausschnitte beschränken damit die Zugriffsrechte des

jeweiligen Benutzers.

Zu diesen Aufgaben kommen noch:

- Regeln für Sicherheit und Integrität der Daten implementieren (Konsistenz der

Daten)

- Erstellen von Backup – Strategien und Recovery- Prozeduren (Gewährleistung der

Datensicherheit)

- Überwachung und Steigerung der Perfomance

- Installation des DBMS und Einbinden neuer Hardware

18

Eingriffsmöglichkeiten zur Steigerung der Perfomance für den Datenbank – Administrator:

auf unterster (physikalischer) Ebene:

- Reservieren von Hauptspeicher für Systempuffer zum Zeitpunkt der Installation

des DBMS

- Verteilung der Daten af verschiedene Festplatten (Zeitpunkt: Anlegen der

Datenbank)

- Anschaffung neuer Speicherperipherie (zusammen mit Betriebssystemgruppe,

Zeitpunkt: Lebenszyklus einer Datenbank)

-

auf unterer Ebene (Speicherung der Daten):

Füllungsgrad der Speicherseiten beeinflussen

Reorganisation / Clustern der Daten auf den Speicherseiten

Bereitstellen von Sekundärindizes

Typ eines Sekundärindex bestimmen (soweit das DBMS das zulässt)

-

auf höherer Ebene (Zugriff auf Daten):

Informationserhaltende Strukturänderungen

Bereitstellung von Datenbank-Prozeduren

Zugriffspfad-Analyse und –Optimierung

-

-

19

Generelle Struktur eines DBMS

20

Tupel-Identifier

= Indirektion und damit einfache Verschiebbarkeit von Informationen auf einer Seite.

Um Tupel (Records) flexibel zu speichern, wird üblicherweise eine zweigeteilte Adressierung

gewählt:

Seitenadresse, Offset innerhalb der Seite. Im Offset der Seite steht dann die eigentliche

Speicheradresse des Tupels auf der Seite.

Diese Art der Speicherung ermöglicht eine leichte Verschiebbarkeit eines Tupels in der

Seite. Damit lassen sich leicht Lücken auf einer Seite zusammenziehen und somit Platz für

neue Einträge schaffen.

Grund: nach mehreren Einfügungen, Löschungen und Änderungen von Datensätzen in einer

Seite entstehen Lücken, da die gespeicherten Datensätze in der Regel unterschiedleich lang

sind.

Bei Garbage – Collection kann wieder ausreichend Platz auf der Seite beschafft werden

Beim Tupel-Identifier-Konzept wird die Information wo der Datensatz steht auf die Seite

verschoben, auf der der Datensatz gespeichert ist

kürzere Informationswege über den Speicherort

bei Garbage – Collection braucht nur der Index auf der Seite geändert werden

Beim Verschieben des Datensatz auf Überlaufseite (z.B. bei Clusterung) muss nur der

Eintrag im Seitenindex geändert werden

21

Cluster

Erfolgt häufig ein Zugriff auf Datensätze in einer bestimmten Reihenfolge, kann eine

Clusterung die Performance steigern:

die Datensätze werden so auf die Seiten verteilt, dass Sätze, die in der Ordnung

(Clusterindex) aufeinanderfolgen, so weit wie möglich jeweils auf einer Seite

zusammengefasst

werden

=> bei der Verarbeitung in Reihenfolge des Clusterindex werden die physischen

Speicherzugriffe minimiert

Problem:

liegen Daten geclustered vor und erfolgen eine Reihe von Änderungen, so

können nach gewisser Zeit Datensätze nicht mehr auf diejenige Seite

geschrieben werden, auf die sie auf Grund der Clusterung kommen müssten

=> Überlaufseiten zur Aufnahme der Datensätze

Lösungen:

o Füllungsgrad der Seiten verändern

o Reorganisation

Index

Die Suche nach Datenwerten , die durch eine SELECT-Anweisung mit der WHEREBedingung festgelegt sind, kann auf zwei verschiedene Weisen durchgeführt werden:

sequentiell

indiziert

Sequentielle Suche bedeutet, dass jede Reihe einer Tabelle einzeln auf die Bedingung in

der WHERE-Klausel hin überprüft wird. Nacheinander werden also alle Reihen in der

Reihenfolge, wie sie physikalisch gespeichert sind, geprüft.

Die indizierte Suche kennzeichnet das gezielte Suchen nach den Reihen, die die

angegebene Bedingung erfüllen. Welche Art der Suche angewendet wird hängt primär von

der Speicherstruktur, mit der die Reihen einer Tabelle auf der Platte gespeichert sind, ab.

Einige Speicherstrukturen erlauben den Zugriff auf Daten mit Hilfe eines Schlüssels. In

diesem Fall ist die indizierte Suche möglich. Falls der Zugriff auf Daten ohne Schlüssel

durchgeführt wird, muss die sequentielle Suche angewendet werden.

Ein Index kann mit dem Inhaltsverzeichnis eines Buches verglichen werden. Mit Hilfe eines

Inhaltsverzeichnisses ist es möglich, einen Begriff, der im Buch ein- oder mehrmals

vorkommt, gezielt zu suchen und anschließend im Text ausfindig zu machen.

Aufgabe eines Indexes ist es, einen schnellen Zugriff auf gewünschte Information zu

ermöglichen

Zugriff auf Datensätze in sortierter Reihenfolge

direkter Zugriff auf einen Datensatz

Bereichsanfrage

Dazu

wird

der

Schlüssel

zusammen

mit

dem

=> die zu speichernde Datenmenge ist wesentlich reduziert

TID

gespeichert

22

Zum Suchen gut geeignete Strukturen:

Pointerketten

Index-sequentiell

B-Tree

Hash

Die Art des Index ist in den meisten Fällen bereits durch die Wahl des DBMS

vorgegeben

Ein Index speichert Schlüssel und TID, die zu speichernde Datenmenge ist somit in der

Regel wesentlich kleiner als die Datenmenge des Records. Ferner wird eine zum Suchen

gut geeignete Struktur gewählt: z.B. BTree oder auch Hashverfahren.

Wird nach einem bestimmten Schlüsselwert gefragt, so kann mit wenigen Zugriffen auf den

Index die Menge der zugehörigen TIDs ermittelt werden und dann direkt auf die Tupel

zugegriffen werden. (Beim Hashing wird der TID im Prinzip sogar ohne weiteren Zugriff

direktechnet).

Einsatz eines Indexes

um auf die Einträge in der Reihenfolge, die durch den Index vorgegeben wird - d.h.

sortiert -, zuzugreifen;

um zusammenhängende Bereiche herauszufiltern:

z.B. bei numerischen Daten alle Einträge mit Werten im Intervall von a bis b;

um auf einen Wert direkt zuzugreifen:

z.B. bei numerischen Daten auf denjenigen Eintrag (bzw. diejenigen Einträge) mit

dem Wert a.

Nur bei einem eindeutigen Index ist garantiert, dass der angegebene Wert höchstens

einmal gespeichert ist.

Die ersten beiden Möglichkeiten scheiden bei Einsatz von Hashverfahren aus.

Vorteil eines Indexeinsatzes: Schneller direkter Zugriff

Nachteil:

bei sehr kleinen Dateien (nur wenige Datenblöcke) erzeugt ein Index zusätzlichen

Overhead

Bei Änderungen und Einfügen von Daten verlangsamt der Index, da auch der Index

mitgepflegt werden muss

Index über Feldkombinationen

Indexe können auch über Feldkombinationen der zugrundeliegenden Tupel erstellt werden.

Beim Wiederauffinden kann ein solcher Index nur dann sinnvoll benutzt werden, wenn für die

Kombination von links her die Werte ohne Lücken bekannt sind:

Beispiel: enthalten die Tupel z.B. Felder für Länge, Breite und Höhe von Quadern und wird in dieser Reihenfolge - ein kombinierter Index angelegt, so kann der Index sinnvoll

eingesetzt werden, wenn alle Einträge mit

Länge a, Breite b und Höhe c gesucht werden,

23

Länge a und Breite b oder

nur mit Länge a

gesucht

werden

Suchen

nach

Bereichen

sind

ebenso

zulässig.

Der Index kann jedoch z.B. nicht ausgewertet werden, wenn alle Einträge mit Breite b und

Höhe c gewünscht sind: zum sinnvollen Einsatz fehlt Information über die Länge.

Pointerketten

Anstelle eines Index können Pointerketten verwendet werden: jeder Wert erscheint nur

einmal, im Eintrag steht anstelle des Wertes ein Pointer, über den Einträge mit gleichem

Wert verkettet sind (lineare Liste, Anker ist der mit dem gespeicherten Wert verbundene

erste Pointer).

Obwohl die Algorithmen für Einfügen und Löschen in der Regel einfacher sind als bei der

Verwendung eines Indexes, ist die Verwendung von Pointerketten mit Nachteilen verbunden.

Vergleiche Übungen.

Index-sequentiell

Voraussetzung:

Speicherung auf den Daten-Seiten in Schlüsselreihenfolge (sequentiell)

Im Index wird für jede Daten-Seite der Schlüssel (und TID) des letzten Records

aufgenommen (desjenigen mit größtem Schlüsselwert)

Index selbst sequentiell geordnet

Verfahren kann mehrstufig benutzt werden

Bereichsanfragen sowie sortierter Zugriff sind sehr gut

Suchen: vgl. "Algorithmen..."

Besonderheiten:

geeignet z.B. als Cluster-Index

Überlauf-Organisation

Reorganisations-anfällig

B-Tree

insbesondere: ausgeglichener sortierter B-Tree

Spezialfall von Index-sequentiell

wird mit k die für den Baum vereinbarte Schlüsselanzahl bezeichnet, so gilt:

der Baum ist sortiert

jeder Knoten (bis auf die Wurzel) enthält mindestens k und max. 2k

Schlüssel

der Weg von der Wurzel zu jedem Blatt ist gleich lang

k beschreibt die Breite (Fan Out) des Baumes: k=100 bedeutet z.B., dass man mit

nur zwei Zugriffen 100x100=10000 TIDs auffinden kann,

mit drei Zugriffen einen Datensatz in 10000 Datensätzen lesen kann

schneller Zugriff

Bereichsanfragen möglich

sortierter Zugriff möglich

Problem: Reorganisation

Einsatz typisch für RDBMS

24

Hash

die Verbindung zwischen Schlüssel und TID erfolgt über eine Funktion,

kein Lesezugriff

besonders schnell

Problem:

keine Bereichsanfrage möglich!

kein Zugriff in sortierter Reihenfolge möglich

Wahl der geeigneten Hash-Funktion

Beim Hashing werden die Datensätze in einem Feld mit direktem Zugriff gespeichert. Die

Hash-Funktion ermöglicht für jeden gespeicherten Wert den direkten Zugriff auf den

Datensatz.

Hashing(engl.: to hash=zerhacken) beschreibt eine spezielle Art der Speicherung der

Elemente einer Menge durch Zerlegung des Schlüssel-Universums. Die Position des DatenElements im Speicher ergibt sich (zunächst) durch Berechnung direkt aus dem Schlüssel.

Die Menge aller möglichen Schlüssel (der Wertebereich) sei D (Domain). Der Speicher wird

ebenfalls zerlegt in m gleich große Behälter (Buckets). Es ist |D| sehr viel größer als m.

Eine Hash-Funktion h kann nun für jeden Schlüssel s die Nummer des Buckets

h(s) 0,1,..., m 1 berechnen. Ideal wäre eine eindeutige Speicher-Zuordnung eines

Datums mit Schlüssel s zum Bucket mit Nummer h(s): Einfügen und Suchen könnten in

konstanter Zeit (O(1))erfolgen. Tatsächlich treten natürlich Kollisionen auf: Mehrere

Elemente können auf die gleiche Hash-Adresse abgebildet werden. Kollisionen müssen

(auf eine von verschiedenen Arten) behandelt werden.

Hash-FunktionenDef.:

Es sei D ein Wertebereich von Schlüsseln und m dieAnzahl der Behälter Bo , ... , Bm-1zum

Speichern einer gegebenen Menge {e1, .. en}von Elementen (Datensätzen)Eine HashFunktion hist eine (totale) Abbildung

h: D .{0, .. m-1},

die jedem Schlüsselwert w D eine Nummer h(w)und damit einen Behälter Bh(w)zuordnet.

Die Nummern der Behälter werden auch als Hash-Adressenund die Menge der Behälter als

Hash-Tabellebezeichnet. (Vorlesung ALG 2, ...)

Hashing ist eine gut bekannte Technik für Direkt-Zugriffs-Dateien. Die Methode ist sehr

einfach und die Zeit zum Wiederauffinden eines Datensatzes ist sehr gering.

Grundoperationen, wie Einfügen und Löschen, sind keine aufwendigen und komplizierten

Verfahren und können zur Laufzeit im Normalfall auch sehr schnell durchgeführt werden.

Einer der großen Nachteile der statischen Hashverfahren ist die statische

Speicherplatzverwaltung. Die Größe der Datei muss im Voraus bekannt sein oder beurteilt

werden können, um einen physikalischen Speicher für die Datei zu reservieren. Die Größe

des bereitgestellten Speichers ist von einer festen Länge und kann nicht ohne

Reorganisation des gesamten schon bestehenden Files verändert werden. Wenn die

Speichernachfrage eines Files bei der Erstellung zu gering eingeschätzt wurde, dann gibt es

zwangsläufig eine hohe Zahl von Overflow-Einträgen, was die Suche nach einem Record

oder das Einfügen eines Records verlangsamt. Bei zu geringer Ausnutzung des Speichers

wird andererseits Speicherplatz verschwendet. So kommen wir zu dem Schluss, dass es

sehr schwer ist, eine angemessene Größe für ein File zu bestimmen, wenn die Größe dieses

Files großen Schwankungen in der Anzahl der Records unterlegen ist, d.h. die Größe sehr

dynamisch ist.

Beim Hash-Verfahren ist keine Bereichsanfrage möglich. Oft werden gleichartige Datensätze

an unterschiedlichen Orten gespeichert. Desweiteren ist kein Zugriff in sortierter Reihenfolge

möglich. Deshalb wird für RDBMS typischerweise der B-Tree benutzt.

25

Ein Problem des Baumes ist jedoch die Reorganisation. Diese ist sehr performanceaufwändig, deshalb sollte sie nicht nach jedem Ändern eines Datensatzes durchgeführt

werden.

Index

Nur eindeutiger Index garantiert, dass angegebener Wert höchstens einmal

vorhanden ist

Vorteile beim Einsatz:

schnelles Suchen von Datenätzen

Nachteile beim Einsatz:

bei Änderungen (Einfügen, Löschen, Ändern von Datensätzen) muss

Index mitgepflegt werden

=> Verlangsamung

bei sehr kleinen Dateien (nur wenige Seiten) erzeugt Index sogar beim

Lesen zuviel Overhead

Index: kombinierte Spalten

Index kann aus mehreren Attributen kombiniert sein.

=> Index kann beim Auffinden nur dann sinnvoll benutzt werden, wenn Attribute von

links her ohne Lücken bekannt sind:

Tabelle Prüfungen

MatrNr

VName

Semester

Note

4711

Programmierung 1 Sommer 2000 2.0

4712

Programmierung 1 Sommer 2000 3.0

4712

Programmierung 2 Winter 2000 3.0

4711

Datenbanken

4711

Programmierung 2 Sommer 2001 1.3

Sommer 2001 1.0

werden Informationen über Prüfungen verwaltet und ein Index über MatrNr, VName

und Note (in dieser Reihenfolge) angelegt, so kann Index ausgenutzt werden, wenn

MatrNr, VName und Note

MatrNr und VName

MatrNr

bekannt sind, sonst jedoch nicht.

Manche DBMSe ermöglichen es, mit einem Zugriff auf den Index auszukommen ohne

auf die Datensätze zuzugreifen, wenn gesuchte Information bereits im Index

vorhanden ist.

Anmerkung:

die Reihenfolge des Indexspalten muss nicht mit der Reihenfolge der Spalten in der

Tabelle übereinstimmen

26

Der Optimierer (Optimizer)

Der Optimierer ist jene Komponente eines relationalen DBMS, die für die effiziente

Ausführung der Abfrageoperationen zuständig ist. Nach der Kostenschätzung aller

ausgewählten Ausführungspläne entscheidet sich der Optimierer für den aus seiner

Sicht günstigsten Plan.

In relationalen Datenbankmanagementsystemen werden zwei Grundtechniken vom

Optimierer verwendet, um Datenbankoperationen effizient auszuführen:

heuristische Regeln und systematische Kostenschätzung

Diese beiden Techniken werden meistens kombiniert angewendet.

Die Existenz der heuristischen Regeln basiert darauf, dass im relationalen

Datenmodell ein Ausdruck auf mehrere unterschiedliche Arten dargestellt werden

kann. Die Verknüpfung zweier Tabellen kann in den meisten Fällen sowohl durch eine

Unterabfrage als auch durch einen Join äquivalent dargestellt werden.

Die wichtigste heuristische Regel ist, dass unäre Datenbankoperationen (Selektion,

Projektion) immer vor binären Operationen (Join, Vereinigung) ausgeführt werden

sollten.

Die Existenz von Indizes für Tabellenspalten beeinflusst maßgeblich die Auswahl des

Ausführungsplan und damit auch die Performance einer gegeben Abfrage. Das gilt

besonders für Filter, d.h. die Spalten, die in der WHERE-Klausel erscheinen. Die

Entscheidung, ob ein Index verwendet wird oder nicht, hängt von der Indexselektivität

ab und vom Indextyp.

Ist die Indexselektivität hoch (es werden nur wenige Reihen identifiziert und

ausgewählt), wird der Index verwendet.(MS SQLServer)

Beispiel:

select *

from arbeiten

where einst_dat = '01.01.1989'

and aufgabe = 'Sachbearbeiter'

Die Tabelle arbeiten hat je einen Index für die Spalten einst_dat und aufgabe.

Welcher Index wird zuerst verwendet ?

Gesamtanzahl von Reihen: 100 000

geschätzte Anzahl Reihen, die die Bedingung in einst_dat erfüllen = 100

geschätzte Anzahl Reihen, die die Bedingung in aufgabe erfüllen = 40 000

Mit Hilfe dieser Statistiken kann der Optimierer die Selektivität berechnen.

Zuerst würde der Optimierer den Index für die Spalte einst_dat ausführen

(100 / 100 000 = 0,1), dann den Index für die Spalte aufgabe (40 000 / 100 000), weil

die Selektivität für die Spalte einst_dat wesentlich höher ist als die Selektivität für die

Spalte aufgabe.

[Dusan Pethovic, MS-SQL-SERVER 2000]

Kriterien für "günstigen" Pfad:

keine

Regel-basiert

o Reihenfolge der Tabellen im SELECT-Statement

o wenn möglich, Index verwenden

27

...

Kosten-basiert

o Ermittlung mehrerer Alternativen

o abschätzende Bewertung der jeweiligen Kosten

Plattenzugriffe

CPU-Belastung

Speicherbedarf

o

Auswahl der günstigsten Alternative

o

Aufgabe der Komponente, Optimizer:

Ermitteln von Zugriffspfaden

Ermitteln des "günstigsten" Pfads

Kriterien für "günstigen" Pfad:

keine

Regel-basiert

o

o

o

Reihenfolge der Tabellen im SELECT-Statement

wenn möglich, Index verwenden

...

Kosten-basiert

Ermittlung mehrerer Alternativen

abschätzende Bewertung der jeweiligen Kosten

Plattenzugriffe

CPU-Belastung

Speicherbedarf

o Auswahl der günstigsten Alternative

o

o

Beispiel

Tabelle Student

MatrNr

Name

Vorname Anschrift ImmatrikDatum ExmatrikDatum ...

4711 Mustermann Demo

Irgendwo 11.11.1999

-

...

4712 Element

...

-

...

...

...

Tabelle Prüfungen

MatrNr

VName

Semester

Note

4711

Programmierung 1 Sommer 2000 2.0

4712

Programmierung 1 Sommer 2000 3.0

28

4712

Programmierung 2 Winter 2000 3.0

4711

Datenbanken

4711

Programmierung 2 Sommer 2001 1.3

Sommer 2001 1.0

Index auf Student.Name und Prüfungen.Matr.Nr

Anfrage:

SELECT Student.MatrNr, Name, VName, Semester, Note

FROM Student, Prüfungen

WHERE Name = "Mustermann"

AND Vorname = "Demo"

Mögliche Zugriffspfade?

Beispiele für Zugriffspfade

Einige Beispiele:

ohne Indexe:

Sequentielles Abarbeiten von Student, zu jedem akzeptierten

Datensatz sequentielles Abarbeiten von Prüngen

o umgekehrt: Abarbeiten von Prüfungen und für jeden

akzeptierten Datensatz Abarbeiten von Student

o Vorsortieren von Prüfungen hinsichtlich des Attributs MatrNr,

sequentielle Verarbeitung von Student, für jeden akzeptierten

Datensatz binäres Suchen in der sortierten Tabelle von

Prüfungen

o Vorsortieren beider Tabellen nach dem Attribut MatrNr und

Zusammenfügen, danach satzweises Abarbeiten

o

mit Einsatz von Indexen

Sequentielles Abarbeiten von Student, für jeden akzeptierten

Datensatz direkter Zugriff auf Prüfungen

o Direkter Zugriff auf akzeptierte Datensätze von Student, danach

direkter Zugriff auf Prüfungen

o ...

o

... und wenn beide Tabellen nach MatrNr geclustered vorliegen?

Regel-basiert:

Direkter Zugriff auf akzeptierte Datensätze von Student, danach

direkter Zugriff auf Prüfungen

29

Je nach Regelsatz bleibt nur dieser Ansatz übrig.

Nicht immer optimal! (?)

Kosten-basiert:

ohne Indexe:

Sequentielles Abarbeiten von Student, zu jedem akzeptierten

Datensatz sequentielles Abarbeiten von Prüngen

ergeben sich aus dem sequentiellen Lesen der Tabelle Student

und dem wiederholten sequentiellen Lesen der Tabelle

Prüfungen Dabei geht die Selektivität der Anfrage hinsichtlich

der Tabelle Student ein

o umgekehrt: Abarbeiten von Prüfungen und für jeden

akzeptierten Datensatz Abarbeiten von Student

Kosten: ?

o Vorsortieren von Prüfungen hinsichtlich des Attributs MatrNr,

sequentielle Verarbeitung von Student, für jeden akzeptierten

Datensatz binäres Suchen in der sortierten Tabelle von

Prüfungen

Kosten: ?

o Vorsortieren beider Tabellen nach dem Attribut MatrNr und

Zusammenfügen, danach satzweises Abarbeiten

Kosten: ?

o

mit Einsatz von Indexen

Sequentielles Abarbeiten von Student, für jeden akzeptierten

Datensatz direkter Zugriff auf Prüfungen

Kosten: ?

o Direkter Zugriff auf akzeptierte Datensätze von Student, danach

direkter Zugriff auf Prüfungen

Kosten: ?

o ...

o

... und wenn beide Tabellen nach MatrNr geclustered vorliegen?

Datenkompression

Durch Verwendung von Kompressionstechniken wird das gespeicherte Datenvolumen

verringert. Dies wirkt sich positiv bei physischen Zugriffen auf die Platten aus.

Dafür muss mehr Rechenleistung aufgewendet werden, um die komprimierten Daten wieder

zu dekomprimieren.

30

Eine interessante Möglichkeit der Datenkompression bietet sich bei der Verbindung zu

Clustern:

der clusternde Wert braucht ggf. nur einmal gespeichert zu werden, außerdem lässt sich

ausnutzen, dass die Clusterwerte sortiert vorliegen.

Speicherung von Daten (Beispiel: MS SQL Server)

Die Datenspeicherung beim SQL Server basiert auf zwei physikalischen Einheiten:

-

physikalische Seite

extent

Die wichtigste Einheit für die Datenspeicherung beim SQL Server ist die physikalische

Seite. Eine physikalische Seite weist eine feste Größe von 8 KB auf. Jede Seite hat

einen Anfangsbereich von 96 Bytes, der für die Speicherung der Systeminformation

benutzt wird. Daten werden unmittelbar nach dem Anfangsbereich gespeichert. Es

gibt 6 unterschiedliche Typen von physikalischen Seiten

(Datenseite, Indexseite ...).

Bei der Erstellung einer Tabelle oder eines Index wird vom SQL Server zuerst ein

fester Speicherbereich zur Verfügung gestellt. Falls der zur Verfügung stehende

Speicherbereich nicht für die Daten ausreicht, wird vom System zusätzlicher Speicher

zugewiesen. Die physikalische Einheit, die vom System in so einem Fall zugewiesen