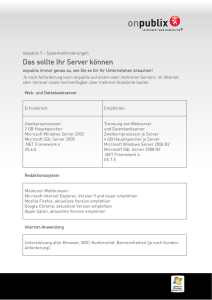

Einführung - Microsoft

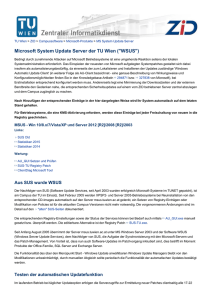

Werbung