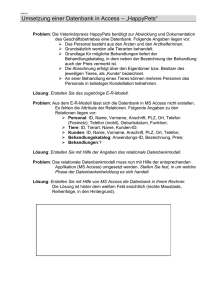

Erstellen und Umstellen von relationalen Datenbanken

Werbung