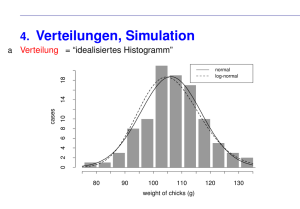

Empirie des makroökonomischen Transmissionsmechanismus

Werbung

Prof. Dr. Isabel Schnabel Professur für Volkswirtschaftslehre, insb. Financial Economics Lösungsskizze zur ersten Übung, Aufgabe 1 Vorlesung „Empirische Wirtschaftsforschung“ Sommersemester 2008 Aufgabe 1: (i) Gesetz der Großen Zahlen (Verwendung der nicht standardisierten Zufallsvariable) Lasst uns kurz das am Anfang der Übung real durchgeführte Zufallsexperiment ins Gedächtnis rufen: Ein Würfel sei fair, so dass Pr(Augenzahl 1) = Pr(Augenzahl 2) = … = Pr(Augenzahl 6) = 1/6 ist. Wir interessieren uns dafür, wie oft man die Augenzahl Sechs würfelt. Die Zufallsvariable dieses Zufallsexperimentes ist Bernoulli-verteilt: Die Wahrscheinlichkeit, dass man keine Sechs würfelt, (X=0) beträgt Pr(X=0) = 5/6. Mit Pr(X=1) = 1/6 wird eine Sechs (X=1) gewürfelt. Man könnte nun ein groß angelegtes Experiment durchführen und 100-mal, 1000-mal oder gar 10 000mal würfeln und die relativen Häufigkeiten aufschreiben. Man würde Folgendes beobachten: Je länger eine Versuchsreihe ist, umso näher wird die relative Häufigkeit der Erfolge (wir ziehen eine Sechs) an 1/6 herankommen. Wir interessieren uns im Folgenden für die Verteilung des Stichprobenmittelwerts eines Zufallsexperimentes, in dem eine Stichprobe der Größe n gezogen wird, wobei die einzelne Ziehung wieder einer Bernoulli-Verteilung unterliegt. Wir würfeln also nicht mit einem, sondern mit n Würfeln und berechnen jeweils den Stichprobenmittelwert der Ausprägungen (0 oder 1). Um die Stichprobenverteilung des Stichprobenmittelwerts zu ermitteln, werden wir 10 000-mal (mit jeweils n Würfen) würfeln. Allerdings erscheint es nicht realistisch, solch ein Experiment tatsächlich mit Würfeln durchzuführen. So bedient man sich computergenerierter Zufallsvorgänge, die in beinahe beliebig großem Umfang simuliert werden können. 1 Jede Simulation führt zu einer neuen Zufallsstichprobe und daher auch zu einem neuen Stichprobenmittelwert. Nach 10 000 Wiederholungen haben wir 1 Sowohl das real durchgeführte als auch das computerbasierte Experiment beschreiben eine Monte-Carlo Simulation. 1 also 10 000 Stichproben mit jeweils n Beobachtungen gezogen und 10 000 Stichprobenmittelwerte berechnet. Beachten Sie, dass der Stichprobenmittelwert in Fall eines Bernoulli-Experimentes gerade der relativen Häufigkeit des Auftretens einer Sechs (X=1) entspricht. Solch ein Experiment soll nun in der ersten Aufgabe durchgeführt werden, um die Grundidee des Gesetzes der Großen Zahlen zu verdeutlichen Zur Übungsaufgabe: Mittels des in der Übung verwendeten Programms Figure2_8.do erzeugen wir zunächst einmal eine Bernoulli verteilte Zufallsvariable: p = 0,78 ⎧1 mit Y =⎨ ⎩0 mit (1 − p ) = 0,22 (1) Das bedeutet, dass Y nur die Werte 0 und 1 annehmen kann, und zwar mit den Wahrscheinlichkeiten Pr(Y = 0) = 1 − p =0,22 und Pr(Y = 1) = p =0,78. Weiterhin gilt: E (Y ) = 1 ⋅ p + 0 ⋅ (1 − p ) = p und (2) Var (Y ) = p(1 − E (Y )) 2 + (1 − p)(0 − E (Y )) 2 (3) = p(1 − p) 2 + (1 − p)(0 − p) 2 = p(1 − p) (4) 2 (a) Teilaufgabe 1: Erzeugen einer Zufallsvariable, die einer Bernoulli Verteilung folgt! Teilaufgabe 1: Stata soll mit diesem Befehl die Zufallsvariable mean generieren. Hierbei soll er eine Stichprobe mit n=1 (obs(1)) 10 000mal (reps(10000)) simulieren! 0 20 Density 40 60 80 Für n = 1 ergibt sich nach Ausführen des Programms: 0 .2 .4 .6 .8 1 r(mean) ⇒ Informativ ist auch der tab-Befehl (die genauen Zahlen werden natürlich variieren!): tab mean r(mean) | Freq. Percent Cum. ------------+----------------------------------0 | 2,157 21.57 21.57 1 | 7,843 78.43 100.00 ------------+----------------------------------- 3 Total | 10,000 100.00 In diesem Fall entspricht der Mittelwert ja gerade der Ausprägung der Bernoulli-Variablen. Wir sehen, dass sich in ca. 22% der Fälle eine 0 ergibt, in ca. 78% der Fälle eine 1. (b) Teilaufgabe 2: Erwartungswert = 0,78 (siehe (2) und VL) Varianz = 0,1716 (siehe (3) und VL) Standardabweichung = 0,1716 = 0,4142 (c) Teilaufgabe 3: Erwartungswert des Stichprobenmittels : ⎡1 ⎤ np E (Y ) = E ⎢ (Y1 + Y2 + ... + Yn )⎥ = = p = 0,78 ⎣n ⎦ n Varianz des Stichprobenmittels (bei Unabhängigkeit der Ziehungen!): 1 p(1 − p) 0.1716 ⎡1 ⎤ 1 = Var (Y ) = Var ⎢ (Y1 + Y2 + ... + Yn )⎥ = 2 Var [(Y1 + Y2 + ... + Yn )] = 2 np(1 − p ) = n n n ⎣n ⎦ n Standardabweichung des Stichprobenmittels: Var (Y ) = p (1 − p) 0.4142 = n n Für n = 1 ergeben sich diese Werte näherungsweise aus dem su-Befehl (s. Log): su mean Variable | Obs Mean Std. Dev. Min Max -------------+-------------------------------------------------------mean | 10000 .7843 .4113276 0 1 4 (d) Teilaufgabe 4: In dieser Zeile kann der Stichprobenumfang n durch „obs(2)“ veränderten werden. 0 20 Density 40 60 Für n=2 ergibt sich in einer neuen Simulation: 0 .2 .4 .6 .8 1 r(mean) . su mean Variable | Obs Mean Std. Dev. Min Max -------------+-------------------------------------------------------mean | 10000 .78155 .2936209 0 1 5 Der Mittelwert des Mittelwerts entspricht wieder in etwa dem Erwartungswert, die (empirische) Standardabweichung entspricht in etwa der theoretischen Standardabweichung von 0,2929 (= 0,4142 ). n (e) Teilaufgabe 5: 0 10 Density 20 30 40 n = 5: 0 .2 .4 .6 .8 1 .6 .8 1 r(mean) 0 5 Density 10 15 20 n = 25: 0 .2 .4 r(mean) 6 0 2 4 Density 6 8 10 n = 100: 0 .2 .4 .6 .8 1 r(mean) 0 20 Density 40 60 80 n = 10 000: 0 .2 .4 r(mean) .6 .8 Hier sieht man jetzt ganz deutlich das Gesetz der Großen Zahlen. Wenn die Stichprobe gegen Unendlich geht, konzentriert sich die Wahrscheinlichkeitsverteilung des Mittelwerts um den Erwartungswert. Informativ sind auch die deskriptiven Statistiken: . su mean Variable | Obs Mean Std. Dev. Min Max -------------+-------------------------------------------------------mean | 10000 .7799573 .004117 .7646 .7954 Die Standardabweichung ist jetzt fast gleich Null. n = 100 000 (dies kann etwas länger dauern) 7 100 Density 50 0 0 .2 .4 r(mean) .6 .8 . su mean Variable | Obs Mean Std. Dev. Min Max -------------+-------------------------------------------------------mean | 10000 .7800135 .0013147 .77523 .78549 (ii) Zentraler Grenzwertsatz (Verwendung der standardisierten Zufallsvariable) Unter (i) haben wir gesehen, dass: Y ⎯⎯p → μ Y Hinreichende Bedingungen für Konsistenz: E (Y ) = μY (5) limVar(Y ) = lim σ Y2 = lim n →∞ n →∞ n →∞ σ Y2 n =0 (6) Daraus folgte, dass sich die Verteilung des arithmetischen Mittels immer enger um μ zusammenzieht. In vielen Anwendungen genügt es aber nicht, nur die ersten beiden Momente (Erwartungswert und Varianz) zu kennen, man wüsste gerne mehr über die Verteilungsfunktion der Zufallsvariable. Im Prinzip könnte diese Verteilungsfunktion aus der Ausgangsverteilung der Zufallsvariablen Yi berechnet werden, was aber nur in speziellen Fällen unkompliziert ist. So wissen wir ja, dass die Summe von identisch und unabhängig verteilten Bernoulli-Variablen –definitionsgemäß- binomialverteilt ist. Auch die Summe von binomialverteilten Zufallsvariablen ist wieder binomialverteilt, wenn sie den gleichen Parameter p haben. Diese Reproduktionseigenschaft findet man ebenfalls bei der Poisson-Verteilung, der Exponentialverteilung und der Normalverteilung. In den meisten anderen Fällen stellt sich die Berechnung der Verteilungsfunktion eher schwieriger dar. Es ist ganz und gar unmöglich, wenn die Ausgangsverteilung unbekannt ist, wie es oftmals in der Pra- 8 xis der Fall ist. Hier hilft uns der Zentrale Grenzwertsatz. Der entscheidende Aspekt liegt darin, dass er keinerlei Anforderungen an die Ausgangsverteilung stellt: Wie auch immer die –identisch und unabhängige- Verteilung der Yi beschaffen sein mag, konvergiert die Verteilungsfunktion des standardisierten arithmetischen Mittels stets gegen die Standardnormalverteilung. Und genau diese Eigenschaft wollen wir im Folgenden mit Stata zeigen. Im Programm figure2_8.do müssen allerdings zwei Veränderungen vorgenommen werden: In dieser Zeile erfolgt die Standardisierung. Zu Aktivierung, muss man das Sternchen zu Beginn der Zeile entfer- Der Stichprobenumfang n muss jetzt an zwei Stellen verändert werden! Aufgrund der Standardisierung (N(0,1)) muss das Histogramm angepasst werden. Hierzu die zweite Zeile aktivieren und erste deaktivieren. (f) Teilaufgabe 6: 0 5 Density 10 15 n = 1: -6 -4 -2 0 r(mean) 9 Einziger Unterschied zu oben: Die Graphik ist so verschoben, dass der Mittelwert ungefähr bei 0 liegt (wegen Standardisierung). . su mean Variable | Obs Mean Std. Dev. Min Max -------------+-------------------------------------------------------mean | 10000 -.0072429 1.00502 -1.883148 .5311444 0 2 4 Density 6 8 10 n = 2: (n muss an 2 Stellen angepasst werden!) -6 -4 -2 r(mean) 0 2 0 2 Density 4 6 n = 5: -6 -4 -2 r(mean) 0 2 10 0 .5 1 Density 1.5 2 2.5 n = 25: -6 -4 -2 r(mean) 0 2 0 .2 Density .4 .6 .8 1 n = 100: -6 -4 -2 0 2 4 r(mean) 0 .1 Density .2 .3 .4 n = 10 000: -6 -4 -2 0 2 4 r(mean) Hier sieht man jetzt ganz deutlich den Zentralen Grenzwertsatz. Im Gegensatz zu vorher wird die Verteilung nicht zu einer Spitze, sondern nähert sich einer Standardnormalverteilung an (durch die 11 Standardisierung wird die Verteilung gestreckt). Dies sieht man auch an den deskriptiven Statistiken (hier detailliert): . su mean, detail r(mean) ------------------------------------------------------------Percentiles Smallest 1% -2.31772 -3.597295 5% -1.690004 -3.452438 10% -1.303717 -3.452438 Obs 10000 25% -.7001442 -3.380009 Sum of Wgt. 10000 50% 6.87e-07 Mean Largest -.0181693 Std. Dev. .9991956 75% .6518597 3.428296 90% 1.255433 3.452439 Variance .9983918 95% 1.617577 3.549011 Skewness -.014056 99% 2.317722 3.597297 Kurtosis 2.954163 Wir stellen fest: Der Mittelwert ist nahe Null, die Standardabweichung nahe 1. Die Schiefe ist nahe 0, und die Kurtosis ist ungefähr 3. 12