Quick Access

Werbung

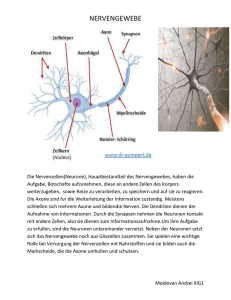

Organisation • • • • Referate Materialien Dritter Termin Workshop 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 1 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung Konnektionismus in a nutshell 27.10.2009 Lars Konieczny Daniel Müller Helmut Weldle Ziel heute… • Was ist, soll und kann konnektionistische Modellierung? • Wo kommt das ganze her? • Wie funktionierts? 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 3 TOPS • • • • • • • • Die "klassische" Sichtweise von Kognition Der Ansatz des Konnektionismus Die Grundidee: „neuronal inspirierte“ Modelle Geschichte: Aufstieg, Fall und Aufstieg... Terminologie und Grundlagen Architekturen Repräsentation Weiter im Seminar (Tlearn, Literatur) 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 4 Klassisch I: Grundannahmen • Grundideen der (klassischen) Kognitionswissenschaft: – Kognition ist Symbolverarbeitung – Kognitive Prozesse sind Algorithmen über Repräsentationen – Hardwareunabhängigkeit: Implementierung der Prozesse ist unwesentlich – Modellierung auf verschiedenen "Levels of Explanation" • Merkmale (vieler) symbolischer Architekturen: – Trennung von Regeln und (deklarativem) Wissen – Sequentiell / seriell 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 5 Das Vorbild aber… Menschen (und andere Lebewesen)… • kommen relativ gut mit verrauschtem Input klar • können generalisieren (Visuelle Wahrnehmung, Sprache…) • Können komplexe Aufgaben schnell recht gut lösen (z.B. Waschmaschine aussuchen) Ihr Gehirn bzw. Nervensystem ist • Selbstorganisierend • relativ robust (z.B.: Vollrausch) Der größte Teil ihres Könnens und Wissens wird erworben 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 6 Grundprinzipien • Orientierung an der „Wetware“: – Kleine, (relativ) gleichartige Einheiten (Neuronen) empfangen Signale von mehreren anderen und leiten damit zusammenhängende Signale weiter – Die Stärke der Verbindungen zwischen Neuronen verändert sich (Lernen!) – Berechnung findet parallel in vielen Neuronen statt – Information ist auf viele Neuronen verteilt 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 7 Ein kurze Geschichte des Konnektionismus: Aufstieg 1943: Warren McCulloch und Walter Pitts 1949: Donald O. Hebb formuliert die klassische Hebb’sche Lernregel. 1957-1959 Frank Rosenblatt: Perceptron 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 8 Fall und Renaissance 1969 Marvin Minsky und Seymour Papert: XOR und das Problem der linearen Separierbarkeit Keine Forschungsgelder – keine Publikationen … Konnektionismus als Sackgasse 1986: Rumelhart & McClelland, Parallel Distributed Processing. Backpropagation of Error (eigentlich von Werbos,1974) 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 9 Sonstige Bigshots (Auswahl) Teuvo Kohonen: Kohonennetze, SelfOrganizingMaps (SOM) John Hopfield: Hopfieldnetze Jeff Elman: Simple Recurrent Networks (SRN) 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 10 Prinzipien neuronaler Informationsverarbeitung • Neuronen integrieren Input-Signale • Neuronen übermitteln Level des Inputs • Mehrschichtige Architektur – Z.B. visuelle Verarbeitung • Der Einfluss eines Neurons auf ein anderes ist abhängig von der Stärke der Verbindung zwischen beiden • Lernen geschieht (u.a.) durch die Veränderung der Verbindungsstärken – Z.B. Hebb'sches Lernen 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 11 Echte und künstliche Neuronen 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 12 Mehrere Verarbeitungsschichten 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 13 Ein kleines Netzwerk Input Input Layer Input Hidden Layer 00 01 10 11 0 1 1 1 Hidden Output Output Layer Output 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 14 Verbindunen/Synapse n/connections Excitatorische Verbindung Inhibitorische Verbindung Recurrente Verbindung -Autoassoziative Netze -Simple Recurrent Networks… 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 15 Ein paar Begriffe und Formeln Input Knoten/Neuron/Node j aj wij: Verbindungsstärke/gewicht(connection weight) von Knoten j zu Knoten i netinputi Unit i Knoten/Neuron/Node i ai: Aktivation(activation) des Knoten i inputij = ajwj Wij netinputij = ajwij ai netinputi ai Ai=F(netinputij ) Output 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 16 Linear mit Schwellenwert activity(a)i Linear activity(a)i Aktivierungsfunktionen netinputi Sigmoid activity(a)i Binärer Schwellenwert activity(a)i netinputi netinputi 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung netinputi 17 Lernen Ausganssituation: • Inputvektor • Targetvektor (Zielzustand) • Outputvektor 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 18 Lernen: Wie könnte es gehen? Input • • • • neue Verbindungen entwickelt, vorhandene Verbindungen löschen Verbindungsgewichte verändern Schwellenwerte von Neuronen verändern • Neuronenfunktionen verändern (Aktivierungs-, Propagierungs- und Ausgabefunktion) • neue Neurone entwickeln • vorhandene Neurone löschen Output 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 19 Lernen: Die DeltaRegel Δwij = [ai(soll) - ai(ist)] aj ε Δwij: Gewichtsveränderung der Verbindung aj : Aktivation des Quellknotens (?) ε : Lernrate 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 20 …das war nur der Anfang 27.Oktober 2010 Projektseminar WS 09/10 Konnektionistische Sprachverarbeitung 21