4.4 Bilinearformen über R, selbstadjungierte und orthogonale

Werbung

c Rudolf Scharlau

Lineare Algebra II – Sommersemester 2015

4.4

313

Bilinearformen über R, selbstadjungierte und

orthogonale Endomorphismen

Alle in diesem Abschnitt vorkommenden Vektorräume sind über den reellen Zahlen R definiert und endlich dimensional.

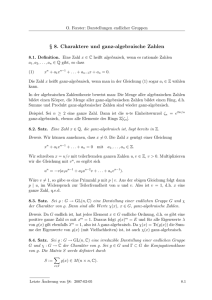

Satz 4.4.1 (Trägheitssatz von Sylvester)

nearform auf dem R-Vektorraum V .

2

Es sei b eine symmetrische Bili-

a) Es existiert eine Orthogonalbasis v1 , . . . , vn von V derart, dass

b(vi , vi ) ∈ {0, 1, −1} für alle i = 1, . . . , n.

b) Die Anzahlen

n+ := |{i | b(wi , wi ) > 0}|

n− := |{i | b(wi , wi ) < 0}|

n0 := |{i | b(wi , wi ) = 0}|

sind unabhängig von der Wahl der Orthogonalbasis w1 , . . . , wn .

Das Tripel (n+ , n− , n0 ) heißt die Signatur von b.

Beweis: zu a): Nach Satz 4.3.10 existiert eine Orthogonalbasis w1 , . . . , wn bezüglich b. Wenn man einen Basisvektor wi durch αwi für ein α ∈ R r {0} ersetzt, so

wird der entsprechende Diagonaleintrag gii = b(wi , wi ) der Gram-Matrix G durch

α2 gii ersetzt. Da jede positive reelle Zahl eine Quadratwurzel besitzt (hier geht

p die

Generalvoraussetzung K = R entscheidend ein), können wir mit αi := 1/ |gii |

und vi := αi wi für gii 6= 0 das gewünschte Ergebnis erreichen.

zu b): Die Anzahl n0 der Nullen ist gleich der Dimension des Kerns der GramMatrix G und somit nach Bemerkung 4.3.9 unabhängig von der Wahl der Basis

(nämlich gleich dem Defekt von b gemäß Definition 4.3.8). Entsprechend ist die

Summe n+ + n− gleich dem Rang von G, bzw. von b. Es sei nun w10 , . . . , wn0

eine weitere Orthogonalbasis und n0+ , n0− , n00 die entsprechenden Anzahlen. Wegen

n0 = n00 ist auch n0+ + n0− = n+ + n− , es reicht also, n+ = n0+ zu zeigen. Betrachte

dazu

V+ := Lin{wi | b(wi , wi ) > 0},

V−0 := Lin{wi0 | b(wi0 , wi0 ) < 0},

und sei V0 das Radikal von b. Die Summe V−0 + V0 ist eine direkte Summe, also

dim(V−0 + V0 ) = n0− + n0 . Weiter ist V+ ∩ (V−0 + V0 ) = {0}, denn für ein v in diesem

Durchschnitt, v 6= 0 wäre einerseits b(v, v) > 0, weil b auf V+ positiv definit ist,

andererseits b(v, v) ≤ 0. Also ist auch die Summe V+ + (V−0 ⊕ V0 ) direkt, und

2

James Joseph Sylvester, 1814 - 1897, britischer Mathematiker, wirkte in London und Oxford

sowie auch in den USA (Virginia, Maryland)

c Rudolf Scharlau

314 Lineare Algebra II – Sommersemester 2015

damit n+ + n0− + n0 ≤ n = n0+ + n0− + n0 , also n+ ≤ n0+ . Da die Rollen von V+

und V+0 vertauschbar sind, folgt auch n0+ ≤ n+ , insgesamt also Gleichheit, wie

gewünscht.

Bemerkung:

a) Der eben geführte Beweis zeigt die folgende Kennzeichnung der Signatur

einer symmetrischen Bilinearform: n+ ist die größte Dimension eines Unterraumes U ⊆ V derart, dass b|U ×U positiv definit ist. Entsprechend ist n−

die größte Dimension eines Unterraumes U ⊆ V derart, dass b|U ×U negativ

definit ist, d.h. −b|U ×U ist positiv definit.

b) Es sei (V, b) ein Vektorraum mit symmetrischer Bilinearform, (n+ , n− , n0 )

seine Signatur. Ferner sei W ⊆ V ein Untervektorraum und (m+ , m− , m0 )

die Signatur von b|W ×W . Dann gilt n+ ≥ m+ und n− ≥ m− .

Noch etwas expliziter kann man das Ergebnis von Teil a) des vorigen Satzes wie

folgt ausdrücken: Es gibt natürliche Zahlen n+ , n− (die in Teil b) definierten)

derart, dass bei geeigneter (Um-)Nummerierung der Basisvektoren gilt:

1 für i = 1, . . . , n+ ,

b(vi , vi ) = −1 für i = n+ + 1, . . . , n+ + n− ,

0 für i > n+ + n− .

Dieses bedeutet eine sehr spezielle, sozusagen normierte” Gestalt der Gram”

Matrix von b bezüglich dieser Basis. Es handelt sich um die Matrix

Diag( 1, . . . , 1, −1, . . . , −1, 0, . . . , 0),

| {z } | {z } | {z }

n+ mal

n− mal

n0 mal

wobei Diag(d1 , d2 , . . . , dn ) die Diagonalmatrix mit Diagonaleinträgen d1 , d2 , . . . , dn

bezeichnet.

Teil b) des Satzes (das ist der eigentliche Trägheitssatz” von Sylvester) be”

sagt, dass diese Matrix bei gegebenem b eindeutig bestimmt ist. Er liefert also

eine eindeutige Normalform für symmetrische Bilinearformen, bzw. für symmetrische Matrizen über den reellen Zahlen. In der Tat ist die Situation völlig analog

zum Normalformenproblem für Endomorphismen, bzw. Ähnlichkeit von Matrizen: Auf den reellen symmetrischen Matrizen ist die Äquivalenzrelation der Kongruenz definiert (siehe Definition 4.2.6), und jede Äquivalenzklasse enthält genau

eine Matrix in der beschriebenen Normalform.

Der nächste Satz gibt ein Kriterium an, wie man im nicht-entarteten Fall die

Signatur (n+ , n− ) bestimmen kann, ohne eine Orthogonalbasis explizit zu berechnen. Allerdings funktioniert dieses Kriterium nicht für jede Wahl der ursprünglichen Basis, bzw. der Gram-Matrix. Wichtig ist vor allem das dann folgende

Korollar 4.4.3.

Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

315

Satz 4.4.2 (Determinanten-Kriterium für die Signatur)

Es sei b eine symmetrische Bilinearform auf einem n-dimensionalen R-Vektorraum V und v1 , . . . , vn eine beliebige Basis von V , weiter G = (gij ) die GramMatrix von b bezüglich dieser Basis. Wir betrachten für k = 1, . . . n die Untermatrizen Gk := (gij )i,j=1,...,k und setzen voraus, dass alle Unterdeterminanten

dk := det Gk , k = 1, . . . n, von Null verschieden sind. Dann ist die Signatur von

b gleich (n+ , n− , 0), wobei n− die Anzahl der Vorzeichenwechsel in der Folge der

dk (dabei d0 := 1) ist:

dk

<0 .

n− = # k |

dk−1

Beweis: Für n = 1 ist die Behauptung klar: Es ist G1 = (d1 ), es muss nichts

diagonalisiert werden.

Sei nun dim V = n > 1 und die Behauptung für Bilinearformen auf Vektorräumen kleinerer Dimension bereits bewiesen (Induktionsannahme). Wir wenden dieses auf W := Lin{v1 , . . . , vn−1 } an. Hierzu gehören die Haupt-Unterdeterminanten d0 = 1, d1 , . . . , dn−1 (die gleichen Werte wie für b auf V ). Die

Signatur von b auf W ist nach Voraussetzung von der Form (m+ , m− , 0), wobei nach der Bemerkung zu Satz 4.4.1 gilt m+ ≤ n+ , m− ≤ n− und ferner

m+ + m− = n − 1. Es bleiben also nur die Möglichkeiten n+ = m+ + 1, n− = m−

oder n+ = m+ , n− = m− + 1. Diese beiden Fälle müssen wir im folgenden Hauptteil dieses Beweises anhand des Vorzeichens von d0 := dn /dn−1 unterscheiden.

Nach 4.3.6 gilt dim W ⊥ = 1; sei w ein von Null verschiedener Vektor von W ⊥ .

Wenn w ∈ W gelten würde, dann wäre b(w, z) = 0 für alle z ∈ W und damit

die Einschränkung von b auf W entartet, im Widerspruch zur Voraussetzung.

Also ist w ∈

/ W und V = W ⊕ Rw (orthogonale direkte Summe). Es sei G0 die

Gram-Matrix von b bezüglich der Basis v1 , . . . , vn−1 , w. Nach Satz 4.2.6 gibt es

eine reguläre Matrix S, für die gilt

det G0 = det(S t GS) = det S t det S det G = (det S)2 det G,

d.h. det G = dn und det G0 haben das gleiche Vorzeichen. Andererseits ist G0 eine

Blockmatrix mit einem Block Gn−1 und dem anderen Block b(w, w) der Größe 1,

d.h. det G0 = dn−1 b(w, w). Wenn man das mit der obigen Gleichung dn = dn−1 d0

zusammennimmt, sieht man, dass d0 und b(w, w) das gleiche Vorzeichen haben.

Wenn d0 positiv ist, dann ist b(w, w) > 0, und nach Definition der Signatur folgt

weiter n+ = m+ + 1; wenn dagegen d0 < 0, dann ist b(w, w) < 0 und nach

Definition der Signatur folgt weiter n− = m− + 1.

316 Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

Korollar 4.4.3 (Determinanten-Kriterium für positive Definitheit) 3

Eine symmetrische Bilinearform b auf einem n-dimensionalen reellen Vektorraum

ist genau dann positiv definit, wenn für eine oder jede Gram-Matrix G von b alle

Haupt-Unterdeterminanten det Gk , k = 1, . . . n, wobei Gk := (gij )i,j=1,...,k , positiv

sind.

Beweis: zu ⇒”: Die Determinanten von zwei verschiedenen Gram-Matrizen

”

derselben Bilinearform haben, wie schon im Beweis von 4.4.2 gesehen, das gleiche

Vorzeichen. Insbesondere ist im positiv-definiten Fall die Determinante nicht nur

für eine Orthogonalbasis, sondern sogar für jede Basis positiv. Sei nun v1 , . . . , vn

eine Basis von V und b positiv definit. Dann ist auch die Einschränkung von b

auf den von v1 , . . . , vk erzeugten Unterraum positiv definit und somit det Gk > 0,

für alle k = 1, . . . , n.

zu ⇐”: Das folgt sofort aus dem vorigen Satz 4.4.2.

”

Im zweiten Teil dieses Abschnittes kommen wir nun zur Begriffsbildung eines

adjungierten Endomorphismus”.

”

Definition 4.4.4 Es sei (V, h , i) ein euklidischer Vektorraum und F, G ∈ End(V ).

a) G heißt adjungiert zu F , falls für alle v, w ∈ V gilt:

hF (v), wi = hv, G(w)i .

b) F heißt selbstadjungiert, falls F zu sich selbst adjungiert ist, d.h. für alle

v, w ∈ V gilt:

hF (v), wi = hv, F (w)i .

Bemerkung 4.4.5 Es sei (V, h , i) ein euklidischer Vektorraum. Wir betrachten

Endomorphismen F und G von V .

a) Wenn G adjungiert zu F ist, dann ist auch F adjungiert zu G.

b) F ist genau dann orthogonal , wenn F bijektiv und zu F −1 adjungiert ist.

Beweis: Teil a) folgt daraus, dass die G kennzeichnende Gleichung hF (v), wi =

hv, G(w)i äquivalent ist zu hG(w), vi = hw, F (v)i (die beiden Seiten vertauschen

und benutzen, dass h , i symmetrisch ist). Die Bijektivität in Teil b) war bereits

in Bemerkung 2.10.24 festgestellt worden: Jeder orthogonale Endomorphismus

ist bijektiv, also ein Automorphismus. Man ersetzt nun in der Definition einer

3

Gelegentlich spricht man vom Hurwitz-Kriterium. Dieses erscheint aber historisch nicht

korrekt, vielmehr geht das Kriterium im Wesentlichen bereits auf Sylvester zurück. Adolf Hurwitz (1859 - 1919, deutscher Mathematiker, wirkte in Göttingen, Königsberg und Zürich) hat

das Kriterium für ein bestimmtes Problem benutzt und dadurch weiter verbreitet.

c Rudolf Scharlau

Lineare Algebra II – Sommersemester 2015

317

orthogonalen Abbildung das durch ganz V laufende w durch F −1 (w) und erhält

wie gewünscht hF (v), wi = hv, F −1 (w)i .

Adjungiertheit ist zunächst als (symmetrische) Relation zwischen zwei Endomorphismen definiert; tatsächlich gibt es aber zu jedem F genau ein G, das mit F

in dieser Relation steht, wie wir jetzt zeigen werden. (Mit anderen Worten: die

Relation ist eine Abbildung, genauer der Graph einer Abbildung; siehe 1.1.16.)

Satz 4.4.6 Es sei (V, b) ein euklidischer Vektorraum.

a) Zu jedem Endomorphismus F von V gibt es einen eindeutigen adjungierten

Endomorphismus G, bezeichnet mit G =: F ad .

b) Für alle F, F1 , F2 ∈ End(V ) und jeden Skalar α gilt

(F1 ◦ F2 )ad = F2ad ◦ F1ad , (F1 + F2 )ad = F1ad + F2ad (αF )ad = αF ad .

c) Es sei B eine Orthonormalbasis von V und A = MBB (F ). Ein G ∈ End(V )

ist genau dann adjungiert zu F , wenn MBB (G) = At ist.

Beweis: zu c): Wir betrachten zunächst einen

Spezialfall: Es sei V = Rn und b das Standard-Skalarprodukt h , i. Es sei

A ∈ Rn×n . Dann ist FAt adjungiert zu FA , d.h.

hA~x, ~y i = h~x, At ~y i für alle ~x, ~y ∈ Rn .

Beweis hierzu: Dieser ergibt sich ohne das Rechnen mit Doppelsummen aus der

Darstellung des Standardskalarproduktes als Matrixprodukt Zeile mal Spalte”:

”

Für alle ~x, ~y ∈ Rn gilt

hA~x, ~y i = (A~x)t ~y = ~xt (At ~y ) = h~x, At ~y i.

Für den allgemeinen Fall schreiben wir

v=

n

X

i=1

xi v i ,

w=

n

X

yj vj ,

mit xi , yj ∈ R

j=1

und B = (v1 , . . . , vn ), d.h. wir benutzen den Basisisomorphismus ΦB : Rn → V .

Nach Bemerkung 2.10.23 (siehe auch 2.10.17) ist dieser eine orthogonale Abbildung, d.h. b(v, w) = h~x, ~y i, ensprechend auch für b(F (v), w) und b(v, G(w)).

Unter Benutzung der grundlegenden Formel aus Satz 2.8.2 (über die Koordinaten

von Bildvektoren) erhalten wir nun

b(F (v), w) = hA~x, ~y i,

b(v, G(w)) = h~x, B~y i,

318 Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

wobei B := MBB (G). Aus dem Spezialfall folgt nun sofort die gewünschte Gleichung im allgemeinen Fall, wenn B = At ist. Die umgekehrte Implikation, d.h.

die Aussage genau dann” aus c) folgt aus der in a) festgestellten Eindeutigkeit

”

der zu F adjungierten Abbildung.

zu a): Die Existenz einer adjungierten Abbildung folgt sofort aus c) (wir definieren G über seine Darstellungsmatrix). Die Eindeutigkeit folgt daraus, dass

jedes Skalarprodukt nicht-entartet ist: wenn G und G0 beide adjungiert zu F sind,

dann folgt für alle w ∈ V , dass hv, G(w) − G0 (w)i = 0 für alle v ∈ V und damit

G(w) − G0 (w) = 0.

zu b): Man rechnet nach, dass die jeweilige rechte Seite der Behauptung die

Bedingung an die zu bestimmende Adjungierten erfüllt und benutzt die Eindeutigkeit.

Wir wollen nun zeigen, dass selbstadjungierte Endomorphismen diagonalisierbar sind und für orthogonale Endomorphismen eine ähnliche, etwas schwächere

Aussage gilt. Hierfür müssen wir zunächst etwas über F -invariante Unterräume

wissen.

Lemma 4.4.7 Seien (V, h , i) ein euklidischer Vektorraum, F ∈ End(V ), und U

ein Unterraum von V . Wenn U F -invariant ist, dann ist U ⊥ F ad -invariant.

Beweis: Gegeben sei y ∈ U ⊥ . Für alle x ∈ U gilt

hx, F ad (y)i = hF (x), yi = 0,

weil F (x) ∈ U . Also ist F ad (y) ∈ U ⊥ , wie behauptet.

Lemma 4.4.8 Jeder (komplexe) Eigenwert einer reellen symmetrischen Matrix

ist reell.

Beweis: Wir benutzen das sogenannte komplexe Standard-Skalarprodukt

h~z, w

~ i :=

n

X

~ ∈ Cn .

zi wi , für alle ~z, w

i=1

Es gelten die Rechenregeln

h~z, λw

~ i = λh~z, w

~ i für alle ~z, w

~ ∈ Cn , λ ∈ C,

sowie hw,

~ ~z i = h~z, w

~ i; ansonsten gelten die Regeln eines (reellen) Skalarproduktes; insbesondere ist h~z, ~z i reell und positiv, wenn ~z 6= ~0 ist. Sei nun ~z ein

Eigenvektor zum Eigenwert λ ∈ C von A = At ∈ Rn×n . Dann ist

λh~z, ~z i = hλ~z, ~z i = hA~z, ~z i = h~z, A~z i = h~z, λ~z i = λh~z, ~z i.

Also ist λ = λ und damit λ ∈ R.

Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

319

Satz 4.4.9 (Spektralsatz) Es sei F ein selbstadjungierter Endomorphismus eines euklidischen Vektorraumes V .

a) Jeder F -invariante Unterraum besitzt ein F -invariantes Komplement.

b) F ist diagonalisierbar. Es gibt sogar eine Orthonormalbasis von V aus Eigenvektoren von F .

Beweis: Teil a) folgt sofort aus Lemma 4.4.7: Man nehme das orthogonale Komplement des Unterraums.

zu b): Nach Satz 4.4.6.c) kann F durch eine symmetrische Matrix dargestellt werden, hat also nach Lemma 4.4.8 einen (reellen) Eigenwert und damit

auch einen Eigenvektor v1 . Diesen können wir als normiert annehmen: kv1 k = 1.

Wir haben nach Satz 2.10.8 eine orthogonale Zerlegung V = Rv1 ⊕ v1⊥ . Nach

Lemma 4.4.7 ist v1⊥ F -invariant. Der von F auf v1⊥ induzierte Endomorphismus

ist trivialerweise wieder selbstadjungiert. Wenn wir für diesen Endomorphismus

entsprechend vorgehen, und so weiter, erhalten wir in n = dim V Schritten ein

System von n normierten Eigenvektoren, die alle senkrecht aufeinander stehen.

(Formal machen wir hier natürlich einen Induktionsbeweis über die Dimension

von V .)

Bemerkung: Die praktische Berechnung einer ON-Basis, ausgehend von einer

symmetrischen Darstellungsmatrix von F , wird nicht unbedingt dem im Beweis

angegebenen Weg folgen: Wenn die Eigenwerte bereits bekannt sind, bestimmt

man einfach alle Eigenräume. Diese sind orthogonal zueinander, was wir im folgenden Satz separat beweisen, und V ist ihre direkte Summe (weil F diagonalisierbar ist; vergleiche Korollar 3.4.8 und Satz 3.4.6). Man bestimmt dann für

jeden Eigenraum eine ansonsten völlig beliebige ON-Basis (etwa mit dem GramSchmidt-Verfahren) und setzt diese einzelnen Basen zu der gesuchten Basis des

Gesamtraumes zusammen.

Satz 4.4.10 Seien (V, h , i) ein euklidischer Vektorraum und F ∈ End(V ) selbstadjungiert. Dann sind Eigenvektoren aus verschiedenen Eigenräumen stets orthogonal zueinander.

Beweis: Für v ∈ Eig(F, λ), w ∈ Eig(F, µ) gilt λhv, wi = hF (v), wi = hv, F (w)i =

µhv, wi. Unter der Voraussetzung λ 6= µ folgt hieraus hv, wi = 0.

Korollar 4.4.11 Jede reelle symmetrische Matrix A ist diagonalisierbar, und

sogar mit einer orthogonalen Transformationsmatrix. D.h., zu A existiert eine

orthogonale Matrix S mit

S −1 AS = D = Diag(d1 , d2 , . . . , dn ),

S −1 = S t .

320 Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

Beweis: Wir betrachten den Rn mit dem Standardskalarprodukt und wenden

den Spektralsatz 4.4.9.b) auf den nach Satz 4.4.6 c) selbstadjungierten Endomorphismus FA von Rn an. Aus den Vektoren der hiernach existierenden Orthonormalbasis bilden wir spaltenweise eine Matrix S. Diese ist nach Satz 2.10.25 (iii)

orthogonal, und nach Konstruktion ist S −1 AS eine Diagonalmatrix.

Aus dem letzten Korollar, ergibt sich als weiteres Korollar die folgende, gegenüber

Satz 4.4.2 verbesserte (nämlich immer anwendbare) Methode zur Bestimmung der

Signatur.

Korollar 4.4.12 Es sei b eine symmetrische Bilinearform auf einem R-Vektorraum. Dann ergibt sich die Signatur (n+ , n− , n0 ) von b aus einer beliebigen GramMatrix A von b als die Anzahl (mit Vielfachheiten) der Eigenwerte von G, die

positiv, bzw. negativ, bzw. Null sind.

Beweis: Die zur gegebenen Gram-Matrix A gehörige Basis sei A, also A :=

GA (b). Wir wenden nun das Korollar 4.4.11 auf die Matrix A an. an. Wir definieren eine neue Basis B durch CAB = S und entnehmen der Gleichung S −1 = S t und

der Basiswechselformel aus Satz 4.2.5, dass D die Gram-Matrix von b bezüglich

B ist. Nach Definition der Signatur ist also n+ die Anzahl der positiven Diagonalelemente von D, entsprechend n− . Andererseits sind aber die Diagonalelemente

von D genau die Eigenwerte von D, also auch von A. Damit ist die Behauptung

bewiesen.

Lemma 4.4.13 Es sei F ein beliebiger Endomorphismus eines endlich-dimensionalen reellen Vektorraumes V . Dann besitzt V einen nicht-trivialen F -invarianten

Unterraum U der Dimension ≤ 2.

Beweis: Durch Wahl einer Basis reduziert man das Problem leicht auf den Fall

V = Rn , F = FA , A ∈ Rn×n . Es sei λ ∈ C eine Nullstelle des charakteristischen

Polynoms PF = PA . Falls λ ∈ R ist, ist λ ein Eigenwert von F , und ein Eigenvektor v ∈ V zu λ erzeugt sogar einen eindimensionalen F -invarianten Unterraum.

Neu zu behandeln ist also der Fall λ ∈ C r R. In diesem Fall besitzt immerhin noch die lineare Abbildung FA : Cn → Cn einen Eigenvektor ~z ∈ Cn , also

A~z = λ~z. Wir schreiben nun λ = α + iβ, α, β ∈ R, und ~z = ~x + i~y , ~x, ~y ∈ Rn .

Den Schluss des Beweises halten wir als eigenständige Aussage fest, die wir später

noch einmal zitieren werden.

Zusatz zu 4.4.13: Mit den eben eingeführten Bezeichnungen gilt: ~x und ~y sind

linear unabhängig, und der von ihnen erzeugte zweidimensionale Unterraum U

von Rn ist invariant unter FA . Die Darstellungsmatrix

von FA , eingeschränkt auf

!

α −β

U bezüglich der Basis ~x, −~y ist gleich

.

β α

Zum Beweis dieses Zusatzes stellen wir zunächst fest, dass ~z und sein konjugiert

komplexer Vektor ~z¯ = ~x − i~y linear unabhängig (über C) sind, weil sie zu verschiedenen Eigenwerten λ bzw. λ̄ gehören. Aus ~x = 21 (~z + ~z¯) und ~y = − 2i (~z − ~z¯)

Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

321

folgt dann sofort, dass auch ~x und ~y linear unabhhängig sind (über C, erst recht

über R). Wenn man in der Gleichung A~z = λ~z sowohl ~z = ~x + i~y als auch

λ = α + iβ einsetzt und dann Realteil und Imaginärteil vergleicht, erhält man

A~x = α~x − β~y , A~y = β~x + α~y , was genau die angegebene Darstellungsmatrix

liefert.

Wir erinnern noch daran, dass die eben angegebene 2 × 2-Matrix die Darstellungsmatrix der Multiplikationsabbildung z 7→ λz, C → C bezüglich der R-Basis

1, i von C ist.

Lemma 4.4.14 Seien K ein Körper, V ein endlich-dimensionaler K-Vektorraum, F : V → V linear und bijektiv und U ein F -invarianter Teilraum von

V . Dann ist U auch F −1 -invariant.

Beweis: Da U endlich-dimensional und F bijektiv ist, folgt aus F (U ) ⊆ U sogar

F (U ) = U , weiter U = F −1 (U ) und insbesondere F −1 (U ) ⊆ U .

Satz 4.4.15 Es sei F ein orthogonaler Automorphismus eines euklidischen Vektorraumes V .

a) Jeder F -invariante Unterraum besitzt ein F -invariantes Komplement.

b) Es gibt eine F -invariante Zerlegung von V als orthogonale Summe von Unterräumen der Dimension ≤ 2.

Beweis: Teil a) ergibt sich unmittelbar aus Lemma 4.4.7 zusammen mit Lemma

4.4.14. Teil b) folgt aus Teil a) zusammen mit Lemma 4.4.13.

Aus dem letzten Satz und der Klassifikation der orthogonalen Abbildungen bzw.

Matrizen aus Satz 2.10.26 ergibt sich leicht der folgende abschließende Klassifikationssatz für orthogonale Abbildungen. Wir erinnern an die Matrix

!

cos γ − sin γ

Rγ =

, γ ∈ R, 0 ≤ γ < 2π,

sin γ cos γ

die eine Drehung in der Ebene um den Winkel γ beschreibt.

Lemma 4.4.16 Für jeden (reellen) Eigenwert λ einer orthogonalen Abbildung

gilt λ = 1 oder λ = −1.

Beweis: Für v ∈ Eig(F, λ) r {0} gilt hv, vi = hF (v), F (v)i = hλv, λvi = λ2 hv, vi,

woraus λ = ±1 folgt.

322 Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

Satz 4.4.17 (Normalform orthogonaler Abbildungen)

Es sei F eine orthogonaler Automorphismus eines euklidischen Vektorraumes V .

Dann gibt es eine Orthonormalbasis von V derart, dass die zugehörige Darstellungsmatrix von F die folgende Gestalt hat:

1

..

.

1

−1

γ1 , . . . , γk ∈ R,

..

.

0 < γj < π,

,

−1

γ1 ≤ γ2 ≤ · · · ≤ γk

Rγ1

Rγ2

..

.

Rγk

Dabei ist die Matrix durch F eindeutig bestimmt.

Beweis: Nach Satz 4.4.15.b) gibt es eine Zerlegung von V als orthogonale direkte

Summe von eindimensionalen F -invarianten Unterräumen Rvi und von zweidimensionalen F -invarianten Unterräumen Uj . Die eindimensionalen liefern nach

Lemma 4.4.16 die behaupteten Werte ±1 auf der Diagonalen der Darstellungsmatrix.

Von den zweidimensionalen F -invarianten Unterräumen können wir annehmen, dass sie nicht mehr weiter in eindimensionale Unterräume zerfallen, d.h.

F|Uj hat keinen (reellen) Eigenwert. Nach Satz 2.10.26 ist F|Uj eine Drehung oder

Spiegelung. Der zweite Fall tritt unter den jetzigen Voraussetzungen nicht auf,

da dann F|Uj die Eigenwerte 1 und −1 hätte und Uj in zwei eindimensionale

Unterräume zerfallen würde. (Wir hatten dieses bereits in Beispiel 3.3.4 festgestellt.) Im Fall einer Drehung ist die Darstellungsmatrix von F|Uj eine Matrix

Rγ , zunächst mit 0 ≤ γ < 2π. Der Fall γ = 0 fällt weg, weil dann R0 = E2

die Einheitsmatrix wäre und wieder Uj in eindimensionale Unterräume zerfallen

würde (doppelter Eigenwert 1). Entsprechend fällt Rπ = −E2 weg (doppelter

Eigenwert −1, Drehung um 180 Grad). Wenn wir schließlich in einem der Uj

den zweiten Basisvektor durch sein Negatives ersetzen, dann werden die beiden

Matrixeinträge a12 und a21 (also ± sin γ) durch ihr Negatives ersetzt, was man

auch durch den Übergang von γ zu 2π − γ erreichen kann. (Anschaulich: Eine

Linksdrehung” um z.B. 270◦ wird als eine Rechtsdrehung” um 90◦ aufgefasst.)

”

”

Auf diese Art können wir alle auftretenden Werte γ auf den angegebenen Bereich

0 < γ < π einschränken.

Nun zur Eindeutigkeit der Matrix unter den angegebenen Nebenbedingungen. Die Anzahl der Einträge 1 ist gleich der Dimension des Eigenraumes zum

Lineare Algebra II – Sommersemester 2015

c Rudolf Scharlau

323

Eigenwert 1, ebenso für −1. (Tatsächlich sind diese geometrischen Vielfachheiten

des Eigenwertes ±1 auch gleich der jeweiligen algebraischen Vielfachheit.) Wir

müssen nun, ohne Bezug auf eine bestimmte Basis, feststellen, welche Werte γ

in den Zweierblöcken auftauchen, und wie oft jedes γ auftaucht. Dieses geschieht

mit Hilfe der komplexen Eigenwerte” von F , d.h. der komplexen Nullstellen von

”

PF , die nicht in R liegen. Wenn man das charakteristische Polynom von Rγ hinschreibt, sieht man, dass die Nullstellen genau λ = cos γ + i sin γ sind und das

konjugiert-komplexe λ̄ sind. Das beweist man mit dem Satz von Vieta”, mit dem

”

man aus den beiden Nullstellen die Koeffizienten des Polynomes zurückberechnet:

PF (X) = (X − λ)(X − λ̄) = X 2 − (λ + λ̄)X + λλ̄ = X 2 − 2 cos γ · X + 1 .

Ein Wert γ tritt also in der Matrix genau dann auf, wenn cos γ + i sin γ ein

Eigenwert von F ist. Mit jedem komplexen Eigenwert λ ist auch das konjugiertkomplexe λ̄ ein Eigenwert; das gilt für die Nullstellen eines beliebigen Polymons

mit reellen Koeffizienten. Aus der Eindeutigkeit der Zerlegung eines Polynoms in

Linearfaktoren folgt weiter, dass λ und λ̄ jeweils mit der gleichen Vielfachheit in

PF vorkommen. Diese gemeinsame Vielfachheit ist gleich der Anzahl der Blöcke

Rγ in der Darstellungsmatrix. Genauer gibt es in jedem Paar λ, λ̄ genau einen

mit positivem Imaginärteil, nämlich cos γ + i sin γ mit sin γ > 0, was genau zu

unserer Festlegung 0 < γ < π äquivalent ist.