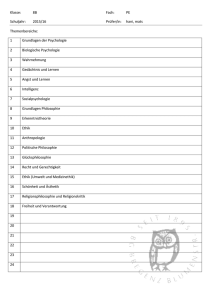

Allgemeine Psychologie I WS0405

Werbung

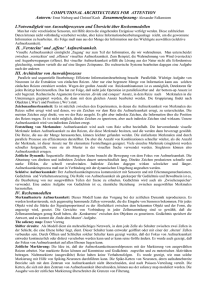

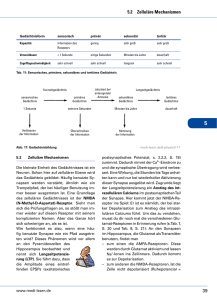

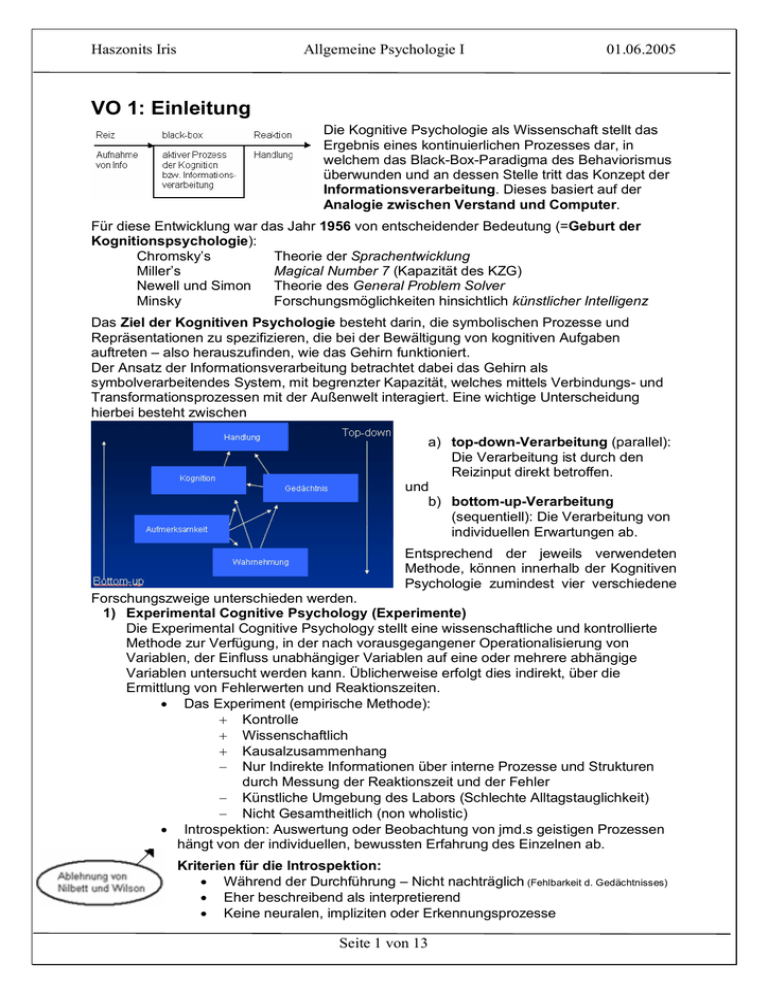

Haszonits Iris Allgemeine Psychologie I 01.06.2005 VO 1: Einleitung Die Kognitive Psychologie als Wissenschaft stellt das Ergebnis eines kontinuierlichen Prozesses dar, in welchem das Black-Box-Paradigma des Behaviorismus überwunden und an dessen Stelle tritt das Konzept der Informationsverarbeitung. Dieses basiert auf der Analogie zwischen Verstand und Computer. Für diese Entwicklung war das Jahr 1956 von entscheidender Bedeutung (=Geburt der Kognitionspsychologie): Chromsky’s Theorie der Sprachentwicklung Miller’s Magical Number 7 (Kapazität des KZG) Newell und Simon Theorie des General Problem Solver Minsky Forschungsmöglichkeiten hinsichtlich künstlicher Intelligenz Das Ziel der Kognitiven Psychologie besteht darin, die symbolischen Prozesse und Repräsentationen zu spezifizieren, die bei der Bewältigung von kognitiven Aufgaben auftreten – also herauszufinden, wie das Gehirn funktioniert. Der Ansatz der Informationsverarbeitung betrachtet dabei das Gehirn als symbolverarbeitendes System, mit begrenzter Kapazität, welches mittels Verbindungs- und Transformationsprozessen mit der Außenwelt interagiert. Eine wichtige Unterscheidung hierbei besteht zwischen a) top-down-Verarbeitung (parallel): Die Verarbeitung ist durch den Reizinput direkt betroffen. und b) bottom-up-Verarbeitung (sequentiell): Die Verarbeitung von individuellen Erwartungen ab. Entsprechend der jeweils verwendeten Methode, können innerhalb der Kognitiven Psychologie zumindest vier verschiedene Forschungszweige unterschieden werden. 1) Experimental Cognitive Psychology (Experimente) Die Experimental Cognitive Psychology stellt eine wissenschaftliche und kontrollierte Methode zur Verfügung, in der nach vorausgegangener Operationalisierung von Variablen, der Einfluss unabhängiger Variablen auf eine oder mehrere abhängige Variablen untersucht werden kann. Üblicherweise erfolgt dies indirekt, über die Ermittlung von Fehlerwerten und Reaktionszeiten. • Das Experiment (empirische Methode): + Kontrolle + Wissenschaftlich + Kausalzusammenhang − Nur Indirekte Informationen über interne Prozesse und Strukturen durch Messung der Reaktionszeit und der Fehler − Künstliche Umgebung des Labors (Schlechte Alltagstauglichkeit) − Nicht Gesamtheitlich (non wholistic) • Introspektion: Auswertung oder Beobachtung von jmd.s geistigen Prozessen hängt von der individuellen, bewussten Erfahrung des Einzelnen ab. Kriterien für die Introspektion: • Während der Durchführung – Nicht nachträglich (Fehlbarkeit d. Gedächtnisses) • Eher beschreibend als interpretierend • Keine neuralen, impliziten oder Erkennungsprozesse Seite 1 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 2) Cognitive Science (Modellierung und Berechung) Die Cognitive Science entwickelt Berechungsmodelle um höhere Kognitionen zu verstehen. Diese Modelle werden in Computerprogrammen realisiert, die bei gleichem Input, denselben Output liefern sollen wie Menschen. Man unterscheidet vor allem drei Arten von Modellen: • Semantische Netzwerke bestehen aus Konzepten (Knoten) die mit/durch verschiedene Beziehungen (unterschiedlich gewichtete Verbindungen) verknüpft sind. Lernen ist das Hinzufügen von neuen Verbindungen oder die Änderung der Gewichtungen der Verbindungen. Der Grundgedanke ist der, dass jedes Wissen in Form von Assoziationen besteht. Es gibt drei Hauptprinzipien der Assoziation: • Contiguity (Zusammenhang): Zwei Dinge werden assoziiert, weil sie zusammen in einer Zeitspanne auftreten. • Similarity (Gleichartigkeit): Zwei Dinge werden assoziiert, weil sie ähnlich sind. • Contrast (Kontrast): Zwei Dinge werden assoziiert, weil sie die jeweiligen Gegensätze sind. • Produktionssysteme bestehen aus Produktionen von „Wenn-dann-Regeln“. Das Produktionssystem vergleicht die Inhalte des Arbeitsspeichers mit den Wenn-Teilen der Regeln und arbeitet dann die Dann-Teile ab. • Verbindungsnetzwerke (Neuronale Netzwerke) unterscheiden sich von den vorangegangenen Modellen vor allem dadurch, dass hier Lernerfahrungen berücksichtigt werden (rückwärts gerichtete Weitergabe). Eine neuronenähnliche Einheit (Knoten) ist mit vielen anderen Knoten über unterschiedliche Beziehungen (gewichtete Verbindungen) verknüpft. Die Einheit summiert alle gewichteten Eingaben und produziert eine einzige Ausgabe, wenn die Summe der gewichteten Eingaben größer ist als der Schwellenwert der Einheit. (Mehrere Schichten; dezentrale Konzeptspeicherung) 3) Cognitive Neuropsychology (Beeinträchtigungen und Patienten) Die Cognitive Neuropsychology beschäftigt sich mit kognitiven Beeinträchtigungen von gehirngeschädigten Patienten, um Informationen über die normal funktionierenden menschlichen Kognitionen zu erhalten. Das kognitive System wird somit als modulares System betrachtet, im Sinne einer Isomorphie in der Organisation zwischen dem physischen Gehirn und dem Verstand (Jedes Modul hat eine physische Entsprechung). 4) Cognitive Neuroscience (Ins Gehirn schauen – Wann und Wo verarbeitet wird) Die Cognitive Neuroscience verwendet verschiedene Techniken, um das Gehirn zu studieren, wobei diese im Hinblick auf Grad der räumlichen und zeitlichen Auflösung in dem sie neuronale Strukturen und Vorgänge abbilden, unterschieden werden. Zu den wichtigsten Verfahren zählen: • Einzelzelllableitung: Eine Mikroelektrode (1/10.000mm) wird ins Gehirn eingefügt; große Auswahl an Zeitspannen; Neuronale Ebene • ERPs (Event related potentials): Electroencephalogramm (EEG): Messung auf der Kopfoberfläche; Nur zur Messung der kognitiven Basisprozesse geeignet • PET (Positron emission tomography): Radioaktiv verseuchtes Wasser; indirekte Messung der neuralen Aktivität; Identifikation vieler kognitiver Aktivitäten – rasche Änderungen können aber nicht aufgezeigt werden • MRI (magnete resonance imaging): Radiowellen; Struktur und Funktion des Gehirns; fMRI (Functional): misst den Blutfluss; Indirekt • Magnetenzephalographie (MEG): direkte, sehr genaue Messung, keine strukturelle Info, meist verbunden mit MRI Seite 2 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 VO 2: Wahrnehmung, Gibsons Ansatz Entsprechend konstruktivistischer Theorien (indirekte Wahrnehmungstheorien) stellt Wahrnehmung einen aktiven und konstruktiven Prozess dar, der von Hypothesen und Erwartungen abhängt und von motivationalen als auch emotionalen Faktoren beeinflusst wird. Wenngleich sich mit diesen Ansätzen die Wahrnehmung besonders kurzzeitig dargebotener Reize sehr gut erklären lässt, so werden bei alltäglicher Wahrnehmung weit mehr Fehler vorhergesagt als tatsächlich auftreten. WAHRNEHMUNG = how the world appears to us • Die Welt wäre dumm und schwarz, wenn wir keine Sinnesorgane hätten. • Jeder Organismus muss von seiner Umgebung adaptiert werden, wenn er überleben und sich reproduzieren will. Die Struktur und die Physiologie eines Organismus sind nicht am Anfang des Lebens fixiert, sondern er wird durch Anpassung von der Umwelt adaptieren. Arten von Adaptionen Wachstum: Wissen über die Welt aneignen (top down) Bewegung: durch Bewegung Info verändern und sich anpassen Lernen Wahrnehmungsorgane • Augen • Ohren • Zunge • Haut • Nase • Seitenlinienorgan (z.B. bei den Fischen) • Elektromagnetische Strahlung • Innere Organe (z.B. die Niere dient auch dem Gleichgewicht) Visuelle Wahrnehmung: Das Sehvermögen ist unser stärkster Sinn bei der Erforschung unserer Umwelt. Das Auge leitet die elektromagnetische Strahlung, die ja das Licht in Wirklichkeit ist, weiter und diese passiert diverse Stellen im Gehirn, wo sie letztendlich als Bild im Gehirn bewusst gemacht wird. Die Theorie der direkten Wahrnehmung von Gibson (1979) beschreibt einen ökologischen Ansatz, in welchem die optische Anordnung invariante Informationen über die Form und Repräsentation von Objekten in der visuellen Umwelt enthält. Invariant deshalb, weil sie bei Bewegungen oder Positionsänderungen des Beobachters, unterschiedlichen Blickwinkeln oder Lageänderungen des Wahrnehmungsobjekts unverändert bleiben. Viele Invarianten entstehen dabei erst bei Bewegung, wobei • Texturgradienten (Gradient: Neigung, Steigung, Gefälle; Textur: Oberflächenbeschaffenheit, Struktur, Gestalt) • das optische Flussmuster (Bewegungswahrnehmung durch Fixpunkt) und • die Handlungsabsichten (Fokussierung der Wahrnehmung auf die potentielle Verwendung von Gegenständen) die entscheidende Information liefern. Es ist nach Gibsons Ansatz kaum Informationsverarbeitung notwendig, alle Informationen sind direkt in der Umwelt enthalten. Zumindest wurden die nötigen Informationsverarbeitungsschritte von Gibson nicht expliziert. Seite 3 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Prinzipien der direkten Wahrnehmung 1) Die ganze Information, die für eine fehlerfreie Wahrnehmung nötig ist, ist in der Umwelt enthalten 2) Wahrnehmung ist unmittelbar und spontan. 3) Wahrnehmung und Handlung können nicht voneinander getrennt werden. Ökologische Wahrnehmung: + Es ist philosophisch von weit reichender Bedeutung. Die Umwelt und der Organismus interagieren. + Reichhaltigkeit der visuellen Reize – Überspezifizierung (durch die multidimensionale Gliederung (Form, Farbe, Winkel etc.). − Wahrnehmungsprozesse sind komplizierter − Gibsons Ansatz ist relevant für das „Sehen“ (z.B. einen Stern), aber sagt nichts über das „Erkennen“ (z.B. den Polarstern) aus. − erklärt welche visuelle Information wir wahr nehmen, aber nicht warum wir Dinge kennen (Das Gedächtnis ist wichtig, ohne könnten wir nichts wahr nehmen) Als Alternative zu Gibson postulieren indirekte Wahrnehmungstheorien (z.B. Marr 1982, Biedermann 1987) die Ausbildung von internen Repräsentationen, wobei Basismerkmale zu höheren Einheiten zusammengefasst werden. Die Rekonstruktion der Wirklichkeit beruht dabei auf Wissen. Direkte Wahrnehmungstheorien • • • • • Indirekte/konstruktivistische Wahrnehmungstheorien • Abhängig von inneren Prozessen – Rekonstruktion der Wirklichkeit beruht auf Wissen • Erklärung von Wiedererkennen • Top-down- und Bottom-up-Prozess Keine inneren Repräsentationen involviert – Die Umwelt enthält alle Informationen Wahrnehmung von Handlungen Bottom-up-Prozess Lernen spielt eine Rolle Licht ist der Mediator von Wahrzunehmenden und Wahrnehmenden Ob wir tatsächlich mit der Umwelt in einer direkten Form interagieren, steht im Mittelpunkt vieler Untersuchungen hinsichtlich Bewegung, Wahrnehmung und Handlung. Entsprechend der outflow-theory von Helmholz (1866) wird die Bewegung im retinalen Abbild, mit Hilfe von Spiralen welche an die Augenmuskulatur gesendet werden, interpretiert. Hinsichtlich des Einflusses des optischen Flussmusters auf präzises, zielgerichtetes Verhalten ist zu beachten, dass die Bewegung auf die Retina ebenso von den Kopf- und Augenbewegung abhängt. Die Zeit zum Kontakt kann dabei mittels einer spezifischen optischen Variablen (tau) berechnet werden, aber auch über die Schätzung der Geschwindigkeit und Distanz. Untersuchungen zur Bewegung sprechen für die tau-Hypothese zumindest dann, wenn sich ein Objekt auf einen unbewegten Beobachter bewegt. Dennoch spielen auch andere Informationen, wie beispielsweise das Wissen über eine bekannte Objektgröße, eine entscheidende Rolle. Für die Wahrnehmung augenblicklicher Bewegung sind sowohl strukturelle als auch dynamische Hinweise bedeutend. Seite 4 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 VO 3: Wahrnehmung als Informationsverarbeitung Wahrnehmungstheorie von David C. Marr Marr entwickelte eine Grundannahme des Informationsverarbeitungssystems in Form von drei Stufen der Analyse: 1) Die Stufe der rechenbetonten Theorie des Systems (computational theory of the system) 2) Die Stufe des Algorithmus und Repräsentation, die eine Berechnung benötigen (algorithm and representation, which are used to make computations) 3) Die Stufe der Implementierung: die zugrunde liegende Hardware oder „Maschinerie“ auf der die Berechnungen durchgeführt werden. (implemetation: the underlying hardware or „machinery“ on which the computations are carried out) Algorithmen zur Eckenentdeckung Ecken (oder besser wichtige Kanten) in einem Bild befinden sich an Stellen, an denen sich die Intensität besonders steil ändert. Dies ist eine theoretische Definition davon, was eine Kante ist (in einem Bild). Dieser Wert (die Steilheit der Veränderung in der Intensität) entspricht dem ersten Derviat (die erste Ableitung) der Leuchtdichteverteilung. Wenn der Wert positiv ist, handelt es sich um einen positiven Anstieg (es wird beispielsweise heller; ist er negativ, wird es dunkler). Um Ecken zu finden, muss man die höchsten Werte in dieser Repräsentation suchen (gradient peaks). Denn an der Stelle eines Höchstwertes (peak) ist die Steigung gleich Null. Die Ecken befinden sich also laut Marr und Hildreth (1980) an den Nullstellen der zweiten Ableitung. Primärskizze (the raw primal sketch) Ausgangsmaterial: Graustufen-Darstellung (Pixel, Leuchtdichteprofil, Oberfläche) Bilder sind voller Rauschen, welches zu unerwünschter Information führt, die durch das Filtern noch verstärkt wird. Als Rauschen wird jede Art von Information gezählt, die nicht zu einem bestimmten Signal gehört, im Fall eines Bildes also beispielsweise Unschärfen, oder bedeutungslose Texturen. Marr und Hildreth (1980) schlagen vor, dass ein Gaussfilter das Bild vor der eigentlichen Filterung der Leuchtdichteintensitäten unscharf macht. Dadurch wird das Problem von Rauschen (noise) reduziert. Nimmt man beide Operatoren zusammen, so kommt man auf den gaussgefilterten Laplacefilter oder auch (LoG) Operator. Dieser Filter stellt auch eine schöne Annäherung an die im Auge vorhandenen Ganglien-Zellen dar, die ebenfalls ein Zentrum haben, das von on- bzw. off-Zellen umgeben ist. Volle Primärskizze (the full primal sketch): Gruppierung • Kantensegmente (edge segments): Die Kantenerkennung wurde oben detailliert beschrieben. Um die Kanten aus verschiedenen Repräsentationen zu gewichten, könnte man in der resultierenden Primärskizze eine Kante immer dann repräsentieren, wenn sie in mehr als einer Filter-Auflösung enthalten ist. Dadurch erhält man die „stärksten“ Kanten • Balken (bars): Dort, wo sich parallele Kantensegmente unterschiedlicher Polarität nahe beieinander befinden. Ein Filter kann das Vorhandensein solcher Balken entdecken und sie entsprechend repräsentieren • Endungen (terminations): Endungen können markiert werden, wo an drei Stellen Kanten zusammentreffen. • Kleckse oder Klumpen (blobs): Wenn edge-segments eine geschlossene Form ergeben, die entlang ihrer Innenseite identische Ladungen hat, dann kann diese unregelmäßige Form repräsentiert werden. Seite 5 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Gestaltpsychologie Prägnanzgesetz: Bei mehreren geometrisch möglichen Organisationen wird dasjenige auftreten, dass die beste, einfachste und stabilste Form aufweist. Diese Form nehmen wir als Figur-Grund-Prinzip. • Prinzip der Ähnlichkeit, Geschlossenheit, Nähe, gute Fortführung, gemeinsames Schicksal 2,5 D-Skizze • Berechnung der räumlichen Tiefe und Orientierung • Beschreibung der Schattierung, Textur, binokulare Ungleichheit etc. der sichtbaren Teile des Objekts! • Abhängig vom Blickwinkel 3D-Modellrepräsentation • Definition der dreidimensionalen Form von Objekten und deren Beziehung, blickwinkelig unabhängige Modellpräsentation VO 4: Objekterkennung Die Anfänge der Theorien zur Objekterkennung begingen die Gestaltpsychologen zu Beginn des 20. Jahrhunderts, wobei versucht wurde, Wahrnehmungsphänomene durch bestimmte, möglichst einfache Gesetze zu erklären. Jede Theorie der Objekterkennung muss dabei das Problem der Äquivalenz oder Objektkonstanz auslösen. Als Beispiel kann man die einfache Merkmalsentdeckung von Stichlingen nach Tinbergen (1951) nennen. Dabei wird ein (Schlüssel-) Stimulusmerkmal zum Auslöser einer Reaktion (z.B. der rote Bauch bei dem Fisch „Stichling“ ist ein Zeichen für Geschlechtsreife. Dieser Stimulus löst die Reaktion „Balzverhalten“ aus). Später entwickelten sich Schablonentheorien, die auf der Übereinstimmung von gesehenen Objekten und gespeicherten Prototypen basieren (template maching), sowie Merkmalstheorien die für die Differenzierung und Erkennung von Objekten hervorstechende Eigenschaften als bedeutend annehmen. Erst jedoch Modelle struktureller Beschreibungen, die neben den jeweiligen Merkmalen auch deren räumliche Anordnung sowie das Gesamtarrangement berücksichtigen, ermöglichen eine Objekterkennung. Entsprechend der Computational-Theory von Marr (1922) ist beim Prozess der Objekterkennung die Ausbildung von drei, zunehmend detailreicheren Repräsentationen erforderlich: • Die Primärskizze entsteht durch die Analyse von Lichtintensitätsunterschieden, die eine zweidimensionale Beschreibung von Formmerkmalen, wie Kanten, Konturen, Flecken oder Linien beinhaltet. • Danach entsteht aus der Berechnung der räumlichen Tiefe und Orientierung die 2,5D-Skizze. • Schließlich werden die dreidimensionale Form von Objekten und deren Beziehung definiert und es entsteht eine blickwinkelig unabhängige 3-D-Modellrepräsentation. Für die Erkennung von Objekten müssen dabei die Hauptachsen erkannt werden. Marr und Nishihara (1978) stellen ein Modell vor, wonach eine Kombination aus Kontur und Silhouette die Objekterkennung leiten. Marr & Nishihara (1978): Die Objektform selbst bildet einen wichtigen Referenzrahmen. Wichtig dabei sind die Hauptachsen und die generalisierten Cones (Zylinder, Kegel). Die Umwelt lässt sich also in einfache Dinge zerteilen, die hierarchische Ordnung von Objekten basiert auf den unterschiedlichen zylindrischen Grundelementen. Seite 6 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Einen etwas anderen Ansatz stellt Biedermann (1987) in seiner recognition-by-componentstheory dar. Im Mittelpunkt stehen dabei 36 verschiedene Geons – elementare Teilkörper, wie beispielsweise Zylinder, Kegel etc. – welche, auf unterschiedliche Art und Weise zusammengesetzt, Objekte des Alltags definieren. Die Objekterkennung selbst besteht aus einem Prozess, indem zunächst aus dem Stimulus Ecken und Kanten extrahiert werden. Anschließend erfolgt die Identifikation der nicht zufälligen Eigenschaften, die in Kombination mit den Konturen jene Geons definieren, die das Objekt repräsentieren. Die Erkennung erfolgt schließlich durch den Vergleich zwischen den Komponenten und den gespeicherten Repräsentationen. Die soeben vorgestellten Theorien sind allerdings in der Weise limitiert, als ihre Gültigkeit auf die basic-level-recognition beschränkt bleibt. Wir Menschen sind jedoch in der Lage bzw. häufig dazu gezwungen auf einer sehr spezifischen Ebene Objekte zu erkennen, besonders wenn diese einer sehr homogenen Klasse angehören. Abschließend wird ein Interactive-Activation Modell von Humphreys, Lamote und LloydJones (1995) vorgestellt, das Objekterkennungs- und Benennungsprozesse modelliert und auch zur Erklärung von Agnosie (Unfähigkeit etwas wahrzunehmen z.B. Seelenblindheit) verwendet werden kann. VO 5: Gesichter Gesichter stellen eine Klasse dar, in der Objekterkennung auf subordinaten Niveau stattfindet: Man muss nicht erkennen, dass etwas ein Gesicht ist, sondern welcher Person es zugehört. Deswegen reicht eine einfache Beschreibung anhand von Geons oder die Liniendarstellung nicht aus. Gesichtsidentifizierung erfolgt demzufolge anhand von subordinatelevel-discrimination. Bruce und Young (1986) entwickelten ein Modell der Gesichtserkennung, welches die Verarbeitung verschiedener im Gesicht enthaltender Informationen abbildet, und zwar bei bekannten und nicht bekannten Gesichtern. Eine besonders wichtige Frage untersucht, ob es schon so etwas wie eine angeborene Gesichtssensitivität gibt. Es scheint, dass schon Neugeborene Gesichtern besondere Aufmerksamkeit zuwenden, jedoch ist nach aktuellen Studien nicht sicher, ob dies nicht mit den spezifischen visuellen Eigenschaften (ObenVersus-Unten-Präferenz) zu tun hat. Interessant ist auch die Frage, wie Erwachsene Gesichter so effizient verarbeiten können. Neuere Untersuchungen zum Gesichtsinversionseffekt (Gesichter sind auf den Kopf gestellt schwieriger zu erkennen) haben gezeigt, dass dabei die Seite 7 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Enkodierung von sowohl • lokalen (local; z.B. Nase, Mund, Augen) als auch • konfiguralen Merkmalen (relational; z.B. Augenabstand, NaseMund-Abstand, etc.) sowie • ganzheitliche Merkmale (holistic; Textur und Formmerkmale), für die Gesichtserkennung eine notwendige Voraussetzung darstellt. Die Erkennung von Gesichtern scheint also anderen Verarbeitungsmechanismen zu unterliegen, als jene von Objekten. Ein Beleg dafür ist eine besondere Form der visuellen Agnosie (Unfähigkeit etwas wahrzunehmen), der Prosopagnosie (Gesichtsblindheit). Patienten mit dieser Beeinträchtigung wissen zwar oftmals, dass ein Gesicht ein Gesicht ist und können auch häufig Merkmale benennen, dennoch sind sie nicht in der Lage, das Gesicht, im Sinne einer Personenidentifikation zu erkennen. Gleichzeitig zeigen sie jedoch keinerlei Beeinträchtigung bei der Erkennung von Objekten, weshalb die Annahme von getrennten Verarbeitungsstrukturen gerechtfertigt scheint. Scheinbar unabhängig von Identifikationen können Gesichtsausdrücke von Gesichtern sehr effizient erkannt werden. Weitere Gesichtsklassifikationen (Alter, Attraktivität) beruhen auf der effizienten Analyse von Gesichts- und auch Kopfmerkmalen. Abschließend wird noch die Implementierung bisherigen Wissens in ein Neuronales Netzwerkmodell (Burton et al, 1990) vorgestellt. Gesichtsausdrucksanalyse FACS System (nach Ekman & Friesen) - Facial Action Coding System; Für bestimmte Gesichtsausdrücke werden unterschiedliche Muskeln verwendet und gebraucht. Es existiert eine Universalität der Emotionen im Gesicht. Man kann also immer erkennen, was der Mensch in etwa in diesem Moment fühlt. Sie versuchten also zu kodieren, welche Gesichtsausdrücke welche Emotionen widerspiegeln. Basisemotionen: Ärger, Ekel, Freude, Schreck (ist eine sehr schnelllebige Emotion, vergeht innerhalb kürzester Zeit), Trauer/Traurigkeit, Überraschung Funktion von Gesichtsausdrücken: Die Grunddimension von einem Gesichtsausdruck ist entweder positiv oder negativ. • Senden von Signalen bzw. • Aufnehmen von Informationen (z.B. Bei Schreck werden die Augen aufgerissen, um den Stressfaktor so schnell wie möglich zu erkennen.) oder • Schutz (z.B. Das Rümpfen der Nase bei Ekel kann ein Schutz vor giftigen Gasen sein. ) Es gibt ein eigenes kognitives Modul im Gehirn, das sich mit Gesichtsausdrücken beschäftigt und die Universalität der Gesichtsausdrücke entziffert. Kategorisierung von Gesichtern Gesichter können nach folgenden Eigenschaften kategorisiert werden: 1. Attraktivität • Eine gut bestätigte Hypothese ist die, das ein Gesicht dann als attraktiv bezeichnet wird, wenn es „durchschnittlich“ ist. Man muss sich unter der Durchschnittlichkeit einen Prototyp vorstellen, der alle Objekte einer Klasse optimal repräsentiert (Mitteltyp der Population). • average-morphing: Ein Prototyp wird aus verschiedenen Bildern gebildet. Das Ergebnis ist meist attraktiver als die einzelnen Bilder, aus denen es zusammengesetzt wurde. • Weiblichkeit in männlichen Gesichtern kann assoziiert werden mit der entgegengesetzten Charakteristikasammlung (Ein weiblicher Mann wirkt wärmer, gefühlsvoller, freundlich und umgänglich.) Studien besagen, dass Frauen für längere Beziehungen Männer mit mittelmäßiger Weiblichkeit suchen. 2. Alter • Im Alter verändert sich die Kopfform systematisch • Pittenger & Shaw (1975) - Shear and strain Levels: Dabei werden 35 verschiedene „Scheren-” und „Verzerrungsprofile” erstellt. • Laserscans: Dies ist die neueste Methode der Alterserkennung bei Gesichtern. Dabei werden 3-D-Modelle des Kopfes erstellt. 3. Geschlecht Seite 8 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 VO 6: Aufmerksamkeit Aufmerksamkeit hängt eng mit der Selektivität der Verarbeitung zusammen und kann dabei aktiv sein, auf top-down-Prozesse basieren und kontrolliert werden von individuellen Zielen oder passiv sein, auf bottom-up-Prozesse basieren und kontrolliert werden von externen Stimuli. Die Untersuchungen zur Aufmerksamkeit sind zumeist auf externe zweidimensionale Reize beschränkt, die weder individuelle Ziele noch Motivation berücksichtigen, wobei grundsätzlich zwischen • fokussierter Aufmerksamkeit (liefert Rückschlüsse über den Selektionsprozess und dem Schicksal der nicht beachteten Reize) und • geteilter Aufmerksamkeit (gibt Aufschluss über generelle Verarbeitungsbeschränkungen) differenziert werden muss. Shadowing-Aufgaben zur Untersuchung der fokussierten auditorischen Aufmerksamkeit zeigten zwar oftmals eine begrenzte Verarbeitung des Reizes im nicht beachteten Kanal, jedoch wurde auch im zunehmenden Maße umfangreiche Verarbeitung desselben festgestellt. Daraus resultierte eine Kontroverse zwischen • early-selection models Broadbendt (1958): Zwei Reize oder Mitteilungen erhalten zur selben Zeit (parallel) Zugang zum sensorischen Zwischenspeicher. Eine der Eingaben wird es gestattet durch einen Filter auf Basis seiner physikalischen Charakteristiken zum Kurzzeitgedächtnis zu gelangen, die andere Eingabe verweilt in dem Zwischenspeicher für die spätere Verarbeitung. Flaschenhals früh in der Verarbeitung Kritik an dieser Theorie: − inflexibles System − Der Fakt, dass Selektion auch auf der Bedeutung der Information basieren kann, widerspricht dieser Theorie. o Treisman (1964): Zwei Reize oder Mitteilungen erhalten zur selben Zeit (parallel) Zugang zum sensorischen Zwischenspeicher. Der Filter reduziert die Analyse der nicht beachteten Information. Wobei der Flaschenhals flexibler ist als in der Theorie von Broadbendt. Die Reizanalyse ist systematisch und hierarchisch, beginnt mit Analysen basierend auf physikalischen Hinweisen, silbenbildende Muster und spezifischen Wörtern, und fährt fort mit Analyse individueller Wörter, grammatikalischer Struktur und Bedeutung. Wenn zu wenig Verarbeitungskapazität zur vollen Reizanalyse vorhanden ist, dann werden Tests der höheren Hierarchie weggelassen. o und • late-selection models o Deutsch & Deutsch (1963): argumentierten, dass alle Reize ganzheitlich analysiert werden, wobei der wichtigste oder relevante Reiz die Reaktion bestimmt. Diese Theorie platziert den Flaschenhals sehr viel näher zum Reaktionsteil der Verarbeitung als bei der Theorie von Treisman. vorgestellt werden. Heute sprechen Untersuchungsergebnisse eher für die Annahme einer eher früheren Selektion und einer relativen Flexibilität des selektiven Filters. Seite 9 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Untersuchungsergebnisse zur fokussierten visuellen Aufmerksamkeit bevorzugen Eriksens und St. James’ zoom-lens- gegenüber Pashlers spotlight-model, da die Größe des visuellen Feldes bei konzentrierter Aufmerksamkeit in Abhängigkeit von der Aufgabenanforderung variiert. Beide Modelle postulieren, dass visuelle Aufmerksamkeit eher auf eine bestimmte Region im visuellen Feld gerichtet ist, wenngleich auch oftmals die Fokussierung auf bestimmte Objekte nachgewiesen wurde. Dies spricht für eine hohe Flexibilität der visuellen Linse, welche auch in ERP-Studien, bei denen weniger gründliche Verarbeitung von nicht beachteten Reizen festgestellt wurde, gezeigt werden konnte. Die Merkmalsintegrationstheorie (Feature Integration theory) von Treisman (1988; 1992) zur visuellen Suche beschreibt dabei zunächst eine rasche parallele Verarbeitung gefolgt von einem langsamen seriellen Prozess in dem Merkmale zu Bildung von Objekten zusammengefügt werden. Die serielle Suche ist langsamer als die parallele, auch hängt sie stark von der Setzgröße ab. Die visuelle Suche verläuft jedoch nicht ausschließlich parallel oder seriell. Die Suchzeiten sind normalerweise schneller als von der Theorie vorhergesagt. Die fokussierte Aufmerksamkeit erlaubt Merkmal-Objekt-Verbindungen, die vom Wissen abhängen (z.B. Bananen sind gelb). Wolfe (1998) postuliert in seiner guided-search-theory (Gesteuerte Suche Theorie) die Idee einer Aktivationskarte, in der von Anfang an gesuchte Merkmale aktiviert sind. Posner (1995) vertritt die Auffassung, dass visuelle Aufmerksamkeit die Ablösung der Konzentration von einem Stimuli, dem Wechsel der Aufmerksamkeit von einem Reiz zu einem anderen sowie die erneuten Zuweisung zu einem neuen Stimulus, beinhaltet. Untersuchungen zur geteilten Aufmerksamkeit haben gezeigt, dass Leistungen von • der Ähnlichkeit der dargebotenen Reize (Task similarity), • Übung (Practice) und • Schwierigkeit abhängen (Task difficulty). In jedem Fall konnte eine psychologische Refraktärperiode festgestellt werden, wenn sich die verwendeten Stimuli und Antworte im Hinblick auf ihre Ähnlichkeit stark unterscheiden oder aber ein anhaltendes Lernen stattfand. Als Ursache hierfür werden einerseits ein Flaschenhals in der Verarbeitung oder aber andererseits eine ausgedehnte parallele Verarbeitung diskutiert, in weiterer Folge auch die Art der Verarbeitungsressourcen. Mehrere Theorien postulieren eine automatische Verarbeitung, die auf vorangegangener Übung oder stetiger Wiederholung basiert. Diese Verarbeitung ist generell sehr schnell, implizit (unbewusst und unvermeidlich) und hat kaum Auswirkungen auf die Kapazität. So besagt die Instance-Theorie (Logan, 1988), dass Wissen über den Gebrauch verschiedener Stimuli durch Übung gesteigert wird und automatisch immer dann auftritt, wenn Informationen sehr rasch abgerufen werden. Automatismus stellt somit ein Gedächtnisphänomen dar, das von der Beziehung zwischen Enkodier- und Abrufungsprozess abhängt. Action Clips (ungeplante Aktionsausführung) im Zusammenhang mit Aufmerksamkeitsfehlern treten oftmals bei der Überwachung hochgradig geübter oder überlernter Motorprogramme auf. Kontrollierte Aufmerksamkeit ist dabei während der Ausführung eines Programms nicht notwendig, sehr wohl an kritischen Punkten, vor allem bei Wechsel oder Übergang von Programmen. Seite 10 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 VO 7: Gedächtnis Die Gedächtnispsychologie behandelt die Strukturen, Prozesse und Mechanismen, die unsere Erfahrungen für die Zukunft bereitstellen. Im Prinzip geht es um drei Prozesse: Encoding (Prozess des Übergangs vom Wahrnehmen ins Gedächtnis), Storage (Speichern von Information) und Retrieval (Wiederhervorholen aus dem Gedächtnis). Gedächtnisstrukturen: Das modale Gedächtnismodell (oder auch Mehrspeichermodell) unterscheidet zwischen dem sensorischen Speicher (Iconic memory und echoic store), einem Kurzzeitspeicher (beschränkte Kapazität – magical number 7 (7±2 Elemente)) und einem Langzeitspeicher (unbeschränkte Kapazität). Es gibt starke Beweise, die diese Vorstellung von verschiedenen, qualitativ unterschiedlichen Gedächtnisspeicher unterstützen, das Mehrspeichermodell wird jedoch sehr vereinfacht dargestellt. Es wird angenommen, dass sowohl das KZG als auch das LZG jeweils eine eigene Einheit bilden, d.h. das jeder Speicher vollkommen getrennt vom anderen arbeitet. [zu stark vereinfacht, bei KZG-Zugriffen wird automatisch auf das LZG zugegriffen, Modalitätsunterschiede (stärkere Einschränkung bei verbalem Material] Arbeitsgedächtnis: Baddeley postulierte ein einheitlichen Kurzspeicher – ein so genanntes Arbeitsgedächtnis, das aus drei Komponenten besteht. Eine phonologische Schleife (phonological loop) zur Verarbeitung und Aufrechterhaltung verbaler/auditiver Information, ein visuell-räumlicher Notizblock (visul-spatial sketchpad) zur Aufrechterhaltung visueller Vorstellung und für räumlich visuelle Information, und eine aufmerksamkeitssteuernde Instanz, die zentrale Exekutive (central executive). Diese steuert und koordiniert die Verarbeitung von Inhalten in Subsystemen. Speicherprozesse: Craik und Lockhart nahmen in ihrer Verarbeitungstheorie an, dass Prozesse, die während des Lernens ablaufen, einen großen Einfluss auf das spätere LZG haben. Die Verarbeitungstiefe, Elaboration (sorgfältige Ausführung) und Distinctiveness (Unterscheidbarkeit) wurden als wichtige Faktoren beim Lernen und Speichern identifiziert. Zu wenig Beachtung fand jedoch die Beziehung von Prozessen, die beim Lernen und Abrufen ablaufen. Andere Probleme sind, dass die Verarbeitungstheorie nicht erklärt, dass es schwer ist jene Verarbeitungsebenen festzustellen, die beim Lernen verwendet werden, und dass selbst oberflächiges Verarbeiten zu einer guten Langzeiterinnerung führen kann. Vergessenstheorien: Verschiedene Theoretiker argumentieren, dass Vergessen deswegen passiert, da es einen spontanen Verfall der Gedächtnisspuren über die Zeit gibt. Es gibt sogar eine direkte Unterstützung für diese Theorie. Freud betonte die Wichtigkeit von emotionalen Faktoren beim Vergessen. Er argumentierte, dass sehr bedrohliches oder angstauslösendes Material oft keinen Zugang zum Bewusstsein hat, und er verwendete den Begriff „Verdrängung“ (repression) für dieses Phänomen. Ein verdrängungsähnliches Phänomen wurde im Labor untersucht, und es gibt Beweise von einer Vielzahl missbrauchter Erwachsener, die verdrängte Erinnerungen an sexuellen oder physischen Missbrauch wiedererlangten. Obwohl die retroaktive (Späteres Lernen stört das vorherige Lernen) und proaktive Interferenz (Vorheriges Lernen stört das spätere Lernen) in Studien nachgewiesen wurde ( Interferenz Theorie), ist nicht klar, ob die speziellen Konditionen, die zu wirklichen Interferenzpunkten führen, im täglichen Leben vorkommen. Seite 11 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Das „cue-depended forgetting“ (hinweisabhängiges Vergessen – Information ist im Gedächtnis, aber kann nicht abgerufen werden trace-dependent forgetting (Spurabhängiges Vergessen) – Information wird nicht länger abgespeichert.) ist von großer Wichtigkeit, ebenso wie die Beziehung zwischen externen und internen Hinweisen, die beim Lernen und Testen verfügbar sind und einen großen Einfluss auf die Gedächtnisleistung haben. Kontextveränderungstheorien (context-change theory – Mit der Zeit ändert sich der Hintergrundkontext und macht es weniger wahrscheinlich, dass das Zielmaterial abgerufen wird.), die auf diesen Vorstellungen basieren, liefern glaubhafte Erklärungen für das Vergessen. Freies Reproduzieren und Wiedererkennen: Es gab viele Kontroversen darüber, ob die Prozesse beim freien Reproduzieren (recall) und Wiedererkennen (recognition) im Grunde gleich sind. Die Zwei-Prozess-Theoretiker konzentrieren sich auf Unterschiede zwischen diesen beiden Gedächtnistests. Reproduzieren beinhaltet einen Suchprozess, gefolgt von einen Entscheidungs- oder Wiedererkennungsprozess. Wiedererkennen beinhaltet nur den zweiten Prozess. Tulving, mit seinem Prinzip der Enkodierspezifität hingegen argumentierte, dass die Informationsüberschneidung beim Wiedererlangen von Umwelt und Erinnerung für beide (recall und recognition) entscheidend ist. Freies Reproduzieren erfolgt manchmal direkt, während es zu anderen Zeitpunkten indirekt erfolgt, wie z.B. beim Problemlösen. In ähnlicher Weise ereignet sich Wiedererkennen einerseits auf der Basis von Ähnlichkeit, und anderseits erfordert es manchmal bewusstes sich wieder erinnern. Es gibt keine einfache Beziehung zwischen freien Reproduzieren und Wiedererkennen. VO 7: Alltags - Gedächtnis Einleitung: Die Sicht der Alltagsgedächtnisforscher unterscheidet sich von jener der traditionellen Forscher in Fragen wie: was für, wie und wo soll Gedächtnis (-phänomene) beforscht werden. Nichtsdestotrotz wurde die Kontroverse darüber in den letzten Jahren geringer. Neisser folgend ist das Alltagsgedächtnis zweckorientiert, hat eine persönliche Komponente und ist durch Situationsvariablen beeinflusst. Autobiographisches Gedächtnis: Es handelt sich hierbei um das Gedächtnis für Ereignisse des eigenen Lebens. Es dürfte hierarchisch strukturiert sein – in Lebensabschnitte, allgemeine Lebensereignisse und ereignisspezifisches Wissen. Amnestysche Patienten können sich am besten an Lebensabschnitte erinnern, am schlechtesten sind sie im Erinnern ereignisspezifischen Wissens. Der Allgemein-EreignisLevel wurde als das wichtigste identifiziert, was aber mehr freiwillige, als unfreiwilliges Erinnern betrifft. Eine überdurchschnittlich große Menge an Erinnerungen stammt aus den Jahren zwischen dem 15. und 25. Lebensjahr – einhergehend mit der Entwicklung eines stabilen, erwachsenen Selbstbildes. Kindliche Amnesie tritt auf, weil Kleinkinder noch kein Gefühl für das Selbst und etwas ältere noch zu wenige effektive Lernstrategien entwickelt haben. Die Erinnerung ist am besten für jene autobiographischen Inhalte, die hervorstechend, emotional besetzt und angenehm sind. Seite 12 von 13 Haszonits Iris Allgemeine Psychologie I 01.06.2005 Unvergessliche Erinnerungen: Informationen über einen selbst (self-reference-effekt – Selbstbezugseffekt) und über wichtige, dramatische, überraschende, allgemeine oder persönliche Ereignisse (flashbulbmemories – Blitzlichterinnerungen) werden allgemein gut erinnert. Der self-reference-effekt durfte auftreten, weil das Selbstkonzept die Ausbildung und Organisation von Informationen unterstützt. Flashbulbmemories sind nicht nur sehr genau und sehr langjährig, sie beinhalten oft die folgenden Informationskategorien: Informant, Ort an dem die Neuigkeiten gehört wurden, aktuelle Geschehnisse, eigener emotionaler Status, emotionaler Status der Anderen, Konsequenzen des Ereignisse für Einzelne. Brown und Kulik (1977) betonen, dass flashbulbmemories sich von anderen Erinnerungen durch Langlebigkeit, Genauigkeit und Abhängigkeit von bestimmten neuronalen Mechanismen unterscheiden. Nichtsdestotrotz haben Faktoren, die mit der Produktion von flashbulbmemories in Zusammenhang stehen (z.B. Neuheitsgrad, Überraschung, individuelle Wichtigkeit, emotionale Reaktion, Wiederholungsrate) auch mit der Ausbildung normaler Erinnerungen zutun, was den Schluss zulässt, dass flashbulbmemories sich nicht grundlegend von anderen Erinnerungen unterscheiden. Augenzeugen-Berichte: Die Erinnerung des Augenzeugens an ein Ereignis ist fehleranfällig, und kann leicht durch irreführende Informationen aus der Zeit nach dem Ereignis verzerrt werden. Einige Ergebnisse basieren auf „post-event-information“ dürften die gesuchten Charakteristika einer Situation widerspiegeln, aber die meisten dürften unter Annahme von Falschinformation entstanden sein. Es wurden Techniken entwickelt, um den Informationsgehalt von Zeugenaussagen zu erhöhen. Sie basieren auf der Annahme, dass es verschiedene Zugriffsarten auf Erinnerungen gibt, und dass es demnach sinnvoll ist, verschiedene Abrufstrategien zu verwenden um die Erinnerungsleistung zu maximieren. Herausragende Erinnerungsleitungen: Die meisten Menschen mit herausragenden Gedächtnisleistungen mussten viel Zeit investieren, um spezielle Memotechniken zu erlernen, andere wiederum weisen von Natur aus ein „gutes“ Gedächtnis auf. Techniken zur Verbesserung des Gedächtnisses beinhalten meist in Beziehung stehende, zu erlernende Information in einer sinnvollen Wiese, um ein bestehendes Wissen zu erlangen, gespeicherte Schlüssel (cues) zum Wiederabruf, und ausreichende Übung um die notwendigen Prozesse zu beschleunigen. Für verschiedene Techniken wurden verschiedene Memotechniken entwickelt (z.B. Namens/Gesichts-Gedächtnis, loci-methode). Diese Techniken sind effektiv, aber haben begrenzte, sinnvolle, praktische Anwendbarkeit. Einige der Techniken sind von allgemeiner Relevanz – zum Beispiel: • • Die Schlüsselwortmethode zur Erlernung von Vokabeln einer fremden Sprache: 1.Schritt: Assoziation bilden zwischen jeden gesprochenen fremden Wort und den deutschen Wort oder gesprochenen Ausdruck 2.Schritt: Erschaffung eines mentalen Bildes mit dem Stichwort als Verbindung zwischen dem fremden Wort und dem deutschen SQ3R Methode (Survey – “Besichtigung” , Question – “Selbstbefragung”, Read – “Lesen innerhalb der Question-Stufe”, Recite – „Rezitieren“, Review – „Bewertung“) Vorausplanendes Gedächtnis: Das prospektive Gedächtnis erscheint allgemein für Routineabläufe besser, weiter für Handlungen hoher Priorität oder Handlungen eines ganzen Handlungsgefüges. • • Ereignisgebundenes prospektives Gedächtnis: Erinnern um eine Aktion innerhalb einer bestimmter äußerer Umstände auszuführen. Dieses Gedächtnis scheint verlässlicher zu sein als zeitgebundenes, das intendierte Handlungen eher durch externe Schlüsselreize ausgelöst werden. Es benötigt konzeptgeleitete Prozesse und hängt viel mit der Aufmerksamkeitsfunktion zusammen. Zeitgebundenes prospektives Gedächtnis: Erinnern um eine Aktion zu einer bestimmten Zeit auszuführen. Die Prozesse des zeitgebundenen prospektiven Gedächtnisses sind bis heute eher ungeklärt, manchmal dürften teilrelevante externe Schlüsselreize mit beteiligt sein. Seite 13 von 13