Lineare Algebra

Werbung

Kurzskript

Lineare Algebra

Wintersemester 2006/2007

und Sommersemester 2007

Prof. Dr. Joachim Rosenthal

Stand: 19. September 2007

Der erste Teil des Skriptes fasst die Vorlesung “Lineare

Algebra I” von Joachim Rosenthal aus dem Wintersemester 2006/07 zusammen; die Ergänzungsvorlesungen sind

nur zum Teil integriert worden. Der zweite Teil ist eine

Ausarbeitung der Vorlesung “Lineare Algebra II” aus dem

Sommersemester 2007.

Das Skript basiert auf Mitschriften, die mir freundlicherweise von Aljoscha Epprecht bereitgestellt worden sind.

Dafür möchte ich mich bedanken. Dieses Skript wurde in

LATEX gesetzt.

Weiterhin möchte ich mich insbesondere bei Jens Zumbrägel für das gründliche Korrekturlesen und seine vielen Korrekturen und Anmerkungen bedanken. Neben Jens

möchte ich mich noch bei Joachim Rosenthal, Philippe Logaritsch, Martin Huber und Ariel Amir für ihre Korrekturen bedanken.

Felix Fontein

Zürich, Juli 2007

ii

Inhaltsverzeichnis

1 Lineare Algebra I

1.1 Mengen und Abbildungen . . . . . . . . . . . . . . . . . . . .

1.1.1 Mengen . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.2 Abbildungen . . . . . . . . . . . . . . . . . . . . . . . .

1.1.3 Intermezzo zu Beweisen . . . . . . . . . . . . . . . . .

1.1.4 Mächtigkeit von Mengen . . . . . . . . . . . . . . . . .

1.2 Gruppen und Körper . . . . . . . . . . . . . . . . . . . . . . .

1.2.1 Der Körper der komplexen Zahlen . . . . . . . . . . . .

1.3 Gleichungssysteme und Matrizenrechnung . . . . . . . . . . .

1.3.1 Gauß-Algorithmus und elementare Zeilenumformungen

1.3.2 Matrizenrechnung . . . . . . . . . . . . . . . . . . . . .

1.4 Vektorräume . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.4.1 Erzeugendensysteme und Basen . . . . . . . . . . . . .

1.4.2 Rechnerische Probleme für Untervektorräume . . . . .

1.4.3 Lineare Gleichungssysteme: geometrische Interpretation

1.5 Ringe und Polynomringe . . . . . . . . . . . . . . . . . . . . .

1.5.1 Teilbarkeitstheorie . . . . . . . . . . . . . . . . . . . .

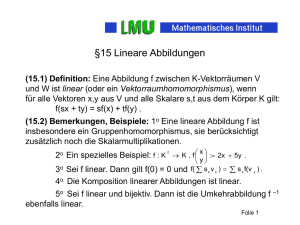

1.6 Lineare Abbildungen . . . . . . . . . . . . . . . . . . . . . . .

1.6.1 Charakterisierung von linearen Abbildungen . . . . . .

1.6.2 Der Vektorraum Hom(V, W ) . . . . . . . . . . . . . . .

1.6.3 Hintereinanderausführen von linearen Abbildungen . .

1.6.4 Basiswechsel . . . . . . . . . . . . . . . . . . . . . . . .

1.6.5 Äquivalenz von Matrizen . . . . . . . . . . . . . . . . .

1.6.6 Der Dualraum eines Vektorraums . . . . . . . . . . . .

1.6.7 Determinanten . . . . . . . . . . . . . . . . . . . . . .

1.6.8 Matrizen über Ringen . . . . . . . . . . . . . . . . . .

1.7 Eigenwerte und Eigenvektoren . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Lineare Algebra II

2.1 Basiswechsel bei Endomorphismen . . . . . . . . . . . . . . . . . . . .

2.1.1 Eigenräume . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.2 Jordan-Zerlegung . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.3 Geometrische Interpretation der verallgemeinerten Eigenräume

und Bemerkungen zur Numerik . . . . . . . . . . . . . . . . .

2.1.4 Eine algebraische Interpretation der Zerlegung in verallgemeinerte Eigenräume . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.5 Die Jordansche Normalform . . . . . . . . . . . . . . . . . . .

2.1.6 Funktionen von Matrizen . . . . . . . . . . . . . . . . . . . . .

2.1.7 Minimalpolynom und annullierende Polynome . . . . . . . . .

2.2 Quotientenvektorräume . . . . . . . . . . . . . . . . . . . . . . . . . .

iii

1

2

2

3

4

4

5

8

9

10

11

13

15

18

20

21

23

24

26

27

28

28

29

30

31

35

35

37

38

40

45

49

51

53

58

65

66

iv

INHALTSVERZEICHNIS

2.3

2.4

2.5

Skalarprodukte im Rn und Cn . . . . . . . . . . . . . . . . . . . . .

2.3.1 Bilinearformen . . . . . . . . . . . . . . . . . . . . . . . . .

2.3.2 Skalarprodukte im Rn . . . . . . . . . . . . . . . . . . . . .

2.3.3 Basiswechsel für symmetrische Bilinearformen . . . . . . . .

2.3.4 Quadratische Formen . . . . . . . . . . . . . . . . . . . . . .

2.3.4.1 Anwendung in der Analysis . . . . . . . . . . . . .

2.3.5 Gram-Schmidt-Orthogonalisierung . . . . . . . . . . . . . .

2.3.6 Orthogonale Abbildungen . . . . . . . . . . . . . . . . . . .

2.3.7 Adjungierte Endomorphismen . . . . . . . . . . . . . . . . .

2.3.8 Bilinearformen und Sesquilinearformen . . . . . . . . . . . .

2.3.8.1 Komplexifizierung . . . . . . . . . . . . . . . . . .

2.3.8.2 Reellifizierung . . . . . . . . . . . . . . . . . . . . .

2.3.8.3 Skalarprodukte auf C-Vektorräumen . . . . . . . .

2.3.9 Normale Endomorphismen . . . . . . . . . . . . . . . . . . .

2.3.10 Anwendungsbeispiel: Methode der kleinsten Quadrate . . . .

Multilineare Algebra und Tensorprodukte . . . . . . . . . . . . . . .

2.4.1 Tensorprodukte . . . . . . . . . . . . . . . . . . . . . . . . .

2.4.2 Tensoren in der Physik . . . . . . . . . . . . . . . . . . . . .

2.4.3 Raum der symmetrischen und alternierenden Tensoren . . .

2.4.4 Tensoralgebra und symmetrische Algebra . . . . . . . . . . .

2.4.5 Alternierende Tensoren . . . . . . . . . . . . . . . . . . . . .

Lineare gewöhnliche Differentialgleichungen . . . . . . . . . . . . .

2.5.1 Lineare Differentialgleichungen mit konstanten Koeffizienten

2.5.2 Beschreibung einer linearen Differentialgleichung n-ter Ordnung durch ein lineares System erster Ordnung . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

71

71

71

79

81

86

87

89

91

92

92

93

94

98

102

104

105

118

119

123

126

130

133

. 136

A Verschiedenes

139

A.1 Kombinatorik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 140

A.1.1 Kombinationen . . . . . . . . . . . . . . . . . . . . . . . . . . 140

A.1.2 Variationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . 142

Index

145

Kapitel 1

Lineare Algebra I

1

2

KAPITEL 1. LINEARE ALGEBRA I

Literatur Diese Vorlesung ist an kein spezielles Buch angelehnt. Trotzdem empfiehlt es sich, insbesondere bei Problemen, Literatur zu konsultieren, etwa um andere

Zugänge oder Beschreibungen von Problemen und Themenkomplexen kennenzulernen. Es gibt viele gute Bücher, die eine Einführung in die lineare Algebra bieten.

Wir wollen hier drei vorstellen:

• Albrecht Beutelspacher: “Lineare Algebra”. Vieweg-Verlag.

Eine anschauliche, gut verständliche Einführung in die Lineare Algebra.

• Siegfried Bosch: “Lineare Algebra”. Springer-Verlag Berlin.

• Gerd Fischer: “Lineare Algebra”. Vieweg-Verlag.

Ein sehr umfassendes, jedoch eher in einem knappen, mathematischen Stil

geschriebenes Buch.

1.1

1.1.1

Mengen und Abbildungen

Mengen

Wir arbeiten in dieser Vorlesung mit einer naiven Mengenlehre und ignorieren vorerst

die Probleme, die in einer solchen auftauchen können.

Definition 1.1.1. Eine Menge ist eine Zusammenfassung von Objekten, welche

Elemente genannt werden. Falls x ein Element einer Menge X ist, schreibt man

x ∈ X.

Wichtige Mengen

• ∅ = {} = leere Menge

• N = {0, 1, 2, . . . } = natürliche Zahlen

• Z = {. . . , −2, −1, 0, 1, 2, . . . } = ganze Zahlen

• Q = { pq | p, q ∈ Z, q 6= 0} = rationale Zahlen

• R = reelle Zahlen

• C = {a + ib | a, b ∈ R, i2 = −1} = komplexe Zahlen

• H = Hamiltonsche Quaternionen

Konstruktion von neuen Mengen

(1) Teilmenge: Sei X eine Menge und A(x) eine Aussage, die zu einem Element

x ∈ A entweder falsch oder richtig ist. Dann definiert

Y := {x ∈ X | A(x)}

eine Teilmenge von X, in der alle Elemente x ∈ X enthalten sind, für die die

Aussage A(x) gilt.

3

1.1. MENGEN UND ABBILDUNGEN

(2) Vereinigung: Sei I eine Indexmenge und zu jedem i ∈ I eine Menge Xi gegeben.

Dann definiere

[

Xi := {x | ∃i ∈ I : x ∈ Xi }.

i∈I

(3) Durchschnitt: Sei I eine Indexmenge und zu jedem i ∈ I eine Menge Xi gegeben.

Dann definiere

\

Xi := {x | ∀i ∈ I : x ∈ Xi }.

i∈I

(4) Differenz: Sind X und Y Mengen, so definiere die Differenz von X und Y als

X \ Y := {x ∈ X | x 6∈ Y }.

(5) (endliches) direktes Produkt: sind X1 , . . . , Xn Menge, so definiere

n

Y

i=1

Xi := X1 × · · · × Xn := {(x1 , . . . , xn ) | x1 ∈ X1 , . . . , xn ∈ Xn }.

Ein Element (x1 , . . . , xn ) ∈

1.1.2

Abbildungen

Qn

i=1

Xi heisst n-tupel oder kurz Tupel.

Seien X, Y Mengen. Eine Abbildung von X nach Y ist eine Vorschrift, welche jedem x ∈ X genau ein y ∈ Y zuordnet. Man schreibt:

f :X→Y

x 7→ y = f (x)

Definition 1.1.2. Sei f : X → Y eine Abbildung. Dann heisst

Im f := {y ∈ Y | ∃x ∈ X : f (x) = y}

das Bild von f , und die Menge X heisst das Urbild von f .

Bemerkung 1.1.3. Die Menge aller Abbildungen von X nach Y bildet selber eine

Menge, die mit Y X bezeichnet wird.

Definition 1.1.4. Sei f : X → Y eine Abbildung. Man sagt:

(a) f ist injektiv, falls aus x1 , x2 ∈ X mit x1 6= x2 folgt f (x1 ) 6= f (x2 );

(b) f ist surjektiv, falls Im f = Y ist;

(c) f ist bijektiv, falls f sowohl injektiv als auch surjektiv ist.

Definition 1.1.5. Ist X eine Menge, so heisst die Abbildung IdX : X → X, x 7→ x

die Identität auf X.

Definition 1.1.6 (Hintereinanderausführen von Abbildungen). Gegeben seien Abbildungen f : X → Y und g : Y → Z. Definiere eine Abbildung g ◦ f durch

g ◦ f : X → Z,

x 7→ (g ◦ f )(x) := g(f (x)).

Man spricht vom Produkt der Abbildungen. Notation:

X

f

/Y

g◦f

g

7/ Z

4

KAPITEL 1. LINEARE ALGEBRA I

Satz 1.1.7. Es sei f : X → Y eine bijektive Abbildung. Dann gibt es eine eindeutige

Abbildung g : X → Y so, dass g ◦ f = IdX und f ◦ g = IdY ist.

f ◦g

X

f

/Y

g

/X

:

f

#

/Y

g◦f

Man sagt: g ist die Umkehrabbildung von f und schreibt g = f −1 .

1.1.3

Intermezzo zu Beweisen

Die folgenden zwei “Beweise” sind falsch, wie die Endaussage deutlich zeigt. Der

interessierte Leser möge sich überlegen, welche der Umformungsschritte Äquivalenzaussagen sind (“⇔”), und welche Implikationen in nur eine Richtung sind (“⇐”

oder “⇒”):

(1)

a 2 − a2 = a 2 − a2

(a + a)(a − a) = a(a − a)

a+a=a

2a = a

2=1

(2)

−6 = − 6

4 − 10 = 9 − 15

2

2 − 2 · 2 · 25 = 32 − 2 · 3 · 52

¡ ¢2

¡ ¢2

22 − 2 · 2 · 52 + 25 = 32 − 2 · 3 · 52 + 25

¢2

¢2

¡

¡

2 − 52 = 3 − 25

2 − 52 = 3 − 52

2=3

1.1.4

Mächtigkeit von Mengen

Definition 1.1.8. Zwei Mengen X, Y heissen gleichmächtig, wenn es eine bijektive

Abbildung f : X → Y gibt.

Lemma 1.1.9. Falls X und Y gleichmächtig und Y und Z gleichmächtig sind, so

sind auch X und Z gleichmächtig.

Definition 1.1.10. Man sagt, dass eine Menge X endlich ist, wenn es eine natürliche

Zahl n ∈ N gibt so, dass X gleichmächtig wie {1, 2, . . . , n} ist (wobei man im

Fall n = 0 die Vereinbarung {1, 2, . . . , n} = ∅ trifft). In diesem Fall sagt man,

X hat die Kardinalität n und schreibt |X| = n. Ist X nicht endlich, so schreibt man

|X| = ∞.

1.2. GRUPPEN UND KÖRPER

5

Definition 1.1.11. Man sagt, dass eine Menge X abzählbar unendlich ist, wenn

X gleichmächtig wie N ist.

Definition 1.1.12. Sei X eine Menge.

(a) Man sagt, X sei abzählbar, wenn X endlich ist oder abzählbar unendlich.

(b) Ist X nicht abzählbar, so sagt man, dass X überabzählbar ist.

Lemma 1.1.13. Seien X und Y endliche Mengen. Dann gilt:

(1) |X × Y | = |X| · |Y |;

(2) |X \ Y | = |X| − |Y | wenn Y ⊆ X ist;

(3) |X ∪ Y | = |X| + |Y | − |X ∩ Y |;

¯ ¯

(4) ¯Y X ¯ = |Y ||X| .

Lemma 1.1.14. Die Mengen Z, Q und Nr für r ∈ N sind abzählbar unendlich, also

insbesondere gleichmächtig wie N.

Satz 1.1.15. Die Menge (0, 1) := {x ∈ R | 0 < x < 1} ist überabzählbar unendlich.

1.2

Gruppen und Körper

Definition 1.2.1. Sei M 6= ∅ eine Menge. Eine innere Verknüpfung auf M ist eine

Abbildung ◦ : M × M → M .

Definition 1.2.2. Eine Menge G zusammen mit einer inneren Verknüpfung ◦ :

G × G → G heisst Gruppe, wenn gilt:

(i) ◦ ist assoziativ, d.h. für alle a, b, c ∈ G gilt (a ◦ b) ◦ c = a ◦ (b ◦ c);

(ii) es gibt ein neutrales Element e ∈ G, d.h. für alle a ∈ G gilt a ◦ e = a = e ◦ a;

(iii) zu jedem a ∈ G gibt es ein b ∈ G mit a ◦ b = e = b ◦ a.

Notation 1.2.3. Ist G eine Gruppe mit Verknüpfung ◦, so schreibt man (G, ◦) für

die Gruppe.

Definition 1.2.4. Eine Gruppe (G, ◦) heisst kommutativ oder Abelsch, wenn für

alle a, b ∈ G gilt a ◦ b = b ◦ a.

Beispiele 1.2.5.

(1) (Z, +) ist eine Gruppe;

(2) (R \ {0}, ·) ist eine Gruppe;

(3) Betrachte ein gleichseitiges Dreieck ∆ und die Menge aller Drehungen G, welche

, 4π

} wenn wir jede Drehung mit

∆ auf sich selber abbilden. Dann ist G = {0, 2π

3

3

dem Drehwinkel identifizieren. Das Gruppengesetz kann dann durch folgende

Tafel beschrieben werden:

6

KAPITEL 1. LINEARE ALGEBRA I

◦

0

0

0

2π

3

4π

3

2π

3

4π

3

2π

3

2π

3

4π

3

0

4π

3

4π

3

6π

=0

3

8π

2π

=

3

3

Frage: wie sieht eine allgemeine Gruppe mit drei Elementen aus?

Lemma 1.2.6. Ist (G, ◦) eine Gruppe, so ist das neutrale Element eindeutig, d.h.

sind e, e′ ∈ G Elemente, die die Bedingung (ii) aus der Definition einer Gruppe

erfüllen, so gilt e = e′ .

Lemma 1.2.7. Sei G eine Gruppe. Dann ist zu jedem a ∈ G das inverse Element b ∈

G mit a ◦ b = e = b ◦ a eindeutig bestimmt, wobei e ∈ G das neutrale Element sei.

Notation 1.2.8. Das eindeutig bestimmte Inverse zu a ∈ G, wobei (G, ◦) eine

Gruppe ist, wird mit a−1 bezeichnet. Wenn die Gruppe additiv geschrieben wird, so

schreiben wir auch −a für a−1 .

Lemma 1.2.9. Sei (G, ◦) eine Gruppe und seien a, b, c ∈ G. Gilt a ◦ b = a ◦ c oder

b ◦ a = c ◦ a, so ist b = c.

Definition 1.2.10. Ein Körper K ist eine Menge mit zwei inneren Verknüpfungen +

und · so, dass:

(i) (K, +) eine Abelsche Gruppe ist mit neutralen Element 0 ∈ K;

(ii) (K \ {0}, ·) eine Abelsche Gruppe ist mit neutralen Element 1;

(iii) für alle a, b, c ∈ K gilt a · (b + c) = (a · b) + (a · c) und (b + c) · a = (b · a) + (c · a)

(Distributivität);

(iv) es gilt 0 6= 1.

Notation 1.2.11. Wir schreiben (K, +, ·), wenn K bezüglich der Verknüpfungen +

und · ein Körper ist.

Beispiele 1.2.12. Beispiele für Körper sind R, Q und C (siehe unten).

Definition 1.2.13. Eine Äquivalenzrelation ∼ auf einer Menge X ist dabei eine

Relation1 , welche den folgenden drei Bedingungen genügt:

(i) x ∼ x für alle x ∈ X (Reflexivität);

(ii) x ∼ y impliziert y ∼ x für alle x, y ∈ X (Symmetrie);

(iii) x ∼ y und y ∼ z impliziert x ∼ z für alle x, y, z ∈ X (Transitivität).

Die Menge X wird in disjunkte Teilmengen zerlegt, die sogenannten Äquivalenzklassen bezüglich ∼. Zu x ∈ X schreiben wir [x] für die Äquivalenzklasse von x,

also

[x] = {y ∈ X | x ∼ y}.

1

Eine (binäre) Relation auf einer Menge X ist eine Teilmenge R ⊆ X × X. Man schreibt xRy

für (x, y) ∈ R.

7

1.2. GRUPPEN UND KÖRPER

Sei n ∈ N>0 fest gewählt. Definere auf Z die Relation x ∼ y genau dann, wenn

n | (x − y), also wenn n ein Teiler von x − y ist. Dies ist eine Äquivalenzrelation. Zu

a ∈ Z ist

[a] = a + nZ := {a + nb | b ∈ Z}.

Schreibe

Zn := {[a] | a ∈ Z}

für die Menge der Äquivalenzklassen. Wir schreiben häufig a anstelle [a], wenn wir

von den Elementen aus Zn reden. Aus der Eindeutigkeit von Division mit Rest folgt,

dass

Zn = {[0], [1], . . . , [n − 1]}

ist und |Zn | = n. Definiere nun zwei Operationen + und · auf Zn :

[a] + [b] := [a + b]

und

[a] · [b] := [a · b].

Lemma 1.2.14. Diese Operationen sind wohldefiniert, d.h. ist [a] = [a′ ] und [b] =

[b′ ] für a, a′ , b, b′ ∈ Z, so ist [a + b] = [a′ + b′ ] und [ab] = [a′ b′ ].

Lemma 1.2.15. (Zn , +) ist Abelsche Gruppe mit neutralem Element 0 = [0].

Lemma 1.2.16. Die Verknüpfung · auf Zn ist assoziativ, Abelsch und hat das neutrale Element 1.

Bemerkung 1.2.17. Anstelle a ∼ b schreibt man auch oft a ≡ b (mod n) und sagt

“a ist kongruent zu b modulo n”.

Lemma 1.2.18. Ein Element [a] ∈ Zn hat genau dann ein multiplikativ Inverses,

wenn a und n teilerfremd sind, also wenn ggT(a, n) = 1 ist.

Korollar 1.2.19. Genau dann ist (Zn , +, ·) ein Körper, wenn n eine Primzahl ist.

Ist n = p eine Primzahl, so schreiben wir auch Fp für Zp .

Bemerkungen 1.2.20. Sei (K, +, ·) ein Körper.

(i) Per Konvention wird das Zeichen · bei der Multiplikationsoperation oft weggelassen, d.h. man schreibt ab anstelle a · b. Es gilt auch Multiplikation vor

Addition: ac + bc = (ac) + (bc).

(ii) Die Bedingung 1 6= 0 folgt bereits aus Bedingung (ii) der Definition eines

Körpers, da demnach (K \ {0}, ·) eine Gruppe ist, womit K \ {0} insbesondere

nicht leer ist und die 1 enthält.

(iii) Für alle a ∈ K gilt 0 · a = 0 = a · 0.

(iv) Für alle a, b, c ∈ K gilt (ab)c = a(bc) und ab = ba.

(v) Es sei a, b ∈ K. Ist ab = 0, so folgt a = 0 oder b = 0 (Nullteilerfreiheit).

(vi) Es gilt a · (−b) = −(a · b) und (−a)(−b) = ab für alle a, b ∈ K.

8

KAPITEL 1. LINEARE ALGEBRA I

1.2.1

Der Körper der komplexen Zahlen

Bezeichne mit C = R2 = {(a, b) | a, b ∈ R}. Betrachte die folgenden zwei inneren

Verknüpfungen:

• Addition: (a, b) + (c, d) = (a + c, b + d);

• Multiplikation: (a, b) · (c, d) = (ac − bd, ad + bc).

Dies ist ein Körper mit 0 = (0, 0), 1 = (1, 0) und −(a, b) = (−a, −b) und (a, b)−1 =

a

−b

( a2 +b

2 , a2 +b2 ).

Beziehung von C zu R Betrachte ϕ : R → C, r 7→ (r, 0). Dies ist injektiv. Da

(r, 0) + (r′ , 0) = (r + r′ , 0) und (r, 0) · (r′ , 0) = (rr′ , 0) ist, können wir also (r, 0) mit

der reellen Zahl r identifizieren. Weiter rechnet man r(a, b) = (ra, rb) und i2 = −1

für i := (0, 1) ∈ C. Damit zeigt man (a, b) = a + ib.

Ist z = a + ib ∈ C eine komplexe Zahl mit a, b ∈ R, so definieren wir das komplex

konjugierte zu z als z := a − ib. Weiter definieren wir den Realteil von z als ℜz := a

und den

von z als ℑz := b, und weiter den (Absolut-)Betrag von z als

√

√ Imaginärteil

2

2

|z| := zz = a + b .

Man erhält folgende Rechenregeln für u, v ∈ C:

(i) u + v = u + v;

(ii) u · v = u · v;

(iii) ℜ(u + v) = ℜu + ℜv;

(iv) ℑ(u + v) = ℑu + ℑv;

(v) |u · v| = |u| · |v|;

(vi) |u + v| ≤ |u| + |v|.

Polarkoordinaten-Beschreibung Sei z = a + ib ∈ C. Schreibe r := |z| =

√

a2 + b2 und z = a + bi = r(cos α + i sin α) für ein α ∈ R. Ist z ′ = a′ + ib′ =

r′ (cos α′ + i sin α′ ), so ist

z · z ′ = rr′ (cos(α + α′ ) + i sin(α + α′ ))

in Polarkoordinaten.

Mittels der Eulerformel cos α + i sin α = eiα lassen sich komplexe Zahlen noch

einfacher in Polarkoordinaten ausdrücken. Hierbei muss man zuerst erklären,

wie eiα

P

k

x

zu verstehen ist. Die Taylor-Entwicklung von ex ist gegeben durch ∞

k=0 k! . Damit

P

k

(iα)

ist eiα = ∞

k=0 k! .

Hat man eine komplexe Zahl in der Form z = reiα mit r, α ∈ R, so kann man z.B.

z 100 sehr einfach ausrechnen, da z 100 = r100 ei100α ist. Hat man dagegen z = a + ib

gegeben mit a, b ∈ R, so ist die Berechnung von z 100 = (a + ib)100 viel mühsamer.

Bemerkung 1.2.21. Ein Polynom f (x) der Form f (x) = xn + an−1 xn−1 + · · · + a0

mit a0 , . . . , an−1 ∈ R hat höchstens n Nullstellen, manchmal weniger.

Über C hat f immer n Nullstellen (mit Vielfachheiten gezählt). Über R ist das

nicht immer so, wie etwa das√Polynom√f (x) = x2 + 2 zeigt: es hat keine Nullstelle

in R, jedoch ist f (x) = (x + i 2)(x − i 2), womit f zwei komplexe Nullstellen hat.

1.3. GLEICHUNGSSYSTEME UND MATRIZENRECHNUNG

1.3

9

Gleichungssysteme und Matrizenrechnung

Das Ziel ist, die vollständige Lösungsmenge des linearen Gleichungssystems

n

X

aij xj = bi ,

i = 1, . . . , m

(∗)

j=1

zu beschreiben, wobei aij , bi Elemente eines Körpers K sind, i = 1, . . . , m, j =

1, . . . , n. Die Unbekannten sind hier x1 , . . . , xn .

Betrachte die Matrix

a11 · · · a1n

..

...

A := (aij ) i=1,...,m = ...

.

j=1,...,n

am1 · · · amn

und die Vektoren

x1

x := ...

und

b1

b := ... .

bm

xn

Dann können wir das Gleichungssystem (∗) auch schreiben als

Ax = b.

Dabei ist

a11

..

Ax = .

am1

definiert als

a1n

x1

.. . . .

.

xn

· · · amn

···

...

a11 x1 + · · · + a1n xn

a21 x1 + · · · + a2n xn

..

.

am1 x1 + · · · + amn xn

Pn

a

x

i=1 1i i

..

.

.

=

Pn

i=1

ami xi

Definition 1.3.1. Man nennt A die Koeffizientenmatrix von (∗) und

a11 · · · a1n b1

..

..

...

M = (A, b) = ...

.

.

am1 · · · amn bm

die erweiterte Koeffizientenmatrix von (∗).

Unser Ziel ist es, die Lösungsmenge

Lös(A, b) := {x ∈ K n | Ax = b}

zu beschreiben.

10

KAPITEL 1. LINEARE ALGEBRA I

1.3.1

Gauß-Algorithmus und elementare Zeilenumformungen

Betrachte die erweiterte Koeffizientenmatrix M = (A, b) des linearen Gleichungssystems (∗). Unter einer elementaren Zeilenoperation versteht man einen der folgenden

Prozesse:

• Typ 1: Vertauschen zweier Zeilen;

• Typ 2: Multiplikation einer Zeile mit Skalar λ ∈ K \ {0};

• Typ 3: Addition eines beliebigen Vielfachen µ ∈ K einer Zeile von M zu einer

anderen Zeile von M .

Satz 1.3.2. Sei M̃ = (Ã, b̃) eine erweiterte Koeffizientenmatrix, die aus M = (A, b)

durch einer Reihe von elementaren Zeilenumformungen entstanden ist. Dann gilt

Lös(A, b) = Lös(Ã, b̃).

Definition 1.3.3. Eine Matrix Z = (zij ) i=1,...,m ist in Zeilenstufenform, wenn gilt:

j=1,...,n

(i) es gibt ein r ∈ N mit r ≤ m so, dass die Zeilen 1, . . . , r alle nicht gleich Null

sind, und die Zeilen r + 1, . . . , m alle Null sind;

(ii) es gibt r Indices 1 ≤ j1 < · · · < jr ≤ n so, dass für alle i = 1, . . . , r gilt, dass

zij = 0 ist für j < ji und zij 6= 0 ist für j = ji .

Die Elemente ziji heissen Pivotelemente, und die Indices ji heissen Pivotindices.

Lemma 1.3.4. Angenommen, Z = (A, b) ist in Zeilenstufenform mit Pivotindices ji , i = 1, . . . , r und Pivotelementen ziji , i = 1, . . . , r. Sei A eine m × n-Matrix

und b ein m-Vektor. Dann ist Lös(A, b) = ∅ genau dann, wenn jr = n + 1 ist.

Falls jr < n + 1 ist, so kann man die Variablen x1 , . . . , xn unterteilen in n −

r freie Variablen und r abhängige Variablen und die Lösung kann iterativ geschrieben

werden; dies wird in Bemerkung 1.3.6 demonstriert.

Bemerkung 1.3.5. Die Eigenschaft

“M̃ = (Ã, b̃) ging aus M = (A, b) durch eine Reihe

von elementaren Zeilenumformungen hervor”

ist eine Äquivalenzrelation auf dem Raum der m×(n+1)-Matrizen (den erweiterten

Koeffizientenmatrizen).

Daraus ergibt sich folgende Konsequenz: Die Äquivalenzrelation unterteilt die

Menge der Koeffizientenmatrizen in Äquivalenzklassen und je zwei Elemente (A, b)

und (Ã, b̃) einer solchen Klasse haben die gleiche Lösungsmenge, also Lös(A, b) =

Lös(Ã, b̃).

Dies führt zu der Frage, ob es in jeder Äquivalenzklasse [(A, b)] von (A, b) Elemente (Ã, b̃) gibt, so dass sich Lös(Ã, b̃) besonders einfach beschreiben lässt.

1.3. GLEICHUNGSSYSTEME UND MATRIZENRECHNUNG

11

Bemerkung 1.3.6. Falls die erweiterte Koeffizientenmatrix (A, b) in Zeilenstufenform ist mit Pivotelementen aiji , i = 1, . . . , r, so kann man die Variablen xj ,

j = 1, . . . , n, unterteilen in die unabhängigen (freien) Variablen xs , s ∈ {1, . . . , n} \

{j1 , . . . , jr }, und die abhängigen Variablen xt , t ∈ {j1 , . . . , jr }, und Lös(A, b) kann

iterativ berechnet werden:

Zur Vereinfachung nehmen wir an, dass ji = i ist, 1 ≤ i ≤ r. Dies kann etwa

durch Umnummerieren der Variablen erreicht werden. Dann hat (A, b) die Form

b1

a11 ∗ · · · · · · ∗

∗ ··· ∗

..

..

..

..

... ...

.

.

.

.

0

. .

..

..

..

..

..

.. ... ...

.

.

.

.

(A, b) =

0

·

·

·

0

a

∗

∗

·

·

·

∗

b

rr

r

0 ··· ··· ··· ··· ··· ··· 0

br+1

.

.

.

..

..

..

bm

0 ··· ··· ··· ··· ··· ··· 0

Dann folgt:

(i) Lös(A, b) 6= ∅ genau dann, wenn br+1 = · · · = bm = 0;

(ii) falls es eine Lösung gibt, wähle xr+1 = λ1 , . . . , xn = λk , wobei k = n − r ist

und λ1 , . . . , λk beliebig sind. Mit

xr =

1

(br − ar,r+1 λ1 − · · · − arn λk )

arr

ergibt sich der Wert von xr , und hat man bereits xℓ+1 , . . . , xr berechnet, so

ergibt sich xℓ durch

xℓ =

1

(bℓ − aℓ,ℓ+1 xℓ+1 − · · · − aℓr xr − aℓ,r+1 λ1 − · · · − aℓn λk ).

aℓℓ

Es verbleibt nun die Frage, ob jede erweiterte Koeffizientenmatrix durch elementare Zeilenumformungen in Zeilenstufenform gebracht werden kann.

Satz 1.3.7 (Gauß). Jede m × n-Matrix lässt sich durch eine Reihe elementarer

Zeilenumformungen in Zeilenstufenform bringen.

Bemerkungen 1.3.8.

(i) Betrachtet man die Äquivalenzrelation “A geht aus à durch eine Reihe von

elementaren Zeilenumformungen hervor” auf der Menge der m × n-Matrizen,

so zeigt der Satz von Gauß, dass jede Äquivalenzklasse [A] ein Element in

Zeilenstufenform besitzt. Im Allgemeinen gibt es sogar viele solche Matrizen.

(ii) Es gibt eine reduzierte Zeilenstufenform, welche eindeutig ist. Diese Form erreicht man, indem man jede Zeile der Zeilenstufenform durch das in ihr enthaltende Pivotelement teilt (mittels je einer Typ-2-Operation) und die Elemente

oberhalb jedes Pivotelements mittels Typ-3-Operationen Null werden lässt.

1.3.2

Matrizenrechnung

Bezeichne mit Matm×n (K) die Menge aller m × n-Matrizen mit Einträgen in K.

12

KAPITEL 1. LINEARE ALGEBRA I

Addition Sind A = (aij ) und B = (bij ) zwei m × n-Matrizen, so definiert man

A + B := (aij + bij ).

Bemerkung 1.3.9. Haben die Matrizen A und B verschiedene Grössen, so ist die

Addition nicht definiert!

Lemma 1.3.10. (Matm×n (K), +) ist eine Abelsche Gruppe.

Skalarmultiplikation Ist A ∈ Matm×n (K) und λ ∈ K mit A = (aij ), so definere

λ · A := (λaij ) ∈ Matm×n (K).

Matrizenmultiplikation Sei A = (aij ) ∈ Matℓ×m (K) und B = (bjk ) ∈ Matm×n (K).

Dann definiere eine ℓ × n-Matrix A · B = (cik ) durch

cik =

m

X

aij bjk .

j=1

Bemerkungen 1.3.11.

(i) Falls die zweite Matrix nicht gleichviele Zeilen wie die erste Matrix Spalten

hat, so ist die Matrizenmultiplikation für diese zwei Matrizen nicht definiert.

(ii) Im Allgemeinen ist die Matrizenmultiplikation nicht kommutativ !

Lemma 1.3.12. Die Matrizenmultiplikation ist assoziativ.

Rechenregeln für Matrizen Falls die Multiplikation bzw. Addition definiert

sind, so gilt für Matrizen A, B, C und Skalare λ ∈ K:

(i) A(B + C) = AB + AC;

(ii) (A + B)C = AC + BC;

(iii) λ(AB) = (λA)B = A(λB).

Bemerkung 1.3.13. Wir haben gesehen, dass (Matm×n (K), +) eine Abelsche Gruppe ist. Wie steht es mit der Multiplikation? Da man zwei Matrizen A, B ∈ Matm×n (K)

nur multiplizieren kann, wenn n = m ist, müssen wir uns auf Matn×n (K) beschränken.

Lemma 1.3.14. Die Matrizenmultiplikation definiert auf Matn×n (K) eine assoziative innere Verknüpfung mit neutralem Element

1 0 ··· 0

. . . . . . ..

.

0

En := . .

.

.

.. . . . . 0

0 ··· 0 1

Definition 1.3.15. Seien A, B ∈ Matn×n (K) zwei Matrizen. Wir sagen, dass B ein

Inverses von A ist, wenn AB = En = BA ist.

13

1.4. VEKTORRÄUME

Lemma 1.3.16. Hat eine Matrix A ∈ Matn×n (K) ein Inverses, so ist dieses eindeutig.

Notation 1.3.17. Falls A ∈ Matn×n (K) ein Inverses besitzt, so bezeichnen wir

dieses mit A−1 .

Wenn nun eine Matrix A ∈ Matn×n (K) ein Inverses besitzt, kann man dieses

effektiv berechnen?

Bemerkung 1.3.18. Betrachte das Gleichungssystem

¡ ¢

AX = En

mit

X = xij i,j=1,...,n .

(Dies kann aufgefasst werden als n Gleichungssysteme der Form Ax(i) = b(i) , 1 ≤

i ≤ n, wobei x(i) die i-te Spalte von X ist und b(i) die i-te Spalte von En .) Existiert

eine Lösung X ∈ Matn×n (K), so gilt AX = En . Gilt auch XA = En ?

Lemma 1.3.19. Ist A eine Matrix und (En , B) die reduzierte Zeilenstufenform von

(A, En ), so ist B das Inverse von A, also B = A−1 .

Definition 1.3.20. Bezeichne mit Gln (K) die Menge aller n × n-Matrizen, die

Inverse besitzen, also

Gln (K) = {A ∈ Matn×n (K) | ∃B ∈ Matn×n (K) : AB = En = BA}.

Die Abkürzung Gl steht hier für general linear group.

Lemma 1.3.21. (Gln (K), ·) ist eine Gruppe bezüglich der Multiplikation.

1.4

Vektorräume

Sei K ein Körper.

Definition 1.4.1. Eine Abelsche Gruppe (V, +) zusammen mit einer Operation · :

K × V → V , (λ, v) 7→ λv heisst K-Vektorraum, wenn:

(i) die Distributivitätsgesetze gelten:

(a) (λ + µ)v = λv + µv für alle λ, µ ∈ K, v ∈ V ;

(b) λ(v + w) = λv + λw für alle λ ∈ K, v, w ∈ V ;

(ii) für die Skalarmultiplikation gilt:

(a) (λµ)v = λ(µv) für alle λ, µ ∈ K, v ∈ V ;

(b) 1v = v für alle v ∈ V .

Beispiele 1.4.2.

(a) V = K n mit

v 1 + w1

w1

v1

.. ..

..

. + . :=

.

vn

und

wn

v n + wn

λv1

v1

λ ... := ... .

vn

λvn

14

KAPITEL 1. LINEARE ALGEBRA I

(b) V = Matm×n (K) mit der gewöhnlichen Matrizenaddition und

λ(aij )ij := (λaij )ij .

(c) Der Raum der Polynome V = K[x] := {a0 + a1 x + · · · + an xn | n ∈ N, ai ∈

K, i = 0, . . . , n} mit Koeffizienten in K mit der gewöhnlichen Addition und

λ(a0 + a1 x + · · · + an xn ) := (λa0 ) + (λa1 )x + · · · + (λan )xn .

(d) V = Abb(R, R) := {f : R → R Abbildung } mit K = R. Die Addition

von f, g ∈ Abb(R, R) ist definiert durch

(f + g)(x) := f (x) + g(x)

und die Skalarmultiplikation durch

(λf )(x) := λf (x),

λ ∈ K = R.

(e) Es seien L, K Körper so, dass K ⊆ L ein Unterkörper ist, d.h. für a, b ∈ K gilt

a +K b = a +L b und a ·K b = a ·L b. Insbesondere ist dann 0K = 0L und 1K = 1L .

(Beispielsweise ist R ein Unterkörper von C.)

In dieser Situation ist L ein K-Vektorraum mit der Skalarmultiplikation

(λ, v) 7→ λv,

wobei hier λ als Element in L aufgefasst wird und dort die normale Multiplikation durchgeführt wird.

Rechenregeln in einem K-Vektorraum Sei V ein K-Vektorraum.

(i) Falls 0V ∈ V das Nullelement bezüglich der Addition ist, so gilt λ · 0V = 0V

für alle λ ∈ K.

(ii) Ist 0K ∈ K das Nullelement ist, so gilt 0K · v = 0V für alle v ∈ V .

(iii) Es gilt (−λ)v = λ(−v) = −(λv) für alle λ ∈ K und v ∈ V .

(iv) Sind λ ∈ K und v ∈ V , so gilt λv = 0 genau dann, wenn λ = 0K ist oder

v = 0V .

Definition 1.4.3. Sei V ein K-Vektorraum. Eine Teilmenge U ⊆ V heisst (K)Untervektorraum oder (K-)Unterraum von V , wenn gilt:

(i) U 6= ∅;

(ii) aus u, v ∈ U folgt u + v ∈ U ;

(iii) aus λ ∈ K und u ∈ U folgt λu ∈ U .

Bemerkung 1.4.4. Bedingungen (ii) und (iii) sind äquivalent zu:

aus u, v ∈ U und λ, µ ∈ K folgt λu + µv ∈ U.

15

1.4. VEKTORRÄUME

Beispiel 1.4.5. Sei A eine beliebige m × n-Matrix. Dann ist

Lös(A) := Lös(A, 0) = {x ∈ K n | Ax = 0}

ein K-Untervektorraum von K n .

Lemma 1.4.6. Ist U ⊆ V ein K-Untervektorraum, dann ist U zusammen mit der

auf U eingeschränkten Addition und Skalarmultiplikation wieder ein K-Vektorraum.

Lemma 1.4.7. Sei V ein K-Vektorraum, I eine beliebige Indexmenge undTzu jedem i ∈ I sei ein K-Untervektorraum Ui ⊆ V von V gegeben. Dann ist U := i∈I Ui

ebenfalls ein K-Untervektorraum von V .

Definition 1.4.8. Sei V ein K-Vektorraum und T ⊆ V eine beliebige Teilmenge.

Dann heisst

\

hT i := {U | U ⊆ V Untervektorraum, T ⊆ U }

der von T erzeugte Untervektorraum von V .

Bemerkung 1.4.9. Der von T ⊆ V erzeugte Untervektorraum von V ist nach dem

Lemma tatsächlich ein Untervektorraum. Er ist der kleinste Untervektorraum von

V , welcher T enthält.

Bemerkung 1.4.10. Der Nullvektor ist in jedem Untervektorraum enthalten.

Satz 1.4.11. Sei T 6= ∅. Dann gilt

hT i =

1.4.1

r

nX

i=1

¯

o

¯

λi vi ¯ r ∈ N, λi ∈ K, vi ∈ T für i = 1, . . . , r .

Erzeugendensysteme und Basen

Definition 1.4.12. Sei V ein K-Vektorraum und U ⊆ V ein K-Untervektorraum.

(i) Eine Teilmenge T ⊆ U heisst Erzeugendensystem von U , wenn hT i = U ist.

(ii) Der Untervektorraum U heisst endlich erzeugt, wenn es ein Erzeugendensystem T von U gibt, welches endlich ist.

Beispiel 1.4.13. Der Polynomring K[x] wird erzeugt von {1, x, x2 , . . . }, und man

kann zeigen, dass K[x] nicht endlich erzeugt ist.

Bemerkung 1.4.14. Jeder Untervektorraum U ⊆ V besitzt ein Erzeugendensystem; etwa mit T := U gilt hT i = U .

Definition 1.4.15. Sei V ein Vektorraum. Eine Teilmenge T ⊆ V heisst linear

unabhängig, wenn für jede endliche Teilmenge {v1 , . . . , vn } ⊆ T mit vi 6= vj für

i 6= j gilt, dass aus λ1 v1 +· · ·+λn vn = 0 für λ1 , . . . , λn ∈ K bereits λ1 = · · · = λn = 0

folgt. Eine Menge heisst linear abhängig, wenn sie nicht linear unabhängig ist.

Lemma 1.4.16. Folgende Bedingungen sind für eine Teilmenge T ⊆ V äquivalent:

(1) T ist linear unabhängig;

16

KAPITEL 1. LINEARE ALGEBRA I

(2) jeder Vektor v ∈ T kann eindeutig als endliche Linearkombination mit Vektoren

aus T beschrieben werden, d.h. für v gibt es eindeutige Vektoren {v1 , . . . , vn } ⊆

T , vi 6= vj für i 6= j, und eindeutige λ1 , . . . , λn ∈ K \ {0} mit v = λ1 v1 + · · · +

λn vn .

Definition 1.4.17. Sei V ein Vektorraum. Eine Teilmenge B ⊆ V heisst Basis von

V , wenn:

(1) B ein Erzeugendensystem von V ist, also hBi = V ist, und wenn

(2) B linear unabhängig ist.

Satz 1.4.18 (Basisergänzungssatz). Es sei B ⊆ V eine Menge von Vektoren.

Genau dann ist B eine Basis von V , wenn B eine maximal linear unabhängige

Menge ist, d.h. B ist linear unabhängig und jede Menge B′ ⊆ V mit B $ B′ ist

linear abhängig.

Satz 1.4.19 (Basisauswahlsatz). Es sei B ⊆ V eine Menge von Vektoren. Genau

dann ist B eine Basis von V , wenn B ein minimales Erzeugendensystem von V

ist, d.h. B ist ein Erzeugendensystem von V und jede Teilmenge B′ $ B ist kein

Erzeugendensystem von V .

Satz 1.4.20 (Hauptsatz über Basen). Jeder K-Vektorraum besitzt eine Basis.

Bemerkung 1.4.21. Im allgemeinen Fall benötigt man das Auswahlaxiom zum

Beweis des Satzes. Ist dagegen V endlich erzeugt, so folgt dies aus dem Basisauswahlsatz.

Von nun an sei V ein endlich erzeugter Vektorraum. Nach dem Basisauswahlsatz

hat V eine endliche Basis B = {v1 , . . . , vn } mit |B| = n. Wir zeigen zuerst, dass die

Zahl n nicht von B abhängt sondern nur von V .

Lemma 1.4.22 (Austauschlemma). Sei B ⊆ V eine Basis und w ∈ V \ {0} ein

Vektor. Dann gibt es einen Vektor v ∈ B so, dass

B′ := (B \ {v}) ∪ {w}

wieder eine Basis von V ist.

Satz 1.4.23 (Austauschsatz von Steinitz). Sei B = {v1 , . . . , vn } eine Basis

von V mit |B| = n. Sei C = {w1 , . . . , wm } ⊆ V eine linear unabhängige Menge mit

|C| = m. Dann ist m ≤ n und es gibt n − m Vektoren aus B, ohne Einschränkung

seien dies vm+1 , . . . , vn , so dass {w1 , . . . , wm , vm+1 , . . . , vn } eine Basis von V ist.

Korollar 1.4.24. Je zwei Basen eines endlich erzeugten Vektorraums sind gleichmächtig.

Bemerkung 1.4.25. Dies kann auch für nicht endlich erzeugte Vektorräume gezeigt

werden.

Definition 1.4.26. Sei V ein endlich erzeugter Vektorraum und B eine Basis von

V . Dann heisst dim V := |B| die Dimension von V .

Im Fall, dass V nicht endlich erzeugt ist, schreiben wir dim V = ∞. Ist V endlich

erzeugt, so sagen wir auch, dass V endlichdimensional sei.

Beispiel 1.4.27. Es ist dim K n = n für jedes n ∈ N und dim K[x] = ∞.

1.4. VEKTORRÄUME

17

Komplementärräume

Definition 1.4.28. Sei U ⊆ V ein Untervektorraum. Ein zweiter Untervektorraum U ′ ⊆ V heisst Komplementärraum von U in V , wenn

(i) hU, U ′ i = V ist und

(ii) U ∩ U ′ = {0}.

Aus dem Satz von Steinitz folgert man nun:

Satz 1.4.29. Sei V ein endlich erzeugter Vektorraum und U ⊆ V ein Untervektorraum. Dann gibt es einen Komplementärraum zu U in V .

Summe und direkte Summe von Untervektorräumen

Korollar 1.4.30. Sind U1 , U2 ⊆ V Untervektorräume, so ist

hU1 , U2 i = U1 + U2 := {u1 + u2 | u1 ∈ U1 , u2 ∈ U2 }.

Man nennt U1 + U2 die Summe der Untervektorräume U1 und U2 .

Bemerkung 1.4.31. Man kann dies auf endlich viele Untervektorräume verallgemeinern: sind U1 , . . . , Ur Unterräume von V , so ist

hU1 , . . . , Ur i = U1 + · · · + Ur := {u1 + · · · + ur | ui ∈ Ui , 1 ≤ i ≤ r}.

Satz 1.4.32 (Dimensionsformel). Ist V ein endlichdimensionaler Vektorraum

und seien U1 , U2 ⊆ V Untervektorräume. Dann gilt

dim(U1 + U2 ) = dim U1 + dim U2 − dim(U1 ∩ U2 ).

Bemerkungen 1.4.33.

(1) Sind U1 , U2 ⊆ V Komplementärräume, so hat man U1 + U2 = V und U1 ∩ U2 =

{0}. Damit gilt also dim V = dim U1 + dim U2 .

(2) In der Mengentheorie gilt eine ähnliche Formel: sind T1 , T2 Teilmengen von M ,

so gilt |T1 ∪ T2 | = |T1 | + |T2 | − |T1 ∩ T2 |.

Definition 1.4.34. Sind U1 , U2 ⊆ V zwei Untervektorräume von V mit U1 ∩ U2 =

{0}, so schreiben wir U1 ⊕ U2 für U1 + U2 und sprechen von einer (inneren) direkten

Summe.

Ist U1 ⊕ U2 eine direkte Summe, so gilt dim(U1 ⊕ U2 ) = dim U1 + dim U2 .

Satz 1.4.35. Seien U1 , U2 ⊆ V zwei Untervektorräume von V und sei V endlich

erzeugt. Dann sind äquivalent:

(i) U1 + U2 = U1 ⊕ U2 ist eine direkte Summe;

(ii) jedes x ∈ U1 + U2 kann eindeutig in der Form x = u1 + u2 mit ui ∈ Ui , i = 1, 2

geschrieben werden.

18

KAPITEL 1. LINEARE ALGEBRA I

Definition 1.4.36. Seien U1 , . . . , Ur Untervektorräume von V . Wir sagen, dass

U1 + · · · + Ur eine direkte Summe ist, wenn jedes x ∈ U1 + · · · + Ur eine eindeutige

Darstellung x = u1 + · ·L

· + ur mit ui ∈ Ui , 1 ≤ i ≤ r hat. Wir schreiben dann

U1 ⊕ · · · ⊕ Ur oder auch ri=1 Ui .

Satz 1.4.37. Seien U1 , . . . , Ur Untervektorräume von V . Dann sind folgende Bedingungen äquivalent:

(i) U1 + · · · + Ur ist direkte Summe;

P

(ii) Ui ∩ k6=i Uk = {0} für i = 1, . . . , r;

(iii) dim(U1 + · · · + Ur ) = dim U1 + · · · + dim Ur .

1.4.2

Rechnerische Probleme für Untervektorräume

Fragen

(i) Sei V ein endlich erzeugter Vektorraum und sei U = hu1 , . . . , ur i ein Untervektorraum. Sei v ∈ V .

Wie findet man rechnerisch eine Basis von U und wie entscheidet man effektiv,

ob v ∈ U ist?

(ii) Es seien U1 , U2 ⊆ V Untervektorräume. Wie berechnet man eine Basis von

U1 + U2 und wie verifiziert man, ob U1 = U2 ist?

(iii) Wie berechnet man eine Basis für U1 ∩ U2 ?

Darstellung mittels Koordinaten Im Folgenden nehmen wir an, dass V eine

Basis B = {v1 , . . . , vn } hat mit |B| = n. Betrachte die Abbildung

n

φB : K → V,

(λ1 , . . . , λn ) 7→

n

X

λk v k .

k=1

Vorsicht: Hier ist die Reihenfolge der Basiselemente wichtig! Wir nehmen im

Folgenden an, dass eine Reihenfolge fest gewählt wurde.

Lemma 1.4.38. Die Abbildung φB ist bijektiv.

Lemma 1.4.39. φB bildet Untervektorräume von K n bijektiv auf Untervektorräume

von V ab, d.h.:

n

(a) Ist U ⊆ V ein Untervektorraum, so ist Z = φ−1

B (U ) ⊆ K ein Untervektorraum;

(b) Ist Z ⊆ K n ein Untervektorraum, so ist U = φB (Z) ⊆ V ein Untervektorraum.

P

Sei U = hu1 , . . . , um i ein Untervektorraum von V , und schreibe ui = nj=1 aij vj ,

i = 1, . . . , m mit aij ∈ K. Dann ist

n

φ−1

B (ui ) = (ai1 , . . . , ain ) ∈ K .

n

Wie findet man nun eine Basis von Z = φ−1

B (U ) ⊆ K ? Es gilt

Z = {(λ1 , . . . , λm )A | λ1 , . . . , λm ∈ K}

mit

a11

..

A= .

···

...

a1n

.. .

.

am1 · · · amn

19

1.4. VEKTORRÄUME

Definition 1.4.40. Gegeben sie eine m×n-Matrix A. Der Untervektorraum Z ⊆ K n

heisst Zeilenraum von A, wenn

Z = {vA | v ∈ K m }

gilt. Man schreibt auch Z = spanZ (A). Man definiert den Zeilenrang von A durch

RangZ (A) := dim spanZ (A).

Lemma 1.4.41. Sei A eine m × n-Matrix und sei à aus A hervorgegangen durch

elementare Zeilenumformungen. Dann gilt spanZ (A) = spanZ (Ã).

Korollar 1.4.42. Sei à eine reduzierte Zeilenstufenform von A so, dass die ersten

r Zeilen von à ungleich Null sind. Dann bilden die ersten r Zeilen von à eine

K-Basis von spanZ (A). Insbesondere ist r = RangZ (A).

Zurück zur ersten Frage. Diese kann so gelöst werden:

Gegeben ein Untervektorraum U = hu1 , . . . , um i, berechne zi := φ−1

B (ui ).

Wende Gauß-Elimination auf die Matrix

z1

..

.

zm

an; dies liefert eine Matrix in Zeilenstufenform von Rang r. Die ersten

r Zeilen bilden dann eine Basis von φ−1

B (U ), und deren Bilder unter φB

eine Basis von U .

Verbleibt der zweite Teil der Frage: gegeben sei v ∈ V , ist v ∈ U ? Dazu betrachte z := φ−1

B (v) = (c1 , . . . , cn ). Die Bedingung v ∈ U ist nun äquivalent zu

z ∈ Z = φ−1

(U

)

= spanZ (A).

B

Lemma 1.4.43. Betrachte die erweiterte Matrix

µ ¶

A

.

à :=

z

Dann ist z in spanZ (A) genau dann, wenn RangZ (A) = RangZ (Ã) ist.

Nun zur zweiten Frage. Seien Z1 , Z2 die Zeilenräume von zwei Matrizen A1 , A2 ,

also Zi = spanZ (A

µ i ), ¶i = 1, 2. Gesucht ist nun eine Basis von Z1 + Z2 . Nun ist

A1

, womit die Gauß-Elimination wie bei der ersten Frage die

Z1 + Z2 = spanZ

A2

Antwort liefert.

Wie sieht man nun, ob Z1 = Z2 ist?

(1) Basierend auf dem ersten Lemma kann man überprüfen, ob

µ ¶

A1

RangZ (A1 ) = RangZ (A2 ) = RangZ

A2

ist. Dies ist genau dann der Fall, wenn Z1 = Z2 ist.

20

KAPITEL 1. LINEARE ALGEBRA I

(2) Alternativ kann man die reduzierte Zeilenstufenform von A1 und A2 berechnen;

seien diese mit Ã1 und Ã2 bezeichnet. Haben A1 und A2 das gleiche Format

(andernfalls füge Nullzeilen zur Matrix mit weniger Zeilen hinzu), so gilt: Genau

dann ist spanZ (A1 ) = spanZ (A2 ), wenn Ã1 = Ã2 ist:

Satz 1.4.44. Die reduzierte Zeilenstufenform einer Matrix ist eindeutig.

Korollar 1.4.45. Seien A1 , A2 ∈ Matm×n (K) zwei Matrizen mit reduzierten Zeilenstufenformen Ã1 , Ã2 , so gilt Ã1 = Ã2 genau dann, wenn spanZ (A1 ) = spanZ (A2 )

ist.

Definition 1.4.46. Sei A ∈ Matm×n (K). Der Spaltenraum von A ist spanS (A) :=

{Av | v ∈ K n } ⊆ K m ; dies ist ein K-Untervektorraum von K m . Der Spaltenrang

von A ist definiert als RangS (A) := dim spanS (A).

Satz 1.4.47. Für jede Matrix A ∈ Matm×n (K) gilt RangZ (A) = RangS (A).

Für den Beweis wird folgendes Hilfslemma benötigt:

Hilfslemma 1.4.48. Es sei à aus A hervorgegangen durch eine Reihe von Zeilenumformungen. Dann sind die Spalten i1 < · · · < is von A genau dann linear

abhängig, wenn die entsprechenden Spalten von à linear abhängig sind.

Definition 1.4.49. Der Rang von A ∈ Matm×n (A) sei definiert als

Rang(A) := RangS (A) = RangZ (A).

1.4.3

Lineare Gleichungssysteme: geometrische Interpretation

Es sei A eine m × n-Matrix mit Rang(A) = r und b ∈ K m . Wir sind interessiert an

dem linearen Gleichungssystem

Ax = b.

(∗)

Satz 1.4.50 (Existenz von Lösungen linearer Gleichungssysteme). Das

Gleichungssystem (∗) hat mindestens eine Lösung genau dann, wenn Rang(A) =

Rang(A, b) ist.

Satz 1.4.51 (Lösungsmenge linearer Gleichungssysteme). Sei s ∈ K n eine

Lösung von (∗) und H = {x ∈ K n | Ax = 0} der Lösungsraum des homogenen

Systems Ax = 0. Dann ist die allgemeine homogene Lösung H ⊆ K n ein Untervektorraum mit Dimension dim H = n − r, und die allgemeine Lösung von (∗) ist

gegeben durch

L = s + H = {s + h | h ∈ H}.

Definition 1.4.52. Sei V ein K-Vektorraum. Eine Teilmenge H ⊆ V heisst affiner

Unterraum von V , wenn es ein v ∈ V und einen Untervektorraum U ⊆ V gibt mit

H = v + U.

Insbesondere bilden also die Lösungen von (∗) einen affinen Unterrraum.

21

1.5. RINGE UND POLYNOMRINGE

1.5

Ringe und Polynomringe

Sei K ein Körper und

K[x] := {a0 + a1 x + · · · + an xn | n ∈ N, ai ∈ K, i = 0, . . . , n}.

Dann heisst K[x] der Polynomring über K in der Unbestimmten x. Man kann K[x]

als Unterraum von

K N = {(a0 , a1 , a2 , . . . ) | ai ∈ K, i ∈ N}

auffassen (Raum der Folgen mit Werten in K). In K[x] gibt es die folgenden Operationen:

• Addition: ist f = a0 + a1 x + · · · + an xn und g = b0 + b1 x + · · · + bm xm , ohne

Einschränkung sei m ≤ n, so ist f + g definiert als

(a0 + b0 ) + (a1 + b1 )x + · · · + (am + bm )xm + am+1 xm+1 + · · · + an xn .

Wir haben gesehen, dass K[x] eine Abelsche Gruppe ist.

• Skalarmultiplikation: ist f = a0 + a1 x + · · · + an xn und λ ∈ K, so ist

λf := (λa0 ) + (λa1 )x + · · · + (λan )xn .

Damit wird K[x] zu einem K-Vektorraum (wie wir bereits in Beispiel 1.4.2 (c)

gesehen haben).

• Man kann auf K[x] auch eine Multiplikation definieren: ist f = a0 + a1 x +

· · · + an xn und g = b0 + b1 x + · · · + bm xm , so definiere

f g :=

m+n

X

ci x

i

mit

ci :=

i=0

i

X

k=0

ak bi−k , 0 ≤ i ≤ n + m.

Mit dieser Multiplikation wird K[x] zu einem Ring:

Definition 1.5.1. Eine Menge R mit zwei inneren Verknüpfungen + und · heisst

Ring, wenn gilt:

(i) (R, +) ist eine Abelsche Gruppe;

(ii) · ist eine assoziative Verknüpfung auf R;

(iii) es gelten die Distributivgesetze r(s + t) = rs + rt und (s + t)r = sr + tr für

alle r, s, t ∈ R.

Beispiele 1.5.2.

(i) Jeder Körper ist ein Ring.

(ii) Z ist ein Ring.

(iii) Zn ist ein Ring.

(iv) Matn×n (K) ist ein Ring.

22

KAPITEL 1. LINEARE ALGEBRA I

(v) K[x] ist ein Ring.

(vi) C[x1 , . . . , xn ] (Polynomring mit n Variablen über C) ist ein Ring.

Der Ring K[x] kommt mit Einsetzungsabbildungen: Dazu sei α ∈ K. Definiere

evα : K[x] → K,

f 7→ f (α).

Diese Abbildung ist linear, d.h.

evα (f + g) = (f + g)(α) = f (α) + g(α) = evα (f ) + evα (g)

und

evα (λf ) = (λf )(α) = λf (α) = λevα (f )

für alle f, g ∈ K[x], λ ∈ K. Man sieht leicht, dass die Einsetzungsabbildungen

Ringmorphismen sind:

Definition 1.5.3. Seien R, S Ringe und f : R → S eine Abbildung. Dann heisst f

Ringhomomorphismus oder Ringmorphismus, wenn für alle a, b ∈ R gilt f (a + b) =

f (a) + f (b) und f (ab) = f (a)f (b).

Definition 1.5.4. Sei f ∈ K[x] und sei L ein Erweiterungskörper von K. Ein

Element α ∈ L heisst Nullstelle von f , wenn evα (f ) = f (α) = 0 ist.

Schliesslich besitzt jedes f ∈ K[x] einen Grad : ist f = a0 + a1 x + · · · + an xn , so

definiere grad(f ) := max{i | ai 6= 0}, wobei max ∅ := −∞ gesetzt wird. Wir können

damit die Menge

K ≤d [x] := {f ∈ K[x] | grad(f ) ≤ d}

betrachten. Es zeigt sich, dass K[x] ein (d + 1)-dimensionaler K-Vektorraum ist.

Lemma 1.5.5 (Gradformel). Es gilt grad(f g) = grad(f ) + grad(g), wobei man

−∞ + x = −∞ definiert für alle x ∈ N ∪ {−∞}.

Bemerkung 1.5.6. Weiterhin gilt grad(f + g) ≤ max{grad(f ), grad(g)}, wobei im

Falle grad(f ) 6= grad(g) Gleichheit gilt.

Man kann sich folgende fundemantale Fragen stellen:

(i) Gegeben sei f ∈ K ≤d [x]. Gesucht sind alle α ∈ K (oder alle Elemente aus

einem Erweiterungskörper) so, dass evα (f ) = f (α) = 0 ist.

In anderen Worten: Wo sind die Nullstellen von f ?

Die Antwort hierauf liefert im wesentlichen der Fundamentalsatz der Algebra

(siehe unten).

(ii) Gegeben seien α1 , . . . , αt ∈ K und β1 , . . . , βt ∈ K. Gesucht sind alle Polynome

in f ∈ K ≤d [x] mit f (αi ) = βi , 1 ≤ i ≤ t.

Die Antwort auf diese Frage wird durch Lagrange-Interpolation gegeben (siehe

unten).

Satz 1.5.7 (Fundamentalsatz der Algebra). Es sei f ∈ K[x] ein Polynom von

Grad d mit höchstem Koeffizienten 1, d.h. f = xd + ad−1 xd−1 + · · · + a1 x + a0 .

23

1.5. RINGE UND POLYNOMRINGE

(a) Es gibt höchstens d verschiedene Elemente α1 , . . . , αk ∈ F ⊇ K, wobei F ein

beliebiger Oberkörper von K ist, so dass f (αi ) = 0 ist, 1 ≤ i ≤ k.

(b) Es gibt einen Oberkörper F von K und Elemente α1 , . . . , αd ∈ F so, dass

d

Y

f=

(x − αi )

i=1

ist.

Ein Beweis wird in der Vorlesung ‘Einführung in die Algebra’ gegeben.

Weiterhin gibt es zu jeden Körper K einen Erweiterungskörper L so, dass jedes

nicht-konstante Polynom über K mindestens eine Nullstelle in L hat. Ein minimaler

solcher Körper L heisst algebraischer Abschluss von K. Kann man L = K wählen,

so heisst K algebraisch abgeschlossen.

Ist etwa K = R, so ist L = C ein algebraischer Abschluss von K. Ist dagegen

K = Q und L = C, so hat jedes Polynom mit Koeffizienten in K eine Nullstelle in

L, jedoch ist L nicht minimal.

1.5.1

Teilbarkeitstheorie

Definition 1.5.8. Seien f, g ∈ K[x].

(a) Man sagt f teilt g, wenn es ein Polynom h ∈ K[x] gibt mit g = f · h.

(b) Ein Polynom h ∈ K[x] heisst gemeinsamer Teiler von f und g, wenn h sowohl

Teiler von f als auch von g ist.

(c) Ein Polynom h ∈ K[x] heisst grösster gemeinsamer Teiler von f und g, wenn

h gemeinsamer Teiler von f und g ist und für jeden anderen gemeinsamen

Teiler h′ gilt, dass h′ ein Teiler von h ist.

Satz 1.5.9 (Polynomdivision). Seien f, g ∈ K[x] mit g 6= 0. Dann gibt es

eindeutig bestimmte Polynome q, r ∈ K[x] mit grad(r) < grad(g) so, dass f = q·g+r

ist.

Bemerkung 1.5.10 (Euklidischer Algorithmus). Seien f, g ∈ K[x] gegeben

mit g 6= 0. Setze r0 := g und r−1 := f . Berechne iterativ

ri−1 = qi+1 ri + ri+1 mit grad(ri+1 ) < grad(ri ),

i = 0, 1, 2, . . . , bis rk 6= 0 und rk+1 = 0 ist. Dann ist rk ein grösster gemeinsamer

Teiler von f und g.

Lemma 1.5.11 (Bezóut). Seien f, g ∈ K[x] mit f 6= 0 6= g. Dann gibt es

Polynome a, b ∈ K[x] so, dass af + bg ∈ K[x] ein grösster gemeinsamer Teiler

von f und g ist. Man kann a und b effektiv mit Hilfe des Euklidischen Algorithmus

berechnen.

Lemma 1.5.12. Sei f ∈ K[x] und α ∈ K. Genau dann ist f (α) = 0, wenn x − α

ein Teiler von f ist.

Definition 1.5.13. Sei f ∈ K[x] und α ∈ K. Wir sagen, α sei eine Nullstelle mit

Vielfachheit k von f , wenn (x − α)k ein Teiler von f ist, (x − α)k+1 dagegen nicht.

Q

Bemerkung 1.5.14. Kann man f = ki=1 (x − αi )ei schreiben mit paarweise verschiedenen αi ∈ L, wobei L ein Erweiterungskörper von K ist (etwa wie im Fundamentalsatz), so kann man zeigen, dass diese Darstellung bis auf Umordnung der αi

eindeutig ist, und dass ei die Vielfachheit der Nullstelle αi ist.

24

KAPITEL 1. LINEARE ALGEBRA I

Beweis des Fundamentalsatzes (Skizze) Wenn α eine Nullstelle von f in einem Oberkörper ist (also f (α) = 0), so kann man also f = (x − α) · g schreiben mit

g ∈ K[x]. Weiterhin sieht man wegen der Nullteilerfreiheit von K, dass

{β ∈ K | f (β) = 0} = {β ∈ K | g(β) = 0} ∪ {α}

ist. Per Induktion nach grad(f ) erhält man somit die erste Aussage.

Lagrange-Interpolation Es seien α1 , . . . , αk verschiedene Elemente von K und

β1 , . . . , βk beliebige Elemente in K. Dann existiert genau ein Polynom f ∈ K <k [x] :=

K ≤k−1 [x] mit f (αi ) = βi für 1 ≤ i ≤ k.

Das gesuchte Element f liegt in evα−11 (β1 ) ∩ · · · ∩ evα−1k (βk ).

Idealtheorie Sei R ein kommutativer Ring mit Eins, also etwa R = Z, R = K[x]

oder R = Zn .

Definition 1.5.15. Eine Teilmenge I ⊆ R heisst Ideal, wenn

(i) (I, +) eine Untergruppe von (R, +) ist und

(ii) für alle r ∈ R und i ∈ I bereits ri ∈ I gilt.

Beispiele 1.5.16.

(a) Ist r ∈ R, so ist rR = {rr′ | r′ ∈ R} ein Ideal. Dann ist (r) := rR das kleinste

Ideal, welches a enthält, da jedes weitere Ideal, welches a enthält, bereits (a)

umfassen muss.

(b) Sind a1 , . . . , an ∈ R, so ist (a1 , . . . , an ) := a1 R + · · · + an R = (a1 ) + · · · + (an )

das kleinste Ideal, welches a1 , . . . , an umfasst.

Beispiele 1.5.17.

(a) Im Spezialfall R = Z ist (a, b) = (c), wenn c ein grösster gemeinsamer Teiler

von a und b ist.

(b) Ebenso gilt in R = K[x], dass (f, g) = (h) ist, wenn h ein grösster gemeinsamer

Teiler von f und g ist.

1.6

Lineare Abbildungen

Definition 1.6.1. Seien V, W zwei K-Vektorräume. Eine Abbildung f : V → W

heisst (K-)linear genau dann, wenn

(i) f (v1 + v2 ) = f (v1 ) + f (v2 ) für alle v1 , v2 ∈ V und

(ii) f (λv) = λf (v) für alle λ ∈ K, v ∈ V gilt.

Man spricht auch von einem (K-linearen) Homomorphismus (strukturerhaltende

Abbildung).

25

1.6. LINEARE ABBILDUNGEN

Beispiele 1.6.2.

(a) Die R-linearen Abbildungen f : R → R sind alle von der Form x 7→ cx für

c := f (1).

(b) Ist A ∈ Matm×n (K), so definiert f : K n → K m , x 7→ Ax eine lineare Abbildung.

(c) Sei V ein n-dimensionaler Vektorraum mit Basis {v1 , . . . , vn }. Dann ist

n

φB : K → V,

(λ1 , . . . , λn ) 7→

n

X

λi v i

i=1

eine bijektive (siehe oben) lineare Abbildung.

(d) Sei V = C ∞ (R, R) der R-Vektorraum der unendlich oft stetig differenzierbaren

df

d

Abbildungen R → R. Dann ist dx

: V → V , f 7→ dx

eine R-lineare Abbildung.

Bemerkung 1.6.3. Die Bedingungen (i) und (ii) aus der Definition einer linearen

Abbildung sind äquivalent zu der Bedingung

“für alle λ1 , λ2 ∈ K und v1 , v2 ∈ V gilt f (λ1 v1 + λ2 v2 ) = λ1 f (v1 ) + λ2 f (v2 ).”

Definition 1.6.4. Sei f : V → W eine lineare Abbildung.

(a) Wir sagen, dass f ein Endomorphismus ist, wenn V = W ist.

(b) Wir sagen, dass f ein Monomorphismus ist, wenn f injektiv ist.

(c) Wir sagen, dass f ein Epimorphismus ist, wenn f surjektiv ist.

(d) Wir sagen, dass f ein Isomorphismus ist, wenn f bijektiv ist.

(e) Wir sagen, dass f ein Automorphismus ist, wenn V = W und f bijektiv ist.

Lemma 1.6.5. Sei f : V → W linear.

(i) Es gilt f (0V ) = 0W .

(ii) Es gilt f (−v) = −f (v) für alle v ∈ V .

Satz 1.6.6. Sei f : V → W eine lineare Abbildung.

(a) Falls U ⊆ V ein Untervektorraum ist, so ist f (U ) ⊆ W ebenfalls ein Untervektorraum.

(b) Ist andersherum U ′ ⊆ W ein Untervektorraum, so ist f −1 (U ′ ) ⊆ V ein Untervektorraum.

Lineare Abbildungen bilden also Untervektorräume auf Untervektorräume ab.

Einige wichtige Spezialfälle des Satzes:

• Im f := f (V ) ⊆ W ist ein Untervektorraum von W ;

• Ker f := f −1 (0) = {v ∈ V | f (v) = 0} ist ein Untervektorraum von V .

Definition 1.6.7. Sei f : V → W eine lineare Abbildung.

26

KAPITEL 1. LINEARE ALGEBRA I

(i) Der Untervektorraum Ker f = f −1 (0) = {v ∈ V | f (v) = 0} heisst Kern von

f.

(ii) Der Untervektorraum Im f = f (V ) heisst Bild von f .

Lemma 1.6.8. Eine lineare Abbildung f : V → W ist genau dann ein Monomorphismus, wenn Ker f = {0} ist.

Lemma 1.6.9. Sei I eine Indexmenge. Seien V, W Vektorräume und B = {vi | i ∈

I} eine Basis von V . Genau dann ist f ein Monomorphismus, wenn {f (vi ) | i ∈ I}

linear unabhängig ist und f (vi ) 6= f (vj ) ist für i 6= j.

Korollar 1.6.10. Es sei V ein endlichdimensionaler Vektorraum und f : V → W

ein Monomorphismus. Dann ist dim(V ) = dim(Im f ).

Lemma 1.6.11. Sei I eine Indexmenge. Seien V, W Vektorräume und B = {vi |

i ∈ I} eine Basis von V .

(a) Genau dann ist f ein Epimorphismus, wenn {f (vi ) | i ∈ I} ein Erzeugendensystem von W ist.

(b) Genau dann ist f ein Isomorphismus, wenn {f (vi ) | i ∈ I} eine Basis von W

ist und f (vi ) 6= f (vj ) ist für i 6= j.

Lemma 1.6.12. Sei die Abbildung f : K n → K m definiert durch x 7→ Ax für ein

A ∈ Matm×n (K).

(a) Genau dann ist f ein Monomorphismus, wenn n = Rang(A) ≤ m gilt.

(b) Genau dann ist f ein Epimorphismus, wenn m = Rang(A) ≤ n gilt.

(c) Genau dann ist f ein Isomorphismus, wenn n = m = Rang(A) gilt.

Korollar 1.6.13. Sei f : V → W eine lineare Abbildung. Ist f ein Monomorphismus, so gilt dim(V ) ≤ dim(W ). Ist f ein Isomorphismus, so gilt dim(V ) = dim(W ).

1.6.1

Charakterisierung von linearen Abbildungen

Satz 1.6.14. Seien V, W beliebige K-Vektorräume und I eine Indexmenge so, dass

B = {vi | i ∈ I} eine Basis von V ist, und sei T = {wi | i ∈ I} eine Teilmenge von

W . Dann gibt es genau eine lineare Abbildung f : V → W mit f (vi ) = wi für alle

i ∈ I.

Eine lineare Abbildung ist eindeutig beschrieben durch die Werte der Abbildung

auf einer Basis.

Seien V und W endlichdimensionale Vektorräume mit dim V = n und dim W =

m, sei BV = {v1 , . . . , vn } eine Basis von V und BW = {w1 , . . . , wm } eine Basis von

W . Ist f : V → W eine lineare Abbildung, so ist f nach obigen eindeutig durch

die Bilder f (vi ), i = 1, . . . , n beschrieben. Da BW eine Basis von W ist, können wir

f (vj ) als Linearkombination der wi s schreiben, etwa

f (vj ) =

m

X

i=1

aij wi ,

j = 1, . . . , n.

27

1.6. LINEARE ABBILDUNGEN

Dann ist

···

...

a11

..

(f (v1 ), . . . , f (vn )) = (w1 , . . . , wm ) .

a1n

.. .

.

am1 · · · amn

Hierbei verwenden wir folgende Notation:

Sind v1 , . . . , vm Vektoren aus einem beliebigen K-Vektorraum V und ist

A = (aij )ij ∈ Matm×n (K) eine Matrix, so soll (v1 , . . . , vm )A das n-tupel

m

m

³X

´

X

aj1 vj , . . . ,

ajn vj ∈ V n

j=1

j=1

sein, wobei A = (aij ) sei.

Man nennt A := (aij ) ∈ Matm×n (K) die zu f zugehörige Transformationsmatrix

und schreibt

fBBWV := A.

Lemma 1.6.15. In der Situation von oben gilt für alle λ1 , . . . , λn ∈ K

f (λ1 v1 + · · · + λn vn ) = φBW (A(λ1 , . . . , λn )),

also insbesondere gilt

mit

f = φBW ◦ fˆ ◦ φ−1

BV

fˆ : K n → K m ,

x 7→ Ax.

Korollar 1.6.16. Es seien V und W endlichdimensionale Vektorräume und f :

V → W eine lineare Abbildung. Seien BV bzw. BW Basen von V bzw. W , und

sei dim V = n und dim W = m. Sei A = fBBWV . Dann induziert φBV : V → K n

einen Isomorphismus Ker f → {x ∈ K n | Ax = 0} und φBW : W → K m einen

Isomorphismus Im f → spanS (A). Insbesondere ist Rang(A) = dim(Im f ).

1.6.2

Der Vektorraum Hom(V, W )

Definition 1.6.17. Es seien V und W K-Vektorräume. Die Menge aller K-linearen

Abbildungen f : V → W bezeichnen wir mit Hom(V, W ).

Lemma 1.6.18. Die Menge Hom(V, W ) hat die Struktur eines K-Vektorraums,

wenn man die Addition per

(f + g)(v) := f (v) + g(v)

und die Skalarmultiplkation per

(λf )(v) := λf (v)

definiert, λ ∈ K, f, g ∈ Hom(V, W ).

Satz 1.6.19. Es seien V und W Vektorräume mit dim V = n < ∞ und dim W =

m < ∞. Sei BV = {v1 , . . . , vn } eine Basis von V und BW = {w1 , . . . , wm } eine

Basis von W . Dann ist die Abbildung

ϕ : Hom(V, W ) → Matm×n (K),

f 7→ fBBWV

ein Isomorphismus. Insbesondere gilt also

dim(Hom(V, W )) = dim(Matm×n (K)) = dim(V ) · dim(W ).

28

KAPITEL 1. LINEARE ALGEBRA I

1.6.3

Hintereinanderausführen von linearen Abbildungen

Satz 1.6.20. Seien V , W und U drei endlichdimensionale Vektorräume und seien f : V → W und g : W → U lineare Abbildungen. Sei BV eine Basis von V , BW

eine Basis von W und BU eine Basis von U . Dann gilt

(g ◦ f )BBVU = gBBUW · fBBWV .

Isomorphismen Sei f : V → W ein Isomorphismus.

Lemma 1.6.21. Die inverse Abbildung f −1 : W → V ist wieder ein Isomorphismus.

Satz 1.6.22. Sei f : V → W ein Homomorphismus zwischen endlichdimensionalen

Vektorräumen gleicher Dimension. Ist A = fBBWV die Transformationsmatrix von f ,

so ist A genau dann invertierbar, wenn f ein Isomorphismus ist.

Bemerkung 1.6.23. Wir haben gesehen, dass Hom(V, W ) isomorph zu Matm×n (K)

ist wenn dim V = n und dim W = m ist. Ist V = W , so ist Hom(V, W ) also

isomorph zu der K-Algebra Matn×n (K) (eine K-Algebra ist ein Ring, der eine zur

Ringstruktur kompatible K-Vektorraum-Struktur hat). Die Automorphismen f :

V → V entsprechen unter dem Isomorphismus Hom(V, V ) → Matn×n (K) gerade

den Elementen aus Gln (K).

Dimensionsformel für lineare Abbildungen

Satz 1.6.24 (Dimensionsformel). Sei f : V → W eine lineare Abbildung zwischen endlichdimensionalen K-Vektorräumen V und W . Dann gilt

dim(Ker f ) + dim(Im f ) = dim(V ).

1.6.4

Basiswechsel

Man hat eine lineare Abbildung f : V → W , wobei V, W endlichdimensional sind.

Sei f beschrieben in Bezug auf die Basen BV = {v1 , . . . , vn } und BW = {w1 , . . . , wm },

wobei dim V = n und dim W = m sei. Seien nun zwei weitere Basen B̂V =

{v̂1 , . . . , v̂n } von V und B̂W = {ŵ1 , . . . , ŵm } von W gegeben. Wie kann man nun

fB̂B̂V aus fBBWV und den Koordinatentransformationen berechnen?

W

Dazu sei S die Matrix, welche (v̂1 , . . . , v̂n ) = (v1 , . . . , vn )S erfüllt, also die Transformationsmatrix (IdV )B̂BVV , und sei T = (IdW )B̂BW

.

W

Satz 1.6.25. Es gilt

¡

¢−1 BV

fB̂B̂V = T −1 fBBWV S = (IdW )B̂BW

fBW (IdV )B̂BVV .

W

W

Dazu ein kleines Diagramm:

B

BV

fB V =A

W

VO

BW

T

S

B̂V

/W

O

V

f

B̂V

B̂W

=T −1 AS

/W

B̂W

29

1.6. LINEARE ABBILDUNGEN

Bemerkung 1.6.26. Sei V = W . Es macht Sinn, BV = BW und B̂V = B̂W zu

wählen. Wie sieht dann fBBVV in Bezug auf fB̂B̂V aus, wenn f : V → V ein EndomorV

phismus ist? Ist S =

IdB̂BVV

, so ist nach dem Satz

fB̂B̂V = S −1 fBBVV S.

V

Dies wirft die folgende, prinzipielle Frage auf: wenn ein Homomorphismus f :

V → W gegeben ist, wie kann man eine Basis BV von V und eine Basis BW von W

so wählen, dass fBBWV besonders “einfach” ist?

Satz 1.6.27. Seien V, W endlichdimensionale Vektorräume und sei dim V = n,

dim W = m. Ist f : V → W eine lineare Abbildung, so gibt es Basen BV von V und

BW von W so, dass mit r := dim(Im f ) gilt

1

0

..

.

0

0

BV

1

fBW =

∈ Matm×n (K),

0

0

wobei der obere linke Block die Grösse r × r hat.

1.6.5

Äquivalenz von Matrizen

Definition 1.6.28. Seien A, B ∈ Matm×n (K). Wir sagen, dass A und B äquivalent

sind, wenn es invertierbare Matrizen R ∈ Glm (K) und S ∈ Gln (K) gibt mit A =

RBS.

Lemma 1.6.29. Die Äquivalenz von Matrizen ist eine Äquivalenzrelation auf der

Menge Matm×n (K).

Satz 1.6.30. Es gibt genau min{m, n}+1 Äquivalenzklassen auf Matm×n (K), welche

repräsentiert werden durch die Matrizen

¶

µ

Er 0

∈ Matm×n (K),

r ∈ {0, 1, . . . , min{m, n}}.

0 0

Korollar 1.6.31. Zwei Matrizen A, B ∈ Matm×n (K) sind genau dann äquivalent,

wenn Rang(A) = Rang(B) ist.

Ähnlichkeit für Endomorphismen Wir wollen eine weitere Äquivalenzrelation

betrachten.

Definition 1.6.32. Zwei Matrizen A, B ∈ Matn×n (K) heissen ähnlich, wenn es

eine invertierbare Matrix S ∈ Gln (K) gibt mit A = S −1 BS.

Lemma 1.6.33. Die so definierte Ähnlichkeit ist eine Äquivalenzrelation auf der

Menge Matn×n (K).

30

KAPITEL 1. LINEARE ALGEBRA I

Bemerkung 1.6.34. Zwei Matrizen A, C ∈ Matn×n (K) sind also genau dann

ähnlich, wenn es einen Endomorphismus f : K n → K n und zwei Basen B und

B̂ von K n gibt mit fBB = A und fB̂B̂ = C

Die Klassifizierung der Äquivalenzklassen ist in diesem Fall wesentlich schwieriger

als im Fall der im letzten Abschnitt definierten Äquivalenz. Dies wird erst in der

Linearen Algebra II vollständig beantwortet, und dort auch nur im Fall, dass der

Körper algebraisch abgeschlossen ist.

1.6.6

Der Dualraum eines Vektorraums

Definition 1.6.35. Sei V ein K-Vektorraum. Der Dualraum V ∗ von V ist definiert

als V ∗ := Hom(V, K).

P

Beispiel 1.6.36. Für A ∈ Matn×n (K) mit A = (aij ) definiere Spur(A) := ni=1 aii .

Dann ist Spur ∈ Matn×n (K)∗ .

Ist V n-dimensional, so ist Hom(V, K) isomorph zu Mat1×n (K). Insbesondere ist

dann also dim V ∗ = n. Sei BV = {v1 , . . . , vn } eine Basis von V . Wenn wir die Basis

{1} von K wählen, dann ist der Isomorphismus V ∗ → Mat1×n (K) explizit gegeben

durch

f 7→ (f (v1 ), . . . , f (vn )).

Wir wählen die kanonische Basis {f1 , . . . , fn } von Mat1×n (K) mit

fi = (0, . . . , 0, 1, 0, . . . , 0),

wobei die 1 in der i-ten Komponente steht, 1 ≤ i ≤ n. Dann entsprechen die fi

über den Isomorphismus V ∗ → Hom1×n (K) den Homomorphismen fˆi : V → K, die

durch

(

1 für i = j

fˆi : V → K,

vj 7→ fi (vj ) = δij :=

0 für i 6= j

gegeben sind, 1 ≤ i ≤ n.

Definition 1.6.37. Wir bezeichnen die duale Basis zu BV mit BV∗ := {fˆ1 , . . . , fˆn }.

Wir haben also unter anderem gezeigt:

Satz 1.6.38. Ist dim V = n, so ist dim V ∗ = n. Ist BV eine Basis von V , so ist BV∗

eine Basis von V ∗ .

Der Doppeldualraum V ∗∗

Es ist

V ∗∗ = (V ∗ )∗ = {f : V ∗ → K | f linear }

der Doppeldualraum von V .

Satz 1.6.39. Durch

ϕ : V → V ∗∗ ,

v 7→ v ∗∗ :

(

V∗ →K

f 7→ f (v)

ist ein basisunabhängiger Isomorphismus gegeben.

Solche basisunabhängigen Abbildungen werden oft als natürliche Abbildungen

bezeichnet.

1.6. LINEARE ABBILDUNGEN

1.6.7

31

Determinanten

Axiomatische Definition der Determinante nach Weierstraß

Definition 1.6.40. Eine Abbildung det : Matn×n (K) → K heisst Determinante,

falls:

(i) det multilinear ist, d.h. sind v1 , . . . , vn ∈ K n und ṽi ∈ K n und sind λ, µ ∈ K,

so gilt

v1

v1

v1

..

..

..

.

.

.

vi−1

vi−1

vi−1

det λvi + µṽi = λ det vi + µ det ṽi ;

vi+1

vi+1

vi+1

..

...

...

.

vn

vn

vn

(ii) det alternierend ist, d.h. falls A zwei gleiche Zeilen hat, so ist det A = 0;

(iii) det normiert ist, d.h. det En = 1.

Satz 1.6.41 (Hauptsatz über Determinanten). Zu jedem n gibt es genau eine

Determinante det : Matn×n (K) → K.

Der Beweis wird erst später geführt. Wir wollen zunächst einige Konsequenzen

aus der Definition herleiten.

Lemma 1.6.42. Ist A ∈ Matn×n (K), λ ∈ K und det eine Determinante, so ist

det(λA) = λn det(A).

Lemma 1.6.43. Ist A eine Matrix und B eine Matrix, die durch eine elementare

Zeilenumformung von Typ 1 aus A entsteht (also durch Vertauschen zweier Zeilen),

so gilt det(B) = − det(A) für jede Determinate det.

Bemerkung 1.6.44. Die Bezeichnung “alternierend” für die Eigenschaft (ii) der

Determinatendefinition stammt aus dieser Eigenschaft.

Ist umgekehrt det : Matn×n (K) → K eine multilineare Abbildung so, dass der

Tausch zweier Zeilen zu einem Vorzeichenwechsel führt, und ist 1 + 1 6= 0 in K, so

folgt det(A) = 0.

Lemma 1.6.45. Ist λ ∈ K und entsteht B aus A durch Addition des λ-fachen

der i-ten Zeile zur j-ten Zeile (also durch eine Zeilenoperation vom Typ 3), so ist

det A = det B für jede Determinante det.

Lemma 1.6.46. Hat A ∈ Matn×n (K) eine Nullzeile, so gilt det(A) = 0 für jede

Determinante det.

Lemma 1.6.47. Ist A eine obere Dreiecksmatrix, also von der Form

λ1 ∗ · · · ∗

. . . . . . ..

.

0

A=. .

,

.

.. .. ∗

..

0 · · · 0 λn

und ist det eine Determinante, so gilt

det(A) = λ1 · · · λn .

32

KAPITEL 1. LINEARE ALGEBRA I

Mit den vorhergehenden Lemmata folgt, dass wir die Determinante einer beliebigen Matrix effektiv ausrechnen können und das die Determinante eindeutig ist

(wenn sie denn existiert): Jede Matrix A ∈ Matn×n (K) kann durch elementare Zeilenumformungen in Zeilenstufenform gebracht werden, und jede Zeilenstufenform

enthält entweder eine Nullzeile oder ist eine obere Dreiecksmatrix.

Bei Zeilenumformungen von Typ 1 (Vertauschen zweier Zeilen) wechselt das Vorzeichen der Determinante, bei Operationen von Typ 2 (Multiplizieren einer Zeile mit

einer Konstanten 6= 0) wird die Determinante mit dieser Konstanten multipliziert,

und bei Operationen von Typ 3 (Addition des λ-fachen einer Zeile zu einer anderen)

ändert sich die Determinante nicht. Und sobald eine Zeilenstufenform vorliegt, hat

man entweder eine Nullzeile (und die Determinante ist 0) oder eine obere Dreiecksmatrix und kann somit den Wert der Determiante ausrechen. Da diese Regeln für

alle Determinanten gelten, das Ergebnis aber unabhängig von der Determinantenfunktion ist, gibt es somit höchstens eine Determinante.

Satz 1.6.48. Sei A ∈ Matn×n (K). Angenommen, es existiere eine Determinante det. Dann sind folgende Eigenschaften äquivalent:

(i) A ist invertierbar;

(ii) die Zeilen von A sind linear unabhängig;

(iii) die Spalten von A sind linear unabhängig;

(iv) für jedes b ∈ K n hat das Gleichungssystem Ax = b eine Lösung;

(v) det(A) 6= 0;

(vi) die reduzierte Zeilenstufenform von A ist En ;

(vii) es ist Rang(A) = n.

Satz 1.6.49 (Determinantenproduktsatz). Seien A, B ∈ Matn×n (K). Ist det

eine Determinante, so gilt det(AB) = det(A) det(B).

Die symmetrische Gruppe Sn Um eine konkrete Determinantenfunktion nach

Leibniz anzugeben, benötigen wir die symmetrische Gruppe.

Definition 1.6.50. Wir bezeichnen mit Sn die Menge der bijektiven Abbildungen π :

{1, . . . , n} → {1, . . . , n}. Diese Abbildungen heissen Permutationen und Sn heisst

die symmetrische Gruppe.

Bemerkung 1.6.51. Sind π, σ ∈ Sn , so ist π ◦ σ ∈ Sn .

Satz 1.6.52. (Sn , ◦) ist eine Gruppe der Ordnung n!, wobei n! :=

von n ist.

Qn

i=1

i die Fakultät

Definition 1.6.53. Eine Permutation τ ∈ Sn heisst Transposition, wenn es Indices j, k gibt mit 1 ≤ j < k ≤ n so, dass τ (j) = k, τ (k) = j ist und τ (i) = i für

i ∈ {1, . . . , n} \ {j, k}.

Lemma 1.6.54. Jede Permutation π ∈ Sn lässt sich als endliches Produkt von

Transpositionen schreiben.

33

1.6. LINEARE ABBILDUNGEN

Bemerkungen 1.6.55.

(1) Es ist sogar möglich, eine beliebige Permutation als Produkt von benachbarten

Transpositionen zu schreiben, also von Transpositionen τ mit τ (i) = i + 1 und

τ (i + 1) = i für ein i.

(2) Die Darstellung als Produkt von Transpositionen ist nicht eindeutig, und ebensowenig die Anzahl der Faktoren in der Darstellung.

Definition 1.6.56. Sei π ∈ Sn eine Permutation. Ein Fehlstand von π ist ein

Paar (i, j) mit 1 ≤ i < j ≤ n so, dass π(i) > π(j) ist.

Definition 1.6.57. Das Signum einer Permutation π ∈ Sn ist sign(π) := (−1)s ,

wobei s die Anzahl der Fehlstände von π sei.

Bemerkung 1.6.58. Für jede Transposition τ ∈ Sn gilt sign(τ ) = −1.

Lemma 1.6.59. Für π ∈ Sn gilt

sign(π) =

σ(j) − σ(i)

.

j−i

1≤i<j≤n

Y

Satz 1.6.60. Für alle σ, τ ∈ Sn gilt sign(τ ◦ σ) = sign(τ ) · sign(σ).

Bemerkung 1.6.61. Sind G, H Gruppen und ist f : G → H eine Abbildung mit

f (gh) = f (g)f (h) für alle g, h ∈ G, so sagt man, dass f ein Gruppenhomomorphismus ist. Damit ist sign : Sn → {−1, 1} ein Gruppenhomomorphismus.

Man kann zeigen, dass für Gruppenhomomorphismen Ker f = {g ∈ G | f (g) =

eH } eine Untergruppe von G ist. Diese Untergruppe wird mit An bezeichnet und die

alternierende Gruppe genannt. Für n > 1 gilt |An | = 21 n!:

Sei σ ∈ Sn \ An ; betrachte dann die Abbildung ϕ : An → Sn , τ 7→ στ . Man

rechnet leicht nach, dass ϕ(An ) = Sn \ An ist und dass ϕ bijektiv ist. Damit folgt

|An | = |S2n | = 12 n!.

Existenz der Determinante nach Leibniz

Satz 1.6.62. Zu einer Matrix A = (aij ) ∈ Matn×n (K) definiere

X

det(A) :=

sign(σ)a1σ(1) · · · anσ(n) .

σ∈Sn

Dann ist det : Matn×n (K) → K eine Determinante.

Die Transponierte

Definition 1.6.63. Sei A = (aij ) ∈ Matm×n (K). Dann ist die Transponierte von

A definiert als At = (bij ) ∈ Matn×m (K) mit bij := aji , 1 ≤ i ≤ n, 1 ≤ j ≤ m.

Satz 1.6.64. Es gilt det(At ) = det(A).

Lemma 1.6.65. Es sei A ∈ Matn×n (K) eine Blockdiagonalmatrix, d.h. von der

Form

A1

0

A2

A=

,

...

0

Am

Pm

wobei Ai ∈ Matni ×ni (K) ist mit i=1 ni = n. Dann gilt

det(A) = det(A1 ) · · · det(Am ).

34

KAPITEL 1. LINEARE ALGEBRA I

Laplace-Entwicklung Zu einer Matrix A = (aij ) ∈ Matn×n (K) und zu i, j ∈

{1, . . . , n} definiere

und

a11

..

.

ai−1,1

Aij := 0

ai+1,1

.

..

an1

a11

..

.

a

Âij := i−1,1

ai+1,1

.

..

an1

···

...

a1,j−1

..

.

0

..

.

· · · ai−1,j−1

···

0

· · · ai+1,j−1

..

...

.

· · · an,j−1

···

...

a1,j−1

..

.

a1,j+1

..

.

0 ai−1,j+1

1

0

0 ai+1,j+1

..

..

.

.

0 an,j+1

a1,j+1

..

.

···

...

· · · ai−1,j−1 ai−1,j+1 · · ·

· · · ai+1,j−1 ai+1,j+1 · · ·

..

..

...

...

.

.

· · · an,j−1

an,j+1 · · ·

···

...

···

···

···

...

···

a1,n

..

.

ai−1,n

0 ∈ Matn×n (K)

ai+1,n

..

.

ann

a1,n

..

.

ai−1,n

∈ Mat(n−1)×(n−1) (K).

ai+1,n

..

.

ann

Lemma 1.6.66. Es ist det(Aij ) = (−1)i+j det(Âij ).

Satz 1.6.67 (Laplace-Entwicklung). Sei A = (aij ) ∈ Matn×n (K). Dann gilt für

jedes i ∈ {1, . . . , n}

n

X

det(A) =

aij (−1)i+j det(Âij )

j=1

und für jedes j ∈ {1, . . . , n}

det(A) =

n

X

aij (−1)i+j det(Âij ).

i=1