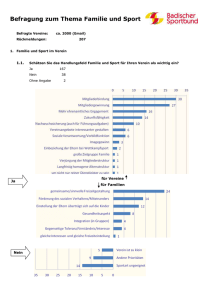

Grundlagen

Werbung