Suchportlet

Werbung

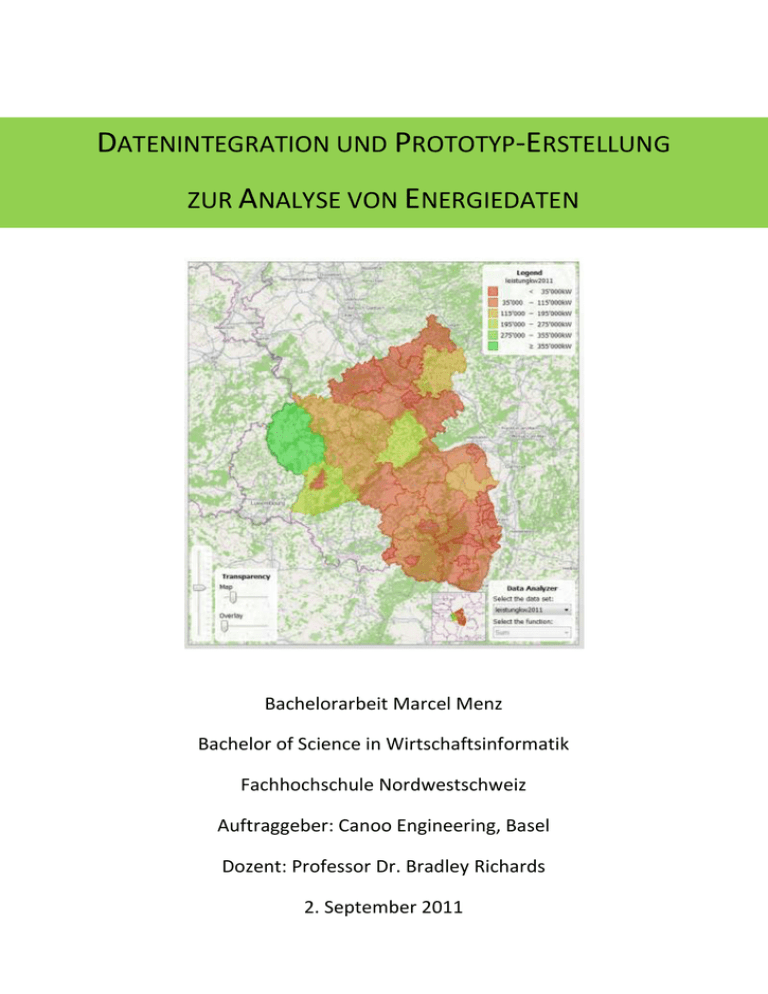

DATENINTEGRATION UND PROTOTYP-ERSTELLUNG

ZUR ANALYSE VON ENERGIEDATEN

Bachelorarbeit Marcel Menz

Bachelor of Science in Wirtschaftsinformatik

Fachhochschule Nordwestschweiz

Auftraggeber: Canoo Engineering, Basel

Dozent: Professor Dr. Bradley Richards

2. September 2011

EIDESSTATLICHE ERKLÄRUNG

Ich erkläre hiermit an Eides statt, dass ich die vorliegende Thesis selbständig und ohne unzulässige

fremde Hilfe angefertigt habe. Die verwendeten Quellen sind vollständig zitiert.

Datum: 01.09.2011

Unterschrift_______________

MANAGEMENT SUMMARY

Ziel der vorliegenden Arbeit war, die ULCGeoMaps und den ULCBigTableExplorer in einem Prototyp

zu vereinen und die Komponenten und deren Integrationsfähigkeit zu validieren. Insbesondere sollte

die gemeinsame Programmierschnittstelle überprüft werden. Ebenfalls interessierte die Frage, wie

gut die Komponenten mit einer Datenbank zusammenarbeiten. Zu diesem Zweck wurden

Energiedaten aus Deutschland verwendet. Diese wurden zuerst vorverarbeitet.

Eine gemeinsame Nutzung des ULCBigTableExplorer und der ULCGeoMaps ist möglich. Die

Komponenten sind schon weit entwickelt. Es hat sich aber gezeigt, dass insbesondere dem

ULCBigTableExplorer noch einige wichtige Funktionen fehlen um erweiterte Analysen durchführen zu

können. Die Komponente sollte bei den Diagrammen, den Aggregationen, Sortierungen und

Berechnungen sowie beim Datenexport erweitert werden. Dies ist aber aufgrund der soliden Basis

schnell möglich. Beim ULCBigTableExplorer sollte zudem noch die Performanz verbessert werden.

Die Integration mit einer Datenbank ist noch nicht elegant möglich. Die Datenanbindungsschnittstelle

ist noch zu stark auf die Verwendung mit Datenfiles optimiert. Die Flexibilität der Datenbank kann

noch nicht genutzt werden. Insbesondere für einen Einsatz im Bereich "Business Intelligence" ist aber

eine gute Unterstützung von Datenbanken matchentscheidend. Aufgrund der gut durchdachten

Architektur der Komponenten ist eine Erweiterung aber schnell möglich.

Der Prototyp ist im Moment erst auf der Datenebene integriert. Eine vollständige Integration der

Komponenten ist schon in Planung. Dies wäre sicherlich eine gewinnbringende Kombination. Die

einfache Nutzung der Komponenten muss dabei aber im Auge behalten werden.

Durch eine moderate Weiterentwicklung, die sich konsequent von den Anforderungen eines

Analysetools leiten lässt, können die Komponenten verbessert und markttauglich gemacht werden.

INHALTSVERZEICHNIS

1

ABBILDUNGSVERZEICHNIS ............................................................................................................................. VIII

2

TABELLENVERZEICHNIS ................................................................................................................................. VIII

3

4

EINLEITUNG ................................................................................................................................................. 9

3.1

Auftraggeber.......................................................................................................................................... 9

3.2

Projektpartner ....................................................................................................................................... 9

3.3

Hintergrund ........................................................................................................................................... 9

3.4

Ausgangslage ....................................................................................................................................... 10

3.5

Problemstellung................................................................................................................................... 10

3.6

Zielsetzung ........................................................................................................................................... 10

3.7

Nutzen ................................................................................................................................................. 10

3.8

Vorgehen ............................................................................................................................................. 11

KOMPONENTEN ......................................................................................................................................... 12

4.1

Funktionalität ...................................................................................................................................12

4.1.2

Theoretische Einordnung .................................................................................................................13

4.2

5

6

ULCBigTableExplorer ........................................................................................................................... 12

4.1.1

ULCGeoMaps ....................................................................................................................................... 15

4.2.1

Funktionalität ...................................................................................................................................15

4.2.2

Theoretische Einordnung .................................................................................................................16

DATENANALYSE .......................................................................................................................................... 17

5.1

Vorgehen ............................................................................................................................................. 17

5.2

Was wurde analysiert? ........................................................................................................................ 17

5.3

Daten ................................................................................................................................................... 19

5.3.1

Gemeindedaten Rheinland Pfalz ......................................................................................................19

5.3.2

EEG-Kraftwerksdaten Rheinland Pfalz ..............................................................................................21

5.3.3

Stromdaten Verbandsgemeinden Rheinland Pfalz ..........................................................................23

5.3.4

Open GEO DB Datenbank .................................................................................................................24

DATENBANKSCHEMA ................................................................................................................................... 25

6.1

Beschreibung ....................................................................................................................................... 26

6.1.1

Geographische Entitäten ..................................................................................................................26

6.1.2

Tabelle kraftwerk .............................................................................................................................26

6.1.3

Tabelle Gemeindedaten ...................................................................................................................26

6.1.4

Tabelle Gemeindeverbandsdaten ....................................................................................................26

6.1.5

Tabellen meta_info/ meta_info_mapper .........................................................................................26

6.1.6

Tabelle mapping _helper ..................................................................................................................26

6.1.7

Tabelle open_geodb .........................................................................................................................27

6.1.8

Abbildung der Gemeindehierarchie .................................................................................................27

6.1.9

Trennung Stamm- und Bewegungsdaten .........................................................................................28

6.1.10 Datenbank Views ..............................................................................................................................31

6.1.11 Modellierung in GORM ....................................................................................................................32

7

DATENIMPORT ........................................................................................................................................... 34

7.1

8

Vorgehen ............................................................................................................................................. 34

DATENINTEGRATION.................................................................................................................................... 36

8.1

Gemeindemapping EEG-Kraftwerksdaten ........................................................................................... 36

9

10

8.1.1

Problem ............................................................................................................................................36

8.1.2

Normalisierung der Gemeindenamen ..............................................................................................36

8.1.3

Vorgehen Normalisierung ................................................................................................................36

8.1.4

Zuordnungsheuristik ........................................................................................................................37

8.1.5

Resultate ..........................................................................................................................................44

DATENANREICHERUNG ................................................................................................................................. 46

9.1

Längen- und Breitengrade ................................................................................................................... 46

9.2

Resultate .............................................................................................................................................. 47

PROTOTYP ERSTELLUNG ............................................................................................................................... 50

10.1

Ziele ..................................................................................................................................................... 50

10.2

Vorgehen ............................................................................................................................................. 50

10.3

Datenauswahl GUI ............................................................................................................................... 50

10.4

BigTableDataProvider .......................................................................................................................... 51

10.4.1 Hintergrund ......................................................................................................................................51

10.4.2 Architektur .......................................................................................................................................51

10.4.3 Programmierschnittstelle .................................................................................................................52

10.4.3.1

DataDescription ...................................................................................................................... 52

10.4.3.2

DataSource ............................................................................................................................. 54

10.4.4 Index .................................................................................................................................................55

10.5

Herausforderungen ............................................................................................................................. 56

10.5.1 Grails ULC Plugin ..............................................................................................................................56

10.5.2 Index .................................................................................................................................................56

10.5.3 Laden der Ressourcen ......................................................................................................................56

10.5.4 Dependency Management ...............................................................................................................57

10.5.5 Benutzerschnittstelle .......................................................................................................................57

10.5.5.1

Null Safety .............................................................................................................................. 57

10.5.5.2

ValueGetterFunction .............................................................................................................. 57

10.5.5.3

Data Source Singleton ............................................................................................................ 58

10.5.5.4

Eingebauter Date Kategorisierer ............................................................................................ 59

10.5.5.5

NoAggregationAggregationFunction ...................................................................................... 59

10.5.5.6

toName() ................................................................................................................................ 59

10.5.5.7

Dokumentation....................................................................................................................... 59

10.5.6 Performanz .......................................................................................................................................59

10.6

10.5.6.1

Datenbank Abfragen............................................................................................................... 59

10.5.6.2

Indexgenerierung ................................................................................................................... 61

10.5.6.3

Bemerkungen Performanz ...................................................................................................... 62

Bewertung der Komponenten ............................................................................................................. 62

10.6.1 Index .................................................................................................................................................62

10.6.2 Wechseln der DataDescription und DataSource ..............................................................................63

10.6.3 Kategorienbildung ............................................................................................................................63

10.6.3.1

Längen- und Breitengrade ...................................................................................................... 64

10.6.4 Aggregation der Werte .....................................................................................................................64

10.6.5 Auswertungen über die Zeit .............................................................................................................65

10.6.6 Sortierungsfunktion..........................................................................................................................65

10.6.7 Charts ...............................................................................................................................................65

10.6.8 Exportfunktionalität .........................................................................................................................66

10.6.9 Vollständige Integration der Komponenten .....................................................................................66

10.6.10 Direkte Datenbank abfragen ............................................................................................................66

11

EVALUATION COUCHDB............................................................................................................................... 69

11.1

Was ist NoSQL? .................................................................................................................................... 69

11.2

Warum NoSQL in diesem Projekt? ...................................................................................................... 69

11.2.1 Schnelle Anfragen ............................................................................................................................70

11.2.2 Schemafreiheit .................................................................................................................................70

11.2.3 Kategorisierung auf der Datenbank .................................................................................................70

11.2.4 Grails Plugin ......................................................................................................................................70

11.2.5 Know-How ........................................................................................................................................70

11.3

Konzepte von NOSQL ........................................................................................................................... 70

11.3.1 Schemafreiheit .................................................................................................................................70

11.3.2 CAP Theorem ....................................................................................................................................72

11.3.3 Map/ Reduce ....................................................................................................................................72

11.3.4 Vor- und Nachteile von CouchDB gegenüber relationalen Systemen ..............................................76

11.4

12

Ergebnis ............................................................................................................................................... 77

FAZIT ....................................................................................................................................................... 79

12.1

Fachliches ............................................................................................................................................ 79

12.2

Projektablauf ....................................................................................................................................... 79

12.3

Zielerreichung ...................................................................................................................................... 80

12.4

Persönliches Fazit ................................................................................................................................ 81

13

DANK ...................................................................................................................................................... 83

14

LITERATURVERZEICHNIS ................................................................................................................................ 84

15

GLOSSAR/ TECHNOLOGIEN ........................................................................................................................... 87

16

15.1

Closure ................................................................................................................................................. 87

15.2

Levenshtein-Distanz............................................................................................................................. 87

15.3

JSON ..................................................................................................................................................... 87

15.4

Groovy ................................................................................................................................................. 87

15.5

Grails Webframework.......................................................................................................................... 87

15.6

Canoo Ultra Light Client (ULC) ............................................................................................................. 88

15.7

MySQL .................................................................................................................................................. 88

ANHANG .................................................................................................................................................. 89

16.1

Quelldatenfiles .................................................................................................................................... 89

16.1.1 Gemeindeverzeichnis Rheinland Pfalz .............................................................................................89

16.1.2 EEG-Kraftwerksdaten Rheinland Pfalz ..............................................................................................89

16.1.3 Stromdaten Verbandsgemeinden Rheinland Pfalz ..........................................................................90

16.2

Inhalt der CD ........................................................................................................................................ 91

16.2.1 Arbeit ................................................................................................................................................91

16.2.2 Quelldaten Files ................................................................................................................................91

16.2.3 Gemeindemapping Dateien .............................................................................................................91

16.2.4 Datenbank Output Files....................................................................................................................91

16.2.5 Groovy Skripten ................................................................................................................................91

16.2.6 SQL Skripten .....................................................................................................................................92

1

ABBILDUNGSVERZEICHNIS

Abbildung 1, ULCBigTableExplorer........................................................................................................................ 12

Abbildung 2, ULCGeoMaps ................................................................................................................................... 15

Abbildung 3, OpenGeoDB Datenauschnitt ............................................................................................................ 24

Abbildung 4, Datenbankschema ........................................................................................................................... 25

Abbildung 5, Zielformat Gemeindehierarchie ....................................................................................................... 28

Abbildung 6, GORM Klasse GemeindeView .......................................................................................................... 32

Abbildung 7, XML-Response Yahoo Geolokationsservice ..................................................................................... 43

Abbildung 8, Scatter-Plot der Kraftwerks Längen- und Breitengrade ................................................................... 48

Abbildung 9, Karte Rheinland Pfalz ....................................................................................................................... 48

Abbildung 10, Datenauswahl GUI ......................................................................................................................... 51

Abbildung 11, Architektur BigTableDataProvider, (Bräunlich, 2011).................................................................... 52

Abbildung 12, Code: defineStructure-Methode, EEGDataDescriptionGORM....................................................... 53

Abbildung 13, Kategorieanwahl ULCBigTableExplorer ......................................................................................... 66

Abbildung 14, Beispiel CouchDB Dokument im JSON Format .............................................................................. 71

Abbildung 15, Beispiel CouchDB View .................................................................................................................. 73

Abbildung 16, Beispiel Grouping CouchDB ........................................................................................................... 75

Abbildung 17, Beispiel 2 Grouping CouchDB ........................................................................................................ 75

Abbildung 18, Beispiel 3 Grouping CouchDB ........................................................................................................ 76

2

TABELLENVERZEICHNIS

Tabelle 1, Regionalschlüssel Beispiel .................................................................................................................... 20

Tabelle 2, Beispiel Kraftwerkstabelle .................................................................................................................... 28

Tabelle 3, zeilenorientierte Speicherung Bewegungsdaten .................................................................................. 29

Tabelle 4, Gemeindemapping Resultate ............................................................................................................... 44

Tabelle 5, Resultate Längen- und Breitengrad Abfragen ...................................................................................... 47

Tabelle 6, Bit-Index BigTableDataProvider............................................................................................................ 55

Tabelle 7, Performanz Indexerstellung ................................................................................................................. 61

Tabelle 8, Auszug Tabelle ULCBigTableExplorer ................................................................................................... 64

viii

3

EINLEITUNG

3.1

AUFTRAGGEBER

Canoo Engineering AG in Basel bietet Produkte und Dienstleistungen im Bereich Software. Die beiden

Hauptprodukte sind die Canoo RIA Suite mit der leistungsfähige Java-Webapplikationen vollständig in

Java realisiert werden können und Software-Tools im Bereich Sprachanalyse. Canoo beschäftigt

zurzeit über 40 Softwareentwickler. Viele davon sind aktive Commiter bei Open Source Projekten und

Sprecher auf internationalen Konferenzen.

3.2

PROJEKTPARTNER

Die ECOSCOP ist eine Gesellschaft für Umweltberatung und -recherche in Trier. Sie ist eine Gründung

von Wissenschaftlern, Technikern und Praktikern der unterschiedlichsten Fachbereiche. Der

Ansprechpartner für die vorliegende Arbeit war Matthias Gebauer.

Die ECOSCOP ist seit ihrer Gründung in den Schwerpunkten "Beratung & Planung von kleinen

Energieanlagen", "Umweltberatung", "Weiterbildung und Knowhow-Transfer" und "Umwelt und

Informatik" tätig.

3.3

HINTERGRUND

In Deutschland besteht eine Einspeisevergütung für alternative Energie (EEG). Das Einspeisen von

Strom, aus zum Beispiel einer Solaranlage, wird von der öffentlichen Hand subventioniert. Von der

Politik werden Zielvorgaben gemacht und diese überprüft. In gewissen Zeitabständen wird also

eruiert, wie sich diese Einspeisevergütung auswirkt. Insbesondere soll natürlich der Anteil von

alternativer Energie erhöht werden. Zwischen den Kommunen wird ausserdem ein Benchmarking

durchgeführt. Im Moment besteht kein Standard wie solche Energiebilanzen zu erstellen sind. Die

Vergleichbarkeit ist dadurch schwierig. Bei den vorhandenen Tools am Markt besteht insbesondere

die Schwierigkeit, dass die Verarbeitungsschritte der Systeme nicht transparent sind. Canoo und

ECOSCOP möchten ein Tool entwickeln, dass den Anforderungen dieser Domäne gerecht wird.

9

3.4

AUSGANGSLAGE

Die RIA Suite von Canoo erlaubt es Rich Internet Applications (RIAs) vollständig in Java zu realisieren.

Dabei steht den Entwicklern ein reichhaltiges Set von GUI-Komponenten zur Verfügung. Im Canoo

RIALab werden Prototypen von neuen Komponenten entwickelt. Der ULCBigTableExplorer und die

ULCGeoMaps sind ein Resultat dieser Arbeit. Die Komponenten sollen die Möglichkeit bieten grosse

Datenmengen auf eine möglichst einfache Art zu analysieren. Ein Anwendungsentwickler soll die

Komponenten möglichst einfach in Applikationen integrieren können. Um dieses Ziel zu unterstützen

wurde eine gemeinsame Datenanbindungsschicht implementiert.

3.5

PROBLEMSTELLUNG

Die ULCGeoMaps-Komponente wurde bereits einmal erfolgreich in einem Kundenprojekt eingesetzt.

Der BigTableExplorer nicht. Dieser befindet sich noch stärker in Entwicklung. Die Praxistauglichkeit

der beiden Komponenten, insbesondere des ULCBigTableExplorers wurde bisher nicht getestet. Die

Komponenten arbeiten zur Zeit nur mit CSV-Files. Wie gut sich die Komponenten zusammen mit

einer Datenbank nutzen lassen, ist noch unklar. Die gemeinsame Datenanbindungsschicht ist noch

neu und ebenfalls nicht ausgiebig getestet.

3.6

ZIELSETZUNG

Das Ziel der vorliegenden Arbeit ist es, die Daten des Projektpartners zu intergieren und mit dem

Einsatz der neuen Komponenten der Canoo RIA Suite, auswertbar zu machen. Dazu werden die

Daten in einer Datenbank integriert und ein Prototyp entwickelt. Als Integrationsbasis soll das Grails

Webframework Verwendung finden.

3.7

NUTZEN

Der Projektpartner erhält einen Prototyp mit dem er erste Analysen seiner Daten vornehmen kann.

Die darunterliegende integrierte Datenbasis kann er auch unabhängig von den Tools

weiterverwenden.

Canoo erhält ein Proof of Concept für seine neuen Komponenten. Eine vollständige Bewertung ist im

Rahmen dieser Arbeit aus zeitlichen Gründen nicht möglich. Erwartet werden dürfen aber

insbesondere Antworten auf die folgenden Fragen:

Wie gut integrieren die Komponenten mit einer Datenbank?

Wie leicht lassen sich die Komponenten ins Grails Webframework integrieren?

10

Wie stabil laufen die Komponenten?

Welche Fehler wurden identifiziert?

Wie performant läuft die Applikation mit den bestehenden "real world" Daten?

Welche zusätzlichen Anforderungen an die Funktionalität und die Programmierschnittstelle

können aus der Arbeit hergeleitet werden?

3.8

VORGEHEN

Es wurde grob in drei Phasen vorgegangen. Zuerst wurden die Daten integriert, danach der Prototyp

entwickelt und anschliessend das Projekt dokumentiert.

Die Datenintegration unterteilte sich in die Phasen:

Datenanalyse

Datenintegration

Datenanreicherung

Überprüfung Datenqualität

Danach wurde auch ein Grails Domänenmodell/ Datenbankschema entworfen und die Daten in die

Datenbank geladen.

Die Prototyperstellung unterteilte sich in die Phasen:

Datenanbindungsschicht und Datendefinitionen implementieren

Integration der Komponenten mit Grails

Datenbank Views erstellen und anbinden

Entwicklung eines Datenauswahl GUIs

Bug Fixing

Testing/ Profiling und Optimierung des Prototypen

Deployment

Während allen Phasen des Projekts wurde fortlaufend dokumentiert. Anschliessend erfolgte die

Konsolidierung der Entwürfe in diesen Bericht.

11

4

KOMPONENTEN

4.1

ULCBIGTABLEEXPLORER

Der ULCBigTableExplorer wurde von Dieter Holz und Franz-Josef Wiszniewsky entwickelt.

Abbildung 1, ULCBigTableExplorer

4.1.1 FUNKTIONALITÄT

Der ULCBigTableExplorer soll eine möglichst einfache mehrdimensionale Auswertung von

tabellarischen Daten ermöglichen. Die Komponente hat drei Darstellungsbereiche: Die KategorieAnsicht, die Tabelle mit den Quelldatensätzen und eine Chart-Ansicht.

Es können, wie in Abbildung 1 ersichtlich, mehrere Kategoriepanels eingeblendet werden. Das

Einblenden macht aber natürlich nur Sinn, wenn für die entsprechenden Spalten auch Kategorien

definiert wurden. Die Panels können ihre Position jeweils mit dem Nachbarpanel tauschen. Die

Anwahl einer oder mehrerer Kategorien wirkt als Filter auf die Datensätze in der Tabelle und die

Chart-Anzeige. Die Filter werden UND-verknüpft. Die Kategorieanwahl in Abbildung 1führt also dazu,

12

dass in der Tabelle nur die Wasser-, Wind- und Biomassekraftwerke, die im Jahr 2005 oder 2007 in

Betrieb genommen wurden, angezeigt werden. Die Zahl hinter der dem Kategorienamen, wie zum

Beispiel WAS (11), zeigt wie viele Datensätze nach der Filterung noch vorliegen. In den Jahren 2007

und 2005 sind also 11 Wasserkraftwerke in Betrieb gegangen. Pro Kraftwerk liegt in den Quelldaten

jeweils eine Zeile vor.

Im Moment kann die Komponente Säulen-, Kuchen-, Linien- und XY-Diagramme darstellen. Sie wählt

aufgrund der Kategorieanwahl jeweils eine geeignete Darstellung. Eine manuelle Anwahl ist ebenso

möglich. Nicht jeder Diagrammtyp ist aber sinnvoll. In Abbildung 1 ist auf der X-Achse die Anzahl der

Kraftwerke aufgetragen, auf der Y-Achse liegen die Jahre und die Farben kennzeichnen den

Kraftwerkstyp. Beim Anwählen einer Säule werden die entsprechenden Datensätze in der Tabelle

markiert.

Die Komponente hat ausserdem eine Suchfunktionalität.

4.1.2 THEORETISCHE EINORDNUNG

Übersichtstabellen entstehen nach (Reber, Analyseprozesse in Datawarehouses, 2011) durch

Filterung und Aufsummierung (Aggregation) von Detaildaten. Ersteres erlaubt das vorliegende Tool.

Die Aggregation der Daten ist in der Architektur der Komponenten vorgesehen, aber noch nicht im

GUI umgesetzt. Es stellt sich die Frage, welche Aspekte eines OLAP (Online Analytical Processing)

Tools der ULCBigTableExplorer bereits abdeckt.

Nach (Reber, Analyseprozesse in Datawarehouses, 2011) sind OLAP Tools:

"mehrdimensional, weil es ...

o

endbenutzerfreundlich, weil es ...

o

direkte Manipulation ermöglicht

o

Ergebnisse einfach darstellt, insbesondere visualisiert

detaillierend und zusammenfassend, weil ...

o

Daten übersichtlich zusammengefasst und nur auf Verlangen detailliert

o

Drilling Up and Down navigiert entlang einer Dimension

analysierend und synthetisierend, weil ...

o

der Benutzer Dimensionen einfach hinzufügen und weglassen kann

schnell, weil es ...

o

13

Indikatoren nach ihren Dimensionen analysiert

ad hoc-Abfragen in Sekunden beantwortet

o

aufwendige ad-hoc-Berechnungen durch Voraggregation vermeidet

Data Mart - orientiert, weil es ...

o

weniger Details als das zentrale EDW unterstützt"

Der ULCBigTableExplorer ermöglicht mehrdimensionale Auswertungen, nach vordefinierten

Kategorien. Die Auswertungsdimensionen können schnell gewechselt werden, dass heisst es ist

analysierend und synthetisierend. Auch die Benutzerfreundlichkeit ist hoch. Eine Analyse ist sehr

einfach. Detaillieren und Zusammenfassen kann das Tool, wie gesagt, noch nicht. Das heisst ein Drill

Down and Drill Up, also das Zusammenfassen oder Detaillieren entlang einer Dimension (Reber,

Analyseprozesse in Datawarehouses, 2011), ist noch nicht möglich. Durch einen optimierten Index

soll das Tool auch schnelle Antwortzeiten bieten.

Typisch für ein Data Warehouse ist die Unterscheidung von Fakten (Indikatoren) also einem

betriebswirtschaftlicher Erfolgsfaktor und Dimensionen, also den Kriterien seiner Beurteilung (Reber,

Modellierung von Datawarehouses, 2010). Die Dimensionen sind beim ULCBigTableExplorer die

Kategorien nach denen gefiltert wird. Was aber sind die Fakten? Im Moment sind die Fakten die

Kraftwerke die nach der Filterung noch vorhanden sind und insbesondere deren Anzahl. So können

Fragen wie: Wie viele Solarstromkraftwerke wurden zwischen 2005 und 2010 in Trier in Betrieb

genommen, leicht beantwortet werden. Für die Frage aber wie viel Energieertrag in kWh die

Kraftwerke in diesen Jahren geliefert haben, ist dies noch nicht direkt möglich.

14

4.2

ULCGEOMAPS

Die ULCGeoMaps wurde von Michael Faes und Christoph Bräunlich entwickelt.

Abbildung 2, ULCGeoMaps

4.2.1 FUNKTIONALITÄT

Die ULCGeoMaps ermöglicht eine Auswertung von aggregierten Daten bezüglich der Dimension

Raum. Für jede geographische bzw. administrative Einheit werden in einem Tooltip alle vorhandenen

aggregierten Werte angezeigt, sobald sich der Mauszeiger über dem Gebiet befindet. Im "Data

15

Analyzer" Menü wird eine Datenart angewählt, in unserem Fall Leistung der Kraftwerke in kW. Die

Polygonzüge, die über der Karte liegen, werden dadurch nach den Kategorien in der Legende

eingefärbt.

Durch einen langen Klick auf einen Polygonzug kann in dieses Gebiet hinein navigiert werden.

Daraufhin werden die geographisch darunter liegende Einheiten angezeigt. Es können auch mehrere

Polygonzüge miteinander kombiniert werden.

Die tiefste Navigationsebene ist die einzelne Adresse. In unserem Fall ist somit das Einzeichnen von

einzelnen Kraftwerken möglich.

4.2.2 THEORETISCHE EINORDNUNG

Die Fakten sind, im Fall der ULCGeoMaps, die aggregierten Werte. Zum Beispiel der Energieertrag in

kWh. Diese werden nach der Dimension Raum ausgewertet. Eine Grundfunktionalität ist der DrillDown und Drill-Up. Es kann in die einzelnen Raumgrenzen hinein und wieder heraus gesprungen

werden. Die Daten werden dadurch auf verschiedenen geographischen Hierarchiestufen

(Bundesland, Regierungsbezirk, Landkreis, …) auswertbar.

Bei (Martin Theus, 2009) wird dieser Art der Visualisierung auch ein Name gegeben. "The most

common way to display geographically referenced data ist choropleth maps. Even if a finer resolution

for the geographical location of the items can be given, the interest lies mostly in the aggregated

data represented by administrative entities such as ZIP-code areas *…+." (Martin Theus, 2009). Der

deutsche Begriff wäre laut Wörterbuch: Flächenkartogramm.

16

5

DATENANALYSE

Die verarbeiteten Daten sind alle aus Deutschland. Zusammen mit dem Projektpartner wurde

entschieden nur die Daten vom Bundesamt Rheinland Pfalz zu verwenden. Alle Daten lagen in Form

von Excel Files vor.

5.1

VORGEHEN

Zuerst wurden die bereits vorhanden Datenfiles gesichtet. Es zeigte sich, dass die gleichen Daten

jeweils von verschiedenen Quellen vorhanden waren. Andere Daten waren zu Beginn der Arbeit noch

nicht vorhanden oder in einer Form, die nicht für die Verarbeitung geeignet schien. Mit dem

Projektpartner wurde abgegrenzt welche Daten analysiert und integriert werden sollten. Der

Stromdatensatz und der EEG-Kraftwerksdatensatz wurden vom Projektpartner vorverarbeitet.

5.2

WAS WURDE ANALYSIERT?

Folgende Fragen wurden während der Datenanalyse gestellt:

Gibt es einen eindeutigen Schlüssel der den jeweiligen Datensatz eindeutig identifiziert oder können

mehrere Attributwerte zu einem Schlüssel kombiniert werden?

Welche Skalenniveaus sind vorhanden (nominal, ordinal, numerisch)? Dies ist insbesondere wichtig,

um die Darstellung der Kategorien im ULCBigTableExplorer zu modellieren. Bei ordinalen Werten ist

die Reihenfolge in der die Kategorien im GUI angezeigt werden zum Beispiel relevant, während

dessen dies bei nominalen Werten nicht der Fall ist.

Welche Datentypen sind vorhanden? Die entsprechenden Datentypen werden auch in der

Datenbank verwendet.

Gibt es abhängige Spaltenwerte, das heisst Werte die von anderen Spaltenwerten abhängen? Dies

ist für die Modellierung des Schemas relevant.

Sind die Daten vollständig vorhanden? Es muss auf Datenbank- und Applikationsebene entschieden

werden, wie mit Leerwerten umgegangen wird.

17

Wie ist die syntaktische Variabilität der Spaltenwerte? Werden zum Beispiel Adressinformationen

immer gleich angegeben oder gibt es Varianten? Dies ist insbesondere für die Verarbeitung der

Daten relevant. Die Importskripten müssen diese Unterschiede kennen.

Sind zusammengesetzte Spaltenwerte vorhanden oder sind alles atomare Werte? Dies ist für die

Modellierung des Schemas relevant. Zum Beispiel muss geklärt werden, ob zusammengesetzte Werte

aufgetrennt werden sollen.

Können aus Spaltenwerten fachliche Informationen herausgelesen werden? Welche Informationen

sind zum Beispiel in einem Schlüssel codiert?

Wie sind temporale Informationen angegeben? Die Importskripten müssen diese Syntax kennen.

Welche Metadaten sind vorhanden? In welcher Zeichencodierung sind die Daten zum Beispiel

gespeichert.

18

5.3

DATEN

5.3.1 GEMEINDEDATEN RHEINLAND PFALZ

Siehe auch im Anhang 16.1.1

Vom deutschen statistischen Bundesamt wurden Gemeindedatensätze bezogen. Diese enthalten die

Gemeindedaten aller Gemeinden in Deutschland. Die folgenden Daten sind für die Arbeit relevant:

Satzart

Gemeindename

Regionalschlüssel

Fläche in km2

Bevölkerungszahlen

Postleitzahl

Die Satzart beschreibt die Hierarchiestufe auf der die entsprechende geographische Entität steht. Im

Originalfile sind die folgenden Stufen angegeben:

10 = Bundesland

20 = Regierungsbezirk

30 = Region (nur in Baden Württemberg)

40 = Landkreis

50 = Verbandsgemeinde

60 = Gemeinde

Die Analyse der Daten ergab, dass nicht alle Bundesländer einen Regierungsbezirk haben. Es kann

aber in einem Bundesland verschiedene Regierungsbezirke geben. In Rheinland Pfalz sind es deren

drei. Die Satzart 30 bezieht sich nur auf ein Bundesland und ist in unserem Fall irrelevant. Eine Stufe

tiefer sind die Landkreise. Im Datensatz ist ersichtlich, dass nicht alle Gemeinden in einem Landkreis

sind. Es gibt kreisfreie Städte wie zum Beispiel Koblenz. Es sind auch nicht alle Gemeinden in einer

Verbandsgemeinde. Die Gemeinden sind die unterste Stufe der Hierarchie. Es sind keine Daten zu

den Gemeinde- und Stadtteilen vorhanden.

Der Gemeindename ist der Bezeichner der geographischen Entität, also zum Beispiel " RheinlandPfalz", "Sinzig, Stadt" oder "Koblenz, kreisfreie Stadt". Für unseren Zweck sind vor allem die

Gemeindenamen auf der Stufe Gemeinde relevant.

19

Beispiele:

Berod bei Hachenburg

Steinebach/ Sieg

Altenkirchen (Westerwald), Stadt

Rosenheim (Landkreis Altenkirchen)

Sonnenberg-Winnenberg

Es gibt zusammengesetzte Gemeindenamen bei nicht eindeutigen Namen (a + b), Zusätze wie "Stadt"

oder "Landkreis" (c, d) und Doppelnamen (e).

Der Regionalschlüssel ist eine, auf Gemeindeebene, zwölfstellige Zahl. Diese identifiziert die

Gemeinde eindeutig. Der Regionalschlüssel löst den älteren achtstelligen Gemeindeschlüssel ab.

Beide Schlüssel sind noch in Gebrauch (Wikipedia, Amtlicher Gemeindeschlüssel, 2011).

Beispiel:

07

2

31 0134

134

Wittlich, Stadt

Tabelle 1, Regionalschlüssel Beispiel

Die Ziffern 1-2 identifizieren das Bundesland. Die Ziffern 3-5 identifizieren den Landkreis bzw. die

kreisfreien Städte. Ziffer 3 ist der Regierungsbezirk oder ehemalige Regierungsbezirk oder 0 bei den

Gemeinden ohne Regierungsbezirk. In Baden-Württemberg zeigt die vierte Ziffer außerdem an, zu

welchem Regionalverband die Gemeinde gehört. Die Ziffern 1-5 werden als Kreisschlüssel

bezeichnet. Die Ziffern 6-9 identifizieren den Gemeindeverband. Seit dem 1. Januar 2009 wird die

Ziffernfolge 0000 für verbandsfreie Gemeinden durch 0, gefolgt von einer Wiederholung der Stellen

10 bis 12 ersetzt. An der ersten Stelle steht bei verbandsangehöriger Gemeinden die Zahl 5 bei

verbandsfreien Gemeinden die Zahl 0 und bei gemeindefreien Gebieten die Zahl 9. Die Ziffern 10 bis

12 identifizieren die Gemeinde (Wikipedia, Amtlicher Gemeindeschlüssel, 2011).

Die Fläche in km2 und die Bevölkerungsinformationen sind auf Gemeindestufe vorhanden. Die

Aggregationen für die darüber liegenden geographischen Entitäten, sind nicht im Datensatz.

Für jede Gemeinde ist eine Postleitzahl angegeben. Bei Gemeinden, die mehrere Postleitzahlen

haben, wird jeweils nur diejenige des Verwaltungssitzes angegeben (Angabe im Quelldatenfile).

20

5.3.2 EEG-KRAFTWERKSDATEN RHEINLAND PFALZ

Siehe auch im Anhang 16.1.2

Der Datensatz enthält Daten zu Kraftwerken die eine Einspeisevergütung enthalten (EEG). Es liegen

48667 Zeilen vor. Die folgenden Daten sind für die Arbeit relevant:

Strasse

Postleitzahl

Ort

Leistung in kW

Energieträger

INB_Datum

Ertrag in kWh

Vergütung in Euro

In der Spalte Strasse stehen die Strassennamen der jeweiligen Kraftwerke und eine oder mehrere

Hausnummern. Dabei ist die Abtrennung der Hausnummer unterschiedlich. Auch gibt es Teilweise

Zusätze wie "Schulhaus" und dergleichen. Es gibt auch Zeilen die die identische Strasseninformation

haben. Diese Datensätze unterscheiden sich teilweise nur durch den Anlagenschlüssel, dieser ist das

Identifikationsmerkmal.

Beispiele:

Batterieweg 103 /

Blumenberg 33 / 1641B 195/50

Calmuth 7 (Schloss Calmuth) /

Pastor-Keller-Straße 192 Z (Sporthalle) /

Grüner Weg 3a / 224/16

Vorderste Berg / Flurstück( 114 )

Am Tränkwald 21 Flurstück 740_82

Breitwiesenstr. 1a und 1b

2 Hallen auf Parzelle 24/1 /

Bei allen Zeilen des Files gibt es einen Eintrag in der Spalte Strasse. Bei 42 Datensätzen sind aber nur

die Hausnummern vorhanden.

21

Es gibt anzumerken, dass bei ca. 10 Prozent der Datensätze schon Längen- und Breitengrade

vorhanden sind. Diese wurden nicht weiter berücksichtigt, da diese Information für alle Datensätze

benötigt wird und auf anderem Weg beschaffen werden soll.

Eine Spalte enthält die Postleitzahlen. Die Gemeinden haben jeweils mehrere Kraftwerke und damit

kommen die Postleitzahlen mehrfach vor. Eine einzelne Gemeinde kann auch verschiedene

Postleitzahlen haben. Zudem kann eine Postleitzahl von verschiedenen Gemeinden verwendet

werden. Die Postleitzahlen sind vollständig vorhanden.

Die Spalte Ort enthält die Gemeindenamen. Bei einer Zeile gibt es keinen Eintrag und eine Zeile

enthält nur einen Schrägstrich. Einige Gemeindenamen enthalten hinter dem Namen eine Nummer

wie zum Beispiel: "Bad Neuenahr-Ahrweiler / 13" oder Zusätze wie zum Beispiel: "Meisenheim / Auf

der Lettweiler Höhe". Einige nur einen Schrägstrich.

In der Spalte Leistung steht die Leistung der einzelnen Kraftwerke in kW. Ein Datensatz enthält keine

Informationen und ein anderer 0. Alle anderen haben einen Eintrag in Form einer Gleitkommazahl.

Diese hat höchstens drei Nachkommastellen.

Die Spalte Energieträger beschreibt die Art des Kraftwerks. Es gibt im gesamten Datensatz sieben

verschiedene Werte. Diese sind: BIO, DEP, GEO, KLA, SOL, WAS, WIN. Es handelt sich um

Abkürzungen. SOL steht zum Beispiel für Solarstrom. Der Energieträger ist für alle Zeilen vorhanden.

Die Spalte INB_Datum enthält das Inbetriebnahmedatum des Kraftwerks. Drei Zeilen enthalten hier

keinen Datumswert.

Die Spalte Ertrag in kWh enthält die kWh, die in einem Jahr von dem entsprechenden Kraftwerk

geliefert wurden, als Ganzzahl. Das Jahr, auf das sich diese Zahlen beziehen, ist nicht im Datensatz

ersichtlich, wurde aber in den Metadaten mitgeliefert. 14866 Zeilen enthalten keinen Eintrag. 317

Zeilen haben den Eintrag 0.

Die Spalte Vergütung in Euro enthält den Geldbetrag, der als Einspeisevergütung bezahlt wurde. Das

Jahr, auf das sich diese Zahlen beziehen, ist nicht im Datensatz ersichtlich, wurde aber als Metadaten

mitgeliefert. 14866 Zeilen enthalten keinen Eintrag. Dies sind die gleichen Zeilen, die auch beim

Ertrag keinen Wert haben. 310 Zeilen haben den Eintrag 0. Auch hier sind es, mit zwei Ausnahmen,

die Datensätze, bei denen auch beim Ertrag eine 0 steht.

22

5.3.3 STROMDATEN VERBANDSGEMEINDEN RHEINLAND PFALZ

Siehe auch Anhang 16.1.3

Das File enthält die Strom Verbrauchsdaten für die Verbandsgemeinden in Rheinland Pfalz. Laut

Aussage des Projektpartners sind nicht alle Verbandsgemeinden enthalten. Die folgenden Daten sind

enthalten:

VGSchlüssel

VG

Nutzergruppe

Verbrauch 2007 in kWh

Die Spalte VGSchlüssel enthält einen eindeutigen Schlüssel der die Verbandsgemeinde identifiziert.

Es handelt sich dabei um die letzten fünf Ziffern des Gemeindeschlüssels, der schon im Abschnitt

5.3.1 beschrieben wurde.

Die Spalte VG enthält den Namen der Verbandsgemeinde. Die Angaben sind vollständig.

Die Spalte Nutzergruppe beschreibt die Art der Nutzergruppe. Die vorkommenden Werte sind:

Industrie u. Gewerbe > 30kW u. 30.000 kWh p.a., Wärmespeicher, Wärmepumpe, Haushalte,

Gewerbe < 30kW und 30.000 kWh p.a., Landwirtschaft. Die Angaben sind vollständig.

Die Spalte Verbrauch 2007 in kWh enthält die aufsummierten Stromverbräuche in kWh pro

Verbandsgemeinde als Ganzzahl. Die Angaben sind vollständig.

Es

gibt

anzumerken,

dass

der

gleiche

Schlüssel

(VGSchlüssel)

mit

dem

gleichen

Verbandsgemeindename (VG) jeweils für jede Nutzergruppe vorkommt, dass heisst redundant.

23

5.3.4 OPEN GEO DB DATENBANK

"Im Mittelpunkt des Projektes OpenGeoDB steht der Aufbau einer möglichst vollständigen

Datenbank mit Geokoordinaten zu allen Orten und Postleitzahlen (bisher: A,B,CH,D und FL). Dies soll

vor allem durch die Beteiligung von möglichst vielen Personen geschehen, die diese zentrale

Datenbank pflegen" (OpenGeoDB, 2011).

Die Daten der OpenGeoDB werden von freiwilligen gesammelt und gepflegt. Dadurch haben sie

keinen offiziellen Charakter und können uns ausschliesslich als Referenz dienen. Die

Nachvollziehbarkeit ist ein zentrales Kriterium unseres Projektpartners. Diese ist hier nicht

gewährleistet. Es ist nicht klar wer die Daten erfasst und nach welchen Verfahren bearbeitet hat.

Abbildung 3, OpenGeoDB Datenauschnitt

24

6

DATENBANKSCHEMA

Abbildung 4, Datenbankschema

25

6.1

BESCHREIBUNG

6.1.1 GEOGRAPHISCHE ENTITÄTEN

Die Tabellen staat, bundesland, regierungsbezirk, landkreis, gemeindeverband, gemeinde enthalten

Informationen zu geographischen bzw. administrativen Entitäten. Es handelt sich jeweils um eine 1:n

Beziehung.

6.1.2 TABELLE KRAFTWERK

Diese Tabelle enthält die Stamm- und Bewegungsdaten der einzelnen Kraftwerke. Warum diese

beiden Datenarten in einer Tabelle gemischt sind, erläutert der Abschnitt 6.1.9. Es sind drei

Fremdschlüssel auf die Metainformationen vorhanden und ein Fremdschlüssel auf die Gemeinde.

6.1.3 TABELLE GEMEINDEDATEN

Diese Tabelle enthält zusätzliche Daten zu der Gemeinde. Im Moment sind dies Bevölkerungs- und

Flächendaten.

6.1.4 TABELLE GEMEINDEVERBANDSDATEN

Die Tabelle enthält zusätzliche Daten zu dem Gemeindeverband. Im Moment sind dies

Stromverbrauchsdaten.

6.1.5 TABELLEN META_INFO/ META_INFO_MAPPER

Die Tabelle Meta_Info enthält die Metainformationen zu den Daten. Es besteht eine 1:n Beziehung

zu den Tupeln der Meta_Info_Mapper Tabelle. Diese enthält das Referenz- sowie Importdatum der

Daten und hat eine 1:n Beziehung zu allen anderen Tabellen, ausser den Hilfstabellen.

Die Metadaten eines Datenfiles werden also in der Meta_Info Tabelle gespeichert. Da aber die

einzelnen Spalten der Importfiles teilweise unterschiedliche Referenzdatumswerte ausweisen, muss

über die Zwischentabelle Meta_Info_Mapper verküpft werden.

6.1.6 TABELLE MAPPING _HELPER

Diese Tabelle enthält Informationen zu dem Gemeindemapping. Teilweise wurden die

Kraftwerksdaten manuell zu den Gemeindedaten gemappt oder durch eine Heuristik zugeordnet. Die

Resultate dieser Zuordnungen sind in dieser Tabelle hinterlegt und können in Zukunft genutzt

werden, um die Kraftwerksdatensätze einfacher zuzuordnen.

26

6.1.7 TABELLE OPEN_GEODB

Diese Tabelle enthält ebenfalls Informationen zu geographischen Entitäten, aus dem OpenGeoDB

Projekt (OpenGeoDB, 2011). Die Daten werden als Hilfsmittel bei dem Gemeindemapping (siehe 8.1)

verwendet.

6.1.8 ABBILDUNG DER GEMEINDEHIERARCHIE

Es bestehen unterschiedliche Formen hierarchische Daten in einem relationalen Datenbanksystem

abzubilden. In den Gemeindequelldaten (siehe 5.3.1) ist die ganze Hierarchie in einer Tabelle

gespeichert. Über den Regionalschlüssel ist es möglich alle Vaterelemente zu bestimmen. Für die

Gemeinde

07

1

31

5001

001

Adenau, Stadt

ist zum Beispiel ersichtlich, dass sie in der Verbandsgemeinde mit dem Regionalschlüssel

07

1

31

5001

Adenau

liegt und im Landkreis mit dem Regionalschlüssel

07

1

31

Ahrweiler

Die Gemeindedaten hätten exakt so in einer Datenbanktabelle gespeichert werden können. Falls die

einzelnen Teile des Regionalschlüssels in einzelnen Spalten gespeichert worden wären, hätten

einfach Abfragen gemacht werden können. Zum Beispiel welche Gemeinden im Landkreis

"Ahrweiler" liegen.

Alternativ hätte eine Tabelle nach dem "Adjazenz List Modell" aufgebaut werden können. Dabei

hätte jeder Tupel, ausser dem Wurzelknoten, in einer Spalte "parent", jeweils eine Referenz auf den

Tupel des Vaterelements (Fürst, 2006). Diese Art der Speicherung erachte ich als sinnvoll, wenn

häufig neue Knoten auf zusätzlichen Hierarchiestufen dazukommen. Diese können einfach

hinzugefügt werden. Die Abfragen sind aber aufwendig.

Die Anzahl der Hierarchiestufen ist in unserem Fall stabil. Der Gemeindedatensatz beinhaltet auch

für jeden Eintrag einen direkten Vorgänger. Es wurde entschieden, für jede Stufe eine Tabelle

anzulegen. Jeder Gemeindeeintrag hat somit genau fünf Hierarchiestufen über sich. Der Vorteil

dieser Abbildung ist insbesondere, dass die von der Komponente benötigte tabellarische Ansicht der

27

Daten leicht erzeugt werden kann. Die Informationen zu den geographischen Entitäten sollen wie

folgt vorliegen:

Abbildung 5, Zielformat Gemeindehierarchie

Mit der gewählten Modellierung können die Hierarchiestufen, mittels einfachen Joins, in einem View

zusammengeführt werden. Ein Vorteil ist ebenfalls, dass die Hierarchiestufen im Schema ersichtlich

sind.

Die Möglichkeit die Daten direkt in einer Tabelle abzuspeichern, die dem obigen View entspricht,

wurde aufgrund der damit entstehenden Redundanzen vermieden. Bei Problemen mit der

Performanz, kann das Resultat einer Abfrage des Views, auch in einer temporären Tabelle

gespeichert werden.

6.1.9 TRENNUNG STAMM- UND BEWEGUNGSDATEN

Die Quelldaten enthalten verschiedene Datensätze, die sich auf ein bestimmtes Datum oder Jahr

beziehen, also Bewegungsdaten. Als Bespiel sollen die Ertragsdaten der Kraftwerke dienen. Für jedes

Kraftwerk ist in der Spalte "Ertrag in kWh" die gelieferte Energie, eines in den Metadaten

bestimmten Jahres, enthalten. Im ULCBigTableExplorer sollen die Erträge wie folgt dargestellt

werden:

Kraftwerksadresse

Ort

Ertrag in kWh 2009

Ertrag in kWh 2010

Tabelle 2, Beispiel Kraftwerkstabelle

Kraftwerksadresse und Ort sind die Stammdaten und die Erträge die Bewegungsdaten. Jedes Jahr

kommt eine neue Spalte hinzu. Es ist anzumerken, dass die Stammdaten nicht verändert werden,

dass heisst es findet keine Stammdatenpflege statt. Des Weiteren werden die Daten in der Form wie

sie auch in der Komponente angezeigt werden, geliefert. Natürlich jeweils nur für ein Jahr.

Die folgenden Optionen waren denkbar:

Stamm- und Bewegungsdaten in einer Tabelle. Die Tabelle entspricht genau der Ansicht in der

Komponente und ebenfalls der Struktur des angelieferten Files. Jedes Jahr müsste die

Datenbanktabelle um eine Spalte ergänzt werden.

Vertikale Partitionierung. Die Ertragsdaten würden in eine separate Tabelle ausgelagert und diese

jedes Jahr um eine Spalte ergänzt.

28

Spaltenorientierte Jahrestabellen. Die Bewegungsdaten würden pro Jahr in eine Tabelle ausgelagert.

Jedes Jahr würde eine neue Tabelle erzeugt.

Zeilenorientierte Tabelle für die Bewegungsdaten. Für jedes Kraftwerk werden die Bewegungsdaten

zeilenorientiert gespeichert. Im nächsten Jahr müsste lediglich eine neue Zeile hinzugefügt werden.

fk_kraftwerk

Jahr

Ertrag

…

Tabelle 3, zeilenorientierte Speicherung Bewegungsdaten

Die Begründung für eine Variante soll nach dem Ausschlussverfahren erfolgen. Die Option d. wäre die

offensichtlichste Variante. Bei dieser Variante müssen keine strukturellen Änderungen an der Tabelle

vorgenommen werden. Im ursprünglichen Entwurf des Schemas wurde diese Option gewählt. Zu

Beginn des Projekts war aber noch nicht klar, wie die Bewegungsdaten im ULCBigTableExplorer

dargestellt werden sollen. Die spaltenorientierte Darstellung (Tabelle 2) die gewählt wurde, kommt

einer zeilenorientierten Speicherung der Bewegungsdaten nicht entgegen. Ein SQL Statement, das

die Ertrags- und Vergütungsdaten spaltenorientiert in einem View konsolidiert, könnte wie folgt

aussehen:

SELECT

k.adresse,

g.name,

gv.name as gemeindeverband,

lk.name as landkreis,

rb.name as regierungsbezirk,

ertVerg.ertrag2009,

ertVerg.ertrag2010,

ertVerg.ertrag2011,

ertVerg.verguetung2009,

ertVerg.verguetung2010,

ertVerg.verguetung2011

FROM

kraftwerk k,

gemeinde g,

gemeindeverband gv,

landkreis lk,

regierungsbezirk rb,

(

SELECT

ev.fk_kraftwerk as kraftwerk,

ev2009.ertrag_kwh as ertrag2009,

ev2010.ertrag_kwh as ertrag2010,

ev2011.ertrag_kwh as ertrag2011,

ev2009.verguetung_euro as verguetung2009,

ev2010.verguetung_euro as verguetung2010,

ev2011.verguetung_euro as verguetung2011

FROM ertrag_verguetung ev

INNER JOIN ertrag_verguetung ev2009

ON ev.fk_kraftwerk = ev2009.fk_kraftwerk AND ev2009.jahr = 2009

INNER JOIN ertrag_verguetung ev2010

ON ev.fk_kraftwerk = ev2010.fk_kraftwerk AND ev2010.jahr = 2010

29

INNER JOIN ertrag_verguetung ev2011

ON ev.fk_kraftwerk = ev2011.fk_kraftwerk AND ev2011.jahr = 2011

GROUP BY ev.fk_kraftwerk

) as ertVerg

WHERE

k.id = ertVerg.kraftwerk AND

g.id = k.gemeinde_id AND

g.gemeindeverband_id = gv.id AND

gv.landkreis_id = lk.id AND

lk.regierungsbezirk_id = rb.id;

Das Problem einer solchen Anfrage ist sofort ersichtlich. Sie ist kompliziert, sicherlich langsam und

muss jedes Jahr abgeändert werden. Der Preis den man für diese Modellierung bezahlt ist zu hoch,

insbesondere um nur ein 'alter table' Statement zu vermeiden. Es gibt auch zu erwähnen, dass das

Grails Domänenobjekt das der konsolidierten Datenbanktabelle entspricht, auch jedes Jahr

abgeändert werden müsste, unabhängig davon in welcher Form die Bewegungsdaten vorliegen. Des

Weiteren ist es sehr wahrscheinlich, dass zukünftig weitere Spalten mit neuen Informationen zu den

Kraftwerken vorhanden sind. Eine zeilenorientierte Tabelle müsste daher auch um eine Spalte

ergänzt werden. Die Möglichkeit die Spalten erst auf der Applikationsebene zu bilden würde das

Problem zwar lösen, aber es wären keine flexiblen Voraggregationen möglich (siehe 6.1.10).

Es wurde entschieden die Stamm- und Bewegungsdaten in einer Tabelle zu speichern, dass heisst in

der Form in der sie bereits im angelieferten File vorliegen und wie sie vom ULCBigTableExplorer

benötigt werden (Option a.). Wenn neue Daten dazukommen wird die Tabelle um eine Spalte

erweitert. Der Vorteil dieser Option ist auch der vereinfachte Import der Daten, durch die

Entsprechungen in der Struktur.

Die Optionen b. und c. bieten keine Vorteile gegenüber Option a. und wurden nicht weiter in

Betracht gezogen.

Eine Schwierigkeit ergibt sich bezüglich der Metainformationen, zum Beispiel dem Dateinamen.

Diese sind in der Tabelle meta_info gespeichert und über die Tabelle meta_info_mapper mit den

Datensätzen verknüpft. Diese Metadaten beziehen sich jeweils auf einen Tupel der Stammdaten bzw.

einer Spalte der Bewegungsdaten, zum Beispiel auf die Spalte Ertrag2009. Es wurde entschieden den

Spalten mit den Bewegungsdaten jeweils eine Spalte für den Fremdschlüssel auf die

Metainformationen hinzufügen. Die Spalten Ertrag2009 und Verguetung2009 hätten zum Beispiel

eine Spalte fk_ev2009_meta_info_mapper, die auf den entsprechenden meta_info_mapper Tupel

referenziert.

30

6.1.10 DATENBANK VIEWS

Es wurde entschieden für die Analysen verschiedene Datenbank Views zu erstellen. Damit kann

schon von der Datenbank her, die benötigte tabellarische Ansicht erzeugt werden. Auch ist es

möglich schon Voraggregation zu machen. Es sind drei Views vorhanden:

KraftwerksView

Dieser View ist auf Kraftwerksebene. Es handelt sich um einen virtuellen View, das heisst das DBMS

erzeugt im Hintergrund die entsprechenden Abfragen. Es gibt keine Aggregation da die

Kraftwerksdaten die unterste Ebene sind.

GemeindeView

Dieser View ist auf Gemeindeebene. Es handelt sich um einen materialisierten View. Weil MySQL

dieses Konzept nicht unterstützt wurde einfach eine zusätzliche Tabelle gefüllt. Bei neuen Daten

muss diese wieder aktualisiert werden. Auf Trigger wurde verzichtet. Ein virtueller View konnte nicht

gemacht werden, da MySql keine Views auf Abfragen die Subqueries enthalten erlaubt.

Die Leistungs- /Ertrags und Vergütungsdaten der Kraftwerke wurden hinzu aggregiert. Damit wird es

zum Beispiel möglich die Stromertragsdaten in Beziehung zu der Bevölkerungsanzahl auszuwerten.

GemeindeverbandsView

Dieser View ist auf Gemeindeverbandsebene und enthält Stromverbrauchs- und dazu aggregierte

Ertragsdaten. Er ist ebenso wie der GemeindeView materialisiert.

31

6.1.11 MODELLIERUNG IN GORM

Es soll anhand eines Beispiels die Art der Modellierung in GORM beschrieben werden.

Klasse GemeindeView

Abbildung 6, GORM Klasse GemeindeView

Die Klasse GemeindeView ist das Gegenstück zu dem Datenbank View mit gleichem Namen. Als

erstes sind die Attribute aufgelistet. Wenn Grails gestartet wird und diese Datenbanktabelle noch

nicht besteht wird sie automatisch anhand dieser Informationen erstellt. Bei Änderungen wird sie

auch automatisch angepasst. Natürlich kann dieses Verhalten für den Produktivbetrieb ausgeschaltet

werden.

Die getGeoHierarchie() Methode ist eine getter-Methode für ein quasi virtuelles Attribut geoHierarchie.

Der Zugriff ist wie für ein normales Attribut möglich, gemeindeView.getHierarchie . Das Attribut wird von

einem Kategorisierer des ULCBigTableExplorers verwendet, um eine Gemeindehierarchie

darzustellen, nach deren Einträge gefiltert werden kann. In der mapping Closure (siehe 15.1) wird das

32

Datenbankmapping konfiguriert. Es werden Angaben zu der ID, der Versionierung, dem Cache und

dem Tabellenname gemacht. Die

transient

Closure definiert, dass das

geoHierarchie

Attribut keine

Entsprechung in der Datenbank hat.

Die

constraints

null

sein darf.

33

Closure enthält Validationsinformationen, hier dass der Attributwert bei der Fläche

7

DATENIMPORT

Die Quelldaten wurden mit Hilfe von Importskripten in die Datenbank gespeichert. Es wurde

entschieden die Programmiersprache Groovy zu verwenden. Eine Beschreibung der Sprache befindet

sich in Kapitel 15.4. Mehrere Argumente sprachen für Groovy.

Das für die Integration verwendete Grails Framework (siehe 15.5) ist in Groovy geschrieben. Das

heisst, es konnte die Grails Konsole verwendet werden. Mit diesem kleinen Programm können

Groovy Skripte direkt auf einer Grails Instanz ausgeführt werden. Man hat dadurch Zugriff auf das

Grails API. Man ist insbesondere in der Lage, direkt Domänenobjekte zu instanziieren und zu

speichern. Die Sprache hat ausserdem sehr elegante Mittel um mit Files umzugehen, Webservices

aufzurufen und XML zu verarbeiten. Des Weiteren ist sie sehr Ausdrucksstark, es kann viel mit wenig

Code ausgedrückt werden. Bei Canoo ist ausserdem viel Groovy Know-How vorhanden. Dierk Koenig

ist ein "comitter" beim Groovy Projekt und hat das Buch "Groovy in Action" geschrieben.

7.1

VORGEHEN

Die einzelnen Excel-Files wurden im CSV Format gespeichert. Die Files mussten jeweils in einem

Quelltext Editor geöffnet und zu UTF-8 konvertiert werden. Das Verarbeiten des File Inhalts, kann in

Groovy in einer Closure (siehe 15.1) erledigt werden.

Ein fragmentarisches Beispiel von dem Skript GemeindedatenImport.groovy soll die grundlegende

Funktionsweise exemplarisch aufzeigen.

Hier wird über die Gemeindedaten iteriert. Die Methode "splitEachLine" zerteilt jede Zeile des CSVFiles auf dem angegeben Zeichen und übergibt die Liste der Teilstrings der Closure. Der Ausdruck

fields[7]?.trim()

34

zeigt die Prägnanz von Groovy. Das Fragezeichen verhindert eine NullPointerException

wenn das achte ([7]) Element null ist. Anschliessend wird ein Gemeindeverband-Objekt erzeugt und

mit dem Aufruf der Methode

save()

gespeichert. Diese Methode wird dem Objekt dynamisch vom

Framework hinzugefügt und muss nicht implementiert werden (Metaprogrammierung) (Ledbrook,

2009). Andere Entitäten die im Gemeindevebandsobjekt gekapselt sind, werden gleich

mitgespeichert. Hier zum Beispiel das Landkreis Objekt. Um das Eintragen des Fremdschlüssels in der

Datenbank muss sich der Entwickler nicht kümmern. Dies wird von Grails übernommen.

Grails arbeitet mit dem Persistenz-Framework Hibernate (Ledbrook, 2009). Um die Zeitdauer des

Imports zu verkürzen, wurden bei allen Skripten die Inserts in eine Transaktion gepackt und auf der

Hibernate Session jeweils nach 100 Datensätzen die

flush()

Methode aufgerufen. Dies veranlasst

Hibernate ein einziges Insert Statement abzusetzen. Der Aufruf der

save()

Methode auf der

Domäneninstanz führt also nicht direkt zu einem Insert. Der folgende Code zeigt die konkrete

Implementierung für die Kraftwerksdaten.

In der

cleanUpGorm()

Methode wird die aktuelle Hibernate Session von der SessionFactory abgefragt

und die mittels des Aufrufs von

daraufhin gelöscht.

35

flush()

die Daten in die Datenbank geschrieben. Die Session wird

8

DATENINTEGRATION

Der eigentliche Datenintegrationsteil der vorliegenden Arbeit, war das Mapping der EEGKraftwerksdaten auf die Gemeindedaten des statistischen Amtes. Letztere stellen die Referenz für

alle anderen Datensätze dar, die einer geographischen Entität zugeordnet werden können. Alle

Datensätze müssen sich also darauf beziehen.

8.1

GEMEINDEMAPPING EEG-KRAFTWERKSDATEN

8.1.1 PROBLEM

Die EEG-Kraftwerksdaten besitzen keinen eindeutigen Schlüssel mit dem die Datensätze direkt einer

geographischen Entität, also in unserem Fall einer Gemeinde, zugeordnet werden könnten. Es sind

jeweils nur die Gemeindenamen und die jeweilige Postleitzahl vorhanden.

8.1.2 NORMALISIERUNG DER GEMEINDENAMEN

Der EEG-Datensatzes und der Gemeindedatensatz wurden jeweils um den normalisierten

Gemeindenamen ergänzt. Ein Gemeindename wie "Bad Münster am Stein-Ebernburg, Stadt" wurde

zum Beispiel um seinen normalisierten Namen, nämlich "BAD MUENSTER" ergänzt. Am Anfang der

Arbeit wurde davon ausgegangen, dass die Gemeindedaten des OpenGEODB Projekts (siehe 5.3.4)

Verwendung finden. Diese enthalten bereits den normalisierten Gemeindenamen. Dieser Datensatz

wurde zu Gunsten der offiziellen Gemeindedaten vom statistischen Amt aufgegeben. Das Mappen

mit dem normalisierten Gemeindenamen war aber auch bei den schliesslich benutzen Datensätzen

eine erfolgreiche Strategie. Insbesondere die Gemeindenamen des EEG-Kraftwerksdatensatzes

mussten sowieso bereinigt werden, da sie Schrägstriche und teilweise Zahlen enthielten.

8.1.3 VORGEHEN NORMALISIERUNG

Der Gemeindenamen wurde bei den folgenden Zeichen und Wörtern getrennt:

, | bei | am | an | vor | im | unter | bin | ( | /

36

Der linke Teilstring wurde wie folgt weiter verarbeitet:

Umlaute konvertieren: ä -> ae; Ä -> Ae; ö -> oe; Ö -> Oe; ü -> ue; Ü -> Ue

St. -> Sankt

Alles zu Grossschrift konvertieren

8.1.4 ZUORDNUNGSHEURISTIK

Es wurde versucht möglichst viele der Datensätze automatisiert zuzuordnen, um den manuellen

Aufwand klein zu halten. Hier werden die verschiedenen Schritte des Mappings beschrieben. Wenn

bei einem Schritt eine Zuordnung möglich war, wurde der Vorgang abgebrochen.

Mit Gemeindename wird immer der "normalisierte" Gemeindename gemeint. Mit Referenzdaten

werden die Gemeindedaten des statistischen Amtes gemeint.

Schritt 1, Direkte Zuordnung über den Gemeindenamen und die Plz.

Die Angaben zum Gemeindenamen und der Postleitzahl im Kraftwerksdatensatz wurden verwendet,

um das korrespondierende Objekt im Gemeindedatensatz zu finden.

Der Methodenaufruf auf dem Gemeindenamen zeigt wiederum die Eleganz des Grails-Frameworks.

Die Methode

findByNameNormalisertAndPlz(name,

plz)

ist implizit vorhanden und muss nicht

programmiert werden. Der Rückgabewert ist ein Objekt des Typs Gemeinde oder null. In SQL

entspräche der Aufruf einem select

* from Gemeinde where nameNormalisiert = :name AND plz = :plz; .

Diese

Anfragemethoden heissen bei Grails "dynamic finders" (Ledbrook, 2009). Viele verschiedene

Anfragemethoden sind "out-of-the-box" vorhanden.

Schritt 2, Nutzung der MappingHelper Tabelle

Einige Datensätze wurden schon früher manuell zugeordnet und die Zuordnungen in der

Datenbanktabelle MappingHelper abgelegt. Auf diese Tabelle wurde ein Lookup mittels der

Postleitzahl und dem normalisierten Namen des EEG-Kraftwerksdatensatzes gemacht.

37

Schritt 3, Eindeutiger Gemeindename und Levenshtein-Distanz von Plz höchstens 1

Bei diesem Schritt wurden zuerst überprüft, ob der Gemeindename im EEG-Kraftwerksdatensatz im

Referenzdatensatz eindeutig ist. Falls dem so war, wurde überprüft, ob die Postleitzahl eine

Levenshtein-Distanz (siehe 15.2) von höchstens eins hat und in diesem Fall direkt gemappt.

Zusätzlich wurde der Yahoo Gelocations Webservice verwendet um die Wahrscheinlich der korrekten

Zuordnung zu beurteilen, getQualityByYahooLookup(plzRef,

name, adresse) .

Bei Schritt 8 wird dieser Aufruf

beschrieben.

Schritt 4, Eindeutiger Gemeindename

Es wurde überprüft, ob der Gemeindename in den Referenzdaten Eindeutigkeit ist und in diesem Fall

direkt gemappt.

38

Schritt 5, Inhaltsvergleich Gemeindename

Alle Gemeinden, mit der im EEG-Kraftwerksdatensatz angegeben PLZ, wurden aus den Referenzdaten

geladen und überprüft, ob der Gemeindename des EEG-Datensatzes in einem Gemeindename der

geladenen Referenzdaten vorkommt oder ob einer der Gemeindenamen des Referenzdatensatzes in

dem Gemeindenamen des EEG-Datensatzes vorkommt.

39

Schritt 6, Levenshtein-Distanz

Alle Gemeinden, mit der im EEG-Kraftwerksdatensatz angegeben PLZ, wurden aus den Referenzdaten

geladen und überprüft, ob der Gemeindename des EEG-Datensatzes im Vergleich mit einem

Gemeindename der geladenen Referenzdaten, eine Levenshtein-Distanz (siehe 15.2) von kleiner 20

Prozent der Namenslänge besass.

Schritt 7, OpenGeoDB-Lookup

Im EEG-Kraftwerksdatensatz sind einige Kraftwerke nicht einer Gemeinde, sondern einem

Gemeindeteil bzw. Stadtteil zugeordnet. Die Referenzdaten sind aber nur bis Stufe Gemeinde

vorhanden. Um heraus zu finden, in welcher Gemeinde dieses Kraftwerk liegt, wurde die

OpenGeoDB-Datenbank (siehe 5.3.4) verwendet. Diese wurde in die lokale Datenbank eingespielt.

Danach wurde in diesen Daten nach der PLZ und dem Gemeindenamen des EEGKraftwerksdatensatzes gesucht. Falls ein Eintrag auf dem Level 7 (Gemeindeteil) oder Level 8

(Stadtteil) gefunden wurde, wurde das entsprechende Vaterelement über die loc_id ausgelesen. Falls

diese auf dem Level 6 war (Gemeinde), wurde diese Gemeinde in den Referenzdaten gesucht.

40

Schritt 8, Yahoo Lookup mit PLZ, Gemeindename und Adresse

Mit der Postleitzahl, dem Gemeindenamen und der Adresse des Kraftwerks wurde der Yahoo

Geolocation Webservice (Yahoo, 2011) angefragt.

41

Dieser liefert einen XML-Response zurück. Erneut konnte die Ausdrucksstärke von Groovy zum Zuge

kommen. Das Aufrufen des Yahoo Webservices und das Auslesen der PLZ benötigt einen Einzeiler:

new XMLParser().parse(url).Result.uzip.text()

Die Struktur des zurückgelieferten XML ist in Abbildung 7 ersichtlich.

Wenn die Adressezuordnung eine Qualität von über 80 hatte, wurde der zurückgelieferte "city"Name von Yahoo und die PLZ verwendet um die Gemeinde in den Referenzdaten nachzuschlagen.

Schritt 9, Yahoo Lookup der übergeordneten Gemeinde

Da der Referenzdatensatz, wie schon erwähnt, nur Informationen auf Gemeindeebene enthält,

mussten die EEG-Kraftwerksdatensätze, die sich auf Gemeindeteile oder Stadtteile beziehen einer

übergeordneten Gemeinde zugeordnet werden. Das unter Schritt 7 beschriebene Vorgehen nutzte

dazu die Daten der OpenGeoDB. Hier wurde der Yahoo Geolocation Webservice verwendet. Der

Gemeindename und die PLZ der EEG-Kraftwerksdaten wurden an den Webservice geschickt.

Der XML-Response von Yahoo hat die folgende Struktur:

42

Abbildung 7, XML-Response Yahoo Geolokationsservice

Unter dem Knoten neighborhood ist der gesuchte Gemeindeteil und unter dem Knoten city die

übergeordnete Gemeinde. Diese wurde ausgelesen und mit der PLZ des EEG-Kraftwerksdatensatzes

in den Referenzdaten gesucht. In der Yahoo Dokumentation wird das neighborhood Element wie

folgt beschrieben: "The neighborhood element describes an area that is contained within a larger

administrative place (city)." (Yahoo, 2011)

43

Schritt 10, Yahoo Lookup mit PLZ und Adresse

Dieser ist fast identisch zum Schritt 8. Es wurde aber die PLZ und die Adresse zum Abfragen des

Yahoo Webservices verwendet.

8.1.5 RESULTATE

Im EEG-Datensatz gibt es 2797 unterschiedliche Gemeindename. 2728 Gemeinden konnten gemappt

werden, 69 nicht. Dies entspricht einer Mappingquote vom 97.5%. In Rheinland Pfalz gibt es nur 2306

Gemeinden. Die Differenz ist durch die Gemeinde- oder Stadtteile und falsche Schreibweisen der

Gemeindenamen zu erklären.

In der nachfolgenden Tabelle ist ersichtlich, wie viele der Datensätze mit welchem Schritt gemappt

wurden. Es wird die absolute Anzahl und das Verhältnis zu der Gesamtanzahl der Gemeindenamen

angegeben.

Schritt

1

2

3

4

5

6

7

8

9

10

nicht gemappt

Total

Tabelle 4, Gemeindemapping Resultate

44

Anzahl

2217

105

41

27

126

86

0

50

52

24

69

2797

%

80

4

2

1

4

3

0

1.5

1.5

1

2

100

Für 80 Prozent der Datensätze ist ein Mapping direkt über den Namen und die PLZ möglich. Es

bleiben aber fast 600 Datensätze übrig. Diese manuell zu mappen wäre sehr mühsam. Die Heuristik

hilft noch bei weiteren 511 Datensätzen. Insbesondere der Lookup auf die MappingHelper Tabelle

(Schritt 2) und der Inhaltsvergleich des Gemeindenamens (Schritt 5) sind erfolgreich. Enttäuschend

ist der Lookup auf die Open Geo DB (Schritt 7). Hier war kein Mapping möglich.

Die fehlenden Mappings wurden vom Projektpartner manuell ergänzt. Bei einer handvoll