Vorlesungsmitschrift - S-Inf

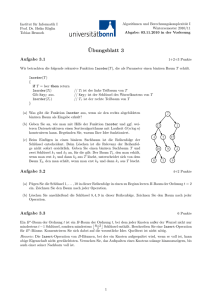

Werbung