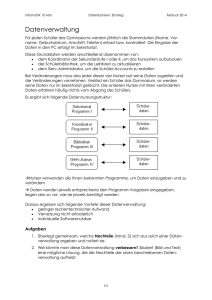

vts_1381. - OPARU

Werbung