Lineare Algebra 1

Werbung

Lineare Algebra 1

Anton Deitmar

WS 2013/14

Inhaltsverzeichnis

1 Grundlagen

1.1 Mengen . . . . . . . . . .

1.2 Abbildungen . . . . . . .

1.3 Komposition . . . . . . .

1.4 Produkte und Relationen

1.5 Vollständige Induktion .

.

.

.

.

.

1

1

4

8

9

11

.

.

.

.

18

18

22

25

30

3 Vektorräume

3.1 Räume und Unterräume . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.2 Summen und direkte Summen . . . . . . . . . . . . . . . . . . . . . . . .

36

36

39

4 Dimension

4.1 Linearkombinationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Lineare Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Basen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

43

45

48

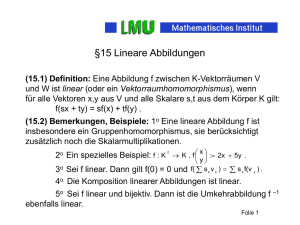

5 Lineare Abbildungen und Matrizen

5.1 Erste Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2 Kern und Bild . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

54

54

58

2 Gruppen und Körper

2.1 Gruppen . . . . . . . .

2.2 Körper . . . . . . . . .

2.3 Die Körper Q, R und C

2.4 Polynome . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

i

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Lineare Algebra 1

5.3

5.4

5.5

5.6

Matrizen . . . . . . .

Matrixmultiplikation

Blockmatrizen . . . .

Basiswechsel . . . . .

ii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

61

63

68

69

6 Gauß-Elimination

6.1 Zeilentransformationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Lineare Gleichungssysteme . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3 Rang . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

73

73

76

79

7 Determinanten

7.1 Permutationen . . . . . . . . . . . . . . . . .

7.2 Determinante und Zeilentransformationen

7.3 Multiplikativität . . . . . . . . . . . . . . . .

7.4 Laplace-Entwicklung . . . . . . . . . . . . .

.

.

.

.

81

81

85

88

89

.

.

.

.

93

93

94

95

103

.

.

.

.

108

108

111

113

115

8 Eigenwerte

8.1 Ein Beispiel . . . . . . . . . . . . . . . . . . .

8.2 Lineare Unabhängigkeit von Eigenvektoren

8.3 Das charakteristische Polynom . . . . . . .

8.4 Der Satz von Cayley-Hamilton . . . . . . .

9 Der Jordan-Normalform Satz

9.1 Nilpotente Endomorphismen

9.2 Hauptraum-Zerlegung . . . .

9.3 Jordan-Matrizen . . . . . . . .

9.4 Berechnung der Normalform

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10 Dualraum und Quotient

117

10.1 Der Dualraum . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

10.2 Quotienten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122

11 Dimension

11.1 Das Lemma von Zorn . . . . .

11.2 Kardinalzahlen . . . . . . . .

11.3 Abzählbarkeit . . . . . . . . .

11.4 Basen beliebiger Vektorräume

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

127

127

128

131

134

Lineare Algebra 1

iii

Lineare Algebra 1

1

1.1

1

Grundlagen

Mengen

Eine Menge ist eine (gedachte) Zusammenfassung von (wirklichen oder gedachten)

Objekten, die die Elemente der Menge genannt werden.

no

Beispiele 1.1.1.

• Die Leere Menge = ∅.

n

o

• Die Menge 1, 2, 3 der Zahlen 1,2,3.

n

o

• Die Menge N = 1, 2, 3, . . . der natürlichen Zahlen.

Zwei Menge heißen gleich, falls sie die gleichen Elemente haben. In Worten:

N=M

⇔

(x ∈ N ⇔ x ∈ M).

Eine Menge A ist Teilmenge einer Menge B, falls jedes Element von A schon in B liegt,

also

A ⊂ B ⇔ (x ∈ A ⇒ x ∈ B).

Folgerung. Zwei Mengen M, N sind genau dann gleich, wenn jede Teilmenge der

anderen ist, also

M = N ⇔ (M ⊂ N und N ⊂ M).

Sei M eine Menge. Die Potenzmenge P(M) von M ist definiert als die Menge aller

Teilmengen von M.

n

o

Beispiel 1.1.2. Sei M = 1, 2, 3 . Dann ist

n

o

P(M) = ∅, {1}, {2}, {3}, {1, 2}, {1, 3}, {2, 3}, {1, 2, 3} .

Seien A und B Mengen. Der Durchschnitt A ∩ B von A und B ist die Menge der

gemeinsamen Elemente:

x∈A∩B

⇔

x ∈ A und x ∈ B ,

oder, was das Gleiche bedeutet:

n

o

A∩B= x∈A:x∈B .

Lineare Algebra 1

2

Beispiel 1.1.3.

n o n o n o

1, 2 ∩ 2, 3 = 2 .

Zwei Menge A und B heißen disjunkt, falls A ∩ B = ∅, sie also keine gemeinsamen

Elemente haben.

Die Vereinigung zweier Mengen A ∪ B ist die Menge aller x, die in mindestens einer

der beiden Mengen liegen, also

x ∈ (A ∪ B)

⇔

x ∈ A oder x ∈ B .

Beispiel 1.1.4.

n

o n o n

o

1, 2 ∪ 2, 3 = 1, 2, 3 .

Proposition 1.1.5. Sind A, B, C Mengen, dann gilt

(a) A ∩ (B ∪ C) = (A ∩ B) ∪ (A ∩ C),

(b) A ∪ (B ∩ C) = (A ∪ B) ∩ (A ∪ C).

B

A

C

Beweis. Für (a) rechnen wir

⇔

⇔

⇔

⇔

⇔

x ∈ A ∩ (B ∪ C)

x ∈ A und x ∈ B ∪ C

x ∈ A und (x ∈ B oder x ∈ C)

(x ∈ A und x ∈ B) oder (x ∈ A und x ∈ C)

(x ∈ A ∩ B) oder (x ∈ A ∩ C)

x ∈ (A ∩ B) ∪ (A ∩ C)

Def.

Def.

(*)

Def.

Def.

Lineare Algebra 1

3

(*) Für beliebige Aussagen A, B, C gilt:

A und (B oder C)

⇔

(A und B) oder (A und C).

Die Aussage (*) schliesslich beweist man wie folgt. Es gibt folgende Möglichkeiten:

Die Aussage A ist entweder wahr oder falsch. Ebenso für B und C. Daraus ergeben

sich folgende mögliche Konstellationen:

A B C B oder C A und (B oder C)

w

w

w

w

f

f

f

f

w

w

f

f

w

w

f

f

w

f

w

f

w

f

w

f

w

w

w

f

w

w

w

f

w

w

w

f

f

f

f

f

und andererseits

A B C A und B A und C (A und B) oder (A und C)

w

w

w

w

f

f

f

f

w

w

f

f

w

w

f

f

w

f

w

f

w

f

w

f

w

w

f

f

f

f

f

f

w

f

w

f

f

f

f

f

w

w

w

f

f

f

f

f

Durch Vergleich der beiden letzten Spalten folgt (*).

Teil (b) beweist man analog.

Die Menge der natürlichen Zahlen

n

o

N = 1, 2, 3, . . .

Lineare Algebra 1

4

erweitert man zur Menge der ganzen Zahlen

n

o

Z = . . . , −2, −1, 0, 1, 2, . . .

und diese zur Menge der rationalen Zahlen

p, q ∈ Z, q > 0

p

:

Q=

q p und q sind teilerfremd

.

Wir haben also

N ⊂ Z ⊂ Q ⊂

R

|{z}

⊂

die reellen Zahlen

C

|{z}

.

die komplexen Zahlen

Man beschreibt Teilmengen gern durch Eigenschaften

n

o

x ∈ X : x hat Eigenschaft E .

Beispiel 1.1.6.

n

o n

o

n ∈ N : n ≤ 5 = 1, 2, 3, 4, 5 .

Ist Y ⊂ X, so heißt die Menge

n

o

XrY= x∈X :x<Y

das Komplement von Y in X.

n

o

Beispiel 1.1.7. Z r N = . . . , −2, −1, 0 .

Man verwendet die Schreibweise X r Y aber auch, wenn Y keine Teilmenge von X ist.

n o n o n o

Beispiel 1.1.8. 1, 2 r 2, 3 = 1 .

1.2

Abbildungen

Sind X, Y Mengen, so ist eine Abbildung f : X → Y eine Zuordnung, die jedem

Element x von X genau ein Element y = f (x) von Y zuordnet.

n

o

n o

Beispiele 1.2.1.

• f : 1, 2, 3 → 4, 5

f (1) = 4,

f (2) = 4

f (3) = 5.

Lineare Algebra 1

5

• f :R→R

f (x) = x2 .

• Auf jeder gegebenen Menge X gibt es eine kanonische Abbildung X → X,

nämlich die Identität

IdX : X → X; x 7→ x.

Definition 1.2.2. Eine Abbildung f : X → Y heißt injektiv, falls verschiedene

Elemente verschiedene Bilder haben, also wenn für alle x, x0 ∈ X gilt

x , x0 ⇒ f (x) , f (x0 ),

oder, anders ausgedrückt, wenn

f (x) = f (x0 ) ⇒ x = x0 .

injektiv:

'$

x

x

x

x

'$

x

x

- x

- x

x

-

&%

&%

nicht injektiv:

'$

x

x

x

x

&%

'$

:

x

x

x

x

x

&%

Lineare Algebra 1

6

Beispiele 1.2.3.

• Die Abbildung f : R → R mit f (x) = x2 ist nicht injektiv, denn

f (1) = f (−1) = 1.

• Die Abbildung f : R → R mit f (x) = x3 ist injektiv.

Definition 1.2.4. Eine Abbildung f : X → Y heißt surjektiv, falls es zu jedem y ∈ Y ein

x ∈ X gibt mit f (x) = y, wenn also jedes y ∈ Y getroffen wird.

surjektiv:

'$

x

x

x

x

'$

:

&%

x

x

x

&%

nicht surjektiv:

'$

x

x

x

x

'$

:

&%

x

x

x

x

x

&%

Beispiele 1.2.5.

• Die Abbildung F : R → R mit f (x) = x2 ist nicht surjektiv, da es

kein x ∈ R gibt mir f (x) = −1.

• Die Abbildung f : R → R mit f (x) = x3 ist surjektiv.

Eine Abbildung f : X → Y die sowohl injektiv als auch surjektiv ist, heißt bijektiv.

Lineare Algebra 1

7

Satz 1.2.6. Ist X eine endliche Menge und ist f : X → X eine Selbstabbildung, so sind

äquivalent:

(a) f ist injektiv,

(b) f ist surjektiv,

(c) f ist bijektiv.

n

o

Beweis. Sei X = x1 , . . . , xn mit n Elementen.

(a)⇒(b) Da f (x1 ), . . . , f (xn ) alle verschieden sind, sind es wieder n Elemente, also

n

o

f (x1 ), . . . , f (xn ) = X, damit ist f surjektiv.

(b)⇒(c) Sei f surjektiv. Wir haben zu zeigen, dass f injektiv ist. Wegen

n

o n

o

f (x1 ), . . . , f (xn ) = x1 , . . . , xn müssen die f (x1 ), . . . , f (xn ) paarweise verschieden sein,

also ist f injektiv.

Die Richtung (c)⇒(a) ist trivial.

Definition 1.2.7. Eine Permutation auf einer Menge M ist eine bijektive Abbildung

M → M. Mit Per(M) bezeichnen wir die Menge aller Permutationen auf M. Ist

n = 1, 2, 3, . . . eine natürliche Zahl, so bezeichnet Per(n) die Menge der Permutationen

n

o

auf der Menge 1, 2, 3, . . . , n .

Die Menge Per(1) hat ein Element. Die Menge Per(2) hat zwei Elemente, die Menge

Per(3) hat sechs Elemente:

1 2 3 1 2 3

1 2 3 1 3 2

1 2 3

2 1 3

1 2 3 1 2 3

3 2 1 3 1 2

1 2 3

2 3 1 .

Lineare Algebra 1

1.3

8

Komposition

Seien f : X → Y und g : Y → Z Abbildungen, so kann man ihre Komposition g ◦ f

(lies: “geh nach eff”) bilden, dies ist eine Abbildung von X nach Z definiert durch

g ◦ f (x) = g( f (x)).

Man visualisiert dies durch ein Diagramm:

f

X

g◦ f

/Y

g

Z.

Beispiel 1.3.1. Ist f : X → Y, dann gilt f ◦ IdX = f und IdY ◦ f = f .

Lemma 1.3.2 (Assoziativität der Komposition). Seien f : W → X, g : X → Y und

h : Y → Z Abbildungen. Dann gilt

h ◦ (g ◦ f ) = (h ◦ g) ◦ f.

Beweis. Sei w ∈ W, dann gilt

h ◦ (g ◦ f )(w) = h(g ◦ f (w)) = h(g( f (w))) = (h ◦ g)( f (w)) = (h ◦ g) ◦ f (w).

Proposition 1.3.3. Sind g und f beide injektiv, so ist g ◦ f injektiv. Ebenso für surjektiv.

Beweis. Es seien beide injektiv und x , x0 in X. Da f injektiv ist, folgt f (x) , f (x0 ). Da g

injektiv ist, folgt hieraus g ◦ f (x) = g( f (x)) , g( f (x0 )) = g ◦ f (x0 ). Also ist g ◦ f injektiv.

Es seien beide surjektiv. Sei z ∈ Z. Da g surjektiv ist, gibt es ein y ∈ Y mit g(y) = z. Da f

surjektiv ist, gibt es ein x ∈ X mit f (x) = y. Dann folgt g ◦ f (x) = g( f (x)) = g(y) = z.

Also ist g ◦ f surjektiv.

Insbesondere ist die Komposition bijektiver Abbildungen bijektiv.

Eine Abbildung f : X → Y heißt invertierbar, wenn es eine Abbildung g : Y → X gibt

mit

g ◦ f = IdX und f ◦ g = IdY .

Lineare Algebra 1

9

Satz 1.3.4. (a) Sei f eine invertierbare Abbildung. Dann ist die Abbildung g mit

f ◦ g = IdY und g ◦ f = IdX eindeutig bestimmt. Wir nennen sie die inverse

Abbildung oder Umkehrabbildung und schreiben g = f −1 .

(b) Eine Abbildung f : X → Y ist genau dann invertierbar, wenn sie bijektiv ist.

Beweis. (a) Wir nehmen an, es gibt eine weitere Abbildung h : Y → X mit h ◦ f = IdX

und f ◦ h = IdY . Dann gilt

g = g ◦ IdY = g ◦ ( f ◦ h) = (g ◦ f ) ◦ h = IdX ◦ h = h,

also g = h wie behauptet.

(b) Sei f : X → Y eine Abbildung. Wir müssen zeigen:

f invertierbar ⇔ f bijektiv.

“⇒” Sei f invertierbar und sei f −1 die Umkehrabbildung. Sind x, x0 ∈ X mit

f (x) = f (x0 ), so gilt x = IdX (x) = f −1 ◦ f (x) = f −1 ( f (x)) = f −1 ( f (x0 )) = IdX (x0 ) = x0 , also

x = x0 , somit ist f injektiv. Sei ferner y ∈ Y, so gibt es ein x ∈ X, nämlich x = f −1 (y) mit

f (x) = f ( f −1 (y)) = y, also ist f auch surjektiv.

“⇐” Sei f bijektiv und sei y ∈ Y. Dann existiert ein x ∈ X mit f (x) = y, da f surjektiv

ist. Da f obendrein injektiv ist, ist x eindeutig bestimmt. Wir definieren also g(y) = x.

Wir machen dies für jedes y ∈ Y und definieren so eine Abbildung g : Y → X, die nach

Definition die Gleichung f ◦ g = IdY erfüllt. Sei x ∈ X und sei y = f (x), dann folgt

x = g(y) und also g( f (x)) = x und also auch g ◦ f = IdX .

1.4

Produkte und Relationen

Das Produkt oder auch das kartesische Produkt X × Y zweier Mengen X und Y ist

definiert als die Menge aller Paare (x, y) wobei x ∈ X in y ∈ Y ist.

n o n

o n

o

Beispiele 1.4.1.

• 1, 2 × 3, 4, 5 = (1, 3), (1, 4), (1, 5), (2, 3), (2, 4), (2, 5) .

• Die Menge R × R kann als die Ebene verstanden werden.

Lineare Algebra 1

10

Sei X eine Menge. Eine Relation auf X ist eine Teilmenge R ⊂ X × X. Wir schreiben

dann x ∼R y oder einfach x ∼ y für (x, y) ∈ R.

Beispiele 1.4.2.

• X = Menge aller Menschen,

x∼y

⇔

x ist Vetter von y

• X = R,

x∼y

⇔

x≤y

• X = Z,

x∼y

⇔

x − y ist gerade.

Eine Relation ∼ heißt Äquivalenzrelation, falls für x, y, z ∈ X gilt

1.

2.

3.

x∼x

x∼y ⇒ y∼x

x ∼ y, y ∼ z ⇒ x ∼ z

Reflexivität

Symmetrie

Transitivität.

Falls ∼ eine Äquivalenzrelation ist und x ∼ y gilt, so sagt man: x ist äquivalent zu y.

Beispiele 1.4.3.

• Die “Vetternwirtschaft” ist keine Äquivalenzrelation, denn es

kann sein, dass x ein Vetter von y ist und y ein Vetter von z, aber x kein Vetter

von z.

• x ≤ y ist keine Äquivalenzrelation, denn 0 ≤ 1, aber 1 0.

• x ∼ y ⇔ x − y ist gerade ist eine Äquivalenzrelation.

Sei ∼ eine Äquivalenzrelation auf der Menge X. Für x ∈ X sei

def

[x] =

n

o

y∈X:y∼x

die Äquivalenzklasse von x.

Proposition 1.4.4. Ist ∼ eine Äquivalenzrelation auf X, so zerfällt X in paarweise disjunkte

Äquivalenzklassen. Ist umgekehrt eine Zerlegung von X in paarweise disjunkte Teilmengen

gegeben:

[

·

X=

Xi

i∈I

Lineare Algebra 1

11

So definiert man eine Äquivalenzrelation ∼ durch

x∼y

⇔

x und y liegen in derselben Menge Xi .

Man kann also sagen: Eine Äquivalenzrelation auf einer Menge X ist dasselbe wie

eine disjunkte Zerlegung von X in Teilmengen.

Beweis. Sei ∼ eine Äquivalenzrelation. Wegen der Reflexivität liegt jedes x ∈ X in einer

Äquivalenzklasse, nämlich x ∈ [x]. Wir müssen zeigen, dass für x, y ∈ X gilt, dass

entweder [x] = [y] oder [x] ∩ [y] = ∅. Dies geht wie folgt: Nimm an, dass [x] ∩ [y] , ∅,

dann existiert ein z ∈ X mit z ∼ x und z ∼ y. Dann folgt x ∼ z wegen der Symmetrie.

Nach Transitivität folgt dann x ∼ y, wir müssen hieraus folgern, dass [x] = [y] ist. Wir

zeigen [x] ⊂ [y] und [y] ⊂ [x]. Sei zunächst u ∈ [x], also u ∼ x. Es gilt x ∼ y und daher

nach Transitivität u ∼ y, also u ∈ [y], wir habe also [x] ⊂ [y] gezeigt. Wegen Symmetrie

ist aber auch y ∼ x und daher folgt ebenso [y] ⊂ [x].

Die Tatsache, dass jede Zerlegung von X eine Äquivalenzrelation definiert, sei dem

Leser zur Übung überlassen.

1.5

Vollständige Induktion

Ist A(n) eine Aussage, die für eine natürliche Zahl n Sinn macht, so gilt

⇒ A(n) gilt für jedes n ∈ N.

A(n) ⇒ A(n + 1)

für jedes n ∈ N

A(1) gilt,

Beispiel 1.5.1. Für jede natürliche Zahl n gilt

1 + 2 + 3 + ··· + n =

n(n + 1)

.

2

Beweis. Induktionsanfang: Für n = 1 ist die Behauptung wahr, denn die linke Seite ist 1

1(1+1)

und die rechte Seite ist 2 = 22 = 1.

Induktionsschritt: n → n + 1 Wir nehmen an, die Behauptung A(n) gilt für n. Wir

Lineare Algebra 1

12

rechnen dann

1 + 2 + · · · + n +(n + 1) =

|

{z

}

=

n(n + 1)

+n+1

2

n(n+1)

2

=

n2 + n + 2n + 2 (n + 1)(n + 2)

=

.

2

2

Also haben wir gezeigt, dass aus der Behauptung für n folgt:

1 + 2 + · · · + n + (n + 1) =

(n + 1)(n + 2)

.

2

Dies ist aber gerade A(n + 1).

Es kann auch passieren, dass eine Aussage A(n) erst ab einer bestimmten Zahl richtig

ist. Wir zeigen dass an folgendem

Beispiel 1.5.2. Für jede natürliche Zahl n ≥ 5 gilt 2n > n2 .

Beweis. Induktionsanfang: n = 5. In diesem Fall rechnen wir

2n = 25 = 32 > 25 = n2 .

Induktionsschritt: n → n + 1. Es gelte 2n > n2 und es sei n ≥ 5. Wir rechnen

2n+1 = 2 · 2n > 2 · n2 = n2 + n2 = n2 + (n − 1)n + n

≥ n2 + 2n + 1 = (n + 1)2 ,

|{z}

für n≥3

dies ist gerade die Behauptung für n + 1.

Es kommt auch vor, dass man im Induktionsschritt nicht nur (n) als Voraussetzung

braucht, sondern dass der Induktionsschritt lautet: A(1), . . . A(n) ⇒ A(n + 1).

Beispiel 1.5.3. Jede natürliche Zahl n ≥ 2 ist ein Produkt von Primzahlen, lässt sich

also schreiben als

n = p1 · p2 · · · pk ,

wobei die Zahlen p1 , . . . , pk Primzahlen sind.

Beweis. Induktionsanfang: n = 2. Diese Zahl ist allerdings selbst eine Primzahl, also

insbesondere ein Produkt von solchen.

Lineare Algebra 1

13

Induktionsschritt: 2, . . . , n → n + 1. Die Behauptung sei wahr für 2, . . . , n. Ist nun n + 1

selbst eine Primzahl, so gilt die Behauptung auch für n + 1. Andernfalls hat n einen

n

o

echten Teiler, sagen wir d. Dann gilt d, n+1

∈

2,

3,

.

.

.

,

n

, damit gilt also die Behauptung

d

n+1

für d und für d , welche damit beide Produkte von Primzahlen sind, also ist auch

n+1=d·

n+1

d

ein Produkt von Primzahlen.

Zur Abkürzung führen wir die das Summenzeichen ein:

n

X

a j = a1 + a2 + · · · + an .

j=1

Beispiel 1.5.4. Für jede natürliche Zahl n gilt

n

X

(2k − 1) = n2 .

k=1

Der Beweis ist eine Übungsaufgabe.

Analog zum Summenzeichen haben wir das Produktzeichen

n

Y

a j = a1 · a2 · · · an .

j=1

So ist zum Beispiel die Fakultät der Zahl n ∈ N definiert als

n! =

n

Y

k = 1 · 2 · · · n.

k=1

Proposition 1.5.5. Die Anzahl aller möglichen Anordnungen einer n-elementigen Menge ist

n!.

n o

Beispiele: Alle Anordnungen der 2-elementigen Menge 1, 2 sind

(1, 2),

(2, 1)

Lineare Algebra 1

14

n

o

also 2 Stück. Alle Anordnungen der 3-elementigen Menge 1, 2, 3 sind

(1, 2, 3), (1, 3, 2), (2, 1, 3), (3, 1, 2), (2, 3, 1), (3, 2, 1),

also 6 = 3 · 2 · 1 = 3!.

Beweis. Wir wollen n-Elemente anordnen. Für die erste Position haben wir die freie

Wahl unter allen n-Elementen. Haben wir die erste Position besetzt, so bleibt uns noch

die Wahl unter n − 1 Elementen, für die ersten beiden Positionen haben wir also

n · (n − 1) verschiedenen Wahlen. Für die dritte Position bleiben (n − 2) viele

Wahlmöglichkeiten und so weiter, bis am Ende die letzte Position vorgegeben ist, so

dass wir im Endeffekt n · (n − 1) · (n − 2) · · · 1 = n! viele Wahlmöglichkeiten haben. Es seien zwei ganze Zahlen 0 ≤ k ≤ n gegeben. Wir definieren den

Binomialkoeffizienten nk durch

!

Anzahl der k-elementigen Teilmengen

n

=

k

einer n-elementigen Menge

Beispiele 1.5.6.

• Ist k = 0 und n beliebig, so ist

die leere Menge.

n

k

= 1, denn man fischt immer nur

n

o

• Ist k = 1, und n ≥ 1 beliebig, so ist nk = n, denn die Menge 1, . . . , n hat genau

n o n o

n o

die 1-elementigen Teilmengen 1 , 2 , . . . , n .

n(n−1)

• Es gilt n2 = 2 , denn, suchen wir eine 2-elementige Teilmenge, so haben wir

für das erste Element n-Wahlmöglichkeiten und für das zweite n − 1. Dann

haben wir aber jede Teilmenge doppelt gezählt, weil ja beide mögliche

Reihenfolgen auftreten.

Proposition 1.5.7. Für 0 ≤ k ≤ n gilt

!

n · (n − 1) · · · (n − k + 1)

n

n!

=

=

.

k

k!(n − k)!

k!

Beweis. Wir wählen k Elemente aus n aus. Wählen wir zunächst mit Reihenfolge. Für

das erste Element haben wir n Wahlmöglichkeiten, für das zweite n − 1 und so weiter,

so dass wir insgesamt n · (n − 1) · · · (n − k + 1) Möglichkeiten haben. Jetzt treten aber

alle möglichen Reihenfolgen der k Elemente auf, also müssen wir das Ergebnis noch

durch k! dividieren.

Lineare Algebra 1

15

Satz 1.5.8. Es gilt stets

!

!

!

n−1

n−1

n

=

+

,

k−1

k

k

wobei

n−1

k

= 0 setzen, falls k > n − 1.

n

o

Beweis. Sei A die Menge der k-elementigen Teilmengen der Menge 1, 2, 3, . . . , n .

Dann gilt |A| = nk , wobei |A| die Anzahl der Elemente der Menge A bezeichnet. Sei A1

die Menge aller Teilmengen, die das Element 1 enthalten und sei A2 die Menge aller

Teilmengen, die die 1 nicht enthalten. Dann ist A die disjunkte Vereinigung von A1

und A2 und daher folgt

|A| = |A1 | + |A2 |.

Es ist nun

!

Anzahl der k − 1-elementigen Teilmengen

n−1

n

o

|A1 | =

=

.

k−1

von 2, 3, . . . , n

Ebenso gilt

!

Anzahl der k-elementigen Teilmengen

n−1

n

o

|A2 | =

=

.

k

von 2, 3, . . . , n

Zusammen folgt die Behauptung.

Man verdeutlicht dieses Gesetz durch das sogenannte Pascalsche Dreieck:

1

1

1

1

1

1

2

3

4

1

3

6

1

4

1

Satz 1.5.9 (Binomischer Lehrsatz). Für jedes n ≥ 0 gilt

!

n

X

n k n−k

(x + y) =

xy .

k

n

k=0

n=0

1

2

3

5

Lineare Algebra 1

16

Insbesondere für y = 1 erhalten wir

!

n

X

n k

x.

(x + 1) =

k

n

k=0

Dieser Satz ist der Grund, warum die Zahlen

n

k

die Binomialkoeffizienten heißen.

Beweis. Induktion nach n. Für n = 0 ist nichts zu zeigen.

Induktionsschritt n → n + 1: Wir rechnen

(x + y)

n+1

!

n

X

n k n−k

= (x + y)(x + y) = (x + y)

xy

k

k=0

!

!

n

n

X

X

n k+1 n−k

n k n+1−k

=

x y +

xy

k

k

k=0

k=0

!

!

n+1

n

X

X

n

n k n+1−k

k n+1−k

=

xy

+

xy

k−1

k

k=1

k=0

!

n+1

X n+1

=

xk yn+1−k .

k

n

k=0

Damit folgt die Behauptung.

Folgerungen:

!

n

X

n

= 2n ,

k

k=0

!

n

X

n

(−1)k = 0.

k

k=0

Satz 1.5.10 (Geometrische Reihe). Für jedes n ∈ N gilt

n

X

k=0

xk =

1 − xn+1

1−x

Lineare Algebra 1

17

Beweis. Man kann diesen Satz durch Induktion nach n beweisen. Wir machen es aber

anders, wir rechnen

(1 − x)

n

X

k=0

x =

k

n

X

k=0

k

x −

n

X

k=0

k+1

x

=

n

X

k=0

Nach Division durch (1 − x) folgt die Behauptung.

k

x −

n+1

X

xk = 1 − xn+1 .

k=1

Lineare Algebra 1

2

18

Gruppen und Körper

2.1

Gruppen

Sei M eine Menge. Eine Verknüpfung auf M ist eine Abbildung:

M × M → M.

Beispiele 2.1.1.

• Addition und Multiplikation auf N sind Verknüpfungen:

(m, n) 7→ m + n;

N × N → N,

sowie

N × N → N,

(m, n) 7→ mn.

• Hintereinanderausführung von Permutationen:

Per(M) × Per(M) → Per(M),

(α, β) 7→ α ◦ β

ist eine Verknüpfung.

• Sei M = Q, R, so definiert das arithmetische Mittel

a∗b=

a+b

2

eine Verknüpfung auf M.

Definition 2.1.2. Eine Gruppe ist eine Menge G mit einer Verknüpfung G × G → G,

geschrieben als (a, b) 7→ ab, so dass für alle a, b, c ∈ G folgende Axiome erfüllt sind:

• Assoziativgesetz

a(bc) = (ab)c,

• neutrales Element: es gibt ein e ∈ G mit

ae = a,

• inverses Element: zu jedem a ∈ G gibt es ein a0 ∈ G mit

aa0 = e.

Lineare Algebra 1

19

Beispiele 2.1.3.

• Die Menge N ist mit der Addition keine Gruppe, denn sie

enthält kein neutrales Element.

• Die Menge der ganzen Zahlen:

n

o

Z = . . . , −2, −1, 0, 1, 2, . . .

ist eine Gruppe mit der Addition, denn die Null ist ein neutrales Element und

das Inverse zu k ∈ Z ist −k ∈ Z. Ebenso sind (Q, +) und (R, +) Gruppen.

n o

• Die Menge Q× = Q r 0 , so ist G mit der Multiplikation eine Gruppe, ebenso

n o

R× = R r 0

• Die Menge R ist mit dem arithmetischen Mittel keine Gruppe, denn diese

Verknuepfung ist nicht assoziativ. Es ist

!

a+b c a b c

a+b

∗c=

+ = + +

(a ∗ b) ∗ c =

2

4

2 4 4 2

im Allgemeinen verschieden von

!

a b c

b+c

= + + .

a ∗ (b ∗ c) = a ∗

2

2 4 4

• Ist M eine Menge, dann ist die Menge G = Per(M) aller Permutationen auf M mit

der Hintereinanderausführung als Verknüpfung eine Gruppe. Das neutrale

Element ist die identische Abbildung Id : M → M und die Inverse zu f ∈ Per(M)

ist ihre Umkehrabbildung f −1 .

Proposition 2.1.4. Sei G eine Gruppe.

(a) Das neutrale Element e ist eindeutig bestimmt.

(b) Das neutrale Element e erfüllt auch ea = a für jedes a ∈ G.

(c) Zu gegebenem a ∈ G ist das inverse Element a0 eindeutig bestimmt.

(d) Das Inverse a0 zu a erfüllt auch a0 a = e.

Beweis. Wir beginnen mit der letzten Aussage (d). Ist a0 ein Rechtsinverses zu a und ist

Lineare Algebra 1

20

a00 ein Rechtsinverses zu a0 , dann gilt

a0 a = (a0 a)e

neutrales Element

= (a0 a)(a0 a00 )

inverses Element

= (a0 (aa0 ))a00

Assoziativgesetz, mehrfach

= (a0 e)a00

inverses Element

= a0 a00

neutrales Element

=e

inverses Element

Damit ist (d) bewiesen.

Nun beweisen wir (b) unter Benutzung von (d). Es gilt

ea = (aa0 )a

inverses Element

= a(a0 a)

Assoziativgesetz

= ae

=a

nach (d)

neutrales Element

Dies benutzen wir nun, um (a) zu zeigen. Sei e2 ein weiteres neutrales Element. Dann

gilt

e2 = ee2

=e

nach (b)

da e2 neutral

Jetzt fehlt noch (c). Sei also a2 ein weiteres Inverses zu a. Dann gilt

a2 = ea2

nach (b)

= (a0 a)a2

nach (d)

= a0 (aa2 )

Assoziativgesetz

= a0 e

da a2 invers zu a

= a0

neutrales Element

Damit ist die Proposition vollständig bewiesen.

Da das inverse Element a0 zu a nun eindeutig bestimmt ist, schreiben wir a−1 für a0 .

Korollar 2.1.5. Sei G eine Gruppe, dann gilt für alle a, b, x, y ∈ G,

Lineare Algebra 1

21

(a) (a−1 )−1 = a,

(b) (ab)−1 = b−1 a−1 ,

(c) ax = ay ⇒ x = y.

Beweis. Es gilt a−1 a = e, also ist a ein Inverses zu a−1 und (a) folgt aus der Eindeutigkeit

des Inversen.

(b) Es gilt (b−1 a−1 )(ab) = b−1 (a−1 a)b = (b−1 e)b = b−1 b = e.

(c) Multipliziere beide Seiten der Gleichung mit a−1 .

Definition 2.1.6. Sei G eine Gruppe. Eine Teilmenge H ⊂ G heißt Untergruppe, falls H

mit der Verknüpfung von G selbst wieder eine Gruppe ist.

Lemma 2.1.7. Sei H eine Untergruppe der Gruppe G.

(a) Das neutrale Element e von G liegt in H und ist das neutrale Element von H.

(b) Ist h ∈ H, so liegt das Inverse h−1 zu h in H und ist das Inverse bzgl H

Eine nichtleere Teilmenge H ⊂ G ist genau dann eine Untergruppe, wenn

a, b ∈ H

⇒

ab−1 ∈ H

gilt.

Beweis. Sei eH das neutrale Element von H und e das von G. Dann gilt in G die

Identität e = eH e−1

= (eH eH )e−1

= eH (eH e−1

) = eH e = eH und (a) ist bewiesen.

H

H

H

(b) Sei h ∈ H und sei h0 das Inverse bezüglich H. Dann gilt hh0 = eh = e und damit ist

h0 = h−1 das Inverse in G.

Nun zur letzten Aussage. Ist H eine Untergruppe und sind a, b ∈ H, so folgt nach (b),

dass b−1 ∈ H und damit ab−1 ∈ H. Sei umgekehrt H eine nichtleere Teilmenge, die der

Bedingung des Lemmas genügt. Sei h ∈ H ein Element, dann ist e = hh−1 ∈ H, also

enthält H das neutrale Element. Wir zeigen nun, dass H zu jedem Element h auch sein

Inverses h−1 enthält. Hierzu schreibe h−1 = eh−1 ∈ H. Seien nun a, b ∈ H, dann liegt

b−1 ∈ H und es gilt ab = a(b−1 )−1 ∈ H, also ist H abgeschlossen unter der Multiplikation.

Zusammen folgt, dass H eine Untergruppe ist.

Lineare Algebra 1

22

Definition 2.1.8. Eine Gruppe G heißt kommutativ oder abelsche Gruppe, falls für

alle a, b ∈ G gilt

ab = ba.

Beispiele 2.1.9.

• Die Gruppen (Z, +), (Q, +), (R, +), (Q× , ×), (R× , ×) sind abelsch.

• Ist M eine Menge mit mehr als zwei Elementen, dann ist Per(M) nicht abelsch.

n

o

Dies zeigen wir exemplarisch an dem Beispiel der Menge M = 1, 2, 3 . Seien

Dann ist

1 2 3

,

α =

2 1 3

1 2 3

.

β =

1 3 2

1 2 3

,

αβ =

2 3 1

1 2 3

.

βα =

3 1 2

Beispiel 2.1.10. Sei m ∈ N eine natürliche Zahl. Auf der Menge

n

o

Z/m = 0, 1, . . . , m − 1

definieren wir eine Addition durch

a b = Rest von a + b bei Division nach m.

Dann ist Z/m eine Gruppe. Das neutrale Element ist die Null und das Inverse zu a ist

m − a, wenn a , 0.

n o

Für m = 1 ist Z/m = 0 die triviale Gruppe.

n o

Für m = 2 ist Z/m = 0, 1 und es gilt 1 1 = 0.

Für m = 3 geben wir die Addition durch folgende Tabelle an:

2.2

0

1

2

0

1

2

1

2

0

2

0

1

0

1

2

Körper

Definition 2.2.1. Ein Körper ist ein Tripel (K, +, ×) bestehend aus einer Menge K und

zwei Verknüpfungen + und ×, wobei wir a × b als ab schreiben, so dass die folgenden

Lineare Algebra 1

23

Axiome erfüllt sind:

• (K, +) ist eine abelsche Gruppe. Wir schreiben das neutrale Element dieser

Gruppe als 0 = 0K und nennen es das Nullelement.

• (K r {0}, ×) ist eine abelsche Gruppe. Wir schreiben das neutrale Element als

1 = 1K und nennen es das Einselement.

• Es gilt das Distributivgesetz: für alle a, b, c ∈ K gilt

a(b + c) = ab + ac.

Beispiele 2.2.2.

• (Z, +, ×) ist kein Körper, da nicht jedes Element x , 0 ein

multiplikatives Inverses besitzt, so gibt es zum Beispiel kein Inverses für x = 2.

• (Q, +, ×) ist ein Körper und R ebenso.

n o

• Auf der Menge F2 = 0, 1 definieren wir Addition und Multiplikation durch

+ 0

1

× 0

1

0

1

1

0

0

1

0

1

0

1

0

0

Dann ist F2 ein Koerper.

• Allgemeiner sei p eine Primzahl. Auf der Gruppe Fp = Z/p erklären wir

Addition wie gehabt und die Mutiplikation durch

a b = Rest von ab bei Division durch p.

Dann ist (Fp , , ) ein Körper. Für F3 sind die Verknüpfungstabellen:

+ 0

1

2

× 0

1

2

0

1

2

1

2

0

2

0

1

0

1

2

0

1

2

0

2

1

0

1

2

0

0

0

Schreibweise: Wir schreiben −a für das additive Inverse zu a und a − b für a + (−b).

Lineare Algebra 1

24

Satz 2.2.3. Sei K ein Körper. Dann gilt für alle a, b, c ∈ K:

(a) 0 , 1,

(b) 0 · a = 0

(c) ab = 0

a = 0 oder b = 0,

⇒

(d) a(−b) = −ab = (−a)b,

(e) ab = ac, a , 0

⇒

Nullteilerfreiheit

(−a)(−b) = ab,

b = c,

(f) a(b − c) = ab − ac.

n o

Beweis. (a) Das Element 1 ist das neutrale Element von K× = K r 0 , also ist 1 , 0.

(b) Für a ∈ K gilt 0a = (0 + 0)a = 0a + 0a. Nun addiere −0a auf beiden Seiten.

(c) Ist a, b ∈ K× , so auch ab.

(d) Es gilt ab + a(−b) = a(b − b) = a0 = 0. Also folgt wegen der Eindeutigkeit der

Inversen, dass a(−b) = −ab. Der Rest geht ähnlich.

(f) a(b − c) = a(b + (−c)) = ab + a(−c) = ab − ac.

(e) Es gelte ab = ac mit a , 0. Dann hat a ein multiplikatives Inverses a−1 . Multipliziere

beide Seiten der Gleichung mit a−1 und erhalte b = c.

Definition 2.2.4. Sei K ein Körper. Die Zahl

n

o

min

n

∈

N

:

n

·

1

=

0

,

K

K

char(K) =

0

falls endlich,

sonst,

heißt die Charakteristik des Körpers K.

Beispiele 2.2.5.

• Die Charakteristik von Fp ist p.

• Die Charakteristik von Q oder R ist 0.

Bemerkung. Ist die Charakteristik des Körpers K gleich Null, dann ist die Abbildung

N → K,

n 7→ n · 1K

injektiv. Also kann man in diesem Fall N als Teilmenge von K auffassen.

Lineare Algebra 1

2.3

25

Die Körper Q, R und C

Die Menge der rationalen Zahlen Q reicht nicht aus, um die Welt zu beschreiben. So

hat etwa seit Pythagoras ein quadratischer Tisch der Kantenlaenge 1 eine

√

Diagonallaenge von 2. Diese ist aber keine rationale Zahl.

Proposition 2.3.1. Es gibt keine rationale Zahl r mit r2 = 2.

Beweis. Angenommen doch, etwa r =

p

q

mit teilerfremden p und q. Dann folgt

p2

2 = r2 = q2 , also p2 = 2q2 . Damit ist p2 eine gerade Zahl und folglich ist auch p gerade,

etwa p = 2k mit k ∈ Z. Es folgt 2q2 = (2k)2 = 4k2 , also q2 = 2k2 . Damit ist auch q eine

gerade Zahl, was der angenommenen Teilerfremdheit widerspricht!

Da die rationalen Zahlen also zur Erfassung der Welt nicht ausreichen, führt man die

√

reellen Zahlen ein, in denen es unter anderem auch eine Zahl r = 2 gibt, deren

Quadrat die Zahl 2 ist. In der Schule versteht man unter der Menge der reellen Zahlen

die Menge aller Dezimalzahlen mit eventuell unendlich vielen Nachkommastellen,

also zum Beipiel

π = 3, 141592653589793...

oder

√

2 = 1, 414213562373095...

Es gibt auch Dezimalzahlen mit Ziffern, die sich endlos wiederholen. Dies deutet man

üblicherweise durch einen Balken über den Ziffern an, also ist etwa 0, 123 dasselbe

wie 0, 123123123 . . . . Es gibt allerdings Probleme mit der Dezimaldarstellung, da sie

nicht eindeutig ist, so ist etwa 0, 99999... = 0, 9 dasselbe wie 1. Dieses Problem kann

ausgeräumt werden, indem man nur solche Zahlen betrachtet, die nicht in einer 9-er

Periode enden.

Definition 2.3.2. Eine Dezimalzahl ist ein Ausdruck der Form

±aN . . . a1 , b1 b2 . . .

wobei N ∈ N ist und a j , b j ∈ {0, . . . , 9} gilt. Ferner soll aN , 0 oder N = 1 sein. Eine

Dezimalzahl heißt regulär, wenn sie nicht in einer 9-er Periode endet, d.h., wenn es zu

jedem k ∈ N ein j > k gibt, so dass b j , 9 gilt. Die Menge R der reellen Zahlen wird

definiert als die Menge aller regulären Dezimalzahlen.

Lineare Algebra 1

26

Jede ganze Zahl k ∈ Z lässt sich auf genau eine Weise als Dezimalzahl

k = ±aN . . . a1 , 0 = ±

N

X

a j 10 j

j=1

schreiben. Die Menge der Dezimalzahlen kann demzufolge mit der Menge

Z × {0, . . . , 9}N

identifiziert werden, wobei {0, . . . , 9}N die Menge aller Abbildungen von N nach

{0, . . . , 9} ist. Die Menge R ist dann die Menge der regulären Elemente von

Z × {0, . . . , 9}N .

Durch schriftliche Division sieht man, dass sich jede rationale Zahl als Dezimalzahl

schreiben lässt, etwa 14 = 0, 25 oder 13 = 0, 3. Diese Darstellung kann stets regulär

gewählt werden.

Satz 2.3.3. Eine reelle Zahl x liegt genau dann in Q, wenn sie am Ende periodisch ist,

wenn x also von der Form

x = ±aN . . . a1 , b1 . . . bk c1 . . . cl

ist.

Beweis. Sei x ∈ R. Es ist zu zeigen

x∈Q

⇔

x = ±aN . . . a1 , b1 . . . bk c1 . . . cl .

“⇒” Dies folgt aus dem Algorithmus der schriftlichen Division, den man in der

Schule lernt, denn man erhält bei Division durch eine natürliche Zahl d eine Periode,

sobald derselbe Rest bei den Nachkommastellen ein zweites Mal auftritt. Da die

möglichen Reste aber nur die endlich vielen Zahlen 0, 1, . . . , d − 1 sind, muss

irgendwann ein Rest zweimal auftreten. Man sieht das sehr schön, wenn man mal

zum Beispiel 1 : 7 = 0, 142857 ausrechnet.

“⇐” Sei x = ±aN . . . a1 , b1 . . . bk c1 . . . cl , wobei l ∈ N ist. Da x genau dann rational ist,

Lineare Algebra 1

27

wenn −x rational ist, kann x ≥ 0 angenommen werden, also

x = aN . . . a1 , b1 . . . bk c1 . . . cl .

Dann ist 10k x = aN . . . a1 b1 . . . bk , c1 . . . cl . Sei n die Dezimalzahl aN . . . a1 b1 . . . bk ∈ N0 und

sei y = 10k x − n, d.h. y = 0, c1 . . . cl . Dann ist aber

def

p = 10l y − y = c1 . . . cl ∈ N0

und es gilt daher y =

p

10l −1

∈ Q. Dann ist aber auch x =

y−n

10k

in Q.

Der Koerper C

Auf der Menge R2 führen wir folgende Verknüpfungen ein:

Addition:

(x, y) + (x0 , y0 ) = (x + x0 , y + y0 )

und Multiplikation:

(x, y)(x0 , y0 ) = (xx0 − yy0 , xy0 + x0 y).

Lemma 2.3.4. Mit diesen Verknüpfungen ist die Menge R2 ein Körper. Das Nullelement ist

(0, 0) und das Einselement ist (1, 0). Das additive Inverse zu (a, b) ist (−a, −b) und das

−b

a

,

multiplikative Inverse zu (a, b) , 0 ist a2 +b

2 a2 +b2 .

Beweis. Das muss man im Einzelnen nachrechnen, was langwierig ist, aber nicht

schwierig. Als Beispiel rechnen wir die Assoziativität der Multiplikation. Seien also

(x, y), (a, b), (u, v) ∈ R2 , dann gilt

((a, b)(u, v))(x, y) = (au − bv, av + bu)(x, y)

= (aux − bvx − avy − buy, auy − bvy + avx + bux).

Andererseits ist

(a, b)((u, v)(x, y)) = (a, b)(ux − vy, uy + vx)

= (aux − avy − buy − bvx, auy + avx + bux − bvy).

Wir nennen die Menge R2 mit diesen Verknüpfungen die Menge der komplexen

Lineare Algebra 1

28

Zahlen, geschrieben C und setzen

1C = (1, 0),

i = (0, 1).

Jede komplexe Zahl lässt sich eindeutig schreiben als z = a1C + bi mit a, b ∈ R. Die

Abbildung a 7→ a1C identifiziert R mit einer Teilmenge von C. Es gilt i2 = −1. Man

definiert den Realteil einer komplexen Zahl z = x + yi als

Re(z) = x

und den Imaginärteil als

Im(z) = y.

Es gilt dann also z = Re(z) + Im(z)i.

Für z = x + yi definieren wir die komplex konjugierte zu z als

z = x − yi.

Es folgt unmittelbar

1

Re(z) = (z + z),

2

Im(z) =

1

(z − z).

2i

Lemma 2.3.5. Für z, w ∈ C gilt

(a) z = z,

(b) z + w = z + w,

(c) (zw) = z w.

Beweis. Teil (a) und (b) sind trivial. Für (c) sei z = x + yi und w = u + vi, dann ist

zw = (x + yi)(u + vi) = xu − yv + (xv + yu)i

= xu − yv − (xv + yu)i = (x − yi)(u − vi) = z w.

Definition 2.3.6. [Betrag einer komplexen Zahl] Für z = x + yi gilt

zz = (x + yi)(x − yi) = x2 + y2

Lineare Algebra 1

29

und diese reelle Zahl ist ≥ 0. Wir definieren den Betrag einer komplexen Zahl z als

√

|z| =

zz.

Satz 2.3.7. Für z, w ∈ C gilt

(a) |z| ≥ 0 und |z| = 0 ⇔ z = 0,

Definitheit

(b) |zw| = |z||w|,

Multiplikativität

(c) |z + w| ≤ |z| + |w|.

Dreiecksungleichung

Beweis. Teil (a) ist klar. Für Teil (b) rechne

√

|zw| =

√

zwzw =

√

zzww =

√

zz ww = |z||w|.

Schliesslich beweisen wir (c)

|z + w|2 = (z + w)(z + w) = zz + ww + zw + wz .

| {z }

=2 Re(zw)

Für jede komplexe Zahl w = u + vi gilt | Re(w)| ≤ |w|, also folgt

|z + w|2 = |zz + ww + 2 Re(zw)|

≤ zz + ww + 2| Re(zw)| ≤ zz + ww + 2|z||w| = (|z| + |w|)2 .

Durch Wurzelziehen folgt die Behauptung.

Die folgenden Bilder verdeutlichen die Addition und Multiplikation in C.

Lineare Algebra 1

30

z+w

w

z

zw

w

z

Hierbei ist der Winkel von zw die Summe der Winkel von z und w und die Länge ist

das Produkt der Längen.

2.4

Polynome

Sei K ein Körper. Der Polynomring K[x] ist die Menge der formalen Ausdrücke der

Form

a0 + a1 x + a2 x2 + · · · + an xn

Lineare Algebra 1

31

mit n ∈ N und a0 , . . . , an ∈ K. Man hat eine Addition:

(a0 + a1 x + a2 x2 + · · · + an xn ) + (b0 + b1 x + b2 x2 + · · · + bn xn )

= (a0 + b0 ) + (a1 + b1 )x + (a2 + b2 )x2 + · · · + (an + bn )xn ,

wobei man bei verschiedenem Grad ein Polynom durch Nullen auffüllt. Ferner hat

man eine Multiplikation

(a0 + a1 x + a2 x2 + · · · + am xm )(b0 + b1 x + b2 x2 + · · · + bn xn )

X

ak bl xp + . . .

= a0 b0 + (a1 b0 + a0 b1 )x + · · · +

k+l=p

Präziser definieren wir den Polynomring als Menge aller Folgen (a0 , a1 , a2 , . . . ) in K mit

der Eigenschaft, dass es ein j0 ∈ N gibt mit a j = 0 für j ≥ j0 . Wir definieren die

Addition durch

(a0 , a1 , a2 , . . . ) + (b0 , b1 , b2 , . . . ) = (a0 + b0 , a1 + b1 , . . . )

und die Multiplikation durch

(a0 , a1 , a2 , . . . )(b0 , b1 , b2 , . . . ) = (c0 , c1 , c2 , . . . )

mit cp =

P

i+j=p

a j bi .

Beispiel 2.4.1. Sei K = F2 , dann gilt für jedes t ∈ K, dass

1 + t = 1 + t2 ,

aber die Polynome 1 + x und 1 + x2 sind verschiedene Elemente in F2 [x]. Man kann

also K[x] nicht mit der Menge der polynomialen Abbildungen K → K identifizieren!

Definition 2.4.2. Für ein Polynom f (x) = a0 + a1 x + · · · + an xn , das nicht gerade Null ist,

sei der Grad von f das größte k ∈ N0 mit ak , 0. Man erweitert diese Definition durch

grad(0) = −∞.

Lineare Algebra 1

32

Dann gilt für beliebige Polynome f (x), g(x), dass

grad( f g) = grad( f ) + grad(g),

grad( f + g) ≤ max grad( f ), grad(g) ,

wenn man formal −∞ + n = n + (−∞) = −∞ rechnet.

Satz 2.4.3 (Division mit Rest). Sind f, g ∈ K[x] und ist g , 0, so gibt es eindeutig

bestimmte Polynome q, r ∈ K[x] so dass

f = qg + r

und

grad(r) < grad(g).

Beweis. Existenz: Wir geben ein Verfahren zur Berechnung an. Schreibe

f (x) = an xn + · · · + a0

g(x) = bm xm + · · · + b0

mit an , 0 und bm , 0. Ist n < m, so setze r = f und q = 0, denn dann ist ja

f = qg + r

und

grad(r) < grad(g).

Ist hingegen n ≥ m, so setze q1 = bamn xn−m und f1 = f − q1 g. Dann folgt

grad( f1 ) < grad( f ). Ersetze nun f durch f1 und wiederhole diesen Vorgang bis der

Grad kleiner wird als grad(g).

Nun zur Eindeutigkeit: Seien q0 , r0 ∈ K[x] zwei weitere Polynome mit f = q0 g + r0 und

grad(r) < grad(g). Dann gilt

0 = f − f = (q − q0 )g + (r − r0 ).

Also gilt (q − q0 )g = (r0 − r) und damit

grad(q − q0 ) + grad(g) = grad(r0 − r)

≤ max(grad(r0 ), grad(r)) < grad(g).

Daraus folgt grad(q − q0 ) < 0, also grad(q − q0 ) = −∞ und damit q = q0 , woraus auch

Lineare Algebra 1

33

r = r0 folgt.

Beispiel 2.4.4. Sei K = Q und f (x) = 3x3 + 2x + 1, sowie g(x) = x2 + 4x. Dann ist

q(x) = 3x − 12 und r(x) = 50x + 1.

Sei f ∈ K[x], etwa

f (x) = a0 + a1 x + · · · + an xn .

Für λ ∈ K setze

f (λ) = a0 + a1 λ + a2 λ2 + · · · + an λn ∈ K.

So definiert f eine polynomiale Abbildung K → K.

Ein λ ∈ K mit f (λ) = 0 heißt Nullstelle des Polynoms f .

Proposition 2.4.5. Ist λ ∈ K eine Nullstelle von f ∈ K[x], f , 0, dann existiert ein

g(x) ∈ K[x] und ein p ∈ N mit

f (x) = (x − λ)p g(x)

und g(λ) , 0. Es folgt dann grad(g) = grad( f ) − p. Die Zahl p heißt die Vielfachheit der

Nullstelle λ von f .

Beweis. Nach Polynomdivision existiert g1 (x) und r(x) mit

f (x) = (x − λ)g1 (x) + r(x)

und grad(r) < grad(x − λ) = 1. Daher ist r(x) konstant. Aber wegen

0 = f (λ) = (λ − λ)g(λ) + r = r

ist r = 0 und wir erhalten f (x) = (x − λ)g1 (x). Ist nun g1 (λ) , 0, setzen wir p = 1 und

g = g1 . Andernfalls wiederholen wir den Schritt mit g1 und der Stelle von f , so lange,

bis wir auf ein Polynom g mit g(λ) , 0 stossen.

Korollar 2.4.6. Ist f ∈ K[x], f , 0 und ist k die Anzahl der Nullstellen von f . Dann gilt

k ≤ grad( f ).

Beweis. Sind λ1 , . . . , λk die verschiedenen Nullstellen von f , dann gilt

f (x) = (x − λ1 )g1 (x)

Lineare Algebra 1

34

für ein g1 ∈ K[x], g1 , 0. Dann ist

0 = f (λ2 ) = (λ2 − λ1 ) g1 (λ2 )

| {z }

,0

und also g1 (λ2 ) = 0. Daher gibt es ein g2 (x) , 0 mit g1 (x) = (x − λ2 )g2 (x) und daher

f (x) = (x − λ1 )(x − λ2 )g2 (x).

Wir wiederholen dies Argument bis zu

f (x) = (x − λ1 )(x − λ2 ) · · · (x − λk )gk (x),

mit gk , 0, was soviel heisst wie grad(gk ) ≥ 0. Daher ist grad( f ) = k + grad(gk ) ≥ k.

Definition 2.4.7. Sei f ∈ K[x], f , 0 und λ ∈ K. Dann heißt

n

o

µ( f, λ) = max n ∈ N : ∃ g∈K[x] f (x) = (x − λ)n g(x)

die Vielfachheit der Nullstelle λ. Es ist µ( f, λ) = 0 falls λ gar keine Nullstelle ist.

Sind λ1 , . . . , λk die verschiedenen Nullstellen von f und m j = µ( f, λ j ) die

Vielfachheiten, dann gilt

f (x) = (a − λ1 )m1 · · · (x − λk )mk g(x)

für ein Polynom g, das keine Nullstelle hat.

Beispiel 2.4.8. Das Polynom g(x) = 1 + x2 hat in K = R keine Nullstelle.

Satz 2.4.9. Sei Φ : K[x] → Abb(K, K) die Abbildung, die einem Polynom die

entsprechende Polynomiale Abbildung zuordnet, also

Φ(a0 + a1 x + · · · + an xn )(α) = a0 + a1 α + · · · + an αn ,

verkürzt geschrieben als

Φ( f )(α) = f (α),

Lineare Algebra 1

35

oder, in der anderen Schreibweise,

Φ(a0 , a1 , a2 , . . . )(α) = a0 + a1 α + a2 α2 + . . .

Ist dann K ein unendlicher Körper, dann ist Φ injektiv.

Beweis. Sei K unendlich und sei Φ( f ) = Φ(g). Wir müssen zeigen, dass f = g gilt.

Für α ∈ K gilt Φ( f − g)(α) = f (α) − g(α) = Φ( f )(α) − Φ(g)(α) = 0. Das heißt, das

Polynom h = f − g hat unendlich viele Nullstellen. Nach Korollar 2.4.6 muss es das

Nullpolynom sein, also f − g = 0 oder f = g.

Definition 2.4.10. Ein Koerper K heisst algebraisch abgeschlossen, falls jedes

nichtkonstante Polynom f (x) ∈ K[x] eine Nullstelle hat.

Beispiele 2.4.11.

• K = Q ist nicht algebraisch abgeschlossen, weil f (x) = x2 − 2

keine Nullstelle hat.

• K = R ist nicht algebraisch abgeschlossen, weil x2 + 1 keine Nullstelle hat.

• Der Fundamentalsatz der Algebra besagt, dass der Körper C algebraisch

abgeschlossen ist.

• Man beweist in der Algebra, dass es zu jedem Körper K einen

Erweiterungskörper K ⊃ K gibt, der algebraisch abgeschlossen ist. Jeder

algebraisch abgeschlossene Körper hat unendlich viele Elemente.

Lineare Algebra 1

3

36

Vektorräume

3.1

Räume und Unterräume

Sei K ein Körper. Ein Vektorraum über K ist eine abelsche Gruppe (V, +) zusammen

mit einer Abbildung

K × V → V,

(λ, v) 7→ λv,

so dass für alle v, w ∈ V und alle λ, µ ∈ K gilt:

(a) 1 · v = v,

(b) (λµ)v = λ(µv)

(c) (λ + µ)v = λv + µv,

λ(v + w) = λv + λw.

Beispiele 3.1.1.

• Sei Kn = K × · · · × K die Menge der n-tupel (x1 , . . . , xn ) von

Elementen von K. Aus Gründen, die später klar werden, schreiben wir die

Elemente von Kn als Spalten:

Kn =

Die Addition

: x1 , . . . , xn ∈ K

xn

x1

..

.

+

xn

x1

..

.

x1 + y1

..

=

.

yn

xn + yn

y1

..

.

macht Kn zu einer abelschen Gruppe. Die skalare Multiplikation ist erklärt durch

λ

λx1

..

= .

xn λxn

x1

..

.

für λ ∈ K.

• Sei S irgendeine Menge mit S , ∅. Sei V = Abb(S, K) die Menge aller

Lineare Algebra 1

37

Abbildungen f : S → K. Durch die Addition

( f + g)(s) = f (s) + g(s)

wird V eine abelsche Gruppe und die Vorschrift

(λ f )(s) = λ( f (s))

macht V zu einem Vektorraum.

Beweis. Die Nullfunktion f0 (s) = 0 ist ein neutrales Element für die Addition,

denn für jedes f ∈ V gilt

( f + f0 )(s) = f (s) + f0 (s) = f (s) + 0 = f (s).

Die anderen Gruppeneigenschaften rechnet man ebenso nach. Wir zeigen noch

die Vektorraumaxiome. Es gilt

(1 · f )(s) = 1 · f (s) = f (s),

für jedes s ∈ S, also 1 · f = f . Ferner ist für λ, µ ∈ K und f ∈ V,

((λµ) f )(s) = (λµ)( f (s)) = λ(µ( f (s)) = λ((µ f )(s)) = (λ(µ f ))(s).

Schliesslich ist

((λ + µ) f )(s) = (λ + µ)( f (s)) = λ( f (s)) + µ( f (s)) = (λ f )(s) + (µ f )(s) = (λ f + µ f )(s).

Und ebenso λ( f + g) = λ f + λg.

Sei V ein Vektorraum. Eine Teilmenge U ⊂ V heißt Unterraum oder

Untervektorraum, wenn U mit der Addition und der Skalarmultiplikation von V

selbst ein Vektorraum ist.

Proposition 3.1.2. Sei V ein K-Vektorraum. Eine nichtleere Teilmenge U ⊂ V ist genau dann

ein Unterraum, wenn gilt

(a) u, v ∈ U

⇒

(b) u ∈ U, λ ∈ K

u + v ∈ U,

⇒

λu ∈ U.

Lineare Algebra 1

38

Beweis. “⇒” Wenn U ein Unterraum ist, sind (a) und (b) offensichtlich erfüllt.

“⇐” Sei U nichtleer mit (a) und (b). Nach (a) definiert + eine Verknüpfung auf U. Wir

zeigen, dass (U, +) eine abelsche Gruppe ist. Assoziativgesetz (a + b) + c = a + (b + c)

und Kummutativgesetz a + b = b + a sind klar, denn die sind in V erfüllt. Da U nichtleer

ist, gibt es ein u0 ∈ U. Mit (b) folgt, dass (−1)u0 ∈ U und daher ist 0 = u0 + (−1)u0 ∈ U,

also hat U ein neutrales Element. Für u ∈ U ist (−1)u ∈ U ein Inverses und die

Behauptung ist gezeigt. Die verbleibenden Axiome gelten in U, da sie in V gelten. Beispiel 3.1.3. Sei S eine Menge und sei V = Abb(S, K). Fixiere ein s0 ∈ S und setze

n

o

U = f ∈ V : f (s0 ) = 0 .

Dann ist U ein Unterraum von V.

Beweis. U ist nichtleer, da die Nullabbildung in U liegt.

(a) Seien f, g ∈ U, so gilt

( f + g)(s0 ) = f (s0 ) + g(s0 ) = 0 + 0 = 0,

also gilt f + g ∈ U.

(b) Sei f ∈ U und λ ∈ K, so gilt

(λ f )(s0 ) = λ( f (s0 )) = λ · 0 = 0.

Also ist λ f ∈ U.

Definition 3.1.4. Ist I irgendeine Indexmenge und ist für jedes i ∈ I eine Menge Ai

gegeben, so definieren wir die Schnittmenge

\

Ai

i∈I

als die Menge aller x, die in jeder der Mengen Ai liegen. Das heisst:

x∈

\

Ai

⇔

x ∈ Ai fuer jedes i ∈ I.

i∈I

Proposition 3.1.5. Sind U, W Unterräume von V, so ist U ∩ W ein Unterraum.

Lineare Algebra 1

39

Allgemeiner gilt: Ist I eine Indexmenge und ist für jedes i ∈ I ein Unterraum Ui gegeben, so ist

U=

\

Ui

i∈I

ein Unterraum von V.

Beweis. Wir zeigen nur die zweite, allgemeinere Aussage. Zunächst ist U , ∅, da die

Null in jedem Ui und damit in U liegt. Seien u, v ∈ U. Dann gilt u, v ∈ Ui für jedes i ∈ I.

Also ist u + v ∈ Ui für jedes i ∈ I und daher ist u + v ∈ U. Ist λ ∈ K und u ∈ U, so sieht

man ebenso, dass λu ∈ U ist.

3.2

Summen und direkte Summen

Definition 3.2.1. Sei V ein K-Vektorraum und seien U, W ⊂ V Unterräume. Die

Summe von U und W ist definiert als

n

o

U + W = u + w : u ∈ U, w ∈ W .

Beispiel 3.2.2. Sei K = R und V = R3 , sowie

x

U=

:

x

∈

R

0

0

und

0

W=

:

y

∈

R

.

y

0

Dann sind U und W zwei verschiedene Geraden im dreidimensionalen Raum. Es ist

dann

x

U+W =

:

x,

y

∈

R

y

0

eine Ebene.

Definition 3.2.3. Sind U1 , . . . Um ⊂ V Unterräume von V, so definiert man

n

o

U1 + · · · + Um = u1 + · · · + um : u1 ∈ U1 , . . . , um ∈ Um .

Lineare Algebra 1

40

n

Beispiel 3.2.4. Sei V = K , sowie e1 =

1

0

..

.

0

0

0

.

1

.

.

, e2 = 0 , . . . , en = . Für jedes

0

.

..

1

0

n

o

j ∈ 1, . . . , n sei

n

o

λe j : λ ∈ K

| {z }

U j = Ke j =

=von e j aufgespannte Gerade

Dann gilt

U1 + · · · + Un = V.

Bemerkung. Für einen Unterraum U ⊂ V gilt

U + U = U.

Beweis. “⊂” Sei v ∈ U + U. Dann gibt es u1 , u2 ∈ U mit v = u1 + u2 . Da U ein Unterraum

ist, folgt v ∈ U.

“⊃” Sei u ∈ U. Dann ist u = u + 0 ∈ U + U.

Definition 3.2.5. Seien U1 , . . . , Um Unterräume von V. Die Summe U = U1 + . . . Um ist

eine direkte Summe, wenn jedes u ∈ U auf genau eine Weise als u = u1 + · · · + um

geschrieben werden kann. Ist dies der Fall, so schreiben wir

U = U1 ⊕ U2 ⊕ · · · ⊕ Um =

m

M

U j.

j=1

Beispiele 3.2.6.

• Sei V = K3 und

x

U=

:

x,

y

∈

K

,

y

0

sowie

0

W=

:

y,

z

∈

K

.

y

z

Dann ist die Summe U + W nicht direkt, denn die Null kann auf zwei Weisen

Lineare Algebra 1

41

geschrieben werden:

0 0

0 = 1 + −1 .

0

0

0 = 0 + 0,

|{z}

|{z}

∈U

∈W

• Sei V = K3 , U1 = Ke1 und U2 = Ke2 . Dann ist die Summe U = U1 + U2 direkt

Beweis. Sei u ∈ U mit u = u1 + u2 = u01 + u02 , wobei u j , u0j ∈ U j gilt. Wir müssen

zeigen, dass u1 = u01 und u2 = u02 gilt. Hierzu schreibe u1 = λ1 e1 , u2 = λ2 e2 , sowie

u01 = λ01 e1 und u02 = λ02 e2 . Es folgt

0

λ1

λ1

λ = λ e + λ e = u = λ0 e + λ0 e = λ0

2

2

1

2

1 1

2 2

2

1

0

0

.

Also folgt λ1 = λ01 sowie λ2 = λ02 , also u1 = u01 sowie u2 = u02 .

Proposition 3.2.7. Seien U, W, U1 , . . . , Um Unterräume eines Vektorraums V.

(a) Die Summe U + W ist genau dann direkt, wenn U ∩ W = 0.

(b) Die Summe U1 + · · · + Um ist genau dann direkt, wenn für alle u1 ∈ U1 , . . . , um ∈ Um gilt

u1 + · · · + um = 0

⇒

u1 = · · · = um = 0.

Beweis. (a) Sei die Summe direkt und sei v ∈ U ∩ W. Dann sind

0=

0 + 0 = v + (−v)

|{z} |{z} |{z} |{z}

∈U

∈W

∈U

∈W

zwei Schreibweisen der Null. Diese müssen nach Definition der direkten Summe

gleich sein, also v = 0.

Sei umgekehrt U ∩ W = 0 und sei u + w = u0 + w0 mit u, u0 ∈ U und w, w0 ∈ W. Dann ist

u − u0 = w0 − w ∈ U ∩ W also gleich Null und damit u = u0 und w = w0 .

(b) “⇒” folgt direkt aus der Definition. Wir zeigen “⇐”: Sei u1 + · · · + um = u01 + · · · + u0m

mit u j , u0j ∈ U j . Dann ist

u1 − u01 + · · · + um − u0m = 0,

Lineare Algebra 1

also u1 = u01 , . . . , um = u0m .

42

Lineare Algebra 1

4

43

Dimension

4.1

Linearkombinationen

Seien v1 , . . . , vm Elemente des Vektorraums V. Eine Linearkombination der Vektoren

v1 , . . . , vm ist jeder Vektor der Gestalt

λ1 v1 + · · · + λm vm

wobei λ1 , . . . , λm ∈ K. Die Menge aller Linearkombinationen ist der Spann von

v1 , . . . , vm , also

n

o

Spann(v1 , . . . , vm ) = λ1 v1 + · · · + λm vm : λ1 , . . . , λm ∈ K .

Beispiele 4.1.1.

• Seien K = R, V = R3 . Seien weiter v1 , v2 ∈ V, wobei keiner ein

Vielfaches des anderen ist. Dann ist Spann(v1 , v2 ) die eindeutig bestimmte

Ebene, die die Punkte 0, v1 , v2 enthält.

1

2

7

• Sei K = Q. der Vektor 2 liegt im Spann der Vektoren 1 und 0

1

3

9

, denn es

gilt

1

2

7

2 = 2 1 + 3 0

1

3

9

.

Proposition 4.1.2. Sei V ein Vektorraum und u1 , . . . , um ∈ V. Dann ist Spann(u1 , . . . , um )

ein Untervektorraum von V.

Beweis. Sei U = Spann(u1 , . . . , um ). Wir müssen zeigen:

u, v ∈ U ⇒ u + v ∈ U,

u ∈ U, λ ∈ K ⇒ λu ∈ U.

Seien also u = λ1 u1 + · · · + λm um und v = µ1 u1 + · · · + µm um und λ ∈ K. Dann ist

u + v = (λ1 + µ1 )u1 + · · · + (λm + µm )um ∈ U,

Lineare Algebra 1

44

sowie

λu = (λλ1 )u1 + · · · + (λλm )um ∈ U.

Definition 4.1.3. Gilt V = Spann(v1 , . . . , vm ), so sagen wir, dass die Vektoren v1 , . . . , vm

den Vektorraum V aufspannen. Ist dies der Fall, sagen wir, dass v1 , . . . , vm ein

Erzeugendensystem von V ist.

0

1

.

.

0

.

Beispiel 4.1.4. Sei V = Kn . Die Vektoren e1 = . , . . . , en = spannen der Raum V

0

..

1

0

auf, denn es gilt für v ∈ V,

v =

= x1 e1 + · · · + xn en .

xn

x1

..

.

Definition 4.1.5. Ein Vektorraum V heißt endlich-dimensional, falls es ein endliches

Erzeugendensystem gibt. Ansonsten heißt er unendlich-dimensional.

Beispiele 4.1.6.

• Der Raum Kn ist endlich-dimensional.

• Der Polynomring K[x] ist mit der Skalarmultiplikation

λ(a0 + · · · + an xn ) = (λa0 ) + · · · + (λan )xn

ein Vektorraum. Dieser ist nicht endlich-dimensional.

Beweis. Angenommen, K[x] wäre endlich-dimensional, also etwa erzeugt von

f1 , . . . , fm . Sei dann N das Maximum der grade grad( f j ) für j = 1, . . . , m. Dann ist

xN+1 nicht als Linearkombination der f j darstellbar. Widerspruch!

• Sei S eine nichtleere Menge. Ist S endlich, dann ist V = Abb(S, K)

endlich-dimensional.

n

o

Beweis. Sei S = s1 , . . . , sn Für 1 ≤ j ≤ n sei δ j : S → K definiert durch

1

δ j (t) =

0

t = s j,

t , s j.

Lineare Algebra 1

45

Wir behaupten, dass δ1 , . . . , δn ein Erzeugendensystem ist. Sei hierzu f ∈ V und

sei λ j = f (s j ) ∈ K für j = 1, . . . , n. Wir zeigen

f = λ1 δ1 + · · · + λn δn .

Sei s ∈ S. Dann gibt es genau ein 1 ≤ i ≤ n mit s = si . Es ist dann

f (s) = f (si ) = λi = λ1 δ1 (s) + · · · + λn δn (s).

Damit folgt die Behauptung.

4.2

Lineare Unabhängigkeit

Sei V = Spann(v1 , . . . , vm ). Dann kann jedes v ∈ V in der Form

v = λ1 v1 + · · · + λm vm

geschrieben werden. Diese Darstellung ist im Allgemeinen nicht eindeutig, denn es

könnte zum Beispiel v1 = 0 sein, was bedeutet, dass man für λ1 jeden Wert einsetzen

kann. Ist also

v = µ1 v1 + · · · + µm vm

eine zweite Darstellung, so folgt

0 = v − v = v = (λ1 − µ1 )v1 + · · · + (λm − µm )vm .

Es stellt sich heraus, dass die Darstellung genau dann eindeutig ist, wenn v1 , . . . , vm

linear unabhängig im Sinne der folgenden Definition sind.

Definition 4.2.1. Die Vektoren v1 , . . . , vm ∈ V heißen linear unabhängig, falls es keine

Linearkombination der Null gibt, außer der trivialen, also wenn gilt

λ1 v1 + · · · + λm vm = 0

⇒

λ1 = · · · = λm = 0.

Mit anderen Worten, die Vektoren sind linear unabhängig, wenn es nur eine

Linearkombination der Null gibt.

Beispiel 4.2.2. Die Vektoren e1 , . . . , en ∈ Kn sind linear unabhängig, denn ist

Lineare Algebra 1

46

λ1 e1 + · · · + λn en = 0, so heißt das

0

= λ1 e1 + · · · + λn en = ...

0

λn

λ1

..

.

,

also λ1 = · · · = λn = 0.

Lemma 4.2.3. Sind die Vektoren w1 , . . . , wm ∈ V linear unabhängig, so gilt für 1 ≤ j ≤ m,

bj . . . , wm ),

w j < Spann(w1 , . . . w

wobei

bj . . . , wm ) = (w1 , . . . , w j−1 , w j+1 , . . . , wm )

(w1 , . . . w

die Familie w1 , . . . , wm ohne den Eintrag w j bezeichnet.

Beweis. Angenommen, w j liegt in dem Spann, dann gibt es λ1 , . . . , b

λ j , . . . , λm ∈ K mit

w j = λ1 w1 + · · · + λ j−1 w j−1 + λ j+1 w j+1 + · · · + λm wm .

Hieraus folgt

λ1 w1 + · · · + λ j−1 w j−1 + (−1)w j + λ j+1 w j+1 + · · · + λm wm = 0,

also λ1 = · · · = λn = 0 und (−1) = 0, Widerspruch!

Definition 4.2.4. Die Vektoren v1 , . . . , vm heißen linear abhängig, wenn sie nicht linear

unabhängig sind, also wenn es eine nichttriviale Linearkombination der Null gibt.

2 1 7

Beispiel 4.2.5. Sei K = Q. Die Vektoren 3 , −1 , 3 ∈ Q3 sind linear abhängig,

1

2

8

denn

2

1

7

2 3 + 3 −1 + (−1) 3 = 0.

1

2

8

Lemma 4.2.6. Sind v1 , . . . , vm linear abhängig und ist v1 , 0, dann existiert ein

n

o

j ∈ 2, 3, . . . , m so dass

(a) v j ∈ Spann(v1 , . . . , v j−1 ),

Lineare Algebra 1

47

(b) Spann(v1 , . . . b

v j . . . , vm ) = Spann(v1 , . . . , vm ).

Beweis. Da die v1 , . . . , vm linear abhängig sind, existieren Koeffizienten λ1 , . . . , λn ∈ K,

nicht alle Null, so dass

λ1 v1 + · · · + λm vm = 0.

Sei j der größte Index mit λ j , 0.

Dann ist also λ j+1 = · · · = λm = 0, es folgt λ1 v1 + · · · + λ j v j = 0 und wegen v1 , 0 ist

j > 0. Da λ j , 0, erhalten wir

!

!

−λ j−1

λ1

vj = −

v1 + · · · +

v j−1 ,

λj

λj

also folgt (a). Für (b) sei v ∈ Spann(v1 , . . . , vm ), etwa

v = µ1 v1 + · · · + µm vm .

In

Linearkombination

können wir v j durch den Ausdruck

dieser

λ j−1

λ1

v j . . . , vm )

− λ j v1 + · · · + λ j v j−1 ersetzen und wir sehen, dass v ∈ Spann(v1 , . . . b

gilt.

Lemma 4.2.7. (a) Ist w ∈ Spann(v1 , . . . , vm ), dann ist die Familie w, v1 , . . . , vm linear

abhängig.

(b) Ist w < Spann(v1 , . . . , vm ) und ist v1 , . . . , vm linear unabhängig, dann ist w, v1 , . . . , vm

linear unabhängig.

Beweis. (a) Ist w = λ1 v1 + · · · + λm vm , dann ist 0 = (−1)w + λ1 v1 + · · · + λm vm eine

nichttriviale Linearkombination der Null.

(b) Sei λw + λ1 v1 + · · · + λm vm = 0. Dann muss λ = 0 sein, denn sonst wäre

λm

λ1

w= −

v1 + · · · + −

vm ,

λ

λ

was der Voraussetzung widerspricht. Also ist λ = 0, und dann folgt λ1 = . . . , λm = 0,

da die v1 , . . . , vm linear unabhängig sind.

Lineare Algebra 1

48

Satz 4.2.8. Sei V ein endlich-dimensionaler Vektorraum. Die Länge einer linear

unabhängigen Familie ist ≤ der Länge jedes Erzeugendensystems.

Mit anderen Worten: Gilt V = Spann(v1 , . . . , vn ) und sind w1 , . . . , wk linear unabhängig,

dann ist k ≤ n.

Beweis. 1. Schritt. Da die v1 , . . . , vn den Raum aufspannen, ist w1 , v1 , . . . , vn linear

abhängig. Nach Lemma 4.2.6 können wir eines der v j entfernen und haben immer

noch ein Erzeugendensystem.

Wir wiederholen diesen Schritt.

(j+1)-ter Schritt. Nach Schritt j wissen wir, dass die Familie w1 , . . . , w j , vi1 , . . . , vin− j ) ein

Erzeugendensystem ist. deshalb ist die Liste w1 , . . . , w j+1 , vi1 , . . . , vin− j ) linear abhängig.

Nach Lemma 4.2.6 gibt es einen Vektor, der in dem Span der vorhergehenden liegt.

Dies kann keiner der w1 , . . . , w j+1 sein, denn die sind linear unabhängig. Wir können

also eines der vi entfernen und behalten immer noch ein Erzeugendensystem.

Dieser Prozess stoppt erst nach dem k-ten Schritt und liefert ein Erzeugendensystem

der Länge n von der Form

(w1 , . . . , wk , ∗),

wobei der Stern für einige der v j steht. Damit folgt k ≤ n.

Proposition 4.2.9. Jeder Unterraum eines endlich-dimensionalen Raums ist

endlich-dimensional.

Beweis. Sei U ein Unterraum eines endlich-dimensionalen Raums V, etwa

V = Spann(v1 , . . . , vn ). Jede linear unabhängige Liste u1 , . . . , uk hat eine Länge k ≤ n. Sei

k die maximale Länge einer solchen Liste. Dann behaupten wir, dass u1 , . . . , uk bereits

ein Erzeugendensystem von U ist. Wäre dem nicht so, dann gäbe es einen Vektor

u0 ∈ U mit u0 < Spann(u1 , . . . , uk ). Dann ist nach Lemma 4.2.7 aber u0 , u1 , . . . , uk linear

unabhängig, was der Maximalität von k widerspricht.

4.3

Basen

Definition 4.3.1. Eine Basis eines Vektorraums V ist ein linear unabhängiges

Erzeugendensystem.

Lineare Algebra 1

49

Mit anderen Worten: v1 , . . . , vn ist Basis von V, falls

(a) V = Spann(v1 , . . . , vn ) und

(b) v1 , . . . , vn sind linear unabhängig.

Beispiele 4.3.2.

• e1 , . . . , en ist eine Basis von Kn .

1 1

eine Basis von K2 .

• Ist char(k) , 2, dann ist ,

1

−1

Proposition 4.3.3. Die Familie v1 , . . . , vn ist genau dann eine Basis von V, wenn sich jeder

Vektor v ∈ V auf genau eine Weise als v = λ1 v1 + · · · + λn vn schreiben lässt.

Beweis. “⇒” Sei v1 , . . . , vn eine Basis und sei v ∈ V. Da v1 , . . . , vn ein

Erzeugendensystem ist, gibt es Koeffizienten λ1 , . . . , λn ∈ K so dass

v = λ1 v1 + · · · + λn vn . Es bleibt zu zeigen, dass die λ j eindeutig bestimmt sind. Ist

v = µ1 v1 + · · · + µn vn eine weitere Darstellung, dann folgt

0 = v − v = (λ1 − µ1 )v1 + · · · + (λn − µn )vn .

Wegen der linearen Unabhängigkeit folgt λ1 = µ1 , . . . , λn = µn .

“⇐” Lässt sich jeder Vektor so schreiben, ist die Familie ein Erzeugendensystem. Ist

die Darstellung der Null eindeutig, folgt die lineare Unabhängigkeit.

Satz 4.3.4. Jedes endliche Erzeugendensystem eines Vektorraums enthält eine Basis.

Beweis. Sei v1 , . . . , vn ein Erzeugendensystem. Ist es nicht linear unabhängig, dann

kann man nach Lemma 4.2.6 einen Vektor rauswerfen und hat immer noch ein

Erzeugendensystem. Diesen Schritt wiederholt man, bis es linear unabhängig ist.

Beispiel 4.3.5. Nach diesem Verfahren reduziert sich das Erzeugendensystem

1 3 4

, ,

2

6

7

5

, zu 1 , 4

9

2

7

.

Korollar 4.3.6. Jeder endlich-dimensionale Vektorraum hat eine Basis.

Lineare Algebra 1

50

Satz 4.3.7. Sei V endlich-dimensional und seien v1 , . . . , vk linear unabhängig. Dann gibt

es vk+1 , . . . , vn so dass v1 , . . . , vn eine Basis ist.

Beweis. Ist v1 , . . . , vk nicht schon eine Basis, dann gibt es ein vk+1 ∈ V mit

vk+1 < Spann(v1 , . . . , vk ). Nach Lemma 4.2.6 ist dann v1 , . . . , vk+1 wieder linear

unabhängig. Diesen Schritt wiederholen wir so lange, bis wir eine Basis haben. Das

Verfahren muss nach endlich vielen Schritten abbrechen, denn nach Satz 4.2.8 kann

die Länge einer linear unabhängigen Familie nicht die eines Erzeugendensytems

überschreiten und wir wissen ja, dass es eines endlicher Länge gibt.

Proposition 4.3.8. Sei U ⊂ V ein Unterraum des endlich-dimensionalen Vektorraums V.

Dann existiert ein Unterraum W ⊂ V so dass

V = U ⊕ W.

Der Raum W wird ein Komplementärraum zu U genannt.

Beweis. Nach Proposition 4.2.9 ist U endlich-dimensional. Nach Korollar 4.3.6 hat U

eine Basis v1 , . . . , vk . Nach Satz 4.3.7 lässt sich diese zu einer Basis v1 , . . . , vn von V

verlängern. Setze W = Spann(vk+1 , . . . , vn ). Dann ist V = U + W, da sich jedes v ∈ V als

Linearkombination der 1 , . . . , vn schreiben lässt. Ferner ist U ∩ W = 0, denn ist

v ∈ U ∩ W, dann ist einerseits v = λ1 v1 + · · · + λk vk für geeignete Koeffizienten

λ1 , . . . , λk ∈ K und andererseits v = λk+1 vk+1 + · · · + λn vn für Koeffizienten

λk+1 , . . . , λn ∈ K. Es folgt

0 = v − v = λ1 v1 + · · · + λk vk + (−λk+1 )vk+1 + · · · + (−λn )vn ,

woraus wegen der linearen Unabhängigkeit λ1 = · · · = λn = 0 und damit v = 0

folgt.

Beispiel 4.3.9. Sei K = Q und V = Q2 , sowie U = Qe1 . Dann ist Qe2 ein

Komplementärraum. Allerdings ist auch Q(λe1 + e2 ) ein Komplementärraum für jedes

λ ∈ Q. Damit gibt es unendlich viele verschieden Komplementärräume.

Lineare Algebra 1

51

Satz 4.3.10. Je zwei Basen eines Vektorraums haben dieselbe Länge.

Sind also v1 , . . . , vn und w1 , . . . , wm Basen des Vektorraums V, dann folgt m = n. Diese

gemeinsame Länge wird die Dimension des Raums V genannt.

Beweis. Da v1 , . . . , vn linear unabhängig und w1 , . . . , wm ein Erzeugendensystem ist,

folgt nach Satz 4.2.8, dass n ≤ m ist. Aus Symmetrie folgt auch n ≥ m.

Beispiel 4.3.11. Es ist dim(Kn ) = n, da e1 , . . . , en eine Basis ist.

Proposition 4.3.12. (a) Ist U ⊂ V ein Unterraum des endlich-dimensionalen Vektorraums

V, so gilt dim U ≤ dim V.

(b) Ist dim V = n, so ist jedes Erzeugendensystem der Länge n eine Basis. Ebenso ist jede

linear unabhängige Familie der Länge n eine Basis.

(c) Für jeden Vektorraum V gilt

V=0

⇔

dim V = 0.

Beweis. (a) Jede Basis von U kann zu einer Basis von V verlängert werden.

(b) Sei v1 , . . . , vn ein Erzeugendensystem der Länge n. Nach Satz 4.3.4 enthält es eine

Basis. Diese muss aber die Länge n haben, also ist v1 , . . . , vn selbst eine Basis.

Sei v1 , . . . , vn eine linear unabhängige Familie. dann kann sie nach Satz 4.3.7 zu einer

Basis verlängert werden. Diese muss die Länge n haben, also ist sie gleich v1 , . . . , vn .