3.3 Parametertests: Prüfverfahren für die unbekannten Parameter

Werbung

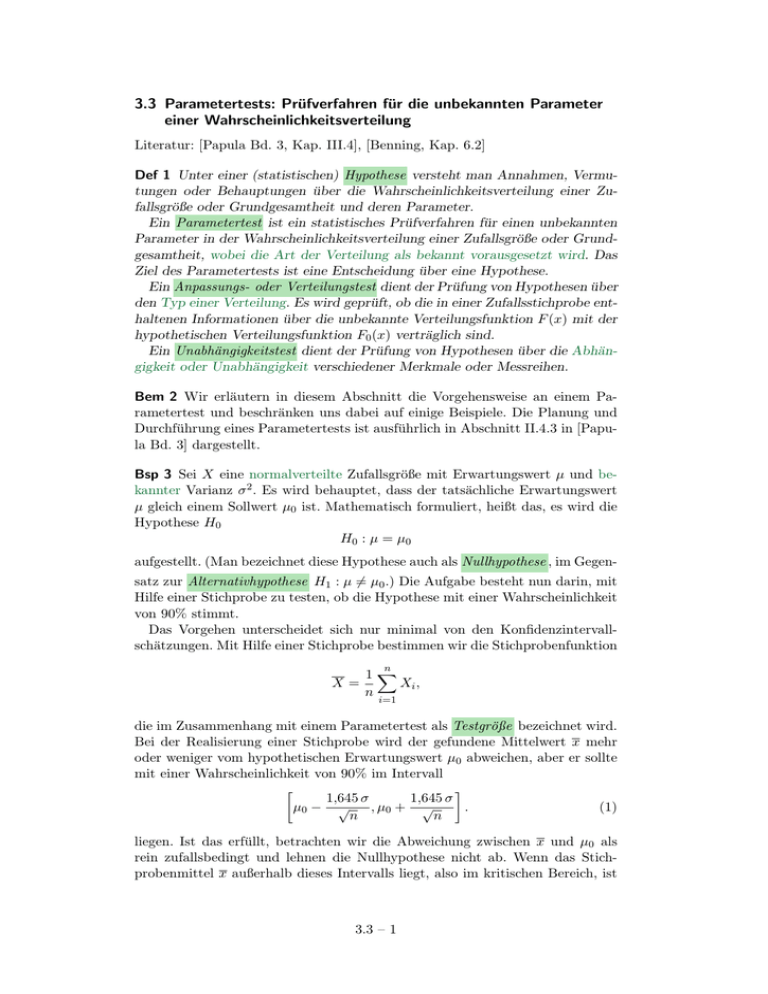

3.3 Parametertests: Prüfverfahren für die unbekannten Parameter einer Wahrscheinlichkeitsverteilung Literatur: [Papula Bd. 3, Kap. III.4], [Benning, Kap. 6.2] Def 1 Unter einer (statistischen) Hypothese versteht man Annahmen, Vermutungen oder Behauptungen über die Wahrscheinlichkeitsverteilung einer Zufallsgröße oder Grundgesamtheit und deren Parameter. Ein Parametertest ist ein statistisches Prüfverfahren für einen unbekannten Parameter in der Wahrscheinlichkeitsverteilung einer Zufallsgröße oder Grundgesamtheit, wobei die Art der Verteilung als bekannt vorausgesetzt wird. Das Ziel des Parametertests ist eine Entscheidung über eine Hypothese. Ein Anpassungs- oder Verteilungstest dient der Prüfung von Hypothesen über den Typ einer Verteilung. Es wird geprüft, ob die in einer Zufallsstichprobe enthaltenen Informationen über die unbekannte Verteilungsfunktion F (x) mit der hypothetischen Verteilungsfunktion F0 (x) verträglich sind. Ein Unabhängigkeitstest dient der Prüfung von Hypothesen über die Abhängigkeit oder Unabhängigkeit verschiedener Merkmale oder Messreihen. Bem 2 Wir erläutern in diesem Abschnitt die Vorgehensweise an einem Parametertest und beschränken uns dabei auf einige Beispiele. Die Planung und Durchführung eines Parametertests ist ausführlich in Abschnitt II.4.3 in [Papula Bd. 3] dargestellt. Bsp 3 Sei X eine normalverteilte Zufallsgröße mit Erwartungswert µ und bekannter Varianz σ 2 . Es wird behauptet, dass der tatsächliche Erwartungswert µ gleich einem Sollwert µ0 ist. Mathematisch formuliert, heißt das, es wird die Hypothese H0 H0 : µ = µ0 aufgestellt. (Man bezeichnet diese Hypothese auch als Nullhypothese , im Gegensatz zur Alternativhypothese H1 : µ 6= µ0 .) Die Aufgabe besteht nun darin, mit Hilfe einer Stichprobe zu testen, ob die Hypothese mit einer Wahrscheinlichkeit von 90% stimmt. Das Vorgehen unterscheidet sich nur minimal von den Konfidenzintervallschätzungen. Mit Hilfe einer Stichprobe bestimmen wir die Stichprobenfunktion n X= 1X Xi , n i=1 die im Zusammenhang mit einem Parametertest als Testgröße bezeichnet wird. Bei der Realisierung einer Stichprobe wird der gefundene Mittelwert x mehr oder weniger vom hypothetischen Erwartungswert µ0 abweichen, aber er sollte mit einer Wahrscheinlichkeit von 90% im Intervall 1,645 σ 1,645 σ , µ0 + √ . (1) µ0 − √ n n liegen. Ist das erfüllt, betrachten wir die Abweichung zwischen x und µ0 als rein zufallsbedingt und lehnen die Nullhypothese nicht ab. Wenn das Stichprobenmittel x außerhalb dieses Intervalls liegt, also im kritischen Bereich, ist 3.3 – 1 die Abweichung zwischen x und µ0 nur mit einer Wahrscheinlichkeit von 10% zufallsbedingt, und wir lehnen die Hypothese H0 ab. Das Intervall (1) ergibt sich analog zu Abschnitt 3.2 daraus, dass die Zufallsgröße X −µ √ U= σ/ n standardnormalverteilt ist. Wegen P (|U | ≤ 1,645) = 0,9, (Quantil der Standardnormalverteilung) gilt 1,645 σ 1,645 σ P µ0 − √ = 0,9 ≤ X ≤ µ0 + √ n n (im Vergleich zu Abschnitt 3.2 sind die Rollen von X und µ0 vertauscht), d.h., mit 90%-iger Wahrscheinlichkeit liegt die Testgröße X im Intervall (1). Bem 4 Wie im vorherigen Abschnitt halten wir fest: • Für eine höhere Wahrscheinlichkeit muss man lediglich andere Quantile benutzen. Bei gleichem Stichprobenumfang n wird dadurch das Intervall größer. • Das Intervall wird kleiner, wenn man den Stichprobenumfang erhöht. Bsp 5 Im vorherigen Beispiel sind wir davon ausgegangen, dass wir die Varianz kennen. Kennen wir sie nicht, schätzen wir sie durch die empirische Varianz S 2 und verwenden die Testvariable T = X − µ0 √ , S/ n die der t-Verteilung mit n − 1 Freiheitsgraden genügt, siehe auch Abschnitt II.4.5.2 in [Papula Bd. 3]. Bsp 6 Ein Differenzentest wird durchgeführt, wenn die Erwartungswerte zweier Messreihen entweder auf Gleichheit oder eine bestimmte vorgegebene Differenz überprüft werden sollen (z.B. Test, ob sich ein Messpunkt an einem gefährdeten Bauwerk verschoben hat, oder Vergleich der Lebensdauern ähnlicher Produkte). Die Vorgehensweise ähnelt der dargestellten, weil man die Differenz der Erwartungswerte als neue Zufallsgröße auffasst und auf den Sollwert testet. Die Besonderheiten kommen jedoch dadurch zustande, dass • zwei Stichproben genommen werden müssen, die voneinander abhängig oder unabhängig sein können, • die Standardabweichung der beiden Zufallsgrößen bekannt oder unbekannt und gleich oder ungleich sein können. Für Details sei auf die Literatur verwiesen, z.B. [Papula Bd. 3, Kap. III.4.5.3] oder [Benning, Kap. 6.2.2]. 3.3 – 2 Bsp 7 Beim Test einer unbekannten Varianz, H0 : σ 2 = σ02 , führt man wie in Abschnitt 3.2 die Zufallsvariable χ2 = (n − 1) S2 σ2 ein, die χ2 -verteilt mit n − 1 Freiheitsgraden ist, siehe auch Abschnitt II.4.5.4 in [Papula Bd. 3]. Bsp 8 Formuliert man die Hypothese als Ungleichung, z.B. µ < µ0 , gibt es nur eine kritische Grenze, und man spricht von einem einseitigen Parametertest . Der praktische Unterschied besteht in der Verwendung einseitiger Quantile. Anwendung finden einseitige Paramertests beim Prüfen von Mindestgrößen (z.B. einer Mindestfestigkeit, µ ≥ µ0 ) oder Höchstgrößen (z.B. bei einer Mindestgenauigkeit, σ ≤ σ0 ). Bem 9 Wie auch immer die Entscheidung bei einem Parametertest ausfällt, sie kann richtig oder auch falsch sein. Wird eine richtige Hypothese abgelehnt, spricht man von einem Fehler 1. Art . Wird eine falsche Hypothese beibehalten (nicht abgelehnt), begeht man einen Fehler 2. Art . Eine Diskussion der Wahrscheinlichkeit, einen Fehler 1. oder 2. Art zu begehen, findet man in Abschnitt II.4.4 von [Papula Bd. 3]. 3.3 – 3