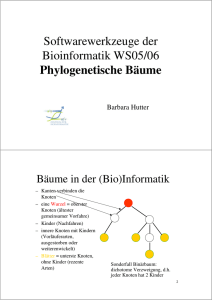

Datenstrukturen

Werbung