Statistik6BivariatIntervall

Werbung

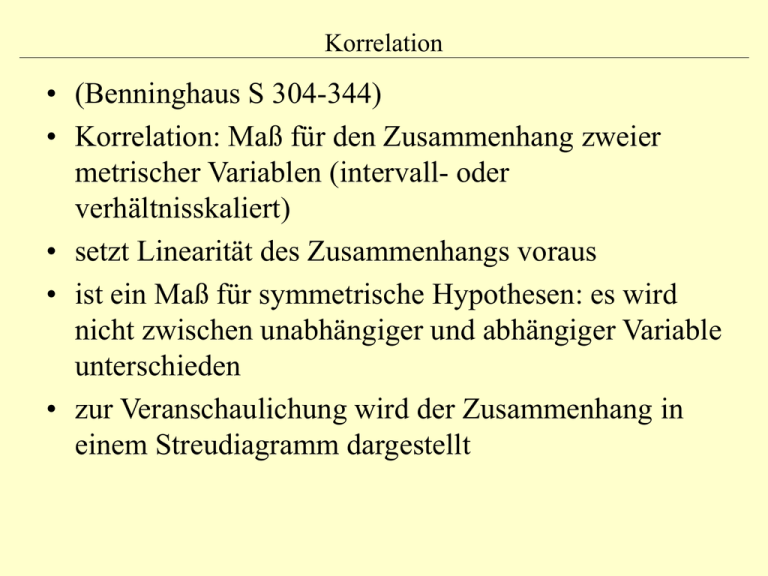

Korrelation • (Benninghaus S 304-344) • Korrelation: Maß für den Zusammenhang zweier metrischer Variablen (intervall- oder verhältnisskaliert) • setzt Linearität des Zusammenhangs voraus • ist ein Maß für symmetrische Hypothesen: es wird nicht zwischen unabhängiger und abhängiger Variable unterschieden • zur Veranschaulichung wird der Zusammenhang in einem Streudiagramm dargestellt Lineare (a,b) und nicht lineare Zusammenhänge fast perfekte positive Korrelation fast perfekte negative Korrelation keine Korrelation positive Korrelation mittlerer Höhe Beispiel nach Gehring und Weins • Es soll die Annahme überprüft werden, dass in Orten mit hohem Katholikenanteil der Anteil der CDU-Wähler besonders groß ist. Die Annahme muss bestätigt werden, wenn in Orten mit überdurchschnittlichem Katholikenanteil auch der CDU-Wähler-Anteil überdurchschnittlich ist und wenn in Orten mit unterdurchschnittlichem K-Anteil auch der Anteil der CDU-Wähler unterdurchschnittlich ist. Was über/unterdurchschnittlich ist, erkennen wir am Vergleich mit dem Mittelwert. Beispiel • Wenn der Zusammenhang hoch ist, variieren beide Variablen gemeinsam, haben also eine hohe Kovarianz: n cov( x, y ) ( x x ) ( y y) i 1 i i n Beispiel • Da die Kovarianz sich mit der Maßeinheit ändert, sind Kovarianzen nicht vergleichbar, daher standardisiert man sie, indem man durch die Standardabweichungen beider Variablen teilt (Korrelation ist Kovarianz durch Standardabweichungen) Formeln für Korrelation n r (x i 1 i x ) ( yi y ) n sx s y Korrelation = Kovarianz durch Standardabweichungen, reicht von -1 bis 1 Formel nach Benninghaus r N xi yi xi yi [ N xi ( xi ) ][ N yi ( yi ) ] 2 2 2 2 Formel zum einfacheren Rechnen im Glossar von Andreß SAP Summe der Abweichungsprodukte SAQ Summe der Abweichungsquadrate Praktisches Vorgehen: Arbeitstabelle Regression • Regression: auch hier geht es um den Zusammenhang zweier metrischer Variablen (intervall- oder verhältnisskaliert) • setzt Linearität des Zusammenhangs voraus • ist geeignet für asymmetrische Hypothesen: es wird zwischen unabhängiger (x) und abhängiger Variable (y) unterschieden • man spricht von der Regression von y auf x (d.h. auf Grund von x), man will die Varianz von y durch x erklären Wichtige Begriffe • Regressionsgerade: y = a + b x Wird so in die Punktwolke eingefügt, dass die Summe der quadrierten Abweichungen jedes Meßwerts von der Regressionsgerade ein Minimum erreicht • aus dieser Vorgabe ergeben sich die Werte der Regressionskoeffizienten a und b (Achsenabschnitt und Steigung) • es läßt sich ein PRE-Maß formulieren (Determinationskoeffizient R²) Formeln für die Regressionskoeffizienten (auch als b1 und b0 bezeichnet) ( x x )( y y ) b (x x) i i 2 i a y bx am obigen Beispiel Interpretation der Regressionsgeraden • b: Wenn x um eine Einheit steigt, steigt y um b Einheiten (hier 0.19). • a: Wenn x Null wäre, läge y bei a. • a ist nur sinnvoll zu interpretieren, wenn x den Wert Null annehmen kann und wenn y bei x=0 sinnvoll hochzurechnen ist. Beim Zusammenhang zwischen Alter und Einkommen macht es keinen Sinn, das Einkommen beim Alter von 0 Jahren hochzurechnen. Lineare Einfachregression: Annahmen und OLS-Schätzung (1) Fragen zur Vorlesung Frage: Warum betrachtet man die quadrierten Abweichungen von der Regressionsgeraden und nicht die einfachen Abweichungen? Antwort: Weil die Summe der einfachen Abweichungen für jede Regressionsgerade, die durch den Schwerpunkt (x-quer, y-quer) der Punktwolke verläuft, gleich Null ist. Frage: Gibt es einen Punkt, durch den jede Regressionsgerade laufen muß? Antwort: Ja, der Schwerpunkt der Punktwolke. Der Schwerpunkt entspricht dem Punkt mit den Koordinaten x=x-quer und y=y-quer. Lineare Einfachregression: Annahmen und OLS-Schätzung (2) Frage: Gibt es statt Probieren eine mathematische Methode, wie man die Gerade (genauer: die Parameter der Geradengleichung) bestimmen kann, die die Summe der quadrierten Abweichungen minimiert? Antwort: Die Minimierung einer Funktion, hier die Summe der Abweichungsquadrate als Funktion der Parameter b0 und b1, SAQ = f(b0, b1), ist ein Problem der Differentialrechnung. Bildet man die ersten Ableitungen der Funktion SAQ = f(b0, b1) und setzt diese Null, ergeben sich die Formeln für b0 und b1 in der Formelsammlung. Erläuterung der proportionalen Fehlerreduktion (PRE) • Ohne Kenntnis der UV sagen wir für jede Untersuchungseinheit bei der Variable y den Mittelwert y quer vorher. • Der Fehler, den wir dabei machen, ist die Summe aller quadrierten Abweichungen der Meßwerte aller Untersuchungseinheiten vom Mittelwert y quer (Gesamtvariation) 2 ( yi y ) Erläuterung der proportionalen Fehlerreduktion (PRE) • Mit Kenntnis der UV sagen wir für jede Untersuchungseinheit bei der Variable y den Wert vorher, der sich aus der Regressionsgeraden ergibt: y´i = a + b xi • Der Fehler, den wir dabei machen, ist die Summe aller quadrierten Abweichungen der Meßwerte aller Untersuchungseinheiten von den geschätzten Werten y´i (nicht erklärte Variation) ( y y i i) 2 Erläuterung der proportionalen Fehlerreduktion (PRE) • Erklärte Variation dagegen sind die quadrierten Abweichungen der geschätzten Werte y ´i vom Mittelwert y quer ( y y ) i 2 Erläuterung der proportionalen Fehlerreduktion (PRE) • Varianzzerlegung: Die Gesamtvariation ist die Summe der erklärten und nicht erklärten Variation. Die Gesamtvarianz ist die Summe der erklärten und der nicht erklärten Varianz: Erläuterung der proportionalen Fehlerreduktion (PRE) • Fehlerreduktion (E1-E2) / E1 • (Gesamtvariarion – nicht erklärte Variation) geteilt durch Gesamtvariation • identisch mit: erklärte Variation durch Gesamtvariation • man erhält die gleichen Werte, wenn man statt der Variation die Varianz verwendet • das Maß für die Fehlerreduktion heißt R² oder Determinationskoeffizient, er bezeichnet den Teil der erklärten Varianz an der Gesamtvarianz. R² ist ein symmetrisches Maß, ergibt sich also genauso bei der Regression von x auf y. E1 E2 s y s 2 E1 s y 2 2 y r 2 Zusammenhang zwischen Korrelation und Regression Das Bestimmtheitsmaß R2 entspricht dem Quadrat des Korrelationskoeffizienten. Korrelation ist identisch mit dem Regressionskoeffizienten b bei der Regression der z-transformierten Variable y auf die z-transformierte Variable x. Interpretation r: das Maß, in dem eine Steigung einer Variablen mit der Steigung (oder dem Absinken bei negativen Korrelationen) einer anderen Variablen einhergeht. Interpretation R²: der Anteil der erklärten Varianz von y durch x (damit ist aber noch keine kausale Aussage verknüpft)