Open Source Datenbanken für analytische Systeme

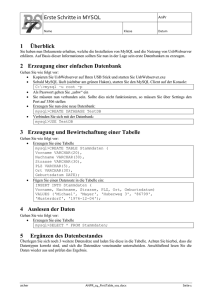

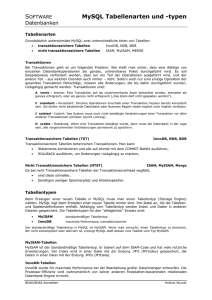

Werbung