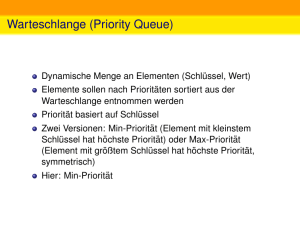

Datenstrukturen - Informatik @ Uni Frankfurt

Werbung