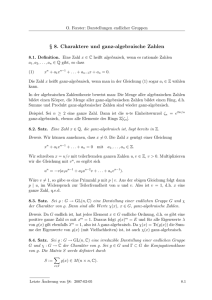

5 Symmetrische Bilinearformen

Werbung

5

5.1

Symmetrische Bilinearformen

Die Signatur

In diesem Abschnitt betrachten wir einen endlich-dimensionalen reellen Vektorraum V mit einer symmetrischen, aber nicht notwendigerweise positiv definiten

Bilinearform h·, ·i. Wir interessieren uns u.A. für die dem Skalarprodukt zugeordnete quadratische Form, d.h. die Abbildung

q : V → R,

v 7→ q(v) := hv, vi.

Beispiel 5.1.1 Sei V = R2 und h·, ·i die durch die Matrix

0 1

A=

1 0

bestimmte symmetrische Bilinearform. Für einen Vektor v = (x1 , x2 ) ∈ V gilt

q(v) = hv, vi = 2x1 x2 .

Dieser Wert kann sowohl positiv, negativ oder Null sein. Man nennt die symmetrische Bilinearform h·, ·i und ihre zugeordnete quadratische Form q indefinit.

Die Punkte der Ebene, auf denen die quadratische Form q einen konstanten

Wert a 6= 0 annimmt, q(v) = a, bilden eine Hyperbel mit Gleichung

2x1 x2 = a.

(Im Grenzfall a = 0 erhält man die Vereinigung der beiden Koordinatenachsen.)

Man nennt (V, h·, ·i) deshalb auch die hyperbolische Ebene.

Sei B = (v1 , v2 ) die Basis von V mit den Vektoren

1 −1

1 1

,

v2 = √

.

v1 = √

2 1

2 1

Die darstellende Matrix der Bilinearform bezüglich B ist

hv1 , v1 i hv1 , v2 i

1 0

MB (h·, ·i) =

=

.

hv2 , v1 i hv2 , v2 i

0 −1

Insbesondere ist B eine orthogonale Basis.

Satz 5.1.2 Sei V ein endlich-dimensionaler reeller Vektorraum und h·, ·i eine

symmetrische Bilinearform auf V . Dann gibt es eine orthogonale Basis B =

(v1 , . . . , vn ) mit

hvi , vi i ∈ {0, 1, −1},

für i = 1, . . . , n. Bei geeigneter Wahl der Reihenfolge der Basisvektoren gilt also

i = 1, . . . , p,

1,

hvi , vi i = −1,

(39)

i = p + 1, . . . , p + q,

0,

i = p + q + 1, . . . , n,

für gewisse ganze Zahlen p, q ≥ 0.

70

Der Beweis dieses Satzes wird ganz ähnlich geführt wie der des Orthogonalisierungssatzes im euklidischen Fall (Satz 4.2.2), nähmlich durch Induktion über

die Dimension. Als Ersatz für die positive Definitheit benötigen wir hier den

folgenden Begriff und das anschließende Lemma.

Definition 5.1.3 Ein Vektor v ∈ V heißt isotrop, falls

hv, vi = 0.

Andernfalls heißt v anisotrop.

Lemma 5.1.4 Sei V ein reller Vektorraum und h·, ·i eine symmetrische Bilinearform auf V .

(i) Wenn h·, ·i =

6 0 nicht identisch Null ist, so gibt es einen anisotropen Vektor

v ∈V.

(ii) Ist v ∈ V anisotrop und U := hvi der von v aufgespannte Untervektorraum, so gilt

V = U ⊕ U ⊥.

Beweis: Ist h·, ·i =

6 0, so gibt es Vektoren v, w ∈ V mit hv, wi =

6 0. Gilt

zusätzlich hv, vi 6= 0 oder hw, wi 6= 0, so ist nichts zu zeigen. Wir können also

annehmen, dass v und w isotrop sind. Aber dann ist u := v + w wegen

hu, ui = hv, vi + 2hv, wi + hw, wi = 2hv, wi =

6 0

anisotrop. Damit ist (i) bewiesen.

Zum Beweis von (ii) nehmen wir an, dass v anisotrop ist und U = hvi. Wir

müssen die folgenden zwei Aussagen beweisen:

(a) U ∩ U ⊥ = {0},

(b) V = U + U ⊥ .

Ein beliebiger Vektor u ∈ U ist von der Form u = λ · v, mit λ ∈ R. Es gilt

u ∈ U ⊥ genau dann, wenn hu, vi = 0. Aber wegen

hu, vi = λ · hv, vi

und hv, vi =

6 0 gilt dies nur für λ = 0, also u = 0. Daraus folgt (a).

Zum Beweis von (b) müssen wir einen beliebigen Vektor w ∈ V in der Form

w = λ · v + w0 mit hw0 , vi = 0 schreiben. Die Bedingung an λ lautet:

hw0 , vi = hw − λ · v, vi = hw, vi − λ · hv, vi.

Wegen hv, vi =

6 0 können wir diese Gleichung nach λ auflösen. Damit haben wir

(b) bewiesen. Nun ist alles gezeigt.

2

Beweis: (von Satz 5.1.2) Wir führen den Beweis durch Induktion über n :=

dimR V . Für n = 0 ist nichts zu zeigen, deshalb nehmen wir n ≥ 1 an.

71

Ist h·, ·i = 0, so ist ebenfalls nichts zu zeigen – die Aussage des Satzes ist für

jede Basis B erfüllt, mit p = q = 0. Wir dürfen also h·, ·i =

6 0 annehmen. Nach

Lemma 5.1.4 (i) gibt es dann einen anisotropen Vektor v ∈ V . Wir setzen

v1 := p

1

|hv, vi|

· v.

Nun gilt hv1 , v1 i = ±1. Wir werden im Folgenden versuchen, (v1 ) zu einer Basis

B = (v1 , . . . , vn ), die die Bedingung aus Satz 5.1.2 erfüllt, zu ergänzen.

Sei U := hv1 i. Nach Lemma 5.1.4 haben wir eine Zerlegung

mit W := U ⊥ .

V = U ⊕ W,

Insbesondere gilt dimR W = n−1. Wir wenden nun unsere Induktionshypothese

auf den Vektorraum W , versehen mit der Einschränkung von h·, ·i, an. Demnach

gibt es eine orthogonale Basis B 0 = (v2 , . . . , vn ) von W mit hvi , vi i ∈ {0, 1, −1},

für i = 2, . . . , n. Aus der Zerlegung V = U ⊕ W folgt mit Proposition 4.3.3,

dass B := (v1 , v2 , . . . , vn ) eine Basis von V ist. Da W = U ⊥ , ist der Vektor

v1 orthogonal zu allen Vektoren vi mit i ≥ 2. Nach Konstruktion ist B also

eine orthogonale Basis von V mit den geforderten Eigenschaften. Damit ist der

Beweis von Satz 5.1.2 vollständig.

2

Korollar 5.1.5 Sei A ∈ Mn,n (R) eine relle symmetrische Matrix. Dann gibt

es eine invertierbare Matrix Q ∈ GLn (R), so dass

Ep

.

−Eq

Qt · A · Q =

0s

Die Matrix auf der rechten Seite heißt die Normalform von A.

Beweis: Wir wenden Satz 5.1.2 auf den Vektorraum V = Rn und die durch

A bestimmte Bilinearform h·, ·iA an. Ist B = (v1 , . . . , vn ) eine orthogonale Basis

von V , die (39) erfüllt, und ist Q := TEB = (v1 | · · · | vn ), so ist Qt · A · Q in

Normalform.

2

Definition 5.1.6 Sei V ein endlich-dimensionaler reeller Vektorraum und h·, ·i

eine symmetrische Bilinearform auf V . Sei B = (v1 , . . . , vn ) eine orthogonale

Basis von V (existiert nach Satz 5.1.2). Wir definieren die Signatur von h·, ·i

als das Paar ganzer Zahlen (p, q), wobei p die Anzahl der Basisvektoren vi

bezeichnet mit hvi , vi i > 0 und q die Anzahl der vi mit hvi , vi i < 0.

Die Wohldefiniertheit der Signatur ist eine Konsequenz des folgenden Satzes.

Satz 5.1.7 (Trägheitssatz von Sylvester) Die oben definierte Signatur (p, q)

ist unabhängig von der Wahl der orthogonalen Basis B.

72

Beweis: Seien B = (v1 , . . . , vn ) und B 0 = (v10 , . . . , vn0 ) zwei orthogonale

Basen von V . Ohne Einschränkung der Allgemeinheit dürfen wir annehmen,

dass

i = 1, . . . , p,

1,

hvi , vi i = −1,

i = p + 1, . . . , p + q,

0,

i = p + q + 1, . . . , n,

für gewisse p, q ≥ 0, und dass

1,

0 0

hvi , vi i = −1,

0,

i = 1, . . . , p0 ,

i = p0 + 1, . . . , p0 + q 0 ,

i = p0 + q 0 + 1, . . . , n,

für gewisse p0 , q 0 ≥ 0. Wir müssen zeigen, dass dann p = p0 und q = q 0 gilt.

Wir zeigen zunächst p + q = p0 + q 0 . Diese Aussage folgt aus dem folgenden

Lemma, welches die Zahl s := n − p − q mit der Dimension eines Untervektorraumes identifiziert, der nicht von der Wahl der Basis B abhängt.

Lemma 5.1.8 Die Vektoren vp+q+1 , . . . , vn bilden eine Basis des Untervektorraumes

V ⊥ = { v ∈ V | hv, wi = 0 ∀ w ∈ V }.

Insbesondere gilt

dimR V ⊥ = n − p − q.

(Den Untervektorraum V ⊥ nennt man das Radikal der Bilinearform h·, ·i.)

Beweis: Aus den getroffenen Annahmen folgt sofort, dass die Vektoren

vp+q+1 , . . . , vn in V ⊥ liegen und dass sie linear unabhängig sind. Es bleibt

zu zeigen, dass sie den Untervektorraum V ⊥ P

erzeugen.

n

Sei v ∈ V ⊥ beliebig. Wir schreiben v = i=1 λi · vi und wählen uns einen

⊥

Index j ∈ {1, . . . , n}. Aus der Annahme v ∈ V folgt, da B eine Orthogonalbasis

ist,

n

X

0 = hv, vj i =

λi · hvi , vj i = λj · hvj , vj i.

i=1

Für j ≤ p + q gilt aber hvj , vj i =

6 0 und daher λj = 0. Es folgt

v = λp+q+1 · vp+q+1 + . . . + λn · vn .

2

Damit ist das Lemma bewiesen.

Zurück zum Beweis von Satz 5.1.7. Aus Lemma 5.1.8 folgt die Gleichheit

p + q = p0 + q 0 . Wir betrachten nun das System der n + p − p0 Vektoren

(v1 , . . . , vp , vp0 0 +1 , . . . , vn0 )

(40)

und behaupten, dass es linear unabhängig ist. In der Tat, jede lineare Relation

dieses Systems kann man auf die Form

λ1 · v1 + . . . + λp · vp = µ1 · vp0 +1 + . . . µn−p0 · vn0

73

(41)

bringen. Sei v der durch beide Seiten von (41) definierte Vektor. Benutzt man

die linke Seite von (41) und die Voraussetzung an die Basis B, so erhält man

hv, vi = λ21 · hv1 , v1 i + . . . + λ2p · hvp , vp i = λ21 + . . . + λ2p ≥ 0.

(42)

Benutzt man dagegen die rechte Seite von (41) und die Voraussetzungen an B 0 ,

so erhält man

hv, vi = µ21 · hvp0 0 +1 , vp0 +1 i + . . . + µ2n−p0 · hvn0 , vn0 i

= −(µ21 + . . . + µ2n−p0 −q0 ) ≤ 0.

(43)

Durch Gleichsetzen von (42) und (43) erhält man λi = 0 für i = 1, . . . , p und

µi = 0 für i = 1, . . . , n − p0 − q 0 , d.h.

v = µn−p0 −q0 +1 · vp0 0 +q0 +1 + . . . + µn−p0 · vn0 = 0.

Da das System (vp0 0 +q0 +1 , . . . , vn0 ) Teil der Basis B 0 ist, ist es linear unabhängig.

Es gilt als λi = µi = 0 für alle möglichen Indizes i.

Wir haben gezeigt, dass das System der n + p − p0 Vektoren in (40) linear

unabhängig ist. Aus Dimensionsgründen folgt daraus n + p − p0 ≤ n, also p ≤ p0 .

Da man das Argument auch mit vertauschten Rollen durchführen kann, folgt

sogar p = p0 . Da wir bereits die Gleichheit p + q = p0 + q 0 gezeigt hatten, ist der

Beweis vollständig.

2

Definition 5.1.9 Eine symmetrische Bilinearform h·, ·i auf einem reellen Vektorraum V heißt nichtausgeartet, wenn das Radikal verschwindet, d.h. wenn

V ⊥ = {0}.

Eine symmetrische Matrix A ∈ Mn,n (R) heißt nichtausgeartet, wenn die zugehörige Bilinearform auf Rn nichtausgeartet ist.

Bemerkung 5.1.10 (i) Eine symmetrische Bilinearform auf V mit Signatur

(p, q) ist nichtausgeartet genau dann, wenn p + q = dimR V gilt.

(ii) Ist A ∈ Mn,n (R) eine symmetrische Matrix mit Signatur (p, q), so gilt

p + q = Rang(A).

Die Matrix A ist also nichtausgeartet genau dann, wenn sie invertierbar

ist.

Quadratische Formen

Wir wollen ein paar allgemeine Dinge über den Zusammenhang zwischen

Bilinearformen und quadratischen Formen festhalten.

74

Sei V ein Vektorraum über einem Körper K, in dem 2 6= 0 gilt. Jeder

Bilinearform s : V × V → K können wir eine sogenannte quadratische Form

zuordnen; dies ist die Funktion

q : V → K,

q(v) := s(v, v).

Wir wollen im Folgenden immer vorausstzen, dass die Bilinearform s symmetrisch ist.

Proposition 5.1.11 Sei s : V × V → K eine symmetrische Bilinearform und

q : V → K die zugehörige quadratische Form. Dann gilt für alle v, w ∈ V und

λ ∈ K:

q(λ · v) = λ2 · q(v),

und

q(v + w) = q(v) + q(w) + 2s(v, w).

2

Beweis: Direktes Nachrechnen

Eine einfache, aber wichtige Konsequenz aus der obigen Proposition ist die

Tatsache, dass die Bilinearform s eindeutig durch die quadratische Form q bestimmt ist. Das sieht man, wenn man die zweite Formel umformt zu

s(v, w) =

5.2

1

q(v + w) − q(v) − q(w) .

2

(44)

Der Spektralsatz (reelle Form)

Im Folgenden sei (V, h·, ·i) ein euklidischer Vektorraum der Dimension n.

Definition 5.2.1 Ein Endomorphismus φ : V → V heißt selbstadjungiert oder

symmetrisch (bzgl. h·, ·i), wenn für alle v, w ∈ V gilt:

hφ(v), wi = hv, φ(w)i.

Proposition 5.2.2 Sei φ : V → V ein Endomorphismus, B eine Orthonormalbasis von V und A ∈ Mn,n (R) die darstellende Matrix von φ bezüglich B. Dann

ist φ selbstadjungiert genau dann, wenn A symmetrisch ist, d.h. wenn

At = A.

Beweis: Wir dürfen V vermöge des durch B definierten Koordinatensystems

mit dem euklidischen Standardvektorraum identifizieren. Dann gilt hx, yi = xt ·y

und φ(x) = A · x.

Angenommen, φ ist selbstadjungiert. Dann gilt

xt · A · y = hx, A · yi = hA · x, yi = xt · At · y,

für alle x, y ∈ Rn . Daraus folgt At = A, und wir haben eine Richtung der

behaupteten Äquivalenz bewiesen. Der Beweis der Umkehrung ist sehr ähnlich.

2

75

Bemerkung 5.2.3 Die Matrix A im obigen Beweis spielt eine ‘Doppelrolle’:

zum einen als darstellende Matrix eines Endomorphismus, zum anderen als Matrix einer Bilinearform. Das läßt sich so erklären: ist φ : V → V ein selbstadjungierter Endomorphismus, so ist die Abbildung

s : V × V → R,

(v, w) 7→ hφ(v), wi = hv, φ(w)i

eine symmetrische Bilinearform auf V . Identifizieren wir V vermöge einer Orthonormalbasis B mit dem euklidischen Standardraum Rn , so gilt φ(x) = A · x

und

s(x, y) = xt · A · y

ist die symmetrische Bilinearform zu A.

Ersetzen wir die Orthonormalbasis B durch eine andere Orthonormalbasis

B 0 , so wird aus A die Matrix

A0 = S −1 · A · S = S t · A · S,

0

wobei S := TBB die Basiswechselmatrix ist. Der entscheidende Punkt ist, dass

S orthogonal ist und daher S −1 = S t gilt; für den Basiswechsel ist es also egal,

ob wir A als Endomorphismus oder als Bilinearform auffassen.

Satz 5.2.4 Sei φ : V → V ein selbstadjungierter Endomorphismus eines euklidischen Vektorraumes der Dimension ≥ 1. Dann besitzt φ mindestens einen

Eigenvektor.

Korollar 5.2.5 Eine reelle symmetrische Matrix A ∈ Mn,n (R) besitzt mindestens einen reellen Eigenwert.

Beweis: (von Satz 5.2.4) Wir fassen V als einen normierten und insbesondere topologischen Vektorraum auf. Die 1-Sphäre S ist die Teilmenge von V

aller Vektoren der Länge 1:

S := { v ∈ V | ||v|| = 1 }.

Dies ist eine beschränkte und abgeschlossene Teilmenge von V , mithin eine

kompakte Menge.

Wir betrachten nun die quadratische Form

q : V → R,

v 7→ q(v) := hφ(v), vi = hv, φ(v)i.

Dies ist eine stetige Funktion auf V ; sie nimmt daher auf der kompakten Teilmenge S ⊂ V ein Maximum an. Es gibt also einen Vektor u ∈ V mit

||u|| = 1,

q(u) ≥ q(v),

Das Lemma folgt nun aus der folgenden

Behauptung: u ist ein Eigenvektor von φ.

76

∀ v ∈ S.

(45)

Zum Beweis dieser Behauptung betrachten wir den von u aufgespannten,

eindimensionalen Unterraum U := hui. Offenbar ist u ein Eigenvektor von φ

genau dann, wenn φ(u) ∈ U .

Nach Proposition 4.3.8 und Bemerkung 4.3.12 haben wir eine orthogonale

direkte Zerlegung

V = U ⊥ W,

mit W := U ⊥ .

Insbesondere gilt

U = W ⊥.

Für den Beweis der Behauptung genügt es nun zu zeigen, dass für alle w ∈ W

gilt:

hφ(u), wi = 0.

(46)

Dann folgt nämlich φ(u) ∈ W ⊥ = U = hui, und u ist ein Eigenvektor von φ. Es

ist klar, dass wir (46) nur für alle w ∈ W der Länge 1 zeigen brauchen.

Sei also w ein Vektor mit

||w|| = 1,

hu, wi = 0.

Für t ∈ R setzen wir

v = v(t) := cos(t) · u + sin(t) · w.

Wegen u, w ∈ S, hu, wi = 0 und Lemma 4.3.13 gilt

||v|| = cos2 (t) · ||u||2 + sin2 (t) · ||w||2 = 1,

d.h. v liegt auf S, für alle t ∈ R. Wir betrachten nun die Funktion

f : R → R,

f (t) := q(v).

Unter Verwendung von Proposition 5.1.11 erhalten wir

f (t) = q cos(t) · u + sin(t) · w

= cos2 (t) · q(u) + sin2 (t) · q(w) + 2 cos(t) sin(t) · hφ(u), wi.

Insbesondere ist f differenzierbar. Ein kurze Rechnung zeigt

f 0 (0) = 2 · hφ(u), wi.

(47)

Andererseits gilt nach Wahl des Vektors u (siehe (45)) die Ungleichung

f (t) = q(v) ≤ q(u) = f (0),

für alle t ∈ R. Die Funktion f nimmt bei t = 0 also ein Maximum an. Wir

schließen daraus:

f 0 (0) = 0.

Aus (47) folgt nun (46), wie gewünscht. Der Beweis des Satzes ist damit vollendet.

2

Wir werden später noch einen anderen Beweis dieses Satzes kennenlernen,

der algebraischer ist und einen Umweg über die komplexen Zahlen und den

Fundamentalsatz der Algebra nimmt.8

8 Beim

Beweis des Fundamentalsatzes kommt man auch nicht ganz ohne Analysis aus.

77

Proposition 5.2.6 Es sei φ : V → V ein selbstadjungierter Endomorphismus

und

V =U ⊥W

eine Zerlegung von V in eine direkte orthogonale Summe von zwei Untervektorräumen (siehe Bemerkung 4.3.12). Dann gilt

φ(U ) ⊂ U

genau dann, wenn

φ(W ) ⊂ W.

(wir sagen in diesem Fall, dass φ die orthogonale Zerlegung V = U ⊥ W respektiert.)

Beweis: Es reicht, eine der zwei Implikationen zu beweisen. Angenommen,

es gilt φ(U ) ⊂ U . Wir wollen zeigen, dass daraus φ(W ) ⊂ W folgt. Sei also

w ∈ W beliebig. Dann gilt für alle u ∈ U :

hu, φ(w)i = hφ(u), wi = 0.

(Im ersten Schritt haben wir die Selbstadjungiertheit von φ und im zweiten

Schritt die Annahme φ(U ) ⊂ U = W ⊥ verwendet.) Wir schließen aus obiger

Gleichung:

φ(w) ∈ U ⊥ = W.

2

Damit ist die Proposition bewiesen.

Satz 5.2.7 (Spektralsatz) Sei φ : V → V ein selbstadjungierter Endomorphismus auf einem euklidischen Vektorraum V . Dann besitzt V eine Orthonormalbasis B = (v1 , . . . , vn ), die aus Eigenvektoren von φ besteht:

hvi , vj i = δi,j

und φ(vi ) = λi · vi ,

mit λ1 , . . . , λr ∈ R.

Insbesondere ist jeder selbstadjungierte Endomorphismus von V diagonalisierbar.

Korollar 5.2.8 (Hauptachsentransformation) Sei A ∈ Mn,n (R) eine relle

symmetrische Matrix. Dann gibt es eine orthogonale Matrix S ∈ On (R) so, dass

λ1

..

S −1 · A · S =

.

λn

eine Diagonalmatrix ist.

Insbesondere ist jede reelle symmetrische Matrix über R diagonalisierbar.

78

Eine geometrische Begründung des Begriffes ‘Hauptachsentransformation’

wird im folgenden Abschnitt nachgeliefert.

Beweis: (von Satz 5.2.7) Wir beweisen den Satz durch Induktion nach n :=

dimR (V ). Dabei dürfen wir n ≥ 1 annehmen. Nach Satz 5.2.4 gibt es einen

Eigenvektor v1 ∈ V von φ, sagen wir zum Eigenwert λ1 . Durch Normieren von

v1 können wir erreichen, dass v1 die Länge 1 hat, ||v1 || = 1.

Sei U := hv1 i und W := U ⊥ . Nach Proposition 4.3.8 und Bemerkung 4.3.12

erhalten wir eine orthogonale direkte Zerlegung

V = U ⊥ W.

Da U von einem Eigenvektor von φ aufgespannt wird, gilt φ(U ) ⊂ U . Aus

Proposition 5.2.6 folgt nun wegen der Selbstadjungiertheit von φ:

φ(W ) ⊂ W.

Da dimR W = n − 1, können wir die Induktionsannahme auf den Endomorphismus φ|W : W → W anwenden. Als Ergebnis erhalten wir eine Orthonormalbasis

B 0 = (v2 , . . . , vn ) von W , die aus Eigenvektoren von φ|W besteht. Nach Konstruktion ist dann B := (v1 , . . . , vn ) eine Orthonormalbasis von V , bestehend

aus Eigenvektoren von φ.

2

Beispiel 5.2.9 Für symmetrische (2, 2)-Matrizen kann man den Spektralsatz

leicht direkt beweisen. Sei

a b

A=

,

b d

mit a, b, d ∈ R. Das charakteristische Polynom von A ist

PA = x2 − (a + d) x + (ad − b2 ).

Anhand der p-q-Formel sieht man nach einer kurzen Rechnung, dass PA für

b 6= 0 oder a 6= d zwei verschiedene reelle Nullstellen besitzt:

αi =

p

1

a + d ± (a − d)2 + 4b2 ,

2

i = 1, 2. Es folgt, dass A über R stets diagonalisierbar ist.

Für das konkrete Beispiel a = d = 1, b = 2, also

1 2

A=

,

2 1

erhält man die Eigenwerte −1, 3 und die entsprechenden Eigenvektoren

1

1

v1 =

,

v2 =

.

−1

1

Es ist kein Zufall, dass v1 und v2 orthogonal sind, sondern eine Konsequenz aus

dem Spektralsatz (siehe auch die folgende Bemerkung)! Durch Normieren der vi

79

erhalten wir eine Orthonormalbasis von R2 und entsprechend eine orthogonale

Matrix

1

1 1

S=√

2 −1 1

mit der Eigenschaft

S

−1

t

·A·S =S ·A·S =

−1

0

0

.

3

Bemerkung 5.2.10 Sei φ : V → V ein selbstadjungierter Endomorphismus

auf einem euklidischen Vektorraum V . Sind v1 , v2 zwei Eigenvektoren mit verschiedenen Eigenwerten λ1 6= λ2 , so sind v1 und v2 automatisch orthogonal.

Das folgt aus Satz 5.2.7, läßt sich aber auch leicht aus der folgenden Rechnung

ableiten:

λ1 · hv1 , v2 i = hφ(v1 ), v2 i = hv1 , φ(v2 )i = λ2 · hv1 , v2 i.

Aus λ1 6= λ2 folgt sofort hv1 , v2 i = 0.

Beispiel 5.2.11 (Orthogonale Projektionen) Es gilt folgende ‘Umkehrung’

des Spektralsatzes: ein Endomorphismus φ : V → V , der eine Orthonormalbasis

aus Eigenvektoren besitzt, ist selbstadjungiert. Das ist eine direkte Folge der

Proposition 5.2.2.

Sei U ⊂ V ein Untervektorraum und p : V → V die orthogonale Projektion

auf U (siehe Proposition 4.3.8). Wir wählen eine Orthonormalbasis BU von U

und eine Orthonormalbasis BW des orthogonalen Komplement W := U ⊥ . Dann

ist B := BU ∪ BW eine Orthonormalbasis von V , die aus Eigenvektoren von p

besteht. Genauer: die darstellende Matrix von p bezüglich B ist

Er

MB (φ) =

,

0s

mit r := dim U , s := dim W . Insbesondere ist p selbstadjungiert.

Nun sei V = Rn der euklidische Standardraum der Dimension n und p :

V → V ein Endomorphismus mit darstellender Matrix A ∈ Mn,n (R) (also

p(x) = A · x). Aus dem Spektralsatz folgt, zusammen mit obiger Diskussion:

p ist die orthogonale Projektion auf den Untervektorraum U = Bild(A) genau

dann, wenn A symmetrisch ist und

A2 = A

gilt. Die zweite Bedingung kann man (wenn A symmetrisch ist) ersetzen durch

die Bedingung, dass das charakteristische Polynom PA von A nur 0 und 1 als

Nullstellen hat, also

PA = ±(x − 1)r xs .

Für n = 2 gilt zum Beispiel: ist U ⊂ R2 die Gerade, die man durch Drehung

der x1 -Achse um den Winkel α erhält, so ist die orthogonale Projektion p :

80

R2 → U durch die Matrix

cos2 α

A=

sin α cos α

sin α cos α

sin2 α

gegeben.

5.3

Quadriken und Kegelschnitte

Eine Quadrik ist die (nichtleere) Lösungsmenge Q ⊂ Rn einer quadratischen

Gleichung, d.h. einer Gleichung der Form

q(x) + l(x) + c = 0,

wobei q : Rn → R eine quadratische Form und l : Rn → R eine lineare Funktion

ist. Die quadratische Form q ist durch eine symmetrische Matrix A = (ai,j ) 6= 0,

die lineare Funktion l durch einen Zeilenvektor B = (bi ) gegeben. Die Gleichung

lautet dann explizit:

X

X

xt · A · x + B · x + c =

ai,j xi xj +

bi xi + c = 0.

(48)

i,j

i

Quadriken in der Ebene E = R2 nennt man auch Kegelschnitte.

Unser Ziel ist nun, die Kongruenzklassen solcher Quadriken zu studieren.

Dabei heißen zwei Quadriken Q, Q0 kongruent oder deckungsgleich, wenn Q

durch eine euklidische Bewegung des Rn in Q0 überführt werden kann.

Wir werden dies nur für den Fall n = 2, also in der euklidischen Ebene

E = R2 durchführen. Unsere Vorgehensweise läßt sich aber problemlos auf

höhere Dimensionen übertragen.

Definition 5.3.1 Eine ebene Quadrik Q ⊂ E = R2 heißt entartet, wenn sie

die leere Menge ist oder nur aus einem Punkt, oder aus einer Geraden oder aus

zwei Geraden besteht. Andernfalls heißt Q nichtentartet.

Satz 5.3.2 Eine nichtentartete ebene Quadrik Q ⊂ E = R2 ist kongruent zu

einer der folgenden Typen:

(i) Ellipse:

a1,1 x21 + a2,2 x22 − 1 = 0,

(ii) Hyperbel:

a1,1 x21 − a2,2 x22 − 1 = 0,

(iii) Parabel:

a1,1 x21 − x2 = 0,

wobei jeweils a1,1 , a2,2 > 0 sind.

81

Beweis: Sei Q ⊂ R2 eine (nichtleere) Quadrik, gegeben durch die quadratische Gleichung (48). Wir betrachten zunächst nur den quadratischen Anteil

der Gleichung

q(x) = xt · A · x = a1,1 x21 + 2a1,2 x1 x2 + a2,2 x22 .

Nach Korollar 5.2.8 gibt es eine orthogonale Matrix S ∈ O2 (R), so dass

λ1 0

0

t

A := S · A · S =

0 λ2

eine Diagonalmatrix ist. Nach Anwenden des euklidischen Koordinatenwechsels

x=S·y

schreibt sich die quadratische Form q in y-Koordinaten so:

q(x) = q(S · y) = λ1 y12 + λ2 y22 .

Die Koordinatenachsen des neuen Koordinatensystems heißen die Hauptachsen

von q. Sie werden natürlich aufgespannt von den Spalten der orthogonalen

Matrix S. Die Gleichung der Quadrik Q in den neuen Koordinaten lautet

λ1 y12 + λ2 y22 + b01 y1 + b02 y2 + c = 0,

für gewisse Konstanten b01 , b02 ∈ R, die sich leicht berechnen lassen.

Anstatt durch einen Koordinatenwechsel können wir unser Zwischenergebnis

auch so formulieren: durch Anwenden der ebenen Symmetrie

∼

f : E → E,

f (x) := S −1 · x

(eine Drehung oder eine Spiegelung) auf Q erhält man eine kongruente Quadrik

Q0 := f (Q) mit Gleichung

λ1 x21 + λ2 x22 + b01 x1 + b02 x2 + c = 0.

Für den Verlauf des Beweises ist es ungünstig, dass bei Vereinfachung der

Gleichung ständig neue Konstanten auftauchen. Es ist geschickter, die ursprüngliche Notation beizubehalten, auch wenn sich die konkreten Werte der

Konstanten ai,j , bi , c beim Umformen verändern. Was wir bisher bewiesen

haben, zeigt doch, dass wir für den Beweis des Satzes annehmen dürfen, dass

die Quadrik Q durch die Gleichung

a1,1 x21 + a2,2 x22 + b1 x1 + b2 x2 + c = 0

(49)

gegeben ist.

Annahme 1: a1,1 , a2,2 6= 0.

Diese Bedingung ist äquivalent zu der Aussage, dass die quadratische Form q

nichtausgeartet ist. In unserer Situtation können wir diese Bedingung benutzen,

82

um den linearen Term durch einen weiteren Koordinatenwechsel zu beseitigen:

nach der Substitution

bi

xi = yi −

, i = 1, 2,

2ai,i

in (49) erhält man die folgende Gleichung für Q:

a1,1 y12 + a2,2 y22 + c0 = 0.

für eine gewisse Konstante c0 ∈ R. Diese Substitution entspricht einer Translation der Quadrik um den Vektor v = (b1 /2a1,1 , b2 /2a2,2 ).

Ist c0 = 0 so sieht man leicht, dass die Quadrik Q entartet ist. Da wir diesen

Fall ausgeschlossen ahben, gilt c0 6= 0. Da sich eine Quadrik nicht verändert,

wenn wir ihre Gleichung mit einer Konstanten 6= 0 durchmultiplizieren, können

wir c0 zu 1 normalisieren.

Alles in allem dürfen wir also annehmen, dass die Quadrik Q durch die

Gleichung

a1,1 x21 + a2,2 x22 = 1

(50)

gegeben ist.

Wie unsere Quadrik geometrisch aussieht, hängt von den Vorzeichen der ai,i

ab; es gibt im Wesentlichen zwei Fälle. Der dritte Fall (a1,1 , a2,2 < 0) tritt nicht

ein, da in diesem Fall die Quadrik die leere Menge, also ausgeartet wäre.

1. Fall: a1,1 , a2,2 > 0

In diesem Fall ist die Quadrik Q eine Ellipse. Es tritt also der Fall (i) von

Satz 5.3.2 ein.

BILD von Q

Es sei nebenbei bemerkt, dass man auch hier noch zwei Fälle unterscheiden

kann. Sind die Koeffizienten ai,i verschieden, so handelt es sich um eine echte Ellipse mit zwei wohlbestimmten, orthogonalen Hauptachsen. In der Normalform

(50) sind dies die Achsen des Koordinatensystems.

Für a1,1 = a2,2 ist Q offenbar ein Kreis. Es gibt keine ausgezeichnete Hauptachsen, und der erste Vereinfachungsschritt (der Koordinatenwechsel x = S · y)

war überflüssig, weil die Matrix A bereits eine Diagonalmatrix war.

2. Fall: a1,1 · a2,2 < 0

In diesem Fall ist die Quadrik Q eine Hyperbel, d.h. Fall (ii) von Satz 5.3.2

tritt ein. Es gibt zwei eindeutig bestimmte, zueinander orthogonale Hauptachsen.

BILD EINER HYPERBEL

83

Was passiert, wenn die Annahme 1 nicht zutrifft? Da wir von Anfang an

angenommen haben, dass die Matrix A der quadratischen Form q nicht verschwindet, ist entweder a1,1 6= 0 oder a2,2 6= 0. Es reicht, nur einen der beiden Fälle zu betrachten. Wir gehen also zurück zu der Gleichung (49) für die

Quadrik Q und treffen die

Annahme 2: a1,1 6= 0, a2,2 = 0.

Wir haben also die Gleichung

a1,1 x21 + b1 x1 + b2 x2 + c = 0.

Wäre b2 = 0, so hinge diese Gleichung nicht mehr von x2 ab und würde eine

entartete Quadrik definieren (z.B. zwei Geraden, parallel zur x2 -Achse). Da wir

dies ausgeschlossen haben, gilt b2 6= 0. Durch die Substitution

x1 = y1 −

b1

2a1,1

beseitigen wir den Koeffizienten b1 und anschließend durch die Substitution

x2 = y2 −

c0

b2

den konstanten Term c0 . Schließlich normieren wir durch Multiplizieren der

Gleichung mit −1/b2 den Koeffizienten b2 zu −1. Nach diesen Umformungen

erhalten wir die Gleichung

a1,1 x21 − x2 = 0.

Dies ist die Gleichung einer Parabel.

BILD EINER PARABEL

Sollte a1,1 < 0 sein, so kann man durch die Substitution

x1 = y1 ,

x2 = −y2

das Vorzeichen umdrehen. Wir dürfen also a1,1 > 0 annehmen, was dem Fall

(iii) aus Satz 5.3.2 entspricht. Damit ist alles gezeigt.

2

Beispiel 5.3.3 Sei Q ⊂ E die durch die Gleichchung

3x21 − 2x1 x2 + 3x22 + 8x22 − 8x2 + 6 = 0

definierte Quadrik. Der quadratische Anteil dieser Gleichung wird durch die

symmetrische Matrix

3 −1

A=

−1 3

84

bestimmt. Die Hauptachsentransformation von A sieht so aus:

1

1 0

1 −1

t

S ·A·S =

,

mit S := √ ·

.

0 2

1 1

2

Die Substitution

x1

x2

y

=S· 1

y2

in die Gleichung für Q und anschließende Division durch 2 führt uns auf die

Gleichung

√

y12 + 2y22 − 4 2y2 + 3 = 0.

Durch die Substitution

y1 = z1 ,

y2 = z2 +

√

2

erhalten wir schließlich eine Gleichung in Normalform:

z12 + 2z22 − 1 = 0.

Die Quadrik Q ist also eine Ellipse, deren Hauptachsen die Achsen des zKoordinatensystems sind. Die Beziehung zwischen x- und z-Koordinaten ist

0

−1

√

x=S·z+S·

=S·z+

1

2

d.h.

1

x1 = √ z1 − z2 − 1,

2

1

x2 = √ z1 + z2 + 1.

2

Mit diesen Angaben ist es leicht, die Lage der Quadrik Q in der Ebene zu

skizzieren:

Bild von Q bzgl x- und z-Koordinaten

∼

Nun sei f : E → E die Bewegung der Ebene, die die Beziehung zwischen z−

und x-Koordinaten ausdrückt:

0

z = f (x) = S t · x + √ .

2

Da die Determinante der orthogonalen Matrix S gleich 1 ist, ist f eine Drehung

(um welchen Punkt und mit welchem Drehwinkel?). Die Quadrik Q0 := f (Q) ⊂

E ist eine zu Q kongruente Ellipse in Normalform, gegeben durch die Gleichung

x21 + 2x22 − 1 = 0.

85

References

[1] M. Artin, Algebra, Birkhäuser.

[2] G. Fischer, Lineare Algebra.

[3] S. Wewers, Skript zur Vorlesung Lineare Algebra I im WS 07/08.

www.iazd.uni-hannover.de/~wewers/la1/vorlesung/gesamt.pdf

86