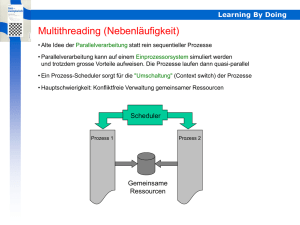

Nebenläufige Programmierung in Java

Werbung