- Fachgebiet Datenbanken und Informationssysteme

Werbung

Erweiterung eines objektrelationalen

Datenbankmanagementsystems um räumliche

Verbunde

Diplomarbeit im Rahmen des Studienganges

Mathematik mit Studienrichtung Informatik

vorgelegt von Oliver Schweer

Universität Hannover - Fachbereich Informatik

Institut für Informationssysteme

Fachgebiet Datenbanksysteme

Prüfer: Prof. Dr. U. Lipeck

Zweitprüfer: Prof. Dr. R. Parchmann

Hannover, 27. Juni 2003

Inhaltsverzeichnis

1 Einleitung

1

2 Verbunde in Datenbanken

2.1 Verbund ohne Index . . . . . . . . . . . . . . . . .

2.2 Indexe in Datenbanken . . . . . . . . . . . . . . . .

2.2.1 B*-Bäume . . . . . . . . . . . . . . . . . . .

2.2.2 Hash-Index . . . . . . . . . . . . . . . . . .

2.2.3 Bitmap-Listen . . . . . . . . . . . . . . . . .

2.2.4 Verallgemeinerte Zugriffspfadstruktur . . . .

2.3 Indexgestützter Verbund . . . . . . . . . . . . . . .

2.3.1 Verbundindexe . . . . . . . . . . . . . . . .

2.3.2 Verbunde in objektrelationalen Datenbanken

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

4

5

6

9

14

15

17

17

19

3 Spatial Join Algorithmen

3.1 indexed nested loops join . . . . . . . . . . . . . . . . . . . . .

3.2 R*-tree join . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.2.1 Aufbau eines R-Baumes . . . . . . . . . . . . . . . . .

3.2.2 Spatial Join . . . . . . . . . . . . . . . . . . . . . . . .

3.3 Seeded Trees . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3.1 Seeded Tree Konstruktion . . . . . . . . . . . . . . . .

3.4 Spatial Hash-Join . . . . . . . . . . . . . . . . . . . . . . . . .

3.4.1 Funktionsweise des Hash-Joins . . . . . . . . . . . . . .

3.4.2 Beispiele für Zuweisungs- und Ausdehnungsfunktionen

3.5 Z-Codes und Standard-Indexe . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

20

20

21

21

22

24

25

27

27

28

30

.

.

.

.

.

.

.

36

37

41

41

42

43

43

45

4 GiST-Indexe

4.1 Überblick über GiST . . . . . . . . . . . . . .

4.2 libgist der University of California at Berkeley

4.2.1 GiST-Erweiterungen . . . . . . . . . .

4.2.2 Funktionsübersicht . . . . . . . . . . .

4.2.3 Klassenübersicht . . . . . . . . . . . .

4.2.4 Suchbaumerweiterungen . . . . . . . .

4.2.5 Einschränkungen der libgist . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5 GiST Indexe für Oracle

5.1 Oracle - Extensible Indexing Interface . . . . . . . .

5.1.1 Methoden des Extensible Indexing Interface

5.2 OraGIST-Bibliothek . . . . . . . . . . . . . . . . .

5.2.1 Änderungen an der libgist . . . . . . . . . .

5.2.2 Struktur der Implementierung . . . . . . . .

5.2.3 Die Klasse OraGiST . . . . . . . . . . . . . .

5.3 Oracle - Pipelined Table Functions . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

47

47

48

50

50

51

52

54

6 Entwurf des Verbund-Algorithmus

6.1 Vorüberlegungen . . . . . . . . . . . . .

6.2 Verbundalgorithmen für GiST . . . . . .

6.2.1 Einfacher GiST-Verbund . . . . .

6.2.2 Zusätzliche Selektionen . . . . . .

6.2.3 Verbundalgorithmus für die libgist

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

57

57

58

59

60

60

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7 JoinGiST

7.1 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.2 Methoden der JoinGiST-Klassen . . . . . . . . . . . . . . . . .

7.2.1 JoinGiST parameters . . . . . . . . . . . . . . . . . . .

7.2.2 JoinGiST ext t . . . . . . . . . . . . . . . . . . . . . .

7.2.3 JoinGiST . . . . . . . . . . . . . . . . . . . . . . . . .

7.2.4 odci2join - Schnittstelle zwischen JoinGiST und Oracle

7.3 Einschränkungen . . . . . . . . . . . . . . . . . . . . . . . . .

7.3.1 Cursorerweiterung . . . . . . . . . . . . . . . . . . . .

7.3.2 Compiler . . . . . . . . . . . . . . . . . . . . . . . . . .

7.3.3 Speicherort der Indexdaten . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

63

63

64

64

66

67

69

70

70

70

71

8 Anwendung und Performance

8.1 Anwendung . . . . . . . . . . . . . . . .

8.1.1 Formulierung von Anfragen . . .

8.1.2 Weitere Verbunde . . . . . . . . .

8.2 Praktisches Beispiel mit Performance . .

8.3 Performance-Analyse . . . . . . . . . . .

8.4 Ausblick und Verbesserungsmöglichkeiten

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

72

72

72

73

73

75

75

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

A Beispiel einer OraGiST-Erweiterung

77

B Beispiel einer JoinGiST-Erweiterung

92

Kapitel 1

Einleitung

In objektrelationalen Datenbankmanagementsystemen (ORDBMS) besteht die Möglichkeit, komplexe Datenstrukturen mit zugehörigen Methoden zu verwalten. So ist es unter

anderem möglich, geographische Daten in den Tabellen einer Datenbank abzulegen und

verschiedene Operationen darauf anzuwenden. Eine dieser Operationen ist der räumliche Verbund (spatial join), wo die Objekte zweier Relationen mittels eines geeigneten

Operators verglichen werden und Paare dieser Objekte als Ergebnis geliefert werden.

Als Beispiel stelle man sich in einer Relation Straßen, in einer anderen Flüsse vor. Eine

Anfrage, die alle Straßen liefern soll, die sich mit Flüssen kreuzen, muss zunächst einen

räumlichen Verbund der beiden Tabellen bilden. Dabei benutzt man einen Operator,

der überprüft, ob sich zwei Objekte überschneiden (intersection). Man erhält also alle

Straßen, deren Verlauf von dem der Flüsse geschnitten wird.

Um nicht alle Objekte der einen Relation mit allen Objekten der anderen Relation

vergleichen zu müssen (nested loops join), ist es hilfreich die Daten vorher zu partitionieren. Wenn es gelingt, Objekte, die räumlich nahe beieinander liegen, zu gruppieren,

können während des Join-Prozesses große Datenmengen schon ausgeschlossen werden, da

sie sich nicht in räumlicher Nähe des gerade betrachteten Objektes befinden.

Da die Anwendung des Vergleichs-Operators auf die konkreten Objekte der Datensätze

vergleichsweise rechenintensiv sein kann, unterteilt man die Verarbeitung der Verbundberechnung üblicherweise in zwei Stufen: In einer ersten Filterstufe wird mit Hilfe der

zu den Relationen gehörenden Index-Daten eine Kandidaten-Liste erstellt, die Objektpaare enthält, welche als Verbundpaar in Betracht gezogen werden müssen. Da in den

Index-Daten meistens nicht die tatsächliche Geometrie eines Objektes, sondern nur eine

Approximation davon aufgenommen ist, kann diese Filterstufe den Verbund nicht komplett berechnen, sondern nur dazu beitragen, bestimmte Kombinationen auszuschließen.

Die zweite Filterstufe verwendet dann diese Kandidatenliste, um die Verbund-Operation

anhand der tatsächlichen Datenobjekte der Kandidaten durchzuführen.

Ziel dieser Arbeit ist es, eine Möglichkeit zu finden, das objektrelationale Datenbankmanagementsystem Oracle 9i um die Berechnung räumlicher Verbunde auf Basis

benutzerdefinierter Indexstrukturen zu erweitern. Dazu wird eine im Rahmen einer anderen Diplomarbeit entwickelte Indexunterstützung verwendet, die die Datenbank um

benutzerdefinierte Indexe in der Form verallgemeinerter Suchbäume erweitert.

2

Auf diese Indexerweiterung (OraGiST) aufbauend, wird daher eine Bibliothek JoinGiST entwickelt, die es erlaubt, eine Verbundberechnung mittels zweier in verallgemeinerten Suchbäumen gespeicherten Indexstrukturen auszuführen.

Gliederung der Arbeit

Kapitel 2 beschreibt zunächst, was unter einem Verbund zweier Tabellen zu verstehen

ist. Da hier die Indexunterstützung bei einem Verbund von besonderem Interesse ist,

werden dazu einige der in Datenbanken verwendeten Indexierungsstrategien vorgestellt

und erläutert, wie diese bei der Berechnung eines Verbundes hilfreich sein können.

Speziell die Verbundalgorithmen mit den zugehörigen Indexierungsstrategien für räumliche Daten werden in Kapitel 3 betrachtet.

Kapitel 4 beschäftigt sich mit verallgemeinerten Suchbäumen, die als universelle Baumarchitektur eine Vielzahl verschiedener zur Verwendung als Index geeigneter Baumtypen

unterstützt.

Das folgende Kapitel betrachtet die Verwendung dieser Bäume als benutzerdefinierte

Indexstrukturen in Verbindung mit der Oracle-Datenbank. Die vorgestellte Bibliothek

OraGiST dient dabei als Bindeglied zwischen einer C++ -Implementierung verallgemeinerter Suchbäume und der Oracle-Datenbank. Zudem werden einige Schnittstellen der

Datenbank betrachtet, die im Zusammenhang mit dieser Arbeit oder den benutzerdefinierten Indexstrukturen von Bedeutung sind.

Im sechsten Kapitel wird schließlich der Algorithmus vorgestellt, der in dieser Arbeit

verwendet werden soll, um zwei verallgemeinerte Suchbäume miteinander zu verbinden.

Die darauf aufbauende Bibliothek JoinGiST zur Verbundberechnung zweier OraGiSTObjekte wird in Kapitel 7 vorgestellt.

Das letzte Kapitel betrachtet die Anwendung dieser Bibliothek mit einigen Beispieldaten und betrachtet das Abschneiden des Verbundalgorithmus bei der tatsächlichen

Berechnung darauf aufbauender Verbunde.

Wie die dazu benötigten OraGiST-Spezialisierungen angelegt werden, wird dazu nochmal kurz im Anhang A skizziert. Anhang B beinhaltet das dazugehörige Beispiel zur

Erstellung einer Erweiterung zu JoinGiST, um zwei Bäume dieses Typs zu verbinden.

Kapitel 2

Verbunde in Datenbanken

Wesentliches Ziel beim Einsatz moderner relationaler und objektrelationer Datenbanken

ist, die Speicherung redundanter Daten zu vermeiden oder zumindest zu kontrollieren,

soweit dies zur Sicherstellung des Erhalts der Datensicherheit oder zur PerformanceSteigerung notwendig ist. Dazu wird die Möglichkeit genutzt, Daten auf mehrere Tabellen

zu verteilen, so dass gleiche Informationen nicht für jeden Datensatz erneut gespeichert

werden müssen, sondern nur einmalig in den entsprechenden Tabellen abgelegt werden.

Die Verbindung zwischen den Informationen wird ebenfalls über Tabellen gespeicherte

Relationen hergestellt (dabei kann es sich auch um eine weitere Spalte in einer der Datentabellen handeln).

Eine Aufgabe des Datenbankmanagementsystems ist es, den berechtigten Benutzern

den Zugriff auf die so verteilten Daten zu ermöglichen. Dazu ist es notwendig, für eine

Anfrage an die Datenbank die entsprechenden Einträge in den betroffenen Tabellen zu

lokalisieren und zur Ausgabe oder weiteren Verarbeitung zusammenzufügen.

In der Datenbank einer Firma können beispielsweise in einer Tabelle Departments

alle Informationen zu einer Abteilung und in der Tabelle Employees die Informationen

über die Angestellten gespeichert sein, insbesondere auch die Abteilungsnummer (deptnr ) der Abteilung, der ein Angestellter zugeteilt ist. Ein Personalbearbeiter kann dann

folgende SQL-Anfrage verwenden, um die Namen aller Angestellter mit den zugehörigen

Abteilungsnamen zu erhalten:

select EMPLOYEES.name, DEPARTMENTS.name from EMPLOYEES, DEPARTMENTS

where EMPLOYEES.deptnr = DEPARTMENTS.deptnr;

In der Relationenalgebra entspricht dies:

πe.name, d.name (EMPLOYEES e ./ DEPARTMENTS d)

e.deptnr=d.deptnr

Eine solche Anfrage stellt die Datenbank vor die Aufgabe, zu allen Datensätzen (Tupeln) in Employees diejenigen in Departments zu finden, deren Einträge in den jeweiligen

deptnr -Spalten gleich sind. Da bei dieser Anfrage die Inhalte mehrerer Tabellen verknüpft

werden müssen, spricht man von einem Verbund (engl.: join).

KAPITEL 2. VERBUNDE IN DATENBANKEN

4

Hier ist der Operator, der zum Vergleich beider der beiden Tabellen herangezogen

wird, der Gleichheitsoperator (EMPLOYEES.deptnr = DEPARTMENTS.deptnr ). Aus

diesem Grund kann man auch von einem Equiverbund sprechen. Es sind aber auch andere

Verbundoperatoren möglich.

Wie ein Datenbanksystem eine Verbundanfrage bearbeiten kann, möchte ich in den

folgenden Abschnitten kurz skizzieren, wobei sich die Beschreibung an [HR01] und [Li97]

orientiert.

2.1

Verbund ohne Index

Die Bearbeitung der an die Datenbank gestellten Anfrage ist möglich, indem zu jeder Spalte der Tabelle Employees die Departments-Tabelle jeweils komplett durchsucht (gescannt)

wird, wobei man diejenigen Paare, bei denen die Vergleichsoperation erfüllt ist, hier also

gleiche deptnr, der Ergebnismenge zufügt. Dieses Verfahren, alle Datensätze einer Tabelle

für jeden Datensatz einer anderen Tabelle zu überprüfen, nennt man direkter Verbund

(nested loops join), wobei in einer äußeren Schleife (loop) alle Tupel der einen Tabelle

gelesen werden, um sie dann in einer inneren, im Schleifenrumpf der äußeren Schleife

befindlichen (nested ) Schleife, mit den jede Runde neu zu lesenden Tupeln der anderen

Tabelle zu vergleichen. Handelt es sich um größere Tabellen, so ist dieses Verfahren ineffizient, denn die Anzahl der zu lesenden Einträge entspricht in etwa dem Produkt der

Tabellenmächtigkeit der beteiligten Tabellen.

Die Verarbeitungsgeschwindigkeit bei der Ausführung eines Gleichheits-Verbundes,

lässt sich steigern, wenn die Daten linear angeordnet werden können und entsprechend

der Ordnung sortiert gespeichert wurden. Gibt es in wenigstens einer Tabelle keine Duplikate in der betreffenden, sortierten Spalte, so ist ein Verbund durch Mischen (merge

sort) möglich. Dabei werden die beiden Tabellen sequenziell durchlaufen, wobei jeweils

die Sequenz mit dem kleineren Element weiterrückt. Die gefundenen Paare werden der

Ergebnismenge zugefügt. Beim Mischverbund braucht jedes Tupel nur einmalig gelesen

werden, weswegen die Anzahl der Lesevorgänge proportional der Summe der Tabellenmächtigkeiten ist. Für nicht duplikatfreie, sortierte Tabellen bildet man jeweils Gruppen

mit gleichen Attributen, die dann beim Verbund jeweils miteinander verglichen werden.

1

2

1

1

1

1

1

1

2

2

2

3

2

3

4

5

5

5

4

5

5

5

Abbildung 2.1: Verbund zweier sortierter Tabellen

KAPITEL 2. VERBUNDE IN DATENBANKEN

5

Zur Illustration der Vergleichspartner betrachte man Abbildung 2.1, wo jeweils das

erste Attribut der linken Tabelle auf Gleichheit mit dem zweiten Attribut der rechten

Tabelle geprüft werden soll. Der linke Verbund besitze dabei keine Duplikate beim ersten

Attribut, während beim rechten Verbund erst die grau unterlegten Gruppen gebildet

werden, um deren Elemente anschließend miteinander zu vergleichen.

Da eine Tabelle in der Regel nur nach einer Spalte sortiert werden kann, ist ein vorheriges Umsortieren nötig, bevor ein Mischverbund erstellt werden kann. Das Umsortieren

nimmt dann aber bei größeren Tabellen, im Vergleich zum eigentlichen Verbund, die meiste Zeit in Anspruch. (Bei einer Tabellenmächtigkeit von N ist der Zeitbedarf O(N log N ).)

Um Tabellen nicht vor jedem Verbund neu sortieren zu müssen, sind weitere Strukturen

nötig, um einen Verbund effizient zu unterstützen. Dies ist mit einem Index möglich, einer Struktur die bereits zur Unterstützung der Suche in einzelnen Tabellen Anwendung

findet.

2.2

Indexe in Datenbanken

Sollen in einer Tabelle nicht alle, sondern nur einzelne Datensätze lokalisiert werden,

so kann die Datenbank durch Erstellung von Indexstrukturen unterstützt werden. Diese

werden für die Spalten erstellt, afür die eine Selektion stattfinden soll, ein Index erstellt

wird. Um bestimmte Einträge zu finden, ist dadurch kein kompletter Scan einer Tabelle

mehr notwendig. Statt dessen kann die Datenbank bei der Auswahl eines Zugriffspfades

entscheiden, einen Index zu verwenden.

In einem Index sind zu Schlüssel, die aus den Werten in der indexierten Spalte generiert werden, zumeist Verweise auf die Speicherorte der entsprechenden Daten abgelegt

(z.B. als Tupel-ID oder RowID). Bei einer Selektion wird daher in einem deutlich weniger Speicherseiten belegendem Index nachgesehen, welche Tupel als Ergebnis in Frage

kommen. Speicherzugriffe auf externen Speicher sind vergleichsweise zeitraubend. Somit

lohnt sich der zusätzliche Verwaltungsaufwand mit einer solchen Zugriffsstruktur besonders, wenn häufig Anfragen gestellt werden, die nur einen kleinen Teil des Datenbestandes

einer Tabelle selektieren. Dadurch braucht zusätzlich zu den Indexdaten möglicherweise

nur ein Bruchteil des eigentlichen Datenbestandes geladen werden.

Da Datenbanken die Tupel üblicherweise zu Seiten gruppiert im externen Speicher ablegen, sollte die Ergebnismenge des Index-Scans vor dem eigentlichen Datenzugriff nach

den Speicherseiten der referenzierten Speicherseiten sortiert werden. Sonst kann ein kompletter Scan der gesamten Tabelle schon bei mittlerer Selektivität einer Anfrage effizienter

sein als ein Indexscan, da der mögliche Geschwindigkeitsvorteil des indexgestützten Zugriffes durch die zur Auffindung der entsprechenden Seiten auf externen Speichermedien

benötigte Zeit bei wahlfreiem Zugriff zunichte gemacht wird, wenn beim einzelnen Aufsuchen der Tupel die Speicherseiten mehrfach gelesen werden müssen.

Statt Referenzen auf die Datensätze im Index abzulegen, ist es auch denkbar, weitere Kopien der Attribute abzuspeichern. Solche Indexe haben Vorteile bei aggregierenden

Funktionen (wie sum(GEHALT)), da die betreffenden Daten nicht erst in den Speicherseiten der Datensätze gesucht werden müssen, sondern direkt mittels des Indexes ausge-

KAPITEL 2. VERBUNDE IN DATENBANKEN

6

wertet werden können.

Bei den Zugriffstrukturen unterscheidet man, ob sie für die Indexierung von Primärschlüsseln oder Sekundärschlüsseln ausgelegt sind. Bei Primärschlüsseln ist der Suchschlüssel einmalig, so dass eine Suche auf höchstens einen Satz führt. Zugriffspfade für

Sekundärschlüssel, auch sekundäre Zugriffspfade genannt, können dagegen mehrere Datensätze als Ergebnis liefern. Die bei sekundären Zugriffspfaden verwendeten Strukturen

kann man in Einstiegsstruktur und Verknüpfungsstruktur aufteilen. Als Einstiegsstruktur sind alle Strukturen möglich, die auch bei Primärschlüsseln verwendet werden. Statt

zum Schlüssel eine RowID abzuspeichern, wird dann aber die Verknüpfungsstruktur oder

eine Referenz darauf im Index abgelegt. Typischerweise verwendet man als Verknüpfungsstruktur eine Liste von RowIDs. Statt einer einzelnen Referenz auf einen Tupel erhält man

bei einer erfolgreichen Suche diese Liste und damit gleich alle Referenzen auf Tupel, die

im Index den gleichen Schlüssel besitzen. Ein Schlüssel wird dabei nur einmal im Index

abgelegt, kommen ein weiterer Eintrag mit gleichem Schlüssel hinzu, wird lediglich die

Verknüpfungsstruktur um ein Element erweitert.

Alternativ wäre es auch möglich, die Einträge mehrfach mit gleichem Schlüssel im

Index abzulegen, wenn man dies bei der Suche entsprechend berücksichtigt. Dadurch

werden die Schlüssel zwar redundant gespeichert, man spart sich aber ein aufwendiges

Listenmanagement für die Verknüpfungsstruktur, weswegen dieses Verfahren in der folgenden Vorstellung einiger Indexstrukturen gelegentlich verwendet wird.

Als Indexstrukturen kommen vor allem die sogenannten Mehrwegbäume (und dabei

besonders B*-Bäume) in Frage, die in einem Knoten mehrere Verzweigungsmöglichkeiten besitzen. Binäre Suchbäume werden in Datenbanken selten eingesetzt, da sie überlicherweise auf Anwendungen, die im Hauptspeicher ablaufen, ausgerichtet, aber nicht

auf seitenbasierte Verarbeitung ausgelegt sind. Für einige Anwendungsfälle können HashVerfahren und Bitmap-Listen eingesetzt werden.

2.2.1

B*-Bäume

B*-Bäume gehören zu den hohlen“ oder blattorientierten Bäumen, denn die eigentlichen

”

Informationen befinden sich ausschließlich in den Blattknoten. Die Knoten haben feste

Größen, die sich üblicherweise an den Blockgrößen eines Speichertransfers zu einem externen Speichermedium orientieren (also z.B. 4kB). Die inneren Knoten beinhalten lediglich

Referenzschlüssel, die als Wegweiser bei der Suche nach den richtigen Blättern verwendet

werden. Wesentliche Kriterien eines B*-Baumes sind:

• Alle Blätter sind gleich weit von der Wurzel entfernt

• Interne Knoten beinhalten zwischen k und 2k Schlüssel

• Blätter haben zwischen j und 2j Einträge

• Die Wurzel nimmt eine Sonderstellung ein: Sie hat mindestens 2 Nachfolger oder

ist ein Blatt. Als Blatt kann sie auch weniger als j Einträge besitzen.

KAPITEL 2. VERBUNDE IN DATENBANKEN

7

Die Parameter k und j richten sich nach dem Speicherbedarf der in den Knoten gespeicherten Informationen und sagen im Wesentlichen aus, dass ein Knoten höchstens voll

und mindestens halbvoll sein muss.

Es ergeben sich zwei verschiedene Knotenformate: Interne Knoten enthalten Schlüssel

und Zeiger auf Nachfolgeseiten, Blätter Schlüssel Si und die dazugehörenden Datenelemente Di (Zeiger oder Zeigerlisten auf Datensätze). Die Informationen aller Knoten werden nach den Schlüsseln sortiert abgespeichert. Zur Suche nach Schlüsselbereichen (und

zur Restrukturierung des Baumes) ist es hilfreich, die Knoten nicht nur von der Wurzel

zu den Blättern zu verlinken, sonden zusätzliche Zeiger auf den linken und rechten Nachbarknoten vorzusehen. In Abbildung 2.2 sind die beiden Knotentypen dargestellt. Dabei

muss die aktuelle Anzahl der in internen Blättern gespeicherten Schlüssel x zwischen k

und 2k liegen (für Blätter: j ≤ y ≤ 2j). Man beachte auch, dass die internen Knoten auf

einen Nachfolgeknoten mehr verweisen, als Schlüssel darin gespeichert sind.

interne Knoten

Blattknoten

S1

S2

..........

Sx−1

Sx

freier Platz

S1 D1 S2 D2 .......... Sy−1 Dy−1 Sy Dy freier Platz

Abbildung 2.2: Möglicher Knotenaufbau eines B*-Baumes

Aus den eingeschränkten Verzweigungsgraden (j, k) der beiden Knotentypen des Baumes resultiert, dass sich die Baumhöhe nur in gewissen Grenzen bewegen kann. Für N

N

Datenelement bewegt sich die Baumhöhe h für h ≥ 2 zwischen 1 + log2k+1 ( 2j

) (alle KnoN

ten maximal gefüllt) und 2 + logk+1 ( 2j ) (minimal gefüllte Knoten, die Wurzel hat nur 2

Nachfolger).

Die Baumhöhe entspricht aber gerade der Anzahl der zu lesenden Seiten bei einer

Suche nach einem einzelnen Schlüssel. Damit lässt sich der Zeitaufwand zur Suche eines Schlüssels abschätzen. Zur Optimierung der Suche ist die Reduzierung der Höhe am

geeignetsten, denn dies ist der dominierende Faktor bei der Zugriffszeit. Grundgedanke

ist dabei die Verbreiterung des Baumes, was durch Erhöhung der Anzahl der in internen

Knoten gespeicherten Zeiger möglich ist. Dies kann bei gleicher Seitengröße geschehen,

indem die Schlüssellänge verkürzt wird. Bei gewissen Datentypen (z.B. Zeichenketten)

kann dies sehr leicht durch Kompressionsverfahren geschehen, da die internen Schlüssel

nur Wegweiserfunktion haben. (Bei Strings beispielsweise: Speicherung nur des Präfixs

oder Speicherung nur der Zeichen, in denen sich der Schlüssel vom Vorgänger und Nachfolger unterscheidet.)

Zur Suche im Baum vergleicht man den Suchschlüssel mit den in internen Knoten gespeicherten Referenzschlüsseln, bis man den ersten größeren oder gleichen gefunden hat.

Die Suche wird dann mit dem Teilbaum, der durch den links neben dem Referenzschlüssel liegenden Zeiger verlinkt ist, fortgesetzt, bzw. mit dem Zeiger ganz rechts, falls alle

Referenzschlüssel kleiner sind. Erreicht man die Blattebene, so sucht man, bis man den

passenden Schlüssel gefunden hat.

KAPITEL 2. VERBUNDE IN DATENBANKEN

8

Da die Einträge auf Blattebene ebenfalls sortiert vorliegen, hat man alle Einträge

gefunden, sobald ein größerer Schlüssel als der Suchschlüssel beim sequentiellen Durchsuchen der Schlüssel auftritt. Passiert dies nicht, so wird die Suche in den rechten Nachbarknoten fortgesetzt. Zeiger auf die Nachbarknoten erleichtern dies. Im B*-Baum ist nicht

nur eine Suche auf Gleichheit möglich, sondern auch auf einen Wertebereich sehr einfach.

Die Suche beginnt mit der linken Intervallgrenze als Suchschlüssel. Auf der Blattebene

werden dann alle Einträge bis zur rechten Grenze geliefert. Soll die Sortierreihenfolge

umgedreht werden, so nimmt man die obere Intervallgrenze, wobei man evtl. den rechts

neben den Referenzschlüsseln liegenden Zeiger verfolgt. Auf der Blattebene wird dann der

Verweis auf den linken Nachbarknoten ausgenutzt, und ab dort jeweils von rechts nach

links bis zur unteren Intervallgrenze gesucht.

Die Einfüge- oder Löschoperationen funktionieren sehr einfach, solange dadurch die

Einschränkungen der Knotenbelegung nicht verletzt werden. (An der richtigen Position einfügen, bzw. löschen und die sonstigen Einträge entsprechend aufrücken.) Im Falle

einer Unter- oder Überfüllung werden Algorithmen zur dynamischen Restrukturierung

eingesetzt. Dazu wird ein voller Knoten entweder auf die Nachbarknoten verteilt (die mit

Zeigern auf die Nachbarknoten der gleichen Ebene leicht zu finden sind) oder man spaltet

einen Knoten in zwei neue, halb so große Knoten auf. Der linke Knoten wird anstelle des

ursprünglichen Knotens im Vorgängerknoten verlinkt (der Referenzschlüssel links daneben muss evtl. geändert werden), der rechte muss rechts daneben mit einem neuen Zeiger

und entsprechendem Referenzschlüssel in den Vorgängerknoten eingesetzt werden. Die

Referenzschlüssel, die immer zwischen zwei Zeigern und damit Teilbäumen stehen, müssen immer genau so gewählt werden, dass alle Blätter im linken Teilbaum kleiner-gleich

und im rechten größer-gleich sind. Sie können damit aus dem linkesten Blatt des rechten

Teilbaumes generiert werden. Das Aufsplitten kann sich bis zur Wurzel fortsetzen, falls

keine Einträge auf Nachbarknoten verteilt werden können. Wird die Wurzel aufgeteilt, so

erhält der Baum eine neue Wurzel mit den beiden beim Aufteilen enstandenen Knoten

als Nachfolger.

Bei einer Unterfüllung kann man versuchen, sich zunächst Einträge aus Nachbarknoten

zu leihen, ansonsten müssen zwei Knoten zusammengefasst werden. Dies löst wiederum

ein Entfernen von Referenzschlüssel und Zeigern aus den Vorgängerknoten aus, was sich

bis zur Wurzel forsetzen kann. Wurzeln mit nur noch einem Nachfolger werden gelöscht,

und der alte Nachfolger als neue Wurzel verwendet.

Abschließend betrachte man noch als Beispiel den B*-Baum in Abbildung 2.3, wo ein

Element mit Schlüssel p“ eingesetzt werden soll. Zur Vereinfachung ist in den Blättern

”

nur die Schlüsselkomponente dargestellt und die Blätter fassen lediglich einen Eintrag.

Die internen Knoten haben bei zwei Referenzschlüsseln Platz für 3 Nachfolgeknoten.

Zuerst wird der Knoten gesucht, in den p eingesetzt werden muss. Dies ist das Blatt

1 (auf der vorletzten Ebene ist im Knoten 2 der Schlüssel q“ der erste größer-gleich p“,

”

”

der linke Zeiger führt zu 1). Das Blatt fasst (hier) nur einen Eintrag, deswegen wird es

geteilt und das Blatt mit p“ erzeugt. Der linke Knoten ist Blatt 1a, er bleibt in 2 verlinkt.

”

Das neue Blatt 1b muss rechts von o“ eingefügt werden, mit Schlüssel p“. In 2 ist nicht

”

”

genug Platz für einen neuen Eintrag, deswegen muss wieder geteilt werden. Die Knoten

KAPITEL 2. VERBUNDE IN DATENBANKEN

9

j t

3

e

4

n r

x

2

c c

f

a c c

l m

o q

r s

j l m 1

r r s

e f

n o q

v

y z

x y z

t v

j r

n p

e

t x

2a

c c

f

a c c

l m

2b

q

o

j l m

e f

r s

v

r r s

n o

p q

y z

x y z

t v

1a 1b

Abbildung 2.3: Aufteilung von Knoten beim Einsetzen in einen B*-Baum

2a und 2b entstehen und müssen in 3 eingetragen werden. Eigentlich müsste Knoten 3

geteilt werden, da aber in Knoten 4 noch Platz ist, kann ein Eintrag verschoben werden.

Dies bewirkt auch, dass der Referenzschlüssel r“ in die Wurzel wandert, und t“ als neuer

”

”

Schlüssel in Knoten 4, denn r“ ist jetzt das linkeste Blatt des ganz rechten Teilbaumes

”

in der Wurzel. In 3 ist jetzt Platz, um den Knoten 2b einzutragen, dessen linkestes Blatt

p“ ist.

”

2.2.2

Hash-Index

Hash-Indexe verwenden Schlüsseltransformations-Verfahren zur Auffindung der Indexinformationen. Die Speicheradresse des Indexeintrages eines Datensatzes wird durch eine

geeignete Hash-Funktion direkt aus dem Suchschlüssel berechnet. Im Idealfall wird keine weitere Hilfsstruktur benötigt, um dadurch den Datensatz aufzufinden. Die Aufgabe

der Hashfunktion besteht darin, allen möglichen Werten des Schlüsselraumes einen Wert

des Adressraumes zuzuweisen. Für die bei Datenbankanwendungen interessanten HashVerfahren, die auf Externspeicher auf Seitenbasis ausgelegt sind, entspricht der Adressraum einer Seitennummer, in der möglichst alle Indexeinträge mit demselben Hash-Wert

untergebracht werden.

Da üblicherweise nicht alle der möglichen Schlüssel gerade verwendet werden, ist es

in der Regel nicht möglich, eine Hashfunktion zu finden, die eine kollisionsfreie Satzzuordnung ermöglicht, ohne extreme Speicherplatzverschwendung in Kauf zu nehmen.

Deswegen nimmt man hin, dass zu verschiedenen Schlüsseln die gleiche Adresse berech-

KAPITEL 2. VERBUNDE IN DATENBANKEN

10

net wird. Diese Speicher- oder Segment-Adresse bezeichnet eine Seite fester Größe des

externen Speichers, auch Bucket (Eimer, Korb) genannt, in dem mehrere Datenelemente

Platz finden können, ohne eine Kollision auszulösen.

Zahlreiche Hash-Verfahren wurden im Laufe der Zeit entwickelt, die eine gleichmäßige

Ausnutzung des zur Verfügung stehenden Adressbereiches erstreben. Einige davon sind:

Restklassenbildung: (Divisionsrestverfahren) Die Speicherdarstellung des Schlüssels

wird als ganze Zahl s interpretiert. Mit einer Hash-Funktion h(s) = s mod n

wird daraus eine Restklasse berechnet, die eine Speicheradresse des Adressraumes

der Mächtigkeit n ergibt. Mit der Wahl der Bucket-Anzahl wird dabei wesentlich

die Gleichverteilung der Schlüssel beeinflusst. Empfehlenswert sind Primzahlen, die

nicht benachbart zu Potenzen des vom Rechner verwendeten Zahlensystems liegen

sollten, da sich sonst bei gleichen Endziffern ähnliche Adressmengen in verschiedenen Zahlenbereichen wiederholen.

Dieses Verfahren wird insbesondere bei nicht bekannter Schlüsselverteilung empfohlen.

Faltung: Der in einzelne Bestandteile zerlegte Schlüssel wird durch Spiegelungen oder

Verschiebeoperationen überlappend übereinandergelegt. Durch Addition, Multiplikation oder Boolsche Verknüpfung erhält man einen Hash-Wert, der nur noch an

den verfügbaren Adressraum angepasst werden muss.

Dieses Verfahren kann gut in Kombination mit der Restklassenbildung eingesetzt

werden, um eine noch bessere Gleichverteilung zu erreichen.

Multiplikationsverfahren: Der Schlüssel wird mit einer Konstanten multipliziert oder

mit potenziert. Aus der sich ergebenden Zahl wählt man eine von der Größe des

Adressraumes abhängige Anzahl von Bits aus, die dann den Hash-Wert, also die

Adresse bilden.

Zufallsgenerator: Ein an den zur Verfügung stehenden Adressraum angepasster PseudoZufallszahlengenerator wird mit dem Schlüssel als Saat“ aufgerufen. Sollte eine

”

Kollisionsbehandlung notwendig sein, so kann mit einem weiteren Aufruf des Generators (reproduzierbar) eine ganze Folge von weiteren Adressen berechnet werden.

Ziffernanalyse: Ist die Menge der zu speichernden Schlüssel vorab bekannt, so kann

diese Menge untersucht werden, um eine Verteilungsschiefe bei ungünstiger Parameterwahl (z.B. der zu verwendenden Bits) rechtzeitig zu erkennen und zu beheben.

Dieses Verfahren ist sehr aufwendig, gewährleistet aber eine gute Gleichverteilung.

Leider sind in produktiven Umgebungen die Schlüssel üblicherweise nicht a priori bekannt, weswegen das Verfahren praktisch nur für statische Daten angewendet

werden kann.

Da es bei festgelegter Anzahl von Adressen im Laufe des Datenbankbetriebes zu Kollisionen, also vollen Index-Speicherseiten, kommen kann, ist eine Kollisions- oder Überlaufbehandlung notwendig, wenn weitere Schlüssel indexiert werden sollen. Bei der Suche

im Index sind evtl. vorhandene Überlaufbereiche entsprechend mit einzubeziehen.

KAPITEL 2. VERBUNDE IN DATENBANKEN

11

Tritt eine Kollision auf, so kann diese aufgelöst werden, indem ein Speicherplatz innerhalb einer anderen Seite des ursprünglich Adressraumes (des Primärbereiches) gesucht

wird oder es wird eine weitere Speicherseite im sogenannten Überlaufbereich erstellt.

Möchte man nur den Primärbereich verwenden, so ist die Aufnahmefähigkeit des Indexes

durch die bei der Indexerstellung vorgegebene Seitenzahl begrenzt. Gibt es ein Kollision,

so verwendet man den Korb mit der nächsten relativen Seitennummer, erstellt eine Verkettung der Seiten oder benutzt eine weitere Hash-Funktion (oder einen weiteren Aufruf

der Hash-Funktion) zur Berechnung des Ablageplatzes. Durch Clusterbildung kann es bei

hohem Belegungsfaktor (≥ 80%) verstärkt zu Mehrfachkollisionen kommen. Zusätzlich

ist das Löschen erschwert, da die Kollisionen dann wieder aufgelöst werden müssen, bzw.

man Löschvermerke und spätere Reorganisation benötigt. Daher empfiehlt es sich einen

separaten Überlaufbereich einzurichten. Dort können neue Speicherseiten angelegt werden, die durch Verkettung mit dem Primärbereich erreichbar sind. Dadurch erhöht sich die

Anzahl der zu einem Hash-Wert speicherbaren Einträge dynamisch, jeweils um die Größe

eines Korbes. Auch wenn die doppelte Kapazität des Primärbereiches gespeichert werden

muss, kann die Anzahl der durchschnittlich benötigten Seitenzugriffe üblicherweise < 2

gehalten werden.

Als Beispiel für einen Hash-Index mit verkettetem Überlaufbereich betrachte man

Abbildung 2.4, wo die Hashfunktion aus einer Faltung mit anschließendem Divisionsrestverfahren besteht.

Ein Datenelement, dessen zugehöriger Schlüssel binär die Folge 1001011010101100

besitzt, soll neu in den Index aufgenommen werden. Dazu wird der Schlüssel in ein höherwertiges und niederwertiges Byte aufgeteilt, und die beiden Teile mit einer bitweisen

XOR-Operation (⊕) verknüpft. Die sich ergebende Zahl hat dezimal den Wert 58. Da

fünf Buckets vorgesehen sind, wird mit dem Divisionsrestverfahren eine Korb-Nummer

berechnet, wobei als Modul 5 verwendet wird. Der berechnete Bucket (3) ist schon voll,

so dass in den Überlaufbereich ausgewichen werden muss. Dieser ist über Verkettung

der zusätzlich benötigten Seiten an den Primärbereich angeschlossen. Dort ist noch für

zwei Elemente Platz, so dass ein Eintrag ohne weitere Kollision an der dritten Position

vorgenommen werden kann.

Ist die Indexgröße bekannt, so kann mit einem Verfahren, das nach dem Prinzip des

Open Adressing arbeitet, ein Index erstellt werden, der mit genau einem Externspeichzugriff einen gesuchten Indexeintrag findet. Die Belegung sollte dabei aber dennoch nicht

über etwa 80% steigen, denn sonst kann die Zugriffseigenschaft nicht mehr garantiert

werden. Als zusätzliche Datenstruktur wird eine sogenannte Separatortabelle ständig im

Hauptspeicher gehalten, die etwa ein Byte pro Bucket benötigt.

Zunächst erfolgt die Beschreibung der Suche: Zu jedem Schlüssel wird nicht nur ein

Hash-Wert, sondern gleich ein ganzer Vektor von möglichen Adressen berechnet, z.B. mit

einem Pseudozufallsgenerator, der den Schlüssel als Saat verwendet. Zusätzlich wird mit

einer weiteren Funktion eine Signatur für jeden Schlüssel berechnet. Die Separatortabelle

enthält für jeden Bucket einen Eintrag, der bestimmt, bis zu welcher Signatur Einträge auf

der entsprechenden Speicherseite gemacht werden. Zur Bestimmung der Speicherseite auf

dem externen Speicher werden die Werte des Hash-Vektors nacheinander durchgegangen

KAPITEL 2. VERBUNDE IN DATENBANKEN

Primärbereich

0 S1

D1

D2

D3

1 S1

D1

D2

D3

D4

2 S1

D1

D2

D3

D4

S2

S3

S2

S3

S4

S2

S3

S4

3 S1

S2

S3

S4

4 S1

S2

D1

D2

D3

D4

12

Überlaufbereich

S1

S2

S3

S4

D1

D2

D3

D4

S1

D1

Schlüssel: 1001011010101100

10010110

00111010

S1

S2

S3

D1

D2

D3

001110102 = 5810 mod 5

3

D1

D2

Abbildung 2.4: Hash-Index mit separatem Überlauf und verketteten Buckets

(sondiert), wobei jeweils der Eintrag in der Separatortabelle mit der Signatur verglichen

wird. Ist die Signatur kleiner als der Eintrag in der Tabelle, so befindet sich der Datensatz

in dem entsprechenden Bucket (oder existiert nicht), ansonsten muss der Eintrag des

nächsten Vektor-Elements überprüft werden.

Soll ein neuer Eintrag eingefügt werden, so wird ebenfalls ein Hash-Vektor und eine

Signatur für den zugehörigen Schlüssel berechnet. Wie bei der Suche wird die Signatur

entsprechend dem Hash-Vektor mit den in Frage kommenden Buckets bzw. ihren Einträgen in der Separatortabelle verglichen. Der erste Bucket, wo die Signatur kleiner als der

Eintrag in der Separatortabelle ist, kommt damit in Frage. Ist dort noch genügend Platz,

so kann der Eintrag vorgenommen werden. Ist dies nicht der Fall, so wird der Eintrag des

Buckets in der Separatortabelle verkleinert, bis dadurch wenigstens ein Platz im Bucket

frei wird. (Bei leerer Tabelle und damit bis zum ersten Überlauf, steht der Eintrag in der

Separatortabelle auf dem maximalen Wert.) Dies bedeutet, dass diejenigen Einträge, die

durch den jetzt niedrigeren Separator-Eintrag nicht mehr in diesem Bucket bleiben dürfen

und entsprechend ihres Hash-Vektors in andere Körbe eingetragen werden müssen. Damit

sich dies nicht unendlich fortsetzt, ist es sehr wichtig, dass der Füllgrad des Indexes klein

genug bleibt (als Richtwert: < 80%), sonst explodieren“ die Einfügekosten. Da es beim

”

Löschen von Einträgen äußerst schwierig ist, die Einträge zu finden, die bereits den Korb

wechseln mussten, ist ein Erhöhen der Einträge in der Separatortabelle nicht vorgese-

KAPITEL 2. VERBUNDE IN DATENBANKEN

13

hen, denn ohne die Schlüssel ist auch der Hash-Vektor nicht bekannt Stattdessen müsste

der Index komplett neu aufgebaut werden, wenn die Einträge in der Separatortabelle zu

niedrig werden.

Die bisher beschriebenen Verfahren verwenden eine feste Anzahl Buckets, weswegen sie

zu den statischen Hash-Verfahren zählen. Daneben gibt es die dynamische Verfahren, bei

denen man versucht, die Bucket-Anzahl an den Speicherbedarf anzupassen. Dabei wird bei

einem Überlauf“ die Anzahl der Buckets so erhöht, dass weitere Einträge beim Einfügen

”

bereits durch die Hash-Funktion richtig aufgeteilt werden können. Ein Verfahren, dass

einen Index für die Buckets verwendet, möchte ich dazu kurz skizzieren:

Statt den Wert der Hash-Funktion, zum Beispiel durch das Restklassenverfahren,

an die vorgegebene Anzahl an Körben anzupassen, wird der dabei berechnete PseudoSchlüssel zunächst nicht weiter transformiert. Stattdessen wird damit ein Blatt eines

Digitalbaum gesucht, welches den entsprechenden Korb darstellt. Die Kanten des Digitaloder Radix-Baumes sind jeweils mit einem Teil (ein oder bei größerem Verzweigungsgrad

entsprechend mehrere Bits) der Schlüssel des Bit-Strings markiert, die im Blatt am Ende

des Weges durch den Baum zu finden sind. Droht beim Einsetzen ein Überlauf, so wird

der Baum an der entsprechenden Stelle weiter aufgeteilt. In Abbildung 2.5 kann man

beispielsweise sehen, wie dies beim Einsetzen des Schlüssels mit Hash-Wert 11010 gleich

zum mehrfachen Aufteilen des Buckets mit dem Präfix 1 führt. Es entstehen zunächst

Buckets, die die Pseudoschlüssel, die mit 10 und 11 beginnen, aufnehmen würden. Da es

aber keinen zu speichernden Hash-Wert gibt, der mit 10 beginnt, landen alle Einträge im

rechten Teilbaum. Dieser wird abermals aufgeteilt in zwei Körbe für die Pseudo-Schlüssel,

die mit 110 respektive 111 beginnen.

0

0

1

0

1

00010

00101

00110

00110

01000

01101

01100

01110

00*

01*

0

11001

11101

11111

11110

1*

1

1

0

1

0

00010

00101

00110

00110

01000

01101

01100

01110

00*

01*

1

10*

11001

11010

11101

11111

11110

110*

111*

Abbildung 2.5: Hash-Index mit Digitalbaum als Index

Zur leichteren Veranschaulichung sind in der Abbildung die Hash-Werte, d.h. Pseudoschlüssel, in den Blättern eingetragen. Tatsächlich würde man dort wie immer die

eigentlichen Schlüssel und zugehörigen Datenelemente abspeichern.

Das Löschen von Einträgen ist problemlos möglich. Gemeinsam an einem Knoten angehängte Blätter können dabei problemlos wieder zusammengefügt werden, falls dabei

KAPITEL 2. VERBUNDE IN DATENBANKEN

14

genügend freie Positionen entstehen. In Abbildung 2.5 reicht beispielsweise das Löschen

eines Eintrages in den Blättern mit Präfix 110 oder 111, um die Blätter wieder zusammenfügen zu können (dann auch gleich mit dem leeren Knoten). Problematisch ist, dass

der Baum nicht ausbalanciert wird. Wird er durch zu viele gleiche Pseudoschlüssel bis

zur vollen Länge der Bit-Strings erweitert, so muss eine andere Kollisionsbehandlung

verwendet werden.

Anzumerken ist noch, dass mit Hash-Indexen zwar Indexstrukturen realisierbar sind,

die mit nur einem externen Speicherzugriff auskommen können, um einen Indexeintrag

zu lokalisieren, aber im Allgemeinen geht dabei die Ordnung der Einträge verloren. Bereichsanfragen sind deshalb nicht ohne weiteres zu realisieren.

2.2.3

Bitmap-Listen

Bitmap-Listen oder Bitmap-Indexe sind besonders gut zur Indexierung von Attributen geeignet, die sehr viele gleiche Schlüssel besitzen. Die Idee besteht darin, zu jedem Schlüssel

einen Bit-String zu speichern. Die einzelnen Bitpositionen dieses Bit-Strings korrespondieren wiederum mit einzelnen Datensätzen (oder Speicherseiten, die qualifizierte Datensätze

enthalten). Problematisch bei der Indexierung einzelner Sätze in den Seiten ist, dass in

modernen Datenbanken die Satzlänge meist variabel ist (z.B. bei Zeichenketten). In den

Bitlisten müssen dann evtl. sehr viele ungenutzte Bits bereitgehalten werden, wenn lange

Einträge eine Seite füllen, also nicht die maximale Anzahl von Einträgen in der Seite ausgenutzt wird, oder die maximale Anzahl in einer Seite speicherbarer Einträge wird auf die

vorgesehene Anzahl Bitpositionen in der Bitliste begrenzt, was bei sehr vielen kleinen Einträge zu ungenutzten Speicherseiten führt. Ein Ausweg bietet die zusätzliche Einrichtung

einer Zuordnungstabelle, die auch bei bestimmten Satzaddressierungstechniken eingesetzt

wird. Eine Bitposition entspricht dann einem Eintrag in der Zuordnungstabelle, die zur

Bestimmung der Seite eines Datensatzes herangezogen wird.

Die Vorteile von Bitmap-Listen bestehen in geringerem Speicherplatzverbrauch, falls

nur wenige verschiedene Schlüssel vorhanden sind. Statt Zeiger auf jeden Datensatz (oder

jede Seite) in einem Mehrwegbaum zu speichern, die meist jeweils mehrere Byte beanspruchen, reicht hier ein einzelnes Bit, um einen Eintrag anzuzeigen.

Beispielsweise betrachte man Abbildung 2.6, wo die einzelnen Bit-Listen für die untereinander angeordneten Schlüssel eine Matrix ergeben. Im Beispiel soll der Index auf

Speicherseiten verweisen, daher können mehrere Schlüssel in einer Seite vorkommen (mehrere 1en in einer Spalte). In einer Spalte steht genau dann eine 1, wenn der zu der Zeile

gehörende Schlüssel in der entsprechenden Seite vorhanden ist. Schlüssel wie S2 , die auf

fast allen Seiten vorhanden sind, benötigen nur einen relativ kurzen Bit-String, statt über

20 Einträge in einem Mehrwegbaum bzw. der Verknüpfungsstruktur eines sekundären Zugriffspfades.

Sucht man Tupel, die im indexierten Attribut die Schlüssel S1 oder S2 besitzen, so ist

dies mit einer OR-Verknüpfung der Bit-Strings zu ermitteln, Sind mehrere Attribute einer

Relation mit einem Bitmap-Index indexiert, können auch Bit-Strings der verschiedenen

Indexe bei Anfragen wie

KAPITEL 2. VERBUNDE IN DATENBANKEN

15

111 111 1 1 1 12 2 22 222 222

01 23 456 789 012 345 678 901 23 456 789 Seiten−Nr.

S 1 00 00 100 000 000 000 110 0 01 00 001 000

S 2 11 11 100 111 010 101 110 111 11 101 010

S 3 00 11 011 000 101 000 000 011 11 000 101

S 4 01 10 000 100 000 010 000 000 00 010 100

S 5 10 01 101 000 000 101 011 010 11 100 001

S 6 00 00 000 010 000 000 000 000 00 000 000

Schlüssel

Abbildung 2.6: Bitmap-Index: Schlüssel mit Bit-Strings als Bitmatrix dargestellt

select * from JEANS

where COLOR = ’RED’ and SIZE = ’L’;

miteinander verknüpft werden. Eine effiziente Hardwareunterstützung ist dabei möglich,

denn mengenalgebraische Operationen (AND, OR, NOT) lassen sich in modernen Prozessoren

oft schon mit einer Wortlänge von 64 Bit oder mehr parallel verarbeiten: Die Bitlisten

können dadurch schnell stückweise miteinander verknüpft werden.

Negativ auf den Speicherplatzbedarf und damit auch auf die Performance wirken sich

viele Einträge aus, die nur auf wenigen (oder sogar nur einer) Seite vorhanden sind. Denn

im Prinzip speichert man in der Bit-Liste nicht nur die Anwesenheit eines Attributes

in einem Datensatz (Bit gesetzt), sondern mit einem ungesetzten Bit auch dessen Abwesenheit ab. Sollten in Abbildung 2.6 viele Schlüssel wie S6 vorkommen, so wäre ein

Mehrwegbaum möglicherweise die geeignetere Indexstruktur. Für Primärschlüssel ist ein

Bitmap-Index ungeeignet, da jeder Schlüssel nur genau einmal vorkommt.

Dem Speicherplatzbedarf bei zunehmender Anzahl von Schlüsseln kann man in gewissen Grenzen entgegentreten, wenn man die Bit-Strings durch den Einsatz von Komprimierungstechniken effizienter speichert. So bietet es sich an, lange Null- oder Eins-Folgen,

oder häufig vorkommende Bitmuster durch bestimmte Codes zu kodieren. In Frage kommen praktisch alle verlustlos komprimierenden Verfahren, wie Bitfolgen-Komprimierung

(run length compression), besondere Codes für Nullfolgen und Bitmuster, Huffman-Codes,

Block-Kompression mit einem zusätzlichen Dicrectory, etc.

2.2.4

Verallgemeinerte Zugriffspfadstruktur

Bisher wurden Verfahren beschrieben, wo sich die Indexierung auf genau ein Attribut

genau einer Tabelle bezog. Daher ist es naheliegend, für jeden Index eine eigene Datenstruktur (z.B. einen B*-Baum) aufzubauen, denn dabei werden die Daten üblicherweise

auch nahe beieinander auf dem externen Speicher abgelegt.

Einen etwas anderen Ansatz verfolgt man bei verallgemeinerten Zugriffspfadstrukturen. Die Idee besteht dabei darin, Schlüssel mit dem gleichen Wertebereich in einer

gemeinsamen Struktur zu verwalten, auch wenn sie von verschiedenen Attributen oder

KAPITEL 2. VERBUNDE IN DATENBANKEN

16

Tabellen stammen. So könnte man beispielsweise Längenangaben, Zeiten, und Personalnummern, möglicherweise nach einer geeigneten Konvertierung, als Ganzzahlen in einem

gemeinsamen Mehrwegbaum unterbringen. Verwendet man B*-Bäume, so bleiben die internen Knoten davon im Aufbau unberührt. Dort dienen die Referenz-Schlüssel schließlich

nur als Wegweiser zu den richtigen Blättern. Allerdings ändert sich der Aufbau der Blätter, wo zu jedem Schlüssel Informationen zu allen in diesem Baum indexierten Attributen gespeichert werden. Statt eines Datenelementes speichert man Längen-Informationen

und Zeigerlisten für die jeweiligen Teil-Indexe. In Abbildung 2.7 ist dies für ein SchlüsselDatenelement-Paar in einem B*-Baum skizziert.

L1 Zeiger

L2 Zeiger

Ln Zeiger

Schlüssel L1 L2 ... Ln Z11 ... Z1j Z21 ... Z2k ... Zn1

Längen−Informationen

Znl

n Zeigerlisten

Abbildung 2.7: mehrere Zeigerlisten bei verallgemeinerten Zugriffspfaden

In der Abbildung werden n Attribute in einem gemeinsamen Index verwaltet. Das

Datenelement zum Schlüssel besteht daher aus n Längenangaben und n Zeigerlisten. Die

Längenangaben Li ermöglichen das Auffinden der zugehörigen Zeigerlisten Zih . Für Primärschlüssel haben die Zeigerlisten entweder 0 oder 1 Element (Primärschlüssel existiert

nicht, oder existiert), andere Attribute können beliebig häufig vorkommen. Da sich durch

die Zeigerlisten variabler Länge nicht immer gleich viele Schlüssel und Datenelemente

in einem Knoten unterbringen lassen, ist eine geeignete Überlaufbehandlung vorzusehen. Dies kann über eine Verkettung weiterer zu einem Knoten gehörenden Seiten in

einem separaten Überlaufbereich (wie bei den Hash-Indexen) oder durch die Aufteilung

in weitere Blätter des Baumes, z.B. mit einem weiteren (gleichen) Schlüssel, erfolgen. Die

Baumoperationen müssen dies entsprechend berücksichtigen. So muss beispielsweise die

Suchfunktion fortfahren, bis alle dem Suchkriterium entsprechenden Schlüssel gefunden

wurden, nicht nur bis zum ersten.

Die Höhe eines B*-Baumes als verallgemeinerte Zugriffsstruktur ändert sich auf Grund

des hohen Verzweigungsgrades nur unwesentlich, denn der Verzweigungsgrad der internen

Knoten ist von den zusätzlich abzulegenden Informationen nicht betroffen. Es können

aber, im Vergleich zu einem einfachen Index, zusätzliche Schlüssel hinzukommen, da auch

mehr Blätter benötigt werden. Dies sollte den Baum aber lediglich um einige wenige

Ebenen vergrößern. Daher sind die direkten Zugriffe nur unwesentlich langsamer als bei

einfachen Indexstrukturen.

Durch die gemeinsame Nutzung der Schlüssel brauchen diese nicht mehrfach in internen Knoten verschiedener einfacher Indexe abgespeichert zu werden, zudem ist es sogar

wahrscheinlicher, dass sich (zumindest die oberen) Knoten bereits in datenbankinternen Puffern befinden, wenn ein neuer Indexzugriff erfolgt. Aufgrund der zusätzlichen

Informationen in den Blättern (evtl. mit Verkettung) ist ein sequentieller Zugriff auf die

Datensätze unter Zuhilfenahme des Indexes nur geringfügig langsamer.

KAPITEL 2. VERBUNDE IN DATENBANKEN

17

Besonders vorteilhaft ist dagegen, dass bestimmte Verbunde auf geradezu natürliche

Weise unterstützt werden: Beim eingangs erwähnten Beispiel

select EMPLOYEES.name, DEPARTMENTS.name from EMPLOYEES, DEPARTMENTS

where EMPLOYEES.deptnr = DEPARTMENTS.deptnr;

befinden sich bei gemeinsamer Indexierung die Informationen zu EMPLOYEES.deptnr

und DEPARTMENTS.deptnr beim gleichen, gemeinsamen Schlüssel, und können damit

direkt ausgegeben werden.

2.3

Indexgestützter Verbund

Existiert ein Index auf eine oder mehrere der bei einem Verbund beteiligten Spalten, so

kann dieser auch bei der Bearbeitung einer Verbundanfrage verwendet werden. Nicht mehr

alle Datensätze müssen bei der Suche nach Verbundpaaren (evtl. mehrfach) eingelesen

werden, sondern dies kann mit dem deutlich kleineren Index geschehen. Der Index passt

möglicherweise sogar komplett in den Hauptspeicher des Datenbankrechners, so dass dort

der komplette Verbund berechnet werden kann, bevor die zugehörigen Datensätze gelesen

werden müssen.

Lassen sich die Schlüssel des Indexes ordnen, so werden die Indexeinträge in der Regel

auch geordnet gespeichert, so dass sie im Index schnell gefunden werden. Dies kommt

wiederum den Verbundalgorithmen zugute, die geordnete Wertemengen benötigen. Zur

Anwendung des bereits erwähnten Mischverbundes reicht es bereits, wenn über den Index

die Tupel auf logischer Ebene geordnet sind. Statt der eigentlichen Tupel kann der Verbund anhand der Schlüssel der Indexeinträge stattfinden. Die Verarbeitung der Verbünde

kann ausschließlich mit Schlüssel- und RowID-Listen erfolgen, wenn für die betroffenen

Attribute geeignete Indexe zur Verfügung stehen. Ist kein Verbund kompletter Tabellen gefordert, so kann diese Liste noch mit weiteren Selektionen verknüpft werden (oder

bereits sein), bevor der eigentliche Zugriff auf die Datentupel erfolgen muss.

2.3.1

Verbundindexe

Als spezieller Zugriffspfad für Zwei-Weg-Verbunde ist es möglich, einen Verbundindex

(join index ) bereitzustellen. Prinzipiell handelt es sich dabei um einen vorberechneten

Verbund: Die Tupel-IDs (TIDs) der Verbundpaare bilden dabei einen Eintrag in einer

zweistelligen Relation V , die alle Paare eines Verbundes enthält, die zu einer gegebenen

Operation auf zwei Verbundattributen gehören. Also etwa

V = {(a.T ID, b.T ID)|f (a.α, b.β) = true, a ∈ A, b ∈ B}

wobei α und β die Verbund-Attribute der Zeilen a und b in den Relationen A, B sind.

Die Relationen müssen dabei nicht verschieden sein. Die boolsche Funktion f kann auch

deutlich komplexer als einfache Vergleiche (=, 6=, <, ≤, etc.) sein und bereits Selektionen

auf α und β berücksichtigen.

Da ein solcher Verbundindex nicht notwendigerweise im Hauptspeicher des Datenbanksystems Platz findet, sollte er geeignet gespeichert werden. Zum schnellen Zugriff

KAPITEL 2. VERBUNDE IN DATENBANKEN

18

empfiehlt sich eine geordnete Speicherung jeweils einer Kopie in zwei B*-Bäumen, eine

nach dem ersten, die andere nach dem zweiten Attribut sortiert. Sollte die Verbundrichtung vorgegeben sein, reicht möglicherweise auch die Speichung einer nach dem relevanten

Attribut sortierten Kopie.

A

T−ID1

B

T−ID7

T−ID3

T−ID2

T−ID1

T−ID4

T−ID2

T−ID1

T−ID2

T−ID6

T−ID3

T−ID3

T−ID5

T−ID1

3

1 7

1 4

2 1

2 6

3 2

3 3

5 1

1 4

2 6

1 7

3

2 1

5 1

3 2

3 3

Abbildung 2.8: Verbundindex als Tabelle und als B*-Bäume, jeweils nach den Tupel-IDs

sortiert

Im Falle eines kompletten Verbundes kann der B*-Baum sequentiell traversiert werden.

Kommen Selektionen hinzu, ergibt sich bei der vorherigen Selektion eine Liste der auszuwählenden Tupel-IDs. Diese wird sortiert, um aus dem entsprechend sortierten B*-Baum

die entsprechenden Verbundpaare in einem Durchlauf auszuwählen. Die referenzierten

Datensätze werden dann vom Externspeicher geholt und unter Beachtung möglicher Projektionsklauseln ausgegeben.

Eine andere Form von Verbundindex lässt sich mit Bitmap-Listen erstellen. Statt

Datensätze oder Speicherseiten der eigenen Relation repräsentieren die einzelnen Stellen

eines Bit-Strings dabei Primärschlüssel oder Listen davon (Tupel-IDs/RowIDs), einer

anderen Tabelle. Werden die Bit-Strings komprimiert, so ergibt sich ein Verbund, der

im Vergleich zu einer materialisierten Sicht eines Verbundes speichereffizienter ist, denn

bei einer materialisierten Sicht werden die RowIDs in der Regel nicht komprimiert (siehe

auch [O9i-DWG] und [O9i-DPTG]).

Änderungsoperationen auf den beteiligten Relationen können sehr umfangreiche Aktualisierungen des Verbundindexes nach sich ziehen. Möglicherweise ist es bei größeren

Änderungen der Relationen günstiger, den Verbundindex komplett neu aufzubauen, statt

viele Änderungen einzelner Zeilen nachzuvollziehen. Daher empfiehlt sich der Einsatz

eines Verbund-Indexes besonders für Anwendungen, die viele Verbund-Abfragen, aber

wenige Datenänderungen nach sich ziehen, wie dies bei Data-Warehouse Anwendungen

oft der Fall ist.

Die Idee einen vorberechneten Verbund zu speichern, lässt sich auf einfache Art und

Weise von einem Zwei-Wege-Verbund auf einen n-Wege-Verbund verallgemeinern. Statt

mehrere zweistellige Verbunde bei mehrstelligen Verbunden zu verknüpfen, kann auch

ein mehrstelliger Verbund vorab berechnet werden. Dazu werden für weitere Attribute

und damit verbundene Verknüpfungen weitere Spalten in der Verknüpfungstabelle be-

KAPITEL 2. VERBUNDE IN DATENBANKEN

19

reitgestellt, was wiederum mehrere B*-Bäume für die entsprechenden Sortierungen nach

sich ziehen kann. Dabei sollte man beachten: Je mehr Verbundoperationen in einem gemeinsamen Index vorberechnet sind, desto spezieller ist sein Einsatzbereich und damit

umso geringer der praktische Nutzen für beliebige Verknüpfungen. Zudem wird der Index

zunehmend wartungsaufwendiger bei Aktualisierungsoperationen.

2.3.2

Verbunde in objektrelationalen Datenbanken

In objektrelationalen Datenbanken gibt es für den Benutzer die Möglichkeit eigene Datentypen (und dazugehörende Methoden) aus den bestehenden Datentypen zu konstruieren.

Diese Flexibilität bringt allerdings mit sich, dass die auf Standarddatentypen basierenden

Indexierungsalgorithmen nicht oder zumindest nicht ohne weiteres, auf die neuen Objekte

angewand werden können.

Die Indexierung zusammengesetzter (oder mehrdimensionaler) Datentypen kann erreicht werden, indem die einzelnen Komponenten dieses Datentyps jeweils einzeln indexiert werden. Bei einer Suche werden dann die Ergebnisse der einzelnen Indexabfragen über mengentheoretische Operationen miteinander verbunden. Dieses Verfahren kann

aber nicht alle Anwendungen abdecken, so ist eine Indexunterstützung für nearest neighbour -Abfragen bei räumlichen Daten nicht ohne weiteres zu bewerkstelligen. Auch ist es

meist nicht sehr effektiv, denn die Eigenschaften der Objekte werden dabei nicht weiter ausgenutzt. Die Methode einzelne Suchschlüsselkomponenten zu einem gemeinsamen

Suchschlüssel zu konkatenieren, verspricht keine Verbesserung, denn bei Ablage dieses

Schlüssels in einem B*-Baum wird er nur nach der ersten Komponente sortiert gespeichert. Ordnungen auf anderen Teilschlüsseln gehen verloren und können bei einer Suche

nicht mehr ausgenutzt werden.

Kapitel 3

Spatial Join Algorithmen

Eine auf den Datentyp angepasste Indexstruktur kann deren Eigenheiten ausnutzen, um

effektiv zu arbeiten. In diesem Kapitel werden einige indexgestützte Verfahren vorgestellen, die dem Verbund räumlicher Objekten dienen. Dabei sind die verwendeten Verbundalgorithmen auf die jeweiligen Indexstrukturen für räumliche Datensätze zugeschnitten,

die daher ebenfalls in diesem Kapitel skizziert werden.

Der indexgestütze Join-Prozess wird normalerweise in zwei Stufen aufgeteilt: In einer

ersten Filter-Phase werden mit Hilfe des Indexes möglichst viele Verbundpaare aussortiert, die nicht der entsprechenden Verbundoperation entsprechen. Da in den Indexen

nicht die tatsächlichen Objektgeometrien hinterlegt sind, sondern meist leichter zu handhabende Approximationen (beispielsweise ein Minimum Bounding Rectangle MBR) kann

der Index nur zur Berechnung einer Kandidatenliste beitragen. In einer zweiten Filterung werden die tatsächlichen Objekt-Geometrien betrachtet, um aus diesen Paaren die

Ergebnis-Menge zu generieren. Da die zweite Phase bei allen Algorithmen gleich ist, sind

dort keine Laufzeitunterschiede zu erwarten. Daher wird die zweite Filter-Phase bei der

Beschreibung der Algorithmen nicht weiter betrachtet.

Auch sind keine prinzipiellen Unterschiede bei der Verwendung verschiedener Operatoren (disjoint, containment, intersection(=overlap), equality, touching) zu erwarten:

Bei vielen Index-Strukturen kann in weiten Teilen nur auf Überlappung oder Disjunktheit geprüft werden. Bei den vorgestellten Baum-Strukturen ist beispielsweise erst auf

der Blatt-Ebene die Unterscheidung möglich.

3.1

indexed nested loops join

Dies ist einer der einfachsten Join-Algorithmus. Dabei werden alle Elemente der einen

Tabelle nacheinander abgearbeitet. Zu jedem Eintrag oa der äußeren Tabelle (oder des

zugehörigen Indexes) werden mittels des Indexes der zweiten Tabelle alle Objekte ob (der

2. Tabelle) gefunden, die dem Vergleichsoperator Θ entsprechen, also etwa ob sich deren

bounding box mit oa schneiden. Existiert auch für die äußere Tabelle ein Index, so kann

dabei sehr einfach eine zusätzliche Selektion stattfinden.

KAPITEL 3. SPATIAL JOIN ALGORITHMEN

21

indexed-join1 (A, B: Index, qa : Query, Θ: Operator);

FOR (oa ∈ IndexScan(A,qa )) DO

construct query qb for Θ and oa

FOR (ob ∈ IndexScan(B,qb )) DO

output(oa , ob )

END

END

END

Diese Strategie hat den Vorteil , dass sie praktisch bei allen Indexstrukturen angewand

werden kann.

3.2

R*-tree join

Dieser Algorithmus ist von Brinkhoff, Kriegel, Seeger in [BKS93] vorgeschlagen und dort

noch bezüglich der CPU- und I/O-Performance optimiert. Er ist deutlich leistungsfähiger als der indexed nested loops join, wenn dieser auch auf einer Baumstruktur basiert.

Denn während beim indexed nested loops join zumindest die oberen Knoten sehr häufig durchlaufen werden müssen, werden sie beim R*-Baum-Verbund nur selten besucht,

denn der Algorithmus arbeitet rekursiv und muss damit nicht jedesmal bei der Wurzel

neu beginnen.

3.2.1

Aufbau eines R-Baumes

Ein R-Baum [Gut84] besitzt eine Datenstruktur, die mit denen von B+ -Bäumen vergleichbar ist, aber mehrdimensionale Rechtecke als Objekte beinhaltet. Bei einem R-Baum

handelt es sich um einen ausgeglichenen Baum, dessen innere Knoten (mbr,child)-Paare

beinhalten, wobei mbr ein Minimum Bounding Rectangle und child einen Zeiger auf einen

Nachfolge-Knoten beinhaltet. Die mbr -Einträge werden nach einer Änderung des Baumes

so aktualisiert, dass sie danach wieder das kleinste (achsenparallele) Rechteck enthalten,

das die Rechtecke aller Nachfolger-Knoten umschließt. Ein Blatt beinhaltet (mrb,obj)Paare, die wiederum ein MBR und einen Verweis auf das entsprechende Objekt in der

Datenbank enthalten.

Im R-Baum werden in den Knoten, die üblicherweise die Größe (oder ein Vielfaches)

einer Datenseite des externen Speichers haben, zwischen m und M solcher Paare gespeichert (2 ≤ m ≤ dM/2e) Die Wurzel besitzt wenigstens 2 Nachfolger oder ist selber

ein Blatt ist, in der dann auch weniger als m Knoten gespeichert sein können. Da kein

prinzipieller Unterschied zwischen einem Zeiger auf einen weiteren Nachfolgeknoten und

einem Zeiger auf ein konkretes Datenobjekt besteht, kann man die Knoteneinträge auch

zu (mbr,ref )-Paaren verallgemeinern.

Wie in [BKSS90] gezeigt wird, ist der R∗ -Baum eine besonders effiziente Spezialisierung der R-Bäume. Er unterscheidet sich nur in den Einsetz- und Teilungsmethoden, aber

nicht im Aufbau der Datenstruktur von den ursprünglichen R-Bäumen.

KAPITEL 3. SPATIAL JOIN ALGORITHMEN

a

b

3

1

22

a

b

c

4

2

1

c

5

6

7

2

3

4

5

6

7

zu den Datensätzen der Objekte

Abbildung 3.1: Beispiel eines R-Baumes

Der Algorithmus, der dem Einfügen von Knoten in einen Baum implementiert, betrachtet bei R*-Bäumen nicht nur die Vergrößerung der Fläche bei der Auswahl des

Einfügepfades, sondern minimiert ebenfalls die Überschneidungen (bei den Knoten der

vorletzten Ebene), die durch das Einfügen eines neuen Knotens entstehen. Muss ein Knoten geteilt werden, so werden die Rechtecke zunächst in Bezug auf ihre Lage auf den

Achsen des Raumes sortiert. Diejenige Achse wird ausgewählt, die verspricht, dass der

Rand um die zu bestimmenden zwei Gruppen am kleinsten wird. Dann wird eine Verteilung der Einträge in zwei Gruppen entsprechend der gewählten Achse ausgewählt, welche

die Überschneidungen zwischen den beiden Gruppen minimiert.

3.2.2

Spatial Join

Der Basis-Algorithmus für einen räumlichen Verbund mit zwei R-Bäumen mit Wurzeln

A und B funktioniert folgendermaßen:

rtree-join1 (A, B: R-Node);

FOR (EA ∈ A) DO

FOR (EB ∈ B with EB .mbr ∩ EA .mbr 6= ∅) DO

IF ((A is a leaf page) OR (B is a leaf page)) THEN

output(EA , EB )

ELSE

ReadPage(EA .ref); ReadPage(EB .ref);

rtree-join1(EA .ref, EB .ref)

END

END

END

END

Der rekursiv arbeitende Algorithmus wird zunächst mit den Wurzeln der zu verbindenden Bäume aufgerufen. Es folgt ein Tiefendurchlauf durch die beiden Bäume, wobei

diese parallel durchsucht werden.

KAPITEL 3. SPATIAL JOIN ALGORITHMEN

23

Zu jedem Eintrag EA des Knotens A wird geprüft, ob die Elemente EB aus B eine

nichtleere Schnittmenge mit EA besitzten. Man beachte hierbei, dass A und B jeweils

auf der gleichen Stufe der entsprechenden Bäume stehen (daher: paralleler Durchlauf).

Werden sich schneidende Einträge gefunden, so wird geprüft, ob es sich dabei bereits um

Blätter einer der Bäume handelt. Dann ist keine weitere Rekursionsstufe mehr nötig und

möglich, denn in wenigstens einem Baum beinhaltet das Objekt bereits den Verweis auf

die Datenbank. Die Funktion output verfolgt denjenigen Baum bis zu den Blättern, der

noch nicht die Blattebene erreicht hat , wobei die MBR des Datenobjektes des Baumes auf

Blattebene berücksichtigt werden sollte. Alle Paare (EAi , EBj ), die sich am Ende dieses

Baumabstieges ergeben, werden als Ergebnis der ersten Filterstufe ausgegeben. Handelt

es sich bei den Knoten beider Bäume bereits um Blätter, so ist das Ergebnis das Paar

(EA , EB ).

Sollte es sich weder bei A noch bei B um ein Blatt handeln, so wird der Algorithmus mit den sich schneidenden Knoten rekursiv aufgerufen, nachdem die entsprechenden

Seiten in den Speicher geladen wurden (falls sie sich noch nicht dort befinden).

Der Algorithmus überprüft alle Elemente in EA .ref und EB .ref. Da die Schnittmenge

der MBRs aber im Allgemeinen kleiner als die einzelnen MBR sind, uns aber nur Elemente aus diesem Schnitt interessieren, ergibt sich eine erste Optimierung, indem man

als weiteren Parameter ein Rechteck angibt, in dem gesucht werden soll.

Vor jeder Rekursion werden die Seiten der referenzierten Knoten in den Speicher geladen. Um die I/O-Zugriffe zu senken, werden üblicherweise Puffer (im Programm oder

vom Betriebssystem/DBMS) verwendet, die den Zugriff auf externen Speicher minimieren

sollen. Ein bereits im Speicher/Puffer befindlicher Knoten soll möglichst zuerst verwendet werden, statt ihn später wieder neu laden zu müssen. Mittels eines Plane-SweepAlgorithmus können die Rechtecke eines Knotens in gewissen Maßen geordnet werden.

Dadurch lassen sich die Vergleiche koordinieren, so dass es (in gewissen Grenzen) möglich ist, sie zu optimieren. Dabei findet dieser Sortiervorgang beim Laden der Seiten in

den Speicher statt, denn die Struktur des R-Baumes soll nicht verändert werden. Das

Sortierung im Speicher beschränkt die Auswahl der anzuwendenden Sortieralgorithmen

auf einfache Typen, da sonst der Performance-Vorteil zunichte gemacht wird, wenn eine

Seite dennoch öfter geladen werden muss.

Eine etwas anderen Weg zur Optimierung dieses Algorithmus wird in [HLR97] vorgeschlagen: Dabei werden die beiden Bäume jeweils ebenenweise betrachtet. Statt aber in

einer Rekursion und damit einer Tiefensuche mögliche Verbundpartner zu suchen, werden

erst alle möglichen Paare auf einer Baumebene bestimmt.

Die Zwischenergebnisse sind dabei nötigenfalls auf externem Speicher zwischenzuspeichern, wenn sie nicht mehr im Hauptspeicher verwaltet werden können. Die Verbundpaare

eines Zwischenergebnisses werden dann geordnet, um untergeordnete Knoten möglichst

selten lesen zu müssen.

Ist dies geschehen, so wird der Verbund für die nächste Ebene berechnet, wobei die

Knoten in der berechneten Reihenfolge untersucht werden.

Statt die Prozedur des normalen R-Baum Verbundes rekursiv zu gestalten, ist es

natürlich auch möglich, die zu untersuchenden Knoten auf einen Stack abzulegen. Beim

KAPITEL 3. SPATIAL JOIN ALGORITHMEN

24

Eintritt in die Prozedur werden jeweils die beiden Elemente entfernt, die beim rekursiven

Aufruf die Wurzeln darstellen. Statt einer neuen Rekursion mit EA .ref und EB .ref werden

diese beiden Elemente auf den Stack abgelegt. Die Prozedur wird in einer Schleife dann

so oft aufgerufen, bis alle Elemente des Stacks entfernt sind.

3.3

Seeded Trees

Ming-Ling Lo und Chinya V. Ravishankar schlagen in [LR94] eine Methode vor, die die

Anzahl der Vergleiche bei den R-Baum-indexgestützten Joins reduzieren soll. Des weiteren bietet sie sich an, wenn nur für einen der beteiligten Datensätze ein Index existiert.

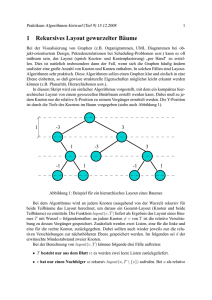

Als Beispiel betrachte man Abbildung 3.2. Dort sind die Bounding-Boxen der Knoten der

Ausgangssituation

Gruppierung bei R−Baum−Erzeugung

für den 2. Datensatz

Datenobjekt im 2. Datensatz

Bounding Box von Baum 1

Günstigere Gruppierung

Bounding Box von Baum 2

Abbildung 3.2: Ungünstige und günstige bounding box -Verteilung in einem Seeded Tree

obersten Ebene eines bereits bestehenden Indexes zu sehen und einzelne Datenobjekte

eines 2. Datensatzes, auf denen ebenfalls ein Index erstellt werden soll. Der übliche Algorithmus würde, wie im mittleren Teil der Abbildung zu sehen ist, möglicherweise kleinere

MBRs erzeugt, die aber jeweils mehrere bounding boxes des 1. Datensatzes schneiden.

Dies würde jeweils mehrere Vergleiche hervorrufen. Ein günstigeren Verteilung ergibt

sich, wenn die Objekte wie im rechten Teil der Abbildung zu sehen gruppiert werden,

denn dadurch reduziert sich die Anzahl der Vergleiche der Knoten des 1. Datensatzes mit

den Knoten des 2. Datensatzes auf der obersten Ebene auf jeweils 1 Paar.

Die Idee von Seeded Trees besteht also darin, eine gewisse Anzahl von Ebenen eines

existierenden R-Baumes für die Konstruktion eines Baumes für den zweiten Datensatz zu

übernehmen. Dadurch kann man die spätere Form des Seeded Trees so beeinflussen, dass

ein Verbund der beiden Datenstrukturen weniger Knoten-Vergleiche und damit weniger

zu lesende Knoten, also Seiten vom externen Speicher benötigt. Die Join-Phase ist mit

der des R-Baumes identisch, denn der Seeded Tree hat eine sehr ähnliche Struktur.

KAPITEL 3. SPATIAL JOIN ALGORITHMEN

3.3.1

25

Seeded Tree Konstruktion

Um einen Seeded Tree aufzubauen, wird in der seeding phase eine gewisse Anzahl an

Ebenen eines existierenden R-Baumes herangezogen, um das Aussehen des Trees zu beeinflussen. Dabei können sowohl die bounding boxes als auch die Mittelpunkte der MBRs

des R-Baumes kopiert werden. Lo und Ravishankar ermittelten einen Vorteil, wenn nur

die Mittelpunkte der MBRs kopiert werden (zumindest auf der untersten Ebene, darüber

liegen dann entweder auch die Mittelpunkte der MBRs des kopierten Baumes oder die

MBRs werden wie im R-Baum aus den Nachfolge-Knoten errechnet).

Die kopierten Ebenen nennt man seed levels, die Ebenen darunter grown levels, wobei

die unterste Ebene der seed levels, also die Vorgänger der grown levels, slot-level genannt

werden. Die ref-Komponente der (mbr, ref )-Paare dieser Ebene werden auch slot-pointer

genannt. Dort werden im Laufe der Baumerstellung Unterbäume wachsen, bei denen es

sich um normale R-Bäume handelt.

Initial ist nur die mbr-Komponente auf der slot-level-Ebene besetzt, um zu bestimmen,

in welchen Unterbaum ein neuer Eintrag einzufügen ist. Die ref-Komponente verweist

anfangs auf einen reservierten Wert, z.B. NULL. In der ersten Ebene der grown levels

liegen also Wurzeln von R-Bäumen, oder die slot pointer verweisen auf den initialen

Wert, NULL-Zeiger.

a

d

k

l

e

m

f

n

o

p

q