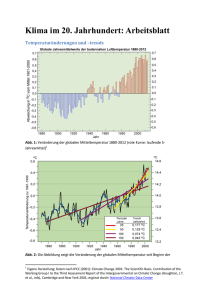

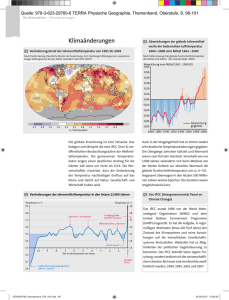

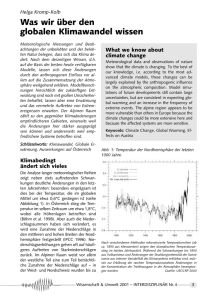

Beeinflussung des globalen Klimas durch den Menschen - KIT

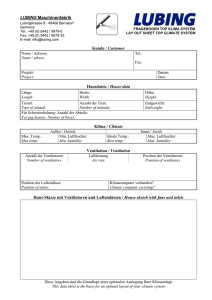

Werbung