PDF file - IDB - Universität Bonn

Werbung

Rheinische Friedrich-Wilhelms-Universität Bonn

Diplomarbeit

Inkrementelle Methoden zur Anpassung

materialisierter Sichten in relationalen

Datenbanken

von:

Matrikel-Nr.:

Adresse:

Roya Juki

1152042

Masurenweg 3

53119 Bonn

Erstgutachter:

Prof. Dr. Rainer Manthey

Abstract

Materialisierte Sichten spielen eine große Rolle in leistungsstarken Abfrageprozessen. Nach der initialen Erzeugung von materialisierten Sichten stellt sich die Frage, wie diese möglichst effizient bei

einer Änderung (Einfüge-, Lösch- oder Update-Operationen) der Basisdaten aktualisiert werden können. Da die komplette Neuberechnung bei großen Datenbanken meistens mit hohem Aufwand verbunden ist, wird eine inkrementelle Sichtenanpassung zur Aktualisierung der materialisierten Sichten

durchgeführt. Dabei sollen nur die Konsequenzen der aktuell geänderten Fakten der Basisrelationen

in den entsprechenden materialisierten Sichten aktualisiert werden. Viele Methoden sind zur Realisierung der inkrementellen Anpassung der materialisierten Sichten entwickelt worden. Alle Verfahren

aktualisieren die relationalen Sichten für die meisten üblichen Operationen. Bei jeder Methode werden bestimmte Sprachen wie z.B. SQL oder Datalog bevorzugt und auch spezielle Einschränkungen

und Erweiterungen der Sprachen vorausgesetzt. Ein Vergleich der verschiedenen Methoden zeigt,

dass Auswahl und Komplexität der materialisierten Sichten und auch die Größe der Datenbank einen

großen Einfluss auf die Effektivität ihrer inkrementellen Anpassung haben.

In dieser Arbeit sind einige Verfahren zur inkrementellen Anpassung von Sichten ausgewählt worden,

die auf den ersten Blick verschiedene Vorgehensweisen vorzeigen. Nach der Beschreibung der Methoden, werden sie unter bestimmten Kriterien verglichen. Es zeigt sich, dass die Verfahren trotz ihrer

unterschiedlichen Ablaufstrategien, auf einer einheitlichen Linie verlaufen und natürlich ein gemeinsames Ziel verfolgen.

1

2

Danksagung

Ein besonderer Dank geht an Herrn Prof. Dr. Manthey für seine unermüdliche, zuverlässige und

freundliche Betreuung. Erst durch sein Vertrauen in meine Person konnte ich diese Arbeit angehen

und zum Abschluss bringen.

Desweiteren möchte ich meiner Korrekturleserin und meinen Korrekturlesern danken für ihre hilfreichen Anmerkungen. Meinem Arbeitsgeber danke ich sehr für die flexiblen Arbeitszeiten während

meines Studiums und besonders während der Diplomarbeitsphase.

Schließlich danke ich meiner Familie herzlich für ihre seelische Unterstützung und ihre Geduld.

Inhaltsverzeichnis

Abstract

1

Danksagung

2

Inhaltsverzeichnis

5

Abbildungsverzeichnis

6

1

Einleitung

7

2

Grundlagen deduktiver Datenbanken

9

3

2.1

Deduktionsregeln . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10

2.2

Fixpunktsemantik deduktiver Datenbanken . . . . . . . . . . . . . . . . . . . . . .

12

2.3

Sichtentypen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

2.4

Trigger . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2.4.1

SQL-Trigger . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

16

2.4.2

Starburst-Trigger . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

Materialisierte Sichten

19

3.1

Auswahl und Anwendung materialisierter Sichten . . . . . . . . . . . . . . . . . . .

21

3.1.1

21

Das allgemeine Problem der Auswahl . . . . . . . . . . . . . . . . . . . . .

3

INHALTSVERZEICHNIS

3.1.2

3.2

3.3

Einsatzgebiete von materialisierten Sichten . . . . . . . . . . . . . . . . . .

22

Anpassung materialisierter Sichten . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

3.2.1

Techniken der Aktualisierung . . . . . . . . . . . . . . . . . . . . . . . . .

24

3.2.2

Klassifizierung von Aktualisierungsalgorithmen . . . . . . . . . . . . . . . .

25

3.2.3

Ungeklärte Probleme bei der Sichtenanpassung . . . . . . . . . . . . . . . .

26

Inkrementelle Anpassung materialisierter Sichten . . . . . . . . . . . . . . . . . . .

26

3.3.1

Klassifikation des Sichtenanpassungproblems anhand von vier Dimensionen

27

3.3.2

Inkrementelle Sichtenanpassungsalgorithmen auf Basis der vollständigen Informationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

27

Ausgewählte Methoden zur inkrementellen Sichtenanpassung

30

4.1

Die GMS-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

4.1.1

Counting-Algorithmus . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

32

4.1.2

Delete and Rederive-Algorithmus (DRed) . . . . . . . . . . . . . . . . . . .

42

Die CW-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

4.2.1

Syntax und Semantik der Produktionsregeln . . . . . . . . . . . . . . . . . .

46

4.2.2

Sicht-Analyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

4.2.3

Regelgenerierung und Änderungspropagierung . . . . . . . . . . . . . . . .

50

4.2.4

Regelgenerierung in positiv verschachtelten Unterabfragen . . . . . . . . . .

55

Die Magic Updates-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

59

4.3.1

Ein Beispiel zur Änderungspropagierung . . . . . . . . . . . . . . . . . . .

62

4.3.2

Magic Updates . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

66

4.2

4.3

5

4

Vergleich der drei Methoden

71

5.1

71

Gemeinsames Beispiel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

INHALTSVERZEICHNIS

5.2

5.3

6

5

Systematische Diskussion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

76

5.2.1

Regelgenerierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

76

5.2.2

Änderungspropagierung . . . . . . . . . . . . . . . . . . . . . . . . . . . .

77

5.2.3

Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

5.2.4

Negation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

82

5.2.5

Aggregatfunktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

83

5.2.6

Duplikatbehandlung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

84

5.2.7

Änderungen und Änderungsarten . . . . . . . . . . . . . . . . . . . . . . .

85

Beurteilung der Methoden . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

Zusammenfassung und Ausblick

89

Literatur

92

Eidesstattliche Erklärung

93

Abbildungsverzeichnis

3.1

Anwendung materialisierter Sichten in DWH . . . . . . . . . . . . . . . . . . . . .

23

3.2

Problemraum der inkrementellen Sichtenanpassung . . . . . . . . . . . . . . . . . .

27

3.3

Problemraum in 3D . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

28

4.1

Struktur der GMS-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

32

4.2

Regel-Ableitung-System . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

4.3

Propagierungsverfahren bei der CW-Methode . . . . . . . . . . . . . . . . . . . . .

51

4.4

Regel-Compilierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

60

4.5

Struktur der Änderungspropagierung in der Magic Updates-Methode . . . . . . . . .

60

4.6

Struktur der Magic Updates-Methode . . . . . . . . . . . . . . . . . . . . . . . . .

67

4.7

Regelgenerierung in der Magic Updates-Methode . . . . . . . . . . . . . . . . . . .

68

5.1

Regelgenerierungen in den drei Methoden . . . . . . . . . . . . . . . . . . . . . . .

77

5.2

Mechanismen zur Faktenerzeugung . . . . . . . . . . . . . . . . . . . . . . . . . .

78

6

Kapitel 1

Einleitung

Eine abgeleitete Relation (Sicht) kann in einer Datenbank materialisiert werden, d.h., die ableitbaren Fakten werden in explizit gespeicherter Form gehalten. Der Zugriff auf eine Sicht wird dadurch

erleichtert, z.B. ihre Verwendung zur Beantwortung einer Abfrage. Die Erzeugung dieser Art von

Sichten ist oft mit hohem Aufwand verbunden, d.h. mit hohen Kosten um Informationen in die Form

gespeicherter Relationen zu bringen. Diese Kosten sind nur einmal aufzubringen und werden sich

dann durch Effizienzgewinn bei jeder Abfrage ausgleichen. Außerdem ist immer eine Aktualisierung

der materialisierten Sichten erforderlich, wenn Änderungen an Basisdaten durchgeführt werden, von

denen die Sichten abgeleitet sind. Die Anwendung materialisierter Sichten ist in der Datenbankkommunikation sehr weit verbreitet. Besonders ihre Anwendung in Data Warehouse, Data Integration und

Replikation.

Eine Aktualisierung einer materialisierten Sicht kann in Form einer Neuberechnung erfolgen, in dem

die materialisierte Sicht bei der Auswertung des Abfrageausdrucks der Sichtendefinition in dem aktuellen Zustand der Datenbank rematerialisiert wird. Eine Neuberechnung ist meistens mit hohen

Kosten verbunden und daher unerwünscht. Also sollten nur die spezifischen Änderungen der Fakten

der Basisrelationen an den abgeleiteten Sichten angewendet werden. Diese Art von Aktualisierung

wird als inkrementelle Sichtenanpassung bezeichnet. In den letzten vier Jahrzehnten wurde ein breites Spektrum an verschiedenen Methoden mit unterschiedlichen Hilfsmitteln zur Aktualisierung von

materialisierten Sichten entwickelt. Ein großer Anteil dieser Verfahren ist für relationale Datenbanken

entwickelt worden (u.a. [CW91], [GMS93], [GL95]). Unabhängig davon, ob sie im Kontext von SQL

oder datalog-basiert entwickelt wurden, haben sie alle ein gemeinsames Ziel:

Die Grundidee dieser Verfahren ist, dass sie sich nur auf aktuell geänderte Fakten beziehen, und diese

inkrementell durch die betroffenen Regeln propagieren. Probleme, die in der Praxis deutlich werden, haben zur Arbeit auf diesem Gebiet motiviert. Bei der Implementierung der verschiedenen Ver7

1. Einleitung

8

fahren sind unterschiedliche Techniken zu Grunde gelegt, wie z.B. Präprozessoren (zur Analyse der

Abhängigkeit zwischen Sichten und Basisrelationen), Trigger, spezielle Algorithmen oder FixpunktIteration. Bei fast allen Verfahren sind bestimmte Einschränkungen, sowohl im Basissystem (z.B.

Starburst: [CW90]), als auch bei der Definition der Sichten vorausgesetzt worden, wie z.B. bei Ceri/Widom, die keine Rekursion und Aggregation zulassen.

Das zentrale Ziel dieser Arbeit liegt darin, einige repräsentative Verfahren zur materialisierten Sichtenanpassung durch gründliches Studieren und Klassifizieren der Methoden und detaillierte Erklärung

der Ansätze miteinander zu vergleichen. Dieser Arbeit liegt zugrunde

• eine ausführliche und klare Beschreibung der Anpassung der relationalen materialisierten

Sichten,

• die Darstellung der Vor- und Nachteile der ausgewählten Methoden,

• ein Vergleich der beschriebenen Strategien anhand von einheitlichen Kriterien als Basis ihrer

weiteren Anwendung wie auch zur Weiterentwicklung sowie als Basis der Implementation von

neuen Methoden zur Anpassung materialisierter Sichten.

In Kapitel 2 werden allgemeine theoretische Grundlagen im Gebiet deduktiver Datenbanken vorgestellt, insofern sie für das Verständnis der verwendeten Methoden erforderlich sind. Ein Überblick

über die Anwendung der materialisierten Sichten und eine erste allgemeine Definition des Anpassungsproblems, wird in Kapitel 3 gegeben.

In Kapitel 4 erfolgt eine Übersicht über die ausgewählten inkrementellen Strategien in relationalen

Datenbanken. Dabei werden diese Methoden nicht in ihrer Gesamtheit dargestellt, vielmehr werden

die zentralen Ideen vorgestellt und eine Interpretation der Methoden in einfacherer Weise, als es in

Literatur üblicherweise zu finden ist, versucht.

Den Kern dieser Arbeit bildet Kapitel 5, wo versucht wird, die vorgestellten Verfahren des vorherigen

Kapitels durch gemeinsame Beispiele in einheitlicher Sprache deutlicher darzustellen. Grundidee des

Kapitels ist es, Beurteilungkriterien zur Bewertung der verschiedenen Methoden bereitzustellen und

die Strategien in den Punkten, in denen gleiche Ergebnisse zu erwarten sind, zu vergleichen. Kapitel

6 gibt eine Zusammenfassung der Arbeit und einen Ausblick auf weitere Anstrengungen auf diesem

Gebiet.

Kapitel 2

Grundlagen deduktiver Datenbanken

Es existiert keine allgemeine, einheitliche Begriffsbestimmung für deduktive Datenbanken. In seiner

Vorlesung "Deduktive Datenbanken" definiert Prof. Manthey diesen Begriff wie folgt:

"Ein DBMS (für ein beliebiges Datenmodell) heißt "deduktiv", wenn es zusätzlich zu den üblichen

Funktionalitäten eines DBMS die Möglichkeit zur Spezifikation, Verwaltung und Anwendung von Sichten und Integritätsbedingungen bietet." [Man94]

In diesem Kapitel werden Grundlagen deduktiver relationaler Datenbanken zusammengestellt, soweit

sie im Kontext der Sichtenanpassung relevant sind.

Datenbankrelationen sind entweder Basisrelationen, die nur durch Fakten erzeugt werden, oder abgeleitete Relationen, die durch Regeln zustande kommen. Im relationalen Modell ist eine Relation eine

Menge gleichstrukturierter Tupel (Fakten). Jedes Tupel einer Relation ist eindeutig identifizierbar. In

SQL hingegen kann eine Relation Duplikate enthalten und stellt somit eine Multimenge dar. Diese

Eigenschaft ist leider ein großer Nachteil von SQL und führt dazu, dass die Ergebnisse von Anfragen

nichtdeterministisch sein können, je nachdem, ob Zwischenergebnisse Duplikate enthalten oder nicht.

Für eine Basisrelation wird in der Datenbank eine Relationsdefinition gespeichert. Dazu gehören u.a.

die Namen der Relation und der Attribute (Spalten). Für eine abgeleitete Relation (SQL: Sicht) wird

zudem die Ableitungsvorschrift (Deduktionsregel) in der Datenbank gespeichert. Die Fakten einer

abgeleiteten Relation werden anhand der Ableitungsvorschrift auf der Grundlage der jeweils vorliegenden Basisfakten ermittelt.

9

2. Grundlagen deduktiver Datenbanken

2.1

10

Deduktionsregeln

Eine deduktive Regel in Datalog ist ein Synonym für eine Sichtendefinition in SQL. Sichtdefinitionen

gehören zum DB-Schema; sie werden mittels der Data Definition Language (DDL) des jeweiligen

Datenmodells ausgedrückt (z.B. CREATE VIEW Kommando in SQL). Eine deduktive Regel ist prinzipiell wie folgt aufgebaut:

Regelkopf ←− Regelrumpf

Dabei ist der Regelkopf ein Muster für eine Informationseinheit einer ableitbaren Datenmenge und

der Regelrumpf eine definierende Anfrage. Deduktive Regeln sind - wie DB-Anfragen - deklarative

Ausdrücke. Im Prinzip kann jedes Datenmodell (auf der Basis der zugehörigen Anfragesprache) um

deduktive Regeln erweitert werden. Die Verwendung deduktiver Regeln hat viele Vorteile, sowohl bei

materialisierter, als auch bei virtueller Datenhaltung:

• deklarativ (selbstdokumentierend)

• flexibel (änderungsfreundlich)

• modulare Wissensdarstellung, inkrementell erstellbar

• einfache, effiziente Darstellung nützlicher Terminologie ohne redundante Datenhaltung

• Geschäftsregeln der Anwendung werden explizit gemacht

Sichten in SQL sind abgeleitete virtuelle Tabellen aus (mehreren) Relationen, die immer wieder neu

abgeleitet werden sollen, was ggf. zu Performanzproblemen führen kann. In manchen Fällen ist eine

direkte Änderung möglich. Eine Sicht kann wie eine Relation behandelt werden (Sichten auf Sichten

sind möglich). Sichten in SQL sind immer virtuell. Der SQL-Standard ist um das Konzept materialisierter Sichten erweitert worden. Allgemeine Sichten werden nicht materialisiert, sondern als Anfrageergebnis interpretiert, das dynamisch beim Zugriff generiert wird. Eine Sicht entspricht einem

dynamischen Fenster auf die zugrundeliegenden Basisrelationen, und Operationen, die auf Sichten

angewendet werden und durch (interne) Query-Umformulierung auf Basisrelationen abgebildet werden.

2. Grundlagen deduktiver Datenbanken

11

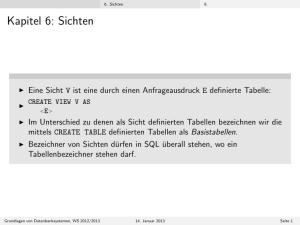

Definition: SQL-Sicht

Jeder Ausdruck der Form

V (A1 , . . . , An ) AS Q

ist eine SQL-Sicht. Hier ist S Sichtsymbol und A1 , . . . , An Attributsymbole (n ≥ 1). Q ist eine

SQL-Anfrage. Die Anzahl n der Attribute der Sicht muss identisch sein mit der Anzahl der Terme der

Ergebnisliste der Anfrage Q.

Die Zuordnung zwischen den Termen der Ergebnisliste der SQL-Anfrage Q und den Attributen der

Sicht erfolgt gemäß der in der Sichtdefinition spezifizierten Reihenfolge (positionelle Darstellung).

Parameterlose Sichten sind anders als in Datalog nicht formulierbar. Eine solche Sichtspezifikation

stellt in SQL keinen eigenständigen Befehl dar. Sie kann zur Spezifikation einer Hilfssicht in der

WITH-Klausel eines Anfrageausdrucks verwendet werden. Zudem kann eine virtuelle Sicht mittels

des DDL-Befehls CREATE VIEW als persistentes Schemaobjekt in einem DB-System definiert werden:

CREATE [RECURSIVE] VIEW V (A1 , . . . , An ) AS Q

Die RECURSIVE-Option muss nur für rekursive Sichten spezifiziert werden. Rekursive Sichten können in SQL sowohl als persistente wie auch als Hilfssichten definiert werden. Die Verankerung der

Rekursion muss mittels UNION-Operator in mindestens einer der beteiligten Sichten definiert werden. Mengenoperatoren, die nicht der Verankerung dienen, sind nicht zugelassen.

Rekursive Sichten

Spezifikation der transitiven Hülle p einer Relation r:

1. Datalog:

p(X, Y ) ←− r(X, Y ) -Verankerung

p(X, Y ) ←− r(X, Z) ∧ p(Z, Y ) -lineare Rekursion

2. SQL mit rekursiver Sicht p

p(a1 , a2 ) AS SELECT tr .a1 , tr .a2 FROM r AS tr

UNION SELECT tr .a1 , tp .a2

-lineare Rekursion

FROM r AS tr , p AS tp WHERE tp .a2 = tr .a1

-Verankerung

2. Grundlagen deduktiver Datenbanken

12

3. SQL mit rekursiven Hilfsichten:

p(a1 , a2 ) AS WITH RECURSIVE h(a1 , a2 ) AS

SELECT tr .a1 , tr .a2 FROM r AS tr UNION

SELECT tr .a1 , th .a2 FROM r AS tr , h AS th WHERE th .a2 = tr .a1

SELECT th .a1 , th .a2 FROM h AS th

In SQL sind ausschließlich linear rekursive Sichten zugelassen.

Nichtlineare Rekursion in Datalog

p(X, Y ) ←− r(X, Y ) -Verankerung

p(X, Y ) ←− p(X, Z) ∧ p(Z, Y )

2.2

Fixpunktsemantik deduktiver Datenbanken

Ableitungsregeln bedeuten nur etwas relativ zu einer gegebenen Faktenmenge F . Als Semantik kann

man dann die Menge aller aus dieser Basismenge mittels R herleitbaren Fakten ansehen, die als F ∗

bezeichnet wird. Dabei ist F ∗ als der kleinste Fixpunkt einer bestimmten Funktion, die jeder Regel

zugeordnet wird, definierbar. Die Fixpunktiteration ist ein konstruktiver Weg, ein Modell zu finden.

Das Konzept des Fixpunkts stammt aus der Funktionentheorie und wurde Mitte des 20. Jhs. besonders

von dem russischen Logiker Tarski untersucht.

Fixpunktiteration stellt eine spezielle Form von Grenzwertbildung dar und kann zur konstruktiven

Definition der Semantik einer deduktiven DB genutzt werden:

F ∗ =def lim T ∗ [R]i (F )

i→∞

T ∗ [R] wird als kumulative Ableitungsfunktion bezeichnet, die ihre erzielten Zwischenergebnisse aufsammelt bzw. kumuliert. T ∗ [R] isr erforderlich um mehrstufige Ableitungen zu charakterisieren, denn

die Anzahl der erforderlichen TR∗ -Schritte ist von R und F abhängig. T ∗ [Ri ] hat eine rein deklarative

Bedeutung, die hier beispielhaft für eine Regel R1 : p(X) ← s(X, Y ), q(Y ) illustriert werden soll:

T ∗ [R1 ](F ) =def {p(X)σ|σ ist eine konsistente Variablensubstitution, so dass s(X, Y )σ ∈ F und

q(Y )σ ∈ F gilt} ∪ F

Für F = {s(1, 2), s(1, 3), s(2, 4), q(3), q(4)} ergibt sich T ∗ [R1 ] = {p(1), p(2)} ∪ F .

2. Grundlagen deduktiver Datenbanken

13

Jetzt betrachten wir zwei Regeln, um kumulative Ableitungen zu berechnen:

R : p(X) ← s(X, Y ), r(Y )

r(Y ) ← q(Y )

F = {s(1, 2), s(1, 3), s(2, 3), q(3)}

T ∗ [R]1 (F ) = {s(1, 2), r(3), r(3), s(1, 3), s(2, 3), q(3)}

T ∗ [R]2 (F ) = {s(1, 2), r(3), s(1, 3), s(2, 3), p(1), p(1), p(2), p(2), q(3)}

Es kann verschiedene Fixpunkte geben, u.U. sogar unendlich viele pro Funktion. Ist ein Fixpunkt bezüglich einer bestimmten Ordnung auf den Eingaben minimal, nennt man ihn minimalen Fixpunkt.

Ein Fixpunkt ist minimal, wenn kein anderer Fixpunkt echt in ihm enthalten ist. Das durch Fixpunktiteration gewonnene F ∗ von (F ,R) ist der einzige, eindeutige minimale Fixpunkt von T ∗ [R], der F

ganz enthält.

Ein Abhängigkeitsgraph stellt die Beziehungen zwischen den Prädikaten einer deduktiven Datenbank dar. Prädikate im Graph stellen die Knoten dar. Eine Kante a → b wird dann genau eingefügt,

wenn eine Regel der Form b : − . . . a . . . existiert. Ist der Graph zyklisch, ist die Datenbank rekursiv.

Prädikate, die im Abhängigkeitsgraph selbsterreichbar sind, heißen rekursiv.

Eine Stratifikation einer Regelmenge R ist eine Unterteilung von R in Schichten, so dass Relationen

in derselben Schicht nicht negativ voneinander abhängen. Stratifikation ist eine eindeutige Funktion

der Form:

λ : RelD → N0

Jeder Relationsname (RelD ) wird eine natürliche Zahl zugeordnet, so dass gilt:

• Wenn p ∈ RelD positiv von q ∈ RelD abhängt, dann ist λ(p) ≥ λ(q)

• Wenn p negativ von q abhängt, dann ist λ(p) > λ(q)

Eine deduktive Datenbank D heißt stratifizierbar, wenn mindestens eine Stratifikation von RelD existiert.

Die Stratifikation kann zur Darstellung des Prinzips der iterierten Fixpunktberechnung verwendet

werden. Die Semantik einer stratifizierbaren Regelmenge R bezüglich einer Faktenmenge F kann

nun formal definiert werden:

2. Grundlagen deduktiver Datenbanken

14

Der kleinste Fixpunkt einer Funktion f , der das Argument M enthält, wird mit lfp(f, M )1 bezeichnet.

Die schichtenweise Abarbeitung der Regelmenge durch lokale Fixpunktiterationen lässt sich dann wie

folgt formalisieren:

Sei eine Stratifikation von (R, F ) mit Schichten {R#1, ..., R#k} gegeben.

F0 =def F

Fi =def lf p(Tneg ∗ [R#i], Fi−1 ) 1 ≤ i ≤ k

Die Bedeutung F ∗ von (R, F ) ist dann definiert als das Resultat der lokalen Fixpunktberechnung auf

dem höchsten Stratum:

F ∗ =def Fk

F ∗ wird den iterierten Fixpunkt von Tneg ∗ [R] bzgl. F genannt.

2.3

Sichtentypen

• SP-Sichten (Select-Project, horizontale Sichten):

ermöglichen die Zugriffsbeschränkung eines Benutzers auf ausgewählte Tupel einer Relation.

Eine solche Sicht wird als horizontal bezeichnet, da sie eine Relation horizontal - also zwischen

ihren Tupeln - aufteilt.

• SPJ-Sichten (Select-Project-Join, vertikale Sichten):

ermöglichen die Zugriffsbeschränkung eines Benutzers auf ausgewählte Attribute einer Relation. Eine solche Sicht wird als vertikal bezeichnet, da sie eine Relation vertikal - also entlang

ihrer Attribute - aufteilt.

• Aggregate + Join-Sichten (Gruppen- und Verbundsichten):

Eine komplexere Art von Sichten mit deren Hilfe mehrere Relationen miteinander zu einer

sogenannten Verbundsicht (engl. join) kombiniert werden und in der Tupel mit der group-byKlausel gruppiert werden, um darauf Aggregatfunktionen anzuwenden.

Wir wissen, dass eine Sicht für eine Datenbank sinnvoll ist, um logische Unabhängigkeit vom konzeptionellen Schema zu erhalten und um die Struktur der Datenbank an die individuellen Anforderungen

einzelner Benutzer anpassen zu können. Darüber hinaus gibt es aber eine Vielzahl weiterer interessanter Anwendungsgebiete für Sichten. Diese sind für konventionelle Datenbanken aus mehreren

Gründen sehr nutzlich.

1

lfp ist eine Abkürzung für least fix point

2. Grundlagen deduktiver Datenbanken

15

• Schema-Entwurf durch Sichtenintegration: Eine Möglichkeit das konzeptionelle Schema einer Datenbank bottom up zu entwickeln. Die Anforderungen an die Datenbank werden für alle

Benutzergruppen getrennt als Sichten entwickelt. Durch Zusammenfügen dieser Sichten und

Eliminierung möglicher Konflikte zwischen ihnen kann das Gesamtschema hergeleitet werden.

• Datenbank-Integration: Daten können aus einer Datenbank in eine andere exportiert werden,

indem die unterschiedlichen Schemata der beteiligten Datenbanken mit Hilfe von Sichten auf

ein gemeinsames (Teil-)Schema abgebildet werden, über das dann die Daten ausgetauscht werden können.

• Anpassung des Datenmodells: Sichten können genutzt werden, um auf eine Datenbank mit

einem anderen Datenmodell zuzugreifen. So können etwa Objekt-Sichten auf relationale Datenbanken (was grob gesagt das Prinzip objektrelationaler Datenbanken ist) oder relationale

Sichten auf objektorientierte Datenbanken definiert werden.

• Visualisierungssysteme: Bei der Visualisierung von Daten einer Datenbank tritt dasselbe Problem auf, wie bei materialisierten Sichten. Ein Visualisierungssystem sollte stets den aktuellen

Datenstand repräsentieren, daher muss es bei Änderungen an den Daten entsprechend aktualisiert werden. Dies entspricht dem Sichtenanpassungsproblem.

2.4

Trigger

Für Triggersysteme hat sich bislang kein einheitliches und allgemein anerkanntes Konzept durchgesetzt. Eine über die Grundlagen hinausgehende ausführliche Beschreibung und Klassifizierung verschiedener aktiver Regel-Systeme sind u.a. in [Gri97], [CW96], [HW93] zu finden. Einsatzmöglichkeiten für aktive Regeln werden in [CCW00] gegeben. Als ein klassisches Aufgabengebiet sehen Ceri

et.al. die prototypische Implementierung systemgenerierter Trigger zur Unterstützung von Kernfunktionen des DB-Systems, wie z.B. materialisierten Sichten.

Grundlegende Eigenschaft eines Triggers ist, dass seine Aktionen automatisch ausgeführt werden,

wenn ein bestimmtes Ereignis eintritt (Event/Action-Paradigma). Die Triggerkomponente als Bestandteil des DB-Systems erkennt das Auftreten eines Ereignisses im Sinne des Regelkonzepts (Datenmanipulationen, Zeitpunkte, abstrakte Ereignisse etc.) und ermittelt die von diesem Ereignis betroffenen Trigger. Zu einem bestimmten Zeitpunkt (unmittelbar, verzögert) werden die Aktionen des

Triggers (Anfragen, Änderungsanweisungen, Transaktionssteuerung (COMMIT), Prozeduraufrufe,

Erzeugen abstrakter Ereignisse) ausgeführt.

2. Grundlagen deduktiver Datenbanken

16

Bei Triggerkonzepten, die dem ECA-Paradigma (Event/Condition/Action) genügen, können für Trigger Bedingungen (Condition) definiert werden, die zum Zeitpunkt der Aktivierung bzw. Ausführung

angewendet werden. Ist die Bedingung nicht erfüllt, so wird der Trigger nicht ausgeführt. Eine weitere

sehr wesentliche Eigenschaft ist die Granularität der Regelausführung. Wird für eine Änderungsanweisung unabhängig davon, wie viele Fakten manipuliert werden, ein Trigger nur einmal gefeuert, so

wird die Regelausführung mengenorientiert bezeichnet. Feuert ein Trigger hingegen für jedes geänderte Fakt, so wird sie als instanzorientiert bezeichnet.

Es gibt zahlreiche Einsatzmöglichkeiten für Trigger. Nachfolgend werden einige der Wichtigsten davon aufgelistet:

• Überwachung nahezu aller Integritätsbedingungen, inkl. dynamischer Integritätsbedingungen

• Validierung von Eingabedaten

• Automatische Erzeugung von Werten für einen neu eingefügten Datensatz

• Wartung replizierter Datenbestände

• Protokollieren von Änderungsbefehlen (Audit Trail)

2.4.1

SQL-Trigger

Trigger sind ausführbare, benannte DB-Objekte, die implizit durch bestimmte Ereignisse (triggering

events) aufgerufen werden können. Die Triggerspezifikation besteht aus dem auslösendem Ereignis,

Ausführungszeitpunkt, optionalen Zusatzbedingungen und Aktion(en).

Syntax von SQL-Triggern

CREATE TRIGGER <trigger name>

{BEFORE | AFTER}{INSERT | DELETE | UPDATE [ OF <column> ]}

ON <table name>

[ORDER <order value>]

[REFERENCING <old or new alias list>]

[FOR EACH {ROW | STATEMENT}]

[WHEN (<search condition>)] <triggered SQL statement>

2. Grundlagen deduktiver Datenbanken

17

<old or new alias> ::= OLD [AS] <old values correlation name> |

NEW [AS] <new values correlation name> |

OLD-TABLE [AS] <old values table alias> |

NEW-TABLE [AS] <new values table alias>

Ein Beispiel für SQL-Trigger

CREATE TRIGGER Gehaltstest

AFTER UPDATE OF Gehalt ON Pers

REFERENCING OLD AS AltesGehalt, NEW AS NeuesGehalt

WHEN (NeuesGehalt < AltesGehalt)

ROLLBACK;

Der Trigger Gehaltstest wird ausgelöst, wenn in der Tabelle Pers Änderungen in der Spalte Gehalt

vorkommen, allerdings mit der Bedingung, dass der neue Eintrag kleiner als der alte Eintrag in der

Tabelle ist.

2.4.2

Starburst-Trigger

Starburst war ein Forschungsprojekt am IBM Almaden Research Center, in dessen Rahmen prototypische Funktionen für SQL-basierte DB-Systeme entwickelt wurden. Eine von IBM entwickelte DBSKomponente ist die Triggerkomponente ’Starburst Rule System’ [CW90], [CW91], [CW94], [Gri97].

In den verschiedenen Publikationen sind aufgabenspezifisch unterschiedliche Varianten des Triggerkonzepts definiert. Die Starburst-Trigger werden nur insoweit vorgestellt, wie sie von Ceri/Widom zur

Implementierung inkrementeller Verfahren in [CW91] verwendet werden.

Definition: Starburst-Trigger

Ein Starburst-Trigger ist eine ECA-Regel der Form:

G WHEN E1 , ..., En

[ IF F ] THEN M1 , ..., Mn PRECEDES G1 , ..., Gm

wobei G, G1 , ..., Gm Triggersymbole sind. Ei (1 ≤ i ≤ n) ist eines der Ereignissymbole INSERTED INTO B, DELETED FROM B, UPDATED B.Aj . Aj ist das Attributsymbol eines Attributs der

Basisrelation B. F ist eine SQL-Formel und Mk (1 ≤ k ≤ g) ist eine SQL-Änderungsanweisung.

2. Grundlagen deduktiver Datenbanken

18

Mit einem CREATE RULE-Befehl wird ein Trigger als persistentes Schemaobjekt erzeugt. Ein StarburstTrigger kann für verschiedene Ereignisse feuern und somit für verschiedene Basisrelationen definiert

werden. Um einen Trigger zu aktivieren, ist es ausreichend, wenn eines der Ereignisse aus der Liste

E1 , ..., En eintritt. Als Ereignis wird die Ausführung der Änderungsanweisungen für Einfügungen,

Löschungen und Modifikationen erkannt. Ein Starburst-Trigger wird nicht unmittelbar bei Eintritt des

Ereignisses gefeuert, sondern erst zum ’rule assertion point’, der immer zum Ende einer Transaktion

oder auch vom Anwender während der Transaktion gesetzt wird.

Zum ’rule assertion point’ wird von der Triggerkomponente der Nettoeffekt der Ereignisse deterministisch ermittelt (Nettoeffekt der Basisfaktenänderungen), die seit dem letzten ’rule assertion point’

eingetreten sind. Für z.B. die Einfügung und Löschung des gleichen Fakts bedeutet dies, dass zum ’rule assertion point’ keine Ereignisse vorliegen, für die Trigger aktiviert werden können. Für die Nettoeffektänderungen werden von der Triggerkomponente die Trigger mengenorientiert gefeuert und

ausgeführt. Mengenorientiert heißt in diesem Zusammenhang, dass ein Trigger für die Ausführung

einer Anweisung einmal feuert, unabhängig davon, wie viele Fakten geändert wurden.

Beim Aktivieren eines Triggers werden keine Variablenbindungen für die optionale Bedingung (IF)

und die Aktionen (THEN) des Triggers erzeugt (keine Instanziierung). Innerhalb der Aktionen und der

Bedingung kann auf den neuen DB-Zustand der Relationen zugegriffen werden. Die Menge der manipulierten Fakten einer Relation liegen in systemintern verwalteten ∆-Mengen (’transition tables’:

INSERTED / DELETED / OLD UPDATED / NEW UPDATED B) vor. Auf die Transitionsrelationen

kann im Aktions- und Bedingungsteil des Triggers lesend zugegriffen werden.

Die optionale PRECEDES-Klausel bietet die Möglichkeit, eine partielle Ordnung für eine Menge von

Triggern zu definieren (Prioritäten). Der Trigger G wird vor den Triggern G1 ,...,Gm ausgeführt. Sind

keine Prioritäten definiert, feuern die Trigger in beliebiger Reihenfolge. Sind alle relevanten Trigger

für ein Ereignis Ei gefeuert, wählt die Triggerkomponente den Trigger G aus, der über keinen aktivierten Vorgänger verfügt. Bevor G ausgeführt wird, wird die Bedingung F der IF-Klausel ausgewertet.

Ist F nicht erfüllt, so wird G nicht ausgeführt, und der nächste aktivierte Trigger wird ausgewählt.

Bricht die Ausführung einer triggerausgeführten Aktion fehlerhaft ab, so wird die gesamte Transaktion zurückgerollt.

Kapitel 3

Materialisierte Sichten

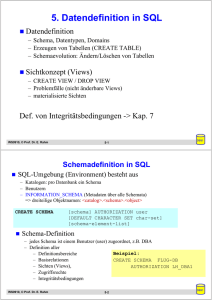

Sichten sind aus mehreren Gründen für konventionellen Datenbanken sehr nützlich. Die externe Ebene

der Sichten repräsentiert die Interessen der Datenbankanwender. Sichten können auch zur Durchführung der Datensicherheit gebraucht werden. In großen Unternehmen werden z.B. Namen und Rollen

aller Angestellten in einer Datenbank gespeichert und ihre Zugriffsrechte auf Daten verwaltet. Dabei sollte die persönliche Daten, wie ihre Gehälter, aus Gesichtspunkten des Datenschutzes nicht zu

sehen sein. In solchen Situationen kann eine Sicht definiert werden, die nur die Attribute der Angestelltenrelation selektiert, welche allen Angestellten mitgeteilt werden dürfen. Die Rechte, die Sichten

durch Anfragen nutzen zu können, können allen Angestellten erteilt werden und die vertraulichen Informationen können dabei geschützt sein. Eine andere nützliche Anwendung der Sichten ist es, dass

sie den Anwendern eine Schnittstelle zu Verfügung stellen, welche die Aufnahme und Nutzung der

Datenbanken in der realen Welt wahrnehmbarer macht.

Die Aussage, dass Sichten nur vorteilhaft sind, ist nicht unbestritten, weil sie zu jeder Referenzierung

neu berechnet werden müssen. Inhalte der Sichten können in einer Datenbank materialisiert werden,

dabei werden die Sichten gespeichert und bei der Abfragebeantwortung genutzt. Diese Idee der materialisierten Sichten geht auf [SB75] und [SS82] zurück mit dem primärem Ziel, die Effizinz des

Datenbanksystems zu verbessern. In [SB75] beinhalten die materialisierte Sichten Zeiger, um schnellen Zugriff auf Daten zu implementieren. In [SS82] war die Idee, Joins vorauszuberechnen und ihre

Ergebnisse als materialisierte Sichten zu speichern, um eine bessere Effizienz zu erzielen.

Eine materialisierte Sicht ist eine Sicht, deren Inhalt, wie bei einer Basis-Relation, in der Datenbank

gespeichert wird. Dieser Vorgang wird Materialisierung genannt. Die materialisierte Sicht ist also

eine Art Cache für den Inhalt der Sicht. Anfragen an eine materialisierte Sicht können dann direkt auf

dem Inhalt dieses Caches berechnet werden als wäre die Sicht eine Basisrelation. Da die Sicht nicht

19

3. Materialisierte Sichten

20

jedesmal neu berechnet werden muß und die Anfragen nicht, wie oben beschrieben, zu komplexeren

Anfragen ergänzt werden müssen, ist der Zugriff auf eine materialisierte Sicht dadurch wesentlich

schneller.

Eine materialisierte Sicht wird meistens so lange in der Datenbank gehalten, wie auf sie zugegriffen

wird. Das heißt, dass die gespeicherten Daten einer materialisierten Sicht erst gelöscht werden, wenn

auf die Sicht für einen gewissen Zeitraum nicht zugegriffen wurde. Wie lang dieser Zeitraum sein

sollte, hängt von der Zeit ab, die benötigt wird, um die Sicht neu zu berechnen, und natürlich von dem

zur Verfügung stehenden Speicherplatz. Ein Wert für die Speicherdauer kann etwa vom Administrator

festgelegt oder vom System automatisch abgeschätzt werden.

Des weiteren können in einer Sichtenmaterialisierung Index-Strukturen aufgebaut werden, die den

Zugriff weiter beschleunigen. Materialisierung reduziert den Berechnungsaufwand bei wiederkehrenden Anfrageteilen.

Der Vorteil, der sich aus materialisierten Sichten ergibt, ist die schnellere Antwortzeit, besonders

bei hoher Anfragerate und hoher Komplexität der Anfragen, da das Ergebnis nicht neu berechnet

werden muß, sondern nur die gespeicherten Tupel abgerufen werden. Die Nachteile sind zusätzliche

Kosten für die Speicherung (redundante Struktur) und die Pflege der materialisierten Sichten bei einer

Änderung von Basisrelationen.

Einige Faktoren zur Beurteilung der Nutzung von bereits existierende materialisierten Sichten:

• Zeit des letzten Zugriffs

• Referenzierungshäufigkeit

• Größe der materialisierten Sicht

• Kosten, die durch eine Neuberechnung oder Aktualisierung der materialisierten Sicht verursacht

wurden

• Anzahl der Anfragen, die in der Vergangenheit mit dieser Sicht hätten beantwortet werden können oder beantwortet worden sind

• Anzahl der Anfragen, die prinzipiell mit dieser Sicht beantwortet werden können

Diese Faktoren gehen unterschiedlich gewichtet in die Berechnung des Nutzwertes einer materialisierten Sicht ein. Mit Hilfe des Nutzwertes werden die bereits materialisierten Sichten sortiert und je

nach Bedarf werden die Sichten mit dem geringsten Nutzen verdrängt.

3. Materialisierte Sichten

21

Das Konzept der Materialisierung von abgeleiteten Daten und ihre Anpassung in Rahmen der Änderungen ist zum ersten Mal in [KP81] erschienen. Der Begriff view materialization oder materialized

view ist in [SI84] eingeführt worden. Laut Jeffrey Ullman1 ist der Ausdruck materialized view ein

Widerspruch in sich. Jedoch ist diese Bezeichnung in neuen Datenbanktechnologien weit verbreitet

(wie z.B. in Data Warehouse, Data Interation, Data-Cube Systems, etc.) und ist weitgehend akzeptiert.

3.1

3.1.1

Auswahl und Anwendung materialisierter Sichten

Das allgemeine Problem der Auswahl

In der Literatur werden eine Reihe verschiedenen Algorithmen zur Auswahl der zu materialisierenden

Sichten vorgestellt. Wenn viele Anfragen über Basisrelationen gemacht werden, können einige temporäre Ergebnisse (Sichten) für mehrere Anfragen genutzt werden. Auf den Resultaten werden durch

weitere Operationen die Anfragen beantwortet. Werden alle Sichten materialisiert, entstehen sehr geringe Kosten für den Anfrageprozess. Es werden dann nur die gespeicherten Tupel abgerufen. Jedoch

die Pflege dieser Sichten ist sehr aufwendig. Materialisiert man keine Sichten, so kommen zwar keine

Kosten für die Anpassung zustande, aber der Anfrageprozess ist nur mit sehr hoher Rechenleistung

zu bewältigen. Es muss eine geeignete Auswahl der materialisierten Sichten gefunden werden. Dabei

sollen die Kosten für die Bearbeitung der Anfragen und Anpassung der Sichten minimal sein.

Statische Auswahl materialisierter Sichten

Eine Möglichkeit der Auswahl einer möglichst optimalen Menge an Materialisierungen ist die statische Auswahl. Das heißt, die Auswahl der materialisierenden Sichten findet zu einem bestimmten

Zeitpunkt statt, der von einem Algorithmus oder dem Administrator bestimmt wird. Der Nachteil ist,

dass das aktuelle Anfrageverhalten nicht in die Berechnung einbezogen wird, sondern höchstens nur

die Informationen, welche Anfragen in der Vergangenheit auftraten.

Das statische Auswahlverfahren basiert auf der Annahme, dass die ausgewählten Sichten in einen

gewissen Zeitraum (z.B. Nachts) materialisiert und aktualisiert werden. Durch statische Materialisierung erfolgen große Leistungssteigerungen, allerdings entstehen durch ihre alleinige Anwendung

auch Nachteile:

1

In der Einleitung von [GM99]

3. Materialisierte Sichten

22

• Oft werden bestimmte Zusammenhänge gezielt untersucht, so dass zu einem bestimmten Zeitpunkt ähnliche Anfragen gestellt werden. Die Folge ist, dass das typische Anfragemuster aus

mehreren nicht vorhersehbaren Anfragen besteht.

• Wenn die Daten häufig verändert werden, veralten die materialisierten Sichten schnell, was

einen erhöhten Aktualisierungsaufwand zur Folge hat.

• Das Anfragemuster ändert sich beständig, so dass ständig eine Anpassung der materialisierten

Sichten stattfinden müsste.

• Aufgrund der zunehmenden Globalisierung, kann es vorkommen, dass aus unterschiedlichen

Zeitzonen auf ein Data-Warehouse zugegriffen wird. Dadurch ergibt sich kein Zeitraum mehr,

indem die Sichten materialisiert werden können, ohne das Anfrageverhalten zu beeiträchtigen.

Dynamische Auswahl materialisierte Sichten

Das Problem der statischen Auswahl von materialisierten Sichten, dass nur das Anfrageverhalten aus

der Vergangenheit zur Entscheidung genutzt wird, welche Sichten zu materialisieren sind, macht es

erforderlich Verfahren zur Anpassung der Sichten an das aktuelle Anfrageverhalten zu ergänzen. Das

heißt Ergebnisse aus einer vorangegangenen Anfrage werden als Grundlage bei der nächsten Anfrage

genutzt. Deshalb ist es nötig einen Teil der Anfrageergebnisse in einem reservierten Speicherbereich

zur Wiederverwendung zu materialisieren. Für dieses Verfahren gibt es noch einen weiteren Vorteil.

Oft sind die Ergebnismengen von Anfragen relativ klein, so dass eine Zwischenspeicherung nicht

übermäßig viel Platz benötigt, aber eine deutliche Beschleunigung einer Folge von Anfragen ermöglicht.

3.1.2

Einsatzgebiete von materialisierten Sichten

Materialisierte Sichten finden in vielen Datenbankgebieten Anwendung. Eine komplete Anzahl der

Anwendungen ist in [GM99] gegeben. Dieses Unterkapitel stellt eine Übersicht der Top-Anwendungen

materialisierter Sichten zusammen.

Schnellzugriff Jede Anfrage kann auf einen simplen Zugriff einer Sichtenmaterialisierung reduziert

werden. Hierdurch wird auch die Belastung des Rechenprozessors und der Festplatten vermindert.

3. Materialisierte Sichten

23

Abbildung 3.1: Anwendung materialisierter Sichten in DWH

Data Warehouse Informationen können gesammelt werden ohne jede Datenbank in das Data Warehouse kopieren zu müssen. Anfragen werden beantwortet, wobei auf den Zugriff auf die Quelldatenbank verzichtet werden kann, der beschränkt oder sehr teuer sein kann.

Chronicle Systems Banken, Handels- und Buchhaltungssysteme gehen täglich mit zusammenhängenden Strömen von Transaktionsdaten um. Solche Systeme speichern Reihen von Tupeln in

zeitlicher Ordnung ab. Sie können daher sehr groß werden und jenseits jeder Datenbankkapazität liegen. Sichtenmaterialisierungen beantworten Anfragen nach den wichtigsten Informationen ohne auf das umfangreiche und schnellwachsende Chronicle System zugreifen zu müssen.

Eine Sichtenmaterialisierung könnte z.B. die Kontostände der Kunden liefern.

Datenvisualisierung Visualiserungsanwendungen zeigen Sichten über Daten einer Datenbank. Ändert der Anwender die Sichtendefinition, muss die Anzeige der Daten entsprechend angepasst

werden. Mit steigender Erfahrung des Anwenders wächst auch sein Verständnis für die angezeigten Datensammlungen. Dank der Sichtenmaterialisieurng kann das System auf solche

interaktiven Änderungen dynamisch reagieren.

Mobile Systeme Mobile Anwendungen verfügen meist über eingeschränkte Möglichkeiten zur Abfrage größerer Datenmengen. Die Geräte auf denen sie laufen verändern ihre Position und es

werden abhängig von ihrem Ort und der Umgebung Anfragen generieren. Hier ist es sinnvoll,

die übertragenen Daten minimal zu halten und nur die Veränderungen neuzuberechnen.

3. Materialisierte Sichten

24

Integritätsprüfung Die meisten statischen Integritätsbedingungen können als eine Menge von Sichten so repräsentiert werden, dass eine nicht leere Sicht auf eine verletzte Bedingung hinweist.

Methoden der Sichtenanpassung können dazu verwendet werden, die Konsistenzbedingungen

inkrementell zu überprüfen, wenn Daten einer Datenbank verändert wurden.

Anfrageoptimierung Zur Optimierung beliebiger Anfragen können die Sichten der Sichtenmaterialisierung verwendet werden.

3.2

Anpassung materialisierter Sichten

Nach der Erzeugung mehrerer materialisierter Sichten stellt sich die Frage, wie diese bei einer Änderung der Detaildaten möglichst effizient aktualisiert werden können. Hinzu kommt das Problem, dass

aufgrund von Redundanzen zwischen verschiedenen Sichten meistens mehrere Sichten gleichzeitig

aktualisiert werden müssen. Die Daten der materialisierten Sicht können unter bestimmten Bedingungen, z.B. Änderungen in den zugrunde liegenden Relationen, ungültig werden.

Es existieren oft viele verschiedene Verfahren und Ansätze zur Pflege der materialisierten Sichten.

Alle Verfahren haben ihre Vor- und Nachteile. Die Frage ist, ob ein kostenbasiertes Modell entwickelt

werden kann, das situationsbedingt abschätzen kann, welches Verfahren zu einem bestimmten Zeitpunkt das günstigste ist und dieses anwendet. Die Sichtenanpassung wird durchgeführt, weil es sich

gezeigt hat, dass die Berechnung der Änderungen und ihre Durchführung in den meisten Fällen kostengünstiger ist als die komplette Neuberechnung.

Mit der sogenennten Re-Materialisierung (Neuberechnung) werden die Sichten auf den aktuellen

Zustand der Datenbank gebracht. Obwohl Re-Materialisierung einfach zu implementieren ist, ist sie

meistens kostenintensiv [GM95]. Eine Alternative ist die inkrementelle Sichtenanpassung.

3.2.1

Techniken der Aktualisierung

Rematerialisierung Komplettes Löschen und Neuberechnen der Sicht nach der Änderung.

Inkrementelle Aktualisierung Bei inkrementeller Sichtenanpassung wird durch Algorithmen, die

die zugrunde liegenden Basisrelationen benutzen, versucht, unnötige Neuberechnungen der

kompletten Sicht zu vermeiden und an Stelle dessen nur notwendige Änderungen in der Sicht

durchzuführen.

Autonome Aktualisierbarkeit Wenn eine materialisierte Sicht nur mit Hilfe der Definition der Sicht,

der Änderung der Basisrelation, sowie der bestehenden Instanz der Sicht eine inkrementelle

3. Materialisierte Sichten

25

Aktualisierung beim Einfügen, Löschen oder Änderung der Basisrelation durchführen kann, so

spricht man von autonomer Aktualisierbarkeit.

Selbstpflege (self-maintenance) Neuberechnung ohne Benutzung der Datenquelle.

3.2.2

Klassifizierung von Aktualisierungsalgorithmen

Es gibt verschiedene Algorithmen zu jeder Aktualisierunsmethode. Die Algorithmen unterscheiden

sich am deutlichsten in der Ausdrucksfähigkeit der verwendeten Sprache für die Sicht-Definition

(SPJ-View, SQL, ...), in der Verwendung von Schlüsseln und in der Behandlung von Einfüge- und

Löschoperationen (getrennt oder im gleichen Durchlauf). Die Effizienz der Algorithmen hängt von

verschiedenen Einflussfaktoren ab:

1. Die Menge der zur Verfügung stehenden Informationen hat Einfluss auf die Auswahl eines

Algorithmus. Allerdings muss die Definition einer Sicht und ihre Ausprägung immer bekannt

sein. Auch wichtig ist die Frage, ob ein Zugriff auf die Basisrelationen überhaupt möglich ist,

beziehungsweise wenn nicht, welche Integritätsbedingungen existieren.

2. Je komplexer die möglichen Anfragekonstrukte zur Definition einer Sicht sind, desto schwieriger wird es auch diese Sichten zu aktualisieren.

3. Wichtig ist, welche Modifikationstypen von den Algorithmen verarbeitet werden können. Im

einfachsten Fall sind es nur Einfüge- und Löschoperationen, die verwendet werden. Änderungsoperationen werden demnach wie eine aufeinander folgende Einfüge- und Löschoperation behandelt.

4. Ein entscheidender Parameter ist die Granularität der Aktualisierung, also ob Sichten einzeln

aktualisiert werden können, was eine sehr flexible Aktualisierung ermöglicht oder ob im Extremfall immer die ganze Datenbank auf einmal aktualisiert werden muss.

5. Der Zeitpunkt der Aktualisierung

Sofortige Aktualisierung Bei einer Änderung der Basisdaten werden gleichzeitig die abgeleiteten Daten, wie z.B. im Data-Warehouse-System, aktualisiert. Der Vorteil ist, dass das

Data-Warehouse immer aktuell ist, allerdings entstehen hohe Kosten durch die häufigen

Modifikationen.

Verzögerte Aktualisierung Eine materialisierte Sicht wird erst dann aktualisiert, wenn auf sie

zugegriffen wird. Dadurch werden unnötige Aktualisierungen vermieden, allerdings kann

Wartezeit entstehen, wenn auf mehrere veraltete Sichten zugegriffen wird.

3. Materialisierte Sichten

26

Snapshot Aktualisierung Die Aktualisierung erfolgt asynchron nach Änderungen der Basisdaten. Der Zeitpunkt kann nach anwendungsspezifischen Kriterien ausgewählt werden,

allerdings wird der Zugriff auf veraltete Daten in gewissen Maßen toleriert.

3.2.3

Ungeklärte Probleme bei der Sichtenanpassung

Es gibt eine Reihe allgemein Probleme, die bei der Aktualisierug der Sichten vorkommen. Hier werden einige wichtigeFragen, die diese Probleme beschreiben, aufgelistet:

• Sollen die Sichtenmaterialisierungen vor oder nach Abschluss (commit) der Transaktion, die

die Basisrelation aktualisiert, gepflegt werden?

• Ist die Sichtenpflege als Bestandteil der Transaktion zu sehen?

• Muss die Sichtenpflege nach jeder einzelnen Aktualisierung oder erst nach allen Updates erfolgen?

• Soll die Sichtenpflege automatisch (z.B. regelbasierend) oder benutzergesteuert eingeleitet werden?

• Lässt sich ein kostenbasiertes Modell entwickeln, das zwischen verschiedenen Lösungswegen

abwägt und das günstigste auswählt?

• Bleibt die Frage nach der Komplexität der Sichtenpflege unbeantwortet?

Obengenannte Fragen tauchen oft bei der Implementitierung und Zusammenführung der Sichten in

einem Datenbanksystem auf.

3.3

Inkrementelle Anpassung materialisierter Sichten

Inkrementelle Anpassung verlangt, dass die Änderungen auf den Basisrelationen benutzt werden, um

die Änderungen der Sicht zu berechnen. Deshalb behandeln die meisten Aktualisierungstechniken

die Sichtdefintion als mathematische Formel und führen eine Differentation durch, um einen Ausdruck für die Änderung der Sichten zu erhalten. Die Idee bei der inkrementellen Aktualisierung ist

es, erst festzustellen, welche der Detaildaten sich geändert haben und dann diese Änderungen in den

materialisierten Sichten nachzuvollziehen. Anders ausgedrückt: Berechnung des neuen Zustands der

materialisierten Sichten aus dem alten Zustand dieser Sichten und der durchgeführten Änderung der

Basisrelation. Der ganze Prozess läuft wie folgt ab:

3. Materialisierte Sichten

27

Abbildung 3.2: Problemraum der inkrementellen Sichtenanpassung

• Update der Basisrelation

• Nachricht an die Sicht über das Update

• Anfragen der Sicht an andere Basisrelationen, ob Aktualisierungen notwendig sind

• Aktualisierung der Sicht

3.3.1

Klassifikation des Sichtenanpassungproblems anhand von vier Dimensionen

Es sind detaillierte Kriterien erforderlich, um die existierende Literatur zur inkrementellen Sichtenanpassung zu charaktersieren bzw. zu vergleichen. In [GM95] und [GM99]werden einige Ansätze vorgestellt, um eine Klassifikation des Problems anhand von mehreren Dimensionen zur Verfügung zu

stellen, die in der Abbildung 3.3 gezeigt werden.

Information Die Menge der für die Sichtenanpassung verfügbaren Informationen

Datenmanipulationssprache Mit welchen Modifikationen kann die Anpassungmethode umgehen

Sichtendefinitionssprache In welcher Sprache wird die Sicht ausgedrückt

Instanzen Für welche Instanzen der Datenbank ist der Anpassungsalgorithmus anwendbar

3.3.2

Inkrementelle Sichtenanpassungsalgorithmen auf Basis der vollständigen Informationen

Im Falle der vollständigen Informationen stehen vier bekannte Algorithmen zu Verfügung. Die folgenden Algorithmen sind für rekursive Sichten vorgestellt worden:

3. Materialisierte Sichten

28

Abbildung 3.3: Problemraum in 3D

Deletion and Rederivation (DRed) Algorithmus DRed nimmt eine zu große Schätzung der zu löschenden Tupel vor und korrigiert diese Liste um die Tupel, für die alternative Ableitungen

existieren. Für die Menge der einzufügenden Tupel reicht die Auswertung der teilweise aktualisierten Sichtenmaterialisierungen.

Propagation / Filtration (PF) Algorithmus Der PF-Algorithmus arbeitet analog zu DRed, die Änderungen werden aber für alle Basisrelationen einzeln und schleifenweise berechnet.

Kuchenhoff Algorithmus Hier werden die Unterschiede nachfolgender Datenbankzustände durch

Ableitungen rekursiv neu berechnet. Auch Kuchenhoff arbeitet ähnlich wie DRed, verwirft aber

keine mehrfach vorkommenden Ableitungen, die keine Auswirkungen auf die Sicht haben.

Urpi-Olive Algorithmus Verwendet ein Modell mit Existenzquantoren, um Änderungen der Basisrelationen in geänderte Sichten zu übersetzen.

Alle Algorithmen für rekursive Sichten können auch für nichtrekursive Sichten eingesetzt werden.

Darüber hinaus sind bestimmte Algorithmen extra für nicht rekursive Sichten implementiert worden:

3. Materialisierte Sichten

29

Counting-Algorithmus Pflegt mittels eines Zählers über die Ableitungen jedes Tupels der Sicht

Einfüge- und Löschoperationen ein.

Algebraic Differencing Relationale Ausdrücke berechnen Änderungen der Sicht ohne Redundanz.

Für jede Sicht werden die Änderungen mit je einer Sicht für das Einfügen und für das Löschen

ermittelt.

Ceri-Widom behandelt ausgewählte SQL-Sichten ohne Duplikate, Aggregation oder Negation getrennt von SQL-Sichten, deren Attribute den Schlüssel der Basisrelation durch eine Funktion

bestimmen.

Einen Algorithmus zu finden, der im Falle der unvollständigen Informationen aller Dimensionen umfasst, ist noch ein großes Problem.

Verwendung unvollständiger Informationen kann in verschiedenen Formen auftreten:

Nullinformation Query independent of update bzw. irrelevant update problem

Self-Maintenance Sicht kann bei jeder Modifikation der Basisrelation sich selbst anpassen

Teil-Referenz Materialisierte Sicht und Teile der Basisrelation sind vorhanden

• Chronik: Sicht ist ohne geänderte Relation verfügbar

• Change-Reference-maintainable: Nur die Sicht und die geänderte Relation sind verfügbar

Kapitel 4

Ausgewählte Methoden zur

inkrementellen Sichtenanpassung

In diesem Kapitel werden drei Strategien zur Anpassung materialisierter Sichten in relationalen Datenbanken vorgestellt, die später verglichen werden sollen:

Die Methode von Gupta/Mumick/Subrahmanian Ein deduktiver Implementierungsansatz ([GMS93])

Die Methode von Ceri/Widom Eine triggerbasierte Implementierung ([CW91])

Die Methode von Manthey Ein alternativer deduktiver Implementierungsansatz1 ([Man03])

Im folgenden werden diese drei Methoden kurz als GMS-, CW- bzw. MU-Methode bezeichnet.

4.1

Die GMS-Methode

Dieses Propagierungsverfahren ist für ableitbare Änderungen entwickelt worden. Es ist eine DeltaPropagierungsmethode, die Algorithmen zur Aktualisierung der materialisierten Sichten in relationalenund deduktiven-Datenbanken präsentiert. Die Implementierung dieses Verfahrens wird als passiv bezeichnet, da die induzierten Änderungen durch interne Deduktionsregeln abgeleitet werden.

Sicht-Definitionen (Regeln) können in SQL oder Datalog geschrieben werden, wobei in [GMS93]

Datalog bevorzugt wird. Regeln dürfen auch UNION, stratifizierte Negation, Aggregation, lineare

1

auch Magic Updates-Methode genannt

30

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

31

Rekursion und allgemeine Rekursion beinhalten. Dieses Verfahren erfordert Zugriff auf alle Basistabellen für alle notwendigen Operationen, was höheren Aufwand bedeutet. Dieses Verfahren lässt

auch Duplikate zu, dabei ist die Anzahl der Ableitungen jedes Tupels relevant. Zur Eliminierung der

Duplikate wird hier ein spezieller Unionoperator definiert.

Im Compilierungsteil der Methode, werden Regeln (Sichten) in Delta-Regeln transformiert:

compilieren

R −−−−−−−→ ∆R

Durch Regelcompilierung wird ein spezielles Inferenzverfahren erzielt, der Interpreter. Algorithmen,

die in [GMS93] angewendet werden, entsprechen diesem Interpreter. Dabei sind nur Änderungen

in der Form von Einfügungen und Löschungen als Input den Algorithmen gegeben. Modifikationen

werden hier als Einfügung des neuen und Löschung des alten Fakts durchgeführt. Mit Hilfe von DeltaRegeln und Fakten (Basisfakten, Deltafakten, materialisierte Fakten) werden abgeleitete Deltafakten

erzeugt.

Die Autoren schlagen zwei inkrementelle Sichtenanpassungsalgorithmen vor:

1. Counting-Algorithmus: Arbeitet mit nichtrekursiven Sichten, die auch Negation und Aggregation beinhalten können.

2. Delete and Rederivation-Algorithmus (DRed): Ist für rekursive Sichten entwickelt worden

und lässt auch Negation und Aggregation zu.

Beide Algorithmen benutzen den Sichtinhalt um ∆-Regeln zu produzieren, um die Änderungen der

Basisdaten an die Sichten anzupassen. Die Algorithmen können sowohl rekursive als auch nichtrekursive Sichten bearbeiten. Für rekursive Sichten kann der Counting-Algorithmus nur effektiv arbeiten,

wenn jedes Tupel eine beschränkte Anzahl von Ableitungen hat. Die Operationen, die Basisrelationen

ändern, sind Einfügen und Löschen von Tupeln. In [GMS93] wird die Datalog-Syntax wegen ihrer

Prägnanz bevorzugt. In Abbildung 4.1 wird die Architektur der Methode nach [GMS93] gezeigt. Der

Delta-Fakt-Generator ist ein iterierter Algorithmus mit terminierender Schleife, der endliche Mengen bearbeitet. Die generierten Delta-Regeln werden mit der Menge der Fakten und Basisänderungen

dem Algorithmus übergeben, um induzierte Änderungen zu erzeugen. Die Menge der abgeleiteten

Deltafakten wird vor dem Ablauf des Prozesses geleert. Die Änderungen werden in der untersten

Schicht des Abhängigkeitsgraphen eingesetzt. Während der bottom-up-Propagierung wird die Anzahl

der Ableitungen pro Fakt in jeder Schicht berechnet. Abgeleitete Relationen in den beiden Zuständen

(neu und alt) werden benötigt, um Deltafakten zu produzieren.

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

32

Abbildung 4.1: Struktur der GMS-Methode

4.1.1

Counting-Algorithmus

Der Counting-Algorithmus ist zur Aktualisierung der materialisierten Sichten in relationalen und deduktiven Datenbanken entwickelt worden. Er hat eine Multimengensemantik, das heißt nicht, dass

die Relationen eine Menge von Tupeln sind, sondern es können mehrere Ableitungen eines Tupels

vorkommen. Änderungen werden als eine Menge betrachtet (Transaktion), die in der Semantik der

deterministischen Transaktionen alle ausgeführt werden müssen bis ein neuer Datenbankzustand erreicht ist.

Sichere und stratifizierte Negation und Aggregation (z.B. Summierung und Durchschnitt von Attributen) sind in den Sichtendefinition erlaubt. Da es in rekursiven Sichten eine unendliche Anzahl von

verschiedenen Herleitungspfaden geben kann, ist dieser Algorithmus nur auf nichtrekursive Sichten

anwendbar.

Der Algorithmus zählt die unterschiedliche Herleitungen eines Tupels t in der Sicht und speichert diesen Wert zusätzlich in der materialisierten Sicht als count(t) ab. Counts sind eine Art Iterationszähler

für Deltafakten. Ein Tupel t wird mit der Anzahl seiner Ableitungen in folgender Form geschrieben:

t ∗ i, wobei i positiv (bei Einfügungen) oder negativ (bei Löschungen) sein kann.

Bei Änderungen werden diese Werte von den Basisprädikaten ausgehend aktualisiert, d.h. Counts

werden während der bottom-up-Propagierung berechnet. Wenn der Wert 0 ist (d.h. keine Basisrelation

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

33

leitet dieses Tupel ab), wird das zugehörige Tupel gelöscht. Nach [Mum91] bezeichnet man count(t)

als die Anzahl des Vorkommens eines Tupels t in positiven Programmen2 berechnet. Die Kosten zur

Berechnung des Counts können bei nichtbeschränkter Anzahl der Ableitungen eines Tupels erheblich

steigen. Bei nichtrekursiven Sichten kann die Anzahl der Ableitungen für jedes Tupel mit einem Minimum an Kosten oder fast keinen Kosten berechnet werden. Der Algorithmus funktioniert in beiden

Fällen der Duplikat-Präsentation, d.h., wenn es mehrere Ableitungen für jedes Tupel gibt oder wenn

mehrere Kopien eines Tupels existieren. Bei diesem Algorithmus wird kein Effektivitätstest im Sinne der Existenz mehrerer Ableitungen durchgeführt, sondern sie werden wie oben erläutert gezählt.

Zusammengefasst kann man die Vorgehensweise wie folgt darstellen:

Bei der ersten Materialisierung wird die Anzahl der alternativen Ableitungswege für jeden Fakt ermittelt. Ist ein später einzufügender Fakt noch nicht vorhanden, so wird der Fakt mit count = 1 eingefügt.

Bei bereits vorhandenen Fakten wird der Zählerwert nur entsprechend aktualisiert. Physisch gelöscht

wird ein Fakt erst, wenn count = 0 ist.

UNION-Operator

U

: Duplikat-Test

Die Mengenoperation vereinigt zwei Mengen und beachtet dabei auch die Counts der einzelnen Tupel.

Die Delta-Regeln für ein Prädikat werden aus den Original-Regeln durch Ersetzen eines Literals im

Rumpf durch das entsprechende Delta-Literal erzeugt.

Jedes Tupel kommt mit einem Count (Anzahl seiner Ableitungen) vor. Für zwei Mengen s1 und s2 :

s1 ] s2 (gelesen: s1 und s2 ) mit Counts c1 und c2 , wird der Operator wie folgt definiert:

• Falls ein Tupel t nur in einer der Mengen s1 oder s2 mit dem Count c auftritt, dann kommt das

Tupel t mit Count c in s1 ] s2 vor.

• Falls ein Tupel t in s1 und s2 mit Counts c1 und c2 vorkommt und c1 + c2 6= 0, dann ist Count

von s1 ] s2 gleich c1 + c2 , sonst (d.h. c1 + c2 = 0) erscheint t nicht in s1 ] s2

Folglich ist P ν = P ] ∆(P ). Dieser Join-Operator ist also eine Neudefinition für Relationen mit

Counts: Der Count des Ergebnistupels ergibt sich aus dem Produkt der Counts der kombinierten

Tupel, wenn zwei oder mehr Tupel durch Join kombiniert werden. Die Korrektheit des CountingAlgorithmus garantiert, dass kein Tupel weder in P noch in P ν einen negativen Count hat. Die Tupel

in der Änderungsrelation ∆(P ) können negative Counts haben.

Durch Verwendung dieses Operators werden Mehrfachableitungen verhindert.

2

Ein positives Programm besteht aus Regeln und Fakten ohne Negation

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

34

Schichten-Nummer (SN) und Regel-Schicht-Nummer (RSN)

Falls ein reduzierter Abhängigkeitsgraph (RDG)3 auf einem maximal stark zusammenhängenden Teilgraph (SCC)4 aufgebaut wird, entsteht ein Schichten-Graph und man redet von der Stratum Number

(SN). Knoten des Abhängigkeitsgraphen bezeichnen die Prädikate und die Kanten die Regeln. Wir

betrachten dazu ein Beispiel mit der Basisrelation link und abgeleitete Relationen hop und tri-hop, die

wie folgt definiert sind: Ein gerichteter Pfeil vom Knoten link zum Knoten hop (s. Abbildung) sagt

aus, dass das Prädikat hop vom Prädikat link abhängig ist, d.h. link ist ein Bestandteil des Rumpfes

der Regel mit dem Prädikat hop im Kopf. Eine topologische Sortierung, die auf den RDG aufgebaut

ist, sorgt für die SN jedes Knotens.

Die bottum-up-Propagierung fängt bei der untersten Schicht an. In jeder Schicht werden die Duplikate

berechnet, dann erfolgt die Elimination der Duplikate. So wird für jedes Tupel in der Schicht der Count

bestimmt. Bei der Bestimmung des Counts für eine höhere Schicht werden die Counts von der unteren

Schicht nicht mitgerechnet. Dies wird im Paragraph Optimierung näher erläutert.

Definition: ∆(P )

∆(P ) ist ein neu abgeleitetes Prädikat, dass die Änderungen in einer abgeleiteten Relation P beinhaltet, wenn Änderungen in Basisrelationen stattfinden. ∆(P ) = {ab ∗ 4, mn ∗ −2} bedeutet z.B., dass

für das Tupel p(a, b) vier Ableitungen eingefügt und zwei Ableitungen des Tupels p(m, n) gelöscht

werden.

3

4

reduced dependency graph

strongly connected component

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

35

P ν verweist auf die Relation P nach der Änderung (P -Neu, Aktueller Zustand). Dabei gilt folgende

Regel:

P ν = P ] ∆(P )

Die nächste Definition beschreibt Regeln, die dieses neu abgeleitete Prädikat mit gegebenen Regeldefinitionen für das abgeleitetes Prädikat p definieren.

Definition: ∆-Regeln

Für jede Regel der Form

(r) : p : −s1 , ..., sn ;

werden n ∆-Regeln ∆(r) erstellt, die das Prädikat ∆(p) definieren:

(∆(r)) : ∆(p) : −sν 1 , ..., sν i−1 , ∆(si ), si+1 , ..., sn

Das ν steht für neu, d.h. neuer Zustand der Datenbank.

Delta-Regeln werden u.a. als Input im Algorithmus ausgewertet, um abgeleitete Fakten zu erzeugen.

Deltarelationen hängen vom Vorzustand und anderen Deltas ab. Interne Deltarelationen protokollieren

Basisdatenänderungen und induzierte Änderungen. Die Auswertung der Restliterale (Residuen) müssen in bestimmten Zuständen erfolgen. Wenn sie nur im alten Zustand ausgewertet werden, werden

einige Folgen von Löschungen nicht berücksichtigt. In einer Delta-Regel erfolgt die Auswertung der

Restliterale bei Löschungen im neuen Zustand (links vom Delta-Literal), und bei Einfügungen im alten Zustand (rechts vom Delta-Literal). Für Residuenauswertungen und Effektivitätstests in [GMS93]

wird ein pessimistischer Ansatz zugrunde gelegt, bei dem ein neuer Zustand simuliert wird.

Transformation der ∆-Regeln

Wir betrachten ein einfaches Beispiel, um eine Vorstellung von dem Counting-Algorithmus zu bekommen.

Gegeben ist eine Sichtdefinition für eine abgeleitete Relation p aus Basisrelationstermen a und b. Die

Relation p wird wie folgt aus Tupeln A und B berechnet:

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

36

(v): p(X, Y ) : − a(X, Z), b(Z, Y );

Wenn die Basisrelationen a und b geändert werden, müssen die Tupel in der abgeleiteten Relation

p auch geändert werden. Die neuen Mengen Aν und B ν werden als A + ∆(a) bzw. B + ∆(b) geschrieben. ∆(a) und ∆(b) können beide eingefügte und gelöschte Tupel mit positiven bzw. negativen

Counts enthalten. Die neue Menge der Fakten für p wird durch folgendes Programm berechnet:

pν (X, Y ) : − aν (X, Z), bν (Z, Y );

Wenn man a durch (a + ∆(a)) und b durch (b + ∆(b)) ersetzt und dann das Distributivgesetz zwischen

Joins mit Unionoperatoren verwendet, kann die Regel aus folgenden vier Regeln gebildet werden:

1. pν (X, Y ) : − a(X, Z), b(Z, Y )

2. pν (X, Y ) : − ∆(a)(X, Z), b(Z, Y )

3. pν (X, Y ) : − a(X, Z), ∆(b)(Z, Y )

4. pν (X, Y ) : − ∆(a)(X, Z), ∆(b)(Z, Y )

Die erste Regel definiert den alten Wert von p. Die restlichen drei Regeln berechnen ∆(p). Daraus

folgt:

∆(p)(X, Y ) : − ∆(a)(X, Z), b(Z, Y )

∆(p)(X, Y ) : − a(X, Z), ∆(b)(Z, Y )

∆(p)(X, Y ) : − ∆(a)(X, Z), ∆(b)(Z, Y )

Die letzten zwei Regeln können unter Verwendung der Formel aν = a ] ∆(a) kombiniert werden:

(v1):

∆(p)(X, Y ) : − ∆(a)(X, Z), b(Z, Y )

(v2):

∆(p)(X, Y ) : − aν (X, Z), ∆(b)(Z, Y )

Die obigen zwei Regeln werden in folgendem Beispiel verwendet:

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

37

A = {12, 16, 23, 24}

B = {28, 68, 39}

P = {18 ∗ 2, 29}

∆(a) = {16 ∗ −1}

∆(b) = {68 ∗ −1, 49, 47}

Aν = {12, 23, 24}

B ν = {28, 39, 49, 47}

Aus der Substitution der Werte von ∆(a) und ∆(b) in den Regeln v1 und v2 ergeben sich die Werte

für ∆(p) und pν :

Aus der Regel v1 folgt ∆(p) = {18 ∗ −1}

Aus der Regel v2 folgt ∆(p) = {29, 27}

pν = p ] ∆(p) = {18 ∗ 2, 29} ] {18 ∗ −1, 29, 27} = {18, 29 ∗ 2, 27}

Dies ist genau das Ergebnis aus dem Join der Mengen Aν und B ν .

Delta-Regeln können auf mehr Basisrelationen verallgemeinert werden:

∆(p) : − ∆(a), b, c

∆(p) : − aν , ∆(b), c

∆(p) : − aν , bν , ∆(c)

Dieses Beispiel der Regeltransformation kann nicht ohne weiteres auf rekursive Programme übertragen werden.

Pseudo-Version des Counting-Algorithmus

Hier wird eine Basisversion des inkrementellen Sichtenanpassungsalgorithmus für nicht rekursive

Sichten ohne Negation und Aggregation beschrieben. Dieser Algorithmus berechnet Änderungen von

Schicht zur Schicht, wobei immer von der untersten Schicht angefangen wird.

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

38

begin

Input: Menge der Regeln R, Menge der Delta-Regeln, Menge der Fakten der materialisierten

Sichten, Menge der Basisfakten, Menge der Delta Basisfakten

(Alle Regeln sind nicht-rekursiv)

Output: Einfügungen/Löschungen der abgeleiteten Deltafakten

for alle abgeleiteten Prädikate in nichtrekursiven Regeln R do

initialisiere P ν durch P

(P : materialisierte Faktenmenge)

Initialisiere ∆(P ) durch leere Menge

while falls keine Regel ausgewertet ist, werden die abgeleiteten Regeln - angefangen

von der untersten Schicht - ausgewertet do (Die Prädikate sind in einem geschichteten RDG konstruiert und die Counts werden während der buttom-up-Propagierung

berechnet)

for für jede abgeleitete Relation do

berechne die Menge der abgeleiteten Deltafakten ∆(P) anhand der oben definierten Delta-Regel-Definition

(Die Definition wird aus der Regel für abgeleitete Relationen in alten und neuen Zuständen und der Formel

P ν = P ] ∆(P )

gewonnen ;

P ν bezeichnet die Relation P nach der Anpassung der Änderungen in P )

Bezeichne r als ausgewertet

done

done

done

end

Die Regeln sind nach Schichtennummern sortiert, die durch eine topologische Sortierung des Abhängigkeitsgraphen über das gegebene Programm im Algorithmus erzeugt werden.

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

39

Optimierung

Der Counting-Algorithmus berechnet die Anzahl der Ableitungen für jedes Tupel während der bottom-up-Propagierung in einem Datenbanksystem.

Ein Programm, das im Count-Algorithmus benutzt wird, besteht aus einer Menge von Fakten und

Regeln. Die Propagierung der Änderungen zu den Prädikaten in höheren Schichten läuft optimal,

falls die Relation P ν aus Mengen von Änderungen der Relation P zustande kommt. Das ist gegeben,

wenn folgende Optimierungsformel gilt:

∆(P ) = set(P ν ) − set(P )

Für nichtrekursiven Sichten gibt es normalerweise keine Kosten für Duplikatberechnung. Eine nichtrekursive Schicht besteht aus einem einzigen Prädikat, das durch einer oder mehreren Regeln definiert

wird. Jeder Operator wie Join, Select, Project und Union leitet nur ein Tupel für jede Ableitung ab.

Daher ist die Countb-Berechnung für nichtrekusive Sichten effizienter als bei rekursiven Sichten.

Duplikate können in einer Implementierung entweder durch Speichern mehrerer Kopien eines Tupels auftreten oder Speicherung eines Counts für jedes Tupel. In beiden Fällen arbeitet der AlgorithU

mus ohne zusätzlichen Kosten für Duplikatberechnung. Der -Operator im Algorithmus funktioneiert

U

wie ein normaler union-Operator, wenn die Operanden positive Counts haben. Ansonsten ist der Operator äquivalent zu der Multimengendifferenz.

Duplikat-Elimination ist eine kostenintensive Operation. Die Autoren dieser Methode behaupten, dass

zunehmende Duplikat-Elimination keine steigenden Operationskosten zur Folge hat. Der Count eines

Tupels wird nach der Duplikat-Elimination vergeben, und dies wird folgendermaßen berechnet: In

jeder rekursiven Schicht wird erstmal eine totale Duplikat-Berechnung vollzogen und danach werden

Duplikate eliminiert. Daraufhin wird für jedes Tupel der zugehörige Count berechnet. Während der

Berechnung der Counts in der nächst höheren Schicht i + 1 sind die Counts von i oder von den

unteren Schichten nicht erforderlich. Jedes Tupel hat in der Schicht i oder in den unteren Schichten

nur eine Ableitung. Nach der Berechnung der Duplikate in der Schicht i + 1 wird folglich der Count

für jedes Tupel in Bezug auf die Anzahl seiner Ableitungen vergeben. Dabei haben alle Tupel der

unteren Schichten entweder keine oder nur eine Ableitung.

In folgendem Beispiel wird unter Verwendung der Optimierungsformel

∆(P ) = set(P ν ) − set(P ), die ∆-Relation für die Sicht hop berechnet.

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

40

Beispiel

Wir betrachten die Relationen hop und hopν nach der Verwendung der beiden Regeln v1 und v2:

∆(tri − hop)(X, Y ) : − ∆(hop)(X, Z), link(Z, Y )

∆(tri − hop)(X, Y ) : − hopν (X, Z), ∆(link)(Z, Y )

∆(hop) = set(hopν ) − set(hop)

∆(hop) = {ac, af, ag, dg, dh, bh} − {ac, dh, bh}

∆(hop) = {af, ag, dg}

Es muss beachtet werden, dass hier das Tupel hop(ac ∗ −1) in ∆(hop) nicht auftritt und auch nicht im

Stufenprozess der Relation tri-hop. Daher wird das Tupel (ah ∗ −1) für ∆(tri − hop) nicht abgeleitet.

Negation

Der Counting-Algorithmus unterstützt die Anpassung der Sichten mit der Negation (Regeln mit negativen Literalen). In dem Verfahren nach [GMS93] wird von sicherer Negation ausgegangen, d.h. die

Variablen, die in einem negativen Prädikat vorkommen, müssen auch in einem positiven Prädikat in

derselben Regel auftreten. Wenn ein Prädikat p negativ von einem anderen Prädikat q abhängt, dann

ist SN (p) < SN (q). Dabei bezeichnet SN die Schichtennummer des Prädikats.

Ein negatives Literal ¬p(A, Y, ...) in einerm stratifizierten Programm wird wie folgt ausgewertet:

Ein negativer Fakt ¬p(a, b, ...) hat den Count Null oder Eins: Null, wenn der Fakt p(a, b, ...) TRUE ist

und count(p(a, b, ...)) > 0, Eins, wenn der Fakt p(a, b, ...) den Wert FALSE hat. Der Grund dafür ist,

dass ein negativ instanziertes Literal ¬p(a, b, ...) als Auswertungsüberprüfung verwendet wird und

folglich wird ¬p(a, b, ...) den Wert FALSE haben, wenn p(a, b, ...) nur einmal abgeleitet wird.

Negation in rekursiven Sichten kann zur Unstratifizierbarkeit führen. Negative Regeln beim CountingAlgorithmus werden so ausgewertet, dass die invertierten Vorzeichen der negativen Prädikate der

induzierten Änderungen übergeben werden.

Nichtrekursive Sichten, die nur einfache Transitionsregeln verwenden, sind immer stratifiziert. Wir

betrachten ein negatives Prädikat ¬q(X, Y ) in einer Regel r, das eine Sicht definiert.

Wir erinnern uns an die ∆-Regel-Auswertung im Counting-Algorithmus:

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

41

(∆(r)) : ∆(p) : − sν1 , . . . , sνi−1 , ∆(si ), si+1 , . . . , sn

Ein negatives Prädikat kann in einem der drei folgenden Positionen in der Regel ri vorkommen:

Fall 1: sνj = (¬q)ν , j zwischen 1 und i − 1: (¬q)ν ≡ ¬(q ν ), da das Prädikat q in einer niedrigeren

Schicht als p liegt und schon berechnet ist.

Fall 2: sj = ¬q, j zwischen i + 1 und n: Die Relation über dem Prädikat ¬q wird als Q bezeichnet.

Q wird aus der Relation Q und aus den positiven Prädikaten in der Regel r, die die Variablen

X und Y beinhalten, berechnet. Ein Tupel (a, b) mit dem Count 1 ist in der Relation Q, wenn

entweder ein positives Prädikat in der Regel r die Werte a und b zu den Variablen X und Y

zuordnet, oder das Tupel q(a, b) ist F alse ((a, b) ∈

/ Q).

Fall 3: ∆(si ) = ∆(¬q): ∆(¬q) wird aus Termen von ∆(q) und den Originalwerten für q berechnet.

Da q und ∆(q) schon berechnet sind, kann ∆(¬q) ohne Auswertung der anderen Prädikate in r

bestimmt werden. ∆(Q) kann wie folgt definiert werden:

Definition: ∆(Q)

Angenommen Q ist die Relation, die über das Prädikat q definiert wird und ∆(Q) repräsentiert die

Änderungen in Q. Für ein Tupel t in ∆(Q) gilt:

1 falls t ∈ ∆(Q) und t ∈

/ Q ] ∆(Q)

count(t) =

−1 falls t ∈ ∆(Q) und t ∈

/Q

Beispiel:

Gegeben:

p(X) : − s(X, Y ), ¬q(Y )

q(X) : − r(X)

s = {ab, ad, dc, bc, ch, f g}

Nach dem Counting-Algorithmus bekommen wir folgende Regeln für ∆(p(X)):

4. Ausgewählte Methoden zur inkrementellen Sichtenanpassung

42

∆(p)(X) : − sν (X, Y ), ∆(¬q(Y ))

∆(p)(X) : − ∆(s)(X, Y ), ¬q(Y )

∆(q)(X) : − ∆(r)(X)

Die Änderung in der Menge s lautet:

∆(s) = {bc ∗ −1}

Nun ist Q = {a, b, c, d, f }.

Nach Verwendung der gegebenen Regeln folgt:

∆(r) = c ∗ −1 =⇒ ∆(q) = c ∗ −1

∆(Q) = {c ∗ −1}

∆(Q) = {c ∗ 1}

Q ] ∆(Q) = {a, b, d, f } =⇒ ∆(p)(X) = {b ∗ 1, cd ∗ 1}

Bei der Propagierung wird das Vorzeichen der Änderung des negativen Prädikats umgekehrt an die

induzierte Änderung (vom abhängigen Prädikat, d.h. Kopf der Regel) weiter gegeben.

4.1.2

Delete and Rederive-Algorithmus (DRed)

In [GMS93] wird ein Algorithmus zur Anpassung rekursiver der materialisierten Sichten vorgestellt.

Dabei können die Sichten Negationen und Aggregationen beinhalten. Der DRed-Algorithmus kann

also auch nichtrekursive Sichten bearbeiten, wobei der Counting-Algorithmus zur Anpassung nichtrekursiver Sichten effizienter ist. Das Problem bei der Anpassung nichtrekursiven Sichten wird beim