Pentaho Data Integration

Werbung

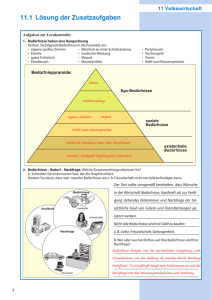

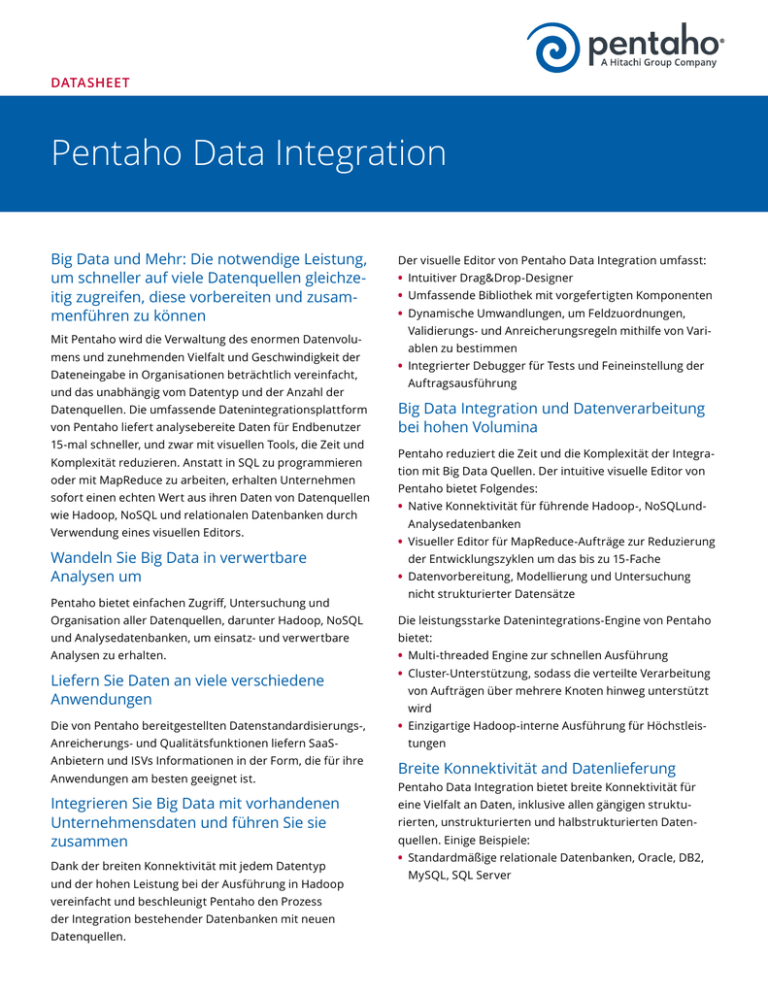

DATASHEET Pentaho Data Integration Big Data und Mehr: Die notwendige Leistung, um schneller auf viele Datenquellen gleichzeitig zugreifen, diese vorbereiten und zusammenführen zu können Mit Pentaho wird die Verwaltung des enormen Datenvolumens und zunehmenden Vielfalt und Geschwindigkeit der Dateneingabe in Organisationen beträchtlich vereinfacht, und das unabhängig vom Datentyp und der Anzahl der Datenquellen. Die umfassende Datenintegrationsplattform von Pentaho liefert analysebereite Daten für Endbenutzer 15-mal schneller, und zwar mit visuellen Tools, die Zeit und Komplexität reduzieren. Anstatt in SQL zu programmieren oder mit MapReduce zu arbeiten, erhalten Unternehmen sofort einen echten Wert aus ihren Daten von Datenquellen wie Hadoop, NoSQL und relationalen Datenbanken durch Verwendung eines visuellen Editors. Wandeln Sie Big Data in verwertbare Analysen um Pentaho bietet einfachen Zugriff, Untersuchung und Der visuelle Editor von Pentaho Data Integration umfasst: • Intuitiver Drag&Drop-Designer • Umfassende Bibliothek mit vorgefertigten Komponenten • Dynamische Umwandlungen, um Feldzuordnungen, Validierungs- und Anreicherungsregeln mithilfe von Variablen zu bestimmen • Integrierter Debugger für Tests und Feineinstellung der Auftragsausführung Big Data Integration und Datenverarbeitung bei hohen Volumina Pentaho reduziert die Zeit und die Komplexität der Integration mit Big Data Quellen. Der intuitive visuelle Editor von Pentaho bietet Folgendes: • Native Konnektivität für führende Hadoop-, NoSQLundAnalysedatenbanken • Visueller Editor für MapReduce-Aufträge zur Reduzierung der Entwicklungszyklen um das bis zu 15-Fache • Datenvorbereitung, Modellierung und Untersuchung nicht strukturierter Datensätze Organisation aller Datenquellen, darunter Hadoop, NoSQL Die leistungsstarke Datenintegrations-Engine von Pentaho und Analysedatenbanken, um einsatz- und verwertbare bietet: Analysen zu erhalten. • Multi-threaded Engine zur schnellen Ausführung Liefern Sie Daten an viele verschiedene Anwendungen • Cluster-Unterstützung, sodass die verteilte Verarbeitung Die von Pentaho bereitgestellten Datenstandardisierungs-, • Einzigartige Hadoop-interne Ausführung für Höchstleis- Anreicherungs- und Qualitätsfunktionen liefern SaaSAnbietern und ISVs Informationen in der Form, die für ihre Anwendungen am besten geeignet ist. Integrieren Sie Big Data mit vorhandenen Unternehmensdaten und führen Sie sie zusammen Dank der breiten Konnektivität mit jedem Datentyp und der hohen Leistung bei der Ausführung in Hadoop vereinfacht und beschleunigt Pentaho den Prozess der Integration bestehender Datenbanken mit neuen Datenquellen. von Aufträgen über mehrere Knoten hinweg unterstützt wird tungen Breite Konnektivität and Datenlieferung Pentaho Data Integration bietet breite Konnektivität für eine Vielfalt an Daten, inklusive allen gängigen strukturierten, unstrukturierten und halbstrukturierten Datenquellen. Einige Beispiele: • Standardmäßige relationale Datenbanken, Oracle, DB2, MySQL, SQL Server • Hadoop, Apache Hadoop, Cloudera, HortonWorks, MapR Pentaho bietet grundlegende Data-Profiling-Funktionen • NoSQL-Datenbanken, MongoDB, Cassandra, HBase wie Zeilenzahl, mathematische Funktionen und Identifi- • Analytische Datenbanken, Vertica, Greenplum, Teradata zierung von Nullwerten sowie Datenqualitätsoperatoren • Spezialisierte Daten-Stores, Splunk, Amazon Redshift wie Zeichenfolgen-Manipulatoren, Zuordnungsfunktionen, • Packages, Enterprise Applications, SAP Filtern und Sortieren. Um Namens- und Adressprüfungs- • Cloudbasierte und SaaS-Anwendungen, Salesforce, Ama- funktionen bieten zu können, ist Pentaho mit führenden zon Web Services • Dateien, XML, Excel, Flatfile- und Webservice-APIs Um die Leistung bei Datenextrahierungs-, Lade- und Lieferprozessen zu erhöhen, bietet Pentaho folgende Funktionen: • Native Konnektivität und Sammelladen für die meisten üblichen Datenquellen • Datenlieferung in ein mehrdimensionales Format für die Analyse • Datenlieferung mithilfe von Echtzeitdiensten für Betrieb- Datenqualitätsanbietern wie Human Inference und Melissa Data integriert. Pentaho-Funktionen für Data-Profiling und Datenqualität bieten: • Identifizierung von Daten, die Business Rules und Normen nicht entsprechen • Deduplizieren und Bereinigen nicht einheitlicher und redundanter Daten • Validierung, Standardisierung und Korrektur von Namens-, Adress-, E-Mail- und Telefondaten sanwendungen von Drittanbietern Teamarbeit und Kooperation für Entwickler Pentaho Data Integration basiert auf einem zentralisierten Repository, auf das alle Mitarbeiter in einem Datenintegrationsprojekt zugreifen, um bei der Entwicklung der Datenverarbeitung zusammen zu arbeiten. Pentaho bietet: • Gemeinsames Repository für die Zusammenarbeit von Datenanalysten, Entwicklern und Datenverantwortlichen • Content Management, Versionierung und Sperrung, um einfach Auftragsversionen zu erstellen und die Wiederherstellung und Nutzung vorheriger Versionen zu ermöglichen Leistungsstarke Administration und Verwaltung Pentaho Data Integration bietet vorgefertigte Funktionen für die Verwaltung aller Geschäftsabläufe bei Datenintegrationsprojekten. Dazu zählen: • Verwaltung von Sicherheitsberechtigungen für Benutzer und Rollen • Integration mit bestehenden Sicherheitsdefinitionen in LDAP und Active Directory • Festlegen von Berechtigungen zur Steuerung von Benutzeraktionen, Lesen, Ausführen oder Erstellen • Zeitplanung für Datenintegrationsabläufe • Überwachung und Analyse der Leistung von Datenintegrationsprozessen WARUM PENTAHO DATA INTEGRATION? • Leistung der Big Data Orchestrierung und Integration: Integration aller Daten, ob Hadoop, NoSQL oder relational, in einer Plattform; Hadoop-interne und ClusterAusführung der Datenverarbeitung, um maximale Skalierbarkeit zu ermöglichen • Einfache Nutzung: Einfaches Setup; intuitiver visueller Editor; keine zusätzliche Programmcodegenerierung; mehr als 100 vorgefertigte Zuordnungsobjekte, mit visuellem MapReduce-Designer für Hadoop • Modern und erweiterbar: 100% Java für plattformübergreifende Entwicklung; flexible Architektur, um Konnektoren, Transformationen und benutzerdefinierte Ausdrücke hinzuzufügen • Hoher Wert, geringe Kosten: Keine sofort zu zahlenden Gebühren; Abonnement-Lizenzmodell ohne Entwickler-/ Benutzerlizenzgebühren; keine Wartungsgebühre Spoon - mongo_data_merge (changed) Perspective: View Design Welcome Data Integration 4:09 PM pentaho Model Visualize mongo_data_merge 100% Steps Big Data Cassandra Input Cassandra Output Hadoop File Input HBase Input Calc Mn/Yr Sales Data Hadoop File Output HBase Input HBase Output MapReduce Input MapReduce Output Add Count Sort country/date Group by country/date Lookup Sales Table output MongoDb Input MongoDb Output Input Output Transform Be social with Pentaho: Copyright ©2015 Pentaho Corporation. All rights reserved. Worldwide +1 (866) 660 7555. 015-127v2 pentaho.de/contact | +1 (866) 660-7555