Vorlesungsskript Teil 1

Werbung

Mathematik für Informatiker 1

Vorlesungsskriptum

Wintersemester 2012/2013

Bernhard Steffen

Oliver Rüthing

Malte Isberner

Fakultät für Informatik

Technische Universität Dortmund

2012

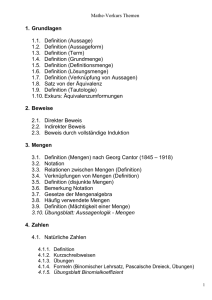

Inhaltsverzeichnis

1 Einleitung

1.1 Illustrative Beispiele und typische Probleme . . . . .

1.2 Das Zusammenspiel von Syntax und Semantik . . . .

1.3 Denken in Strukturen: Ein lernpragmatischer Zugang

1.4 Lernziele und Kompetenzen zusammengefasst . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

6

7

9

2 Aussagen und Mengen

2.1 Aussagen . . . . . . . . . . . . . . . . .

2.1.1 Aussagenlogik . . . . . . . . . . .

2.1.2 Anwendung: Digitale Schaltkreise

2.1.3 Prädikatenlogik . . . . . . . . . .

2.1.4 Logische Beweisprinzipien . . . .

2.2 Mengen . . . . . . . . . . . . . . . . . .

2.2.1 Mengenbeziehungen . . . . . . .

2.2.2 Mengenverknüpfungen . . . . . .

2.2.3 Mächtigkeit endlicher Mengen . .

2.2.4 Antinomien . . . . . . . . . . . .

2.3 Abschließende Betrachtungen . . . . . .

2.4 Lernziele . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

11

12

17

18

21

22

23

24

27

27

28

29

3 Relationen und Funktionen

3.1 Relationen . . . . . . . . . . . . . . .

3.1.1 Kartesisches Produkt . . . .

3.1.2 Exkurs: Endliche Bitvektoren

3.1.3 n-stellige Relationen . . . . .

3.1.4 Binäre Relationen . . . . . .

3.2 Funktionen . . . . . . . . . . . . . .

3.2.1 Eigenschaften von Funktionen

3.2.2 Mächtigkeit von Mengen . . .

3.2.3 Partiell definierte Funktionen

3.3 Äquivalenzrelationen . . . . . . . . .

3.3.1 Partitionen . . . . . . . . . .

3.3.2 Exkurs: Kardinalzahlen . . .

3.4 Lernziele . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

31

31

31

32

33

33

35

37

40

45

45

46

50

50

4 Induktives Definieren

4.1 Natürliche Zahlen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.1 Peano-Axiome . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

53

53

54

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4.2

4.3

4.4

4.1.2 Operationen auf natürlichen Zahlen . . . . .

4.1.3 Induktiv definierte Algorithmen . . . . . . . .

Induktiv strukturierte Mengen . . . . . . . . . . . .

Exkurs: Listen in funktionalen Programmiersprachen

Lernziele . . . . . . . . . . . . . . . . . . . . . . . . .

5 Darstellung und deren Bedeutung

5.1 Zeichenreihen . . . . . . . . . . . . .

5.1.1 Grenzen der Berechenbarkeit

5.2 Semantikschemata . . . . . . . . . .

5.3 Backus-Naur-Form . . . . . . . . . .

5.4 Induktive Semantikschemata . . . .

5.5 Lernziele . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

55

56

57

60

61

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

63

63

65

65

67

70

72

6 Induktives Beweisen

6.1 Ordnungsrelationen . . . . . . . . . . .

6.1.1 Partielle Ordnungen . . . . . .

6.1.2 Quasiordnungen . . . . . . . .

6.1.3 Totale Ordnungen . . . . . . .

6.1.4 Striktordnungen . . . . . . . .

6.1.5 Ordnungen und Teilstrukturen

6.2 Noethersche Induktion . . . . . . . . .

6.2.1 Terminierungsbeweise . . . . .

6.3 Verallgemeinerte Induktion . . . . . .

6.4 Strukturelle Induktion . . . . . . . . .

6.5 Vollständige Induktion . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

75

75

75

77

78

78

79

81

83

84

86

89

7 Ordnungsstrukturen

7.1 Verbände . . . . . . . . . . . . . . . . . . . .

7.1.1 Verbände als algebraische Strukturen .

7.2 Spezielle Verbände . . . . . . . . . . . . . . .

7.2.1 Vollständige Verbände . . . . . . . . .

7.2.2 Boolesche Verbände . . . . . . . . . .

7.3 Konstruktionsprinzipien . . . . . . . . . . . .

7.4 Strukturverträgliche Abbildungen . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

93

93

96

98

98

100

102

103

8 Algebraische Strukturen

8.1 Mengen mit einer Verknüpfung . . . . . . . . . . . . . .

8.1.1 Halbgruppen und Monoide . . . . . . . . . . . .

8.1.2 Gruppen . . . . . . . . . . . . . . . . . . . . . . .

8.1.3 Untergruppen . . . . . . . . . . . . . . . . . . . .

8.1.4 Nebenklassen und der Satz von Lagrange . . . .

8.1.5 Faktorstrukturen . . . . . . . . . . . . . . . . . .

8.1.6 Homomorphismen . . . . . . . . . . . . . . . . .

8.1.7 Schnitte und Produkte algebraischer Strukturen

8.2 Mengen mit zwei Verknüpfungen . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

107

107

107

108

111

113

115

118

123

126

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

8.2.1

8.2.2

8.2.3

8.2.4

Index

Ringe . . . . . . . . . . . . . .

Ideale . . . . . . . . . . . . . .

Homomorphismen . . . . . . .

Integritätsbereiche und Körper

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

126

128

130

132

135

1 Einleitung

Ohne Zweifel ist die Mathematik neben der Elektrotechnik einer der Grundpfeiler der Informatik.

So gab es z.B. noch bis in die neunziger Jahre hinein in Aachen einen Lehrstuhl mit der Bezeichnung „Praktische Mathematik, insbesondere Informatik“. Inzwischen hat sich die Informatik jedoch

emanzipiert und wird als eigenständiges Fach akzeptiert. Das bedeutet jedoch keinesfalls, dass ihre

Wurzeln in der Mathematik dadurch irrelevant geworden sind. Vielmehr sind gerade die wohlverstandenen Grundlagen der Informatik durch einen starken mathematischen Kern gekennzeichnet,

und viele konzeptuelle Vorgehensmuster (insbesondere, aber nicht nur) der theoretischen Informatik sind der Mathematik entlehnt. Auf der anderen Seite gibt es auch klassische mathematische

Probleme, die am Ende nur mit Hilfe der Informatik gelöst werden konnten. Ein prominentes Beispiel ist das Vierfarbenproblem1 , dessen Lösung bis heute auf Hilfsmitteln der Informatik beruht.

Durch diese enge Verzahnung hat die Informatik ihrerseits der Mathematik ihren Stempel aufgedrückt. Beispiele hier sind Bereiche der diskreten Mathematik, die konstruktive Logik und weite

Teile der Numerik.

Ziel der Vorlesung ist es, den Wert dieser Verzahnung greifbar zu machen und ein Gefühl dafür zu

vermitteln, wann welche mathematischen Vorgehensmuster vorteilhaft eingesetzt werden können.

Gleichzeitig sollen die mathematischen Verfahrensmuster auch dazu dienen, die Natur der Informatik etwas besser zu verstehen: Was sind ihre Besonderheiten z.B. gegenüber der Mathematik.

Im Folgenden diskutieren wir einige typische, beispielhafte Problemszenarien, deren Lösungen im

weiteren Verlauf der Vorlesung adressiert werden.

1.1 Illustrative Beispiele und typische Probleme

Der Euklidische Algorithmus zur Berechnung des GGT. Informell ausgedrückt zieht der Euklidische Algorithmus2 solange ein maximales Vielfaches der kleineren Zahl b von der größeren Zahl

a ab, bis schließlich b Null wird. Der GGT ist dann a. Abbildung 1.1 illustriert dies mit a = 65,

b = 50 worauf a = 50, b = 15 und schließlich a = 15 und b = 5 folgt. Der Wert von b passt nun

dreimal in a worauf der Algorithmus mit b = 5, dem größten gemeinsamen Teiler von 65 und 50,

terminiert.

Auf den ersten Blick ist hier keineswegs klar, warum dieser über 2200 Jahre alte Algorithmus

tatsächlich den GGT seiner beiden Eingabeparameter berechnet. Klar wird dies, sobald man die

dem Algorithmus unterliegende Invariante erkennt: Die Subtraktion ändert den zu berechnenden

1 siehe

2 siehe

http://de.wikipedia.org/wiki/Vier-Farben-Satz

http://de.wikipedia.org/wiki/Euklidischer_Algorithmus

1

Abbildung 1.1: Illustration des GGT

GGT nicht!

Invarianten sind der zentrale Schlüssel zum Verständnis von Programmschleifen und Rekursion.

Diese Erkenntnis ist in vollem Einklang mit Archimedes Intuition: „Gebt mir einen Punkt auf dem

ich still stehe, und ich werde die Welt aus den Angeln heben“. Das Verständnis als Invarianten

als archimedische Punkte3 ist ein guter Leitfaden. Er hilft iterative und rekursive Programme zu

beherrschen, Induktionsbeweise zu führen und und evolutionäre Programmentwicklung zu strukturieren, alles durch die Beantwortung der Frage „Was ist beständig im Wandel“.

Türme von Hanoi. Ausgehend von drei unterschiedlich großen Scheiben auf dem ersten von

drei Stapeln, sollen diese durch einzelne Bewegung in die gleiche Position auf dem dritten Stapel

gebracht werden. Es dürfen dabei jedoch nur kleinere Scheiben auf größere gelegt werden (in der

Ausgangsposition sind diese auch so angeordnet).

Abbildung 1.2: Türme von Hanoi

Frage: Wie viele Schritte benötigt man, um den Turm regelgerecht und vollständig zu ’verschieben’ ?

Während im vorigen Beispiel der Algorithmus vorgegeben war, kommt hier ein wesentliches Stück

Informatik hinzu: Die Entwicklung des Algorithmus. Dabei ist darauf zu achten, dass dieser Algorithmus so strukturiert ist, dass er z.B. einer Analyse bzgl. der Schrittzahl zugänglich ist. Wie im

vorigen Beispiel steht dabei der zugehörige archimedische Punkt (die Invariante) im Vordergrund.

Finden eines Objektes in einer Menge. Wie viele Objekte muss man im ungünstigsten Fall aus

einer Menge herausnehmen, um nachzuprüfen, ob ein vorgegebenes Element in dieser Menge liegt?

Ähnlich wie im vorigen Problem ist das Lösungsverfahren auch hier nicht vorgegeben.

3 siehe

2

http://de.wikipedia.org/wiki/Archimedischer_Punkt

Abbildung 1.3: Suchen eines Elements in einer Menge

Offensichtlich gibt es ein triviales Verfahren, das aber erfordert, dass man alle Elemente aus der

Menge herausgenommen haben muss, bevor man entscheiden kann, dass das in Frage stehende

Element nicht in der Menge liegt.

Geht das besser?

Das liegt an den Spielregeln. Darf ich mir die Menge selbst organisieren, d.h. darf ich die Art

und Weise, wie die Elemente abgelegt werden, selbst bestimmen? Sofern das möglich ist, geht es

viel besser. Als Anhaltspunkt denke man an ein Telefonbuch und überlege sich, wie es möglich ist,

die gesuchte Telefonnummer unter Tausenden von Einträgen schnell finden zu können.

Dieses Beispiel illustriert einen wesentlichen Informatik-typischen Aspekt, das Ausnutzen von Modellierungsspielräumen: Man kann (in Grenzen) seine Aufgabenstellung so (um)strukturieren,

dass effiziente/elegante Lösungen möglich sind. Im vorliegenden Fall ist Sortieren der Schlüssel zu

Erfolg. Tatsächlich ist die adäquate (Um-)Strukturierung eine Kunst, die den guten Informatiker

auszeichnet.

Im Folgenden werden wir entsprechende Vorgehensmuster behandeln, die insbesondere die mathematische Beherrschbarkeit und die damit verbunden Zuverlässigkeit von Systemen in den Vordergrund stellen. Spezifisch auf Laufzeiteffizienz zielende Muster werden typischer Weise unter dem

Thema Algorithmen und Datenstrukturen vertieft.

Terminierung von Algorithmen In der Informatik trennt man oft den Aspekt der sogenannten

partiellen Korrektheit, die besagt, dass alle erfolgreichen Berechnungen ein korrektes Ergebnis erzielen, von dem Aspekt der Terminierung. Ein besonders drastisches Beispiel zur Illustration des

Kerns dieser beiden Aspekte ist die sogenannte Collatz-Funktion4 , deren Lebensinhalt es zu sein

4 siehe

http://de.wikipedia.org/wiki/Collatz-Problem

3

scheint, unabhängig vom Eingabewert das Resultat 1 zu berechnen:

Eingabe : Natürliche Zahl n

Ausgabe : 1

solange n 6= 1 wiederhole

wenn n gerade dann

n ← n/2

sonst

n ← 3n + 1

Ende

Ende

Gib n aus.

Algorithmus 1: Berechnung der Collatz-Funktion

Die partielle Korrektheit der Collatz-Funktion ist offensichtlich: Wenn die Funktion überhaupt terminiert, d.h. ein konkretes Ergebnis liefert, dann ist das 1. Ob die Collatz-Funktion aber für jeden

Eingabewert terminiert, ist aber bis heute ein offenes Problem. Dies mag erstaunlich scheinen, da

sie auf sehr einfache Weise zu beschreiben ist. Wie unvorhersehbar sich der Wert von n entwickelt,

erkennt man jedoch daran, dass bereits für den Startwert 27 im Verlauf des Algorithmus ein Wert

von 9232 erreicht wird, während bei einem Startwert von 100 der initiale Wert nie überschritten

wird!

Umgang mit beschränkten Ressourcen. Es ist modern, komplexe Aufgaben zu verteilen, und

zwar zum Teil auf sehr, sehr viele Problemlöser (Crowd Sourcing). Ein von der Verteilung her

noch moderateres Beispiel der Verteilung ist die in Abbildung 1.4 skizzierte ANTS Mission der

NASA. Hier soll ein Schwarm von etwa 2000 notebookgroßen Raumschiffe durch den Asteroidengürtel geschifft werden, um irgendwelche Missionen zu erfüllen, wie Probennahmen, Fotografien,

Analyse, usw.. Wegen ihrer eingeschränkten Größe und Kapazität muss dazu eine klare Rollenverteilung vorgenommen werden: jedes dieser Raumschiffe erfüllt Teilaufgaben, deren Ergebnisse dann

anschließend zusammengeführt werden müssen. Es ist im allgemeinen sehr schwierig, eine derartige Zusammenarbeit effizient zu organisieren. Wir wollen uns daher hier auf ein sehr einfaches

Beispielproblem beschränken:

Abbildung 1.4: ANTS

4

Angenommen wir haben einen Schwarm von Minirechnern, die jeder die ganzen Zahlen bis zu

einem Byte beherrschen. D.h. sie können die üblichen Rechenarten wie +, *, - und / verwenden,

wobei / nur für glatt aufgehende Divisionen definiert ist.

Frage 1: Ist es möglich, trotz des Überlaufproblems zu garantieren, dass alle Ergebnisse, die sich

mit einem Byte darstellen lassen, präzise sind? Oder ist es sogar möglich, die Berechnungsergebnisse abschließend auf einem größeren, beispielsweise auf der Erde stationierten Rechner zu einem

präzisen, in vier oder acht Byte repräsentierbaren Ergebnis zusammen zu führen?

Im Rahmen der Behandlung von Faktorstrukturen werden wir sehen, dass es genügt, nur auf den

Resten nach Division mit einer geeigneten Menge von Primzahlen zu rechnen. Wie und warum das

möglich ist, gehört zu den elementaren Grundlagen der Algebra.

Faktorstrukturen haben viele Anwendungen in der Informatik, insbesondere bei der Modellbildung

und der automatischen Programmanalyse (Stichwort: abstrakte Interpretation).

Lösen linearer Gleichungssystemen Das Lösen kleiner linearer Gleichungssysteme begleitet einen

über Jahre hinweg im gymnasialen Mathematik- und Physikunterricht in den unterschiedlichsten

Szenarien. Einer Motivation des zugehörigen Teils 2 der Vorlesung bedarf es an dieser Stelle also

nicht. Was aber typischer Weise nicht adressiert wird, ist der Aspekt der Skalierbarkeit: Wie löst

man lineare Gleichungssysteme mit wirklich vielen Unbestimmten? Die lineare Algebra umfasst

nicht nur effiziente Methoden zur Lösung komplexer linearer Gleichungssysteme, sondern sie stellt

auch ein mit den Worten der Informatik ausgedrückt ideales domänenspezifisches Framework

zur Verfügung, das es insbesondere erlaubt, die Struktur von Lösungen, deren etwaige Eindeutigkeit, sowie Einflüsse von verändernden Transformationen elegant zu erfassen, zu beschreiben und

zu beherrschen.

Eigenfaces Ein besonders aktuelles Anwendungsfeld der linearen Algebra ist die Gesichtserkennung: Wie charakterisiert man individuelle Gesichter möglichst einfach? Die Idee hier ist es, Gesichter (approximativ) aus einem kleinen Repräsentantensystem, den sogenannten Eigenfaces, zusammen zu setzen/zu überlagern. Dieses Vorgehen ist aus Sicht der Informatik besonders spannend,

da es

• Approximation: Der betrachtete Raum der Faces/Gesichter ist eigentlich unendlichdimensional und wird hier approximativ in den endlichen Raum projiziert, der von den

Eigenfaces aufgespannt wird, und

• die aus der Linearen Algebra bekannte Eigenraumzerlegung zusammen führt.

Während Eigenwerte, Eigenvektoren und Eigenräume konkret Thema dieser Vorlesung sind, können

Theorie und Anwendung der Eigenfaces hier nur intuitiv zur Motivation angerissen werden. Details

sind Thema weiterführender Vorlesungen wie Computergraphik.

5

Abbildung 1.a: Eigenfaces

Das linke Bild zeigt ein Mittelwertgesicht (das ganz oben links) und 19 Eigenfaces. Mittelwertgesichter entstehen durch Überlagerung aller zugrundeliegenden Gesichter und sind daher ein guter

Ausgangspunkt, von dem aus man spezifische Variantengesichter durch Hinzufügen von Eigengesichtern unterschiedlicher Intensität konstruieren kann. Mittelwertgesichter bilden damit den

Ursprung des vollen ’Gesichtsraumes’. Weitere Gesichter werden dann durch sogenannte Linearkombinationen von Eigenfaces gebildet. Die Qualität dieser Bilder hängt von der gewählten Dimension des jeweils gewählten approximative Raumes ab. Abbildung 1.a zeigt Varianten für die

Dimensionen 5, 10, 15, 20.

1.2 Das Zusammenspiel von Syntax und Semantik

Traditionell wird in der Mathematik präzise, aber großenteils informell natürlichsprachlich argumentiert. Ein klare (formale) Abgrenzung zwischen der Argumentationsebene, auf der über das

Problem geredet wird und der Problemebene selbst ist unüblich. Insbesondere trennen Mathematiker typischer Weise konzeptuell nicht zwischen der sogenannten Darstellungsebene/Repräsentation

(Syntax) und der intendierten Bedeutung (Semantik). In der Informatik ist diese Trennung dagegen

essentiell.

Im Rahmen der Vorlesung sollen zwei Vorteile dieser Trennung klar werden

• Die formale Beherrschbarkeit von der Repräsentationsebene. Sie ist Grundlage für jegliche

Computer-gestützte Bearbeitung, angefangen von einfacher Textverarbeitung, über das Übersetzen von Programmen in Maschinencode, bis hin zu ambitionierteren Problemen wie z.B.

automatisiertes Theorembeweisen, Compiler-Generierung und computergestütztes Sprachverständnis.

• Der kreative Spielraum, der durch diese Trennung ermöglicht wird: Das intuitiv vorgegebene

Problem kann auch in der Informatik, wie z.B. in der Physik als „naturgegeben“ angesehen werden. Wir haben aber Spielraum bei der Art, wie dieses Problem formal beschrieben

(repräsentiert) wird:

6

Abbildung 1.5: Semiotisches Dreieck

Beispiel: Natürliche Zahlen: Wir sind an die Dezimaldarstellung gewöhnt, ihre logarithmische Prägnanz, und die elegante Weise wie man im Dezimalsystem stellenbezogen rechnet.

Man vergleiche dies einmal mit der Darstellung als römische Zahlen und mit dem Unärsystem.

Ein weiteres Beispiel, das bis heute Relevanz hat, ist er Vergleich zwischen dem metrischen

System und dem angelsächsischen System mit Fuß, Yard und Meile. Das angelsächsische

System hat wegen seiner klaren Handhabungsschwierigkeiten keine Zukunft.

1.3 Denken in Strukturen: Ein lernpragmatischer Zugang

Das war jetzt ein Feuerwerk von Eindrücken, die nicht alle auf einmal vollständig verstanden

und verarbeitet werden können. Seien Sie deswegen jetzt nicht beunruhigt. Der Weg liegt ja noch

vor ihnen. Doch auch hier kann man auf Euklid zurückgreifen, der gesagt hat: „Es gibt keinen

Königsweg zur Mathematik!“ Das bedeutet aber nicht, dass der Weg zur Mathematik unattraktiv

ist. Vielmehr kann man den „Ausblick“ von jedem neu errungenen Erkenntnisplateau genießen,

besonders wenn man ihn sich hart erarbeitet hat.

Um dieses Erklimmen des ’Erkenntnisberges’ zu unterstützen, ist das Skript ist so aufgebaut, dass

es einen schrittweisen Zugang zu der mathematisch geprägte Welt der ’höheren’ Informatik ermöglicht. Sorgfältig wurden z.B. der klausurrelavante Teil und die illustrativen Beispiele von den hier

grau unterlegten Zusatzinformationen wie Motivation, weiterführenden Gedanken und Vorwärtsverweisen in das weitere Informatikstudium abgegrenzt. Diese Vorwärtsverweise betreffen keinesweg

nur Aspekte der theoretischen Informatik. Vielmehr profitieren fast alle Bereiche der Informatik unmittelbar von den im Rahmen dieser Vorlesung erarbeiteten Denkmustern. Die Universalität dieser

Struktur-orientierten Denkmuster ist damit ein ideales Werkzeug für den Methoden/TechnologieTransfer zwischen den unterschiedlichen Teildisziplinen der Informatik und hinein in die Welt der

Anwendungsdisziplinen.

7

Sicher steht für Viele zunächst das Bestehen der Klausur zunächst im Vordergrund. Die klare

Kennzeichnung der Klausur-relevanten Teil soll dabei helfen, sich bei der finalen Klausurvorbereitung nicht zu verzetteln.5 Es sollte aber nicht vergessen werden, dass die Hintergründe und

Motivationen auch hier helfen, die Intentionen zu begreifen und die unterschiedlichen Begriffe und

Methoden gezielt einzuordnen. Das Gehirn arbeitet hier auf unbewusster Ebene mit. Es ist nicht

selten, dass man später, an ganz anderer Stelle, auf einmal versteht, was da gemeint war. Das

’Fallen von Groschen’ ist ein erstaunliches Phänomen, und wenn es passiert ist es erhebend.

Groschen können aber nur fallen, wenn es genügend Material gibt. Die zahlreichen Hinweise, Beispiele und Verweise sollen hier anregen, zum Weiterdenken, zum Diskutieren aber auch zum Googlen und zum Nachschlagen bei Wikipedia. Jede Beschäftigung mit der Thematik bringt einen

weiter, unmerklich, aber bei entsprechendem Einsatz fast unweigerlich. Die Auseinandersetzung

mit dem Vorlesungsstoff betrifft aber keinesfalls nur die mathematischen Inhalte. Tatsächlich ist

es erstaunlich, was man über die Informatik ’im Spiegel’ der Mathematik alles lernen kann, Dinge,

die eine unmittelbare Beschäftigung mit der Informatik gar nicht ans Licht bringen würden. Wenn

Sie das verstehen, dann ist der Hauptziel erreicht, dann werden sich die vielen Einzelteile nach und

nach zu einem Ganzen zusammenfügen. Das Skript ist daher perspektivisch als eine Art Begleiter für Ihr ganzes Studium aufgebaut, der es Ihnen ermöglichen soll, das Fallen der Groschen zu

erkennen und zu genießen.

An dieser Stelle ist eine Bemerkung zu Verweisen auf Wikipedia-Artikel angebracht, welche sich

bereits im vorangegangenen Text fanden und auch an vielen Stellen im Skript finden werden. Diese sollen als Denkanstöße verstanden werden, sich tiefergehend über interessante mathematische

Phänomene und Problemstellungen zu informieren, auch wenn sich diese aufgrund ihrer Komplexität und der erforderlichen Vorkenntnisse hier allenfalls namentlich erwähnen lassen, und sich so

eine Art „mathematischer Allgemeinbildung“ anzueignen. Für diesen Zweck scheinen Verweise auf

Wikipedia wesentlich geeigneter als auf mathematische Fachartikel. Bitte missverstehen Sie dies

nicht: Wikipedia ist keine wissenschaftliche Quelle, die Sie in Seminar- oder Abschlussarbeiten zitieren können! Dies liegt daran, dass die Informationen nicht durch Wissenschaftler

der jeweiligen Fächer begutachtet werden (peer review), nicht jedoch an der Qualität – diese ist

erfahrungsgemäß insbesondere bei Themen der Mathematik und Informatik sehr hoch.

Es ist ganz normal, wenn Sie am Anfang angesichts der vielen neuen Eindrücke und der Flut an

Begrifflichkeiten, Denkansätze und Techniken zunächst ’schwimmen’. Wichtig ist, dass sie weiterschwimmen!6 und auf diese Weise genügend Material zu sammeln, dass die Groschen auch fallen

können. Das kann je nach Umständen länger dauern, oder manchmal ganz schnell spontan geschehen.

Sorgen machen müssen Sie sich erst, wenn Sie trotz ernsthafter Bemühung7 das hier vorgestellte

Anliegen am Ende der Vorlesung immer noch nicht begreifen. Wenn Sie das Anliegen aber ver5 Hierbei

bezieht sich Klausurrelevanz auf die Methoden und Konzepte, nicht aber auf die konkreten Aufgabenstellungen und Beispiele. Die Klausur kann sehr wohl Fragestellungen des Motivationsteils oder der Übungsaufgaben

übernehmen. Nur lassen sich alle Klausuraufgaben allein mit den als klausurrelevant gekennzeichneten ’Werkzeugen’ bearbeiten.

6 Selbst der Soldat hat bei Wassertiefen ab 1,40m laut Soldatengesetz selbsttätig mit Schwimmbewegungen zu

beginnen.

7 Ernsthaft bedeutet hier zusätzlich zu den Veranstaltungen einen Zeitaufwand von wenigstens 5 vollen Stunden in

der Woche für die Bearbeitung der Übungsaufgaben und themenbezogenen Diskussionen mit Kommilitonen

8

innerlicht haben, dann steht einem erfolgreichen Informatikstudium nichts mehr im Wege. Dann

werden Sie zunehmend in der Lage sein, die Prinzipien und Verfahrensmuster selbst einzusetzen,

fehlende Details zu ermitteln, und sich in neue Thematiken einzuarbeiten.

Ganz wichtig ist es, sich klar zu machen, dass anspruchsvollere Texte, jedes mal wenn man sie liest,

wieder eine neue Ebene des Verstehens anregen. Wenn Sie dieses Skript z.B. im Hauptstudium

lesen, werden Sie auf Hinweise stoßen, die Ihnen früher verborgen geblieben sind, da sie zu dem

Zeitpunkt noch keine entsprechende Sensibilität entwickelt hatten. Das gilt natürlich nicht nur für

Texte. Wenn Sie im Studium auf ein Thema stoßen, dass Ihnen aus der Schule bekannt vorkommt,

sollten Sie besonders aufmerksam sein und zu erkennen versuchen, was neu ist an der universitären

Herangehensweise. Jede Stufe des Verstehens lässt Bekanntes ganz anders aussehen. Bleiben Sie

offen für diese Stufen. Sie werden sehen, es gibt sehr viele davon.

1.4 Lernziele und Kompetenzen zusammengefasst

Zweifelfreies Verstehen:

• mathematische Präzision

• dazugehörige Formalismen, sowie

• mathematisches Vorgehen

Einsatz wiederverwendbarer Muster:

• Beschreibungsmuster

• Strukturierungsmuster

• Beweismuster

• algorithmische Muster

Prinzipielles Vorgehen:

• Was ist der Kern des Problems?

• Was sind angemessene Lösungsmuster?

• Wie kann man diese Muster gezielt zur Problemlösung einsetzen?

• Wie erhält man ein spezifisches Lösungsszenario (Domänenmodellierung)

Beherrschung von Modellierungsspielräumen:

I Trennung von Syntax/Semantik: WIE vs. WAS

II (Induktives) Strukturieren

9

III Generalisierung und Abstraktion

als Grundlage für ’teile und herrsche’-Prinzipien wie:

IV Invarianz

V Kompositionalität

mit dem Ziel:

VI Korrektheit (z.B.(induktive) Beweisbarkeit)

VII Effizienz

VIII Skalierbarkeit

10

2 Aussagen und Mengen

2.1 Aussagen

In der Mathematik ist es von essentieller Bedeutung wissenschaftliche Erkenntnisse in (schrift-)sprachlicher

Form abzufassen. Da umgangssprachliche Formulierungen die Gefahr von Missverständnissen in

sich tragen, hat sich eine formalisierte Verwendung sprachlicher Konstrukte durchgesetzt. Fast

noch stärker gilt dies in der Informatik und der Logik, da hier oft Aussagen über verschiedene

Sinnebenen (z.B. Syntax und Semantik) miteinander in Zusammenhang gesetzt werden. Hier ist

selbst bei der Formalisierung größte Sorgfalt geboten, da es sonst zu Missverständnissen durch

Vermischung verschiedener Ebenen kommen kann.

Ein zentraler Begriff der gesamten Logik ist der Begriff der Aussage (engl. proposition), der sich

wie folgt definieren lässt:

Definition 2.1 (Aussagen). Aussagen sind (schrift-)sprachliche Gebilde, für die es sinnvoll ist,

ihnen einen Wahrheitswert wahr (w) oder falsch (f) zuzuordnen.

Leider ist auch diese Definition nicht völlig eindeutig. Problematisch ist hierbei die Formulierung

„sinnvoll“: Während es für viele Sätze unbestreitbar sinnvoll ist, ihnen Wahrheitswerte zuzuordnen,

ist dies bei anderen weit weniger klar. Wir werden dies weiter unten präzisieren, zunächst folgen

jedoch einige Beispiele für Sätze, die zweifellos Aussagen darstellen.

Beispiel 2.2 (Aussagen).

1. Borussia Dortmund ist Deutscher Fußballmeister der Herren 2011. (w)

2. Delfine sind Fische. (f)

3. 5 ist eine Primzahl. (w)

4. Es gibt nur endlich viele Primzahlen. (f)

5. Jede gerade Zahl größer als zwei ist Summe zweier Primzahlen. (?)

Aussage (4) ist falsch, denn mit dem Satz von Euklid1 lässt sich die Existenz unendlich vieler

Primzahlen nachweisen. Bei Aussage (5) hingegen handelt es sich um die sogenannte Goldbachsche

Vermutung2 , deren Gültigkeit bis heute nicht nachgewiesen werden konnte. Dennoch kann man

1 siehe

2 siehe

http://de.wikipedia.org/wiki/Satz%20von%20Euklid

http://de.wikipedia.org/wiki/Goldbachsche%20Vermutung

11

davon ausgehen, dass die Vermutung entweder durch einen Beweis nachgewiesen oder durch ein

Gegenbeispiel widerlegt werden kann.

Keine Aussagen im mathematischen Sinne sind:

Beispiel 2.3 (Keine Aussagen).

1. Wie spät ist es?

2. Kommt her!

3. Diese Aussage ist falsch.

Während es sich bei (1) und (2) um eine Frage beziehungsweise Anweisung handelt, hat (3) zumindest die äußere Form einer Aussage. Allerdings kann man dem Satz keinen eindeutig bestimmten

Wahrheitswert zuordnen, da es sich um ein logisches Paradoxon handelt: Jeder mögliche Wahrheitswert, den man (3) zuordnen kann, stünde im Widerspruch zum Inhalt des Satzes.

Zuletzt gibt es Sätze, bei denen die Einordnung unklar ist:

Beispiel 2.4.

1. Heute ist das Wetter schön.

2. Verdi hat die bedeutendsten Opern komponiert.

Bei nasskaltem Herbstwetter würden die meisten Menschen Satz (1) wohl für falsch befinden.

Allerdings ist die Beurteilung „schön“ immer von der jeweiligen Person abhängig, und manche

Leute mögen ein solches Wetter vielleicht als „schön“ empfinden. Bei Satz (2) kann man sich

durchaus Gedanken über eine objektive Betrachtung machen – die Bedeutsamkeit einer Oper ließe

sich beispielsweise daran messen, wie oft sie weltweit in einem Jahr aufgeführt wird. Dennoch

ist zu erwarten, dass beide mögliche Zuordnungen eines Wahrheitswerts zu diesem Satz manchen

Widerspruch aus der Musikwissenschaft nach sich ziehen würden.

In der Mathematik und Informatik sind solche Uneindeutigkeiten jedoch selten von Bedeutung:

Es wird verlangt, dass Aussagen in einer bestimmten, genau definierten Form vorliegen müssen

(Syntax), und dass es eindeutige Vorschriften gibt, wie sich die Wahrheitswerte dieser Aussagen

berechnen (Semantik). Dann ist die Zuordnung eines Wahrheitswerts zu einem – syntaktisch korrekten – Ausdruck durch die Semantik unmittelbar als „sinnvoll“ gerechtfertigt.

2.1.1 Aussagenlogik

In der Aussagenlogik betrachtet man, wie komplexere Aussagen aus einfachen Aussagen gebildet

werden können. Hierzu geht man von gewissen elementaren (auch: atomaren, griech. atomos =

„unteilbar“) Aussagen aus, welche zu neuen Aussagen verknüpft werden können. Zwei Gedanken

sind dabei zentral: Zum einen ist die Struktur der elementaren Aussagen nicht relevant, es genügt

die Annahme, dass ihnen ein Wahrheitswert zugeordnet werden kann. Die Frage, ob eine elementare

12

Aussage wirklich eine Aussage im Sinne von Definition 2.1 ist, stellt sich also überhaupt nicht.

Zum anderen findet das sogenannte Extensionalitätsprinzip Anwendung: Der Wahrheitswert der

komplexen Aussagen soll sich eindeutig aus den Wahrheitswerten der Teilaussagen ergeben.

Wir werden in den Kapiteln 4 und 5 späteren Kapiteln diese Sichtweise formal präzisieren, indem wir aussagenlogische Formeln (Syntax ) induktiv definieren und diesen dann induktiv eine

Bedeutung (Semantik ) zuweisen. Zunächst aber betrachten wir hier einen etwas weniger formalen

Zugang:

Definition 2.5 (Verknüpfung von Aussagen). Seien A und B beliebige Aussagen. Die folgenden

Gebilde sind dann ebenfalls Aussagen (aussagenlogische Formeln):

Negation von A: (¬A), gesprochen „nicht A“. Der Wahrheitswert von A wird invertiert.a

Disjunktion von A und B: (A ∨ B), gesprochen „A oder B“. Wahr genau dann, wenn mindestens

eine der beiden Aussagen wahr ist.

Konjunktion von A und B: (A ∧ B), gesprochen „A und B“. Wahr genau dann, wenn beide

Aussagen wahr sind.

Implikation von A und B: (A ⇒ B), gesprochen „A impliziert B“ oder „aus A folgt B“: Wahr

genau dann, wenn falls A wahr ist auch B wahr ist.b

Äquivalenz von A und B: (A ⇔ B), gesprochen „A ist äquivalent zu B“ oder „A genau dann,

wenn B“. Wahr genau dann, wenn beide Aussagen den gleichen Wahrheitswert besitzen.

a Gelegentlich

bA

wird die Negation auch durch einen Überstrich ausgedrückt: A.

ist die Prämisse und B die Konklusion der Implikation.

Bemerkenswert an Definition 2.5 ist die Selbstbezüglichkeit: Obwohl Aussagen im Sinne der Aussagenlogik dort erst definiert werden, so wird in der Definition bereits auf Aussagen A und B

zurückgegriffen. Da für Aussagen A, B, C auch ¬A und (B ∨ C) Aussagen sind, ist auch ¬(B ∨ C)

eine Aussage. An dieser Art des induktiven Definierens, das in Kapitel 4 formalisiert wird, lassen

sich sofort zwei Eigenschaften ablesen: Zum einen ist die Menge aller aussagenlogischen Formeln

unbegrenzt, da sich aus den vorhandenen stets neue, komplexere Aussagen bilden lassen. Zum anderen ist es leicht einsichtig, warum elementare Aussagen benötigt werden: Andernfalls hätte man

keinen Punkt, an dem man mit der Konstruktion einer aussagenlogischen Formel beginnen könnte.

Die Definitionen basieren selbst bereits auf einer der obigen Verknüpfungen: Die Formulierung

„genau dann, wenn ...“ drückt eine Äquivalenzbeziehung aus. Aufgrund der großen Wichtigkeit

dieser Beziehung kürzt man dies auch oft mit „gdw.“ (im Englischen iff = „if and only if“) ab.

Hier zeigt sich allerdings die in der Einleitung bereits angesprochene Wichtigkeit der Trennung

verschiedener Bedeutungsebenen: Die Äquivalenz „⇔“ ist eine Verknüpfung in der Aussagenlogik,

der eine bestimmte Bedeutung zugeordnet ist. Die Aussage „genau dann, wenn ...“ findet jedoch

auf einer Ebene statt, auf der man über die Aussagenlogik bzw. deren Semantik spricht. Die beiden

Ausdrücke sind in der obigen Definition also keinesfalls vertauschbar!

Bei der Implikation ist zu bedenken, dass diese im Falle einer nicht erfüllten Prämisse wahr ist. So

13

ist die Aussage:

10 ist eine Primzahl ⇒ Elefanten können fliegen

eine wahre Aussage. Aus einer logisch falschen Aussage lässt sich daher jede andere Aussage folgern

(lat. ex falso quodlibet, „aus dem Falschen folgt Beliebiges“).

Die Verknüpfungen ⇒ (Implikation) und ⇔ (Äquivalenz) drücken eine „wenn, dann ...“- bzw. „genau

dann, wenn ...“-Beziehung aus. Im normalen Sprachgebrauch vernachlässigt man diese Trennung

jedoch oft. So trifft der Satz „Wenn heute die Sonne scheint, gehe ich schwimmen“ formal logisch

gesehen keine Aussage über den Fall, dass die Sonne nicht scheint – anders als eine „Genau dann,

wenn ...“-Formulierung, also eine Äquivalenz.

Eine weitere Verknüpfung, die weniger in der mathematischen Logik, dafür umso mehr in der

Informatik eine Rolle spielt, ist das sogenannte XOR (von engl. eXclusive OR, „exklusives Oder“,

auch als Kontravalenz oder Antivalenz bezeichnet), ausgedrückt durch das Zeichen ⊕. Die Aussage

A ⊕ B ist genau dann wahr, wenn entweder A oder B, aber nicht beide wahr sind. Es lässt sich

leicht überprüfen, dass dies die Negation der Äquivalenz ist.

Eine zentrale Eigenschaft der XOR-Verknüpfung ist die Tatsache, dass eine zweifache Anwendung

mit dem gleichen Operand wieder den ursprünglichen Wahrheitswert ergibt, d.h. (A⊕B)⊕B besitzt

den gleichen Wahrheitswert wie A. In der Informatik ist sie insbesondere in der Kryptographie von

Bedeutung.

Die Verknüpfungssymbole ¬, ∨, ∧, ⇒ und ⇔ werden auch Junktoren genannt. Um Klammern einzusparen vereinbart man, dass bei der Auswertung ¬ Vorrang vor anderen Junktoren, ∧ Vorrang

vor allen Junktoren außer ¬ und ∨ Vorrang vor ⇒ und ⇔ hat.3

Eine formalere Form der Auswertung von Aussagen im Sinne der Aussagenlogik erlaubt die im

Folgenden dargestellte Wahrheitstafel, welche die in Definition 2.5 Verknüpfungen zusammenfasst:

A

f

f

w

w

B

f

w

f

w

¬A

w

w

f

f

A∨B

f

w

w

w

A∧B

f

f

f

w

A ⇒ B

w

w

f

w

A ⇔ B

w

f

f

w

Die Spalten einer Wahrheitstafel lassen sich in zwei Hälften einteilen: Auf der linken Seite stehen

die elementaren Aussagen (hier A und B), auf der rechten Seite finden sich die aus diesen zusammengesetzten aussagenlogischen Formeln. Eine Zeile in der Wahrheitstafel korrespondiert zu einer

eindeutigen Belegung der elementaren Aussagen mit einem Wahrheitswert. In den Zellen schließlich

finden sich die Wahrheitswerte der Aussagen unter der jeweiligen Belegungen.

Es lässt sich zeigen, dass man für eine gegebene Menge von elementaren Aussagen und eine beliebige

Spalte in der zugehörigen Wahrheitstafel eine aussagenlogische Formel konstruieren kann, deren

Auswertung genau die in der Spalte vorgegebenen Wahrheitswerte ergibt. Dies ist beispielsweise

3 Man

sagt auch, dass ¬ stärker bindet als ∧. Die Rangfolge der Junktoren bezeichnet man auch als Operatorenpräzedenz, in der Arithmetik wird diese durch die Regel „Punkt- vor Strichrechnung“ verkörpert.

14

durch die Konstruktion der disjunktiven Normalform (DNF) möglich, ein Verfahren, welches in

der Vorlesung „Rechnerstrukturen“ vorgestellt wird. Die resultierenden Formeln enthalten sogar

lediglich die Junktoren ¬, ∧ und ∨. Man sagt daher auch, dass die Junktorenmenge {¬, ∧, ∨}

funktional vollständig sei.

Aussagen A und B, deren Wahrheitstafeleinträge gleich sind, werden als (semantisch) äquivalent

bezeichnet (in Zeichen A ≡ B). Zum Beispiel kann die Konjunktion, die Implikation und die

Äquivalenz wie folgt durch alleinige Verwendung der Junktoren ¬ und ∨ ausgedrückt werden.

A∧B

≡

¬(¬A ∨ ¬B)

(2.1)

A ⇒ B

≡

¬A ∨ B

(2.2)

A ⇔ B

≡

¬(¬(¬A ∨ B) ∨ ¬(¬B ∨ A)))

(2.3)

Es sei darauf hingewiesen, dass die semantische Äquivalenz ≡ nicht etwa Junktor der Aussagenlogik

ist, sondern – vergleichbar zu „genau dann, wenn ...“ – Metasymbol, um Aussagen über Aussagen

zu formulieren. Es gilt jedoch, dass für äquivalente Aussagen A ≡ B die Aussage A ⇔ B eine

Tautologie, sprich eine immer wahre Aussage ist.

Größe von Wahrheitstafeln. Bei der Betrachtung aussagenlogischer Formeln interessiert man

sich seltener für den Wahrheitswert unter einer bestimmten Belegung, sondern für die Gesamtheit

aller möglichen Belegungen: Ist eine Aussage widersprüchlich (auch: unerfüllbar), d.h. unter keiner

möglichen Belegung wahr? Ist sie zumindest erfüllbar, d.h. unter mindestens einer Belegung wahr?

Oder ist sie gar eine Tautologie (auch: allgemeingültig), also wahr unter jeder möglichen Belegung?

Man erkennt schnell, dass man für die eindeutige Beantwortung dieser Fragen mithilfe einer Wahrheitstafel immer die gesamte Wahrheitstafel kennen muss – für widersprüchliche und allgemeingültige Aussagen im Falle einer positiven, für die Erfüllbarkeit im Falle einer negativen Antwort.

Jedoch wächst die Größe einer Wahrheitstafel exponentiell mit der Anzahl elementarer Aussagen:

Bei n elementaren Aussagen sind 2n Zeilen erforderlich. Sind im Falle von 2 elementaren Aussagen 4 Zeilen, wie in der obigen Wahrheitstafel, auch für einen Menschen noch überschaubar, so

wird dies bei 5 elementaren Aussagen (32 Zeilen) bereits schwer und bei 10 elementaren Aussagen (1024 Zeilen) unmöglich. Auch Computer geraten spätestens ab n = 50 an ihre Grenzen. In

der Vorlesung „Logik für Informatiker“ werden daher Algorithmen vorgestellt, welche den Test auf

(Un-)Erfüllbarkeit aussagenlogischer Formeln, teilweise unter gewissen Einschränkungen, wesentlich effizienter als durch Berechnung einer Wahrheitstafel durchführen können.

Die Äquivalenzen 2.1 und 2.2 sind exemplarisch in der folgenden Wahrheitstafel bewiesen:

A

f

f

w

w

B

f

w

f

w

¬A

w

w

f

f

¬B

w

f

w

f

¬A ∨ ¬B

w

w

w

f

¬(¬A ∨ ¬B)

f

f

f

w

A∧B

f

f

f

w

¬A ∨ B

w

w

f

w

A⇒B

w

w

f

w

15

Die Gleichungen (2.1) - (2.3) zeigen, dass Negation und Disjunktion alleine ausreichen, um alle

in Definition 2.5 eingeführten Aussagenverknüpfungen auszudrücken. Dies ist nicht überraschend:

Da die Junktorenmenge {¬, ∧, ∨} funktional vollständig ist, und sich ∧ durch ¬ und ∨ ausdrücken

lässt (Äquivalenz 2.1), ist natürlich auch die Menge {¬, ∨} funktional vollständig, also insbesondere

auch ausreichend, um Implikation und Äquivalenz auszudrücken.

Tatsächlich genügt sogar schon ein einziger Operator: Definiert man die „Nicht-Und“-Verknüpfung

(auch NAND-Verknüpfung, Not AND, genannt), durch A ∧ B =df ¬(A∧B), so lässt sich die Negation ausdrücken durch ¬A ≡ A ∧ A und die Disjunktion durch A∨B ≡ ¬A ∧ ¬B ≡ (A ∧ A) ∧(B ∧ B).

Die NAND-Verknüpfung alleine ist also bereits funktional vollständig. Dies ist insbesondere im

Schaltwerksentwurf von Bedeutung, wo es von Vorteil ist, möglichst einheitliche Bausteine zu verwenden.

Im Folgenden werden semantische Äquivalenzen von aussagenlogischen Formeln aufgelistet, welche

insbesondere für die Vereinfachung von Formeln von Bedeutung sind. T und F stehen hierbei als

Symbole für eine immer wahre bzw. immer falsche Aussage. Den Nachweis dieser Äquivalenzen mit

Hilfe von Wahrheitstafeln überlassen wir dem Leser als Übungsaufgabe.

Lemma 2.6 (Semantische Äquivalenzen). Es gelten für beliebige Aussagen A, B, C die folgenden

Äquivalenzen:

16

A∧B

A∨B

≡

≡

B ∧A

B ∨A

(A ∧ B) ∧ C

(A ∨ B) ∨ C

≡

≡

A ∧ (B ∧ C)

A ∨ (B ∨ C)

A ∧ (A ∨ B)

A ∨ (A ∧ B)

≡

≡

A

A

A ∧ (B ∨ C)

A ∨ (B ∧ C)

≡

≡

(A ∧ B) ∨ (A ∧ C)

(A ∨ B) ∧ (A ∨ C)

A ∧ ¬A

A ∨ ¬A

≡

≡

F

T

(Negation)

A∧A

A∨A

≡

≡

A

A

(Idempotenz)

¬ ¬A

≡

A

(Doppelnegation)

¬(A ∧ B)

¬(A ∨ B)

≡

≡

¬A ∨ ¬B

¬A ∧ ¬B

T ∧ A

F ∨ A

≡

≡

A

A

(Kommutativität)

(Assoziativität)

(Absorption)

(Distributivität)

(deMorgansche Regeln)

( Neutralität)

Negationsnormalform. Die sogenannten deMorganschen Regeln erlauben es, eine Negation von

einem Junktor auf die Operanden zu verschieben. Bei der Verarbeitung von aussagenlogischen

Formeln ist es oftmals unerwünscht, dass ganze Teilausdrücke negiert werden. Die wiederholte

Anwendung der deMorganschen Regeln sowie der Elimination von Doppelnegationen erlaubt es,

die Formel in eine semantisch äquivalente Formel zu transformieren, in der Negationen nur noch

unmittelbar vor elementaren Aussagen auftreten. Dieses Vorgehen bezeichnet man als negation

pushing, die resultierende Form bezeichnet man als Negationsnormalform (NNF).

2.1.2 Anwendung: Digitale Schaltkreise

In der bisher betrachteten Aussagenlogik liegt der Fokus auf der Kombination elementarer Aussagen

zu größeren Konstrukten. Die Struktur elementarer Aussagen ist nicht relevant. Die Aussagenlogik

ist daher in Szenarien adäquat, wo nicht näher untersuchte Basisobjekte genau zwei Werte annehmen können. Dieses ist zum Beispiel in der Theorie digitaler Schaltkreise der Fall. Dort geht es um

die Verarbeitung binärer Signale, die durch zwei unterschiedliche Spannungspotentiale, etwa 0 V

(entspricht f oder 0) und 5 V (entspricht w oder 1), realisiert werden.

Wir betrachten hier zunächst die Funktionalität eines Halbaddierers. Dieser addiert die an zwei

Eingängen A und B anliegende Signale (entweder 0 oder 1) und erzeugt dabei gegebenenfalls einen

Überlauf (oder Übertrag), der von einem nachgeschalteten Volladdierer verarbeitet werden kann.

Liegt an einem von beiden Eingängen eine 1 an, so ergibt sich als Summe am Ausgang Z ebenfalls 1,

ein Überlauf geschieht nicht. Liegt jedoch an beiden Eingängen 1 an, so ist – wie in der schriftlichen

Addition, hier in das Binärsystem übertragen – die Summe 0, dafür aber wird der Überlauf Ü auf

1 gesetzt.

Abbildung 2.a: Halbaddierer aus NAND-Bausteinen

In Abbildung 2.a findet sich das Schaltbild eines Halbaddierers, der ausschließlich aus NANDBausteinen besteht.a Die Wahrheitstafel für die Gesamtfunktionalität des Halbaddieres ist in Tabelle 2.a zu finden.

17

A B

0 0

0 1

1 0

1 1

Tabelle 2.a:

a Dies

C

D

E

Z

Ü

z }| { z }| { z }| { z }| { z }| {

¯ B A∧

¯ C C∧

¯ B D∧

¯ E C∧

¯C

A∧

1

1

1

0

0

1

1

0

1

0

1

0

1

1

0

0

1

1

0

1

Wahrheitstafel zu Schaltung aus Abbildung 2.a

ist aufgrund der funktionalen Vollständigkeit von NAND für jede Schaltung möglich.

Wir werden digitale Schaltkreise an dieser Stelle nicht weiter vertiefen. Diese werden ausführlich

in der Vorlesung Rechnerstrukturen oder Elektrotechnik-Vorlesungen (wie z.B. Elektrotechnik und

Nachrichtentechnik) behandelt.

2.1.3 Prädikatenlogik

Genügt die Aussagenlogik zur Beschreibung der Theorie digitaler Schaltkreise, so ist sie für die

Behandlung allgemeiner mathematischer Theorien zu eingeschränkt, da die innere Struktur der

elementaren Aussagen dort eine Rolle spielt. Beispielsweise folgen die Aussagen

1+2

=

2+1

2+3

=

3+2

6 + 14

=

..

.

14 + 6

alle demselben Muster. Sie drücken nämlich die Kommutativität der Addition natürlicher Zahlen

aus. Diesem wird durch die Einführung quantifizierter Ausdrucksformen wie „für alle“ und „es

gibt“ in der Prädikatenlogik Rechnung getragen. Bezeichnet N die Menge der natürlichen Zahlen,4

so drückt die prädikatenlogische Formel

∀ x ∈ N. ∀ y ∈ N. x + y = y + x

den Tatbestand der Kommutativität aus.

Wir verzichten in dieser Vorlesung auf eine formal fundierte Einführung der Prädikatenlogik und

verweisen auf vertiefende Vorlesungen wie Logik für Informatiker. Wesentlicher Bestandteil der

Prädikatenlogik ist eine zugrundeliegende Struktur. Hierunter versteht man eine nichtleere Menge sogenannter Individuen mit zugehörigen Operationen und Relationen (siehe Kapitel 3.1). Ein

wichtiges Beispiel für eine solche Struktur sind die natürlichen Zahlen N, auf denen die Operationen Addition und Multiplikation definiert sind, und welche über die Gleichheits- und ≤-Relation

miteinander verglichen werden können. Die Prädikatenlogik über den natürlichen Zahlen erweitert

die Aussagenlogik in folgender Weise:

4 Im

Verlauf dieses Skripts gehen wir davon aus, dass auch 0 eine natürliche Zahl ist. Für die Menge der echt

positiven natürlichen Zahlen schreiben wir dann N+ .

18

1. Die Junktoren der Aussagenlogik dürfen wie gewohnt zum Kombinieren von Aussagen verwendet werden.

2. Zusätzlich dürfen relationale Ausdrücke mit freien Variablen über natürlichen Zahlen, wie

z.B. n + 1 ≤ 3, verwendet werden. Man spricht hier von Prädikaten oder Aussageformen.5

Aussageformen dürfen auch mehrere freie Variablen enthalten.

3. Aussageformen können unter Verwendung des All- und Existenzquantors in Aussagen überführt werden. Für eine Aussageform A(n) mit freier Variable n bilden wir die:

Allaussage: ∀ n. A(n). Diese ist genau dann wahr, wenn A(n) für alle Werte n ∈ N wahr ist.

Existenzaussage: ∃ n. A(n). Diese ist genau dann wahr, wenn A(n) für mindestens einen

Wert n ∈ N wahr ist.

Ist die zugrundeliegende Struktur der natürlichen Zahlen nicht aus dem Kontext ersichtlich,

schreiben wir auch ∀ n ∈ N. A(n) bzw. ∃ n ∈ N. A(n). In der quantifizierten Formel ist

die Variable n an den Quantor gebunden und kann somit nicht durch äußere quantifizierte

Formeln referenziert werden.

Auf einen Quantor muss nicht immer unmittelbar eine Aussageform folgen. Ist bspw. B eine

Aussageform mit zwei freien Variablen, so kann man z.B. schreiben ∀ n. ∃ m. B(n, m).

Natürlich lassen sich auch Prädikatenlogiken über anderen Strukturen als den natürlichen Zahlen definieren. Um Klammern einzusparen vereinbart man, dass Quantoren schwächer binden als

alle Junktoren. Soll eine engere Bindung zum Ausdruck gebracht werden, müssen quantifizierte

Aussagen entsprechend geklammert werden. Statt ¬(∀ n. A(n)) und ¬(∃ n. A(n)) schreiben wir

kurz 6 ∀ n. A(n) und @ n. A(n). Geschachtelte quantifizierte Aussagen mit demselben Quantor, etwa

∀ x1 . ∀ x2 . . . . ∀ xn . A(x1 , . . . , xn ), können abgekürzt durch ∀ x1 , . . . , xn . A(x1 , . . . , xn ) dargestellt

werden.

Oft führt man in der Prädikatenlogik auch Relationen als Abkürzungen für komplexere Teilformeln

mit freien Variablen ein. Wir demonstrieren dieses für die Eigenschaft des größten gemeinsamen

Teilers (ggT). Als Hilfsmittel definieren wir zunächst die Teilbarkeitsrelation:

n|m =df ∃ k ∈ N. n · k = m.

In Worten: n teilt m, falls es eine natürliche Zahl k gibt, so dass das k-fache von n die Zahl m

ergibt. Darauf aufbauend definieren wir eine dreistellige Relation ggT , die ausdrückt, wann eine

natürliche Zahl x größter gemeinsamer Teiler der natürlichen Zahlen n und m ist:

ggT (n, m, x) =df x|n ∧ x|m ∧ ∀ y ∈ N. (y|n ∧ y|m) ⇒ y ≤ x.

Durch x|n ∧ x|m wird zunächst die Forderung ausgedrückt, dass x ein gemeinsamer Teiler von

n und m ist. Die dann folgende Allaussage drückt die Forderung aus, dass x größer oder gleich zu

5 Der

Begriff Aussageform bringt zum Ausdruck, dass eine solche erst durch das Zuordnen von Werten für die

Variablen zur Aussage wird. Beispielsweise ergibt n + 1 ≤ 3 für n 7→ 2 eine wahre, aber für n 7→ 3 eine falsche

Aussage.

19

jedem anderen gemeinsamen Teiler ist. Da die ggT-Relation auch als Funktion (siehe Kapitel 3.2)

ggT : N × N → N angesehen werden kann, schreibt man statt ggT (n, m, x) auch x = ggT (n, m).

Hier zeigt sich einer der wesentlichen Unterschiede zwischen Mathematik und Informatik: Anhand

der obigen prädikatenlogischen Ausdrücke lässt sich die ggT -Funktion mathematisch einwandfrei

definieren. Zu einer Funktion im Sinne der Informatik gehört jedoch eine Berechnungsvorschrift,

d.h. eine algorithmische Beschreibung, wie man zum korrekten Ergebnis gelangt. In der Definition

des obigen ggT -Prädikats ist eine solche nicht enthalten! Selbst der Test auf Teilbarkeit liefert keine

explizite Beschreibung, wie ein geeignetes k zu finden ist.

Will man jedoch einen Bezug zwischen einer Implementierung der Funktion und dem mathematischen Phänomen des größten gemeinsamen Teilers herstellen, die Korrektheit des Programms also

verifizieren, so ist es oftmals unabdingbar, sich auf die formalen Definitionen etwa in Form der

obigen prädikatenlogischen Formel zu stützen. Dies gilt beispielsweise für die Ableitung korrekter

Invarianten, die ein Schlüsselwerkzeug zur Programmverifikation darstellen. Für das Problem der

ggT-Berechnung mittels des Euklidischen Algorithmus werden wir dies an späterer Stelle auch

durchführen.

Eine häufige Quelle von Missverständnissen ist die Auswirkung logischer Negation auf quantifizierte

Formeln, da diese sich nicht unbedingt mit dem Alltagsverständnis deckt. So ist die Negation von

„alle“ keinesfalls „keiner“, sondern eben „nicht alle“. Formal gilt folgender Zusammenhang:

Lemma 2.7 (Negation von quantifizierten Formeln). Sei A eine Aussageform mit einer freien

Variablen. Dann gelten die folgenden Äquivalenzen:

1. ¬(∀ x. A(x)) ≡ ∃ x. ¬A(x)

2. ¬(∃ x. A(x)) ≡ ∀ x. ¬A(x)

Beweis Wir zeigen exemplarisch die erste Eigenschaft, wobei wir die Struktur natürlicher Zahlen

zugrunde legen.

¬(∀ x. A(x)) ist wahr gdw.

gdw.

gdw.

gdw.

∀ x. A(x) ist falsch

A(x) ist falsch für mindestens ein x

¬A(x) ist wahr für mindestens ein x

∃ x. ¬A(x) ist wahr

(Auswertung ¬)

(Auswertung ∀)

(Auswertung ¬)

(Auswertung ∃)

2

Negationsnormalform. Ähnlich wie über die deMorganschen Regeln lassen sich auch mit den

obigen Äquivalenzen Negationen auf eine tiefere Ebene verschieben. Eine Negationsnormalform,

wie in Abschnitt 2.1.1 beschrieben, lässt sich also auch für prädikatenlogische Formeln definieren. Hierbei wendet man – solange dies möglich ist – die Elimination doppelter Negationen, die

deMorganschen Regeln oder die Regeln zur Negation von Quantoren an. Das Ergebnis ist eine

prädikatenlogische Formel, in der Negationssymbole nur noch unmittelbar vor aus Aussageformen

gebildeten Aussagen auftreten.

20

2.1.4 Logische Beweisprinzipien

Während Wahrheitstafeln ausreichen um beliebige Sätze der Aussagenlogik zu beweisen, kann ein

tabellarischer Ansatz in der Prädikatenlogik wegen der im Regelfall unendlich großen zugrundeliegenden Strukturen nicht mehr zielführend sein. Prinzipiell gibt es beim Beweisen zwei unterschiedliche Ansätze. Zum einen kann ein Beweis semantisch vorgehen, d.h. sich direkt an der Definition

der Semantik der logischen Konstrukte (Junktoren und Quantoren) orientieren. Ein Beispiel für

eine solches Vorgehen ist der Beweis zu Lemma 2.7.6 Zum anderen können als gültig nachgewiesene

Regeln verwendet werden, um die zu beweisende Behauptung syntaktisch zu transformieren. Auf

diesem Vorgehen basieren insbesondere automatisierte Beweissysteme. Ein Beweis für die semantische Äquivalenz T ∨ A ≡ T, der sich ausschließlich auf die Regeln aus Lemma 2.6 stützt, ist:

T∨A

≡

≡

≡

≡

≡

≡

(A ∨ ¬A) ∨ A

(Negation)

A ∨ (¬A ∨ A)

(Assoziativität)

A ∨ (A ∨ ¬A) (Kommutativität)

(A ∨ A) ∨ ¬A

(Assoziativität)

A ∨ ¬A

(Idempotenz)

T

(Negation)

Der vorangegangene Beweis folgt einem Vorgehen, welches zentral für die gesamte Mathematik ist:

Dem axiomatischen Beweisen. Beim axiomatischen Beweisen wird die Gültigkeit einer Behauptung nachgewiesen, indem man sie aus bekannten, als wahr angenommenen Sätzen (den Axiomen)

herleitet. In diesem Beispiel waren dies die in Lemma 2.6 festgehaltenen Äquivalenzen.

Beweisprinzip 2.8 (Axiomatisches Beweisen).

Aus einer Menge von Axiomen, also als wahr vorausgesetzten Sätzen, wird die zu zeigende

Behauptung abgeleitet.

In der mathematischen Praxis verwendet man meist ein gemischtes Vorgehen. Immer wenn ein

praktisch besonders relevantes Beweismuster eingesetzt wird, wird dies in der obigen Weise festgehalten.

Der Begriff „Axiom“

Zentral für den Begriff des Axioms ist die Tatsache, dass dieses als wahr angenommen wird, ohne

dass es bewiesen werden muss – und im strengen Sinne auch nicht bewiesen werden kann. Die

in Lemma 2.6 festgehaltenen Äquivalenzen lassen sich natürlich anhand einer Wahrheitstafel über

die in Definition 2.5 definierte Semantik beweisen, dies ist jedoch für die Gültigkeit des obigen

Beweises nicht notwendig! Nimmt man lediglich ein System an, in dem die Gesetzmäßigkeiten aus

6 Da

die Semantik von Prädikatenlogik in diesem Kapitel nicht vollständig formal ausgeführt ist, sollte man genau

genommen von einem intuitiv semantischen Beweis sprechen. In Kapitel 5 werden wir anhand der formalen

Semantik genauer argumentieren.

21

Lemma 2.6 gelten, so lässt sich die Aussage T ∨ A ≡ T ebenso beweisen, die Negationsregel selbst

ist jedoch nicht ohne Zirkelschluss ableitbar.

Die gesamte moderne Mathematik basiert auf einem solchen Axiomensystem (genauer: auf einer

Axiomatisierung der Mengenlehre, siehe den folgenden Abschnitt). Eine boshafte Interpretation

hiervon ist die Behauptung, Mathematik gründe sich ausschließlich auf willkürliche Annahmen.

Tatsächlich sind auch Systeme denkbar, in denen zusätzliche Axiome gelten, oder aber manche der

gemeinhin verwendeten Axiome als falsch angenommen werden. Dies ist weniger eine Frage von

richtig oder falsch als davon, ob sich im resultierenden System als relevant erachtete Sätze ableiten

lassen – auch wenn Mathematik Grundlage vieler Naturwissenschaften ist, so ist sie nicht per se

zu einer korrekten (was auch immer dies bedeuten mag) Abbildung der Wirklichkeit verpflichtet!

Anforderungen, die man auf einer höheren Ebene an Axiomensysteme stellen kann, sind ihre Konsistenz (aus den Axiomen lässt sich nicht sowohl ein Satz als auch seine Negation ableiten) und

Vollständigkeit (sämtliche wahren Sätze lassen sich aus den Axiomen ableiten). Dem sind jedoch

enge Grenzen gesetzt: In Axiomensystemen hinreichender Komplexität ist weder die Konsistenz

beweisbar, noch die Vollständigkeit realisierbar. Dies wird in Abschnitt 2.3 noch genauer ausgeführt.

2.2 Mengen

Die Mengenlehre als eigenständige mathematische Disziplin geht zurück auf Arbeiten von Georg

Cantor aus dem späten 19. Jahrhunderts. Im Rahmen seiner Arbeit formulierte er folgende Mengendefinition:

Definition 2.9. Unter einer Menge verstehen wir jede Zusammenfassung M von bestimmten

wohlunterschiedenen Objekten m unserer Anschauung oder unseres Denkens (welche die Elemente

von M genannt werden) zu einem Ganzen.

Für eine Menge M kennzeichnet die Aussage m ∈ M , dass m ein Element von M ist. Für die

negierte Aussage ¬(m ∈ M ) wird abkürzend auch m ∈

/ M geschrieben.

Mengen lassen sich in unterschiedlicher Weise beschreiben. Endliche Mengen lassen sich durch

Aufzählung ihrer Elemente beschreiben. So stellt M1 = {♣, ♠, ♥, ♦} die Menge der Kartenfarben

von Spielkarten und M2 = {Montag, Dienstag, Mittwoch, Donnerstag, Freitag, Samstag, Sonntag}

die Menge der Wochentage dar. Auch für unendliche Mengen ist eine solche Beschreibung prinzipiell

möglich, wenn die Beschreibung unmissverständlich ist. So kann man die aus der Schulmathematik

bekannte Menge der natürlichen Zahlen aufzählend beschreiben als N = {0, 1, 2, 3, . . .} und die

Menge der geraden natürlichen Zahlen als Nger = {0, 2, 4, 6, . . .}.7

Die beschreibende Form charakterisiert Mengen, indem die enthaltenen Elemente durch ein Prädikat

charakterisiert werden. So kann die Menge der Primzahlen beschrieben werden durch

P rim = {p | p ∈ N ∧ p ∈

/ {0, 1} ∧ ∀ n ∈ N. n | p ⇒ n ∈ {1, p}}.

7 In

22

Kapitel 4 wird das Konzept des induktiven Definierens als Formalisierung der “..”-Notation eingeführt.

Allgemein hat die beschreibende Form einer Menge M die Gestalt

M = {m | A(m)},

wobei A(m) Prädikat über m, also eine Aussageform mit freier Variablen m ist. Sind die Elemente von m aus einer in A(m) beschriebenen Grundmenge, so kann diese Information auch der

Variablenangabe zugeschlagen werden. Im Falle der Primzahlen hätten wir also:

P rim = {p ∈ N | p ∈

/ {0, 1} ∧ ∀ n ∈ N. n|p ⇒ n ∈ {1, p}}.

Ist A(m) ein unerfüllbares Prädikat so wird dadurch die leere Menge ∅ beschrieben, also ∅ = {x |

F}. Die leere Menge ist die eindeutig bestimmte Menge, die kein Element enthält. Es gilt also

∀ x. x ∈

/ ∅.8

Charakteristisch für Mengen sind die folgenden zwei Eigenschaften:

• Eine Menge definiert keine Anordnung ihrer Elemente. Die Menge {1, 2, 3} unterscheidet sich

nicht von der Menge {3, 2, 1}.

• Elemente einer Menge haben keine Vielfachheit. Von Interesse ist ausschließlich, welche Elemente vorhanden sind. So bezeichnet {1, 1, 2, 2} die gleiche Menge wie {1, 2}.

2.2.1 Mengenbeziehungen

Bei der Betrachtung von Mengen ist es oftmals von Interesse, wie diese sich zueinander verhalten.

Ein naheliegendes Konzept zum Vergleichen zweier Mengen ist natürlich die Betrachtung, ob diese

die gleichen Elemente enthalten, also ob die Mengen an sich gleich sind. Aber auch im Falle

ungleicher Mengen gibt es interessante Fragen: Sind alle Elemente der einen Menge auch in der

anderen Menge enthalten? Formal spricht man hier von einer (echten) Teilmengenbeziehung. Diese

Betrachtung liefert die folgenden Mengenbeziehungen.

Definition 2.10 (Mengenbeziehungen). Seien A und B Mengen. Es gelten die folgenden Beziehungen:

1. A ⊆ B (sprich A ist Teilmenge von B) ⇔df

2. A = B (sprich A ist gleich B) ⇔df

(∀ x. x ∈ A ⇒ x ∈ B)

A ⊆ B ∧ B ⊆ A.

3. A ⊂ B (sprich A ist echte Teilmenge von B) ⇔df

A ⊆ B ∧ A 6= B.

Per Definition ist die leere Menge Teilmenge jeder anderen Menge. Die (echte) Teilmengenbeziehung

von Mengen lässt sich anschaulich gut in einem sogenannten Venn-Diagramm (Abb. 2.1) darstellen.

In diesem werden Mengen durch geometrische Formen (z.B. Kreise) repräsentiert, welche sich

überdecken, ineinander enthalten sind, sich überschneiden oder schnittfrei sind.

8 Auch

wenn „Mengen von Mengen“ erst zu einem späteren Zeitpunkt behandelt werden, so sei bereits an dieser Stelle

angemerkt, dass sich die leere Menge ∅ von der Menge {∅}, welche nur die leere Menge enthält, unterscheidet!

23

A ⊂ B

A

B

Abbildung 2.1: Venn-Diagramm der echten Teilmengenbeziehung

Potenzmengen

Mengen, deren Elemente selbst Mengen über einer Grundmenge M , sind bezeichnet man als Mengensysteme über M . Ein besonders wichtiges Mengensystem ist die Menge aller Teilmengen von

M:

Definition 2.11 (Potenzmenge). Sei M eine Menge. Die Potenzmenge von M ist definiert durch

P(M ) =df {M 0 | M 0 ⊆ M }.

Zu bemerken ist hier, dass die Potenzmenge P(M ) stets sowohl die Grundmenge M als auch die

leere Menge ∅ enthält. Einen besonderen Fall stellt die leere Menge ∅ dar, wo diese beiden Mengen

identisch sind und außerdem das einzige Element der Potenzmenge darstellen; es gilt P(∅) = {∅}.

Beispiel 2.12. Für M = {1, 2, 3} gilt P(M ) = { ∅, {1}, {2}, {3}, {1, 2}, {1, 3}, {2, 3}, M }.

2.2.2 Mengenverknüpfungen

Analog zu den logischen Junktoren, welche Aussagen miteinander verknüpfen, existieren auch

Mengenverknüpfungen, welche die Bildung neuer Mengen aus bestehenden erlauben.

Definition 2.13 (Verknüpfung von Mengen). Seien A und B Mengen. Dann sind folgende Mengenverknüpfungen definiert:

Vereinigung A ∪ B =df {x | x ∈ A ∨ x ∈ B}

Schnitt A ∩ B =df {x | x ∈ A ∧ x ∈ B}

Differenz A \ B =df {x | x ∈ A ∧ x 6∈ B}

Symmetrische Differenz A ∆ B =df (A ∪ B) \ (A ∩ B)

Wie man an der obigen Definition erkennt, weisen die aussagenlogischen Junktoren ∧ und ∨ mit den

Mengenverknüpfungen ∩ und ∪ nicht nur optische Ähnlichkeit auf, stattdessen sind sie zentral für

die Definition derselben. Die symmetrische Differenz ∆ entspricht weiterhin der XOR-Verknüpfung.

24

Falls A ∩ B = ∅ gilt, so nennt man A und B disjunkt. Bei der Übertragung auf mehrere Mengen

ist zu beachten, dass bspw. M1 ∩ M2 ∩ . . . ∩ Mn = ∅ keinesfalls bedeutet, dass diese Mengen jeweils

verschiedene Elemente enthalten, sondern lediglich, dass kein Element in allen Mengen enthalten

ist. Ist jedes Element nur in höchstens einer Menge enthalten, so sagt man, dass die Mengen

M1 , . . . , Mn paarweise disjunkt sind. In einer prädikatenlogischen Formel lässt sich dies ausdrücken

als:

∀ i, j ∈ {1, . . . , n}. i 6= j ⇒ Mi ∩ Mj = ∅.

Für eine gegebene Grundmenge M mit Teilmenge A ⊆ M ist weiterhin das Komplement von A

definiert als A{ =df M \ A.