einführung in empirische methoden für sportwissenschaftler

Werbung

Fritz Brunner

EINFÜHRUNG IN

EMPIRISCHE METHODEN

FÜR SPORTWISSENSCHAFTLER

SS 2007

2

Inhaltsübersicht

Einleitung: Aufgaben des Proseminars

A. Empirische Untersuchungen

1. Gegenstand empirischer Untersuchungen

Leistungskontrolle

Fähigkeitskontrolle

Fertigkeits- oder Technikkontrolle

2. Phasen der empirischen Forschung

3. Untersuchungspläne und Auswertemethoden (Übersicht)

Untersuchungspläne

1. Querschnittsuntersuchungen

2. Längsschnittsuntersuchungen (Messwiederholungen)

3. Komb. Untersuchungen

Beschreibende und explorative statistische Verfahren

Prüfstatistik

4

5

5

5

5

6

6

7

7

7

7

7

8

9

B. Beschreibende Statistik

10

1. Skalenniveau

11

1.1. Nominalskala

1.2. Ordinalskala

1.3. Metrische Skalen

1.3.1. Intervallskala

1.3.2. Rationalskala

2. Verfahren bei nominalskalierten Daten

2.1. Tabellarische Ordnung

2.2. Graphische Darstellungen

2.3. Rechnerische Verfahren

2.3.1. Relativzahlen

Gliederungszahlen

Beziehungszahlen

Verhältniszahlen

Risiko

2.3.2. Zusammenhang nominalskalierter Variablen

Φ-Koeffizient

Kontingenzkoeffizient

3. Verfahren bei intervallskalierten Daten

3.1. Listen/Tabellen

3.2. Graphische Darstellung von Verteilungen

3.3. Statistische Kennwerte

3.3.1. Kennwerte für die zentrale Tendenz (Lagemaße)

Arithmetisches Mittel (Mean)

Median (Zentralwert)

Modus (Modalwert, Gipfelwert, Dichtemittel)

3.3.2. Maße für die Streuung (Dispersionsmaße)

Variationsbreite oder Spannweite (Range)

Quantile

Varianz und Standardabweichung (Standard Deviation)

Grafische Darstellung der Kenngrößen von Messdaten

Kennwerte zur Beschreibung einer Verteilung

3.3.3. Maße für den Zusammenhang

Regression

Korrelation

Zusammenhang bei mehr als zwei Variablen

11

11

11

11

12

13

13

13

13

13

13

13

13

14

14

15

15

16

16

17

19

19

19

19

20

21

21

21

23

24

26

27

27

28

30

3

C. Anwendungen bei der Konstruktion sportmotorischer Test

1. Testanalyse

Analyse der Testaufgaben und der Rohwerte

Analyse der Gütekriterien sportmotorischer Tests

Analyse der Objektivität

Analyse der Reliabilität

Analyse der Validität

2. Normierung

Bezugssysteme

Verfahren der statistischen Normierung

Prozentrang-Norm

Standard-Norm (Normalverteilung)

3. Sportmotorische Leistungsprofile

D. Schließende Statistik

32

33

33

34

34

36

39

43

43

43

43

44

47

49

1. Populationsbeschreibende Untersuchungen – induktiver Schluss

50

Begriffe

50

Grundgesamtheit (Ausgangsverteilung, Population)

50

Stichprobe

50

Repräsentativität

51

Arten von Stichproben

51

Statistische Kennwerte, Maßzahlen

51

Standardfehler des Stichprobenmittelwertes

51

Vertrauensintervall des arithmetischen Mittels von Stichproben

52

Stichprobenumfang

53

2. Hypothesenprüfende Untersuchungen - deduktiver Schluss

54

Hypothesenarten und -formulierungen

54

Unterschiedshypothese

54

Veränderungshypothese

54

Zusammenhangshypothese

55

Alternativhypothese

55

Nullhypothese

55

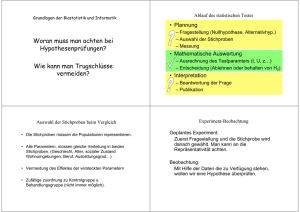

Prüfung von Hypothesen - Signifikanztests

56

Grundprinzip der Signifikanzprüfung

56

Signifikanzaussagen und Signifikanzschranken

57

Der α- und β-Fehler bei statistischen Entscheidungen – Power-Analyse

58

Arbeitsschritte bei der Prüfung von Hypothesen

59

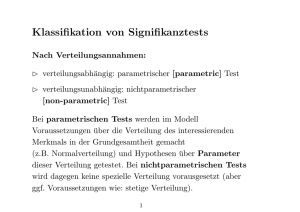

Systematik der Prüfverfahren für Unterschieds- und Veränderungshypothesen

60

Parametergebundene Prüfverfahren für Unterschieds- und Veränderungshypothesen: t-Tests 61

Vergleich eines Stichprobenmittelwertes mit einem Populationsparameter

61

t-Test für unabhängige Stichproben (Unterschiedshypothesen)

61

t-Test für abhängige Stichproben (Veränderungshypothesen)

63

Parameterfreie Prüfverfahren für Unterschieds- und Veränderungshypothesen

64

U-Test von MANN-WHITNEY

64

KOLMOGOROV-SMIRNOV-Omnibustest

65

WILCOXON-Test

65

2

Vergleich von Häufigkeiten mit χ -Tests

66

Signifikanztests für Zusammenhangshypothesen

68

LITERATURAUSWAHL

69

4

Einleitung: Aufgaben des Proseminars

Die Erfassung empirischer (empirisch: griechisch „auf

Erfahrung beruhend“) Daten ist zentraler Bestandteil

sowohl der sportlichen Praxis als auch der

sportwissenschaftlichen Forschung. Letztere sucht nach

neuen Erkenntnissen durch die systematische

Auswertung von Erfahrungen. Nicht selten dienen dazu

Feld- und/oder Laborexperimente.

Die zur Auswertung anstehenden Daten repräsentieren

vorrangig das Niveau von motorischen Leistungen,

Fähigkeiten

oder

Fertigkeiten,

sowie

von

physiologischen, psychischen und soziologischen

Merkmalen.

Wie

ist

der

planmäßige

Untersuchungen?

Ablauf

Gegenstand empirischer

Untersuchungen

empirischer

Untersuchungsplanung

Welchen Anforderungen müssen wissenschaftlich

einwandfreie Methoden zur Datengewinnung genügen?

Gütekriterien der

Datenerhebung

Welche statistischen Methoden können zur Darstellung

der gewonnenen Ergebnisse eingesetzt werden?

Methoden der beschreibenden Statistik

Die an zahlenmäßig begrenzten Untersuchungsobjekten

(Stichproben) gewonnenen Einsichten münden unter

Umständen in Annahmen, die Allgemeingültigkeit

beanspruchen.

Wie kann von einer Stichprobe auf die Population

geschlossen werden ? (induktive Funktion empirischer

Forschung)

Methoden der

schließenden Statistik

Die aus Erfahrungen, persönlichen Überzeugungen und

Theorien abgeleiteten Hypothesen können erst dann als

allgemeingültige Erkenntnisse angesehen werden, wenn

sie durch empirische Befunde bestätigt werden.

Wie werden Hypothesen verifiziert/falsifiziert? (deduktive

Funktion empirischer Forschung: Schluss vom

Allgemeinen, der Population, auf das Besondere, die

Stichprobe).

Welche Voraussetzungen müssen bei der Anwendung

der statistischen Methoden erfüllt sein?

Stichproben

Signifikanztests

Anwendungsvoraussetzungen

5

A. Empirische

Empirische Untersuchungen

1. Gegenstand empirischer Untersuchungen

Motorische, physiologische, psychische, soziologische, … Merkmale

Motorische Merkmale und Methoden zu ihrer Kontrolle

(Motorische) Merkmale unterscheiden man nach ihrer Art in:

Leistungen, Fähigkeiten und Fertigkeiten (oder Techniken)

Leistungskontrolle

Zielsetzung

komplexe sportliche Leistung im Training oder

im Wettkampf

(Laufzeit, Sprunghöhe, Punktezahl ...).

Je komplexer die Leistung, umso weniger gibt die

Leistungskontrolle Auskunft über die

leistungsbestimmenden Faktoren (siehe Fähigkeiten).

Hauptmethoden

Messung

Bewertung als skalierte Beobachtung

Fähigkeitskontrolle

Zielsetzung

motorische Fähigkeiten (Eigenschaften)

Kondition (Kraft, Schnelligkeit, Ausdauer ...)

Koordination (Gleichgewicht, Rhythmisierungsfähigkeit, ...)

kognitive Fähigkeiten

Wahrnehmung, Vorstellung, Denken

musische Fähigkeiten

motivationale Fähigkeiten

Hauptmethoden

(sportmotorische) Tests

Befragung

Beobachtung

6

Fertigkeits- oder Technikkontrolle

Zielsetzung

sporttechnische und technisch-taktische

Fertigkeiten

Qualität der Ausführung

Stabilität der Ausführung

Rentabilität der Ausführung

Hauptmethoden

Beobachtung (skaliert)

visuell, Film, Video

Messung (biomechanisch)

Kinemetrie, Dynamometrie, Goniometrie, ...

2. Phasen der empirischen Forschung

Beschreiben (Deskription) – Suchen (Exploration) – Schließen (De-/Induktion)

1. Erkundungsphase: Fragestellung, Literaturstudium,

Erkundungen,

Beobachtungen durch Induktion, Überprüfen von Einsichten durch Deduktion.

Verarbeiten von

2. Theoretische Phase: Aufstellung von Hypothesen - präzise Formulierung der Annahmen eines

Sachverhaltes, Überprüfung der Hypothesen aufgrund vorliegender empirischer Befunde.

3. Planungsstufe: Konstruktion eines Versuchs, der die Hypothese prüfen soll (siehe

Untersuchungsdesign): was will ich erheben, wo (Kollektiv), wie, ... (lieber zuviel als zuwenig);

Merkmalsstichprobe: Aufstellung aller Variablen, die für die Untersuchung in irgendeiner Weise

relevant sein können - unabhängige Variablen (Einflussgrößen), abhängige Variablen

(Zielgrößen).

Operationalisierung der Variablen, Fehler der Messverfahren.

Personenstichprobe: welche Grundgesamtheit liegt der Stichprobe zugrunde; Kalkulation des

Umfangs; Auswahl, Zufälligkeit, Repräsentativität.

Untersuchungsbedingungen: Labor-, Felduntersuchungen.

Zeitlicher Ablauf der Untersuchung: Pausen, u.U. Programme für die verschiedenen

Trainingsgruppen.

Auswahl von geeigneten statistischen Verfahren.

4. Untersuchungsphase: Realisierung der Planung, Versuchsdurchführung, Datenerhebung.

5. Auswertephase:

a) Bewertung der Daten - Objektivität, Zuverlässigkeit (Reliabilität), Repräsentativität

b) Statistische Auswertung: Anlegen von übersichtlichen Tabellen, Übertragung auf Datenträger,

Datenverarbeitung (statistische Maßzahlen, grafische Darstellungen), Überprüfung der

Anwendungsvoraussetzungen für statistische Tests, Signifikanzniveau, Signifikanztest,

Irrtumswahrscheinlichkeit.

6. Entscheidungsphase: Ergebnisinterpretation und Diskussion:

Verifizierung oder Falsifizierung der Hypothese

inwieweit werden die postulierten Eigenschaften der Population (Theorie) durch stichprobenartig

erhobene Daten (Empirie) bestätigt.

7

3. Untersuchungspläne und Auswertemethoden (Übersicht)

Untersuchungspläne

unabhängige Variable, abhängige Variable, Störvariable

Einzelfalluntersuchungen – Gruppenuntersuchungen

Stichprobe - Grundgesamtheit

populationsbeschreibende – explorative – hypothesenprüfende U.

Felduntersuchungen (externe Validität ) – Laboruntersuchungen (interne Validität)

experimentelle (Zufallsstichprobe) - quasiexperimentelle (natürliche St.) U.

randomisierte, kontrollierte U.

1.

Querschnittsuntersuchungen

G2

G2

V2

V2

„One-Shot Case Study“ (Treatm → Messung)

„Ex Post facto Plan“ (Gv: Tr → M, Gk: M)

a)

b)

c)

d)

G1

G1

V1

V1

2.

Längsschnittsuntersuchungen (Messwiederholungen)

a)

b)

c)

d)

e)

f)

VPretest

VPosttest

VPretest

Treatment

VPosttest „Ein-Gruppen Pretest-Posttest-Design“

VRetest

VTest

mehr als eine Wiederholung

lange Zeitreihen (Anzahl der Messpunkte ≥ 50)

kurze Zeitreihen (A-B, A-B-A, B-A-B, A-B-A-B, ...)

G3

...

V3

...

„Leistungsprofil“

Anm.: d) aus Gruppen- und Einzelfalluntersuchungen

e) aus Einzelfalluntersuchungen

alle anderen Beispiele weiter oben und unten gelten für Gruppenuntersuchungen

3.

Komb. Untersuchungen

a)

Kontrollgruppenplan mit Pretest - Posttest:

PretestExperimentalgruppe

Treatment PosttestExp.Gr.

PretestKontrollgruppe

PosttestKontr.Gr.

z. B. der Standardtyp klinischer Studien: „randomisierte kontrollierte Doppelblindstudie“

(weder Untersucher noch Probanden wissen über die Gruppenzugehörigkeit Bescheid):

PretestExp.Gr.

Treatment

PosttestExp.Gr.

PretestKontr.Gr.

Placebo

PosttestKontr.Gr.

b)

Dreifaktorieller Pretest-Posttest-Plan:

PretestExp.Gr. A

Treatment

PretestExp.Gr. B

Treatment

PretestKontr.Gr. A

PretestKontr.Gr. B

z. B: A ... männlich

B ... weiblich

PosttestExp.Gr. A

PosttestExp.Gr. B

PosttestKontr.Gr. A

PosttestKontr.Gr. B

8

Beschreibende und explorative statistische Verfahren

Kenngrößen

Plots

1.

Querschnittsuntersuchungen

a-d)

MW, s, n

Histogramm, Boxplot, Fehlerbalken

c)

d)

r1/2, r2 , a, b

r, rMatrix, Partialkorr., multiple Korr.

Faktorenanalyse, Clusteranalyse

Streuungsdiagramm

Leistungsprofil

Dendrogramm

2.

Längsschnittsuntersuchungen

a) + b) MW und s von DiffPre-PostICC

a) + b) rPre-Post

c)

Reliabilitätskoeffizient (r), ICC

e)

3.

Autokorrelationen (ARIMA-Modelle)

Komb. Untersuchungen

a) + b) DiffExp.Gr.-Kontr.Gr: beim Pretest und Posttest

MW und s von DiffPre-Post bei Experimentalgruppe und Kontrollgruppe

b)

DiffA-B beim Pretest und Posttest bei Experimantalgruppe

DiffA-B beim Pretest und Posttest bei Kontrollgruppe

9

Prüfstatistik

Signifikanztests für Unterschieds-, Veränderungs- und Zusammenhangshypothesen

Signifikanz (p)

Methoden für normalverteilte Daten und parameterfreie Methoden

1.

a)

b)

c)

2.

Querschnittsuntersuchungen

t-Test für unabhängige Stichproben, U-Test

einfaktorielle Varianzanalye, H-Test

Fisher’s Z-Transformation

Längsschnittsuntersuchungen

a) + b)

a) + b)

Signifikanz für rPre-Post, ICC

t-Test für abhängige Stichproben, Wicoxon-Test

d)

einfaktorielle Varianzanalyse mit Messwiederholungen,

Friedmann-Test

3.

a) + b)

a)

Komb. Untersuchungen

t-Test für unabhängige Stichproben

t-Test für abhängige Stichproben

Zweifaktorielle Varianzanalyse mit Messwiederholungen

z. B. mit den Faktoren Gruppe und Wiederholung

b)

Dreifaktorielle Varianzanylyse mit Messwiederholungen

z. B. mit den Faktoren Gruppe, Wiederholung und Geschlecht

10

B. Beschreibende Statistik

Nach dem Grad ihrer Quantifizierbarkeit ordnet man Merkmale unterschiedlichen

Skalenniveaus zu: Nominalskala, Ordinalskala, metrische Skala (Intervall-,

Rationalskala).

Tabellarische und grafische Darstellungen informieren über die Verteilung eines

Merkmales in einem Kollektiv, bei nominalskalierten Variablen über die Verteilung der

Beobachtungen auf verschiedene Kategorien, bei metrisch skalierten Variablen über die

Verteilung auf Messwerteklassen.

Statistische Kennwerte haben die Aufgabe, über spezielle Eigenschaften der

Merkmalsverteilung summarisch Auskunft zu geben.

Am meisten interessieren uns hierbei Maße, die alle Messwerte möglichst typisch

repräsentieren - die Maße der zentralen Tendenz.

Des weiteren sind Kennwerte gefragt, durch welche die Unterschiedlichkeit oder

Variabilität der Ausprägung eines Merkmals in einem Kollektiv gekennzeichnet wird - die

Streuungsmaße (Dispersionsmaße).

Schließlich gibt es noch Kennwerte, die bei Untersuchungen von zwei oder mehr

Variablen den Zusammenhang zwischen den Merkmalen beschreiben – die

Zusammenhangsmaße.

11

1. Skalenniveau

1.1. Nominalskala

Quelle:

Kriterium:

Häufigkeiten

Übereinstimmung (Verschiedenheit)

führt zur Einteilung in Klassen (Kategorien).

Unterscheidungsmöglichkeit nach Anzahl der Klassen:

z.B. Alternativmerkmale ja - nein, vorhanden - nicht vorh.,

getroffen - nicht getroffen, männlich - weiblich,

oder mehrfach gestufte Merkmale,

z.B. Sportart, Studienrichtung, Beruf, Nationalität u.a.

statistische Verfahren:

Rechenoperationen:

Zählen von Häufigkeiten.

Bildung von Relativzahlen und Prozentwerten

Diese Merkmale werden auch qualitative Merkmale genannt.

1.2. Ordinalskala

Quelle:

Kriterien:

Rangdaten

1. Identität zwischen Elementen auf gleicher Stufe

2. Ordnungsbeziehung: größer – kleiner- bzw.

vor – nach - Relation.

z.B.: Zensuren: sehr gut, gut, befriedigend ...

Güteklassen von Hotels: A, B, C;

Ränge bei sportlichen Bewerben, Treatmentstufen.

statistische Verfahren:

Rangordnung, Zusammenhangsmaße

(zusätzlich zu dem im

vorausgehenden

Skalenniveau genannten)

1.3. Metrische Skal

Skalen

kalen

1.3.1. Intervallskala

Quelle:

Kriterium:

statistische Verfahren:

(zusätzlich zu den in vorausgehenden Skalenniveaus

genannten)

Rechenoperationen:

Messdaten

Abstände (Intervalle) müssen gleich sein.

Mittelwerte, Streuungsmaße,

Zusammenhangsmaße

Addition und Differenzbildung (z.B.: 10 cm größer)

12

1.3.2. Rationalskala

Auch Verhältnisskala oder Absolutheitsskala genannt; besitzt den größten

Informationsgehalt. Zusätzlich zu den Merkmalen der Intervallskala besitzt sie folgende

Eigenschaften:

Kriterium:

statistische Verfahren:

Rechenoperationen

Intervallskala mit absolutem Nullpunkt.

wie Intervallskala

Multiplikation, Division (x-mal schneller, weiter …).

Skalenprobleme!

Noten oder Wertungen mit Punkten: ungleiche Leistungsunterschiede zu benachbarten Skalenstufen

Distanzmessung bei Drehbewegungen: z.B. Rumpfbeugen vw. nach FETZ/KORNEXL

Nach der Quantifizierbarkeit wird bei Messdaten unterschieden in diskrete und stetige

Merkmale:

diskrete Merkmale: Eine Zufallsvariable ist diskret, wenn sie nur endlich (oder abzählbar)

viele Werte aufweist (Beispiel Anzahl der Geschwister, der Treffer, der

Wiederholungen).

stetige oder kontinuierliche Merkmale: können jeden Wert zwischen zwei beliebigen

Werten der Skala annehmen (Beispiel Längen, Zeiten, Gewichtsmessungen ...). Die

Anzahl möglicher Werte ist dabei theoretisch unbegrenzt, praktisch ist sie abhängig

von der Genauigkeit des Messinstrumentes bzw. von der Ablesegenauigkeit.

Werden von an sich stetig ausgeprägten Merkmalen nur ganzzahlige Werte

(Abrundung!) registriert und daraus Mittelwerte gebildet, wird häufig eine

Stetigkeitskorrektur um 0,5 Einheiten vorgenommen.

13

2. Verfahren bei nominalskalierte

nominalskalierten

ominalskalierten Daten

2.1. Tabellarische Ordnung

Kreuztabellen

Untersuchungsgruppen

Geschlecht

Gruppe

Gymnastik

Schwimmen

Kontrollgruppe

Spaltensummen

Verbesserung der Treffgenauigkeit durch Übung

männl. weibl.

6

7

5

18

Zeilensummen

2

1

2

5

8

8

7

23

vorher

getroffen

nicht getr.

getroffen

5

15

nicht getr.

3

8

Zweimalige Erhebung - eindimensional

nachher

Einmalige Erhebung - zweidimensional

2.2

2.2. Graphische Darstellungen

Darstellungen

Balkendiagramm: Streifen- od. Säulen, gruppiert od. gestapelt, absolut od. relativ

Kreis- oder Sektorendarstellung (prozentuell)

Piktogramm (Achtung bei Flächen → 2D - und Körpern → 3D!)

Kartogramm

2.3

2.3. Rechnerische Verfahren

beschränkt auf:

1. Auszählen von Häufigkeiten (N, n)

2. Berechnung von Relativzahlen und Prozentwerten:

2.3.1. Relativzahlen

Gliederungszahlen

Unterordnung einer Teilmenge, relative Häufigkeit, z.B.:

N Sportstudenten

N Studenten

( ⋅100%)

Beziehungszahlen

Nebenordnung verschiedenartiger Mengen,

Quotient zweier verschiedenartiger,

sachlich sinnvoll zusammenhängender Größen, z.B.:

Einwohnerz ahl

Zahl der Sportanlag en

oderAnzahl der Absolventen pro 1000 Studenten und Jahr

Verhältniszahlen

Nebenordnung gleichartiger Mengen,

zahlenmäßiges Verhältnis einer Menge

zu einer gleichartigen nebengeordneten Menge, z.B.:

Schwimmer

Nichtschwimmer

14

Risiko

Koeffizienten, die bei Vierfeldertafeln bestimmt werden können, z.B., wenn das

Risiko, dass ein Ereignis (z. B. Verletzung) eintritt, in Abhängigkeit von einem

Faktor, der 2-fach gestuft ist (Aufwärmen), untersucht wird:

Hinweis für SPSS Anwendungen:

abh. Variable in Spalten (1. Spalte ‚trifft ein’)

unabh. Variable in Zeilen (1. Zeile..Risiko höher)

Kontrollgruppe (wärmt nicht auf)

Interventionsgruppe (wärmt auf)

Die Inzidenzrate ist

Anzahl der

Verletzten

110

60

ohne Verletzung

90

150

bei der Kontrollgruppe

bei der Interventionsgruppe:

110/200 = 0,550

60/210 = 0,286

Das relative Risiko ist 0,550/0,286 = 1,925, d. h.: das Risiko, sich zu verletzen,

ist bei der Kontrollgruppe um das 1,9 fache höher als bei der Interventionsgruppe.

Dieser Koeffizient wird üblicherweise bei Untersuchungen angewandt, die auf Beobachtungen

während eines längeren Zeitraumes beruhen und als Kohortenstudie bezeichnet werden.

Ein weiterer Koeffizient lässt sich berechnen, wenn man die Quoten (Chancen)

bei den beiden Gruppen heranzieht:

Die „Chance“, sich zu verletzen, beträgt

bei der Kontrollgruppe:

110/90 = 1,2

bei der Interventionsgruppe:

60/150 = 0,4

Das Quotenverhältnis Kontrollgruppe/Interventionsgruppe, die sogenannte

odds ratio ist 1,2/0,4 = 3.

Dieser Koeffizient wird üblicherweise bei sogenannten Fall-Kontrollstudien angewandt, bei denen

das Ereignis bereits eingetreten ist, wie es im Beispiel USI-Fitnesstraining (unten) der Fall ist:

37/67

=

0,55

85/54

=

1,57

odds ratio (weibl./männl).:

1,57/0,55

=

2,85

Interpretation: Die Quote derer, die am USI Fitnesstraining mit Musik betreiben, ist beim weiblichen

Geschlecht 2,9 mal höher als beim männlichen Geschlecht.

2.3.2. Zusammenhang nominalskalierter Variablen

Die Quantifizierung bei Nominalskalen besteht in der Angabe von Häufigkeiten. Die

tabellarische Darstellung erfolgt in Kreuztabellen, im einfachsten Fall (bei "dichotomen"

Merkmalen) in einer 4-Feldertafel, z.B.:

USI-Fitnesstraining

Geschlecht

männlich

weiblich

Σ

mit Musik

a: 37

c: 85

122

andere

b: 67

d: 54

121

Σ

104

139

243

a, b, c, d ... beobachtete Häufigkeiten

15

Φ -Koeffizient

Der Zusammenhang von Geschlecht und gewählter Art des Fitnesstrainings kann durch

den Koeffizienten Φ (phi) ermittelt werden:

ad − bc

φ=

(1)

(a + c) ⋅ (b + d) ⋅ (a + b) ⋅ (c + d)

Der Wertebereich für Φ liegt zwischen -1 und +1. Für obiges Beispiel erhalten wir den Wert Φ = - 0,25. Das

negative Vorzeichen lässt sich nicht sinnvoll interpretieren, daher ist es außer Acht zu lassen.

Kontingenzkoeffizient

Wenn die beiden Merkmale in mehr als zwei Kategorien unterteilt sind, ist der

Kontingenzkoeffizient C zu berechnen:

C=

χ2

(2)

χ2+n

χ² (chi-Quadrat) ist eine Kenngröße zur Quantifizierung des Unterschiedes von

Beobachtungshäufigkeiten (fb) und Erwartungshäufigkeiten (fe) (siehe dazu auch

„Vergleich von Häufigkeiten“ in der schließenden Statistik).

n Stichprobenumfang.

Die Erwartungshäufigkeiten lassen sich für obiges Beispiel aus dem Verhältnis der Zeilensummen zur

Gesamtsumme (104/243 = 0,428 bzw. 139/243 = 0,572) berechnen.

Für die Kategorie ‚mit Musik’ ergeben sich die Erwartungshäufigkeiten:

a’ = 122*0,428 = 52,2

und

c’ = 122*0,572 = 69,8;

für die Kategorie ‚andere’ ergeben sich die Erwartungshäufigkeiten:

b’ = 51,8

und

d’ = 69,2.

χ² wird nach folgender Gleichung ermittelt:

χ =

2

χ2 =

k

( f b j - f e j )2

j=1

f ej

∑

(3)

(37 − 52,2) 2 (85 − 69,8) 2 (67 − 51,8) 2 (54 − 69,2) 2

+

+

+

= 15,564

52,2

69,8

51,8

69,2

Für den Kontingenzkoeffizienten C ermitteln wir mit Hilfe von Gleichung 2 den Wert 0,245.

Der Wertebereich für Φ liegt nur im Idealfall, d. h. wenn die Spaltensummen bzw.

Zeilensummen gleich sind, zwischen -1 und +1.

Für C liegt er ebenfalls nur im Idealfall zwischen 0 und +1.

Sowohl für Φ als auch für C ließen sich die maximalen Werte ermitteln, wenn der Wert a oder der Wert c

der obigen 4-Feldertafel 0 auf Null gesetzt wird, und die anderen Häufigkeiten dementsprechend

angepasst werden.

16

3. Verfahren bei intervallskalierte

intervallskalierten

ntervallskalierten Daten

3.1. Listen/Tabellen

Urliste: Ungeordnete Zusammenstellung der Einzeldaten.

Primäre Tafel: nach bestimmten Kriterien (Größe, Gewicht,...) geordnete Urliste.

Vorteil: Übersichtlichkeit, Minimal-Maximalwert,

Differenz daraus → Streuungsbreite.

Stem-and-Leaf Plot: Mittelding zwischen tabellarischer und grafischer Darstellung

Ergebnisse des Tests Armführen – Winkel beim Vortest

(Auswertung mit SPSS)

Frequency Stem & Leaf

1

0

. 9

2

1

* 44

1

1

. 5

4

2

* 3344

2

2

. 67

9

3

* 000122344

4

3

. 5599

Stem width:

Each leaf:

10,0

1 case(s)

Tabellen:

Aufbau: Spalten, Zeilen, Tabellenfach (Zahlenteil);

Formale Hinweise: Tabellen sollen möglichst alle wesentlichen Informationen enthalten.

Überschrift: mit allen notwendigen inhaltlichen Informationen.

Tabellenkopf und Randspalte bilden den Textteil der Tabelle.

Häufigkeitstabelle (Strichliste): Zusammenfassung gleicher Messwerte oder von

benachbarten Messwerten zu Messwerteklassen.

absolute Häufigkeit (fi)

relative Häufigkeit (fir):

f ir =

fi

n

f i% =

fi

⋅ 100%

n

kumulierte Häufigkeit (absolut, relativ)

Mit Hilfe der kumulierten Häufigkeit (Summenhäufigkeit, fc) kann die Frage beantwortet

werden, wieviel Beobachtungseinheiten (Prozent) unter-, ober- oder innerhalb bestimmter

Grenzen liegen. Summenhäufigkeitsverteilungen werden daher für Normierungen verwendet.

fc bis zu einem Messwert oder einer Messwerteklasse auftretende Häufigkeit (inklusiv)

fc1

fc2

fcn -1

fcn

=

=

=

=

f1

f1

f1

f1

+

+ ... +

+ ... +

f2

fn -1

fn -1

+

fn

17

Häufigkeitstabelle: Test Armführen - Winkel vor dem Aufwärmen

Messwerteklassen

< 10°

10° - 14,9°

15° - 19,9°

20° - 24,9°

25° - 29,5°

30° - 34,5°

35° - 39,5°

≥ 40°

Summe

Häufigkeit

Strichliste absolut (fi)

%

/

//

/

////

//

//// ////

////

1

2

1

4

2

9

4

0

23

kumulierte Häufigkeit

absolut

%

(fci)

1

4,3

3

13,0

4

17,4

8

34,8

10

43,5

19

82,6

23

100

23

100

4,3

8,7

4,3

17,4

8,7

39,1

17,4

0

100

Vorteil: geringer Arbeitsaufwand, übersichtlich, Verteilung sichtbar.

3.2. Graphische Darstellung von Verteilungen

Geometrisches Bild einer Menge von Daten oder eines mathematischen

Zusammenhanges; numerische Werte werden durch Punkte, Strecken, Flächen,

Körper ausgedrückt.

Häufigkeitstabelle → Häufigkeitsverteilung, dargestellt im Koordinatensystem:

Abszisse (x-Achse): Messwerteskala oder Messintervalle; Beschriftung: Merkmal, Maßeinheit

Klassenzahl:

Ordinate (y-Achse):

n ≤ 30 → k = 5

30 < n < 400 → k = √n

n ≥ 400 → k = 20

Häufigkeiten (absolut oder prozentuell)

k = 5-15 (höchstens 20)

Die am meisten verwendete Darstellung einer Häufigkeitsverteilung ist das

Histogramm (Treppen-, Stufen-, Säulendiagramm).

schiefe Verteilung (rechtssteil)

Häufigkeitsverteilung (Histogramm)

Häufigkeitsverteilung

PS SS98: Schulterbreite der Vpn. (SPSS-Chart)

PS SS98: Test Armführen - Winkel vor dem Aufwärmen

10

10

8

8

Häufigkeit (abs.)

Häufigkeit (absolut)

„normale“ Verteilung

6

4

2

6

4

2

0

0

34

36

38

40

Schulterbreite (cm)

42

44

7,5

12,5

17,5

22,5

27,5

32,5

37,5

Winkel (°)

Polygonzug (Liniendiagramm): Punkte über den Klassenmitten werden durch Geraden

verbunden.

Summenpolygon: grafische Darstellung der kumulierten Häufigkeitsverteilung

Hinweis: Im Unterschied zu Balkendiagrammen, welche zur Darstellung der Häufigkeit des Auftretens

von Fällen, die verschiedenen Kategorien zuzuordnen sind, müssen die Säulen des Histogrammes

über die ganze Klassenbreite gestellt werden.

Die Gesamtfläche des Histogrammes und die Gesamtfläche unter dem Polygonzug entsprechen der

Kollektivgröße n oder 100% aller Fälle.

Mit übereinandergelegten Polygonzügen können mehrere Verteilungen verglichen werden (bei gleicher

Gruppengröße oder wenn relative Häufigkeiten angegeben werden).

18

Darstellung zweidimensionaler Verteilungen

Die gleichzeitige Untersuchung von zwei Merkmalen einer Personengruppe kann in Form

eines Streuungsdiagrammes bzw. einer zweidimensionalen Häufigkeitsverteilung

übersichtlich dargestellt werden.

Streuungsdiagramm (engl. Scatterplot):

Die gepaarten Beobachtungen jeder Vp. sind als Datenpunkte in das kartesische

Koordinatensystem eingetragen. Üblicherweise werden auf der horizontalen Achse

die Werte der unabhängigen, auf der vertikalen die Werte der abhängigen

Veränderlichen aufgetragen.

Scatterplot

PS SS98: Test Armführen - anthropom. Messdaten

70

Armlänge (cm)

68

66

64

62

60

58

56

32

34

36

38

40

42

44

Schulterbreite (cm)

Wenn eine Tendenz zu einem Zusammenhang besteht, zeigt die Punktewolke eine

in die Länge gezogene Form:

linear - aufsteigend/abfallend

nichtlinear

Die graphische Darstellung des Zusammenhanges in Form eines

Streuungsdiagrammes dient auch als Entscheidungshilfe bei der Wahl der

Kenngrößen für den Zusammenhang (Gerade, Parabel, Kurve 3. Grades,

exponentiell).

bivariate Häufigkeitsverteilung

dreidimensionales Säulendiagramm

x- und y-Achse: Messwerte(klassen)

der beiden korrelierten Variablen;

z-Achse: Häufigkeit

19

Allgemeine Hinweise zur Erstellung von Tabellen und Grafiken

• Tabellen und Grafiken sollen so angelegt und beschriftet sein, dass sie umfassend

informieren, ohne dass man im Text nachlesen muss.

• Die Überschriften müssen die dargestellten Tatbestände in ihrer sachlichen, zeitlichen

und räumlichen Gültigkeit eindeutig abgrenzen.

• Die Benennung der Zeilen/Spalten und Achsen mit der zugehörigen Maßeinheit darf

nicht vergessen werden. Die Klassengrenzen sollen eindeutig sein.

• Bei Übernahme aus Veröffentlichungen muss die Quelle angegeben werden.

3.3.

3.3. Statistische Kennwerte

Die Kennwerte von Stichproben werden meist durch lateinische Buchstaben, Kennwerte

von Grundgesamtheiten meist durch griechische Buchstaben abgekürzt.

3.3.1. Kennwerte für die zentrale Tendenz (Lagemaße)

Bezeichnungen: Mittelwerte, Statistika, Lageparameter;

umgangssprachlich: Durchschnitt(swerte).

Arithmetisches Mittel (Mean)

Symbol: AM, x , µ (my)

n

x =

x 1 + x 2 + ... + x n

=

n

∑x

i

i=1

n

(4)

Def.: Summe aller Messwerte, dividiert durch deren Anzahl.

Gewogenes arithmetisches Mittel (gemeinsamer Mittelwert von zwei oder mehreren

Stichproben):

gleich große Stichproben:

xg =

x1 + x 2

2

unterschiedlich große Stichproben:

xg =

x1 n1 + x 2 n2 + ... + x k n k

n1 + n2 + ... + n k

Median (Zentralwert)

~

Symbol: Mdn, Z, x~ , µ

Def.: jener Messwert, der eine geordnete Reihe von Messwerten (primäre Tafel)

halbiert, sodass oberhalb und unterhalb dieses Messwertes gleich viele

Messwerte vorkommen.

Mdn bei ungeradzahligem n direkt aus der primären Tafel ablesbar, bei geradzahligem n:

arithmetisches Mittel zwischen den beiden zentralen Werten.

20

Modus (Modalwert, Gipfelwert, Dichtemittel)

Def.: Jener Messwert, der am häufigsten vorkommt.

Lage des Modus aus Polygonzug oder Histogramm ablesbar:

beim Maximum oder wenn

mehrere Maxima: bei Nachbarschaft, arithmetisches Mittel der Messwerte,

sonst: beide Werte als Modalwerte angeben, da sie für die Verteilung

charakteristisch sind.

Richtlinien für die Anwendung von Mittelwerten

• Das arithmetisches Mittel ist bei messbaren Merkmalen (Intervallskala) der wichtigste

Lageparameter.

• Der Median ist bei ordinalskalierten Merkmalen anzuwenden. Bei intervallskalierten

Merkmalen soll er zusätzlich oder an Stelle des arithmetischen Mittels bestimmt

werden, wenn die Verteilung schief, mehrgipfelig oder durch Ausreißer verzerrt ist, oder

auch, wenn sehr kleine Stichprobenumfänge vorliegen.

• Für nominal messbare Merkmale ist der Modal der einzig sinnvolle Lageparameter. Die

spezifische Ausprägung der Verteilung eines intervallskalierten Merkmales

(mehrgipfelig, schief) wird durch die Angabe des/der Modalwerte(s) berücksichtigt.

• Falls man die Verteilung der Daten nicht genau kennt oder falls man sich nicht von

vornherein über die Verwendung eines bestimmten Mittelwertes sicher ist, wird

empfohlen, die tabellarische oder besser noch die graphische Darstellung der

Verteilung (Histogramm) zu analysieren, um durch einen treffenden Mittelwert eine

sinnvolle Aussage über die Daten geben zu können.

21

3.3.2. Maße für die Streuung (Dispersionsmaße)

Zur hinreichenden Charakterisierung von Verteilungen sind Mittelwerte nicht ausreichend.

Die Streuungsmaße geben Auskunft über das Ausmaß, in dem die Messwerte vom

Mittelwert entfernt liegen.

Bei der Verwendung von Streuungsmaßen ist auf die Verteilungsform der Daten zu

achten.

Variationsbreite oder Spannweite (Range)

Symbol: R, v

R = x max - x min

Def.: Differenz zwischen dem größten und dem kleinsten Messwert.

Bestimmung: aus der Häufigkeitsverteilung oder primären Tafel )

Nachteil: nur von Extremwerten abhängig (Zufall)!

Quantile

Quantile teilen eine geordnete Zahlenreihe (primäre Tafel) in k gleich umfangreiche Teile:

Perzentile: k = 100

z.B. zehntes Perzentil (P10), neunzigstes P. (P90)

oder Prozentrang - PR30;

Dezile:

k = 10

z.B. erstes Dezil (D1), D9 = P90

Quartile:

k= 4

z.B. erstes Quartil (Q1), drittes Quartil (Q3)

Q1 ist derjenige Wert auf der Merkmalsachse einer Häufigkeitsverteilung, unter dem 25%

und über dem 75% der untersuchten Fälle liegen ( → P25, 25. Perzentil).

Q3 ist derjenige Werte auf der Merkmalsachse, unter dem 75% und über dem 25% der

untersuchten Fälle liegen ( → P75).

Q2 → Median, P50.

• Bestimmung der Quantile:

n Rohdaten (Beobachtungen) werden gereiht (primäre Tafel), sodann wird der

Index i jener Beobachtung bestimmt, die das entsprechende Quantil darstellt,

m.a.W., der wievielten Beobachtung geht die entsprechende Anzahl (10%, 25%

usw.) von Messwerten voraus.

Für Stichprobenumfänge von n = 10 bis n = 21 ist unten eine Zusammenstellung, aus der

zu entnehmen ist, der wievielte Werte (Index i) für bestimmte Quantile (Q1, Median, Q3)

heranzuziehen ist:

n

iQ1

10

3

11

3

12 3+4

13

4

14

4

15

4

iMdn

5+6

6

6+7

7

7+8

8

iQ3

8

9

9+10

10

11

12

n

16

17

18

19

20

21

iQ1

4+5

5

5

5

5+6

6

iMdn

8+9

9

9+10

10

10+11

11

iQ3

12+13

13

14

15

15+16

16

22

Die Ermittlung des Index i der Quartile wird nach folgenden Gleichungen vorgenommen

(nach TUKEY):

Q1(3) = x i

i = integer

n

n

+ 1 (i = integer ⋅ 3 + 1)

4

4

Wenn n durch 4 teilbar ist, liegen die Quartile zwischen zwei Beobachtungen (vgl.

Median):

Q1(3) =

x i + x i+1

2

i =

n

n

(i = ⋅ 3)

4

4

Anmerkung: SPSS weicht von dieser Bestimmungsmethode ab, da es den/die zur Bestimmung

des Medians herangezogenen Wert(e) außer Acht lässt.

Interquartilabstand:

IQR = Q3 − Q1

Angabe, über welchen Wertbereich die Testleistungen der mittleren 50% einer Stichprobe streuen.

Halber Quartilabstand (oder mittleres Quartil):

Q = (Q3 - Q1)/2

durchschnittliche Streuung der Daten um den Median.

Die folgenden Streuungsmaße setzen voraus, dass die Daten symmetrisch verteilt

bzw. normalverteilt sind!

Durchschnittliche Abweichung oder mittlere absolute Abweichung

Def.: arithmetisches Mittel der absoluten Abweichungen aller Messwerte vom Mittelwert.

Symbol: DA, AD

n

∑|x

AD =

i

- x|

i=1

n

Dieser Kennwert wird kaum als Streuungsmaß verwendet.

Bei Bewegungsgenauigkeitstests wird er als Präzisionsmaß verwendet (vgl. FETZ)

23

Varianz und Standardabweichung (Standard Deviation)

Varianz, mittlere quadratische Abweichung:

2

2

Symbole: s , σ

Für normalverteilte Daten.

Def.: Summe der Abweichungsquadrate aller Messwerte vom arithmetischen Mittel,

dividiert durch die Anzahl der Messwerte (vgl. Gl. 4):

n

∑( x

2

s =

i

- x )2

i=1

(5)

n

Vorteil: alle Werte werden berücksichtigt, vom Mittelwert weiter entfernte Werte mehr als

Werte nahe beim Mittelwert.

Standardabweichung:

Symbole: s, σ, SD

Def.: Quadratwurzel aus der Varianz

n

∑( x

s =

Anwendung: s2

s

2

s = ±

i

- x )2

i=1

n

(6)

vor allem in der Prüfstatistik1,

zur Interpretation von Verteilungen

Variabilitätskoeffizient oder Variationskoeffizient:

Def.: Der Variabilitätskoeffizient (v) relativiert die Standardabweichung auf das

arithmetische Mittel.

s

v =

⋅ 100%

(7)

x

Beim Vergleich von Streuungen ist der Variabilitätskoeffizient an Stelle der

Standardabweichung zu verwenden,

• wenn ein Merkmal bei 2 Populationen unterschiedliche Mittelwerte aufweist (z.B.

Körperlänge bei Neugeborenen und bei Erwachsenen - die Streuung ist bei

Erwachsenen größer);

• wenn 2 verschiedene Merkmale hinsichtlich Streuung verglichen werden (z.B.

Kraft/Newton und Schnelligkeit/s).

Einschränkungen für die Verwendung des v:

1

In der Prüfstatistik wird die Varianz/Standardabweichung der Grundgesamtheit benötigt, die in der Regel

aus der Stichprobenvarianz geschätzt wird, indem n im Nenner von Gl. 6 und 7 um 1 vermindert wird (häufig

bei EDV-Programmen).

24

• Die Skala muss einen absoluten Nullpunkt haben,

• die Skala muss konstante Klassengrößen aufweisen (= Intervallskala).

Grafische Darstellung der Kenngrößen von Messdaten

Die Darstellungen enthalten Informationen über die zentrale Tendenz und die Streuung

von Daten.

Fehlerbalken

Dienen zur Darstellung des arithmetischen Mittels und der Standardabweichung

(wahlweise des Standardfehlers und des Konfidenzintervalles - siehe Abschnitt D

Schließende Statistik, Kap 1). Die Fehlerbalken können mit Säulen, welche die Höhe

des Mittelwertes repräsentieren, kombiniert sein.

Hinweis: Zu verwenden bei normalverteilten Daten.

Beispiel:

männlich

weiblich

40

30

30

Anzahl

20

10

10

Std.abw . = .17

Std.abw . = .16

Mittel = 2.54

N = 103.00

0

2.15

2.30

2.45

2.60

2.75

2.90

Mittel = 2.01

N = 72.00

0

3.05

1.35

Standweitsprung (m)

1.50

1.65

Test Standweitsprung - SportstudentInnen

2.6

2.2

2.4

2.0

1.8

1.6

N=

1.80

1.95

2.10

2.25

Standweitsprung (m)

2.8

MW +- 1 SD

2.00

Sprungweite (m)

Anzahl

20

103

72

männlich

w eiblich

2.40

2.55

25

Boxplot

Informiert über Median, erstes und drittes Quartil und über die Extremwerte, ist

daher bei normalverteilten und nicht normalverteilten Daten verwendbar.

Test Einfachreaktion - SportstudentInnen

102

männlich

70

100

60

98

gültige Versuche

Anzahl

50

40

30

20

10

96

94

92

0

87

90

93

96

Einfachreaktion - gültige Versuche

99

90

88

N=

92

54

männlich

weiblich

Hinweis: Falls Werte um mehr als den 1½-fachen bzw. 3-fachen

Interquartilabstand von den Quartilen entfern liegen, werden sie im SPSS

durch die Symbole ° bzw. ∗ als Ausreißer gekennzeichnet.

26

Kennwerte zur Beschreibung einer Verteilung

Schiefe (Skewness) einer Verteilung:

Eine grobe Abschätzung der Schiefe einer Verteilung liefert der Vergleich der

Quartile:

linksteil:

(Q3 - Mdn) >

(Mdn - Q1)

rechtsteil:

(Q3 - Mdn) <

(Mdn - Q1)

oder der folgende Wert:

x - Modus

s

Eine genauere Schätzung der Schiefe ergibt das sog. 3. Potenzmoment (SPSS):

Sch =

n

∑z

Sch =

3

i

i=1

n

• bei linkssteiler Verteilung ist die Maßzahl positiv,

• bei symmetrischer Verteilung Null,

• bei rechtssteiler Verteilung negativ.

(8)

• Faustregel: ein Schiefe-Wert, der mehr als doppelt so groß ist wie sein

Standardfehler (siehe schließende Statistik), spricht für Abweichung von der

Symmetrie.

Exzess, Steilheit, auch Kurtosis genannt (breitgipflig vs. schmalgipflig):

wird durch das 4. Potenzmoment geschätzt (SPSS):

n

∑z

4

i

−3

(9)

n

• Bei hoher Wölbung (schmalgipflig) ist die Maßzahl positiv, bei flacher Wölbung

(breitgipflig) negativ.

Ex =

i=1

27

3.3.3. Maße für den Zusammenhang

Aus den Naturwissenschaften sind Zusammenhänge von Merkmalen bekannt, die durch

exakte Funktionsgleichungen beschrieben werden können, z.B. steigt die Fallhöhe eines

Körper im luftleeren Raum proportional zum Quadrat der Falldauer nach der Funktion

s(t) =

g

⋅ ∆ t2

2

In solchen Fällen lassen sich exakte Vorhersagen über die Höhe des Wertes der

abhängigen Variablen machen, wenn ein bestimmter Wert der unabhängigen Variablen

in die Funktionsgleichung eingesetzt wird (funktionaler Zusammenhang). Wird jedoch z.B.

der Zusammenhang zwischen Trainingsumfang/-intensität und Leistungniveau untersucht,

kann festgestellt werden, dass nicht alle Athleten mit gleichem Training das gleiche

Leistungsniveau erreichen, wofür eine Reihe von anderen z.T. unbekannten Faktoren als

Erklärung dienen können (stochastischer Zusammenhang).

Die (gleichzeitige) Beobachtung von zwei Merkmalen bei der Untersuchung einer

Personengruppe kann grafisch in Form eines Streuungsdiagrammes bzw. in einer

zweidimensionalen Häufigkeitsverteilung dargestellt werden.

Die Gleichung, die einen solchen Zusammenhang beschreibt, wird

Regressionsgleichung genannt, die Enge des Zusammenhanges zwischen zwei

Merkmalen wird charakterisiert durch den Korrelationskoeffizienten.

Regression

Die Ermittlung von Gleichungen, welche die Tendenz eines Zusammenhanges

beschreiben, ist Aufgabe der Regressionsrechnung. Die einfachste Beziehung zwischen

zwei Variablen ist beim linearen Zusammenhang gegeben, von dem im Folgenden die

Rede ist. Die Regressionsgleichung dafür entspricht der

allgemeinen Geradengleichung:

y = a + bx

(10)

Regressionskoeffizienten:

a ... Verschiebung der Geraden, Abschnitt auf der Y-Achse und

b ... Anstieg der Geraden;

a = y − b⋅ x

(11)

n

b=

∑ (x

i =1

i

− x ) ⋅ ( yi − y )

(12)

n

∑ (x

i =1

i

− x)

2

Berechnung der Regressionskoeffizienten: Die Regressionskoeffizienten werden nach dem Kriterium der

kleinsten Quadrate bestimmt: Gesucht wird jene Gerade, für die die Summe der quadrierten

Abweichungen der vorhergesagten y-Werte minimal wird. Die Lösung erhält man mit Hilfe der

Differentialrechnung.

28

Korrelation

Im Streuungsdiagramm können die Datenpunkte nahe der Regressionslinie liegen (enger

oder hoher Zusammenhang), oder weiter davon entfernt sein (niedriger Zusammenhang).

Das Maß für die Enge des Zusammenhanges von zwei Merkmalen (x und y) ist der

Korrelationskoeffizient r oder ρ (rho).

Je nach Skalenniveau wird dafür eine eigene Methode zur Berechnung des

Korrelationskoeffizienten angeboten (siehe unten).

Der Wert von Korrelationskoeffizienten liegt zwischen 0 und 1:

0

für keinen Zusammenhang,

1

für einen vollständigen Zusammenhang zwischen Variablen.

Das Vorzeichen von r beschreibt die Richtung des Zusammenhanges:

+

den positiven oder gleichsinnigen - je größer x, umso größer ist y,

den negativen oder gegensinnigen Zusammenhang - je größer x, umso

kleiner ist y.

Achtung bei der Interpretation des Vorzeichens, z.B.:

Test 1 : Jump a.R.

Test 2 : 20m Sprint

Differenz in cm

Laufzeit in sec

r = - 0.85

Was bedeutet das negative Vorzeichen?

Bei der Interpretation von Korrelationskoeffizienten ist zu unterscheiden, ob mit seiner Hilfe die Höhe des

Zusammenhangs von Variablen beurteilt wird, etwa nach folgender Skala:

r =

0.0 < r <

0.4 ≤ r <

0.7 ≤ r <

r =

0

0.4

0.7

1.0

1

kein Zusammenhang

niedriger

mittlerer

hoher

vollständiger Zusammenhang,

oder ob die Signifikanz des Korrelationskoeffizienten beurteilt wird, das heißt, ob der Zusammenhang

zwischen den Variablen signifikant von Null abweicht (r ≠ 0), siehe dazu die Ausführungen im Abschnitt

„Schließende Statistik“!

Maßkorrelation (Produkt-Moment-Korrelation)

Die Produkt-Moment-Korrelation beruht auf der Kovarianz von zwei intervallskalierten

Variablen. Die Kovarianz als Maß für das "miteinander Variieren" der Messwerte der

beiden Variablen x und y (je größer x, umso größer y) wird folgendermaßen berechnet:

cov(x, y) =

1 n

⋅ ∑ ( xi - x ) ⋅ ( y i - y )

n i=1

(13)

Es ist einsichtig, dass dieses Zusammenhangsmaß durch Maßstabs- bzw.

Streuungsunterschiede zu sehr verschiedenen Werten führen kann, die nicht ohne

weiteres interpretierbar sind; durch Division der Kovarianz durch das Produkt der

29

Standardabweichungen der Variablen x und y erhält man eine "standardisierte

Kovarianz", den sogenannten Produkt-Moment-Korrelationskoeffizienten rpm:

n

∑( x - x ) ⋅ ( y - y )

i

i

i= 1

r=

(14)

n ⋅ sx ⋅ s y

Bestimmtheitsmaß r² (Determinationskoeffizient):

Bei linearem Zusammenhang kann durch Quadrieren von r der auf 1 bezogene

Anteil der gemeinsamen Varianz zweier Merkmale angegeben werden. Als

Prozentwert (r² mal 100%) drückt er aus, welcher Anteil an der Varianz der y-Werte

durch die Variable x (oder umgekehrt) erklärt wird.

männlich

weiblich

A

90

A

Masse (kg)

=

A

A

R-Quadrat

= 0.44

Masse (kg)

80

A

A

A

70

A

A

A

Lineare Regression mit

95.00% Vorhersageintervall für Mittelwert

A AA

A A

A

A

-60.90

+

0.74

* grö

A

A

A

AA

A

A

A

A

A

A

A A

A

A AA

A A

A

A

AA

AA

A

A A

AA

A A

A

AA

A

A

A

A

Masse (kg) = -31.46 + 0.54 * grö

R-Quadrat

= 0.37

A

A

A

A

A A

A

A

A

A

A

A A

A

A A

AAA

A

A

A AA

A

AA

A

A

A

A

AA

60

A

A

A

50

A AA

A

A

A

160

170

180

190

160

Körpergröße (cm)

170

180

190

Körpergröße (cm)

Rangkorrelation

Der Zusammenhang von ordinalskalierten Variablen oder von intervallskalierten Variablen,

die "Ausreißer" enthalten, wird meistens mit dem

Rangkorrelationskoeffizient nach SPEARMAN (rs) erfasst:

n

rs = 1 −

6 ⋅ ∑ d i2

i =1

n(n 2 − 1)

(15)

di Differenz der Rangplätze, die eine Versuchsperson i bezüglich der Merkmale x und y erhalten hat.

Diese Methode für Rangdaten ist von der Produkt-Moment-Korrelation abgeleitet. Sie wird

sehr häufig auch für Messdaten (Intervalldaten) verwendet. Diese müssen zuerst in

Rangreihen übergeführt werden!

Achtung: Verbundene Ränge: Falls identische Messwerte vorkommen, ist diesen jener Rangplatz

zuzuordnen, der sich als durchschnittlicher Rang aller von ihnen beanspruchten Rangplätze ergibt,

z.B. sind den fünf gemessenen Werten 48, 50, 50, 53, 55 die Ränge 1, 2.5, 2.5, 4 und 5 zuzuordnen.

Rangkorrelationskoeffizient nach KENDALL (τ):

Ein anderes bekanntes Korrelationsmaß für Ordinaldaten ist das τ (sprich tau) von KENDALL. Es wird nicht

von der Produkt-Moment-Korrelation abgeleitet. Das τ kann nur positive Werte annehmen, d.h., es gibt nicht

die Richtung des Zusammenhanges an.

Hinweis: Die Rangkorrelation ist auch für jene Fälle heranzuziehen, in denen nur bei einer Variablen die

Voraussetzungen für die Maßkorrelation (Skalenniveau) gegeben sind.

30

Weitere Zusammenhangsmaße sind folgender Übersicht der bivariaten Korrelationsarten

zu entnehmen, die neben weiteren Korrelationsmethoden in BORTZ 1999, 214-225 erklärt

werden.

Merkmal x ⇒

Merkmal y

⇓

Intervallskala

dichotomes

Merkmal

Ordinalskala

Intervallskala

ProduktMoment-Korr.

Punktbiseriale

Korrelation

RangKorrelation

Φ-Koeffizient

biseriale

Rangkorr.

dichotomes

Merkmal

Ordinalskala

RangKorrelation

Zusammenhang bei mehr als zwei Variablen2

Multiple Korrelation

Mit der multiplen Korrelation R wird der Zusammenhang zwischen mehreren (Prädiktor-)

Variablen und einer (Kriteriums-) Variablen bestimmt. Durch Einbeziehen von mehreren

Prädiktoren (unabhängige Variablen) kann ein Kriterium (abhängige Variable) mit Hilfe

einer multiplen Regressionsgleichung vorhergesagt werden. Jede der Prädiktorvariablen

trägt einen Teil zur "Aufklärung" der Varianz der abhängigen Variablen bei. R² mit 100

multipliziert (siehe Bestimmtheitsmaß) gibt an, welchen Prozentsatz der Varianz der

abhängigen Variablen die Prädiktoren aufklären.

Partialkorrelation und „Scheinkorrelation“

Ein Spezialfall für den Zusammenhang zweier Variablen ist gegeben, wenn erst durch

Berücksichtigung einer dritten Variablen der wahre Zusammenhang aufzudecken ist. Wird

beispielsweise der Zusammenhang von Abstraktionsfähigkeit (x) und senso-motorischer

Koordination (y) bei Kindern untersucht, wird ein rxy = 0,89 ermittelt. Wird das Alter der

Kinder (z) mitberücksichtigt und sein Einfluss auf die Variablen x und y

"herauspartialisiert", erhalten wir für den Zusammenhang mit Hilfe der sogenannten

Partialkorrelation den Korrelationskoeffizienten rxy.z = 0,72.

Faktorenanalyse

Wird für die wechselseitigen Beziehungen zwischen vielen Variablen ein einfaches

Erklärungsmodell gesucht, können mit Hilfe einer Faktorenanalyse solche Variablen, die

untereinander stark korrelieren, zu einem Faktor zusammengefasst werden. Variablen von

verschiedenen Faktoren korrelieren untereinander gering. Ausgangspunkt der FA ist die

Korrelationsmatrix. Daraus werden die sogenannten Eigenwerte bestimmt. Es werden

gewöhnlich so viele Faktoren „extrahiert“, als Eigenwerte über 1 vorliegen. Wieviel % der

gesamten Varianz der einzelnen Variablen durch diese Faktoren erklärt werden, wird

angegeben. Die „rotierte“ Faktormatrix enthält die „Ladungen“, welche man als

Korrelationskoeffizienten zwischen den Faktoren und Variablen verstehen kann. Ihre

Deutung führt zum eingangs erwähnten Erklärungsmodell.

2

Die Beschreibung des Grundprinzips und der rechnerischen Durchführung dieser Methoden können

nachgeschlagen werden in BORTZ (1999), S. 429-438 und 495-546

31

Intraclass Correlation Coefficient (ICC)

Wenn die Übereinstimmung von zwei oder mehr als zwei Variablen nicht nur nach ihrer

Richtung betrachtet wird („je größer die eine, desto größer/kleiner die andere“), sondern

auch bezüglich ihres Mittelwertes, dann ist der ICC zu verwenden. Dieser setzt jedoch

voraus, dass alle Variablen in der gleichen Maßeinheit erfasst werden.

Üblicherweise repräsentieren die verschiedenen Variablen das Ausprägungsniveau ein

und desselben Merkmals, das entweder

mit verschiedenen Methoden erfasst wird (z.B. gemessenes und geschätztes

Körpergewicht) oder

das von verschiedenen Beobachtern mit derselben Methode (z. B. bei der Überprüfung

der Objektivität von Tests) erfasst wird, oder

das vom selben Beobachter bei Messwiederholungen (z. B. bei der Überprüfung der

Zuverlässigkeit von Messungen) erfasst wird.

Für Letzteres steht folgendes Beispiel, bei dem es um die Analyse der Reliabilität des

‚Agility’-Tests geht.

120 SportstudentInnen absolvierten je 4 Testdurchgänge mit je 20 Stimuli. Die durchschnittliche

Reaktionszeit bei 20 Stimuli wurde als Testwert registriert. Die Mittelwerte aller 120 Versuchspersonen

(Vp.) bei den 4 Durchgängen sind grafisch als Fehlerbalkendiagramm dargestellt.

Reaktionszeit (Mittelwert +- 1 SD in Sek.)

1000

900

800

700

N=

120

120

MW isol.Sp. V1

V1

V2

V3

V4

V1

1.0000

.7338

.7455

.7533

MW isol.Sp. V2

120

120

MW isol.Sp. V3

MW isol.Sp. V4

V2

V3

V4

1.0000

.8032

.7652

1.0000

.8453

1.0000

Die Maßkorrelationskoeffizienten aus der Kombination aller 4 Variablen sind aus der Korrelationsmatrix

abzulesen. Sie liegen zwischen 0,73 und 0,85.

Im Vergleich dazu ist der mit Hilfe von SPSS errechnete ICC, der eine Art Zusammenfassung aller 6

Kombinationen darstellt, mit 0,75 niedriger als der Durchschnitt der Maßkorrelationskoeffizienten, was auf

die Mittelwertsdifferenzen zurückzuführen ist. Nachdem der ICC hier für die Reliabilitätsüberprüfung

verwendet wurde, ist das Ergebnis so zu interpretieren, dass bei Durchführung des Agility-Tests mit nur

einem Durchgang (single Measure ICC) die Reliabilität nicht sehr überzeugend ist.

Mit der Methode des ICC lässt sich jedoch auch jener Reliabilitäts-Koeffizient ermitteln, der gilt, wenn man

alle 4 Beobachtungsreihen zusammenfasst = mittelt (Average Measure ICC). Dieser beträgt 0,92 und wäre

damit ausgezeichnet.

32

C. Anwendungen bei der Konstruktion

sportmotorischer Test

Sportmotorische Tests sind unter Standardbedingungen

durchzuführende, wissenschaftlichen Kriterien genügende

Prüfverfahren zur Untersuchung sportmotorischer

Merkmale, mit dem Ziel, möglichst genaue quantitative

Angaben über den relativen Grad der

Merkmalsausprägung zu liefern.

Ablaufdiagramm

zur Testkonstruktion

VORÜBERLEGUNGEN

Gültigkeitsbereich

(Valititätskriterium)

Geltungsbereich

TESTENTWURF

Konstruktion d. Testaufgabe

Testanweisung

ERPROBUNG

TESTANALYSE

Anal. d. Testaufgaben

Anal. d. Gütekriterien

KRITERIEN

ERFÜLLT ?

Ja

ENDFORM

NORMIERUNG

PUBLIKATION

Nein

33

1. Testanalyse

Testanalyse

Der Einsatz geeigneter Tests ist grundsätzlich Voraussetzung für die Bewertung von

Untersuchungsergebnissen. Daher ist es unumgänglich, dass wir uns einen tieferen

Einblick in die verschiedenen Aspekte verschaffen, die bei der Beurteilung der Eignung

SMTs zu beachten sind.

Analyse der Testaufgaben und der Rohwerte

Die Testvorform, die an einer repräsentativen Personengruppe erprobt wurde, wird einer

Analyse unterzogen, welche die Aufgabenschwierigkeit, Aufgabentrennschärfe und

Testpunkteverteilung näher untersucht. Sie dienen als wichtige Kriterien für die

Beurteilung der Eignung von Testaufgaben.

Die Untersuchung der Testaufgabe auf diese Kriterien hin erfolgt zweckmäßigerweise

vor der Analyse der Hauptgütekriterien.

Aufgabenschwierigkeit und Aufgabentrennschärfe

Zu hohe oder zu niedrige Schwierigkeit einer Testaufgabe kann dazu führen, dass die

Leistungsfeststellung nur bei einem eingeschränkten Personenkreis möglich ist, z.B.

Test Tauhangeln - die für die Bewertung der Kraftfähigkeit benötigten Zeit ist bei

Kindern nicht erhebbar, der Test ist für die meisten zu schwierig.

Der Test soll eine Differenzierung der Leistungsfähigkeit von Personen ermöglichen,

auch wenn sich deren Leistungsfähigkeit nur wenig unterscheidet; Testaufgaben mit

guter Trennschärfe ermöglichen dies.

Zur Verbesserung der Trennschärfe kann unter Umständen eine Erhöhung der

Testlänge oder der Wiederholungszahl dienen. Die Messgenauigkeit hat Einfluss auf die

Trennschärfe, eine Erhöhung der Messgenauigkeit zur Verbesserung der Trennschärfe

ist aber nur begrenzt sinnvoll. Auch die richtige Aufgabenschwierigkeit kann zu guter

Trennschärfe beitragen. Eine Testbatterie, deren einzelne Items alle gleich schwer sind,

differenziert schlechter als eine Testbatterie mit unterschiedlich schweren Testaufgaben.

Sowohl für die Bewertung der Aufgabentrennschärfe als auch für die Bewertung der

Aufgabenschwierigkeit gibt es „Indizes“ (für den Schwierigkeitsindex nur, wenn es sich

um Aufgabentypen mit dichotomer Leistungsfeststellung - gelöst oder nicht gelöst handelt).

Trennschärfenindizes:

Für intervallskalierte, normalverteilte Testrohwerte:

TI =

Für nichtnormalverteilte oder ordinalskalierte Merkmale:

v

p

TI’ = p

v (%) Variabilitätskoeffizient (siehe deskr. Statistik),

p (%) relative Häufigkeit des Dichtemittels (des Modus).

(vgl. K. JESCHKE, Gedanken zur Trennschärfe sportmotorischer Tests, in:

Leibesübungen - Leibeserziehung, 31(1977) 9:217-220

Für alternativ verteilte (nominalskalierte) Variablen (LIENERT 1989, 113):

34

Upper-Lower-Index: ULI =

Rsuperior - Rinferior

f

Rsup, Rinf

Anzahl der richtigen Antworten in der besseren/schlechteren

Gruppe,

f

Anzahl der Pbn in jeder der beiden gleich großen Gruppen.

Schwierigkeitsindex (LIENERT 1989, 88):

P = 100

NR

N

NR

N

Anzahl der Pbn, die die Aufgabe (richtig) gelöst haben,

Gesamtzahl der Pbn.

Diese Formel wird vor allem für Niveautests verwendet.

Rohwert-Verteilungsanalyse

Die Aufgabenanalyse soll auch darüber Auskunft geben, ob der Test eine hinreichende

Streuung der Punktewerte (Testwerte) besitzt und ob diese annähernd normal verteilt

sind. Hinreichende Streuung und Symmetrie der Rohwerteverteilung sind zwar keine

notwendigen Bedingungen für einen guten Test, aber für die Testeichung von Vorteil.

Analyse der Gütekriterien sportmotorischer Tests

Zu den allgemein geforderten und anerkannten Kriterien von Tests zählen die

sogenannten Hauptgütekriterien:

OBJEKTIVITÄT

RELIABILITÄT oder ZUVERLÄSSIGKEIT

VALIDITÄT,

neben diesen gibt es einige (z.T. umstrittene) Nebengütekriterien wie: Normierung,

Ökonomie, Vergleichbarkeit, Nützlichkeit.

Analyse der Objektivität

Def. (LIENERT 1989, 13): "Unter Objektivität eines Tests verstehen wir den Grad, in

dem die Ergebnisse eines Tests unabhängig vom Untersucher sind. Ein

Test wäre dann vollkommen objektiv, wenn verschiedene Untersucher bei

demselben Probanden zu gleichen Ergebnissen gelangten."

Aufgrund der Differenzierung des testdiagnostischen Prozesses in Durchführung

(Provokation, Registrierung d. Testverh.) Auswertung und Interpretation unterscheiden

wir

- Durchführungsobjektivität,

- Auswertungsobjektivität und

- Interpretationsobjektivität.

35

Zur Erzeugung einer hohen Durchführungsobjektivität ist eine möglichst vollständige

Standardisierung der Bedingungen von Provokation und Registrierung des

Testverhaltens notwendig.

Ermittlung der Durchführungsobjektivität

Indem

1. zwei oder mehrere Untersucher einen Test an derselben Personenstichprobe

durchführen, d.h. das Testverhalten provozieren und registrieren,

2. man das registrierte Testverhalten nach objektiven Kriterien auswertet (-Rohwerte),

3. man den Korrelationskoeffizienten robj(D) zwischen den Testbefunden der

verschiedenen Untersucher ermittelt.

Die Wiederholung der Testdurchführung kann zu einem veränderten Ergebnis führen.

Um dieser Abweichung auf den Grund zu gehen, differenzieren wir den registrierten

Testwert tD in seinen

wahren Wert w (wahre Messkomponente) und seine

Fehlerkomponente eD:

tD = w + e D

Die Fehlerkomponente selbst ist wiederum abhängig von einer Reihe von Faktoren:

eD = eP + eR + eÜb + eFl

eD ... totaler Zufallsfehler bei der Testdurchführung

eP ... Unterschiede in der Provokation

eR ... Registrierungsfehler

eÜb .. Übungseffekte

eFl .. Fluktation des Merkmals

Die Varianz der Messwerte aus wiederholter Testdurchführung, die aus Übungseffekten

stammt, nimmt bei längeren Intervallen zwischen Test und Testwiederholung ab,

während jene Varianz, die durch die Zufallsfehler infolge der Fluktuation bestimmt wird,

größer wird.

Bei der Prüfung der Durchführungsobjektivität ist daher das zeitliche Intervall zwischen

den beiden Testdarbietungen so zu wählen, dass die Summe aus beiden Varianzen ein

Minimum wird.

Ermittlung der Auswertungsobjektivität

Die Auswertungsobjektivität wird ermittelt, indem

1. zwei oder mehrere Auswerter ein registriertes Testverhalten nach bestimmten

Kriterien beurteilen und in Form von Rohwerten aufbereiten.

2. man den Korrelationskoeffizienten zwischen den durch die verschiedenen Auswerter

ermittelten Rohwerten berechnet

Je höher der quantitative Informationsgehalt des testrelevanten Verhaltens ist, umso höher ist der Grad der

Auswertungsobjektivität; bei sportmotorischen Tests spielt die Ermittlung der Auswertungsobjektivität eine

untergeordnete Rolle, wenn die registrierten Ergebnisse eindeutig sind, bzw. auch schon das Testergebnis

darstellen, z.B. Wiederholungszahlen, Trefferzahlen, Zeitwerte, Längenwerte, Gewichtgrößen, Rangziffern,

Punktewerte...

Ermittlung der Interpretationsobjektivität:

Indem zwei oder mehrere Interpreten die Rohwerte nach bestimmten Richtlinien einer

Interpretationskategorie zuordnen und man die Übereinstimmung unter den Interpreten

mit Hilfe des Kontingenzkoeffizienten ermittelt.

36

Beurteilung der Objektivitätskoeffizienten robj

Angaben nur zur komplexen Objektivität (Durchführung, Auswertung, Interpretation):

nach CLARKE (siehe BÖS 1987, 121):

robj

> 0,95

sehr hoch; bei den besten Tests

0,90 - 0,94 hoch; annehmbar

0,80 - 0,89 noch genügend für Individualuntersuchungen

0,70 - 0,79 genügend für Gruppenanalysen, aber nicht ausreichend für

Individualanalysen

< 0,69

brauchbar für Gruppendurchschnittswerte,

völlig ungenügend für Individualanalysen

Analyse der Reliabilität

Def.: (LIENERT 89, 14) "Unter Reliabilität eines Tests versteht man den Grad der

Genauigkeit, mit dem er ein bestimmtes Persönlichkeits- oder

Verhaltensmerkmal misst, gleichgültig, ob er dieses Merkmal auch zu

messen beansprucht (welche Frage ein Problem der Validität ist)."

Ein Test oder eine Messung wäre perfekt zuverlässig, wenn er in der Läge wäre, den

wahren Wert eines Merkmals ohne jeden Messfehler zu erfassen. Ein vollständig

reliabler Test müsste bei wiederholter Anwendung bei denselben Versuchspersonen zu

den gleichen Ergebnissen führen, wenn sich die Fähigkeit (der wahre Wert) nicht

inzwischen geändert hat. Dieser Idealfall kommt in der Praxis nicht vor, wie aus der

Erfahrung mit Versuchswiederholungen bei sportmotorischen Tests bekannt ist.

Fehlereinflüsse können durch Messinstrumente, die Messsituation, durch Ermüdung

und weitere Faktoren verursacht sein.

Voraussetzung

für

die

Bestimmung

der

Reliabilität:

möglichst

genaue

Reproduzierbarkeit der Testergebnisse der einzelnen Testpersonen. Wenn die Messung

genau ist, dann ergibt eine wiederholte Messung dasselbe oder ein ähnliches Ergebnis

( t = w + e).

Der Grad der Zuverlässigkeit wird durch einen Reliabilitätskoeffizienten bestimmt, der

angibt, in welchem Maße die Testergebnisse reproduzierbar sind.

1. Testwiederholungsreliabilität - RETEST-Methode

Die Reliabilität wird bestimmt, indem

1. ein und derselbe Test nach angemessenem Zeitabstand an ein und dieselbe

Stichprobe dargeboten wird und

2. aus den Rohwerten von Test und Testwiederholung der Korrelationskoeffizient rtt

berechnet wird.

Die Anwendung der Retest-Methode ist nur dann sinnvoll, wenn begründet

angenommen werden darf, dass WIEDERHOLUNGSEINFLÜSSE (Übung, ...) keine

oder eine nur sehr geringe, praktisch zu vernachlässigende Auswirkung auf die

Korrelation zwischen Test und Retest haben.

Ein mot. Koordinationstest prüft im Wiederholungsfall zugleich die Funktion des

motorischen Gedächtnisses ⇒ Bedingungsfluktuation.

37

Interpretation der Höhe des Retestkoeffizienten in Abhängigkeit von der Länge des

Zeitintervalls (ROTH 1983, 119):

Länge des Zeitintervalls

Höhe des Retestkoeffizienten

ausreichend

nicht ausreichend

Kurz

hohe Bedingungskonstanz geringe Bedingungskonstanz

(Kurzzeitfunktionsfluktuation)

lang

hohe Merkmalskonstanz

geringe Merkmalskonstanz

hohe Bedingungskonstanz (Langzeitfunktionsfluktuation)

Funktionsfluktuation: ein Test prüft nach einer gewissen Zeit etwas anderes als vorher

oder bei unterschiedlichen Bedingungen einen anderen Aspekt des zu untersuchenden

Merkmals.

Merkmalsfluktuation: das zu prüfende Merkmal weist nach einer gewissen Zeit einen

anderen Ausprägungsgrad auf.

Kriterien für die Anwendung des Retestverfahrens:

1. Wenn die zu untersuchende sportmotorische Leistung eine zeitlich mehr oder weniger

ausgedehnte Invarianz aufweist und

Wiederholungseinflüsse zu vernachlässigen sind.

2. Bei heterogenen Tests, die ein schwer abgrenzbares Persönlichkeitsmerkmal oder

einen Merkmalskomplex diagnostizieren sollen (kein Paralleltest, keine Testhalbierung,

da inhomogene Testbatterie, -profile).

3. Bei sog. Schnelligkeitstests.

2. Paralleltestreliabilität - PARALLELTEST-Methode

wenn wegen Wiederholungseinflüssen (Lern- oder Übungseffekte, Sättigung,

Vertrautheit mit der Testsituation usw.) ein Retest nicht angezeigt ist, dann kann durch

einen PARALLELTEST (validitätsähnlicher Test) die Reliabilität überprüft werden.

Die P. wird bestimmt indem man

1. einen Test und seine Parallelform an derselben Personenstichprobe durchführt

und

2. aus den Rohwertepaaren den Korrelationskoeffizienten rtt ermittelt.

Voraussetzung zur Anwendung ist die Existenz einer Parallelform zu dem

ursprünglichen Test.

Anwendungsgrund: Ausschaltung von Wiederholungseinflüssen.

Problem: Je größer die Gleichartigkeit der beiden Parallelformen ist, umso wirksamer

sind Wiederholungseinflüsse.

Beurteilung der Retest- und Paralleltestreliabilität

BÖS (1987, 123):

Korrelationskoeffizient r

≥ 0,90

0,80 - 0,89

0,70 - 0,79

0,60 - 0,69

< 0,60

ausgezeichnet

sehr gut

annehmbar

mäßig

gering

LIENERT (1989, 309): untere Schranken für r

0,70 zur Beurteilung individueller Differenzen noch ausreichend

0,50 zur Beurteilung von Gruppendifferenzen

0,80 für standardisierte Tests

38

3. Testhalbierungsreliabilität - SPLIT-HALF-Methode

Bei einer Testbatterie kann unter der Voraussetzung, dass der Test aus mehreren

Aufgaben besteht, die sich als Paralleltestformen anordnen lassen.

Die Testhalbierungsreliabilität wird bestimmt, indem man

1. einen Test an einer Personenstichprobe durchführt,

2. die Testaufgaben nach festgelegten Halbierungstechniken aufteilt,

3. den Korrelationskoeffizienten zwischen den beiden Rohwertereihen ermittelt und

4. den Gesamttest Reliabilitätskoeffizienten rtt mit Hilfe einer Schätzformel (u.a.

SPEARMAN-BROWN3) aus dem Halbtest- Reliabilitätskoeffizienten berechnet.

Halbierungstechniken: Halbierung nach geradzahligen und ungeradzahligen Aufg., nach

zufällig ausgewählten Aufg., nach Aufgabenpaaren annähernd gleicher Schwierigkeit,

nach der Testzeit u.a. (LIENERT 1989, 219).

Höhe des Korrelationskoeff. bei allen Methoden abhängig von der Merkmalsvarianz in

der Bezugsgruppe (Stichprobe, Population): bei Leistungshomogenität r ↓,

bei Leistungsheterogenität r ↑.

Komponenten des Messfehlers bei den verschiedenen Verfahren zur Bestimmung

der Reliabilität:

Testwiederholungsmethode

eSubj

eÜb

eFl

e = eSubj + eÜb + eFl

Fehler, der sich auf die Varianz d. Erg. auf Grund mangelnder Objektivität

(bei Provokation, Registrierung, Auswertung) auswirkt.

Fehler, der aus Übungseffekten infolge der ersten Testdurchführung

stammt.

Fehler, der der Fluktuation des zu diagnostiziernden Merkmals

zuzuschreiben ist.

Die Summe aus eÜb und eFl soll ein Minimum sein,

esubj wird ausgeschlossen durch möglichst vollständige Standardisierung.

Paralleltestverfahren

eÄq

e = eSubj + eÜb + eFl + eÄq

mangelnde Übereinstimmung zwischen Test und Paralleltest (eigentl. kein

Fehler sondern wahre Varianz).

Problem: je größer Äquivalenz, desto größer Übungseffekt.

3

vgl. LIENERT 1989, 221

39

Testhalbierung

e = eSub + eÄq

Die Übereinstimmung der beiden "Testhälften" ist am höchsten bei Homogenität des

Tests, d.h. wenn die Testaufgaben dieselbe Variable messen.

Erhöhung der Reliabilität durch Steigerung der Testlänge:

• homogene sportmot. Testbatterien werden erweitert durch weitere homogene Testaufgaben,

• "Verlängern" eines Tests durch Erhöhung der Wiederholungszahl, z.B Wurfgenauigkeit wird besser

gemessen aus 10 Versuchen als aus 5 (Mittelwert daraus - ohne/mit schlechtestem/bestem)

Analyse der Validität

Def.: V. eines Tests gibt den Grad der Genauigkeit an, mit dem dieser Test

dasjenige Persönlichkeitsmerkmal od. diejenige Verhaltensweise, das (die)

er messen soll oder zu messen vorgibt, tatsächlich misst (LIENERT 1989,

16).

Die Validität ist das wichtigste Gütekriterium.

Problem der Gültigkeit von Kontrollmethoden

In den Naturwissenschaften od. in der Anthropometrie sind Messungen eindeutig,

z.B. mit der Waage wird das Gewicht gemessen. Es stellt sich die Frage nach der

Zuverlässigkeit, aber nicht nach der Gültigkeit.

Die bei sportmotorischen Tests geforderten Bewegungsabläufe sind nie Ergebnis

eines einzelnen Funktions- oder Steuerungsprozesses, sondern vielseitig

determiniert.

Das Ergebnis eines sportmot. Tests ist zunächst einmal Ausdruck der erreichten,

speziellen sportmot. Fähigkeit (Fertigkeit) in den geforderten Bewegungen.

Bei der Konstruktion von Testverfahren für die Diagnose mot.

Grundeigenschaften ist zu beachten, dass Einflüsse von Fertigkeiten durch die Art

der Testaufgabe ausgeschaltet werden.

1. Inhaltliche Validität (logische V., triviale V.)

"Der Test bzw. seine Elemente sind so beschaffen, dass sie das zu erfassende

Persönlichkeitsmerkmal oder die in Frage stehende Verhaltensweise repräsentieren, mit

anderen Worten: Der Test selbst stellt das optimale Kriterium für das

Persönlichkeitsmerkmal dar ... Inhaltliche Validität wird einem Test in der Regel durch

ein Rating von Experten zugebilligt" (LIENERT 1989, 16).

Die Erfassung der Maximalkraft mit einem Dynamometer oder die Messung der allgemeinen aeroben

Ausdauer durch Dauerläufe (einfach strukturierte Merkmale) können als inhaltlich valide Methoden

angesehen werden.

Die Interpretation des Ergebnisses hat bei den tatsächlich durchgeführten Operationen zu bleiben,

z.B. Testaufgabe "Wurfgenauigkeit" für die Fähigkeit "genaues Werfen" unter den gegebenen

Bedingungen (z.B aus dem Stand,Bewegung...).,

z.B. kann aus einem Reaktionsschnelligkeitstest nicht auf die Schnelligkeit geschlossen werden, mit der

allgemein reagiert wird.

40

Bei der Inanspruchnahme der inhaltlichen V. werden die zu bewertenden Testaufgaben

einer Gruppe von kompetenten Beurteilern vorgelegt, die über den Gegenstand der

Diagnose befragt werden.

Beispiel: MEINIG (nach ROTH, 1. Aufl. 1977, 133):

Bestätigung der inhaltlichen Validität bei 20 Tests durch Befragung von 110 kompetenten Beurteilern;

einerseits sollte die Dominanz einer "allg. sportmot. Fähigkeit" (mot. Eigenschaft) andererseits der

Gültigkeitsbereich der Fähigkeit nach beteiligten Hauptmuskelgruppen (Arm, Schulter, Bauch, Rücken,

Beinmuskulatur) angegeben werden.

Ergebnis der Beurteiler beim Test:

Klimmziehen

Kraft

64%

Armmuskulatur

61%

Ausdauer

27%

Dreier Hop

Kraft

(50%)

Beinmuskulatur

78%

Gewandtheit

20%

2. Kriteriumsvalidität

Um ein Maß (einen Koeffizienten) für die Höhe der Validität zu erhalten, muss der

Zusammenhang zwischen den nicht direkt beobachtbaren sportmotorischen Funktionsund

Steuerungsprozessen

('latente

Fähigkeiten')

und

den

konkreten

Bewegungsvollzügen ('manifestes Testverhalten') untersucht werden.

Die Kriteriumsvalidität geht davon aus, dass es neben dem Test weitere Möglichkeiten

(Kriterien) gibt, das zu diagnostizierende Merkmal zu erfassen.

Zusammenhang zwischen der latenten Dimension, dem Testverhalten und dem

4

Kriteriumsverhalten (nach FISCHER 1974, 71) :

latente

Dimension

sportmot. Fähigkeit(en) W

die sich bei der Testleistung

und sonstigem (Kriteriums-)

Verhalten auswirken.

rKW

manifeste

Testleistung

rB1W ... Konstruktvalidität

Kriteriumsverhalten K

abhängig von den

sportmot.Fähigkeit(en)

und vom Zufall

rB1K

Testverhalten B1 abhängig

von einer sportmotorischen

Fähigkeit und von