DA Manook - Erich-Thienhaus-Institut

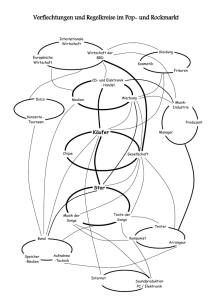

Werbung