2 - Werner Weickert

Werbung

X Grundlagen

Liebe Seminarteilnehmerin, lieber Seminarteilnehmer,

herzlich willkommen zum Seminar „Datenbanksysteme"

Dieses „Tafelskript“ dient nur als ergänzende Unterlage zu den

Lernmaterialien in Buchform und stellt eine Zusammenfassung (ohne

Erklärungen) der wesentlichen Aspekte dar, die im Unterricht entwickelt

werden.

Für Streiche des „Fehlerteufels“ kann leider keine Haftung übernommen

werden,...

Ich wünsche Ihnen viel Spaß und Erfolg bei Ihrem Seminar!

Ihr Seminarleiter

Copyright 2015 Werner Weickert, Westweg 15, 85375 Neufahrn

Ich danke meinen Kursteilnehmern, Kunden und Kollegen für ihre Ratschläge und Kritik. Stellvertretend seien Brigitte Fitznar und Hubert Schierl

genannt.

Unbefugte Vervielfältigung, Verwendung oder Weitergabe sind nicht gestattet! Im Interesse der Kunden werden alle Rechtsmittel genutzt,

um gegen Verstöße gegen das Copyright vorzugehen.

Warennamen werden ohne Gewähr der freien Verwendung genutzt. Für fehlerhafte Angaben wird keine Haftung übernommen.

Vorlage vom 01.03.2015 / skripten2015.dotx

Werner Weickert

Datenbanksysteme

X

Werner Weickert

Inhaltsverzeichnis

Skript Datenbanksysteme

1. Vorteile relationaler DB-Systeme gegenüber Dateisystemen .................... 1

2. Begriffe zum Schichtenmodell ................................................................... 4

3. Datenbankmodelle ...................................................................................... 6

4. Vorgehensweise beim Erstellen einer relationalen DB ............................ 12

5. Normalisierungsprozess............................................................................ 16

6. Übungen zur Normalisierung.................................................................... 21

7. Mehrbenutzerbetrieb und Transaktionskonzept........................................ 25

8. Physische Organisation von Dateisystemen ............................................. 38

9. Physische Organisation bei Datenbanken................................................. 39

10.Primärorganisation von Dateien ............................................................... 53

11.Sekundäre Zugriffspfade........................................................................... 62

12.Recovery und Concurrency....................................................................... 75

13.Verteilte Datenbanken............................................................................... 84

14.Codd´s 12 Regeln für relationale Datenbanken........................................ 91

15.Sicherheit und Integrität............................................................................ 92

Datenbanksysteme

Warum sollte ein Unternehmen seine Daten in einer DB speichern?

Hauptgrund: Zentrale Kontrolle

Bisher: Keine Kontrolle, da jeder Anwender zumeist seine eigenen Dateien,

mitunter sogar Bänder und Platten hat →weite Streuung der Daten.

DBA (Datenbankadministration) erhält zentrale Verantwortung

Vorteile dieser zentralen Kontrolle sind:

1.

Redundanz (Mehrfachspeicherung) wird gesenkt

In dateiorientierten Systemen hat jede Anwendung ihre eigenen privaten Daten,

das führt zu erheblicher Redundanz mit Speicherplatzverschwendung.

Beispiel: Eine Personalanwendung und eine Schulungsanwendung speichern

beide eine Abteilungsinformation über einen Arbeitnehmer. Diese beiden Dateien

könnte man zusammenfassen und Redundanz eliminieren, wenn DBA die

Anforderungen der beiden Anwender kennt, d.h. die zentrale Kontrolle hat.

Die Redundanz lässt sich i.a. nicht total eliminieren, oft sprechen technische

Gründe und sonstige Handhabungen sogar dafür, mehrere Kopien derselben

Daten zu speichern. Jedoch, Kontrolle der Redundanz in DB-System sollte immer

gegeben sein, d.h. dass das System die vorhandene Redundanz kennt und die

Verantwortung für „saubere“ Änderungen übernimmt.

2.

Inkonsistenz kann vermieden werden

Durch Redundanz entstehen ggf. verschiedene Aktualitätsstände.

Beispiel: Arbeiter E3 arbeitet in Abteilung D8 und dies wird an zwei

verschiedenen Stellen in DB gespeichert, DBS weiß dies aber nicht, hat also

keine Kontrolle darüber. Wenn bei einer Änderung nur ein Satz verändert wird,

stimmen die beiden Sätze nicht mehr überein, die DB ist inkonsistent. Eine

inkonsistente DB kann unkorrekte, konfliktträchtige Informationen erzeugen.

Bei nur einem Eintrag (eliminierte Redundanz) kann dies nicht passieren.

1

3.

Die Daten sind teilbar

Verschiedene Benutzer haben Zugriff auf dieselben Daten

Beispiel: Sowohl Personal- als auch Schulungsabteilung haben Zugriff auf die

Informationen Arbeitnehmer, Schulungseintragungen.

Außerdem können neue Anwendungen mit denselben Daten arbeiten, d.h. man

braucht keine neuen Dateien schaffen, wenn man neue Anwendungen hat.

4.

Standards werden gefördert

Durch die zentrale Kontrolle über die DB kann DBA die Anwendung sämtlicher

möglicher Standards garantieren (unternehmerspezifische, nationale,

internationale). Z.B. Standardisierung der Formate gespeicherter Daten ist

wünschenswert bei Datenaustausch oder Systemmigration.

5.

Verbesserter Datenschutz

Durch die zentrale Verfügungsgewalt kann der DBA dafür sorgen, dass der

Datenzugriff über die zugelassenen Wege stattfindet und kann

Autoritätskontrollen festlegen für jeglichen Zugriff auf „gefährdete“ Daten. Für

jede Zugriffsart (Retrieval, Änderung, Löschung.....) kann eine eigene

Kontrollmöglichkeit eingebaut werden.

Wichtig: Kontrollen jetzt sogar nötiger als vorher, denn Datenschutz in DB wäre

sonst noch gefährdeter als in einem traditionellen gestreuten Dateisystem.

6.

Integrität lässt sich erzielen

Die Daten müssen korrekt sein.

Inkonsistenz ist ein Beispiel für fehlende Integrität. Aber sogar nach

Eliminierung von Redundanz kann die DB noch fehlerhafte Daten enthalten, z. B.

die „Tatsache laut DB“, dass ein Arbeitnehmer 200 Std./Woche gearbeitet hat.

Dies lässt sich durch zentrale Kontrolle der DB vermeiden und zwar indem der

DBA Wertprüfungsprozeduren definiert, die bei einer UPDATE Operation

ausgeführt werden. Integrität in einer DB ist sogar wichtiger als in einem

herkömmlichen System, da die Daten teilbar sind damit könnten andere

Programme leichter infiziert werden.

2

7.

Zuschnitt der Daten auf Anforderungen des Unternehmens

So wird z.B. für die hauptsächlich auftretenden Zugriffe hoher Bedienungskomfort (mit z.B. schnellem Zugriff) geboten, auf Kosten von weniger

benötigten Anwendungen.

Anmerkung: Hauptvorteil bzw. sogar Ziel eines DBS ist jedoch die

Datenunabhängigkeit. = Unabhängigkeit der Anwendungen gegenüber einer

Änderung der Speicherstruktur (Datenstrukturunabhängigkeit) oder der

Zugriffsstrategie (Zugriffspfadunabhängigkeit).

Dateiorientierte Anwendungen sind datenabhängig d.h. die Art wie die Daten im

Sekundärspeicher organisiert sind, wie auf sie zugegriffen wird, sind abhängig

von den Anforderungen der Anwendung, mehr noch, die Kenntnis der

Dateiorganisation und der Zugriffstechnik geht sogar in die Anwendungslogik

ein, z.B. Speicherung in indexsequentieller Form.

Die Anwendung muss wissen, dass es einen Index gibt, wie deshalb die Satzfolge

aufgebaut ist. Die Struktur des Programms baut auf dieses Wissen auf. Das

Programm hängt somit in hohem Maße von den Details der Schnittstelle ab, die

von der IS-Software dargestellt wird. Solch eine Anwendung ist datenabhängig,

weil man jetzt nicht einfach die Speicherstruktur (z.B. hash adr. oder seq. ad.)

und den Zugriff ändern kann, ohne das Programm ggf. drastisch umzubauen.

Innerhalb einer DB kann man sich Datenabhängigkeit nicht erlauben.

Beispiele:

1. Zwei Anwendungen A und B, die dasselbe Feld benutzen, werden in eine DB

integriert, Redundanz eliminiert, A braucht das Feld dezimal, B braucht es

binär. Legt man sich nun fest, dass das Feld dezimal gespeichert wird, so wird

es für B jedes Mal umgewandelt. (Ein typischer Fall von Abhängigkeit

zwischen Anwendung und physikalischer Speicherung ohne DB)

2. DBA muss Freiheit haben Speicherstruktur und Zugriffsstrategie zu ändern,

wenn sich Anforderungen ändern (z.B. neue Standards, neue Betriebsmittel

zur Speicherung), ohne schon exist. Anwendungen ändern zu müssen.

Änderung der Programme ist zusätzlicher Programmierereinsatz, der besser

anderweitig genützt würde.

Lösung: Datensubmodelle ( z.B. VIEW, SUBSCHEMA )

3

Begriffe zu: Datenbanksysteme

1. Betrachtung der gespeicherten Daten in verschiedenen Abstraktionsebenen:

a) interne Datensicht: physische Datenorganisation

tatsächliche Speicherung der Daten

b) konzeptionelle Datensicht: logische Gesamtsicht aller Daten

c) externe Datensicht: logische Sichten einzelner Benutzergruppen

auf Teile der DB

2. Schema:

Abstrakte Beschreibung der Satztypen

(Satztyp: Klasse von Sätzen mit qualifizierten Merkmalen und Beziehungen zu

anderen Typen. z.B. LIEFERANT, TEIL, MITARBEITER, ....)

a) konzeptionelles Schema:

beschreibt Aufbau sämtlicher Daten in DB auf logischer Ebene mit DDL.

Ankerpunkt des DB-Entwurfs.

Ziel: stabiler Bezugspunkt.

b) internes Schema:

enthält alle Informationen über Aufbau der phys. abgespeicherten

Datensätze, die Datenorganisation und die Zugriffspfade.

Ziel: Festlegung ideal für Benutzergemeinschaft

(Statistik über Zugriffshäufigkeiten)

c) externes Schema:

(Benutzerschnittstelle)

ähnelt formal dem Konzept: Maßgeschneiderte Benutzersicht +

Zugriffsschutz

DML (Datenmanipulationssprache) ermöglicht Umgang mit logischen

Sätzen auf externer Ebene.

4

Benutzer A1

Benutzer A2

Wirtssprache

+ DSL

Wirtssprache

+ DSL

* Externes

Schema A

Schema

und

Abbildungen

werden

definiert

und gepflegt

vom

DBA

mit

DDL

Benutzer B1

Wirtssprache

+ DSL

Benutzer B2

Wirtssprache

+ DSL

* Externes

Externe Sicht

A

Benutzer B3

Wirtssprache

+ DSL

Externe Sicht

B

Schema B

Externe / Konzeptionelle Abb. A

Externe / Konzeptionelle Abbildung B

Konzeptionelles

Schema

Konzeptionelle Sicht

DBMS

Data Base

Management

Konzeptionelle / Interne Abbildung

System

Speicherstruktur

definition

(Internes

Schema)

* Benutzerschnittstelle

Gespeicherte Datenbank (interne Sicht)

mit DML

5

Das Relationen Modell

L

L#

L1

L2

L3

NAME STATUS STADT

Smith

20

London

Jones

10

Paris

Blake

30

Paris

LIEF

T

T#

T1

T2

T3

T4

TNAME

Mutter

Bolzen

Schraube

Schraube

FARBE

Rot

Grün

Blau

Rot

GEWICHT

12

17

17

14

6

STADT

London

Paris

Rom

London

L#

L1

L1

L1

L2

L2

L3

T#

T1

T2

T3

T1

T2

T2

ANZ

300

200

400

300

400

200

Das Netzwerkmodell

L1 Smith 20 London

300

200

T1│Mutter│Rot│12│London

L2 Jones 10 Paris

400

300

L3 Blake 30 Paris

400

200

T2│Bolzen│Grün│17│Paris T3│Schraube│Blau │17│Rom T4│Schraube│Rot │14 │London

7

Das hierarchische Modell

T1 Mutter Rot

L2 Jones 10

12 London

Paris 300

L1 Smith 20 London 300

T2 Bolzen Grün 17 Paris

L3 Blake 30 Paris 200

L2 Jones 10 Paris 400

L1 Smith 20 London 200

T3 Schraube Blau 17 Rom

T4 Schraube Rot 14

L1 Smith

London

20 London 400

8

Q1: Finde alle L# von

Lieferanten, die Teil

Teilen, die Lieferant

T2 liefern

L2 liefert

hierarchisches Modell

Relationenmodell

do until no more Lief.

Netzwerkmodell

Q2: Finde alle T# von

get next Lieferung

do until no more Lieferung

get next Lieferung

where T# = T2;

print L#;

end;

where L# = L2

print T#;

end;

get [next] Teil

where T# = T2;

do until no more

Lieferanten under this Teil;

get next Lieferant

under this Teil;

print L#;

end;

do until no more Teile;

get next Teil;

get [next] Lieferant

under this Teil

where L# = L2;

if found

then print T#;

end;

get [next] Teil

where T# = T2;

do until no more connectors

under this Teil;

get next connector

under this Teil;

get Lieferant over this

connector;

print L#;

end;

get [next] Lieferant

where L# = L2;

do until no more connectors

under this Lieferant;

get next connector

under this Lieferant;

get Teil over this connector;

print T#;

end;

9

Netzdatenbanken

-

relationale Datenbanken

● Netzdatenbanken - halten die Struktur einer Anwendungsumgebung in der

Datenbank als Netz fest. Dadurch sind die Zugriffszeiten bei

Standardanwendungen kurz (z.B. beim Anzeigen eines Arbeitsplans etwa 5% der

Plattenzugriffe gegenüber einer relationalen Organisation). Auch die Konsistenz

der Datenbank ist einfacher zu gewährleisten, denn wenn ein Wurzelknoten

gelöscht wird, dann entfallen automatisch auch alle abhängigen Knoten.

● Relationale Datenbanken - sind demgegenüber für universelle

Anwendungen geeignet, da die Struktur der Anwendung im

Anwendungsprogramm und nicht in der Datenbank steckt. Der Suchaufwand und

der Speicherbedarf für Schlüssel sind größer. Der größte Vorteil besteht aber

darin, dass mächtige Abfragesprachen zur Verfügung stehen, die es auch dem

Laien gestatten, komplexe Suchfragen an die Datenbank zu stellen.

Zusammenfassung: Netzartige Datenbanken (entwickelt nach dem Bericht der

DBTG der CODASYL aus dem Jahr 1971) sind für komplexe,

anwendungsspezifische, verarbeitungsintensive Fälle wie z.B.

Nettobedarfsermittlung oder Netzplantechnik, ideal geeignet. Relationale

Datenbanken (Codd 1970-71) eignen sich für Abfragesysteme besser.

10

Relationale Datenbanksprachen

1. Einfachheit aufgrund „relationaler Vollständigkeit“.

d.h. ≈ jede in der DB enthaltene Information kann mit einer einzigen Abfrage

gefunden werden (Hilfe: built-in Funktionen).

2.

Mengenorientierte Verarbeitung

Ein Abfragebefehl betrifft alle Zeilen einer oder mehrerer Tabellen, die den im

Abfragebefehl definierten Bedingungen genügen.

( ≠ satzorientierte Abfragesprachen)

3. „Nichtprozedurale“ Sprache

Der Benutzer gibt nur an, welche Daten er möchte und nicht eine Prozedur wie

diese Daten aufzufinden sind.

(„optimale Wahl des Zugriffspfads“, „automatische Navigation“) Aufgrund

„Data Dictionary“ Festlegung des Zugriffs.

4. Einheitlichkeit der Sprache

In jeder Betriebsart die gleiche Syntax für alle Operationen: „direkt“ vom

Bildschirm (interaktiv), aus Programmen

5. Datenunabhängigkeit

Anwendung ist unabhängig von physischer und logischer Datenstruktur.

(Kein expliziter Bezug der Befehle darauf).

6. Unterstützung von Programmiersprachen

Einbettung der Befehle in Programmiersprachen

11

I. Abstraktionsprozess

Für die Erstellung des konzeptionellen Modells bedient man sich der Abstraktion.

Beispiel: Bibliotheksverwaltungssystem

1. Auswahl (Selektion):

Das Ziel dieses Schrittes ist, die Vielfalt von Objekten der Realwelt auf eine als

relevant erachtete, leichter überschaubare Menge von Objekten des Modells zu

reduzieren.

Auch die interessierenden Objekte können nicht zur Gänze beschrieben werden:

Die Beziehungen und Attribute einzelner selektierter Objekte sind zu vielfältig,

um vollständig dargestellt zu werden. Die Selektion beschränkt sich also nicht

nur auf die Auswahl von Objekten, sondern umfasst auch die Bestimmung von

Attributen und Beziehungen.

Bei dem Beispiel interessieren uns als Realweltobjekte Bücher, Autoren und

Kunden der Bibliothek, aber nicht Städte oder Minister. Ein Buch soll durch die

Attribute Inventarnummer, Titel, Verlag, Erscheinungsdatum und Ort-, Preis und

zwei Stichworte, ein Autor durch die Attribute Vor- und Zuname und ein Kunde

durch die Attribute Kundennummer, Vor- und Zuname und Adresse beschrieben

werden. Uninteressant sind die Automarken oder die Anzahl der Zahnfüllungen

der Kunden oder die Farbe der Bucheinbände. Dann werden die Beziehungen

zwischen den ausgewählten Entitytypen festgelegt.

2. Benennung

Jedem Objekt der Realität, jeder Beziehung und jedem Attribut wird ein

eindeutiger Name, ein Bezeichner zugeordnet. Das Ergebnis ist eine

Informationsstruktur, die grafisch dargestellt werden kann, z.B. in einem EntityRelationship-Diagramm.

3. Klassifikation

Die inhomogene Menge der Objekte und Beziehungen wird weiter in homogene

Klassen von Objekttypen unterteilt. Kriterien der Klassifikation sind entweder

sachbezogener oder verarbeitungstechnischer Natur. Der Grad der Klassifikation,

d.h. wie detailliert die Strukturierung vorgenommen wird, ist von Fall zu Fall

verschieden. Beim Beispiel der Bibliothek: Durch die Systematisierung der

Attribute durch Objekttypen wurde bereits ein Teil der Klassifikation

vorweggenommen. Das Ergebnis dieses Modellierungsvorganges nennt man

konzeptionelles Modell (engl. conceptual model )

12

II. Datenbankstrukturen

Nun muss noch ein geeignetes Datenmodell für die Repräsentation der Daten

bestimmt werden, da die Informationsstruktur noch nicht genügend

„computergerecht“ ist.

Tabellen, Netze, Baumstrukturen oder ähnliches lassen sich besser im Rechner

abbilden.

Welches Grundelement (Tabelle, Netz, Baum) verwendet wird, bestimmt das

Datenbank-Verwaltungssystem. Entscheidet man sich für ein bestimmtes DBVS,

so ist damit auch das Datenmodell vorgegeben, da ein DBMS/DBVS i.d.R. nur

ein Datenmodell zulässt.

Das verwendete Datenmodell klassifiziert somit das Datenbanksystem und man

spricht deswegen auch häufig von „Netzwerkdatenbanken“ oder „relationalen

Datenbanken“.

Das Datenmodell dient also dazu, die Informationsstruktur auf ein bestimmtes

Datenbanksystem zugeschnitten zu beschreiben.

13

III. Schritte des Datenbankentwurfs

Die Organisation der Daten in einer Datenbank muss formal beschrieben werden.

Der Weg bis dorthin kann in mehrere Schritte untergliedert werden:

Informationsbedarfsanalyse:

● Feststellen, welche Informationen relevant sind

● Herausfinden der zu realisierenden Funktionen

● Identifikation der zu unterstützenden Aufgaben und der betroffenen Orgeinh.

● Ermittlung der Personen, die für die Präzisierung und Realisierung der

betreffenden Aufgabenlösung relevante Informationen liefern können

● Anforderungssammlung bei den Informationslieferanten

● Filterung der gesammelten Informationen

● Klassifikation der gesammelten Informationen

konzeptioneller Entwurf:

● Vermeidung von Unvollständigkeiten und Inkonsistenzen

● Vereinfachung der Weiterverarbeitung

● Entwurfsmethoden

formal (Normalisierung)

[entwickelt im Zusammenhang mit dem Relationsmodell]

- analytisch: Zusammenstellungen von Datenfeldern (gewonnen aus

Formularen und Übersichten) werden durch fortgesetzte Aufspaltung

(Analyse) zerlegt, bis die gewünschte Normalform erreicht ist.

- synthetisch :ausgehend von Datenfeldern und deren funktionaler

Abhängigkeiten werden normalisierte Relationen zusammengesetzt

semantisch [nicht an eine bestimmte Datenbankstruktur bezogen ]

Objekt-Beziehungsmodell: ein Modell der Realität, bei dem Bedeutung und

Zusammenhänge der Daten erkennbar bleiben

14

Normalisierung

● Die Normalisierung ist eine formale Methode zur Gewinnung zweckmäßiger

Relationen

Hauptziele der Normalisierung sind:

◙ Analyse von Abhängigkeiten

◙ Beseitigung von Redundanzen (und somit möglichen Inkonsistenzen)

◙ Erleichterung der Datenbankoperationen Ändern, Einfügen und Löschen

●

Durch Zerlegung wird eine mit Redundanz behaftete Ausgangsrelation

schrittweise in kleinere Tabellen zerlegt

● Die Eigenschaften, welche die Zielrelation besitzen sollen, werden durch die

Normalformen beschrieben

●

Die Zerlegung muss so erfolgen, dass durch Verbund wieder die

ursprüngliche Relation zu erhalten ist;

außerdem müssen die Abhängigkeiten der Attribute erhalten bleiben

● Das Normalisieren kann zu kleinen und kleinsten Tabellen führen, weswegen

relationale Datenbanksysteme bei der Wiedergewinnung von Information

üblicherweise langsamer sind als z.B. hierarchische DBS

● Man unterscheidet heute sieben Normalformen. Ein guter Entwurf sollte auf

jeden Fall bis zur 3NF durchgeführt werden

Streng relationale Datenbanksysteme

zweidimensionale Tabellen.

verarbeiten

nur

flache,

d.h.

Alle Attribute müssen also elementar sein. Daraus ergibt sich die Definition der

ersten Normalform.

15

Erste Normalform (1NF)

Definition: Eine Relation ist in erster Normalform (1NF), wenn jedes Attribut

elementar aus der Sicht des Datenbanksystems ist und die Tabelle eine feste

Breite hat. (In einer 1NF-Relation kann es also z.B. keine vektor-, matrix-, listenoder mengenwertigen Attribute geben. Es gibt keine Wiederholungen)

Aus der unnormalisierten Tabelle entsteht eine 1NF-Relation, indem durch

Einführen von Redundanz jedes Attribut eines Tupels der Tabelle einen Wert

zugewiesen bekommt und ein Primärschlüssel zur eindeutigen Identifizierung

jedes Tupels definiert wird

1NF-Relation: BESTELLUNG(Lief_Nr, Lief_Name, Best_Nr, Best_Dat,

Best_Pos, Art_Nr, Liefertermin)

Probleme bei redundanten Tabellen (Mutationsanomalien)

Änderungsanomalien

Ändert ein Lieferant seinen Firmennamen, so muss er in allen Tupeln verändert

werden, in denen er vorkommt.

Löschanomalien

Werden alle Zeilen mit Bestellungen bei einem bestimmten Lieferanten gelöscht,

geht gleichzeitig die Information über den Lieferanten selbst verloren.

Einfügeanomalien

Solange ein Lieferant keine Bestellung entgegengenommen hat, ist er nicht in der

Tabelle gespeichert.

Funktionale Abhängigkeit

Die Normalisierung beginnt mit der Untersuchung der Abhängigkeiten zwischen

den Attributen einer Relation. Man unterscheidet im Wesentlichen funktionale

und mehrwertige Abhängigkeiten.

Definition: B heißt funktional abhängig von A (geschrieben: A→B), wenn in

jedem Tupel, in dem A vorkommt, derselbe Wert für B existiert.

Die funktionale Abhängigkeit B von A verlangt somit, dass jeder Wert von A

eindeutig einen Wert von B bestimmt. Da alle Id-Schlüssel die Eigenschaft

haben, dass die Nichtschlüsselattribute eindeutig vom Schlüssel abhängig sind,

gilt somit allgemein für einen Id-Schlüssel S und für ein beliebiges Attribut B

einer bestimmten Tabelle die funktionale Abhängigkeit S -> B.

16

Definition des Primärschlüssels

Für einen Primärschlüssel gelten folgende Forderungen:

● Jedes Nicht-Schlüssel-Attribut ist vom Schlüssel funktional abhängig

(garantiert eindeutige Identifizierung)

● Bei Verbundschlüsseln ist kein Schlüsselattribut von den übrigen

Schlüsselattributen abhängig

Volle funktionale Abhängigkeit (bei Verbundschlüsseln erforderlich)

Definition: B heißt voll funktional abhängig von A (geschrieben A B), wenn

B von allen Elementen von A abhängt und nicht nur von einem Teil von ihnen.

Die Betrachtung der 1NF-Relation zeigt folgende Abhängigkeiten:

Lief_Nr

Lief_Name

Best-Nr ist die Determinante

für Lief-Nr, Lief-Name und

Best-Dat

(nicht voll funktional

abhängig)

Best_Nr

Best_Dat

Best_Pos

Best-Nr und Best-Pos

bilden die

Determinante für

Art-Nr und

Liefertermin

Art_Nr

Liefertermin

17

Zweite Normalform (2NF)

Definition: Eine Relation ist in zweiter Normalform, wenn sie in 1NF ist und

jedes Nicht-Schlüssel-Attribut vom gesamten Schlüssel abhängt

(volle funktionale Abhängigkeit)

Anmerkung: Dies gilt trivialerweise für alle 1NF-Relationen deren Schlüssel nur

aus einem Attribut besteht.

1NF-Relationen können gewöhnlich durch Spaltung in 2NF-Relationen überführt

werden.

Zerlegungsregel: Alle Attribute, die von einem Teil des Schlüssels abhängen,

werden aus der ursprünglichen Relation herausgelöst und bilden eine neue

Relation.

Diese erhält als Schlüssel den Teil des Verbundschlüssels, von dem ihre Attribute

voll funktional abhängig sind.

2-NF-Relationen:

BESTELLUNG (Best_Nr, Lief_Nr, Lief_Name, Best_Dat)

BESTELLPOSITION (Best_Nr, Best_Pos, Art_Nr, Liefertermin)

18

Indirekte (transitive) Abhängigkeit

Definition: C ist von A transitiv abhängig, wenn es eine zwischengeschaltete

Attributmenge B gibt, so dass gilt:

A → C und A → B und B → C

Anschaulich:

In der Menge der Nicht-Schlüssel-Attribute darf es nicht selbst noch einmal

funktionale Abhängigkeiten geben.

In unserem Beispiel ist dies der Fall:

Best-Dat

Best-Nr

Lief-Nr

Lief-Name

Indirekte Abhängigkeit

Indirekte Abhängigkeiten vom Schlüssel können durch Spaltung der Relation

beseitigt werden.

19

Dritte Normalform (3NF)

Definition: Eine Relation ist in dritter Normalform, wenn sie in 2NF ist und kein

Nicht-Schlüssel-Attribut indirekt (transitiv) vom Schlüssel abhängt.

2NF-Relationen können gewöhnlich durch Spaltung in 3NF-Relationen überführt

werden.

Zerlegungsregel: Transitiv vom Schlüssel abhängige Attribute (z.B. Lief-Name)

werden zusammen mit ihrer Nicht-Schlüssel-Determinante (hier: Lief-Nr)

herausgelöst.

Die Determinante (hier: Lief-Nr) wird zum Schlüssel in der herausgelösten

Relation.

In der Ausgangsrelation verbleibt die Determinante (hier: Lief-Nr) als

Fremdschlüssel.

Da keine weiteren Zerlegungen erforderlich sind, können die Relationen mit

endgültigen Namen versehen werden.

3NF-Relationen:

BESTELLUNG (Best_Nr, Lief_Nr, Best_Dat)

BESTELLPOSITION (Best_Nr, Best_Pos, Art_Nr, Liefertermin)

LIEFERANT (Lief_Nr, Lief_Name)

20

Übungen:

1. Attribute:

Ein Informationssystem soll u.a. die folgenden Objektarten enthalten:

● Personal

● Teil

● Lieferant

● Eingangsrechnung

● Eingangsrechnungsposition

Stellen Sie für jede Objektart vier relevante Merkmale zusammen und wählen Sie

einen (natürlichen oder künstlichen) Schlüssel.

2. Objekt-Beziehungsdiagramm

Zeichnen Sie für die Objektarten Teil, Lieferant, Eingangsrechnung und

Eingangsrechnungs-Position ein Objekt-Beziehungs-Diagramm.

Entität E1

Beziehung

Entität E2

3. Umsetzung einer Beschreibung in das OBM

In einer Projekt-DB sollen Daten über Bearbeiter, Projekte und die Zuständigkeit

der Bearbeiter für bestimmte Projekte gespeichert werden. Zur Organisation seien

folgende Angaben gemacht:

Für ein Projekt ist nur ein Bearbeiter zuständig, ein Bearbeiter kann aber für

mehrere Projekte zuständig sein. Jeweils ein anderer Bearbeiter ist als Vertreter

bestimmt, der bei Abwesenheit des zuständigen Bearbeiters einspringt.

21

4. Umsetzung einer Beschreibung in das OBM

Werkstattmitarbeiter einer Standortverwaltung werden zur Reparatur von

Maschinen in allen Liegenschaften des Verwaltungsbereichs eingesetzt. Für

einen Maschinentyp ist jeweils ein bestimmter Reparateur zuständig. Jeder

Maschinentyp kann in allen Liegenschaften vorkommen.

Entwerfen Sie ein Objekt-Beziehungs-Modell, das folgende Informationen

darstellen soll:

● Zuständigkeit der Mitarbeiter für bestimmte Maschinentypen

● Vorhandensein von Maschinen in den Liegenschaften

● Arbeitseinsätze, die die einzelnen Reparateure in den einzelnen

Liegenschaften an den einzelnen Maschinen geleistet haben.

● Zugehörigkeit der einzelnen Maschinen zu Maschinentypen.

22

5. Wohnungsvermittlung

Eine Agentur vermittelt Wohnungen.

Um Kundenwünsche gezielt beantworten zu können, werden Mietobjekte mit

gemeinsamen Merkmalen in Kategorien zusammengefasst und dort pauschal

beschrieben (z.B.: Mehrfamilienhaus im Stadtzentrum, Einfamilienhaus in Vorort

mit Straßenbahnanschluss, …).

Von den einzelnen Gebäuden sind die Adresse und der Zustand der Bausubstanz

von Interesse.

Für jede Wohnung sind Informationen über die Miete, die Höhe einer möglichen

Kaution und bis wann sie belegt sind, zu speichern. Darüber hinaus sind Angaben

über die Räume, samt Größe und Ausstattung zu machen.

Kunden der Agentur werden mit allen erforderlichen Daten gespeichert. Ein

Kunde kann beliebig viele Wohnungsanfragen (Aufträge) stellen. Jeder Auftrag

bezieht sich aber auf einen ganz bestimmten Wohnungstyp.

Ein Auftrag wird von einem ganz bestimmten Mitarbeiter bearbeitet und

resultiert schließlich in einem Vermittlungsangebot, das eine beliebige Anzahl

von Wohnungen enthalten kann.

1. Ordnen Sie die folgenden Attribute so, daß ein Eindruck von den möglichen

Objektarten (Entitytypen) entsteht. Kategorie, Telefon, Kaution, Name, gültig

bis, Geb_Nr, PLZ, Zustand, Wohn_Nr, Miete, Beschreibung, Eigentümer,

Verm_Prov, belegt_bis, Raum_Art, Größe, Ausstattung, Kd_Nr, Baujahr,

Anschrift, Auftr_Nr, Straße, Datum, Bearbeiter, Angeb_Nr, Ort, Angeb_Datum.

2.

Kennzeichnen Sie den jeweiligen Primärschlüssel.

3.

Erstellen Sie ein Entity-Relationship-Diagramm.

4.

Übertragen Sie das E-R-Diagramm in das Relationenmodell, d.h.

a) zerlegen Sie ggf. komplexe Objekte in primitive Objekte

b) überführen Sie n:m-Beziehungen in eigene Tabellen

c) ergänzen Sie ggf. erforderliche Fremdschlüssel.

23

6. Normalisieren

Gegeben sei die unnormalisierte Tabelle PRÜFUNGSGESCHEHEN

Prü- Fach Prüfer Matr.- Name Geb.- Adres- Fachbe- Fachbe- Dekan Note

fungsNr.

Tag

se

reichs- reichsNr.

Nr.

name

3

SP Hoff 123 Huber 011068 xx

20

E-Tech Holst 3

4

5

BS

Carl

RO Manz

456

Maier 210869

yy

20

E-Tech Holst

2

123

Huber 011068

xx

20

E-Tech Holst

2

456

Maier 210869

yy

20

E-Tech Holst

1

123

Huber 011068

xx

20

E-Tech Holst

2

789

Bauer 130568

zz

19

Inform Abel

5

a) Entwerfen Sie auf der Basis dieser unnormalisierten Relation eine flache, also

zweidimensionale, Tabelle.

b) Kennzeichnen Sie in Form einer Skizze die funktionalen Abhängigkeiten.

c) Bestimmen Sie einen Schlüssel für die 1NF-Relation.

d) Zerlegen Sie die Relation weiter, so dass die daraus entstehenden Relationen

in 2NF sind. Wie lautet die Zerlegungsregel?

e) Prüfen Sie, ob bzw. welche der Relationen sich bereits in 3NF befinden. Falls

erforderlich zerlegen Sie weiter, bis sich alle Relationen in 3NF befinden. Wie

lautet die Zerlegungsregel?

f) Erstellen Sie das Objekt-Beziehungs-Diagramm, das diesem logischen

Schema entspricht.

24

Mehrbenutzerbetrieb (vgl. Meier, Andreas: Relationale Datenbanken, Springer Verlag)

Der Begriff der Transaktion

Die Integrität der Daten zu gewährleisten ist eine der wichtigsten Forderungen

aus der Sicht der Datenbankanwender. Die Transaktionenverwaltung eines

Datenbanksystems dient dazu, mehreren Benutzern ein konfliktfreies Arbeiten zu

ermöglichen. Dabei dürfen Änderungen in der Datenbank nach außen erst

sichtbar werden, wenn die von den Benutzern definierten Integritätsbedingungen

alle respektiert sind.

Unter dem Begriff der Transaktion (transaction) versteht man an Integritätsregeln

gebundene Datenbankoperationen, die Datenbankzustände konsistenzerhaltend

nachführen. Präziser ausgedrückt, eine Transaktion ist eine Folge von

Operationen, die atomar, konsistent, isoliert und dauerhaft sein muss:

Atomarität gehorcht dem Alles-oder-Nichts-Prinzip

Eine Transaktion wird entweder komplett durchgeführt, oder sie hinterlässt keine

Spuren ihrer Wirkung auf der Datenbank. Die von einzelnen Operationen

erzeugten Zwischenzustände einer bestimmten Transaktion sind für die übrigen

konkurrierenden Transaktionen nicht spürbar. In diesem Sinne bildet die

Transaktion eine Einheit für die Rücksetzbarkeit nicht abgeschlossener

Transaktionen.

Konsistenz bedeutet Widerspruchsfreiheit der Daten

Während der Transaktion mögen zwar einzelne Konsistenzbedingungen

zeitweise verletzt, bei Transaktionsende müssen jedoch alle wieder erfüllt sein.

Eine Transaktion bewirkt also die Überführung einer Datenbank von einem

konsistenten Zustand in einen anderen und garantiert die Widerspruchsfreiheit

der Daten. Sie wird als Einheit zur Konsistenzerhaltung aufgefasst.

Isolation schützt vor Seiteneffekten

Das Prinzip der Isolation verlangt, dass gleichzeitig ablaufende Transaktionen

dieselben Resultate wie im Falle einer Einbenutzerumgebung erzeugen müssen.

Falls einzelne Transaktionen isoliert von parallel ablaufenden erscheinen, bleiben

diese vor ungewollten Seiteneffekten geschützt. Die Transaktion gilt damit als

Einheit für Serialisierbarkeit.

25

Dauerhaftigkeit setzt Rekonstruierbarkeit voraus

Datenbankzustände müssen so lange gültig und erhalten bleiben, bis sie von

Transaktionen verändert werden. Bei Programmierfehlern, Systemabbrüchen

oder Fehlern auf externen Speichermedien garantiert die Dauerhaftigkeit die

Wirkung einer korrekt abgeschlossenen Transaktion. Von den Wiederanlauf- und

Wiederherstellungsverfahren von Datenbanken her gesehen kann jede

Transaktion als Recovery-Einheit aufgefasst werden.

Die vier Begriffe Atomarität (Atomicity), Konsistenz (Consistency), Isolation

(Isolation) und Dauerhaftigkeit (Durability) beschreiben das so genannte ACIDPrinzip einer Transaktion. Dieses ist für Datenbanksysteme grundlegend und

garantiert jedem Anwender, konsistente Datenbankzustände in ebensolche

überführen zu können. Zwischenzeitlich inkonsistente Zustände bleiben nach

außen unsichtbar und werden im Fehlerfall rückgängig gemacht.

Um eine Folge von Operationen als Transaktion zu deklarieren, muss der

Anwender die Datenbankoperationen durch ein BEGIN_OF_TRANSACTION

und durch ein END_OF_TRANSACTION kennzeichnen. Start und Ende einer

Transaktion signalisieren dem Datenbanksystem, welche Operationen eine

Einheit bilden und durch das ACID-Prinzip geschützt werden müssen.

Serialisierbarkeit

Bei der Beschreibung von Betriebssystemen und Programmiersprachen kommt

der Koordination (Synchronisation) aktiver Prozesse und dem wechselseitigen

Ausschluss konkurrierender Prozesse eine große Bedeutung zu. Auch bei

Datenbanksystemen müssen konkurrierende Zugriffe auf dieselben Datenobjekte

serialisiert werden, da die einzelnen Datenbankanwender unabhängig

voneinander arbeiten möchten.

26

Prinzip der Serialisierbarkeit

Ein System gleichzeitig ablaufender Transaktionen heißt korrekt synchronisiert,

wenn es eine serielle Ausführung gibt, die denselben Datenbankzustand erzeugt.

Bei parallel ablaufenden Transaktionen garantiert das Prinzip der

Serialisierbarkeit, dass die Resultate auf den Datenbanken identisch sind,

gleichgültig ob die Transaktionen streng nacheinander ausgeführt worden sind

oder nicht. Um Bedingungen zur Serialisierbarkeit festlegen zu können, gilt bei

den einzelnen Transaktionen unser Augenmerk den READ- und WRITEOperationen, die das Lesen und Schreiben von Tupeln oder Datensätzen auf der

Datenbank bewerkstelligen.

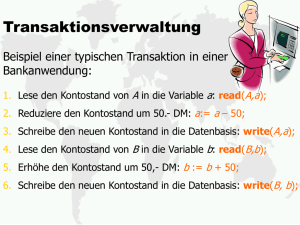

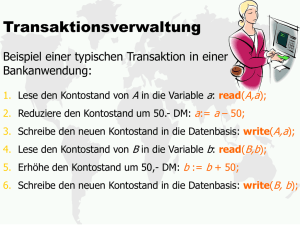

Das klassische Beispiel zur Illustration konkurrierender Transaktion stammt aus

dem Bankbereich. Bei Buchungstransaktionen lautet die grundlegende

Integritätsbedingung, dass Kontobelastungen und –gutschriften sich gegenseitig

ausgleichen müssen. Die Abbildung 1 zeigt zwei parallel ablaufende

Buchungstransaktionen mit ihren READ- und WRITE-Operationen in zeitlicher

Abfolge. Jede Buchungstransaktion verändert für sich betrachtet die

Gesamtsumme der Bestände der Konten a, b und c nicht. So schreibt die

Transaktion TRX_1 dem Konto a 100 Währungseinheiten gut und belastet

gleichzeitig das Gegenkonto b mit 100 Währungseinheiten. Entsprechendes gilt

für die Buchungstransaktion TRX_2 mit dem Konto b und dem Gegenkonto c für

den Betrag von 200 Währungseinheiten. Beide Buchungstransaktionen erfüllen

somit die Integritätsbedingung der Buchführung, da sich die Salden zu Null

aufheben.

Bei der gleichzeitigen Ausführung der beiden Buchungstransaktionen hingegen

entsteht ein Konflikt: Die Transaktion TRX_1 übersieht die von TRX_2

vorgenommene Gutschrift2 b:=b+200, da diese Wertveränderung nicht sofort

zurück geschrieben wird, und liest im Konto b einen „falschen“ Wert. Nach

erfolgreichem Abschluss der beiden Buchungstransaktionen enthält das Konto a

den ursprünglichen Wert plus 100 Einheiten (a+100), b hat sich um 100

Einheiten verringert (b-100) und c ist um 200 Einheiten gekürzt worden (c-200).

Die Summe der Belastungen und Gutschriften ist nicht konstant geblieben, und

die Integritätsbedingung ist verletzt, da im Konto b der Wert b+200 von der

Transaktion TRX_1 übersehen statt verrechnet worden ist.

27

BEGIN_OF_TRX_1

BEGIN_OF_TRX_2

READ (a)

READ (b)

a:= a + 100

WRITE (a)

b:= b + 200

READ (b)

WRITE (b)

b:= b - 100

READ (c)

WRITE (b)

c:= c – 200

WRITE (c)

END_OF_TRX_2

END_OF_TRX_1

ZEIT

Abb. 1 Konfliktträchtige Buchungstransaktionen

Wie sind nun Konfliktsituationen zu erkennen? Aus der Menge aller

Transaktionen führt der Weg dieser Untersuchung jeweils über diejenigen

READ- und WRITE-Operationen, die sich auf ein bestimmtes Objekt, d.h. einen

einzelnen Datenwert, einen Datensatz, eine Tabelle oder im Extremfall sogar eine

ganze Datenbank beziehen. Von der Granularität (der relativen Größe) dieser

Objekte hängt es nämlich ab, wie gut die heraus gepflückten Transaktionen

parallelisiert werden können. Je gröber die Granularität des Objektes gewählt

wird, desto kleiner wird der Grad der Parallelisierung von Transaktionen und

umgekehrt. Die objektwirksamen READ- und WRITE-Operationen aus

unterschiedlichen Transaktionen werden deshalb im so genannten Logbuch

(log) des Objektes x, im LOG(x), festgehalten. Das Logbuch LOG(x) eines

bestimmten Objektes x listet in zeitlicher Abfolge alle READ- und WRITEOperationen auf, die auf das Objekt x zugreifen.

Für das Beispiel der parallelen Buchungstransaktionen TRX_1 und TRX_2

wählen wir die einzelnen Konten a, b und c als Objektgrößen. Wie in Abb. 2

dargestellt, erhält das Logbuch für das Objekt b beispielsweise vier Einträge (vgl.

dazu obige Abb.). Zuerst liest Transaktion TRX_2 den Datenwert b, anschließend

liest TRX_1 denselben Wert, noch bevor die Transaktion TRX_2 den

veränderten Datenwert b zurück schreibt. Den letzten Eintrag ins Logbuch

verursacht die Transaktion TRX_1, die mit ihrem veränderten Wert b jenen der

Transaktion TRX_2 in der Datenbank überschreibt.

28

Eine Auswertung der Logbücher erlaubt uns nun auf einfache Weise, Konflikte

bei konkurrierenden Transaktionen zu analysieren. Der so genannte

Präzedenzgraph (precedence graph) stellt die Transaktionen als Knoten und die

möglichen READ_WRITE oder WRITE_WRITE_Konflikte durch gerichtete

Kanten (gebogene Pfeile) dar. Bezogen auf ein bestimmtes Objekt kann nämlich

ein auf ein READ oder WRITE folgendes WRITE zu einem Konflikt führen.

Hingegen gilt allgemein, dass mehrmaliges Lesen nicht konfliktträchtig ist. Aus

diesem Grunde hält der Präzedenzgraph keine READ_READ-Kanten fest.

Logbuch

Präzedenzgraph für

Datenwert b

TRX_2

LOG (b)

TRX_2: READ

TRX_1: READ

READ_WRITEKante

WRITE_

WRITEKante

TRX_2:WRITE

TRX_1

TRX_1: WRITE

READ_WRITE-Kante: auf ”TRX_1: READ” folgt “TRX_2: WRITE”

WRITE_WRITE-Kante: auf “TRX_2: WRITE” folgt “TRX_1: WRITE”

Abb. 2 Auswertung des Logbuches durch den Präzedenzgraphen

Die Abbildung zeigt für die beiden Buchungstransaktionen TRX_1 und TRX_2

neben dem Logbuch des Objektes b auch den zugehörigen Präzedenzgraphen.

Gehen wir vom Knoten TRX_1 aus, so folgt auf ein READ des Objektes b ein

WRITE desselben durch Transaktion TRX_2, dargestellt durch eine gerichtete

Kante vom Knoten TRX_1 zum Knoten TRX_2. Vom Knoten TRX_2 aus

erhalten wir gemäß Logbuch eine WRITE_WRITE-Kante zum Knoten TRX_1,

da auf ein WRITE von TRX_2 ein weiteres WRITE desselben Objektes b von

TRX_1 folgt. Der Präzedenzgraph ist also zyklisch oder kreisförmig, da von

einem beliebigen Knoten ausgehend ein gerichteter Weg existiert, der zum

Ursprung zurückführt. Diese zyklische Abhängigkeit zwischen den beiden

Transaktionen TRX_1 und TRX_2 zeigt klar, dass sie nicht serialisierbar sind.

29

Serialisierbarkeitskriterium

Eine Menge von Transaktionen ist serialisierbar, wenn die zugehörigen

Präzedenzgraphen keine Zyklen aufweisen.

Das Serialisierbarkeitskriterium besagt, dass die verschiedenen Transaktionen in

einer Mehrbenutzungsumgebung dieselben Resultate liefern wie in einer

Einbenutzerumgebung. Zur Gewährleistung der Serialisierbarkeit verhindern

pessimistische Verfahren von vornherein, dass überhaupt Konflikte bei parallel

ablaufenden Transaktionen entstehen können. Optimistische Verfahren nehmen

Konflikte in Kauf, beheben diese jedoch durch Zurücksetzen der konfliktträchtigen Transaktionen im nachhinein.

Pessimistische Verfahren

Eine Transaktion kann sich gegenüber anderen absichern, indem sie durch

Sperren die zu lesenden oder zu verändernden Objekte vor weiteren Zugriffen

schützt. Exklusive Sperren (exclusive locks) sind solche, die ein bestimmtes

Objekt ausschließlich von einer Transaktion bearbeiten und die übrigen

konkurrierenden Transaktionen abweisen oder warten lassen. Sind solche Sperren

gesetzt, müssen die übrigen Transaktionen warten, bis die entsprechenden

Objekte wieder freigegeben sind.

In einem Sperrprotokoll (locking protocol) wird festgehalten, auf welche Art und

Weise Sperren verhängt bzw. aufgehoben werden. Falls Sperren zu früh oder

leichtsinnig zurückgegeben werden, können nicht serialisierbare Abläufe

entstehen. Auch muss verhindert werden, dass mehrere Transaktionen sich

gegenseitig blockieren und eine so genannte Verklemmung oder Blockierung

(„Deadlock“) heraufbeschwören.

Für das exklusive Sperren von Objekten sind die beiden Operationen LOCK und

UNLOCK notwendig.

Grundsätzlich muss jedes Objekt gesperrt werden, bevor eine Transaktion darauf

zugreift. Falls ein Objekt x durch eine Sperre LOCK(x) geschützt ist, kann dieses

von keiner anderen Transaktion gelesen oder verändert werden. Erst nach

Aufheben der Sperre für Objekt x durch UNLOCK(x) kann eine andere

Transaktion erneut eine Sperre erwirken.

Normalerweise unterliegen Sperren einem wohldefinierten Protokoll und können

nicht beliebig angefordert und zurückgegeben werden:

30

Zweiphasen-Sperrprotokoll

Das Zweiphasen-Sperrprotokoll (two-phase locking protocol) untersagt einer

Transaktion, nach dem ersten UNLOCK (Entsperren) ein weiteres LOCK

(Sperren) zu verlangen.

Mit Hilfe dieses Sperrprotokolls läuft eine Transaktion immer in zwei Phasen ab:

In der Wachstumsphase werden sämtliche Sperren angefordert und errichtet, in

der Schrumpfungsphase werden die Sperren sukzessive wieder freigegeben. Bei

einer Transaktion mit Zweiphasen-Sperrprotokoll dürfen also innerhalb der

Wachstumsphase nur LOCKs nach und nach oder alle auf einmal gesetzt, jedoch

nie freigegeben werden. Erst in der Schrumpfungsphase können UNLOCKs

stufenweise oder gesamthaft am Ende der Transaktion wieder ausgegeben

werden.

Das Zweiphasen-Sperrprotokoll verbietet somit ein Durchmischen von Errichten

und Freigeben von Sperren.

BEGIN_OF_TRX_1

LOCK (a)

READ (a)

a:=a+100

WRITE (a)

Sperren

LOCK (b)

Entsperren

UNLOCK (a)

LOCK (b)

READ (b)

UNLOCK (a)

b:= b-100

WRITE (b)

LOCK (a)

UNLOCK (b)

UNLOCK (b)

END_OF_TRX_1

Zeit

Abb. 3 Beispiel für ein Zweiphasen-Sperrprotokoll der Transaktion TRX_1

31

Die voran gegangene Abbildung 3 illustriert für die Buchungstransaktion TRX_1

ein mögliches Zweiphasen-Sperrprotokoll. In der Wachstumsphase wird

nacheinander das Konto a wie das Gegenkonto b gesperrt, bevor beide Konten

sukzessive wieder freigegeben werden. Bei diesem Beispiel wäre auch möglich,

beide Sperren gleich zu Beginn der Transaktion zu verfügen, anstatt sie im

zeitlichen Ablauf nacheinander errichten zu lassen. Analog könnten die beiden

Sperren auch am Ende der Transaktion TRX_1 nicht gestaffelt, sondern

gesamthaft aufgehoben werden.

Da die Wachstumsphase schrittweise für die Objekte a und b Sperren erwirkt, die

Schrumpfungsphase diese schrittweise wieder freigibt, wird der Grad der

Parallelisierung der Transaktion TRX_1 erhöht. Würden nämlich die beiden

Sperren zu Beginn gesetzt und erst am Ende der Transaktion wieder

zurückgegeben, müssten konkurrierende Transaktionen während der gesamten

Verarbeitungszeit von TRX_1 auf die Freigabe der Objekte a und b warten.

Allgemein gilt, dass das Zweiphasen- Sperrprotokoll die Serialisierbarkeit

parallel ablaufender Transaktionen garantiert.

Pessimistische Synchronisation (pessimistic concurrency control)

Jede Menge konkurrierender Transaktionen ist dank Anwendung des

Zweiphasen- Sperrprotokolls serialisierbar.

Aufgrund der strikten Trennung der Wachstums- von der Schrumpfungsphase

lässt sich zeigen, dass das Zweiphasen- Sperrprotokoll zyklische Abhängigkeiten

in sämtlichen Präzedenzgraphen von vornherein verhindert; die konkurrierenden

Transaktionen bleiben konfliktfrei. Für die beiden Buchungstransaktionen

TRX_1 und TRX_2 bedeutet dies, dass sie bei geschickter Organisation von

Sperren und Entsperren parallelisiert werden können, ohne dass die

Integritätsbedingung verletzt wird.

Abbildung 4 untermauert die Behauptung, dass die beiden Transaktionen TRX_1

und TRX_2 konfliktfrei ablaufen können. Dazu werden LOCKs und UNLOCKs

nach den Regeln des Zwei-Phasen-Sperrprotokolls gesetzt. Damit kann

beispielsweise das von TRX_2 gesperrte Konto b erst in der Schrumpfungsphase

wieder freigegeben werden, und TRX_1 muss beim Anfordern der Sperre für b

warten. Sobald TRX_2 das Konto b durch UNLOCK(b) entsperrt, fordert TRX_1

das Konto b an. Diesmal liest die Transaktion den „richtigen“ Wert von b,

nämlich b+200. Die beiden Transaktionen TRX_1 und TRX_2 können somit

parallel ausgeführt werden.

32

Das Zweiphasen-Sperrprotokoll bewirkt im zeitlichen Ablauf von TRX_1 zwar

eine Verzögerung, aber nach Ablauf der beiden Transaktionen bleibt die

Integrität erhalten. Das Konto a hat sich um 100 Einheiten erhöht (a+100), das

Konto b ebenfalls (b+100), und das Konto c wurde um 200 Einheiten reduziert

(c-200). Die Summe der Bestände der einzelnen Konten hat sich somit nicht

verändert.

BEGIN_OF_TRX_1

LOCK (a)

READ (a)

BEGIN_OF_TRX_2

LOCK (b)

READ (b)

a:=a+100

WRITE (a)

LOG (b)

b:=b+200

LOCK (b)

READ (b)

UNLOCK (a)

b:=b-100

WRITE (b)

UNLOCK (b)

END_OF_TRX_1

TRX_2 : READ

WRITE (b)

TRX_2 : WRITE

LOCK (c)

READ (c)

TRX_1 : READ

UNLOCK (b)

TRX_1 : WRITE

c:= c-200

WRITE (c)

UNLOCK ( c)

END_OF_TRX_2

Zeit

Abb. 4 Konfliktfreie Buchungstransaktionen

Der Vergleich des in Abb. 4 gegebenen Logbuches (LOG(b) des Kontos b mit

dem früher diskutierten Logbuch aus Abb. 1 zeigt einen wesentlichen

Unterschied: Je ein Lesen (TRX_2:READ) und ein Schreiben (TRX_2:WRITE)

wird jetzt strikt zuerst durch TRX_2 durchgeführt, bevor TRX_1 die Kontrolle

über das Konto b erhält und ebenfalls lesen (TRX_1:READ) und schreiben

(TRX_1:WRITE) darf. Der zugehörige Präzedenzgraph enthält weder

READ_WRITE noch WRITE_WRITE-Kanten zwischen den Knoten TRX_2 und

TRX_1, er bleibt also zyklenfrei. Die beiden Buchungstransaktionen erfüllen

damit die Integritätsbedingung.

33

Bei vielen DB-Anwendungen verbietet die Forderung nach hoher Parallelität

gleich ganze Datenbanken oder Tabellen als Sperreinheiten zu verwenden. Man

definiert deshalb kleinere Sperrgrößen, wie z.B. einen DB-Ausschnitt, einen

Tabellenteil, ein Tupel oder sogar einen Datenwert. Sperrgrößen werden

vorteilhaft so festgelegt, dass sie bei der Sperrverwaltung hierarchische

Abhängigkeiten zulassen. Sperren wir beispielsweise eine Menge von Tupeln für

eine bestimmte Transaktion, so dürfen während der Sperrzeit die übergeordneten

Sperreinheiten wie Tabelle oder zugehörige DB von keiner anderen Transaktion

in vollem Umfang blockiert werden. Falls ein Objekt mit einer exklusiven Sperre

versehen wird, können mit Hilfe einer Sperrhierarchie die übergeordneten

Objekte automatisch evaluiert und entsprechend gekennzeichnet werden.

Neben Sperrhierarchien sind verschiedene Sperrmodi von Bedeutung. Die

einfachste Klassifizierung von Sperren beruht auf der Unterscheidung von Leseund Schreibsperren. Eine Lesesperre (shared lock) erlaubt einer Transaktion nur

den lesenden Zugriff auf das Objekt. Fordert eine Transaktion hingegen eine

Schreibsperre (exclusive lock) an, dann darf sie lesend und schreibend auf das

Objekt zugreifen.

Ein weiteres pessimistisches Verfahren, das Serialisierbarkeit gewährleistet, ist

die Vergabe von Zeitstempeln, um aufgrund des Alters von Transaktionen streng

geordnet

die

Objektzugriffe

durchführen

zu

können.

Solche

Zeiterfassungsverfahren erlauben, die zeitliche Reihenfolge er einzelnen

Operationen der Transaktionen einzuhalten und damit Konflikte zu vermeiden.

Optimistische Verfahren

Bei optimistischen Verfahren geht man davon aus, dass die Konflikte

konkurrierender Transaktionen selten vorkommen. Man verzichtet von

vornherein auf das Setzen von Sperren, um den Grad der Parallelität zu erhöhen

und die Wartezeiten zu verkürzen. Bevor Transaktionen erfolgreich abschließen,

werden rückwirkend Validierungen durchgeführt.

Transaktionen mit optimist. Synchronisation durchlaufen drei Phasen, nämlich

eine Lese-, eine Validierungs- und eine Schreibphase. Ohne irgendwelche

präventive Sperren zu setzen, werden in der Lesephase alle benötigten Objekte

gelesen und in einem transaktionseigenen Arbeitsbereich gespeichert und

verarbeitet. Nach Abschluss der Verarbeitung werden in der Validierungsphase

die Objekte geprüft, ob die Veränderungen nicht in Konflikt mit anderen

Transaktionen stehen. Ziel dabei ist, die momentan aktiven Transaktionen auf

Konfliktfreiheit zu überprüfen. Behindern sich zwei Transaktionen gegenseitig,

so wird die in der Validierungsphase stehende Transaktion zurückgestellt. Im

Falle einer erfolgreichen Validierung werden durch die Schreibphase die

Änderungen aus dem Arbeitsbereich der Transaktion in die DB eingebracht.

34

READ_SET(TRX_1)

a

b

c

WRITE_SET(TRX_2)

Abb. 5 Serialisierbarkeitsbedingung für Transaktion TRX_1 nicht erfüllt

Mit Hilfe transaktionseigener Arbeitsbereiche wird bei den optimistischen

Verfahren die Parallelität erhöht. Lesende Transaktionen behindern sich

gegenseitig nicht. Erst wenn sie Werte zurück schreiben wollen, ist Vorsicht

geboten. Die Lesephasen verschiedener Transaktionen können deshalb parallel

ablaufen, ohne dass Objekte durch irgendwelche Sperren blockiert sind. Dafür

muss in der Validierungsphase geprüft werden, ob die im Arbeitsbereich

eingelesenen Objekte überhaupt gültig sind, also mit der Wirklichkeit in der

Datenbank noch übereinstimmen.

Der Einfachheit halber wird vorausgesetzt, dass sich die Validierungsphasen

verschiedener Transaktionen keinesfalls überlappen. Hierfür wird der Zeitpunkt

hervorgehoben, zu welchem die Transaktion in die Validierungsphase tritt.

Dadurch lassen sich sowohl die Startzeiten der Validierungsphasen als auch die

Transaktionen selbst zeitlich ordnen. Sobald eine Transaktion in die

Validierungsphase tritt, wird die Serialisierbarkeit geprüft.

Bei optimistischer Synchronisation wird betreffend Serialisierbarkeit wie folgt

vorgegangen: Mit TRX_t sei die zu überprüfende Transaktion, mit TRX_1 bis

TRX_k seien alle parallel zu TRX_t laufenden Transaktionen bezeichnet, die

während der Lesephase von TRX_t bereits validiert haben. Alle übrigen fallen

außer Betracht, da sämtliche Transaktionen streng nach der Eintrittszeit in die

Validierungsphase geordnet sind. Hingegen sind die von TRX_t gelesenen

Objekte zu überprüfen, sie könnten ja in der Zwischenzeit von den kritischen

Transaktionen TRX_1 bis TRX_k bereits verändert worden sein. Wir bezeichnen

die von TRX_t gelesenen Objektmenge mit dem Ausdruck READ_SET(TRX_t)

und die von den übrigen Transaktionen geschriebene Objektmenge mit

WRITE_SET(TRX_1...,TRX_k) und erhalten das folgende

Serialisierbarkeitskriterium:

35

Optimistische Synchronisation (optimistic concurrency control)

Bei optimistischer Synchronisation müssen die Mengen READ_SET(TRX_t) und

WRITE_SET(TRX_1,...TRX_k) disjunkt sein, damit die Transaktion TRX_t

serialisierbar sein kann.

Als Beispiel können wir wiederum die beiden ursprünglichen

Buchungstransaktionen TRX_1 und TRX_2 von Abb. 1 heranziehen und dabei

voraussetzen, dass TRX_2 vor TRX_1 validiert hat. Ist in diesem Fall nun

TRX_1 serialisierbar oder nicht? Um diese Frage zu beantworten, bemerken wir,

(Abb. 5), dass das von TRX_1 gelesene Objekt b von der Transaktion TRX_2

bereits zurück geschrieben worden ist und in der Schreibmenge

WRITE_SET(TRX_2) liegt. Die Lesemenge READ_SET(TRX_1) und die

Schreibmenge WRITE_SET(TRX_2) überlappen sich aber, was das

Prüfkriterium zur Serialisierbarkeit verletzt. Die Buchungstransaktion TRX_1

muss nochmals gestartet werden.

Eine Verbesserung des optimistischen Verfahrens bringt die präventive Garantie

von Disjunktheit der Mengen READ_SET und WRITE_SET. Dabei wird in der

Validierungsphase der Transaktion TRX_t geprüft, ob diese eventuell Objekte

verändert, die bereits von anderen Transaktionen gelesen worden sind. Bei dieser

Prüfvariante bleibt der Validierungsaufwand auf Änderungstransaktionen

beschränkt.

Vermeidung von Verklemmungen

Auf dem Gebiet der Betriebssysteme werden zur Sperrverwaltung Maßnahmen

studiert, um Verklemmungen, d.h. gegenseitige Behinderungen oder

Blockierungen (deadlocks), aufzulösen oder gar zu verhindern. Bei

Datenbanksystemen mit Mehrnutzerbetrieb müssen größere Mengen von

Objekten berücksichtigt werden. Zusätzlich ist von vornherein nicht bekannt,

welche Ausprägungen von Objekten Änderungen erfahren.

36

Verklemmungen entstehen, wenn Transaktionen wechselseitig aufeinander

warten oder wenn zyklische Abhängigkeiten vorliegen. In Abb. 6 sind einige

Transaktionen durch einen so genannten Wartegraphen dargestellt. Die

Transaktion TRX_2 wartet auf den erfolgreichen Abschluss der beiden

Transaktionen TRX_1 und TRX_4. TRX_4 wartet auf TRX_6, TRX_6 wartet

aber wiederum auf TRX_2. Die Transaktion TRX_2 kann somit erst starten oder

weiterarbeiten, wenn die beiden Vorgängertransaktionen erfolgreich enden oder

ihre gesperrten Objekte freigeben.

Um gegenseitige Behinderungen erfassen zu können, hilft ein Algorithmus (WFG

Wait for graph), der Zyklen im Wartegraphen analysiert. Erkennt er Zyklen, so

wird nach Möglichkeit diejenige Transaktion zurückgestellt, die am wenigsten

Veränderungen nach sich zieht und am sparsamsten Systemressourcen

verbraucht. Zu diesem eher aufwendigen Prüfalgorithmus bietet sich die

Alternative der systemmäßigen Festlegung von Transaktionszeiten an. Falls

innerhalb ihrer vorgegebenen Zeitschranke eine Transaktion nicht erfolgreich

beendet werden kann, wird sie automatisch zurückgesetzt und neu gestartet. Auf

einfache Art werden dadurch Verklemmungen erzwungenermaßen aufgelöst oder

ganz vermieden, was vor allem bei verteilten Datenbanken interessant ist.

Zyklus im Wartegraphen

TRX_1

TRX_2

TRX_4

TRX_6

Abb. 6 Verklemmung bei abhängigen Transaktionen

37

Physische Organisation

Exkurs vorab: Zusammenhang: Dateiorganisation und Dateizugriff

Zugriff

Physikalisch

fortlaufend

Logisch

fortlaufend

Wahlfrei,

direkt

Speicherung

Sequenziell

Indiziert,

indexsequenziell

Relativ (gestreut)

Mit direkter oder

Indirekter

Adressierung

++

+-

+-

-

++

+

-

+-

++

Wesentliche Kriterien zur Beurteilung:

1. Speicherplatz

2. Zugriffszeit

3. Behandlung neuer Datensätze

4. Reorganisationsnotwendigkeit

5. Zusammenhang zwischen Ordnungsbegriff und logischer Adresse

38

Physische Datenorganisation bei Datenbanken

In dieser Kurseinheit befassen wir uns mit Mechanismen für die Abspeicherung

von Daten und zur Beschleunigung von Datenbank-Zugriffen. Als Konsequenz

aus dem enormen Unterschied zwischen Zugriffszeiten interner und externer

Speichermedien muss die Datenablage so organisiert werden, dass beim Betrieb

des DBMS möglichst wenige Zugriffe auf die Sekundärspeicher notwendig sind.

Wir haben es also mit einem speziellen Aspekt des Datenbankentwurfs zu tun,

durch den die konzeptuelle Modellierung ergänzt wird durch den Entwurf von

Speicherungsstrukturen und Zugriffspfaden. Bei relationalen Datenbanksystemen

ist die physische Unabhängigkeit weitgehend gewährleistet, so dass hier der

konzeptionelle Entwurf zunächst eigenständig durchgeführt werden kann. Der

Entwurf der Speicherungsstrukturen und Zugriffspfaden erfolgt dann in einem

nachfolgenden Schritt, der insbesondere auch die Möglichkeit des ausgewählten

Datenbanksystems berücksichtigen muss.

Nach dem Aspekt des Entwurfsproblems werden die wichtigsten Verfahren zur

Datenorganisation behandelt. Dabei geht es um die Abbildung der Entities des

konzeptuellen Modells auf interne Datensätze, um Primär-Zugriffspfade, die die

Organisation der Daten auf dem Speicher bestimmen, sowie um SekundärZugriffspfade, die zusätzliche Informationen zum schnellen Auffinden von

gesuchten Datensätzen enthalten. Dies wäre auch Inhalt einer Vorlesung zum

Thema DATENSTRUKTUREN. Im Unterschied zur dortigen Betrachtungsweise

kommt es hier aber vor allem darauf an, die prinzipiellen Möglichkeiten und ihre

Anwendbarkeiten bei typischen Situationen im Datenbankbereich zu beschreiben.

Während die Ausführungen zum Bereich der Datenorganisation unabhängig vom

konkreten Typ des Datenbanksystems gehalten sind, werden hier abschließend

eingehender die in relationalen DBMS angebotenen Möglichkeiten für die

physische Datenorganisation behandelt.

39

Arbeits- und Sekundärspeicher

Die Daten der Datenbank liegen bei praktischen Anwendungen auf

Sekundärspeichern, im allgemeinen Magnetplatten. Die Zugriffszeiten schneller

Platten liegen bei ca. 3-6 msec, während die Zugriffszeiten für Arbeitsspeicher

bei 10-9 -10-8 sec. liegen. Angesichts dieser „Zugriffslücke“ muss ein

wesentliches Ziel der physischen Datenbankorganisation sein, die Anzahl der

Plattenzugriffe klein zu halten, auch wenn dabei Aufwand innerhalb des

Arbeitsspeichers entsteht.

Die physikalischen Zugriffs- und Übertragungseinheiten zwischen

Plattenspeicher und Arbeitspeicher sind Blöcke oder Seiten (pages) fester Länge,

typischerweise 1K bis 4K Bytes (K= 1024). Beim Zugriff auf ein Datenelement

der Datenbank muss das DBMS feststellen, auf welcher Seite des

Sekundärspeichers die Daten liegen; es muss die Übertragung dieser Seite in den

Arbeitsspeicher veranlassen; schließlich muss es aus dieser Seite die

gewünschten Daten herausfinden. Dieser komplizierte Prozess wird von

verschiedenen Softwareschichten übernommen.

Eine wesentliche Rolle kommt in diesem Zusammenhang dem Systempuffer und

seiner Verwaltung zu. Der Systempuffer ist der Speicherbereich im

Hauptspeicher, der die von der Platte übertragenen Seiten aufnimmt. Diese Seiten

können dann vom DBMS direkt manipuliert werden, d.h. das DBMS liest seine

Daten aus dem Systempuffer und schreibt Änderungen in den Systempuffer

hinein.

Die Systempufferverwaltung muss die vom DBMS benötigten Seiten im

Systempuffer zur Verfügung stellen. Ist bei Anforderung einer Seite kein Platz

mehr im Systempuffer vorhanden, so muss die Systempufferverwaltung zunächst

das Rückschreiben der Seite veranlassen. Dabei sollten die häufig benutzten

Seiten nicht ausgelagert werden.

Die Wahl der Größe des Systempuffers sowie der Strategien zur Verwaltung

(Seitenersetzungsstrategie LRU) haben großen Einfluss auf die Leistung des

Gesamtsystems. Die Größe des Systempuffers kann meist als Parameter bei der

Installation des DBMS festgelegt werden. Die erforderliche Größe hängt im

Wesentlichen von der Art der Anwendungsprogramme und davon ab, in welchem

Maße die Anwendungsprogramme parallel arbeiten sollen. Letzteres deshalb,

weil die mit der Datenbank arbeitenden Anwendungsprogramme konkurrierend

auf den Systempuffer zugreifen.

40

Das Entwurfsproblem

Im Sinne des prinzipiellen Aufbaus wird zunächst das konzeptuelle Modell

unabhängig von der konkreten Datenbank erstellt, meist als Entity-RelationshipModell. Danach wird aus dem konzeptuellen Modell das logische Modell

abgeleitet wird, das die Informationen des konzeptuellen Modells mit Hilfe der

Konstrukte des ausgewählten Datenbank-Modells (Netzwerk, Relational)

darstellt.

Soll die Anwendung auf einer relationalen Datenbank realisiert werden, so

enthält das logische Modell die Tabellen, die aus den Entity- und BeziehungsTypen des ER-Modells entstehen. Nach dieser Transformation können nun auch

durch die DDL des ausgewählten relationalen DBMS die entsprechenden

Relationen definiert werden, Daten eingebracht werden und die zugehörigen

Programme und Anfragen ausgeführt werden. Diese Anwendungsprogramme

berücksichtigen also nicht die interne Organisation der Daten, sie werden

realisiert auf der Basis der logischen (Tabellen-) Strukturen. Dies ist eines der

wesentlichen Verdienste der relationalen Datenbank-Technologie: Durch die

deskriptiven Abfragesprachen ist die Anwendungsprogrammierung entkoppelt

von der physischen Abspeicherung der Daten; sie kann sich auf die logische

Struktur der Daten konzentrieren. Dies gilt nicht für hierarchische und NetzwerkSysteme; hier erfolgt der Zugriff auf Daten weitgehend durch Navigation.

Auch wenn sich die Anwendung kaum um die physische Datenorganisation zu

kümmern brauchen, so ist diese Organisation trotzdem wichtig, um eine gute

Performance zu erreichen, d.h. um Anfragen und Änderungsaufträge in

akzeptabler Zeit ausführen zu können. Daher muss der Datenbankadministrator

auf der Basis des logischen Modells und notwendiger statistischer Informationen

über geplante Anwendungen die physische Organisation der Datenbank

festlegen. Dies geschieht in relationalen Systemen, ohne dass der Anwender das

in der Logik seiner Programme merkt. Er wird allerdings schnell feststellen, dass

bei einer geschickten Datenorganisation Anfragen schneller beantwortet werden,

als bei einer ungeschickten Organisation. Die physische Organisation wird im

internen Schema der Datenbank beschrieben.

Kommerzielle DBMS bieten sehr unterschiedliche Möglichkeiten zur Gestaltung

der internen Ebene.

Eine wichtige Frage, die sich ein Datenbank-Administrator stellen muss, ist die

folgende: Was ist die gewünschte Performance für die Datenbank? Dies kann

nicht pauschal gesagt werden, sondern hängt von den Operationen ab, die gegen

die Datenbank ausgeführt werden sollen. In den Begriffen des konzeptuellen

41

Modells muss der Benutzer die folgenden grundsätzlichen Operationen ausführen

können:

1.

2.

3.

4.

Einfügen von Entities oder Beziehungen

Löschen von Entities oder Beziehungen

Verändern von Entities oder Beziehungen

Auswahl (Selektion) von Entities, die eine bestimmte Bedingung erfüllen.

Aus der Sicht des Datenbanksystems bedeutet Selektion lesenden Zugriff auf die

Datenbank; lesender Zugriff wird häufig als Retrieval bezeichnet. Alle Zugriffe

auf die Datenbank, die Änderungen bewirken, werden mit Update umschrieben.

Es ist die Aufgabe des Datenbank-Administrators, die Daten so zu organisieren,

dass die Gesamtheit der Anwendungen möglichst gut unterstützt wird. Dabei ist

sehr sorgfältig zu prüfen, welche Selektionen und welche Beziehungen zwischen

Entities physisch unterstützt werden sollen. Physische Unterstützung einer

Selektion heißt, dass entweder durch die Art der Abspeicherung der Daten

(Primär-Organisation der Daten) oder durch zusätzliche Daten (SekundärOrganisation, etwa Indexe) das Auffinden der gewünschten Entities beschleunigt

wird, so dass z. B. nicht alle Entities eines Typs durchsucht werden müssen, um

ein bestimmtes Entity zu finden.

Beispiel 1

Um alle Angestellten, die in Dortmund wohnen, aufzufinden, müssen wir häufig

alle Angestelltendatensätze durchsuchen. Kommt diese Art der Abfrage häufiger

vor, so können wir das Suchen erheblich beschleunigen, indem wir z. B. alle

Sätze von Angestellten mit Wohnort Dortmund in einer Liste miteinander

verketten, indem wir diese Sätze physisch zusammenhängend speichern oder

aber, indem wir einen geeigneten Index einführen (Indexe werden noch

ausführlich behandelt):

Diejenigen Selektionen und Beziehungen, die auf der Ebene der physischen

Datenorganisation unterstützt werden, bilden die Zugriffspfade der Datenbank.

Je mehr Selektionen wir durch Zugriffspfade unterstützen, desto schneller wird

das natürliche Retrieval. Diesen Gewinn beim Retrieval erkauft man sich jedoch

mit einer Verteuerung des Update: ist z. B. ein Satz in viele Zugriffspfade

eingebunden, so müssen beim Löschen dieses Satzes alle diese Zugriffspfade

verändert werden. Es liegt somit ein Trade-off vor, der beim Entwurf der

Zugriffspfade berücksichtigt werden muss und der es erfordert, sehr genau die

Ziele der Zugriffsoptimierung zu definieren.

42

Die als Entity-Typen und Beziehungstypen beschriebenen Daten werden in der

Datenbank in Form von internen Sätzen (records) realisiert und gespeichert. Die

Sätze müssen auf Seiten des Externspeichers gebildet werden.

Ausgehend vom Konzeptuellen Modell kann man folgende grobe

Entwurfsschritte für die physische Datenorganisation unterscheiden:

1. Abbildung der Entities auf interne Sätze

2. Festlegung der Primär-Organisation der Daten, d.h. Festlegung der Art der

Abspeicherung von Mengen von internen Sätzen , häufig verbunden mit der

Unterstützung der Selektion bzgl. des Primärschlüssels.

3. Einrichtung von sekundären Zugriffspfaden zu internen Sätzen (Unterstützung

der Selektion bzgl. beliebiger Attribute)

Natürlich sind die drei Fragen beim Entwurf einer konkreten Datenorganisation

nicht streng getrennt behandelbar. Außerdem können für Punkt 2 und Punkt 3 in

vielen Fällen die gleichen grundsätzlichen Methoden der Datenorganisation

angewandt werden.

Interne Sätze

Abbildung von Entities auf internen Sätzen

Ebenso wie wir auf der Ebene der Entities von Entity-Typen sprechen, werden

auch auf der internen Ebene Sätze zu Satztypen zusammengefasst. Es gilt nun, die

Entity-Typen der konzeptuellen Ebene auf diese Satztypen der internen Ebene

abzubilden. Der Datenbank-Administrator muss also festlegen, welche Attribute

der konzeptuellen Entity-Typen zu Satztypen des internen Modells

zusammengefasst werden und wie die Sätze dieser Typen realisiert werden.

Interne Sätze werden oft auch physische Sätze genannt.

Der Begriff des Entity legt es nahe, alle Attribute eines Entity auch als Felder

eines Satzes zu definieren. Aus Gründen der Effizienz ist dies aber nicht immer

sinnvoll. Grundsätzlich muss man es sogar zulassen, dass Attribute verschiedener

konzeptueller Entity-Typen in einem Satz zusammengefasst werden.

43

Beispiel 2:

Die Zusammenfassung von Attributen verschiedener Entities in einem internen

Satz ist z. B. dann bei 1:n-Beziehungen angebracht, wenn diese Beziehung eine

schwache Beziehung (ID-Beziehung) ist, d. h. dass die n Entities von dem einen

zugehörigen Entity abhängen. Etwa: Name und Geburtsdatum der Kinder werden

mit den Attributen des Entity-Typs ANGESTELLTER zu einem internen Satztyp

zusammengefasst. In diesem Fall kann man davon ausgehen, dass die

Informationen über die Kinder nur über das Entity ANGESTELLTER

angesprochen werden.

In der gleichen Weise kann es sinnvoll sein, die Attribute eines Entity-Typs in

mehrere Satztypen zu zerlegen: der Entity-Typ ANGESTELLTER besitze die

Attribute ANG-NR, NAME, ANSCHRIFT, FÄHIGKEITEN, BERUFLICHER

WERDEGANG, GEHALT, STEUERKLASSE,.... Regelmäßig benötigt das

Lohnbüro die Attribute ANG_NR, NAME, ANSCHRIFT, GEHALT,

STEUERKLASSE; die restlichen Attribute werden nur sehr selten benötigt. Da

die Werte der selten benötigten Attribute lang sind, ist es nicht sinnvoll, sie bei

jedem Zugriff auf die häufig benötigten Attribute mit in den Arbeitsspeicher zu

übertragen, d. h. es bietet sich an, zwei interne Satztypen ANGEST1 und

ANGEST2 zu bilden.

Übung 1

Überlegen Sie sich zu obigem Beispiel mindestens zwei Möglichkeiten, die

Beziehungen zwischen den beiden Satztypen ANGEST1 mit den häufig

benutzten Attributen und ANGEST2 mit den selten benutzten Attributen zu

realisieren.

Realisierung interner Sätze

Speicherung variabel langer Sätze als Sätze fester Länge

Grundsätzlich ist die Verwaltung variabel langer Sätze aufwendiger als für Sätze

fester Länge. Aus diesem Grund werden in vielen Fällen auch dort interne Sätze

fester Länge verwendet, wo logisch gesehen variabel lange Sätze vorliegen. Dies

ist z. B. dann sinnvoll, wenn die Obergrenze für die Satzlänge bekannt ist, und

wenn diese nahe bei der mittleren Satzlänge liegt.

Angenommen, dass Gasthörer gleichzeitig höchstens 3 Kurse belegen dürfen und

einige sicherlich weniger Kurse belegen, dann erhält man variabel lange Sätze

des Typs

NAME,...,KURS-NR*,

44

wobei * eine Wiederholungsgruppe (Repeating Group) anzeigt, was bedeutet,

dass das Attribut KURS-NR aus mehreren Werten bestehen kann. Diese variabel

langen Sätze wird man dennoch im Allgemeinen als Sätze fester Länge des

folgenden Typs abspeichern:

NAME,...;KURS_NR1,KURS_NR2,KURS_NR3

NAME,....,KURS-NR(3).

oder

KURS-NR(3) heißt wiederum Wiederholungsgruppe. Falls ein Gasthörer weniger

als 3 Kurse belegt, enthalten die entsprechenden Felder so genannte Nullwerte,

die anzeigen, dass kein Wert existiert.

Ist ein solch spezieller Nullwert nicht verfügbar, so muss für jede

Wiederholungsgruppe in den Satz ein Feld eingefügt werden, das angibt, wie

viele Felder der entsprechenden Wiederholungsgruppe besetzt sind.

Eine zweite Art, mit Sätzen fester Länge auszukommen, besteht darin, den

logischen Satz physisch in eine Folge von Sätzen fester Länge zu zerlegen. Diese

physischen Sätze werden miteinander verkettet.

Der Angestelltensatz, der die Namen und Geburtstage der Kinder enthalten soll,

hat logisch gesehen folgendes Format:

NAME, ...,

(KIND, GEBTAG)*

(KIND, GEBTAG*) ist eine Wiederholungsgruppe. Eine brauchbare obere

Grenze für die Kinderzahl ist jetzt nicht gegeben. Man kann jedoch auf feste

Satzlänge zurückgreifen, wenn man die folgenden Satzformate anwendet:

NAME,

KIND,

..., PT

GEBTAG,

PT1

Hierin ist PT ein Zeiger auf einen Satz mit den Feldern KIND, GEBTAG, PT1;

PT1 ist ein Zeiger auf einen Satz vom gleichen Typ. Das ergibt also die

Datenorganisation des Bildes 1.

Die skizzierten Methoden zur Vermeidung variabel langer Sätze auf physischer

Ebene können beliebig kombiniert werden. Etwa können im obigen Beispiel

gewählt werden:

NAME,

....; (KIND,GEBTAG)(2), PT

KIND,

GEBTAG, PT1.

45

In diesem Falle musste auf Sätze vom zweiten Typ nur noch zugegriffen werden,

wenn der Angestellte mehr als zwei Kinder hat.

Bild 1:

Müller

.....

Peter

13.10.53

Susi

10.01.60

Verwaltung von Wiederholungsgruppen durch

eine Folge von Sätzen fester Länge

Direkte Implementierung variabel langer Sätze

Es gibt eine Reihe unterschiedlicher Möglichkeiten, variabel lange Sätze auch als

solche abzuspeichern. Sofern die Zahl der Einzelwerte eines Attributes im Satz

unterschiedlich sein kann, muss auf irgendeine Weise festgehalten werden,

welche Werte zu welchem Attribut gehören (wir gehen von festen Feldlängen

aus). hier nur zwei skizzierte Lösungsmöglichkeiten:

a) Längenangaben: in einem speziellen Feld wird angegeben, wie viel Werte

das Attribut umfasst

3

Steno

Masch

Längenangabe

Bild 2:

Verwaltung variabel langer Sätze durch Satzfelder

46

Engli

b) Zeiger: am Satzanfang wird für jedes Attribut (oder bei entsprechender

Variation des Verfahrens für bestimmte Attribute) ein Zeigerfeld

eingerichtet; jeder Zeiger weist auf das erste Feld des zugehörigen

Attributes, die Zahl der Felder ergibt sich aus der Differenz zum nächsten

Zeigerwert

40

55

....

Steno

Masch Engli

Bild 3: Verwaltung variabel langer Sätze durch Zeiger zum Attribut-Anfang

Adressierung von internen Sätzen

Bevor es in den folgenden Abschnitten ausführlicher um die Zugriffspfade geht,

soll hier kurz auf die darunter liegende Ebene eingegangen werden, nämlich auf

die Abspeicherung und Adressierung der internen Sätze.

Die Übertragung von Daten zwischen Hintergrundspeicher und Hauptspeicher

geschieht in Einheiten einer festen Länge, den Blöcken oder Seiten. Wenn das

DBMS Daten auf die zur Verfügung stehenden Seiten abbilden will, muss es

zunächst diese Seiten identifizieren können. Dies geschieht einfach durch ein

Durchnummerieren aller zur Verfügung stehenden Seiten, die damit eine

eindeutige Seitennummer erhalten.

Die hardwaremäßige Ansteuerung einer Seite B durch das Betriebssystem

geschieht durch die Angabe einer von dem speziellen Speichergerät abhängigen

physischen Adresse, etwa bei plattenähnlichen Speichergeräten durch

(Zylinder# , Spur# , Sektor#).

Die Zuordnung Seitennummer physische Adresse wird dabei vom

Betriebssystem übernommen.

47

Die Aufgabe des DBMS besteht nun darin, die internen Sätze auf die zur

Verfügung stehenden Seiten zu verteilen. Üblicherweise werden alle Sätze eines