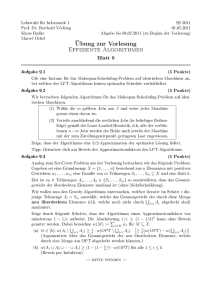

Vorlesungsskript Algorithmische Diskrete Mathematik

Werbung