PDF file - IDB - Universität Bonn

Werbung

Diplomarbeit

Entwurf und Realisierung eines datenbankgestützten Systems

zur Simulation und Überwachung mobiler Objekte auf

Netzwerken

von

Dennis Wegener

Institut für Informatik III

Rheinische Friedrich-Wilhelms-Universität Bonn

Prof. Dr. R. Manthey

31.03.2006

Inhaltsverzeichnis

1 Einführung

1

2 Datenbanken

2

2.1

2.2

2.3

Deduktive Datenbanken

. . . . . . . . . . . . . . . . . . . . . . . . .

2

2.1.1

Einführung

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

2.1.2

Syntax von Datalog . . . . . . . . . . . . . . . . . . . . . . . .

3

2.1.3

Semantik von Datalog

. . . . . . . . . . . . . . . . . . . . . .

8

2.1.4

Änderungspropagierung

. . . . . . . . . . . . . . . . . . . . .

10

MS Access . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

2.2.1

Jet SQL . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

2.2.2

Visual-Basic . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

2.2.3

DAO und ADO . . . . . . . . . . . . . . . . . . . . . . . . . .

12

ODBC und JDBC . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

3 SIMON

15

3.1

Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

3.2

Überwachung von Datenströmen durch kontinuierliche Anfragen . . .

17

3.2.1

Monitoring

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

3.2.2

Datenströme . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

3.2.3

Kontinuierliche Anfragen über Datenströmen . . . . . . . . . .

22

Gesamtarchitektur SIMON . . . . . . . . . . . . . . . . . . . . . . . .

23

3.3

i

ii

Inhaltsverzeichnis

3.4

MOSIM

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

3.5

VISMONET . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

3.6

Monitor

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

3.7

Compiler . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

31

3.7.1

Architektur

31

3.7.2

Beispiel zur Kompilierung

3.7.3

Einbettung des Compilers in MS-Access

3.8

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . .

36

Beipsielszenario . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

37

4 Überwachung von Datenströmen in SIMON

4.1

4.2

4.3

34

39

Klassikation von Datenstrom-Anwendungen . . . . . . . . . . . . . .

39

4.1.1

Klassikationsschema . . . . . . . . . . . . . . . . . . . . . . .

40

4.1.2

SIMON

42

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Ansätze zur Überwachung von Datenströmen in SIMON

. . . . . . .

44

. . . . . . . . . . . . . . . . .

46

4.2.1

Datenbankmanagementsysteme

4.2.2

rule engines

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

47

4.2.3

Datenstrommanagementsysteme . . . . . . . . . . . . . . . . .

48

4.2.4

Fazit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

50

Ein Ansatz zur DBMS-gestützten Analyse von Datenströmen . . . . .

53

4.3.1

Prinzipielle Vorgehensweise

. . . . . . . . . . . . . . . . . . .

53

4.3.2

Architektur

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

4.3.3

Inkrementelle Beantwortung kontinuierlicher Anfragen

. . . .

56

Inhaltsverzeichnis

iii

5 Spezialisierung von SQL-Sichten

62

5.1

Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

62

5.2

Mengen- vs. Multimengensemantik

. . . . . . . . . . . . . . . . . . .

63

5.3

Ansatz mit Mengensemantik . . . . . . . . . . . . . . . . . . . . . . .

64

5.3.1

Delta- und Transitionssichten

. . . . . . . . . . . . . . . . . .

64

5.3.2

Aggregation . . . . . . . . . . . . . . . . . . . . . . . . . . . .

66

Alternativer Ansatz mit Multimengensemantik . . . . . . . . . . . . .

69

5.4.1

Duplikate

. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

70

5.4.2

Eektivitäts- vs Wirksamkeitstest . . . . . . . . . . . . . . . .

70

5.4.3

Delta Regeln

71

5.4.4

Delta-Regeln: Das OR-Problem

5.4.5

Möglichkeiten der Umsetzung

5.4

. . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . .

73

. . . . . . . . . . . . . . . . . .

76

6 SIMON II

78

6.1

Gesamtarchitektur

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

78

6.2

MOSIM II . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

80

6.3

Monitor

86

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3.1

Architektur

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

6.3.2

Inputmanager . . . . . . . . . . . . . . . . . . . . . . . . . . .

87

6.3.3

Compiler . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

90

6.3.4

CQ-Manager

. . . . . . . . . . . . . . . . . . . . . . . . . . .

91

6.4

VISMONET II

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

94

6.5

Schnittstellen

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

98

6.6

Beispiel-Szenario (ICE-Verkehr) . . . . . . . . . . . . . . . . . . . . . 101

7 Zusammenfassung und Ausblick

102

Literaturverzeichnis

103

Anhang

107

Kapitel 1

Einführung

1

Kapitel 2

Datenbanken

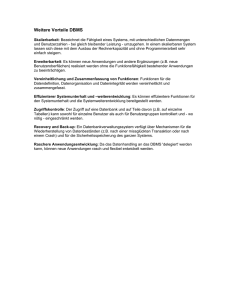

In diesem Kapitel werden die in dieser Arbeit verwendeten Grundlagen hinsichtlich

der Themen deduktive Datenbanken, MS Access sowie der Anbindung von Datenbanken an Anwendungsprogramme vorgestellt. In Abschnitt 2.1 wird eine Einführung in das Thema Deduktive Datenbanken gegeben, die sich im Wesentlichen an

[Man04] und [Pie01] orientiert. Der Ansatz zur datenbankgestützten Überwachung

beruht auf einigen Konzepten deduktiver Datenbanken und wird innerhalb einer

Analysekomponente realisiert. Im Besonderen wird daher auf die deduktive Datenbanksprache Datalog eingegangen, in deren Kontext das der Analysekomponente

zugrundeliegende Prinzip der Änderungspropagierung dargestellt wird. Die Implementierung basiert auf dem relationalen Datenbankmanagementsystem Access von

Microsoft, welches in Abschnitt 2.2 vorgestellt wird. Abschnitt 2.3 beschreibt die

Anbindung von Datenbanken an Anwendungsprogramme, insbesondere hinsichtlich

der objektorientierten Programmiersprache Java, in der die Simulations-, Visualisierungs und Teile der Analysekomponente implementiert sind.

2.1

Deduktive Datenbanken

Im Folgenden wird eine Einführung in das Thema deduktive Datenbanken gegeben und die relationale, deduktive Datenbanksprache Datalog vorgestellt. Obwohl

Datalog weitgehend als Standardsprache der Forschung im Bereich deduktiver Datenbanken gilt, hat sich nur hinsichtlich der Regelsprache ein Quasi-Standard etabliert ([Pie01]). Für die beiden anderen Teilsprachen Datenmanipulation (DML) und

Datendenition (DDL) existieren verschiedene Ansätze. In Abschnitt 2.1.1 werden

Grundbegrie deduktiver Datenbanken eingeführt. Die Abschnitte 2.1.2 und 2.1.3

beschreiben Syntax und Semantik von deduktiven Regeln und Änderungen in Datalog. Abschnitt 2.1.4 befasst sich schlieÿlich mit dem Prinzip der Änderungspropagierung im Kontext von Datalog. Auf eine Einführung in die Datendenitionssprache,

2

2.1

Deduktive Datenbanken

3

die Syntax und Semantik von Anfragen sowie Integritätsbedingungen wird an dieser

Stelle verzichtet und statt dessen auf [Man04] verwiesen.

2.1.1 Einführung

Ein deduktives Datenbanksystem erlaubt zusätzlich zu den üblichen Funktionalitäten eines DBMS die Spezikation, Verwaltung und Anwendung von Sichten und

Integritätsbedingungen ([Man04]). Eine deduktive Datenbank enthält neben explizit gespeicherten Daten (Basisfakten) eine Menge von Regeln. Diese Regeln stellen

zusätzliches anwendungsspezisches Wissen dar und sind unterteilt in deduktive

Regeln (Sichten, views) und normative Regeln (Integritätsbedingungen und Assertions, constraints). Mit Hilfe deduktiver Regeln (Sichtdenitionen) in der Datendenitionssprache (DDL) des verwendeten Datenmodells lassen sich ableitbare

Informationen darstellen. Prinzipieller Aufbau einer solchen deduktiven Regel ist

ein deklarativer Ausdruck der Form Regelkopf

← Regelrumpf ,

wobei der Re-

gelkopf ein Muster für eine Informationseinheit einer ableitbaren Datenmenge und

der Regelrumpf eine denierende Anfrage ist. Der Ausdruck beschreibt eine Menge

impliziter (ableitbarer) Daten, die aus einer Menge expliziter (Basis-)Daten herleitbar ist. Zur Verwaltung und Anwendung der Regeln (Datenherleitung) sowie zur

Konsistenzprüfung werden gererische, anwendungsunbhängige Methoden innerhalb

einer Inferenzkomponente zur Verfügung gestellt.

Generell unterscheidet man zwischen virtueller und materialisierter Darstellung regeldenierter Daten. Bei der virtuellen Darstellung werden die ableitbaren Daten

nicht persistent gespeichert. Sie müssen bei jeder Anfrage erneut temporär erzeugt

werden, d.h. es ndet eine Deduktion bei jeder Anfrage statt. Das System berechnet die Antwortmenge sowie alle zur Herleitung dieser benötigten Daten. Bei der

materialisierten Darstellung werden die Daten einmalig abgeleitet und anschlieÿend

persistent als Fakten abgespeichert. Bei einer Anfrage müssen sie nicht neu abgeleitet

werden. Im Falle von Basisdatenänderungen ist jedoch eine Anpassung der materialisierten Daten notwendig. Bei jeder Änderungsanweisung werden die induzierten

Folgeänderungen hinsichtlich der ableitbaren materialisierten Daten berechnet und

die Daten entsprechend angepasst.

2.1.2 Syntax von Datalog

Die Regelsprache Datalog basiert auf dem relationalen Bereichskalkül (DRC) (vgl.

[KE04]). In Datalog wird eine positionelle Schreibweise der Attribute einer Relation verwendet, wobei die Attribute von Datalog-Relationen nicht benannt werden.

Datalog hat eine mengenorientierte Semantik und nutzt nur einen minimalen Satz

an Operatoren (Konjunktion und Negation). Im weiteren ist mit der Bezeichnung

¬

Datalog immer Datalog mit Negation (Datalog ) gemeint.

4

Kapitel 2.

Eine Datalog-Bereichsvariable ist ein Groÿbuchstabe (z.B.

X ,X1 ,..)

Datenbanken

oder eine mit

einem Groÿbuchstaben beginnende Zeichenreihe. Datalog-Konstanten sind Ziern,

Kleinbuchstaben, Zeichenreihen, die mit einer Zier oder einem Kleinbuchstaben beginnen oder beliebige Zeichenketten in Hochkommata. Ein Datalog-Term

ti

ist eine

Konstante (Grundterm) oder eine Bereichsvariable. Relationsnamen sind Zeichenreihen, die mit einem Kleinbuchstaben beginnen. Die Grundbausteine aller DatalogAusdrücke sind positive und negative Formeln, aus denen Fakten und Regeln bestehen.

Denition 2.1 (atomare Datalog-Formeln)

Eine

atomare

Datalog-Formel

(DB-Atom) ist ein Ausdruck der Form

1.

p(t1 , . . . , tn ), wobei p ein n-stelliges Relationssymbol mit n ≥ 0 ist und t1 , . . . , tn

Terme sind, oder

2.

ti Θtj ,

wobei ti , tj Terme sind und

Θ ∈ {=, 6=, <, >, ≤, ≥}

ein Vergleichsopera-

tor ist.

Gemäÿ Punkt 1 denierte atomare Formeln werden als Literale und gemäÿ Punkt

2 denierte als Vergleichsliterale bezeichnet. Variablenfreie Literale heiÿen Grundliterale. Ein Fakt ist ein positives Grundliteral.

Denition 2.2 (Datalog-Formeln)

Eine Datalog-Formel F ist

1. eine Aussagenlogische Konstante TRUE oder FALSE,

2. ein positives oder negatives Literal L bzw. not L oder

3. eine Konjunktion von Literalen

L1 , . . . , L n

, wobei die

Li

für

1 ≤ i ≤ n positive

oder negative Literale sind.

Eine variablenfreie Datalog-Formel wird als grundinstanziiert bezeichnet.

Denition 2.3 (Ableitungsregel)

Eine Ableitungsregel (Deduktionsregel) ist ein

Ausdruck der Form

H←B [

WITH

help

R1help ← B1 , . . . , Rm

← Bm ]

mit einem DB-Atom H als Kopteral und einer Datalog-Formel B als Regelrumpf.

2.1

Deduktive Datenbanken

5

Eine Ableitungsregel in Datalog kann über eine Hilfsregel verfügen. Die WITH-Liste

help

help

mit den Hilfsrelationen Ri

ist optional (0 ≤ i ≤ m). Ri

← Bi ist eine Hilfsregel

help

mit dem DB-Atom Ri

als Kopteral und einer Datalog-Formel Bi als Regelrumpf.

help

Die Hilfsregeln Ri

besitzen nur einen lokal und temporär begrenzten Gültigkeitsbereich innerhalb der Regelspezikation. Die Hilfsregeln können über keine eigene

WITH-Klausel verfügen (Schachtelungsverbot).

Regelköpfe und Fakten sind positive Literale, Regelrümpfe bestehen aus positiven

und ggf. negativen Literalen. Lokale Variablen sind Variablen, die nur im Rumpf

einer Datalog-Regel vorkommen. Sie gelten zu Beginn des Regelrumpfs als implizit

existenzquantiziert. Die Existenzquantizierung sorgt für Duplikateliminierung in

den abgeleiteten Relationen. Eine wichtige Voraussetzung für eine sinnvolle Semantik von Regeln ist die Forderung nach Bereichsbeschränkung (Sicherheit von Regeln)

([Ull89]).

Denition 2.4 (beschränkte Variable)

ne Variable

1.

Xi

Xi

In einer Regel

H ← L1 , . . . , L n

tritt ei-

beschränkt auf, gdw.

in mindestens einem positiven Rumpiteral

Li

auftritt, das ein DB-Atom

ist,

2.

Xi

Li

in mindestens einem positiven Rumpiteral

Built-In der Form

Xi = Y

ist, und

Y

auftritt, das ein Vergleichs-

entweder eine Konstante ist oder selbst

eine beschränkte Variable oder

3.

Xi

in mindestens einem negativen Rumpiteral

Builtin der Form

Xi 6= Y

ist, und

Y

Li

auftritt, das ein Vergleichs-

entweder eine Konstante ist oder selbst

eine beschränkte Variable.

Denition 2.5 (bereichsbeschränkte Regel)

bereichsbeschränkt (sicher), gdw. jede Variable

Xi

Eine Regel

H ← L1 , . . . , L n

ist

beschränkt ist.

Eine Regel mit Hilfsregeln

H ← L1 , . . . , L n

WITH

Rihelp ← Bi

mit

1≤i≤m

ist bereichsbeschränkt, gdw. die Regel H und jede Hilfsregel

Rihelp

mit

1 ≤ i ≤ m

bereichsbeschränkt sind.

In einer Datenbank liegen nur wahre Fakten gespeichert oder ableitbar vor, somit ist

die Auswertung positiver Literale unproblematisch. Der Auswertung negativer Literale liegt die closed world assumption (CWA) zugrunde, bei der ein Fakt als falsch

angenommen wird, wenn es weder gespeichert noch ableitbar ist. Auf dieser Annahme über vollständiges Wissen basiert das Prinzip des negation as failure (NAF).

6

Kapitel 2.

Datenbanken

Ist für ein negatives Literal das entsprechende positive Fakt nicht in der Datenbank gespeichert und auch nicht durch Regeln ableitbar, wird auf die Wahrheit des

negativen Literals geschlossen. Aus diesem Grund ist für negierte Literale eine zusätzliche Sicherheitsanforderung nötig: Jede Variable, die in einem negierten Literal

vorkommt, muss auch in mindestens einem positiven Literal vorkommen. Aufgrund

der impliziten Existenzquantizierung ist Negation also nur unmittelbar vor Rumpfliteralen zulässig.

Denition 2.6 (Deduktive Datenbank)

D =< F, R >

Eine deduktive Datenbank ist ein Tupel

mit

1. einer endlichen, ggf. leeren Menge

F

von Grundatomen der Basisrelationen

(Basisfakten)

2. und einer endlichen Menge

rel(R)

R

von deduktiven Regeln .

ist die Menge der Relationssymbole. Der sog. Abhängigkeitsgraph stellt die

Beziehungen der Regeln untereinander dar, die beliebig (auch rekursiv) aufeinander aufbauen können. Um eine sinnvolle Ableitung der durch eine Regelmenge

R

beschriebenen abgeleiteten Fakten sowie Propagierung von Folgeänderungen unter

Berücksichtigung von Rekursion und Negation zu gewährleisten, wird eine Schichteneinteilung (Stratikation) der Regelmenge vorgenommen.

Denition 2.7 (Stratikation)

Sei R eine Menge deduktiver Regeln (inkl. lokaler

help

Hilfsregeln Ri

). Eine Stratikation λ bzgl. R ist eine Abbildung λ : rel(R) → N0

der Menge der Relationssymbole rel(R) auf eine Menge von positiven natürlichen

Zahlen. Für alle Relationssymbole

p, q ∈ rel(R)

gilt:

⇔ λ(p) = 0

1.

p

ist eine Basisrelation

2.

p

ist eine abgeleitete Relation

3.

p

hängt positiv von q ab

4.

p

hängt negativ von q ab

⇔ λ(p) ≥ 1

⇔ λ(q) ≤ λ(p)

⇔ λ(q) < λ(p).

Eine deduktive Datenbank heiÿt stratizierbar, wenn mindestens eine solche Stra-

λ von rel(R) induziert eine entsprechende

λR auf der Regelmange R. Dabei ist λR : R→ N0 deniert durch

λR ( p(...) ← ... ) =def λ(p).

tikation existiert. Jede Stratikation

Stratikation

Denition 2.8 (Klassen von Regelmengen, Datenbanken)

duktive DB mit der Menge deduktiver Regeln

R.

Sei

D

eine

de-

2.1

Deduktive Datenbanken

7

1. Die Regelmenge/DB heiÿt positiv, gdw. keine Relationssymbole

p, q ∈ rel(R)

existieren, die negativ voneinander abhängen.

2. Die Regelmenge/DB heiÿt semi-positiv, gdw. negative Abhängigkeiten nur von

Basisrelationen existieren.

3. Die Regelmenge/DB heiÿt hierarchisch (nicht rekursiv), gdw. kein Relationssymbol

p ∈ rel(R)

existiert, das von sich selbst abhängt.

4. Die Regelmenge/DB heiÿt rekursiv, gdw. mindestens ein Relationssymbol

rel(R)

existiert, das von sich selbst abhängt.

5. Die Regelmenge/DB R heiÿt stratizierbar, gdw. kein Relationssymbol

rel(R)

p∈

p ∈

existiert, das von sich selbst negativ abhängt.

Es gibt grundsätzlich drei Arten von Datenbankänderungen: Einfügung, Löschung

und Modikation. Im Folgenden sollen nur Einfügung und Löschung betrachtet werden, eine Modikation lässt sich durch eine Kombination von Einfügung und Löschung simulieren. Einfache Formen von Änderungsanweisungen sind Änderungen

von Fakten (primitive Änderungen). Komplexe Änderungsanweisungen (bedingte

Änderungen) induzieren in Abhängigkeit von einer Bedingung eine Menge von primitiven Änderungen genau einer Basisrelation. Syntaktische Grundbausteine aller

Datalog-Änderungen sind dynamische Literale ([Gri97]). Redundante Änderungen

werden akzeptiert, haben aber keinen Eekt auf den aktuellen Datenbankzustand.

Denition 2.9 (Änderungsanweisung)

Befehl) bzgl. einer deduktiven Datenbank

1. Sind

M, M new , M old

D

Eine

Änderungsanweisung

(DML-

ist induktiv deniert durch:

grundinstanziierte DB-Atome und

{+, −}

Änderungsope-

ratoren, dann sind folgende primitive Änderungsanweisungen spezizierbar:

Einfügung:

Löschung:

2. Sind

+M (t1 , . . . , tn )!

−M (t1 , . . . , tn )!

M, M new , M old

kurz:

kurz:

DB-Atome,

+M

−M

{+, −, ±}

Änderungsoperatoren und

B

eine

Datalog- Formel, dann sind folgende bedingte (komplexe) Änderungsanweisungen spezizierbar:

Einfügung:

Löschung:

+M

−M

WHERE

WHERE

help

B ! [WITH R1help , . . . , Rm

]

help

help

B ! [WITH R1 , . . . , Rm ]

Für Änderungen gelten analog zu den Regeln Sicherheitsanforderungen.

8

Kapitel 2.

Denition 2.10 (bereichsbeschränkte Änderungsanweisung)

Datenbanken

Eine

primiti-

ve Änderungsanweisung ist aufgrund ihrer Grundinstanziierung immer bereichsbeschränkt (sicher). Eine bedingte Änderungsanweisung

+M, −M

mit der Formel

B

im Qualikationsteil ist bereichsbeschränkt (sicher), gdw. die analog denierte Deduktionsregel

M ←B

bereichsbeschränkt ist.

Änderungen können in einer Transaktion zu einer zusammengehörigen Menge zusammengefasst werden. Die Transaktion wird ganz oder gar nicht ausgeführt (Atomarität). Dabei werden die Bedingungen der einzelnen Änderungen komplett über

dem alten Zustand der Datenbank ausgewertet. Das Transaktionskonzept ist mengenorientiert, d.h. es wird angenommen, dass alle Änderungen der Transaktion reihenfolgenunabhängig simultan ausgeführt werden. Eine Transaktion besteht aus einer Menge von primitiven und/oder bedingten Änderungen. Nach Auswertung der

Bedingungen erhält man daraus eine Multimenge von Elementaränderungen. Nach

dem Eliminieren konträrer Änderungen sowie der Duplikate ergibt sich eine Menge

von Elementaränderungen ohne wechselseitige Beziehung (Eekt der Transaktion).

Durch einen Test auf Wirksamkeit hinsichtlich der zu ändernden Relation (ein einzufügendes Fakt darf nicht in der Relation und ein zu löschendes muss in der Relation

enthalten sein) ergibt sich der Netto-Eekt der Transaktion.

Denition 2.11 (Transaktion)

oder bedingten Änderungen

U := {U1 , . . . , Un } von primitiven

Ui ∈ {+U, −U }, (1 ≤ i ≤ n) heiÿt eine Transaktion.

Eine Menge

Änderungen werden nur ausgeführt, wenn sie keine Integritätsbedingung verletzen.

Die Bearbeitung einer Transaktion ndet unter Berücksichtigung der Atomarität

statt, d.h. die Änderungen der Transaktion werden nur ausgeführt, wenn keine dieser

Änderungen eine Integritätsbedingung verletzt.

2.1.3 Semantik von Datalog

Die Semantik einer deduktiven Datenbank D =< F, R > ist die Menge aller ableit∗

baren Fakten F und wird bestimmt durch die Menge der Basisfakten F und die

∗

Menge der gegebenen deduktiven Regeln R. Zur Bestimmung der Menge F wird

eine konstruktive Fixpunktsemantik vorgestellt. Eine deduktive Regel wird dabei als

∗

faktengenerierende Funktion dargestellt. F wird deniert als der kleinste Fixpunkt

einer Funktion (vgl. [Gri97]).

Die Anwendung deduktiver Regeln wird modelliert durch den Tarski-Operator T .

0

Die zu einer Regel Ri := A ← B1 , . . . , Bn gehörige Ableitungsfunktion T [Ri ](F ) bil0

0

det eine beliebige Input-Faktenmenge F auf die Menge aller mittels Ri aus F ableitbaren Fakten ab. Um eine Regelmenge auf dieselbe Input-Faktenmenge anzuwenden,

2.1

Deduktive Datenbanken

9

wird die kollektive Ableitungsfunktion T [R] eingeführt. Die kumulative Ableitungs∗

funktion T [R] führt eine wiederholte Anwendung der T [R]-Funktion aus und stellt

sicher, dass die abgeleiteten Fakten der vorangegangenen

T [R]-Anwendungen

bei

weiteren Herleitungen berücksichtigt werden.

Denition 2.12 (Ableitungsoperator)

Ri := A ← B1 , . . . , Bn , not C1 , . . . , Cm

einer beliebigen Regelmenge R.

Sei

F0

eine beliebige Faktenmenge und

eine bereichsbeschränkte Datalog-Regel aus

1.

T [Ri ](F 0 ) := {Aσ | σ ist eine konsistente Variablensubstitution,

j ≤ n : Bj ∈ F 0 und ∀ 1 ≤ k ≤ m : Ck ∈

/ F 0 }.

2.

T [R](F 0 ) :=

3.

T ∗ [R](F 0 ) := F ∪ T [R](F 0 ).

S

Ri ∈R

so dass

∀1≤

T [Ri ](F 0 ).

Eine konsistente Variablensubstitution

σ ist die Ersetzung aller Variablen eines Aus-

drucks durch Konstanten, so dass jedes Vorkommen derselben Variablen durch dieselbe Konstante ersetzt wird.

Um ein verspätetes Ableiten positiver Fakten bei der Anwendung des

T ∗ [R]-

Operators auf eine Regelmenge mit Negation bzw. Rekursion zu verhindern, wird

∗

die Ausführung des T [R]-Operators bei stratizierbaren Regelmengen anhand der

Stratikationsebenen durchgeführt.

Denition 2.13 (Fixpunktsemantik deduktiver Datenbanken)

1. Sei

von

D =< F, R > eine positive oder semi-positive DB. Dann ist die Bedeutung

D der kleinste Fixpunkt F ∗ := lf p(T ∗ [R](F )) von T ∗ [R], der F ganz

enthält.

D eine stratizierbare DB und λ eine Stratikation von R mit n Ebenen

(n ≥ 0), dann ist die iterierte Anwendung des T ∗ [R]-Operators deniert als:

F0 := F

Fi := lf p(T ∗ [R](Fi−1 )) mit 1 ≤ i ≤ n. Die Bedeutung (iterierter Fixpunkt)

∗

von D ist deniert als F := Fn .

2. Ist

∗

Die Semantik F einer deduktiven Datenbank D =< F, R >, also der kleinste Fix∗

punkt von T [R, der F vollständig enthält, existiert immer, ist endlich und eindeutig

bestimmt ([vEK76]). Eziente Auswertungsverfahren für Datalog-Regeln (Anfragen), wie etwa die Magic Sets Methode [BMUS86], beruhen auf Regeltransformation

und Fixpunktberechnung.

10

Kapitel 2.

Datenbanken

2.1.4 Änderungspropagierung

Basisdatenänderungen können implizite Änderungen abgeleiteter Daten induzieren.

Virtuell dargestellte Sichten werden bei jedem Zugri neu berechnet, materialisierte

Sichten müssen jedoch angepasst werden. Eine naive Möglichkeit zur Bestimmung

dieser Änderungen stellt der Vergleich der DB-Zustände vor und nach der Durchführung einer Änderungsanweisung dar. Dieser Ansatz ist jedoch inezient, da eine

zweimalige vollständige Materialisierung der deduktiven Datenbank nötig ist. Zudem werden im Verhältnis zur Gröÿe der Relationen meist nur wenige Daten geändert. Ein ezienteres Verfahren ist die inkrementelle Berechnung der Änderungen

hinsichtlich abgeleiteter Daten. Im folgenden wird ein solches Verfahren zur Änderungspropagierung beschrieben.

Bei der Propagierung von Änderungen werden zwei Strategien unterschieden. Induzierte Änderungen werden beim top down -Ansatz abgeleitet, indem man Anfragen

nach neuen ableitbaren Fakten (∆-Fakten) stellt. Beim bottom up -Ansatz verläuft

der Propagierungsprozess änderungs- bzw. datengetrieben. Über einen Fixpunktprozess werden, beginnend bei den durch die Basisdatenänderungen induzierten Änderungen, die induzierten Änderungen der jeweils direkt abhängigen Sichten berechnet,

bis alle Änderungen ermittelt sind.

Durch Transformation der deduktiven Regeln werden die zur Berechnung der induzierten Änderungen benötigten Propagierungsregeln (∆-, Delta-Regeln) erzeugt.

Dabei werden für jedes Rumpiteral einer deduktiven Regel zwei ∆-Regeln erstellt,

+

−

eine ∆ -Regel für induzierte Einfügungen und eine ∆ -Regel für induzierte Löschun-

∆-Literal ersetzt. Je nach Polarität des

∆-Literals wird die Polarität des Literals im

Regelkopf bestimmt. Bei einem positiven ∆-Literal wird die Polarität beibehalten,

bei einem negativen wird die Polarität negiert. Die Rumpiterale der ∆-Regeln, die

keine ∆-Literale sind, werden als Seitenliterale (Residuen) bezeichnet. Der Zustand

old

der Datenbank vor der Ausführung der Änderungen wird mit F

bezeichnet, der

new

Zustand nach Ausführung der Änderungen (auch der induzierten) mit F

. Da

gen. Das Rumpiteral wird jeweils durch ein

zum Rumpiteral korrespondierenden

nur echte Änderungen abgeleitet werden sollen, wird zusätzlich ein Eektivitätstest

new

durchgeführt, d.h. ein einzufügendes Fakt muss im neuen Zustand F

ableitbar

sein, durfte aber nicht bereits im alten Zustand existiert haben. Ein zu löschendes

old

Fakt muss im alten Zustand F

ableitbar gewesen sein und es dürfen im neuen Zustand keine alternativen Ableitungswege existieren. Die Seitenliterale einer ∆-Regel

new

werden in Abhängigkeit der Polarität der propagierten Änderung bzgl. F

bei eiold

ner Einfügung und F

bei einer Löschung angewendet. Der Eektivitätstest führt

dazu, dass bei der Propagierung von Änderungen keine Duplikate auftreten können

(keine Multimengensemantik).

Denition 2.14 (Propagierungsregeln)

einer deduktiven Datenbank

Für jedes

Li , 1 ≤ i ≤ n

D.

Sei

Ri ∈ R

Sei

R

die stratizierbare Regelmenge

eine Regel der Form

A ← L1 , . . . , L n .

ist eine Propagierungsregel ein Ausdruck der Form:

2.2

MS Access

11

new

new

new

new

old

A+ ← L +

i , L1 , . . . , Li−1 , Li+1 , . . . , Ln , not A

old

new

new

new

new

A+ ← L −

i , L1 , . . . , Li−1 , Li+1 , . . . , Ln , not A

falls

old

old

old

old

new

A+ ← L −

i , L1 , . . . , Li−1 , Li+1 , . . . , Ln , not A

+

old

old

old

new

A+ ← Li , Lold

1 , . . . , Li−1 , Li+1 , . . . , Ln , not A

falls

falls

falls

Li ≡ L

Li ≡ not L

Li ≡ L

Li ≡ not L

Die Propagierungsregeln arbeiten mit zwei unterschiedlichen Datenbankzuständen.

Da es nicht sinnvoll ist, beide Datenbankzustände zu materialisieren, muss entwenew

old

der F

oder F

simuliert werden. Dies geschieht mit Hilfe der Transitionsregeln.

Welcher der beiden Zustände simuliert wird, hängt von der Reihenfolge der Ausführung von Basisfaktenänderung und Änderungspropagierung ab. Wird zuerst die

Änderung der Basisdaten durchgeführt, muss der alte Zustand simuliert werden (optimistischer Ansatz). Findet die Propagierung vor der Änderung an den Basisdaten

statt, wird der neue Zustand simuliert (pessimistischer Ansatz). Im Folgenden wird

der pessimistische Ansatz verfolgt.

Denition 2.15 (Transitionsregeln)

deduktiven Datenbank

Sei

R

die stratizierbare Regelmenge einer

D.

1. Ist A eine Basisrelation, dann ist eine inkrementelle Transitionsregel ein Ausdruck der Form

Anew ← A, not

new

+

A

2. Ist

A− .

←A .

Ri ∈ R

eine Regel der Form

A ← L1 , . . . , L n .

, dann ist eine naive Tran-

sitionsregel ein Ausdruck der Form

new

Anew ← Lnew

1 , . . . , Ln .

2.2

MS Access

Microsoft Access ist ein Datenbank-Produkt des Herstellers Microsoft ([WWW]).

Das Datenbankmanagementsystem basiert auf dem relationalen Datenmodell. Eine

Vielzahl von Datenquellen werden von Access unterstützt, u.a. auch ODBC (vgl. Abschnitt 2.3). Access bietet im Gegensatz zu den meisten üblichen DBMS zusätzliche

Funktionalitäten wie eine graphische Benutzeroberäche und eine Entwicklungsumgebung für VBA (Visual Basic for Applications). Mittels VBA können benutzerdenierte Erweiterungen von Access erstellt sowie auf Daten anderer Anwendungen oder

Datenbanken zugegrien werden. Access verwendet die sog. JET-Engine (Joint Engine Technology) als Datenbank-Backend ([WIKI]), über die die Daten verwaltet und

alle Datenbankoperationen abgewickelt werden. In dieser Arbeit wird die Version Access 2003 verwendet. Einige der Vorarbeiten innerhalb des SIMON-Projektes sind in

älteren Versionen (Access 2000, Access XP/2002) implementiert. In den folgenden

Abschnitten 2.2.1 bis 2.2.3 werden Jet SQL , VBA und die Datenbankanbindung

über VBA vorgestellt.

12

Kapitel 2.

Datenbanken

2.2.1 Jet SQL

Das Datenbankmodul Microsoft Jet SQL ist mit SQL ANSI-89 Level 1 kompatibel. Bestimmte ANSI SQL-Features sind jedoch nicht in Jet SQL implementiert.

Umgekehrt enthält Microsoft Jet SQL reservierte Wörter und Features, die in ANSI SQL nicht unterstützt werden. Ab Version 4.X wird zusätzlich ANSI-92-SQLSyntax unterstützt ([HLP]). Die in dieser Arbeit verwendeten Komponenten des

SIMON-Projektes, die in Access-Datenbanken implementiert sind (Compiler für

SQL-Sichten, vgl. Abschnitt 3.7, sowie Beispieldatenbank, vgl. Abschnitt 3.8), verwenden die ANSI-89 Syntax. Es können Inkompatibilitäten auftreten, wenn Anwendungsprogramme z.B. über die ODBC-Schnittstelle (vgl. Abschnitt 2.3) auf eine Jet

SQL-Datenbank zugreifen und die dabei verwendeten Operatoren nicht durch das

Datenbanksystem unterstützt werden.

2.2.2 Visual-Basic

Im Kontext dieser Arbeit wichtige Bestandteile von Access sind Formulare und Module. Formulare werden hauptsächlich zur Eingabe oder Anzeige von Daten der

Datenbank verwendet. Sie können an DB-Objekte wie Tabellen oder Abfragen gebunden werden, um die entsprechenden Daten anzuzeigen bzw. Benutzereingaben

zu verarbeiten. Steuerelemente innerhalb der Formulare stellen verschiedene Funktionen zur Verfügung und reagieren auf vom Benutzer ausgelöste Ereignisse wie

neue Eintragungen oder Mausklicks. Die Prozeduren zur Verarbeitung der Ereignisse können vom Benutzer mittels VBA selbst deniert bzw. erweitert werden. Module

stellen benutzerdenierte Erweiterungen von Access dar, die in der Programmiersprache VBA implementiert werden können. Ein Modul besteht aus Subroutinen

und Funktionen (Funktionen geben Werte zurück, Subroutinen führen ausschlieÿlich Code aus). Funktionen lassen sich auch innerhalb von SQL-Abfragen verwenden,

um so die Ausdrucksstärke von SQL zu erweitern. Zusätzlich können Steuerelemente

(Textfelder, Listenfelder o. ä.) von Objekten (Tabellen, Formulare, Berichte o. ä.)

direkt angesprochen werden. Aus VBA-Programmen kann auf die Daten der Datenbank und (eingeschränkt) auf die Daten anderer Anwendungen zugegrien werden

(vgl. Abschnitt 2.2.3). Das Tool zur Spezialisierung von SQL-Sichten (Compiler, vgl.

Abschnitt 3.7), welches in dieser Arbeit erweitert wird, stellt eine benutzerdenierte

VBA-Erweiterung einer Access-Datenbank dar.

2.2.3 DAO und ADO

VBA bietet die Möglichkeit, über die Microsoft Windows-Schnittstellensysteme

DAO (Data Access Objects) oder ADO (Active(X) Data Objects) auf Daten einer Datenbank oder Daten anderer Applikationen zuzugreifen. DAO ist für den

2.3

ODBC und JDBC

13

Zugri auf JET-Datenbanken konzipiert. Der Nachfolger ADO wurde als einheitliche Schnittstelle zwischen unterschiedlichen Datenbanken und Programmiersprachen entwickelt. Mit ADO lassen sich nahezu alle gebräuchlichen Datenbanken ansprechen, wie z.B. Microsoft Access, SQL-Server, Oracle oder Informix ([WIKI]).

2.3

ODBC und JDBC

Damit Anwendungsprogramme mit einer Datenbank kommunizieren können, sind

entsprechende Schnittstellen erforderlich. Ein CLI (Call Level Interface) ist eine

Schnittstellen-Spezikation für den Zugri auf relationale Datenbanken aus anderen Anwendungen heraus ([WIKI]), d.h. zum Ansteuern von Datenbanken wird eine CLI-Implementierung benötigt. Anstatt den Funktionsumfang zum Ansprechen

einer Datenbank in jedem Programm einzeln zu implementieren, greift man auf

bestehende Module zurück. Die CLI-Implementierung bildet ebenfalls die Befehlssätze verschiedener Datenbanksysteme auf eine immer gleiche Funktionsbibliothek

ab, um eine Unabhängigkeit von der konkreten Datenbank zu gewährleisten. Der

CLI-Standard wurde Anfang 1990 von einem Konsortium aus Datenbankherstellern

- der SQL Access Group - entwickelt. Eine erste Umsetzung wurde durch das API

(application programming interface) ODBC von Microsoft (1992) entwickelt. JDBC

(Java Database Connectivity) ist ein API der Java-Plattform, die ebenfalls einer

universellen Datenbankschnittstelle entspricht ([WIKI]).

ODBC (Open Database Connectivity) ist ein API von Microsoft für den dynamischen Zugri auf Datenbanken. Die standardisierte Schnittstelle wurde für C/C++

konzipiert ([KE04]) und erlaubt eine Entwicklung von Anwendungen unabhängig

vom verwendeten DBMS ([WIKI]). Bei der Kommunikation mit dem Datenbanksystem werden SQL-Befehle mit Hilfe von ODBC-Anweisungen an den ODBC-Treiber

weitergeleitet. Dieser ist abhängig von dem verwendeten DBMS. Er sendet die Befehle an die Datenbank und leitet die Antworten zurück. ODBC Treiber haben einen

unterschiedlichen Funktionsumfang: Core (nur Basisfunktionalität), Level 1, Level 2

([WIKI]). Auch das für das Microsoft-Jet-Datenbankmodul optimierte DAO (Data

Access Objects) ermöglicht den mittelbaren Zugri auf ODBC ([WIKI]).

JDBC (Java Database Connectivity) ist ein API der Java-Plattform, die eine universelle Schnittstelle zwischen der Sprache Java und Datenbanken darstellt. Sie stellt eine Weiterentwicklung von ODBC speziell für JAVA-Programme dar ([KE04]). JDBC

beinhaltet einen Satz von Klassen und Methoden, um relationale Datenbanksysteme unter Beibehaltung von Abstraktion aus Java heraus zugänglich zu machen

(DB-Verbindung aufbauen und Verwalten, SQL-Anfragen weiterleiten, Ergebnisse

für Java nutzbar umwandeln). Es kann jede Datenbank angesprochen werden, für

die ein JDBC-Treiber existiert oder die über ODBC zugreifbar ist.

14

Kapitel 2.

Datenbanken

Java-Applikationen greifen auf ein Datenbanksystem über den JDBC Driver Manager zu. In der JDBC Spezikation werden verschiedene Kategorien von JDBCTreibern unterschieden, die der Driver Manager verwenden kann. Ein JDBC Typ 1

Treiber kommuniziert ausschlieÿlich über den von Sun vertriebenen JDBC-ODBCBridge-Treiber. Damit ist es möglich, auf jede Datenbank mit ODBC-Anbindung

1

zuzugreifen . Ein Typ-1 Treiber ist somit abhängig von einem installierten ODBCTreiber. ODBC ist systemabhängig, dementsprechend enthält der Typ1-Treiber native Methoden. Ein Typ 2 Treiber übersetzt JDBC-Aufrufe direkt mit Hilfe einer

plattformspezischen Programmbibliothek in Aufrufe der Datenbank-API. Der Typ

2 Treiber benötigt eine zusätzliche Programmbibliothek und ruft native Methoden

auf. Typ 1 und 2 Treiber sind aufgrund ihrer Plattformabhängigkeit nicht portabel.

Mittels eines Typ 3 Treibers werden die JDBC-API-Befehle in DBMS-Befehle des

Datenbankservers übersetzt und (über ein Netzwerkprotokoll) an einen MiddlewareTreiber übertragen. Die Middleware leitet die Befehle an den Datenbankserver weiter. Es ndet keine direkte Kommunikation seitens des Typ 3 Treibers mit dem Datenbankserver statt, eine plattformspezische Bibliothek wird nicht benötigt. Typ

3 Treiber sind in Java programmiert und eignen sich sehr gut für Internet-Dienste

(Verschlüsselung, geringe Ladezeit). Typ 4 Treiber kommunizieren direkt mit dem

Datenbankserver über ein datenbankspezisches Netzwerk-Protokoll (MiddlewareTreiber werden dabei nicht verwendet). Ein Typ 4 Treiber (univerlesser Treiber)

stellt die performanteste Lösung dar, jedoch denieren nicht alle Datenbanken (z.B.

MS Access) ein entsprechendes Protokoll ([WIKI],[CU04]).

Die in Java implementierten Komponenten MOSIM (vgl. Abschnitt 3.4) und VISMONET (vgl. Abschnitt 3.5) des SIMON-Projektes, die in dieser Arbeit verwendet

und erweitert werden, kommunizieren über einen Typ 1 Treiber mit einer AccessDatenbank.

1 Ein

Typ 1 Treiber wird meist genutzt, falls kein eigenständiger JDBC-Treiber vorhanden ist

Kapitel 3

SIMON

Innerhalb des universitätsinternen Projekts SIMON (Simulation and Monitoring

of Mobile Objects) soll eine prototypische Implementierung eines Systems zur datenbankgestützten Überwachung mobiler Objekte auf Verkehrsnetzen ([MS04]) entwickelt werden. Im Rahmen des Projektes wurden durch mehrere Diplomarbeiten

Komponenten einer Testumgebung konzeptuell modelliert und implementiert. Dazu gehören u.a. ein Simulator (MOSIM), eine Visualisierungskomponente (VISMONET) sowie eine Datenbank, die u.a. Daten eines Beispielszenarios enthält. Ein

Compiler für SQL-Sichten bildet die Basis der regelbasierenden Monitoringkomponente, die in dieser Arbeit entworfen wird. Abschnitt 3.1 motiviert den Einsatz

von Datenbanken bei der Überwachung von Datenströmen. Abschnitt 3.2 gibt eine Einführung in die rechnergestützte Überwachung von Datenströmen. Dabei wird

insbesondere auf die Thematik des Monitorings im allgemeinen, die Modellierung

und Eigenschaften von Datenströmen sowie auf kontinuierliche Anfragen über Datenströmen eingegangen. Abschnitt 3.3 gibt einen Überblick über die Architektur

von SIMON. Die Komponenten aus den Vorarbeiten werden in den Abschnitten 3.4

bis 3.8 vorgestellt. Im Zuge des Entwurfs des Gesamtsystems werden diese Komponenten in den Kapiteln 5 und 6 diskutiert und erweitert.

3.1

Motivation

Im Kontext moderner Geoinformationssysteme gewinnt die Überwachung komplexer

Systeme mobiler Objekte zunehmend an Bedeutung ([MS04]). Dabei liefern Netzwerke von Sensoren umfangreiche Datenströme sich kontinuierlich bewegender Objekte.

Mögliche Anwendungsszenarien sind in Abbildung 3.1 aufgezeigt. Die Daten werden

i.a. zum automatischen Verfolgen (tracking) der Objekte und zur Visualisierung ihrer Bewegungen genutzt. Um jedoch auÿergewöhnliche Ereignisse und Zustände zu

15

16

Kapitel 3.

SIMON

erkennen, bedarf es einer Analyse der Daten. Diese wurde meist durch den Menschen vorgenommen, da intelligentes Überwachen (monitoring) die Fähigkeit zur

Analyse komplexer Situationen voraussetzt. Gleiches gilt für das Auslösen entsprechender Reaktionen auf die Zustände bzw. Ereignisse ([MS04]). Rechnergestütztes

Monitoring bietet jedoch Vorteile, da sehr viel gröÿere Datenmengen in kürzerer

Zeit analysiert werden können, als dies vom Menschen möglich wäre. Zudem sind

die Analyseergebnisse verlässlicher und objektiv. Dafür muss das Prinzip einer intelligenten Analyse in die rechnergestützte Überwachung integriert werden. Das Ziel

der intelligenten Analyse von Datenströmen ist das zeitnahe Aufdecken mehr oder

weniger komplexer Ausnahmesituationen sowie das entsprechende Auslösen vordenierter anwendungsspezischer Systemreaktionen.

Abbildung 3.1: Analyse von Sensordaten [MS04]

Die groÿe Menge an raum-zeitlichen Daten, die die Sensoren in Form von kontinuierlichen Datenströmen (data streams) liefern, sowie meist vorhandene zusätzliche (Meta-)Daten über weitere Zustandsparameter der überwachten Objekte, erfordern zur Bewältigung den Einsatz geeigneter Softwaresysteme. Dabei kann z.B.

Datenbanktechnologie verwendet werden. Entsprechende Datenbank-ManagementSysteme müssen jedoch über Funktionalitäten verfügen, die über den gebräuchlichen

Funktionsumfang hinausgehen, um Monitoring-Anwendungen zu ermöglichen. Von

besonderer Bedeutung ist dabei die Fähigkeit zur Spezikation anwendungsspezischer relevanter Situationen, zum ezienten automatischen Erkennen und Bewerten

von Ereignissen sowie zur Auslösung vordenierter Reaktionen in kritischen Ausnah-

3.2

Überwachung von Datenströmen durch kontinuierliche Anfragen

17

mesituationen (vgl. [MS04]). Das SIMON-System verfolgt zur Bewältigung dieser

Aufgaben einen regelbasierten Ansatz zur datenbankgestützten, reaktiven Überwachung mobiler Objekte auf Verkehrsnetzen, der auf einem DBMS mit aktiven

und deduktiven Regelkonzepten basiert. Die komplexen Situationen werden in Form

von zu überwachenden Bedingungen durch Anfragen speziziert, die kontinuierlich

über den jeweils aktuellen Daten der Datenströme ausgewertet werden (continuous

querys). Mit Methoden der Änderungspropagierung werden die Ergebnisse ezient

berechnet, um mit Hilfe von Triggern Reaktionen des Systems zu veranlassen.

3.2

Überwachung von Datenströmen durch kontinuierliche Anfragen

In diesem Abschnitt wird eine Einführung in die Überwachung von Datenströmen

gegeben. Abschnitt 3.2.1 führt in die Thematik des Monitorings ein und erleutert

wichtige Begrie. In Abschnitt 3.2.2 wird näher auf die Modellierung und die Eigenschaften von Datenströmen und in Abschnitt 3.2.3 auf Anfragen über Datenströmen

und den Zusammenhang mit dem Monitoring eingegangen.

3.2.1 Monitoring

Beim Monitoring wird ein bestimmter Ausschnitt der realen Welt beobachtet. Innerhalb des Realweltauschnitts gibt es bestimmte Objekte und es treten bestimmte

Ereignisse in Zusammenhang mit diesen Objekten auf. Das beobachtete Szenario

kann als Modell innerhalb eines Rechners abgebildet werden. Anhand der beobachteten Daten sollen die eingetretenen Ereignisse vom Rechner mit Hilfe von weiteren

(Meta-)Daten erkannt werden.

Im Kontext des Monitorings sind Objekte eindeutig zu identizierende physische Gegenstände der realen Welt. Jedes Objekt wird durch bestimmte Attribute und die

dazugehörigen Werte beschrieben (Beispiel: Ein grünes Objekt wird durch das Attribut Farbe und den dazugehörigen Wert grün beschrieben ([WIKI])). Objekte

können zu einander in Beziehung stehen und zu Klassen von gleichartigen Objekten

zusammengefasst werden. Der Zustand eines Objekts beschreibt die Werte der Attribute des Objekts zu einem bestimmten Zeitpunkt.

Geschehnisse sind eindeutig identizierbare Phänomene, die ein bestimmtes Zeitintervall andauern (Beispiel: Das Auftreten eines Objekts an einem bestimmten Ort).

Ereignisse sind punktuelle Geschehnisse.

Monitoring ist also das Beobachten von Objekten und Geschehnissen in einem bestimmten Ausschnitt der realen Welt. Ziel dabei ist, die Werte der das Objekt beschreibenden Attribute zu erkennen, um die Objekte zu klassizieren und die Beziehungen der Objekte untereinander zu entdecken. Zusätzlich sollen Geschehnisse

18

Kapitel 3.

SIMON

erkannt und festgestellt werden, welche Objekte davon betroen sind bzw. wie sich

die Werte der Attribute der Objekte verändern.

Die Beobachtung wird meist mit Hilfe von Sensoren oder Detektoren vorgenommen.

Primitive Ereignisse sind Ereignisse, die sich ausschlieÿlich direkt anhand der beobachteten Daten erkennen lassen. Unter Verknüpfung mit Hintergrundwissen bzw.

weiteren primitiven Ereignissen (indirekt) erkannte Ereignisse sind komplexe Ereignisse.

Beispiel 3.1 (Monitoring Szenario)

Bei dem in dieser Arbeit verwendete Bei-

spielszenario (vgl. Abschnitt 3.8) wird der ICE-Verkehr der Deutschen Bahn überwacht. Die wohlunterschiedenen Objekte sind die ICE-Züge. Attribute dieser Objekte

sind z.B. die Koordinaten, an denen sich das Objekt bendet, die Geschwindigkeit

oder die Verbindung, auf der sich das Objekt bendet. Primitive Ereignisse sind etwa das Auftreten eines Objekts an einem bestimmten Ort zu einer bestimmten Zeit,

welches sich anhand der Koordinaten feststellen lässt, oder das Stoppen des Objekts

(anhand der Geschwindigkeit). Ein komplexes Ereignis ist z.B. die Verspätung eines

Objekts hinsichtlich eines Fahrplans, welches durch eine Verknüpfung von primitiven

Ereignissen und Hintergrundwissen zu erkennen ist.

Monitoring wird bei einer Vielzahl von Anwendungen vorgenommen (vgl. Abbildung

3.1). Aufgrund der gewaltigen Datenmengen, die beim Beobachten von Objekten

der realen Welt auftreten, ist eine Analyse dieser Daten kaum vom Menschen durchzuführen. Beispielsweise bei Anwendungen im Kontext der Verkehrsüberwachung

und (automatischen) -steuerung oder der Bewertung von Aktienkursen übersteigt

die Analyse der entsprechenden Daten die Fähigkeiten des Menschen. Aus diesem

Grund gewinnt die rechnergestützte Überwachung zunehmend an Bedeutung. Ziel

ist dabei insbesondere die zeitnahe und objektive Bewertung und Analyse groÿer

Datenmengen.

Beispiel 3.2 (Monitoring Szenario Teil 2)

Das Beispiel 3.1 wird im Kontext

des rechnergestützten Monitorings fortgeführt. Mit Hilfe von Sensoren werden die

Daten hinsichtlich der ICE-Züge beobachtet. Anhand dieser Daten sollen primitive und komplexe Ereignisse von einem Softwaresystem erkannt und der Anwender

benachrichtigt werden. Dazu müssen die entsprechenden zu erkennenden Ereignisse

im Softwaresystem speziziert werden. Das primitive Ereignis Zug angehalten wird

z.B. speziziert durch Attribut: Geschwindigkeit, Wert: 0 und lässt sich direkt aus

den beobachteten Daten herleiten. Zur Spezikation komplexer Ereignisse wie der

Verspätung eines Zuges hinsichtlich des vorgegebenen Fahrplans ist eine Verknüpfung mit Hintergrundwissen (Fahrplandaten) nötig. Die beobachteten Daten müssen

zum Erkennen dieser Ereignisse analysiert werden. Zusätzlich muss die Reaktion

des Softwaresystems im Anschluss an das Erkennen eines Ereignisses (z.B. in Form

einer Warnung) speziziert werden können.

3.2

Überwachung von Datenströmen durch kontinuierliche Anfragen

19

Eine Anwendung ndet rechnergestütztes Monitoring im Kontext der Überwachung

von Datenströmen. In vielen Anwendungen lässt sich das Monitoring als Überwachung von Datenströmen modellieren, z.B. im Verkehrsmanagement ([CHKS03]).

Dabei sollen die bestehenden Kapazitäten eines Verkehrsnetzwerks möglichst ezient ausgenutzt und auf Verkehrsbelastung intelligent (z.B. durch das Herabsetzen

der Geschwindigkeit oder die Umleitung des Verkehrs auf Ausweichstrecken) reagiert

werden. Es ist eine Vielzahl an (Meta-)Daten über das zugrundeliegende Netzwerk

(Steckennetz) sowie die sich darauf bewegenden mobilen Objekte (Verkehrsteilnehmer) vorhanden. Durch die Erfassung von Daten über die Objekte (insbesondere der

Bewegung) durch entsprechende Sensoren wird zudem ein kontinuierlicher Datenstrom (z.B. laufende Positionsdaten) generiert. Diese Daten sollen analysiert werden,

um Ausnahmesituationen zu erkennen und das System darauf reagieren zu lassen.

Einfache Ereignisse wie eine Positionsfeststellung können direkt aus dem Datenstrom abgelesen werden. Um jedoch komplexe Ereignisse wie z.B. das Auftreten von

Stau bzw. Verzögerungen hinsichtlich eines Fahrplans zu erkennen, ist eine komplexe

Analyse der Daten nötig.

Folgende Aufzählung gibt einen Überblick über verschiedene Anwendungen im Kontext der Überwachung von Datenströmen (vgl. [GÖ03]):

•

Überwachung von Sensornetzwerken: Sensornetzwerke können z.B. für Anwendungen im Geo-, Verkehrs- oder im medizinischen Bereich verwendet werden.

•

Überwachung von Netzwerkverkehr: Analyse des Verkehrs innerhalb von Datennetzen (z.B. Datenverkehr im Internet).

•

Finanzanalyse: Analyse von Aktienkursen, um Zusammenhänge aufzudecken,

Trends zu identizieren und zukünftige Kursentwicklungen zu prognostizieren.

•

Log-Analyse: Analyse von Web-Logs, Telefon-Verbindungsdaten oder BankTransaktionen.

Beispiel 3.3 (Monitoring Szenario Teil 3)

Das Beispiel 3.2 wird im Kontext

der Überwachung von Datenströmen fortgeführt. Der zu Überwachende Datenstrom

besteht dabei aus den beobachteten Daten über die sich bewegenden Züge wie etwa

die aktuelle Position, die Geschwindigkeit, die aktuelle Verbindung usw. Diese sich

ändernden Daten sollen kontinuierlich auf das Auftreten der im System spezizierten

Ereignisse analysiert werden.

Abstrahiert man von der konkreten Anwendung, geht es also darum, Datenströme zu

überwachen und dabei benutzerdenierte Ereignisse zu erkennen. Es wird ein Ausschnitt der realen Welt beobachtet und entsprechenden Daten bestimmte primitive

Ereignisse hinsichtlich vordenierter Objekte erkannt, so z.B. das Auftreten eines bestimmten mobilen Objekts an einem Ort mit einer bestimmten Geschwindigkeit. Aus

20

Kapitel 3.

SIMON

den so übermittelten Daten wird ein Datenstrom mit festgelegten Attributen hinsichtlich der beobachteten Objekte generiert. Zur Erkennung komplexer Ereignisse,

die sich i.a. aus Kombinationen primitiver und/oder weiterer komplexer Ereignisse

sowie deren Interpretation und der Berücksichtigung von Meta-Daten ergeben, ist

eine komplexere Analyse der Datenströme nötig.

Die Überwachung eines Datenstroms ist also das Erkennen bestimmter Muster innerhalb der gesendeten Daten ([GIL]). Die Muster entsprechen dabei i.a. den Ereignissen aus der realen Welt. Um die Datenströme kontinuierlich auf das Auftreten dieser

Ereignisse zu überprüfen, müssen die Ereignisse im System speziziert werden. Die

Ereignisse können dabei z.B. als Anfragen speziziert werden, die ununterbrochen

oder kontinuierlich an das Softwaresystem gestellt und anhand der eintreenden

Stromdaten ausgewertet werden (kontinuierliche Anfragen). Die Benachrichtigung

des Benutzers hinsichtlich der Antworten auf die kontinuierlich muss dabei nicht

zwingend auch kontinuierlich erfolgen, sondern kann auch in vorgegebenen Zeitintervallen, nur beim Eintreten bestimmter Ereignisse oder auf explizite Anforderung

des Benutzers geschehen ([GIL]).

In den folgenden Abschnitten 3.2.2 und 3.2.3 wird näher auf die Modellierung von

Datenströmen und Anfragen über Datenströmen eingegangen.

3.2.2 Datenströme

Ein Datenstrom ist eine in Echtzeit übermittelte kontinuierliche Sequenz von Datensätzen in einer bestimmten Reihenfolge ([GIL], [GÖ03], [HRR99]). Bei vielen Anwendungen (vgl. Abschnitt

??) liegen Informationen in Form einer Sequenz (Strom)

von Daten vor ([GÖ03]). Je nach Anwendung bestehen diese Daten z.B. aus Sensordaten ([PGS01], [MF02]), Verkehrsdaten in Datennetzen ([GKMS01], [SH98]), Börsendaten ([CDTW00], [ZS02]), Onlineauktionen ([ABW02]) oder transaction logs

wie Web usage logs oder Telefon-Verbindungsdaten ([CFP+00]). Die Reihenfolge,

in der die Daten eintreen, kann dabei nicht beeinusst werden. Zusätzlich kann auf

die Stromdaten, sofern sie nicht zwischengespeichert werden, nur ein mal zugegrien

werden ([GÖ03],[HRR99]).

Die einzelnen Elemente der Stromdaten können z.B. relationale Tupel oder Instanzen

von Objekten sein ([GÖ03]). Bei Verwendung des relationalen Modells können die

Datenströme als append-only Relationen mit vorübergehenden Tuplen angesehen

werden ([BBD+02]). Es nden dabei keine Modikationen an den Daten, sondern

ausschlieÿlich Einfügungen statt.

Diese Modellierung von Datenströmen weist wesentliche Unterschiede zum konventionellen Modell gespeicherter Relationen auf ([BBD+02]). Bei Datenströmen liegen die Daten nicht in Form von persistenten Relationen vor, sie sind also nicht

3.2

Überwachung von Datenströmen durch kontinuierliche Anfragen

21

für einen wahlfreien Zugri auf einem Speichermedium (z.B. HDD oder RAM) zugänglich. Vielmehr bestehen die Daten aus einem oder mehreren kontinuierlichen

Datenströmen unterschiedlicher Geschwindigkeit. Ebenso ist die Datenmenge sowie der Zeitraum, über den die Daten eintreen, nicht festgelegt. Erst nach einer

Vorverarbeitung der Daten können sie z.B. innerhalb einer DB in Form von persistenten Relationen gespeichert werden. Zusätzlich werden dann innerhalb des DBMS

weitere Funktionalitäten hinsichtlich der Verwaltung der Stromdaten (wie z.B. eine

Historienverwaltung, garbage-collection usw.) benötigt.

Die folgende Aufzählung gibt eine Übersicht über die wichtigsten Eingenschaften

von Datenströmen ([BBD+02], [CHKS03], [GÖ03]):

•

Die Daten des Datenstroms werden direkt verarbeitet (online) bzw. erst nach

einer Vorverarbeitung gespeichert.

•

Das verarbeitende System hat keinen Einuss auf die Reihenfolge und die

Geschwindigkeit, mit der die Daten auf den Datenströmen eintreen.

•

Die Datenmenge ist möglicherweise unbegrenzt.

•

Die Daten werden nur ein mal geliefert. Sie werden verarbeitet und sind danach

nicht mehr zugänglich, sofern sie nicht zwischengespeichert wurden.

Probleme bei der Verarbeitung von Datenströmen bereitet die möglicherweise

unbegrenzte Datenmenge der innerhalb der Datenströme gesendeten Daten, die

eine vollständige Speicherung evtl. unmöglich macht. Dies führt dazu, dass zur

Beantwortung von Anfragen nur ein begrenzter Ausschnitt der Daten verfügbar

ist, da die Daten aufgrund des begrenzten Speicherplatzes nicht komplett vorliegen

bzw. bei der Speicherung aggregiert werden. Daraus resultiert die Tatsache, dass

u.U. nur approximative Antworten auf bestimmte Anfragen möglich sind.

Auf den Elementen der Datenströme kann anhand eines timestamp Attributs (Zeitstempel) eine explizite oder implizite Ordnung hergestellt werden ([BBD+02],

[GÖ03]). Explizite Zeitstempel liegen vor, wenn die Tupel jeweils zu einem Ereignis der realen Welt zu einem bestimmten Zeitpunkt korrespondieren und die

entsprechende Information den Daten durch den Sensor hinzugefügt werden kann.

Explizite Zeitstempel entsprechen dann den jeweiligen Zeitpunkten, an denen die

Daten generiert wurden. Implizite Zeitstempel können den Tupeln vom Softwaresystem automatisch beim Eintreen der Daten hinzugefügt werden, wenn die jeweilige

Datenquelle keine Informationen über das zeitliche Auftreten der Daten mitliefert.

Implizite Zeitstempel entsprechen also dem Zeitpunkt des Eintreens der Daten im

System ([BBD+02]). Probleme bei Zeitstempeln treten auf, wenn das Attribut z.B.

22

Kapitel 3.

SIMON

nach einem JOIN bei der Verarbeitung nicht mehr eindeutig ist oder vollständig

fehlt.

Weitere Probleme bei der Verarbeitung von Stromdaten können auftreten, wenn

z.B. Elemente der Datenströme nicht in chronologischer Reihenfolge oder mit zeitlicher Verzögerung eintreen. Durch eine blockweise oder gefensterte Verarbeitung

der Daten (sliding window ), wie sie z.B. in [CCC+02], [BBD+02] oder [CBB+03]

thematisiert wird, kann man dieses Problem lösen. Die Elemente der Stromdaten

werden zu Blöcken bzw. Fenstern zusammengefasst, auf welchen die Analyse dann

jeweils nacheinander durchgeführt werden. Die gefensterte bzw. blockweise Verarbeitung wird zusätzlich angewandt, wenn leweils nur ein Ausschnitt der Stromdaten

für die Analyse von Interesse ist ([GÖ03]).

3.2.3 Kontinuierliche Anfragen über Datenströmen

Im Kontext von Anfragen über Datenströmen werden zwei wichtige Unterscheidungen getroen ([BBD+02], [TGNO92]). Zum einen wird unterschieden zwischen ein-

1

maligen (one-time ) und kontinuierlichen (continuous ) Anfragen (CQs).

one-time querys sind Anfragen, die (genau) ein mal über dem jeweils zu einem

bestimmten Zeitpunkt aktuellen Zustand der Datenbank ausgewertet werden. Die

entsprechende Antwort wird an den Benutzer übermittelt. continuous querys sind

Anfragen, die kontinuierlich über dem jeweils aktuellen Datenbankzustand ausgewertet werden. Im Kontext der Analyse von Datenströmen werden ständig die selben

Anfragen über den sich ändernden Daten der Datenströme gestellt. Dabei werden

schrittweise neue Antworten auf die Anfragen zurückgegeben, sobald neue Stromdaten eintreen ([GÖ03]). Die Antworten auf die kontinuierlichen Anfragen basieren

dabei auf den bis zum jeweiligen Zeitpunkt auf den Datenströmen eingetroenen

Daten. Da die Daten der Datenströme meist nicht komplett abgespeichert werden

können, steht zur Beantwortung nur eine Teilmenge dieser Daten zur Verfügung.

Die Menge der Daten, die gespeichert werden kann, ist dabei von der Architektur

des Systems abhängig. Im Falle einer Online-Analyse ist die Menge der der Anfragebeantwortung zugrundeliegenden Daten z.B. wesentlich kleiner (Hauptspeicher) als

bei Verwendung eines Sekundärspeichers (z.B. DBMS). Dies beeinusst auch den

Grad der Genauigkeit der Antworten. Die Antworten auf die kontinuierlichen Anfragen können gespeichert und jeweils aktualisiert werden, wenn neue Daten auf den

Datenströmen eintreen, oder auch selbst als Datenströme weiterverarbeitet werden

([BBD+02]).

Eine weitere Unterscheidung wird zwischen vordenierten (predined ) und ad hocAnfragen getroen ([TGNO92], [BBD+02]). Eine vordenierte Anfrage wird dem

Softwaresystem übermittelt, bevor irgendwelche relevanten Daten eingetroen sind

1 Diese

Klasse beinhaltet die Anfragen traditioneller DBMS

3.3

Gesamtarchitektur SIMON

23

(oine). Zu den vordenierten Anfragen zählen i.a. auch die kontinuierlichen Anfragen. Ad hoc-Anfragen werden online während der Verarbeitung der Datenströme

gestellt. Die Verwaltung von ad hoc-Anfragen stellt höhere Anforderungen an das

DSMS. Im Gegensatz zu den vordenierten Anfragen ist die Optimierung von Anfragen, die erst zur Laufzeit an das System übermittelt werden, schwieriger. Zusätzlich

ist bei vordenierten Anfragen bekannt, auf welche Daten sie sich beziehen. Das

DSMS kann darauf reagieren und die benötigten Daten evtl. zwischenspeichern. Ad

hoc-Anfragen können sich jedoch auch auf historische Daten beziehen, die möglicherweise nicht mehr verfügbar sind ([BBD+02]).

Anhand der Daten der Datenströme sollen benutzerdenierte Ereignisse erkannt

werden. Diese Ereignisse lassen sich mit Hilfe von Anfragen spezizieren. Dabei entspricht das Eintreten eines Ereignisses dem Auftreten eines entsprechenden Tupels

in der Antwort der dem Ereignis zugehörigen Anfrage bzw. dem Auftreten eines

entsprechenden Tupels in der dem Ereignis zugehörigen Sicht. Da die Datenströme

kontinuierlich Überwacht werden sollen, werden beim rechnergestützten Monitoring

meist kontinuierliche Anfragen über den Daten der Datenströme ausgewertet.

Die Reaktionen des Systems auf eine Anfrage können in unterschiedlicher Weise

erfolgen. Zum einen werden die Antworten auf die Anfragen berechnet. Zusätzlich

können Meldungen (alerts) an den Benutzer bzw. Applikationen übermittelt werden,

um auf Änderungen bzw. Ergebnisse der Anfrage aufmerksam zu machen. Auch

können entsprechende Folgereaktionen (Trigger) ausgelöst werden, die das System

autonom auf die berechneten Ergebnisse reagieren lassen.

3.3

Gesamtarchitektur SIMON

Das SIMON-System besteht im wesentlichen aus drei Komponenten: Simulator, Monitor und Visualisierer. Ziel ist es, eine prototypische Implementierung eines Systems zur datenbankgestützten Überwachung mobiler Objekte auf Verkehrsnetzen

([MS04]) zu entwickeln. Der Simulator simuliert kontinuierliche Bewegungen mobiler Objekte auf Netzwerken. Die entsprechend generierten Daten werden von einer

regelbasierten Monitoring-Komponente mit Hilfe von Methoden der inkrementellen

Änderungspropagierung analysiert. Die Visualisierungskomponente stellt die simulierten Daten sowie die Ergebnisse der komplexen Analyse dar. Abbildung 3.2 gibt

einen Überblick über die Architektur von SIMON und den Zusammenhang der einzelnen Komponenten.

Als Vorarbeiten aus mehreren Diplomarbeiten stehen folgende Komponenten zur

Verfügung: Simulator MOSIM, Visualisierungskomponente VISMONET, Compiler

für SQL-Sichten, Datenbank mit Beispielszenario. Die Implementierungen von MOSIM und VISMONET wurden in Java vorgenommen, der Sichtencompiler sowie das

24

Kapitel 3.

SIMON

Abbildung 3.2: Architektur SIMON

Beispielszenario sind in eine Access-Datenbank integriert. In den folgenden Abschnitten werden die einzelnen Komponenten hinsichtlich der für diese Arbeit relevanten

Aspekte im Detail vorgestellt.

3.4

MOSIM

Der Simulator MOSIM (Mobile Object Simulator, [Bua03]) ermöglicht es, die kontinuierliche Bewegung mobiler Objekte in einer Netzwerktopologie zu simulieren.

MOSIM ist in Java implementiert und ersetzt momentan von realen Sensornetzen

gelieferte Datenströme. Funktionalität und Architektur von MOSIM wurden von

[Bri02] beeinusst. MOSIM generiert in benutzerdenierten Intervallen Positionsdaten mobiler Objekte, die die kontinuierliche Bewegung der Objekte nachbilden,

sowie je nach Anwendungsszenario weitere Zustandsparameter der zu überwachenden mobilen Objekte. Die Berechnung der aktuellen Positionssdaten jedes einzelnen

Objektes erfolgt skriptgetrieben, d.h. für jedes sich auf dem Netzwerk bewegende

mobile Objekt ist ein Fahrplan mit Angaben wie Startpunkt, Abfahrtszeitpunkt und

Zielort gegeben.

Abbildung 3.3 zeigt die Programmoberäche von MOSIM mit den Schaltächen zur

Steuerung der Simulation. Der Benutzer kann interaktiv in die Simulation eingreifen. Er hat die Möglichkeit, Parameter der Simulation zu beeinussen, so z.B. die

Simulationsgeschwindigkeit (welche Zeitspanne innerhalb der Simulation in einer

3.4

MOSIM

25

Echtzeit-Sekunde vergehen soll). Dem Simulationsbetrieb liegt ein diskretes Zeitmodell zu Grunde. Die Aktualisierungsrate, mit der die Positionsdaten der mobilen

Objekte generiert werden, kann variabel eingestellt werden. Zusätzlich ist eine Routine zur Verarbeitung von selbst-denierten Ereignissen vorbereitet, mit Hilfe derer

man den Ablauf der Simulation gezielt zu vordenierten Zeitpunkten oder aber interaktiv während des Simulationsbetriebes beeinussen kann. Solche Ereignisse sind

z.B. das Sperren von Verbindungen oder das Herabsetzen der Geschwindigkeit.

Abbildung 3.3: GUI MOSIM [Bua03]

Das Netzwerk, auf dem sich die mobilen Objekte bewegen, wird durch einen gerichteten Graphen modelliert. Jedes Netzwerk besitzt einen Typ sowie eine bestimmte

Anzahl von Orten (Knoten) und Verbindungen (Kanten). Ebenso sind die Orte und

Verbindungen von einem bestimmten Typ abgeleitet. Der Netzwerktyp legt die in einem Netzwerk zulässigen Verbindungs- und Ortstypen fest. Ein Ort wird speziziert

durch den zugehörigen Typ, einen Namen sowie seine Position in Form von (X,Y)Koordinaten und eine Verbindung durch einen Verbindungstyp, einen Namen, die

Länge sowie einen Start- und einen Zielort. Der Verbindungstyp legt dabei spezielle

vordenierte, aber auch erweiterbare Klasseneigenschaften wie maximale Kapazität

oder Höchstgeschwindigkeit fest.

Ebenso wie die Orte und Verbindungen besitzen die mobilen Objekte besitzen einen

bestimmten Typ, d.h. sie gehören Klassen mit spezischen Eigenschaften wie maximale Geschwindigkeit oder Fahrzeugtyp an. Die mobilen Objekte werden über

Skripte gesteuert, d.h. zu jedem mobilen Objekt ist ein Skript deniert, das festlegt,

in welcher Weise sich die Objekte auf dem Netzwerk bewegen sollen. Das Skript

26

Kapitel 3.

SIMON

besteht aus einer Liste von Verbindungen, die das entsprechende Objekt nach der

Reihe abfahren soll, und zugehörigen Abfahrtszeiten (Skripteinträge). Ist keine Abfahrtszeit angegeben, fährt das Objekt so schnell wie möglich los. Angefangen beim

Startort der ersten Verbindung sowie dem Startzeitpunkt bewegt sich das Objekt

auf dem Netzwerk. Das Skript ist durch einen Vector realisiert, ein Index deniert

den aktuellen Skripteintrag und somit die nächste Station in der Route an. MOSIM wird in Abschnitt 6.2 hinsichtlich des Funktionsumfangs der Skripte sowie des

Verhaltens der mobilen Objekte erweitert.

Abbildung 3.4 verdeutlicht das in MOSIM verwendete konzeptuelle Modell mobiler

Objekte auf Netzwerken. Es werden die Systemkomponenten (ohne ihre jeweiligen

Attribute) aufgezeigt, auf denen die Simulation beruht. Das Verhalten der mobi-

Abbildung 3.4: Konzeptuelles Modell mobiler Objekte auf Netzwerken [Bua03]

len Objekte wurde auf die folgende Weise modelliert: Jedes mobile Objekt versucht

immer seine bzw. die maximal auf der Verbindung zulässige Höchstgeschwindigkeit

zu erreichen. Deshalb überprüfen mobile Objekte zu jedem Zeitpunkt der Positionsaktualisierung, ob sie ihre Geschwindigkeit erhöhen können, sofern die eigene

Höchstgeschwindigkeit oder maximale Geschwindigkeit der Verbindung noch nicht

erreicht wurde. Im Fall einer gesperrten Verbindung oder falls die Abfahrtszeit des

entsprechenden Skripteintrags noch nicht erreicht wurde, wartet das Objekt an seiner Ausgangsposition bis zur Aufhebung der Sperrung einer Verbindung oder dem

3.5

VISMONET

27

Erreichen der Abfahrtszeit. Ist das mobile Objekt in Bewegung, ändert sich somit

die eigene Position. Die neue Position errechnet sich aus der zuletzt bekannten Geschwindigkeit, der zuletzt bekannten Position sowie dem vergangenen Zeitintervall.

Überschreitet die zurückgelegte Entfernung die noch verbliebene bis zum nächsten

Ort, so ndet anhand des Skripts ein Wechsel auf die nächste Verbindung im Skript

statt, sofern die nicht gesperrt ist, oder das Objekt verbleibt an seinem Zielort.

Die Protokollierung der Simulationsdaten ndet in der Datenbank statt, d.h. bei

jeder Positionsaktualisierung werden die aktuellen Daten aller mobilen Objekte in

der Datenbank gespeichert.

3.5

VISMONET

In [Yer04] wurde das Visualisierungssystem VISMONET entwickelt, welches mobile

Objekte, die sich auf einem Netzwerk bewegen, darstellt. Das in Java implementierte System wertet zur Echtzeit Positionsdaten aus und stellt sie in einer 2DBildschirmkarte dar (vgl. Abbildung 3.5).

Das Verkehrsnetz wird repräsentiert durch die Orte (Knoten) und Verbindungen

(Kanten). Die Darstellung des Netzwerks basiert auf den selben Daten (Koordinaten), die auch der Simulator MOSIM benutzt. Für die Anzeige des Netzwerks werden jedoch zusätzliche Daten benötigt. Jeder Ort und jede Verbindung sind einem

bestimmten Typ zugeordnet, der das Aussehen auf dem Bildschirm repräsentiert.

Die entsprechenden Typen sind in einer Datenbank hinterlegt und spezizieren bestimmte Eigenschaften wie Farbe, Form, Gröÿe oder Linientyp. Die Orte werden

als Punkte (Kreise) dargestellt. Die Verbindungen bestehen aus gerichteten Kanten

(Linien), die die verschiedenen Spurrichtungen modellieren und ein wenig versetzt

angezeigt werden. Dabei wird von Rechts-Verkehr ausgegangen, d.h. die Objekte

bewegen sich immer auf der in Fahrtrichtung rechten Spur.

Die mobilen Objekte werden als Quadrate angezeigt. Die Positionsdaten für die Objekte werden unmittelbar vom Simulator MOSIM geliefert. Diese werden in Form der

ID der Verbindung, auf der sich die Objekte benden, sowie der zurückgelegten Strecke direkt per Java übergeben. Anhand dieser Daten wird die Position der Objekte

auf dem Bildschirm bestimmt, indem aus den Koordinaten des Start- bzw. Zielortes der Verbindung die Richtung bestimmt und so mit der zurückgelegten Strecke

die neue Position relativ zur Startposition auf der Verbindung (Startort) berechnet

wird.

Die Visualisierung ndet getaktet statt. Die entsprechende Aktualisierungsrate bzw.

die Verzögerung zwischen zwei gezeichneten Zuständen kann vom Benutzer beeinusst werden. Die Aktualisierungsrate der Visualisierung und die der Positionsaktualisierung des Simulators sind nicht synchronisiert. In Abschnitt 6.4 werden Erweiterungen von VISMONET vorgenommen.

28

Kapitel 3.

SIMON

Abbildung 3.5: GUI VISMONET [Yer04]

Im Folgenden soll eine Übersicht über einige Klassen bzgl. Netzwerk und mobiler

Objekte gegeben werden. Die Klasse MainFrame entspricht dem Programmfenster

von VISMONET. Sie enthält u.a. die Buttons, über die die Funktionen des Programms zugänglich gemacht werden, die Zeichenäche, auf der die mobilen Objekte

und das Netzwerk gezeichnet werden sowie einen Bereich mit Karteikarten-Layout,

auf dem weitere Informationen zu den gezeichneten Komponenten zur Verfügung

stehen und auch editiert werden können. Die Zeichenäche wird durch die Klasse

DrawingPaneJava2D bereitgestellt. Auf der Zeichenäche werden drei verschiedene

Komponenten dargestellt. Dies sind die mobilen Objekte, die Orte sowie die Verbindungen. Ein Ort wird repräsentiert durch die Klasse NodeObject. Zusätzlich gibt es

Darstellungstypen für Orte (DisplayNOType), die verschiedenartiges Aussehen auf

der Zeichenäche ermöglichen. Jedem NodeObject ist ein DisplayNOType zugewiesen. Analog gilt dies für die Verbindungen (Connections, DisplayCType) und die

mobilen Objekte (MobileObject, DisplayMOType). Die Darstellungstypen beziehen

sich u.a. auf Gröÿe und Farbe der jeweiligen Objekte, die Formen sind an anderer

Stelle teilweise x festgelegt. Das Zeichnen der Objekte, also das Aussehen und die

Positionierung, ergibt sich aus den Attributwerten der Objekte sowie dem zugewie-

3.5

VISMONET

29

Abbildung 3.6: Klassendiagramm Netzwerk [Yer04]

senen Darstellungstyp. Die Zuordnung der Orte und Verbindungen zu ihren Typen

wird in der Datenbank vorgenommen (Tabellen ort_displayNOType bzw. verbindung_displayCType). Die Klasse Network (vgl. Abbildung 3.6) beinhaltet alle Verbindungen und Orte sowie deren Darstellungstypen und stellt das Netzwerk dar, die

Menge der mobilen Objekte entspricht der Klasse MobileObjects (vgl. Abbildung

3.7) und beinhaltet alle mobilen Objekte und die jeweiligen Darstellungstypen.

Abbildung 3.7: Klassendiagramm mobile Objekte [Yer04]

30

3.6

Kapitel 3.

SIMON

Monitor

Die Überwachung und Analyse der vom Simulator erzeugten Daten sollen durch

die Monitoring-Komponente (Monitor) vorgenommen werden. Sie erkennt kritische

Situationen und Ereignisse innerhalb der simulierten Daten, löst ggf. Reaktionen aus

und gibt die Analyseresultate an die Visualisierungskomponente weiter. Der Kern

dieser Komponente ist ein Compiler für Sichten und wurde in [Ber05] entwickelt.

Dieser Compiler wird in Abschnitt 3.7 vorgestellt.

Abbildung 3.8 zeigt die Architektur des Monitors. Vom Benutzer können Anfragen

speziziert werden, welche kontinuierlich durch den Monitor beantwortet werden.

Die Anfragen werden dabei durch den Compiler in eine Form gebracht, die eine eziente Auswertung möglich macht. Basierend auf den Stromdaten, die von MOSIM

simuliert werden, und weiteren in der Datenbank verfügbaren Metadaten werden die

von Benutzer spezizierten Anfragen beantwortet. Die Analyse des Datenstroms besteht also in der Beantwortung kontinuierlichen Anfragen über den Stromdaten und

weiteren Metadaten. Die entsprechenden Antworten bzw. Analyseergebnisse werden

zur graphischen Darstellung an die Visualisierungskomponente weiterleitet.

Abbildung 3.8: Architektur Monitor

In Kapitel 4 wird das Konzept des Monitors motiviert und der dabei verwendete

Ansatz zur datenbankgestützten Überwachung von Datenströmen vorgestellt. Der

Compiler aus [Ber05] wird in Kapitel 6.3.3 diskutiert und erweitert. Insbesondere

wird dabei das Prinzip zur Generierung der Propagierungsregeln verbessert. Die

Monitoring-Komponente selbst wird in Abschnitt 6.3 entworfen.

3.7

3.7

Compiler

31

Compiler

Der innerhalb von Access mittels VBA als Modul implementierte Compiler erstellt

für in einer Access-DB spezizierte Sichten entsprechende weitere Sichten, die für

eine Anwendung des Prinzips der Änderungspropagierung (vgl. Abschnitt 2.1.4) benötigt werden. Die Access-Datenbank wird dabei mit Hilfe der Schnittstelle DAO

manipuliert (vgl. Abschnitt 2.2.3). Die vom Compiler erstellten Sichten erlauben ein

ezientes Berechnen der Änderungen hinsichtlich der zu überwachenden Bedingungen.

Abschnitt 3.7.1 beschreibt die Architektur des Compilers und die prinzipielle Vorgehensweise beim Kompilieren der Sichten. In Abschnitt 3.7.2 wird die Generierung

der Sichten mit Hilfe eines Ansatzes zur Änderungspropagierung in SQL anhand

von Beispielen erläutert. Abschnitt 3.7.3 zeigt die Einbettung des Compilers in MSAccess auf.

3.7.1 Architektur

Das in [Ber05] entwickelte Tool zur Spezialisierung von SQL-Sichten besteht aus der

Implementierung eines Algorithmus, der das Konzept der inkrementellen Sichtenanpassung aus dem Bereich der deduktiven Datenbanken im relationalen Datenbanksystem MS Access (Version: XP/2002) realisiert. Motivation dabei ist, beim Auftreten von Basisdatenänderungen eine komplette Rematerialisierung der abhängigen

Sichten zu vermeiden und statt dessen die Änderungen inkrementell zu propagieren.

In Anlehnung an die in Abschnitt 2.1.4 vorgestellte Methode zur Änderungspropagierung wurde eine Methode der inkrementellen Anpassung von Sichten in ein

SQL-DBMS (Access) implementiert. Die Komponente kann induzierte Sichtenänderungen hinsichtlich der entsprechenden zugrundeliegenden Sichten festzustellen

und berechnen. Die Methoden der Änderungspropagierung werden dabei direkt in

SQL übertragen. Dieser Ansatz wurde einem transformationbasierten Ansatz, der

die SQL-Sichten in eine äquivalente Datalog-Form überführt, dort die entsprechenden Propagierungs- und Transitionsregeln generiert und die Ergebnisse zurück in

eine SQL-Darstellung überführt, vorgezogen. Gründe dafür sind die mangelnde Unterstützung von Duplikaten und Aggregatfuktionen im Kontext von Datalog sowie

die Inezienz, die ein solches Vorgehen mit sich bringt (vlg. [Ber05]).

Abbildung 3.9 zeigt den prinzipiellen Aufbau des Compilers. Der Compiler erhält

eine Sichtdenition als Input und erstellt für die der Sicht zugrundeliegenden Sichten sowie die Sicht selbst die entsprechenden Delta-Sichten (vgl. 2.1.4), die die sich

aus Basisfaktenänderungen ergebenden induzierten Änderungen enthalten, sowie die

Transitionssichten, mit Hilfe derer der Datenbankzustand nach Durchführung der

32

Kapitel 3.

SIMON

Abbildung 3.9: Skizze des Compilers [Ber05]