s - Institut für Informatik

Werbung

Universität Potsdam

Institut für Informatik

Lehrstuhl Maschinelles Lernen

Hypothesenbewertung

Christoph Sawade/Niels Landwehr

Tobias Scheffer

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Vorzeichen-, Wald-, t- und Pearsons –Test

2

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Vorzeichen-, Wald-, t- und Pearsons-Test

3

Hypothesenbewertung

Klassifikation, Regression: Lernproblem

Eingabe: Trainingsdaten L = (x1 , y1 ),..., (x m , ym )

Ausgabe: Hypothese (Modell) f : X → Y

f ( x) =

?∈ Y

x∈ X

Testbeispiel

Ziel des Lernens: genaue Vorhersagen treffen

„Hypothesenbewertung“: Abschätzung der

Genauigkeit von Vorhersagen

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Schätzproblem: was ist eine gute Schätzung des

erwarteten Fehlers?

4

Verlustfunktionen

Instanz (x,y), Hypothese sagt f(x).

Verlustfunktion definiert, wie schlecht das ist.

( y, f ( x)) Verlust der Vorhersage f(x) auf Instanz (x,y)

Nicht-negativ: ∀y, y ' : ( y, y ') ≥ 0

Problem-spezifisch, gegeben.

Verlustfunktionen für Klassifikation

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

=

( y, y ') 0,=

wenn y y '; 1, sonst

Zero-one loss:

Klassenabhängige Kostenmatrix: ( y, y ') = c yy '

Verlustfunktionen für Regression

Squared error:

( y, y =

') ( y − y ') 2

5

Hypothesenbewertung

Zentrale Annahme: dem Lernproblem liegt eine

(unbekannte) Verteilung p(x,y) zugrunde

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Verteilung für Label

gegeben Instanz

Verteilung über

Instanzen

p ( x, y ) = p ( x ) p ( y | x )

Empirisches Risiko:

1

Rˆ ( f ) =

m

∑

m

j =1

l ( y j , f (x j ))

6

Fehler eines Schätzers

Empirischer Fehler ist Schätzer

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

1 m

Rˆ ( f ) = ∑ j =1 ( y j , f (x j ))

m

Schätzer ist Zufallsvariable.

Wert hängt von Zufallsexperiment „Messung des

empirischen Risikos“ ab

(xi , yi ) ~ p (x, y )

Welche (xi , yi ) werden gezogen?

(

)

( )

( )

2

2

Bias Rˆ + Var Rˆ

Rˆ − R =

Bias dominiert

Wert Rˆ ( f )

R

Varianz dominiert

R

7

Bias eines Schätzers

Schätzer

Ansonsten hat

einen Bias:

E[ Rˆ ( f )] − R( f )

Bias < 0.

Schätzer ist pessimistisch, wenn

Rˆ ( f )

Schätzer ist optimistisch, wenn

ist erwartungstreu, genau dann wenn:

E[ Rˆ ( f )] = R( f )

=

Bia s

Rˆ ( f )

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Bias > 0.

Schätzer ist erwartungstreu, wenn

Bias = 0.

8

Varianz eines Schätzers

Schätzer

Rˆ ( f )

hat eine Varianz

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Va [rRˆ ( f )] =

E[( Rˆ ( f ) − E[ Rˆ ( f )]) 2 ] =

E[ Rˆ ( f ) 2 ] − E[ Rˆ ( f )]2

Je größer die Stichprobe ist, die zum Schätzen

verwendet wird, desto geringer ist die Varianz.

Genaue Form der Varianz hängt von der Verlustfunktion

ab.

Hohe Varianz: großer „Zufallsanteil“ bei der Bestimmung

des empirischen Risikos.

Großer Bias: systematischer Fehler bei der Bestimmung

des empirischen Risikos.

9

Hypothesenbewertung: Risikoschätzung

Empirisches Risiko auf Daten T =

(x1 , y1 ),..., (x m , ym )

:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wichtig: Wo kommt T her?

Trainingsdaten (T=L)?

Hold-out: Verfügbare Daten in disjunkte L und T

aufteilen.

Cross-Validation (Spezialfall: Leave-one-out)

10

Holdout-Testing

Starte Lernalgorithmus mit Daten L, gewinne so

Hypothese f L .

Ermittle empirisches Risiko RˆT ( f L ) auf Daten T.

Starte Lernalgorithmus auf Daten D, gewinne so

Hypothese f D .

Ausgabe: Hypothese f D , benutze RˆT ( f L ) als

Schätzer für das Risiko von f D

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

11

Cross Validation

Gegeben: Daten D = (x1 , y1 ),..., (x d , yd )

Teile D =

in n Abschnitte Di =

(xi , yi ),..., (xi , yi ) , k

n

D

=

mit

i =1 Di und Di ∩ D j = 0

Wiederhole für i=1..n

Trainiere fi mit Li = D \ Di.

ˆ ( f ) auf D .

Bestimme empirisches Risiko R

D

i

i

1

1

k

k

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

d /n

i

Training examples

12

Cross Validation

Mittle empirische Risikoschätzungen auf den

jeweiligen Testmengen Di :

R=

1

n

∑

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

n

ˆ (f )

R

i

i =1 Di

Trainiere fD auf allen Daten D.

Liefere Hypothese fD und Schätzer R .

Training examples

13

Leave-One-Out Cross-Validation

Spezialfall n= d heisst auch leave-one-out

Fehlerschätzung

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

d

14

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Vorzeichen-, Wald-, t- und Pearsons –Test

15

Anwendungen Hypothesenevaluierung

Verfahren hat einen Parameter, den wir einstellen

müssen

Regularisierungsparameter λ

f w*

arg min fw

∑ ( f

i

2

x

w

y

+

λ

(

),

)

||

||

w

i

i

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

λ =?

(Hyper)Parameter, der Modellklasse bestimmt, z.B.

Polynomgrad bei polynomieller Regression

M

f w ( x) = ∑ wi x i

M=?

i =0

In allen diesen Fällen ist der Trainingsfehler kein

geeignetes Entscheidungskriterium!

Besser Fehlerschätzung mit Holdout-Menge oder

Cross-Validierung

16

Beispiel polynomielle Regression:

Training vs. Testfehler

Erfolg des Lernens hängt vom gewählten Polynomgrad M ab,

der Komplexität des Modells kontrolliert (hier besonders stark,

weil Modell nicht regularisiert)

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

17

Regularisierte Polynomielle Regression

Regularisierer wirkt wie eine Begrenzung der

Modellkomplexität und verhindert Überanpassung

In der Praxis am besten, Modellkomplexität durch

Regularisierung zu kontrollieren (direkter Parameter wie

bei Polynomen oft nicht verfügbar)

Regularisierer kann durch Fehlerschätzung (HoldoutTesting oder Cross-Validation) eingestellt werden.

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

18

Triple-Cross-Validation

Ziel: Abschätzung der Genauigkeit von

Vorhersagen unter optimalen Parametern

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

19

Triple-Cross-Validation

Gegeben: Daten D = (x1 , y1 ),..., (x d , yd )

Teile D =

in n Abschnitte Di =

(xi , yi ),..., (xi , yi ) , k d / n

n

D

=

mit

i =1 Di und Di ∩ D j = 0

Wiederhole für i=1..n

m

0

Teile Di in m Abschnitte mit Di = j =1 Di , j und Di , j ∩ Di , k =

Wiederhole für j=1..m

1

1

k

k

Trainiere fi,j,C mit Lj = Di \ Di,j f.a. möglichen Parameter C

Bestimme empirisches Risiko RˆC ( fi , j ,C ) auf Di,j.

Bestimme C* mit minimalen Risiko RˆC

Trainiere fi mit Li = D \ Di und C*

Bestimme empirisches Risiko Rˆ D ( f i ) auf Di.

i

20

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Triple-Cross-Validation

Mittle empirische Risikoschätzungen auf den

jeweiligen Testmengen Di :

R=

1

n

∑

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

n

ˆ (f )

R

i

i =1 Di

Trainiere fD auf allen Daten D.

Liefere Hypothese fD und Schätzer R .

21

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Vorzeichen-, Wald-, t- und Pearsons –Test

22

Konfidenzintervalle

Idee Konfidenzintervall:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Intervall um den geschätzten Fehler Rˆ ( f ) angeben

so dass der echte Fehler „meistens“ im Intervall liegt

Quantifiziert Unsicherheit der Schätzung

Weg zum Konfidenzintervall: Analyse der Verteilung der

Zufallsvariable Rˆ ( f )

Rˆ ( f )

[

]

R

23

Zero-One Loss und

Fehlerwahrscheinlichkeit

Für Konfidenzintervalle betrachten wir Risikoschätzung

im Spezialfall Klassifikation mit Zero-One Loss

Verlustfunktion Zero-One Loss:

l ( y , y ' ) = 0, wenn y = y ' ; 1, sonst

→ Risiko = Fehlerwahrscheinlichkeit.

R ( f ) = ∫ ( y, f (x)) p (x, y )dxdy

=

∫ [[ y ≠ f (x)]] p(x, y)dxdy

= p ( y ≠ f (x))

[[ Ereignis ]] : binäre Indikatorvariable

für "Ereignis"

24

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Verteilung für Fehlerschätzer

Hypothese f wird auf separater Testmenge mit m

unabhängigen Beispielen evaluiert:

1 m

RˆT ( f ) = ∑ j =1 ( y j , f (x j ))

m

T = (x1 , y1 ),..., (x m , ym )

Fehlerschätzer ist erwartungstreu, E[ RˆT ( f )] = R( f )

Fehlerschätzer ist Summe über Beispielverluste: Bei

jedem Beispiel kann ein korrektes oder falsches

Ergebnis beobachtet werden

=

j ( y j , f (x j )) ∈ {0,1} unabhängig, Bernouilli-verteilt mit Parameter R( f )

j ~ Bern( | R( f ))

Entspricht m Münzwürfen

25

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Schranken für echtes Risiko

Was sagt das empirische Risiko rˆ = RˆT ( f ) jetzt also

über das echte Risiko?

Empirisches Risiko r̂ → empirische Varianz sr2ˆ = rˆm(1−−1rˆ)

Einseitige Schranke für echtes Risiko:

(

) (

P R( f ) ≤ RˆT ( f ) +=

ε P R( f ) − RˆT ( f ) ≤ ε

e

= P

srˆ

ε

≈ Φ

srˆ

≤

ε

srˆ

)

=

e R ( f ) − Rˆ ( f )

e

e

P | r ≈ N | 0,1

srˆ

srˆ

ε

Φ kumulative Verteilungsfunktion der Normalverteilung

srˆ

26

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Schranken für echtes Risiko

Was sagt das empirische Risiko rˆ = RˆT ( f ) jetzt also

über das echte Risiko?

Empirisches Risiko r̂ → empirische Varianz sr2ˆ = rˆm(1−−1rˆ)

Zweiseitige Schranke:

(

)

(

)

(

P | R( f ) − RˆT ( f ) |≤ ε = 1 − P R( f ) − RˆT ( f ) > ε + 1 − P RˆT ( f ) − R( f ) > ε

)

= ...

ε

≈ 2 1 − 1 − Φ

srˆ

ε

= 2Φ

srˆ

27

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Konfidenzintervalle

Idee: ε so wählen, dass Schranke mit vorgegebener

Wahrscheinlichkeit von 1-δ (z.B. δ =0.05) gilt.

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Einseitiges 1-δ-Konfidenzintervall: Schranke ε, so

dass

P ( R( f ) ≤ RˆT ( f ) + ε ) ≥ 1 − δ

Zweiseitiges 1-δ-Konfidenzintervall: Schranke ε, so

dass

P (| R( f ) − RˆT ( f ) |≤ ε ) ≥ 1 − δ

Bei symmetrischer Verteilung gilt immer:

ε zu einseitigem 1-δ-Konfidenzintervall

= ε zu zweiseitigem 1-δ/2-Konfidenzintervall.

28

Konfidenzintervalle

RˆT ( f )

ist annähernd normal-verteilt

(

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

)

P | R( f ) − Rˆ n ( f ) |> zα =

1−α

α σ

Φ −1 1 −

zα =

2 n

1− α

zα

29

Konfidenzintervalle

RˆT ( f )

ist annähernd normal-verteilt

RˆT ( f )

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

RˆT ( f )

R

R

Experimente

Experimente

30

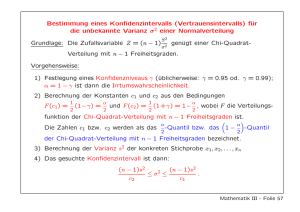

Students t-Verteilung

Empirisches Risiko annähernd normalverteilt:

(

)

p RˆT =

( f ) rˆ=

| r B ( mrˆ | r , m )

r (1− r )

≈ N rˆ | r ,

m

rˆ − r

= N

| 0,1 Einfache Charakterisierung der

σ rˆ

Verteilung des empirischen Fehlers

Problem: Risiko muss bekannt sein, damit wir

Varianz bzw. Standardfehler bestimmen können.

σ rˆ2 =

r (1− r )

;

m

σ rˆ =

r (1− r )

m

Nur das empirische Risiko ist gegeben.

31

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Students t-Verteilung

Schätzen der Varianz durch empirische Varianz:

sr2ˆ

=

rˆ(1− rˆ)

srˆ

,

=

m −1

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

rˆ(1− rˆ)

m −1

Empirisches Risiko folgt bei geschätzter Varianz

Students t-Verteilung (ähnlich Gauß-Verteilung,

aber mehr Wahrscheinlichkeitsmasse in den

Außenbereichen).

Für große m konvergiert Students t-Verteilung

gegen die Normalverteilung.

32

Students t-Verteilung

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

rˆ − r

rˆ − r

lim m→∞ t

|m = N

|0,1

s

s

ˆ

ˆ

r

r

33

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Vorzeichen-, Wald-, t- und Pearsons –Test

p-Wert

34

Klassifikator / Entscheidungsfunktion

Für eine binäre Klassifikation (y= +1 oder -1) wird oft

eine kontinuierliche Entscheidungsfunktion f(x) gelernt.

Z.B. lineares Modell

∑

T

x

f w=

(x) w=

m

i =1

wi xi

Je größer f(x), desto wahrscheinlicher ist, dass x zur

Klasse +1 gehört

Z.B. logistische Regression

Wahrscheinlich p(y=1)

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

σ ( f ( x)) =

Entscheidungsfunktionswert f(x)

1

1 + exp(− f ( x))

35

Klassifikator / Entscheidungsfunktion

Wie bestimmen wir Klassenentscheidung +1/-1 aus

f(x)?

Allgemeine Lösung:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

+1: f (x) ≥ θ

Vorhersage =

−1: sonst

Der Wert für θ verschiebt „false positives“ zu „false

negatives“.

Optimaler Wert hängt von Kosten einer positiven

oder negativen Fehlklassifikation ab.

36

Evaluation von Klassifikatoren und

Entscheidungsfunktionen

Fehlklassifikationswahrscheinlichkeit

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Häufig nicht aussagekräftig, weil P(+1) sehr klein.

Wie gut sind 5% Fehler, wenn P(+1)=3%?

Idee: Nicht Klassifikator bewerten, sondern

Entscheidungsfunktion.

Receiver Operating Characteristic (ROC-Kurve)

Bewertet Entscheidungsfunktion,

Jeder Punkt auf der ROC Kurve entspricht einem

Schwellwert θ

Fläche unter ROC-Kurve = P(positives Beispiel hat

höheren f-Wert als negatives Beispiel)

37

ROC-Analyse

Entscheidungsfunktion + Schwellwert = Klassifikator

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

+1: f (x) ≥ θ

Vorhersage =

−1: sonst

Fehler hängen vom Schwellwert ab

Großer Schwellwert: Mehr positive Bsp falsch.

Kleiner Schwellwert: Mehr negative Bsp falsch.

ROC-Analyse: Bewertung der Entscheidungsfunktion

unabhängig vom konkreten Schwellwert.

Charakterisieren das Verhalten des Klassifikators für

alle möglichen Schwellwerte.

38

ROC-Kurven

X-Achse: „False Positive Rate“

Y-Achse: „True Positive Rate“

Perfekte Funktion

TPR

Gute Funktion

Vorhersage „+“

Vorhersage „-“

Echtes Label „+“

TP

FN

Echtes Label „-“

FP

TN

FPR =

Zufällig raten

FPR

FP

N

=

N FP + TN

TPR =

TP

P

=

P TP + FN

39

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Rate der „False Positives“ und „True Positives“ in

Abhängigkeit des Schwellwertes

Bestimmen der ROC-Kurve von f

Annahme: kein f(x) = f(x´) für x ≠ x‘.

Generiere Liste L aller Instanzen x, absteigend sortiert nach f(x)

P = Anzahl positiver Instanzen, N = Anzahl negativer Instanzen

TP = FP = 0

Für i = 1 bis Länge(L)

x = i-tes Element von L

Wenn x positive Instanz: increment(TP)

Wenn x negative Instanz: increment(FP)

Zeichne neuen Punkt mit Koordination (FP/N,TP/P)

40

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Flächeninhalt der ROC-Kurve

Flächeninhalt AUC kann durch Integrieren (Summieren

der Trapez-Flächeninhalte) bestimmt werden.

x+ = zufällig gezogenes Positivbeispiel

x- = zufällig gezogenes Negativbeispiel

Theorem: AUC = P(f(x+) > f(x-)).

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

41

Precision / Recall

Precision =

Recall =

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Alternative zur ROC-Analyse.

Stammt aus dem Information Retrieval.

TP

TP + FP ← Alle Instanzen mit Vorhersage „+“

TP

TP + FN ← Alle Instanzen mit echtem Label „+“

Precision: P(positiv | positiv vorhergesagt)

Recall: P(positiv vorhergesagt | ist positiv)

42

Precision / Recall Trade-Off

Precision-/Recall-Kurven

Welcher Klassifikator ist der Beste / Schlechteste

43

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

recall

precision

F-Measure, Breakeven Point

Zusammenfassungen der Kurve in einer Zahl:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

F-Measure: Harmonisches Mittel über Precision und

Recall, maximiert über Schwellwert θ

2 ⋅ Precision ⋅ Recall

F-measure=

Precision + Recall

Precision-Recall-Breakeven-Point: Es gibt einen

Punkt θ auf der Kurve für den gilt Precision(θ) =

Recall(θ) =: PRBEP

44

Evaluation von Hypothesen:

Zusammenfassung

Verlustfunktion, Risiko

Empirisches Risiko → Aussagen über echtes

Risiko.

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Holdout-Testing, Cross Validation.

Ein-/zweiseitige Konfidenzschranken.

Qualitäts-/Risikomaße

Fehlerrate,

ROC-Analyse, AUC,

Precision-Recall-Kurven.

45

Überblick

Wiederholung: Hypothesenbewertung

Verfahren

Anwendungen

Konfidenzintervalle

ROC-Analyse

Statistische Tests

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Vorzeichen-, Wald-, t- und Pearsons –Test

46

Statistische Tests

Welche Schlussfolgerungen über die Realität

erlauben uns Beobachtungen wirklich?

Ein Test ist eine Prozedur mit den Eingaben

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Nullhypothese,

Beobachtungen

Parameterα .

Ein Test hat die möglichen Ausgaben

„Nullhypothese abgelehnt“ – das Gegenteil der

Nullhypothese gilt.

„nicht abgelehnt“ – keine Schlussfolgerung möglich,

kein neues Wissen gewonnen.

47

Statistische Tests

Nullhypothese:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Aussage von der wir bis auf weiteres ausgehen,

die wir aber überprüfen möchten und zu widerlegen

bereit sind.

Bedingung für einen statistischen Test:

Wenn die Nullhypothese gilt, dann darf sie nur mit

einer Wahrscheinlichkeit von höchstens α abgelehnt

werden.

48

Statistische Tests

Ausgabe „Nullhypothese abgelehnt“:

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wir ziehen die Schlussfolgerung, dass die

Nullhypothese nicht die Realität beschreibt.

Neues Wissen gewonnen, Publikation!

Ausgabe „nicht abgelehnt“:

Wir können keine Schlussfolgerung ziehen.

Vielleicht gilt die Nullhypothese, vielleicht nicht.

49

Statistische Tests

Beispiel: Wirksamkeit von Medikamenten

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Nullhypothese: „Medikament ist nicht wirksam“.

Beobachtungen: Symptome bei einer Test- und

einer Kontrollgruppe.

Wenn sich Symptome bei Testgruppe so stark von

Kontrollgruppe unterscheiden, dass

P(Beobachteter Unterschied | Nullhypothese) < α ,

dann sagen wir dass die Unterschiede zwischen den

Gruppen signifikant sind und lehnen die

Nullhypothese ab. Medikament ist wirksam.

Ansonsten kein Ergebnis.

50

Statistische Tests

Ziel: anhand vorliegender Beobachtungen x ∈

einer ZufallsvariableX eine begründete

Entscheidung über die Gültigkeit oder Ungültigkeit

einer Hypothese zu treffen

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Formal:

h 0 : θ ∈ Θ0 vs. h1 : θ ∈ Θ1

Nullhypothese

51

Statistische Tests

Im Allgemeinen ist ein statistischer Tests durch

seinen kritischen Bereich

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

R=

{x ∈ | T ( x ) > c}

definiert.

Teststatistik

Kritischer Wert

Wenn X ∈ R , lehnen wir die Nullhypothe ab, sonst

nicht

Woher kommen T ( x ) und c ?

problemabhängig

bestimmen die Aussagekraft

(Verteilungsannahmen, Vorwissen)

52

Statistische Tests

Viele Tests haben die folgende Form

einseitiger Test:

h 0 : θ ≤ θ0 vs. h1 : θ > θ0

zweiseitiger Test: h 0 : θ = θ0 vs. h 1 : θ ≠ θ0

Weitere Unterscheidungen

1 vs. 2 Stichproben-Tests

nach zu schätzenden Parametern (Mittelwert, Varianz)

Varianz bekannt / unbekannt

paired / unpaired

=

α sup P ( X ∈ R | θ )

Signifikanz-Niveau eines Tests:

θ∈Θo

53

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

p-Wert

Die Aussage „Nullhypothese abgelehnt“ ist nicht

sehr informativ

p-Wert: kleinste Signifikanz-Niveau α, für das die

Nullhypothese abgelehnt wird

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wahrscheinlichkeit unter Annahme der

Nullhypothese, dass die wirkliche Teststatistik größer

ist, als die beobachtete

Achtung: keine Wahrscheinlichkeit, dass

Nullhypothese richtig ist!

Ursache für großen p-Wert

Nullhypothese richtig ODER

Nullhypothese falsch, aber Test zu schwach

54

p-Wert

p-Wert: kleinste Signifikanz-Niveau α, für das die

Nullhypothese abgelehnt wird

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wahrscheinlichkeit unter Annahme der

Nullhypothese, dass die wirkliche Teststatistik größer

ist, als die beobachtete

Ein p-Wert von

<5%

<1%

<0,1%

gilt als signifikant

gilt als sehr signifikant

gilt als hoch signifikant

55

Beispiel

Patient

A

B

12 Patienten wurden zwei unterschiedliche

Schmerzmittel A und B verabreicht und die Wirkung

in Stunden gemessen

1

2

3,5

2

3,6

5,7

3

2,6

2,9

4

2,6

2,4

5

7,3

9,9

6

3,4

3,3

7

14,9

16,7

8

6,6

8

9

2,3

3,8

10

2

4

11

6,8

9,1

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

12

8,5

20,9

Gibt es Unterschiede zwischen den Medikament in

der Wirkung?

56

Vorzeichen-Test

Seien x1 ,…, x n unabhängig und identisch verteilt

mit Median m

h 0 : m = µ 0 vs. h1 : m ≠ µ 0

Lehne Nullhypothese ab, gdw. T ( x ) > c

unter h 0 binomial-verteilt

n

n

=

T ( x ) max ∑ x i − µ 0 > 0, ∑ x i − µ 0 < 0

=

i 1 =i 1

α

−1

=

c BinCDFn,0.5 1 −

2

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Vorzeichen-Test

Lehne Nullhypothese ab, gdw. T ( x ) > c

unter h 0 binomial-verteilt

h 0 : m = µ0

Wie wahrscheinlich ist

T ( x ) = 9?

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Beispiel

Patient

A

B

x=B-A

12 Patienten wurden zwei unterschiedliche

Schmerzmittel A und B verabreicht und die Wirkung

in Stunden gemessen

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

12

8,5

20,9

12,4

Gibt es Unterschiede zwischen den Medikament in

der Wirkung?

Nullhypothese: beide gleich h 0 : m = 6

T(x) = 9

59

Beispiel

p-Wert

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

12

8,5

20,9

12,4

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Patient

A

B

x=B-A

Nullhypothese h 0 : m = 6

T(x) = 9

p − Wert

= p (T ( X ) > T ( X n ) | h0 )

= p ( Z > 9 ) + p ( Z < 3) , Z ~ Bin ( k |12;0,5 )

= 2 BinCDF ( 3 |12;0,5 )

≈ 14, 6%

60

Wald-Test

Gegeben eine normalverteilte Schätzung θ̂ ∈ für

einen Parameter θ aus x1 ,…, x n

θˆ − θ0

( 0,1)

se

h 0 : θ = θ0 vs. h1 : θ ≠ θ0

Lehne Nullhypothese ab, gdw. T ( x ) > c

T(x) =

θˆ − θ0

se

α

−1

c Φ 1 −

=

2

unter h 0 normalverteilt

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wald-Test

Wald-Test: Lehne Nullhypothese ab, gdw.

θˆ − θ0

α

−1

> Φ 1 −

2

se

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Wald-Test hat Signifikanz-Niveau α

Beweis:

θˆ − θ0

α

−

1

sup Pθ ( X ∈=

R ) Pθ0

> Φ 1 −

se

2

θ∈Θo

α

→ P Z > Φ −1 1 −

2

=α

1− α

α

Φ −1 1 −

2

62

Beispiel

Patient

A

B

x=B-A

12 Patienten wurden zwei unterschiedliche

Schmerzmittel A und B verabreicht und die Wirkung

in Stunden gemessen

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

12

8,5

20,9

12,4

Gibt es Unterschiede zwischen den Medikament in

der Wirkung?

Nullhypothese: beide gleich h 0 : θ = 0

2,133

T(x) ≈

≈ 2,168

0, 984

63

Beispiel

p-Wert

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

12

8,5

20,9

12,4

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Patient

A

B

x=B-A

Nullhypothese h 0 : θ = 0

T ( x ) ≈ 2,168

p − Wert

= p (T ( X ) > T ( X n ) | h0 )

= p ( Z > 2,168 ) + p ( Z < −2,168 ) , Z ~ N ( 0;1)

= 2 NormCDF ( −2,168 | 0;1)

≈ 3%

64

t-Test

Seien x1 ,…, x n unabhängig normalverteilt mit

Erwartungswert µ und unbekannter Varianz

h 0 : µ = µ 0 vs. h1 : µ ≠ µ 0

Lehne Nullhypothese ab, gdw. T ( x ) > c

X n − µ0

1 n

T(x) =

, Xn = ∑ xi

n i =1

se

α

−1

unter h 0 t-verteilt

=

c Fn −1 1 −

2

(n-1 Freiheitsgrade)

Für kleine n besser geeignet als Wald-Test

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Beispiel

Patient

A

B

x=B-A

12 Patienten wurden zwei unterschiedliche

Schmerzmittel A und B verabreicht und die Wirkung

in Stunden gemessen

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

12

8,5

20,9

12,4

Gibt es Unterschiede zwischen den Medikament in

der Wirkung?

Nullhypothese: beide gleich h 0 : θ = 0

2,133

T(x) ≈

≈ 2,168

0, 984

66

Beispiel

p-Wert

1

2

3,5

1,5

2

3,6

5,7

2,1

3

2,6

2,9

0,3

4

2,6

2,4

-0,2

5

7,3

9,9

2,6

6

3,4

3,3

-0,1

7

14,9

16,7

1,8

8

6,6

6

-0,6

9

2,3

3,8

1,5

10

2

4

2

11

6,8

9,1

2,3

12

8,5

20,9

12,4

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Patient

A

B

x=B-A

Nullhypothese h 0 : θ = 0

T ( x ) ≈ 2,168

p − Wert

= p (T ( X ) > T ( X n ) | h0 )

= p ( Z > 2,168 ) + p ( Z < −2,168 ) , Z ~ Fn −1 ( 0 )

= 2tCDFn −1 ( −2,168 )

≈ 5,3%

67

Pearsons χ -Test

2

Seien x1 ,…, x n unabhängig multinomial-verteilt mit

Erwartungswert µ = ( µ1 ,…, µ k )

x i =…

( x1i , , x ik ) , x ij ∈ {0,1}

h 0 : µ = µ 0 vs. h1 : µ ≠ µ 0

Lehne Nullhypothese ab, gdw. T ( x ) > c

k

T(x) = ∑

(x

j

1

− µj )

2

µj

−1

α

2

=

c χ k −1 1 −

2

j =1

unter h 0 χ -verteilt

(k-1 Freiheitsgrade)

2

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Dualität

Ein Test mit Signifikanzniveau α verwirft die

Nullhypothese h 0 : µ = µ 0 , genau dann nicht, wenn µ 0

innerhalb des 1 − α -Vertrauensintervalls liegt.

69

Sawade/Landwehr/Scheffer, Maschinelles Lernen II

Zusammenfassung

Ein statistischer Test ist spezifiziert durch eine

Statistik und einen kritischen Wert

Wir lehnen die Nullhypothese ab, wenn X ∈ R

R=

{x ∈ | T ( x ) > c}

Da X unbekannt, hängt Test von Beobachtungen ab:

Die Nullhypothese soll nur mit Wahrscheinlichkeit α

fälschlicher Weise abgelehnt werden

Verschiedene Tests: Vorzeichen-Test, Wald-Test,

2

t-Test, Pearson χ

70

Sawade/Landwehr/Scheffer, Maschinelles Lernen II