OpenDataHub HSR – Teilen, Beziehen und

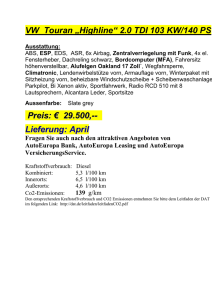

Werbung