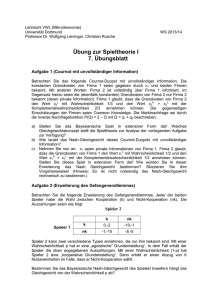

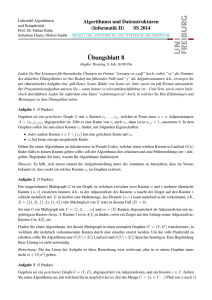

Skript - Professur für Theoretische Informatik

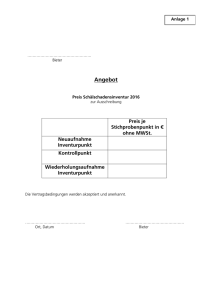

Werbung