Teil III - ORDIX AG

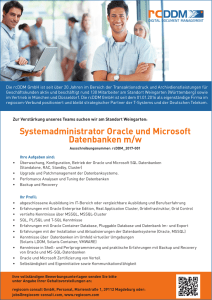

Werbung