Oracle Performance Tuning

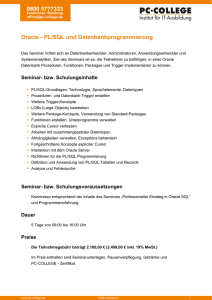

Werbung