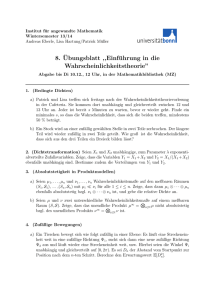

Elementare Wahrscheinlichkeitstheorie Stochastik I

Werbung