Fragmente eines Skripts zur Bildverarbeitung

Werbung

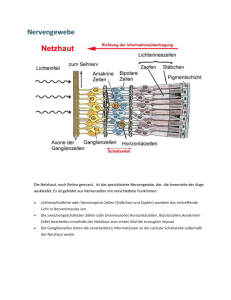

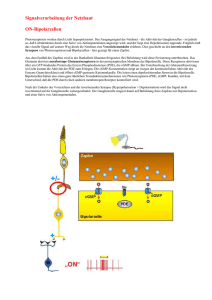

Fragmente eines Skripts zur Bildverarbeitung Lutz Priese Frank Schmitt 31. Oktober 2006 Patrick Sturm 2 Kapitel 1 Bildentstehung 1.1 Sensors 1.1.1 Basic Physical Concepts Units of Measurement The units of measurement for length, weight, temperature, etc., differ from metric to non-metric systems. m stands in the metric system for meter, but in the British and American system for mile. The unit for weight in the metric system is the gram (g). 500 grams form 1 metric pound that are 1.1023 pound in the avoirdupois or 1.3396 pound in the troy and apothecaries weight system. Table 1.1 gives some translations. Throughout this book we follow the metric system. 1 naut. mile = 1852 m 1 mile = 1609 m 1 1 inch = 0.254 m 1 foot = 0.305 m 1 yard = 0.914 m 3.281 feet = 1m 1 Brit. Cable = 183 m US Cable = 219 m 1 grain = 0.0648 g 1 pound (av.) = 453 g 1 pound (ap.) = 373 g 15.432 grains (ap.) = 1g 1 Brit. pint = 0.568 1 Brit. gallon = 4.546 l 1 US dry pint = 0.550 l 1 US liquid pint = 0.473 l 1 US gallon = 3.785 l 1.761 Brit. pints = 1 Tabelle 1.1: Metric units: m (meter), l (liter), g (gram). The abbreviations of table 1.2(a) for multiples are standard. Those names and symbols may be added to different units. Thus, 1 km are 1000 m, 1 kg are 1000 g, 1 nm is 10−9 m, 1.3 GHz are one thousand three hundred MHz, etc. Some caution is required as 109 is called a milliard almost world wide but a billion in the USA, 1012 is a billion in Europe but a trillion in the USA. However, things are much more confusing as Britain has started to use American names and to call 109 one thousand millions or also a billion. To avoid misunderstanding we 3 (a) Prefixes of units factor 10−15 10−12 10−9 10−6 10−3 10−2 103 106 109 1012 1015 name femto pico nano micro milli centi kilo mega giga tera peta symbol f p n µ m c k M G T P (b) Names of numbers World name thousand million milliard billion billiard trillion trilliard quadrillion quadrilliard quintillion quintilliard US name thousand million billion trillion quadrillion quintillion sextillion septillion octillion nonillion decillion value 103 106 109 1012 1015 1018 1021 1024 1027 1030 1033 Tabelle 1.2: Multiples will never talk about a billion meters, e.g., but about 1012 meters or 1 Tm. The USA is one of the rare countries where one counts in 103 steps: Latin prefixes are changed in 103 steps, where million is 103+3 , a billion is 103+3∗2 , thus 1030 = 103+3∗9 is named a nonillion. Almost all other countries prefer a change of the Latin prefixes each 106 step, changing the ending “..illion” to “..illiarde” after a 103 step. I.e., 1030 = 106∗5 = million5 is a quintillion, thus, 1033 becomes a quintilliard. Table 1.2(b) gives the European and US names. Oscillations There are acoustic, water and electro-magnetic waves. Waves may be measured in frequency, wave-length, or energy. The number of oscillations per second is the frequency f with the unity Herz Hz. The velocity v of a wave is the distance (in m) that a single wave travels in one second. The wave-length λ is the distance between two succeeding maxima (see 1.1.1). Obviously, there holds λ= c . f X-rays and gamma-rays are usually measured in energy with the unit eV, optical light in wave-length, radio waves in frequency. The connection to energy is given by h·c 1.24 · 10−6 ≈ eV m. λ λ with h ≈ 6.62608 · 10−34 Jsec and 1J ≈ 6.242 · 1018 eV . E =h·v = 4 λ Abbildung 1.1: Wellenlänge As this book deals with optical light we prefer to identify all waves by their wavelength. The velocity of an acoustic wave depends on the medium it is travelling through and the temperature of that medium. The sonic speed in dry air with a temperature of t◦ C is vt ≈ 331 · r 1 + 0.00367t m , sec thus ≈ 331, 340, 349 m/sec at 0, 15, 30◦C. At 18◦ in iron, glass, brass it is approximately 5100, 5000, 3400 m/sec, respectively. The speed of an electromagnetic wave in vacuum equals c, the speed of light, which is km m ≈ 300000 . sec sec c becomes slightly slower in air and considerably slower in water: cair ≈ c/1.0003, cwater ≈ 3/4·c ≈ 225000km/sec. In water fast electrons can outrun the speed of light, cwater , leading to the blue Čerenkov light. Here light means visible light, i.e., electro-magnetic waves with a wave-length between approximately 400 to 800 nm that equals 7.5 – 3.75·1014Hz. Figure 1.2.1 on page 7 presents different wave-length and visualizes their magnitudes. c = 2.99792 · 108 1.2 Menschliches Sehen Wenn man in einer Fussgängerzone Passanten anhielte und ihnen die Frage stellte “Wie funktioniert eigentlich das Sehen?” würde man vermutlich bestenfalls eine Antwort bekommen wie “Licht tritt aus einer Lichtquelle aus, wird von Gegenständen reflektiert, die reflektierten Lichstrahlen treten in das Auge ein und dann sieht man.”. Tatsächlich ist diese Aussage nicht einmal falsch aber unvollständig. Was passiert auf dem Weg zwischen Lichtquelle und Auge? Wie ist der Weg des Lichts im Auge? Und am Wichtigsten: Wie wird aus Lichtstrahlen, die 5 in unserem Auge eintreffen, das Bild eines Gegenstands in unserem Bewusstsein? Im folgenden Kapitel wollen wir diese Fragen beantworten. 1.2.1 Licht und Farbe Isaac Newton entdeckte im siebzehnten Jahrhundert, dass man Sonnenlicht durch Brechung mit einem Prisma in verschiedene Farben zerlegen kann. Er folgerte, dass das Licht aus Partikeln unterschiedlicher Größe zusammengesetzt sein müsse, die er als Korpuskeln bezeichnete. Mit dieser Theorie stand er im Widerspruch zu den Ansichten Christiaan Huygens, der Licht für eine Welle im Äther hielt. Diese beiden Modelle des Lichts schienen lange Zeit unvereinbar. Heute wissen wir, dass die Eigenschaften des Lichts nur durch eine Kombination beider Ansätze erklärt werden können. Licht ist quantisierbar, also aus elementaren Bausteinen zusammengesetzt, den Photonen. Photonen besitzen jedoch wie alle Elementarteilchen auch Welleneigenschaften. Je nach Experiment treten entweder die Teilcheneigenschaften oder die Welleneigenschaften des Lichts in den Vordergrund. Physikalisch ist Licht elektromagnetische Strahlung, also die sich ausbreitenden Schwingungen eines elektromagnetischen Feldes. Als Licht wird jedoch nicht das gesamte Spektrum der elektromagnetischen Strahlung, sondern nur der kleine, für das menschliche Auge sichtbare, Bereich von etwa 380 bis 780 nm 1 bezeichnet. (siehe Abbildung 1.2.1). In der Regel ist Licht aus Strahlung verschiedener Wellenlängen zusammengesetzt. Die Zusammensetzung des von einer Lichtquelle emittierten oder von einer Oberfläche reflektierten Lichts wird als Spektralverteilung bezeichnet und kann mittels eines Spektrometer untersucht werden. Ist das gesamte Spektrum der sichtbaren Strahlung relativ gleichmäßig vertreten, so spricht man von weißem Licht, wenn das Licht fast ausschließlich aus Strahlung einer bestimmten Wellenlänge besteht von monochromatischem Licht. Weder Sonnenlicht noch das Licht der meisten künstlichen Lichtquellen sind perfekt weiß. Trifft Licht auf eine Oberfläche auf, so können drei Fälle auftreten: Entweder durchdringt das Licht die Oberfläche, oder es wird absorbiert und in Wärme umgewandelt oder es wird von der Oberfläche (meist diffus) reflektiert. Diese Fälle schließen einander jedoch nicht aus. Nehmen wir als Beispiel eine klassische Sonnenbrille: Ein großer Teil der Lichtstrahlen, die das Glas treffen, wird von der Brille absorbiert, speziell kurzwellige Strahlung im UV- und Blaubereich. Die meisten nichtabsorbierten Lichtstrahlen durchdringen die Brille, somit ist es uns möglich durch sie die Umgebung zu sehen. Der Teil der nichtabsorbierten Strahlung, der die Brillengläser nicht durchdringt wird reflektiert, somit kann ein Gegenüber die 1 Es finden sich in der Literatur auch leicht andere Angaben etwa 400 bis 800 nm 6 Abbildung 1.2: Spektrum der elektromagnetischen Strahlung Brillengläsern sehen. Der dominierende Anteil des Wellenspektrums bestimmt unseren Farbeindruck. Abbildung 1.2.1 zeigt den menschlichen Farbeindruck in Abhängigkeit der dominierenden Wellenlänge des Lichts. Die Farbe eines Gegenstands wird also davon bestimmt, welche Wellenlängen von seiner Oberfläche vorrangig reflektiert und welche vorrangig absorbiert werden. Materialien, die Licht selektiv, also in Abhängigkeit der Wellenlänge, absorbieren, werden Pigmente genannt. 7 400 450 500 550 600 650 700 650 700 (a) Farbeindruck gemäß CIE 400 450 500 550 600 (b) Logarithmische Darstellung des Farbeindrucks Abbildung 1.3: Menschlicher Farbeindruck in Abhängigkeit der Wellenlänge des Lichts 1.2.2 Das menschliche Auge Das menschliche Auge ist ein kugelförmiges Organ mit einem Durchmesser von etwa 24 mm. Sein Aufbau ist in Abbildung 1.4 dargestellt. Das Auge ist mit drei Muskelpaaren an der Augenhöhle befestigt, über diese ist es möglich die Blickrichtung in sehr feinen Graden zu verändern. Diese Fähigkeit erlaubt es, das Blickfeld bei Kopfbewegungen konstant zu halten und den fokussierten Punkt an der Stelle des schärfsten Sehens auf der Netzhaut abzubilden. Licht, das in das Auge eintritt, durchdringt zunächst die Hornhaut (lat. Cornea). Die Cornea dient zur Brechung des Lichts, d.h. sie lenkt eintreffende Lichtstrahlen hin zur Netzhaut ab. Die Cornea ist transparent und wird nicht über Blutgefäße versorgt, bezieht jedoch Nährstoffe aus dem dahinter liegenden ebenfalls transparenten Kammerwasser (Humor aquosus). Die Hornhaut ist stärker gekrümmt als der Rest des Augapfels, bildet also eine Art Hügel auf dem Auge. Hinter der Cornea befindet sich die Iris, die zur Steuerung des Lichteinfalls in das Auge dient und somit die Funktion einer Blende übernimmt. Sie besteht aus pigmentiertem, kreisförmigem Gewebe mit einer ebenfalls kreisförmigen Öffnung in ihrer Mitte, der Pupille. Die Größe der Pupille kann über Muskelkontraktion verändert werden. Das Vergrößern (Mydriasis) bzw. Verkleinern (Miosis) der Pupille geschieht jedoch nicht bewusst, sondern als Reflex auf die Menge des einfal8 Abbildung 1.4: Aufbau des menschlichen Auges, Quelle: National Eye Institute, National Institutes of Health, USA lenden Lichts. Die Größe der Pupille bestimmt nicht nur die Menge des einfallenden Lichtes, sondern auch die Größe des Lichtkegels, der die dahinter liegenden Strukturen trifft. Durch die Pupille gelangt einfallendes Licht auf die Linse (Lens Crystallina). Sie besteht aus kristallklarem, beidseitig konvex geformtem Gewebe. Wie die Hornhaut wird auch die Linse nicht über Blutgefäße, sondern über das sie umgebende Kammerwasser mit Nährstoffen versorgt. Die Linse dient dazu das Auge auf unterschiedliche Entfernungen scharf zu stellen, dazu wird ihre Krümmung über Muskeln verändert (Akkommodation). Damit ein Objekt scharf erscheint müssen alle Lichtstrahlen, die von einem Punkt auf dem Objekt abgegeben werden auf einen Punkt der Netzhaut abgebildet werden. Werden Objekte, die nahe am Auge liegen, betrachtet, so müssen Lichtstrahlen, die im äußeren Bereich der Linse eintreffen, stark gebrochen werden. In diesem Fall erschlaffen die Muskeln, die die Form der Linse kontrollieren, was auf 9 Linse Netzhaut Linse betrachteter Punkt Netzhaut betrachteter Punkt (a) Korrekte Lichtbrechung durch die Linse bei weit entferntem Objekt (b) Wird die Form und somit die Brechwirkung der Linse nicht verändert, werden die Lichtstrahlen von nahen Objekten nicht auf einen Punkt auf der Netzhaut gebündelt Linse Netzhaut betrachteter Punkt (c) Korrekte Lichtbrechung durch die Linse bei nahem Objekt Abbildung 1.5: Fokussierung durch Änderung der Linsenkrümmung Grund der Eigenelastizität der Linsenfasern zu einer stärkeren Krümmung führt. Sollen weit entfernte Objekte fokussiert werden (“Unendlichkeitsstellung”), so werden die Muskeln kontraktiert was zu einer Streckung der Linse führt. In diesem Fall wird das Licht fast ausschließlich in der Hornhaut gebrochen. Dieser Vorgang wird in Abbildung 1.2.2 visualisiert. Der Raum zwischen Linse und dem hinteren Bereich des Auges wird durch den Glaskörper (Corpus vitreum) ausgefüllt. Dieser besteht aus einer gelartigen Masse aus Kollagenfasern und Wasser und sorgt dafür, dass die kugelförmige Struktur des Auges gestützt wird. Das Licht, dass in der Linse gebündelt wurde durchdringt den Glaskörper und trifft auf die Netzhaut. Die Netzhaut (Retina) dient zur Umwandlung des einfallende Lichts in Ner10 Abbildung 1.6: Schematische Darstellung des Aufbau der Retina. Quelle: http://webvision.med.utah.edu venimpulse. Wie wir sehen werden ist sie jedoch nicht bloß ein einfacher Photosensor, der ein Abbild der Wirklichkeit ins Auge überträgt, sondern ein komplexes Informationsverarbeitungssystem. Die Retina ist eine mehrschichtig aufgebaute, durchschnittlich etwa 0,25 mm dicke Struktur, die mit einer Fläche von etwa 1100 mm2 einen Großteil der Innenseite des Augapfels bedeckt. Sie bildet sich während der embryonalen Entwicklung aus dem Gehirn aus und ist mit diesem über den Sehnerv direkt verbunden, ist also Teil des zentralen Nervensystems. Ihre funktional wichtigsten Bestandteile sind Photorezeptoren und Nervenzellen (Neuronen). Der Aufbau der Retina ist in Abbildung 1.6 schematisch dargestellt. Die Photorezeptoren des menschlichen Auges absorbieren einfallendes Licht in einer chemischen Reaktion und erzeugen dann ein Signal, das an Neuronen weitergegeben wird. Man unterscheidet zwei Typen von Photorezeptoren, Stäbchen und Zapfen, die in Abbildung 1.7 schematisch dargestellt werden. Die Stäbchen sind zahlreicher (ca. 120 Millionen Stäbchen aber nur ca. 5 Millionen Zapfen) und reagieren schon auf kleine Lichtmengen. Sie dienen hauptsächlich dem Dämmerungssehen und erlauben keine Unterscheidung zwischen 11 Abbildung 1.7: Schematische Darstellung des Aufbaus von Stäbchen- und Zapfenzellen Abbildung 1.8: Normalisierte spektrale Empfindlichkeitskurven von S-, M- und L-Zapfen, Grau: Summe der drei Kurven, also die spektrale Hellempfindlichkeitskurve für das Tagsehen 12 Farben, da alle Stäbchen dasselbe Empfindlichkeitsspektrum haben. Zapfen sind weniger lichtempfindlich als Stäbchen, das heißt sie benötigen größere Lichtmengen um ein Signal liefern zu können. Beim Menschen existieren drei verschiedene Arten von Zapfen, die sich hinsichtlich ihrer spektralen Empfindlichkeit unterscheiden. Die S-Zapfen decken den kurzwelligen Bereich des sichtbaren Lichts ab, ihre größte Empfindlichkeit liegt bei etwa 420 nm. M-Zapfen haben ihre größte Empfindlichkeit im mittleren Bereich des sichtbaren Lichts bei etwa 535 nm. L-Zapfen schließlich decken den langwelligen Bereich ab, ihre größte Empfindlichkeit liegt bei etwa 565 nm. Die spektralen Empfindlichkeiten sind somit nicht gleichmäßig über das sichtbare Spektrum verteilt, die Empfindlichkeit der M-Zapfen liegt relativ nahe an der der L-Zapfen. Zudem überlappen sich die Empfindlichkeiten der drei Zapfenarten, diese Überlappung ist besonders ausgeprägt zwischen den M- und L-Zapfen. (siehe Abbildung 1.8). Stäbchen und Zapfen unterscheiden sich hinsichtlich ihrer Form (aus der sich ihre Bezeichnungen ableiten), der benötigten Lichtmenge um ein Signal auszusenden sowie ihrer spektralen Empfindlichkeit, ihr grundsätzlicher Aufbau ist jedoch gleich. In dem so genannten Außensegment befinden sich Photopigmente, die unter Lichteinfall ihre Struktur verändern. Dadurch wird ein biochemischer Prozess angestoßen, der zu einer Änderung des elektrischen Potentials der Zelle führt. Stäbchen und Zapfen sind mit Nervenzellen (Neuronen) verbunden. Nervenzellen bestehen aus einem Zellkörper, der als Soma bezeichnet wird und Zellfortsätzen zum Empfangen und Senden von Signalen (siehe Abbildung 1.9). In der Regel enthält eine Nervenzelle mehrere Fortsätze die dem Empfang von Signalen dienen, die Dendriten. Diese teilen sich oftmals in sich nochmals baumartig auf, somit kann ein Neuron Signale von vielen anderen Neuronen empfangen. Jede Nervenzelle enthält jedoch maximal einen Fortsatz um selber Signale auszusenden, dieser wird als Axon bezeichnet. Das Axon teilt sich an seinem Ende oftmals baumförmig auf und kann somit Signale an Dendriten mehrerer anderer Neuronen weitergeben. Die Kontaktstellen zwischen Nervenzellen und anderen Zellen bzw. anderen Nervenzellen werden als Synapsen bezeichnet. Am Axon der sendenden (presynaptischen) Zelle werden als Neurotransmitter bezeichnete chemische Stoffe ausgeschüttet. Diese werden von der empfangenden (postsynaptischen) Zelle aufgenommen und bewirken entweder eine Anregung, oder eine Hemmung der elektrischen Aktivität in der empfangenden Zelle. Eine Synapse ist dabei unidirektional aufgebaut, d.h. ein Signal kann nur in eine Richtung übertragen werden. Überraschenderweise bewirkt die durch Lichteinfall ausgelöste Potentialveränderung der Photorezeptoren nicht eine Erhöhung sondern eine Abnahme des Austauschs von Botenstoffen mit den verbundenen Nervenzellen. Stäbchen und Zapfen signalisieren also eintreffendes Licht durch Verringerung der Anzahl der von ihnen ausgesandten Neurotransmitter. 13 Abbildung 1.9: Aufbau einer Nervenzelle Man würde erwarten, dass sich Stäbchen und Zapfen auf der dem Licht zugewandten Seite der Retina und die Nervenzellen dahinter befinden. Tatsächlich ist es jedoch genau umgekehrt. Unter einem Mikroskop lassen sich zehn Schichten (von der Aderhaut hin zum Glaskörper) innerhalb der Retina erkennen: (vgl.: Abbildung 1.10) • (1) Retinales Pigmentepithel: Diese äußerste Schicht der Netzhaut erfüllt mehrere Funktionen: Zum einen bildet sie eine Schranke, die das Eindringen von Blut in die Retina verhindert, zum anderen enthält sie Melanin, einen schwarzen Farbstoff mit dem Licht, das die Retina komplett durchquert hat, absorbiert wird. Außerdem dienen die Zellen in dieser Schicht der Versorgung der Photorezeptoren mit den Stoffen, die für die dort stattfindenden chemischen Reaktionen nötig sind sowie der Entsorgung abgestoßener Stoffe. • (2) Schicht der Photorezeptoren: In dieser Schicht liegen die Außensegmente der Stäbchen- und Zapfenzellen, die lichtempfindliche Pigmente enthalten. • (3) Externe Grenzmembran: Dünne Schicht stützender Fasern (Müllersche Stützfasern) • (4) Äußere Kernschicht: In dieser Schicht befinden sich die Zellkörper und Zellkerne der Stäbchen- und Zapfenzellen. • (5) Äußere plexiforme Schicht: Hier treffen die synaptischen Enden der Stäbchen- und Zapfenzellen auf die Dendriten der davor liegenden Nerven14 Pigment epithelium Photoreceptor layer External limiting membrane Outer nuclear layer Outer plexiform layer Inner nuclear layer Inner plexiform layer Ganglion cell layer Nerve fiber layer Inner limiting membrane Light Abbildung 1.10: Mikrofotografie der Retina, Quelle: Neuroscience Tutorial der Washington University School of Medicine (http://thalamus.wustl.edu/course/) zellen. Es bestehen in der Regel keine eins zu eins Verbindungen zwischen Photorezeptoren und Nervenzellen, ein Rezeptor kann sein Signal an viele Nervenzellen weiterleiten und eine Nervenzelle kann Signale von vielen Rezeptoren empfangen. Somit findet hier eine erste Informationsverarbeitung statt. • (6) Innere Kernschicht: Diese Schicht enthält hauptsächlich Zellkörper und Zellkerne verschiedener Arten von Neuronen. Man unterscheidet zwischen Bipolarzellen (verbinden Photorezeptoren mit Ganglienzellen), Horizontalzellen (bilden seitliche Verschaltungen an den Schnittstellen zwischen Photorezeptoren und Bipolarzellen) und Amakrine Zellen (bilden seitliche 15 Verbindungen zwischen Neuronen). • (7) Innere plexiforme Schicht: Hier treffen Axone aus Zellen der Inneren Kernschicht auf Dendriten der Ganglienzellen. • (8) Ganglionzellschicht: In dieser Schicht befinden sich die Ganglien, spezielle Neuronen, deren Dendriten die Fasern des Sehnervs bilden. • (9) Nervenfaserschicht: Diese Schicht besteht aus den eben beschriebenen Nervenfasern, die über den blinden Fleck das Auge verlassen. • (10) Innere Grenzmembran: Glaskörper hin. Sie bildet die Grenze der Retina zum Die einzelnen Schichten sind jedoch nicht über die gesamte Netzhaut homogen, man teilt die Netzhaut in vier Bereiche mit unterschiedlichem Aufbau ein. Der äußere Bereich der Retina wird als Netzhautperipherie bezeichneten. Die Anzahl der Photorezeptoren ist relativ zur Fläche gering, dabei überwiegen Stäbchen über Zapfen. Es findet eine starke Informationsreduktion statt, d.h. viele Photorezeptoren sind mit einer Ganglienzelle verschaltet, was dazu führt, dass die Auflösung der Wahrnehmung in diesem Bereich gering ist. Die Perifovea schließt an die Netzhautperipherie nach innen an und hat einen Durchmesser von etwa 5,5 mm. Hier ist die Stäbchendichte am höchsten, die Anzahl von Ganglienzellen nimmt deutlich zu. Weiter innen liegt die Paravovea mit einem Durchmesser von etwa 2,5 mm. Hier nimmt der Anteil der Stäbchen stark ab, die absolute Anzahl an Photorezeptoren steigt jedoch. Das Maximum der Rezeptorendichte wird in der Fovea (auch als Sehgrube bezeichnet) erreicht. Dies ist der Bereich der größten Sehschärfe und der Punkt, auf den das Abbild eines fixierten Punktes projiziert wird. Die Fovea hat einen Durchmesser von etwa 1,5 mm und bildet eine Grube in der Netzhaut, in der die Dicke der Schichten 5 bis 9 stark abnimmt. Somit können einfallende Lichtstrahlen die Photorezeptoren ungehindert erreichen. Die Signale der Rezeptoren der Retina werden über Ganglienzellen der Perifovea weitergeleitet. In der Fovea kommen nur Zapfen vor, diese sind extrem dicht gepackt (insgesamt befinden sich in der Fovea etwa 100.000-150.000 Zapfen), so dass sich die Dicke von Schicht 2 bis 4 erhöht. Die Zahl der Ganglienzellen im Verhältnis zur Zahl der Photorezeptoren ist sehr hoch, somit werden die Signale der Rezeptoren in der Fovea praktisch ohne Informationsreduktion in das Gehirn weitergeleitet. Perifovea, Paravovea und Fovea werden häufig unter dem Begriff Gelber Fleck (Macula Lutea) zusammengefasst. Etwa 4 mm in nasaler Richtung von dem gelben Fleck entfernt befindet sich der auch als Papilla bezeichnete blinde Fleck, in dem der Sehnerv sowie die zur Versorgung des Auges dienenden Blutgefäße in 16 Abbildung 1.11: Aufnahme der menschliche Retina durch ein Ophthalmoskop, Quelle: http://webvision.med.utah.edu 17 dieses eintreten (siehe Abbildung 1.11). Der blinde Fleck ist oval geformt (vertikalen Ausdehnung etwa 2 mm, horizontale Ausdehnung etwa 1,5 mm) und unterbricht den Schichtenaufbau der Netzhaut, d.h. an dieser Stelle befinden sich keine Photorezeptoren. Somit entsteht eine Lücke im Gesichtsfeld, die aber normalerweise durch das Bild des anderen Auges und Interpolation der Umgebung aufgefüllt wird. Konstruiert man ein Szenario, in dem diese beiden Mechanismen nicht greifen, so kann man die Lücke im Sichtfeld beobachten (siehe Abbildung 1.12). X O Abbildung 1.12: Visualisierung der Lücke im Sichtfeld aufgrund des blinden Flecks: Bei Fokussierung des “X” bei verdecktem linken Auge aus etwa 30 cm Entfernung verschwindet das “O”. 1.2.3 Signalverarbeitung im Auge Wir haben im vorangegangenen Kapitel gesehen, dass die Photorezeptoren des Auges Licht in Signale umwandeln, die sie an ein mehrschichtiges Netz aus Nervenzellen weiterleiten. Inhalt dieses Kapitels wird Art und Weg dieser Signale sein. Das menschliche Auge enthält 125 Millionen Stäbchen und Zapfen, aber nur eine Million Ganglienzellen, die Informationen zum Gehirn weiterleiten. Das heißt auf ein Feld von 11x11 Sensoren kommt nur eine Signalleitung zum Gehirn, es muss also bereits eine Signalvorverarbeitung im Auge stattfinden. Tatsächlich werden wir sehen, dass die Ganglienzellen nicht ein reines Abbild der aktuellen Helligkeitsverteilung auf der Retina, sondern Informationen über die räumliche und zeitliche Verteilung des Lichts zum Gehirn senden. Die erste Stufe der Vorverarbeitung erfolgt in den Horizontalzellen. Diese unterscheiden sich von gewöhnlichen Nervenzellen darin, dass sie über kein Axon verfügen, stattdessen besitzen sie die Fähigkeit über ihre Dendriten sowohl Signale zu empfangen, als auch auszusenden. Die Dendriten der Horizontalzellen enden an den Schnittstellen zwischen Photorezeptoren und Bipolarzellen, somit werden mehrere Rezeptoren zu einem Verbund verschaltet. Sendet ein Photorezeptor ein Signal aus, so bewirkt dieses eine Hemmung der anderen, mit der gleichen Horizontalzelle verbundenen, Rezeptoren. Umgekehrt wirken Rezeptoren, die kein 18 Abbildung 1.13: Machsche Streifen: An den Grenzen zwischen homogenen Graustufen werden nicht vorhandene helle bzw dunkle Streifen erkannt. oder nur ein sehr schwaches Signal aussenden anregend auf andere Rezeptoren im Verbund. Dieser Mechanismus wird als laterale Hemmung bezeichnet. Dabei ist diese Hemmung bzw. Anregung umso stärker, je näher die Rezeptoren beieinander liegen. Dies führt dazu, dass Helligkeitsübergänge intensiviert werden, es findet also eine Kontrastverstärkung statt. Der eben beschriebene Aufbau liefert die Erklärung für eine optische Täuschung, die unter dem Begriff Machsche Streifen oder auch Machbänder bekannt ist (siehe Abbildung 1.13): An der Grenze zwischen zwei Flächen homogenen Grauwerts erkennen wir einen vermeintlich helleren Streifen im hellen Bereich und einen vermeintlich dunkleren Streifen im dunklen Bereich. Betrachten wir die in Abbildung 1.14 schematisch dargestellte Kante zwischen einem, von den Rezeptoren 1 bis 5 abgedeckten, homogen hellen Bereich und einem homogen dunklen Bereich, in dem die Rezeptoren 6 bis 10 liegen. Ohne gegenseitige Beeinflussung würden die Rezeptoren 1 bis 5 das gleiche hohe Signal und die Rezeptoren 6 bis 10 das gleiche kleine Signal liefern. (Dargestellt durch die gestrichelte Linie.) Sind die Rezeptoren jedoch wie beschrieben über eine Horizontalzelle verbunden, so wird das Signal von Rezeptor 3 abgeschwächt, da seine Nachbarn 2 und 4 sowie 1 und 5 ebenfalls durch Licht angeregt wurden und somit auf ihn hemmend einwirken. Das Signal von Rezeptor 4 wird ebenfalls abgeschwächt, allerdings weniger stark, denn seine direkten Nachbarn 3 und 5 wirken zwar hemmend auf ihn, seine indirekten Nachbarn 2 und 6 heben sich 19 1 2 3 4 5 6 7 8 9 10 Abbildung 1.14: Auswirkungen der horizontalen Verschaltung an einer Hell/Dunkel-Kante. (siehe Text) jedoch in ihrer Wirkung auf. Die Rezeptoren 5 und 6 liefern Signale, die von der Verschaltung in der Horizontalzelle nicht beeinflusst werden, da sie in ihrer Umgebung über ebenso viele hemmende wie anregende Nachbarn verfügen. Die Rezeptoren 7 und 8 wiederum senden ein leicht erhöhtes Signal, da in ihrer Umgebung anregende Nachbarn überwiegen. Wir haben gesehen, dass Horizontalzellen lokale Helligkeitsunterschiede verstärken und in homogenen Bereichen hohe Signale verringern sowie niedrige Signale erhöhen. Dies führt aber nicht nur zu der beschriebenen Kontrastverstärkung, sondern ist essentiell für die Helligkeitsadaption des Auges. Horizontalzellen dienen nur der lateralen, also seitlichen Verschaltung der Photorezeptoren, die Weiterleitung der Signale wird von den Bipolarzellen übernommen. Diese treten in verschiedenen Formen auf: OFF-Bipolarzellen reagieren auf hohe Neurotransmitterausschüttung der Photorezeptoren, also auf Dunkelheit, ON-Bipolarzellen hingegen auf niedrige Rezeptoraktivität, also Helligkeit. Zapfen sind sowohl mit ON- als auch mit OFF-Bipolarzellen verbunden, dies dient, ebenso wie die Horizontalzellen, zur Kontrastverstärkung. Dazu sind mit den finalen Neuronen der Retina, den Ganglienzellen, sowohl ON-Bipolarzellen eines Rezeptors, als auch OFF-Bipolarzellen benachbarter Rezeptoren verbunden. Somit werden Hell-Dunkel-Unterschiede verstärkt. Stäbchen sind nur mit speziellen ON-Bipolarzellen verbunden, diese geben ihre Signale jedoch nicht direkt an Ganglienzellen weiter, sondern sind über Amakrine Zellen mit Zapfen-Bipolarzellen verbunden. Die Signale der Stäbchen reisen also sozusagen Huckepack auf den Signalwegen der Zapfen. In der Regel ist eine Stäbchenbipolarzelle mit vielen Stäbchen verbunden, somit findet eine Addition der einzelnen Signale statt, was die Chance erhöht, dass die Bipolarzelle reagiert, aber eine Reduktion der räumlichen Auflösung bedeutet. 20 Amakrine Zellen dienen nicht nur zur Anbindung der Stäbchen-Bipolarzellen an Zapfen-Bipolarzellen, sondern bilden vermutlich die wichtigste Stufe der retinalen Informationsverarbeitung. Ebenso wie die Horizontalzellen besitzen die meisten Amakrinen Zellen kein Axon, sondern senden Informationen über ihre Dendriten. Eine weiter Gemeinsamkeit ist, dass sie nicht Teil des direkten Informationsweges von den Photorezeptoren zum Gehirn sind, sondern laterale Verbindungen bilden, allerdings nicht wie die Horizontalzellen an der Schnittstelle zwischen Rezeptoren und Bipolarzellen, sondern eine Ebene höher, an der Schnittstelle zwischen Bipolarzellen und Ganglienzellen. Es lassen sich anatomisch etwa 25-30 verschiedene Typen unterscheiden, ihr Zweck und ihre Funktionsweise ist jedoch noch in weiten Bereichen unbekannt. Man vermutet, dass sie eine weitere Stufe der Kontrastverstärkung und Helligkeitsadaption bilden sowie für die Erkennung von Bewegungen verantwortlich sind. Die letzte Stufe der Informationsverarbeitung im Gehirn bilden die Ganglienzellen. Ihre Axone verlassen als Sehnerv das Auge und bilden die Verbindung zum visuellen Cortex des Gehirns. Ganglienzellen erhalten in der Regel Signale von mehreren Bipolarzellen, welche wiederum Signale von verschiedenen Photorezeptoren empfangen. Bedenkt man nun noch die Auswirkungen der Horizontalund Amakrinen Zellen erkennt man, das dieses Signal Ergebnis einer Zusammenfassung von Informationen aus einem größeren Einzugsgebiet ist. Dieses Einzugsgebiet einer Ganglienzelle wird als ihr rezeptives Feld bezeichnet. Das rezeptive Feld einer Ganglienzelle besteht in der Regel aus einem Zentrum und einem Umfeld mit gegensätzlichem Stimulus. Bei ON-Center-Ganglienzellen wird die stärkste Reaktion ausgelöst, wenn das Zentrum des rezeptiven Feldes beleuchtet und die Umgebung dunkel ist, bei OFF-Center-Ganglienzellen ist es genau umgekehrt. Ist das gesamte rezeptive Feld homogen beleuchtet wird keine (oder nur eine sehr geringe) Reaktion ausgelöst. Die rezeptiven Felder der Ganglienzellen sind dabei nicht disjunkt, sondern überlappen sich stark. 1.2.4 Retinale Farbverarbeitung Wir haben bisher gesehen, dass das menschliche Auge über drei verschiedene Zapfenarten verfügt, die für unterschiedliche, aber überlappende Spektralbereiche empfindlich sind. Dieser anatomische Aufbau deckt sich mit der Young-Helmholtzschen Theorie des Trichromatischen Farbsehens. Sie beruht auf der Erkenntnis, dass durch die Mischung von Licht dreier weit von einander entfernt liegenden Wellenlängen alle Farben erzeugt werden können. Eine erste Erklärung dieses Phänomens lieferte Thomas Young. Er vermutete, dass auf der Netzhaut drei Arten von Partikeln vorhanden sein müssten, die für die Farben Rot, Grün und Violett empfindlich seien. Helmholtz baute die Theorien Youngs aus, er führte die Unterscheidung zwischen 21 der additiven Mischung von Licht und der subtraktiven Mischung von Pigmenten ein, die erklärt warum beispielsweise die Mischung von gelber und blauer Farbe grün, die Mischung von gelbem und blauem Licht jedoch weiß ergibt. Im Gegensatz zu den Überlegungen Youngs und Helmholtzs stand die Gegenfarbtheorie Ewald Herings. Er beobachtete, dass keine Farben existieren, die man als gelbliches Blau oder rötliches Grün bezeichnen würde, sehr wohl aber alle anderen Kombinationen dieser Grundtöne. Er schlussfolgerte, dass für das Farbsehen drei Prozesse verantwortlich seien: Einer für das Blau-Gelb-Sehen, einer für das Rot-Grün-Sehen und einer für das Hell-Dunkel-Sehen. Tatsächlich schließen sich beide Ansichten nicht aus. Die Signale der drei Zapfenarten werden nicht direkt an das Gehirn weitergeleitet, stattdessen findet eine Vorverarbeitung innerhalb des Netzes aus Horizontal-, Bipolar-, amakrinen und Ganglienzellen statt, in der die Signale der L- und M-Zapfen miteinander verglichen werden (Rot-Grün-Prozess). Das Ergebnis wiederum wird mit den Signalen der S-Zapfen ins Verhältnis gesetzt (Gelb-Blau-Prozess). Mit diesem Wissen ist es uns möglich das Phänomen der Metamere, unterschiedlicher Spektralverteilungen, die aber den gleiche Farbeindruck hervorrufen zu erklären. Nehmen wir an, monochromatisches Licht einer Wellenlänge von etwa 650 nm trifft auf unsere Netzhaut. In diesem Fall werden M- und L-Zapfen etwa gleich stark erregt, der resultierende Farbeindruck ist gelb. Der selbe Eindruck kann jedoch auch erzielt werden, wenn gleichzeitig monochromatisches Licht der Wellenlänge 600nm und monochromatisches Licht der Wellenlänge 700 nm auf die Netzhaut projiziert wird (siehe Abbildung 1.8 auf Seite 12). 1.2.5 Informationsverarbeitung im Gehirn Die vorverarbeiteten Signale gelangen über den Sehnerv zur primären Sehrinde (visueller Cortex) im hinteren Teil des Gehirn. Hier werden aus den Signalen des rechten und linken Auges Tiefeninformationen generiert, die genutzt werden bekannte Formen und Körper im Bild zu erkennen. Die dabei ablaufenden Vorgänge sind hochgradig komplex und bisher nur zum Teil erforscht. Wir wollen uns deshalb hier darauf beschränken ein Modell einzuführen, mit dem die Leistungsfähigkeit neuronaler Signalverarbeitung demonstriert werden kann. Wir haben bereits gesehen, dass Neuronen über mehrere “Eingänge”, die Dendriten, und einen “Ausgang”, das Axon, verfügen. Ein Ausläufer des Axons einer Nervenzelle kann sein Signal an ein Dendrit einer anderen Nervenzelle weitergeben, die Verbindung zwischen Axon und Dendrit wird als Synapse bezeichnet. Eine Synapse ist immer unidirektional und kann entweder anregende (exhibitorische) oder hemmende (inhibitorische) Wirkung auf das angeschlossene Neuron haben. Eine Nervenzelle sendet ein Signal über ihr Axon aus, wenn die Differenz zwischen über anregenden Synapsen eintreffenden Signalen und über hemmenden 22 Synapsen eintreffenden Signalen einen festen Schwellwert überschreitet. t hemmende Eingänge anregende Eingänge Abbildung 1.15: Graphische Darstellung eines Neurons als Schaltelement Dieses Modell der Funktionsweise eines Neurons repräsentieren wir graphisch wie in Abbildung 1.15 dargestellt: Das Neuron wird als Kreis mit einer horizontalen Trennlinie repräsentiert. Unterhalb der Trennlinie wird der Schwellwert angegeben, der festlegt wie viele Signale zum Aussenden eines Signals nötig sind. Eingänge werden als Linien dargestellt, die den Kreis in der unteren Hälfte treffen. Dabei sind anregende Eingänge mit einer Pfeilspitze und hemmende Eingänge mit einem Kreis markiert. Der Ausgang des Axons wird durch eine Linie dargestellt, die den Kreis an seinem oberen Ende verlässt. Folgende Abbildung zeigt ein Neuron, das mit sechs Photorezeptoren verbunden ist, von denen drei ein Signal aussenden: 3 1 0 1 0 1 0 An jedem der drei exhibitorischen Eingänge liegt ein Signal an, alle inhibitorischen Eingänge empfangen kein Signal. Somit errechnet sich der effektive Si23 gnaleingang als 3 − 0 = 3. Dies ist größergleich dem Schwellwert des Neurons von 3, somit sendet es ein Signal über seinen Ausgang aus. Wir sagen es feuert. Die nächste Abbildung zeigt das gleiche Neuron, allerdings haben sich die Signale an seinen Eingängen verändert: 3 1 0 1 1 1 0 Es liegt zwar immernoch an allen exhibitorischen Eingängen ein Signal an, allerdings empfängt nun auch einer der inhibitorischen Eingänge ein Signal. Der effektive Signaleingang ist nun 3 − 1 = 2, dies liegt unterhalb des Schwellwerts des Neurons, somit feuert es nicht. Wir können nun einfache logische Operatoren durch neuronale Netze simulieren: a) Und-Verknüpfung b) Oder-Verknüpfung A∧B A∨B 2 A 1 B c) Negation A ¬A 1 B A Die bislang vorgestellten Netze waren einstufig, das heißt ein zum Zeitpunkt t0 eintreffendes Signal bestimmt den Signalausstoß zum Zeitpunkt t0 +1. Kompliziertere Netze benötigen jedoch einen mehrstufigen Ausgang. Ein Beispiel wäre folgendes Netz, das den XOR-Operator simuliert: 24 A xor B = (A ∧ ¬B) ∨ (¬A ∧ B) 1 1 A 1 B Eine Eingabe zum Zeitpunkt t0 bestimmt die Ausgabe des Netzes erst zum Zeitpunkt t0 + 2. Beim Aufbau größerer Netze muss darauf geachtet werden, dass miteinander verschaltete Teilnetze ihre Ergebnisse zum richtigen Zeitpunkt ausgeben. Dazu kann es nötig sein Delay-Bausteine einzufügen. Diese entsprechen dem Negations-Netz, allerdings wird der Eingang nicht negiert. 1.3 Digitale Bildaufnahme Mittels digitaler Aufnahmegeräte, wie Scanner und CCD/CMOS-Kameras, lassen sich Bilder in digitaler Form erstellen und mit Computern weiterverarbeiten. Die digitale Aufnahmetechnik ist, im Gegensatz zum menschlichen Auge, nicht auf das sichtbare Spektrum limitiert. Durch geeignete Sensoren lassen sich auch Bereiche des nicht sichtbaren Spektrums abbilden (siehe Abbildung 1.16). Die in der Bildverarbeitung verbreiteste Methode Bilder zu erzeugen, ist die digitale Videokamera bzw. der digitaler Fotoapparat. Die digitale Kamera transformiert Abbildungen der Realität in digitale Signale, die von einem Rechner weiterverarbeitet werden können. Das elementare Bauteil ist der Fotochip. Bei der Aufnahme eines Bildes werden die, von einem Objekt ausgesandten Lichtstrahlen, durch die Optik einer Kamera gebündelt und auf einen Fotochip umgeleitet. Der Fotochip besteht aus einer Matrix von lichtempfindlichen Zellen, die die Menge des einfallenden Lichts misst, und mittels einer Ausleseelektronik und A/D-Wandlern in ein digitales Signal umwandelt. 25 (b) Gleiche Szene im Infrarotbereich von 7001000 nm (a) Natürliche Szene (c) Bild des Ultravioletten Spektrums der Sonne Abbildung 1.16: Beispiele von digitalen Bildern 1.3.1 Der Photosensor Es gibt im Wesentlichen zwei populäre Arten von digitalen Fotochips: den CCD (engl. charge coupled device)- und den CMOS-Fotochip (engl. Complementary Metal Oxide Semiconductor). Ein Fotochip besteht aus einer großen Anzahl von lichtempfindlichen Zellen, wovon jede dieser Zellen die Menge“ des auf ” sie einfallenden Lichts misst. Die gemessene Lichtmenge wird durch AnalogDigital-Wandler (A/D-Wandler) in binäre Signale umgewandelt und durch geeignete Schnittstellen an weiterverarbeitende Geräte, wie Computer, Videorekorder, Fernseher, u. ä. übertragen. CCD-Fotochip Ein CCD-Fotochip (vergleiche 1.17) arbeiten in zwei Phasen: der Akkumulations- und Auslesephase. Während der Akkumulationsphase wan26 Abbildung 1.17: Ladungstransport in einem CCD-Fotochips deln die lichtempfindlichen Zellen mittels des lichtelektrischen Effekts Lichtphotonen in elektrische Ladung um, und sammelt diese. Die Menge der gesammelten Ladung wächst proportional in Abhängigkeit der Beleuchtungsstärke und -dauer. In der Auslesephase werden die Ladungen der einzelnen Sensorzellen einer Spalte in vertikale Schieberegistere übertragen. Die Ladungen innerhalb einer Zeile, werden suksessiv in ein horizontales Schieberegister verschoben und diesem sequentiell ausgelesen. Durch diesen speziellen Auslesemechanismus kann die Ladung einer Sensorzelle nicht beliebig ausgelesen werden. Ein Bild muss immer als ganzes aus dem Chip ausgelesen werden. Jede lichtempfindliche Zelle hat eine maximale Kapazität und kann nur begrenzt Ladungen speichern. Fällt eine zu hohe Lichtmenge auf eine Zelle verteilt sich die überschüssige Ladungen auf die umliegenden Zellen und erhöht die dort bereits gespeicherten Ladungen. Dieser Effekt wird Blooming genannt. Im Bild äußert sich Blooming durch das Überstrahlen von hellen Bereichen in die Umge27 Abbildung 1.18: Beispiel des Blooming-Effekts. Der helle Bereich überstrahlt teilweise die Braumkronen bung (siehe Abbildung 1.18). CMOS-Fotochip Im Gegensatz zu den lichtempfindlichen Zellen eines CCDFotochips verfügen die lichtempfindlichen Zellen eines CMOS-Fotochips bereits über integrierte Verstärker und A/D-Wandler. Dadurch wird ein beliebiger Zugriff auf die Ladungsinformationen einzelner Zellen ermöglicht. Durch die integrierte Elektronik einer jeden Zelle, ist die lichtempfindliche Fläche bezogen auf die Chipfläche, auch Fillfaktor genannt, kleiner als bei gleichgroßen CCDFotochips. CMOS-Fotochips neigen daher zu erhöhtem Bildrauschen und besitzen einen geringeren Dynamikumfang als vergleichbare CCD-Fotochips. Dieser Nachteil kann durch Verwendung einer Mikrolinsenstrukur verringert werden, die das auf die komplette Zelle einfallende Licht gebündelt auf den lichtempfindlichen Teil der Zelle abbildet. Der geringere Stromverbrauch und die geringen Kosten von CMOS-Fotochips im Vergleich zu CCD-Fotochips machen sie besonders attraktiv für den Einsatz von mobilen Geräten wie z.B. Kamerahandys. 1.3.2 Farbkameras Die lichtempfindlichen Zellen auf einem Photochip sind prinzipiell nur in der Lage die Lichtstärke von einfallendem Licht zu messen. Das Resultat ist ein monochromatisches Bild ohne jegliche Farbinformation. Zur Erzeugung von Farb 28 Einchip-Kamera In einer Einchip-Kameras wird nur einziger Photochip verwendet, um ein Farbbild zu erzeugen. Um die Farbanteile des roten, grünen bzw. blauen Lichts zu messen, wird auf jeder lichtempfindlichen Zelle jeweils ein Farbfilter angebracht, der idealerweise nur für einen bestimmten Wellenlängenbereich des Lichts transparent ist und Licht aller übrigen Wellnlängen absorbiert. In der Regel werden rot-, grün- bzw. blau-empfindliche Farbfilter verwendet. Die Farbfilter sind in einem sogenannten Mosaikmuster abwechselnd auf dem Chip aufgebracht. Abbildung 1.19 zeigt das gebräuchliche Bayermuster. Da der Mensch viel mehr Grün- als Rot oder Blautöne unterscheiden kann, ist jeder zweite Farbfilter des Bayermusters ein Grünfilter, aber nur jeder vierte ein Rot- bzw. Blaufilter. Der wesentliche Nachteil von Einchip-Kamera ist, dass die Farbe des Lichts an einem Ort nicht mit genau einer Zelle gemessen werden kann. Die Farbe eines Bildpunktes muss aus den den Messungen von mehreren nebeneinander liegenden Zellen interpoliert werden. Dieser Vorgang wird als Demosaicing bezeichnet. Durch Interpolationsfehler an den Grenzen von kontrastreichen Bildbereichen können Farbsäume an Übergängen von aneinander grenzenden, farblich unterschiedlichen Bereichen im Bild auftreten. G R B G G R B G G B G B R G R G Abbildung 1.19: Verteilung von Farbfiltern auf einem Fotochip (Bayer-Muster) Dreichip-Kameras Dreichip-Kameras vermeiden den Nachteil der EinchipKameras durch die Verwendung von drei separaten Fotochips zur Erfassung des Rot-, Grün- und Blauanteils des Lichtes. Mittels eines optischen Prismas (Strahlenteiler) werden die Wellenlängenbereiche des roten, grünen und blauen Lichtes unterschiedlich stark gebrochen und auf jeweils einen Fotochip gelenkt. Durch das Prisma wird selbst das rote, grüne bzw. blaue Licht, welches aus unterschiedlichen Wellenlängen besteht, weiter aufgefächert. Vor jedem Fotochip sind daher wiederum Farbfilter angebracht, die unerwünschte Wellenl ängen des Lichtes herausfiltern. Mittels einer Dreichip-Kamera können die Rot-, Grün- und Blauanteile des Lichts an einem Bildpunkt gleichzeitig gemessen werden. Dies ist mit einer Einchip-Kamera nicht möglich, da die Rot-, Grün- und Blauanteile eines Bildpunktes aus den Messungen mehrerer Zellen interpoliert werden müssen. 29 Abbildung 1.20: Prinzip einer Dreichip-Kamera 30