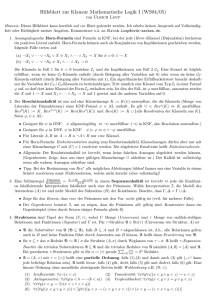

Link nach den Folien zu Aussagenlogik

Werbung