MidPerm - Realisierung einer Provenance SQL

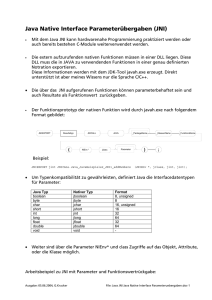

Werbung