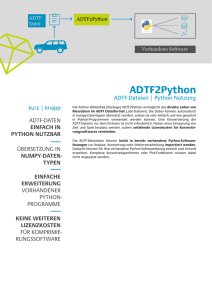

die papiersparende Variante

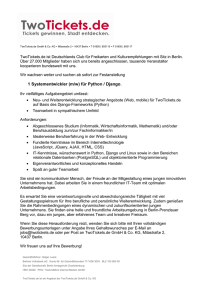

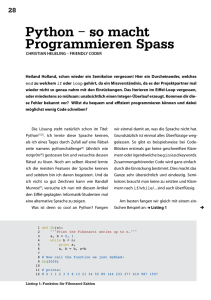

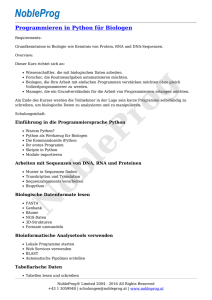

Werbung