Oracle Endeca Information Discovery @ Fin Serv_Jan_2014

Werbung

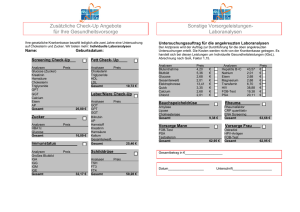

Oracle Endeca Information Discovery für Financial Services - Risk Management & Risk Controlling Anforderungen Die Anforderungen an das Risk Management von Banken sind in den letzten Jahren nicht zuletzt im Zusammenhang mit der Finanzkrise und der Einführung von Basel II / Basel III enorm gestiegen. Risk Manager, welche Risiken falsch bewerten können dafür haftbar gemacht werden. Die korrekte Kenntniss der Risken, welche im Investmentbanking aber auch im Retailbanking lauern hat u.a. direkten Einfluß auf die bereit zu haltenden Risikoreserven und damit auf die Eigenkapitalquote. Ein wesentlicher Arbeitsschritt bei der Beurteilung von Risiken und daraus folgender Handlungen ist, größere Abweichungen von Risikobewertungen, z.B. zwischen aktueller Periode und Vorperiode, erkennen zu können, was mit klassischen BI Mitteln im Allgemeinen relativ einfach zu bewerkstelligen ist. Was nicht mehr ganz so einfach gemacht werden kann, ist sich frei in diesen Daten zu bewegen und damit erforschen zu können, was eigentlich der Grund für diese Abweichungen sind – sind Daten eventuell fehlerhaft in Systemen vorhanden / geliefert worden oder liegt wirklich ein realler Business Case dahinter? Wenn Daten fehlerhaft sind, sind sie natürlich entsprechend zu berichtigen. Wenn ein echter Business Case vorliegt müssen die entsprechenden Fachabteilungen und Ansprechpartner bis evtl. hin zum Vorstand darüber unterrichtet werden und geignete fachliche Maßnahmen ergriffen werden. Hier kommt jetzt Oracle Endeca Information Discovery, kurz: Endeca ins Spiel. Endeca bietet eine Möglichkeit mit „konventionellen“ strukturierten Daten und „unkonventionellen“ semi- oder unstrukturierten Daten umzugehen und ermöglicht hierbei die gewünschten freien Analysen. Unstrukturierte Daten können z.B. Dateien auf bankeigenen Dateiablagen sein, typischerweise PDFs, Word und Excelsheets - aber auch Social Media Daten von Facebook, Twitter und Co., in denen Meinungen zu Kunden oder zum eigenen Institut geäußert werden u.ä. – zusammen mit andere Daten aus dem Web wie zum Beispiel aktuelle Ratings per XML Feed, klassisches Beispiel hierbei sind Ratings der bekannten Ratingagenturen oder aber aktuelle Devisenkurslisten der Notenbanken. Der Endeca Server stellt hierbei dynamische Daten Domänen bereit, welche technisch als Record Stores mit automatischer Indexierung realisiert sind und sich beliebig dynamisch ändern lassen, wobei ein Record einer Kette von Attribut- und Wertpaaren, bzw. Wertlisten entspricht. Es ist damit im Unterschied zu „klassischen“ BI Anwendungen nicht notwendig, ein Datenmodell, etwa ein Star Schema zu modellieren – es langt die Vergleichbarkeit der Daten über gleiche Attributnamen und –werte für Daten aus unterschiedlichen Datenquellen bereitzustellen und in eine gemeinsame Daten Domäne des Endeca Servers zu laden. Dieser stellt dann die Verbindung zwischen den Daten autiomatisch her und ist fungiert gleichzeitig als hybride Search/Analytical Engine. Das bedeutet, dass Google-like Suchfunktionalitäten out-of-the-box vorhanden sind, genauso wie die grundlegenden analytischen Funktionalitäten „klassischer“ BI Lösungen wie Summen, Durchschnitte u.ä., welche im Rahmen einer an SQL angelehnten Abfragesprache (EQL) voll zum Zuge kommen. Im Grunde genommen kann man sich das Arbeiten mit Endeca als eine Art „Data Mining per Hand“ vorstellen, bei der im die Intelligenz vor der Anwendung sitzt anstatt in automatisierten mathematischen Algorithmen verdrahtet zu sein und Endeca den Weg vorgibt beziehungsweise auf vielfältige Art und Weise bei der „Entdeckung“ unterstützt. Der Unterschied von Endeca zu „klassischem BI“ ist also, das jenes auf zumindest vorgedachte Fragen Auskunft gibt, während es Endeca ermöglicht, komplett neue Fragen zu stellen. Einsatzszenario Das Szenario, das ich hier vorstellen möchte geht davon aus, das Mitarbeitern in den zuständigen Fachbereichen - typischerweise sind das die Controlling und Risk Controlling Abteilungen der Unternehmen - die Möglichkeit gegeben werden soll, eigenhändig Risikobewertungen einer Prüfung auf fachliche Korrektheit zu unterziehen beziehungsweise tatsächliche Auffälligkeiten wie etwa große Abweichungen der aktuellen Risikobewertung zur Vorperiode aus den Daten erklären zu können. Im ersten Fall müssen bei fachlichen Fehlern Korrekturen vorgenommen werden – dazu ist es notwendig Listen der fehlerhaften Daten und deren Korrekturen zu erzeugen, welche in das oder die Quellsysteme zurückgespielt werden können. Im zweiten Fall müssen u.U. geignete Maßnahmen zum Umgang mit den Risiken erfolgen, welche auf dem üblichen Weg der Zusammenarbeit innerhalb der Abteilungen erfolgt. Die Visualisierung und der eventuelle Export solcher Fälle in einem geeigneten Format wie CSV erleichtert hierbei erheblich die Argumentation. Es gibt darüber hinaus auch generische Fälle, d.h. fixe Analysen, die jedesmal zu prüfen sind und in Endeca über feststehende EQL Abfragen realisiert werden können. Beispiele dafür sind Abweichungen bestimmter Felder, Nichtvorhandensein von Daten in bestimmten Perioden und ähnliches. Wichtig ist, das solche Fälle auf einen Blick erkannt werden können. Hilfreich ist es auch, gleich Kommentare oder Handlungsanweisungen in solchen Fällen mit auszugeben. Vorgehen Das technische Vorgehen ist dabei wie folgt: Zunächst müssen die Daten aus den Vorsystemen wie z.B. einer Konsolidierungsplattform eines DWH, Risikobewertungen von Agenturen, operationalen Systemen, fachlichen Dokumenten (Excel, Word, PDF,...), Nachrichtenquellen, Blogs und Feeds aus dem WWW und ähnliches gemeinsam in eine Daten Domäne des Endeca Servers geladen werden. Hierzu dient die Komponente „OEID Integrator“, welche ein ETL Tool mit speziellen Funktionalitäten zurm Beladen des „Oracle Endeca Servers“ ist. Es muss lediglich darauf geachtet werden, dass Attribute und dazugehörige Werte gleich benannt werden – genauso wie man es machen würde, wenn man Daten aus verschiedenen Quellen in einem Excelsheet zusammenführt. Das Design eines speziellen Datenmodells, wie es im „klassischen“ BI notwendig wäre, entfällt. Damit ist die Basis gelegt und man kann im Grunde genommen schon mit der freien Analyse der Daten im Webfrontend „OEID Studio“ beginnen, welches die benötigten Komponenten wie Grafiken, Tabellendarstellungen, Detaildarstellungen, Vergleichs-, Suchmöglichkeiten bzw. die geführte Navigation in den Daten nebst Filtrierung neben weiteren Funktionalitäten bereitstellt. Unten ist nochmal die grundlegende Architektur dargestellt: Das Laden der Daten in den Endeca Server geschieht technisch wie schon erwähnt mit Hilfe des Oracle Endeca Integrators. In diesem Screenshot sieht man das Laden von Risikobewertungsdaten und Kommentierungen für die fixen Analysen aus Datenbanktabellen. Es könnten natürlich auch ganz andere Quellen benutzt werden. Nicht dargestellt ist das Laden von internen Kundenbewertungen aus Excelsheets und das Dazuspielen von externen Ratings, welches analog mit Hilfe des Integrators unter Zuhilfenahme von eingebauten Werkzeugen, die eine automatische Text- und Sentimentanalyse erlauben, erfolgen kann. Man beachte, das keine Verteilung der Daten in ein Datenmodell notwendig ist (Operator Bulk Load to Endeca Data Domain): Natürlich sind damit noch keine EQL Views geladen, welche für die fixen Analysen benötigt werden. Man kann das über den Integrator tun oder aber über das Webfrontend die Views definieren: Diese XML Datei, welche die EQL View Definitionen enthält, wird über folgenden ETL Prozess geladen: Alternativ lassen sich EQL Views auch über das Frontend definieren. Es bietet bietet die Möglichkeit, die EQL Query zu validieren und auf die Visualisierung der Attribute Einfluß zu nehmen: Im Allgemeinen macht es Sinn, die Views in einem intitialen Schritt komplett über das Webfrontend zu erzeugen und dann in die XML Datei zu exportieren, welche dann im laufenden Betrieb automatisiert geladen werden kann. Arbeiten im Frontend Nachdem nun die Daten Domäne des Endeca Servers mit den Daten geladen wurde, können die Fachanwender über das Frontend elegant auf die Daten zugreifen und die „Entdeckungstour“ starten. Nachfolgend ist eine Einstiegsseite abgebildet, die es ermöglicht, die wichtigsten Fakten auf einen Blick zu erfassen. Alle Komponenten sind hierbei interaktiv, dass heißt ich kann z.B. in den Daten und Grafiken drillen und bekomme automatisch eine Verfeinerung auf die mit meiner Auswahl verbundenen Atttribute und Werte hin. Das ist der Kern der Guided Navigation: Ich setze Filter und bekomme automatisch zur weiteren Verfeinerung meiner Analyse nur noch die Attribute und Werte angeboten, welche jetzt noch mit den Daten in Verbindung stehen. Genauso kann man mit der Suche arbeiten (hier nicht abgebildet), wo man auch automatisch eine geführte Verknüpfung zu den relevanten Daten und automatisch auch Korrekturvorschläge bekommt, z.B. falls ich mich vertippe oder die genaue Schreibweise eines Begriffes nicht kenne – genauso wie man es von Suchmaschinen wie Google gewohnt ist. Die folgenden zwei Screenshots zeigen die fixen Analysen, welche durch die EQL Views festgelegt wurden und die zusätzlich zu den Daten auch passende Kommentierungen dieser Basisfälle enthalten – Anweisungen an die Bearbeiter der Fachabteilungen, was ein Grund für die Abweichungen sein kömmten sowie Handlungsanweisungen mit ausgeben. Die Berichte können in einfacher Art und Weise als CSV Datei exportiert und weitergegeben werden. Natürlich kann aber auch die eigentliche Stärke von Endeca genutzt werden – die freie Analyse der Daten, das schon erwähnte händische Data Mining, welches unter anderem durch vielfältige Möglichkeiten der Filterung, des Ordnens und Vergleichens von einzelnen Datensätzen bis auf die tiefste Detailebene hinab unterstützt wird. Fazit Oracle Endeca Information Discovery ist das geignete Werkzeug für das Analysieren von Risikobewertungen aber auch für die Untersuchung beliebiger anderer Daten: Sei es Qualitätsicherung von Reportingdaten als auch das Untersuchen von geigneten Big Data Datenscheiben und hat gegenüber „klassischen“ BI Lösungen entscheidende Vorteile auf seiner Seite: Keine explizites Datenmodel nötig ! Hochflexible, beliebig gestalt- und erweiterbare Recordstruktur Daten aus allen denkbaren System und Formaten verknüpfbar Automatische, google-like Suche und Guided Navigation Sowohl freie Analysen als auch fixe Analysen (Reports) möglich Sehr einfach zu bedienendes Frontend und ETL Tool SQL-like Abfragesprache EQL