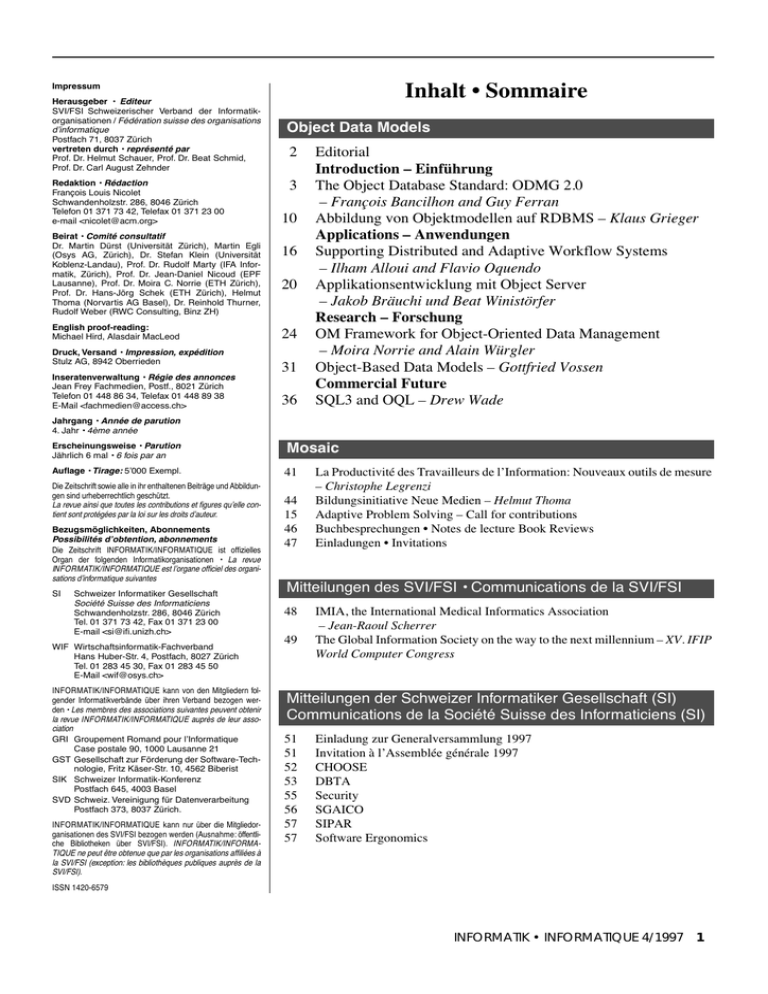

informatik • informatique 4/1997

Werbung