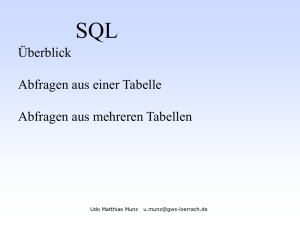

Auswertung von SPARQL-Anfragen mit relationaler Speicherung

Werbung