Juni 2016

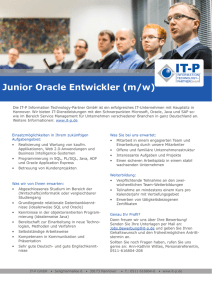

Werbung