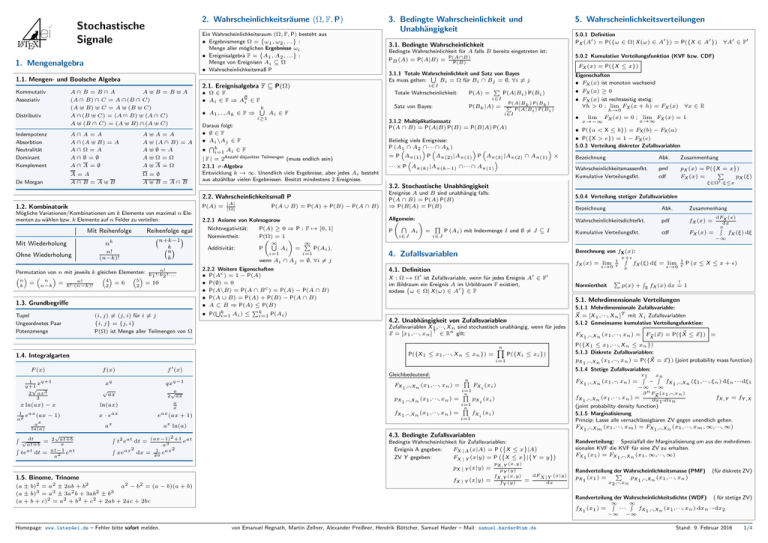

Stochastische Signale

Werbung

4

ei

2. Wahrscheinlichkeitsräume (Ω, F, P)

Stochastische

Signale

*

* kann Spuren von Katzen enthalten

nicht für Humorallergiker geeignet

alle Angaben ohne Gewehr

Ein Wahrscheinlichkeitsraum (Ω, F, P) besteht aus

• Ergebnismenge Ω = ω1 , ω2 , ... :

Menge aller möglichen Ergebnisse ωi

• Ereignisalgebra F = A1 , A2 , ... :

Menge von Ereignisen Ai ⊆ Ω

• Wahrscheinlichkeitsmaß P

1. Mengenalgebra

1.1. Mengen- und Boolsche Algebra

A∩

· B = B∩

· A

A⊎B =B⊎A

(A ∩

· B) ∩

· C = A∩

· (B ∩

· C)

(A ⊎ B) ⊎ C = A ⊎ (B ⊎ C)

A∩

· (B ⊎ C) = (A ∩

· B) ⊎ (A ∩

· C)

A ⊎ (B ∩

· C) = (A ⊎ B) ∩

· (A ⊎ C)

Kommutativ

Assoziativ

Distributiv

Indempotenz

Absorbtion

Neutralität

Dominant

Komplement

A∩

· A=A

A∩

· (A ⊎ B) = A

A∩

· Ω=A

A∩

· ∅=∅

A∩

· A=∅

A⊎A=A

A ⊎ (A ∩

· B) = A

A⊎∅=A

A⊎Ω=Ω

A⊎A=Ω

De Morgan

A=A

A∩

· B =A⊎B

Ω=∅

A ⊎ B = A∩

· B

2.1. Ereignisalgebra F ⊆ P(Ω)

• Ω∈F

• Ai ∈ F ⇒ A∁

i ∈ F

• A1 ,...,Ak ∈ F ⇒

k

S

Mit Wiederholung

Ohne Wiederholung

Mit Reihenfolge

Reihenfolge egal

nk

n+k−1

k

n

k

n!

(n−k)!

n!

Permutation von n mit jeweils k gleichen Elementen: k !·k

1

2 !·...

5

n

4

n

n!

= 10

=6

= n−k = k!·(n−k)!

2

2

k

1.3. Grundbegriffe

Tupel

Ungeordnetes Paar

Potenzmenge

(i, j) ̸= (j, i) für i ̸= j

{i, j} = {j, i}

P(Ω) ist Menge aller Teilmengen von Ω

Bedingte Wahrscheinlichkeit für A falls B bereits eingetreten ist:

PB (A) = P(A|B) =

P(A∩B)

P(B)

P(Bk |A) =

Ai ∈ F

| F | = 2Anzahl disjunkter Teilmengen (muss endlich sein)

2.1.1 σ-Algebra

Entwicklung k → ∞. Unendlich viele Ergebnisse, aber jedes Ai besteht

aus abzählbar vielen Ergebnissen. Besitzt mindestens 2 Ereignisse.

1 xq+1

q+1

√

2 ax3

3

xq

√

ax

qxq−1

x ln(ax) − x

ln(ax)

a

x

x · eax

eax (ax + 1)

1

a2

´

´

f ′ (x)

f (x)

eax (ax − 1)

ax

ln(a)

dt

√

at+b

at

te

=

dt =

√a

2 ax

x

a

√

2 at+b

a

at−1 at

e

a2

= P Aπ(1) P Aπ(2) |Aπ(1) P Aπ(3) |Aπ(2) ∩ Aπ(1) ×

···× P Aπ(k) |Aπ(k−1) ∩···∩ Aπ(1)

h→0

•

FX (x) = 0 ; lim FX (x) = 1

x→∞

x→−∞

Bezeichnung

Abk.

Zusammenhang

Wahrscheinlichkeitsmassenfkt.

Kumulative Verteilungsfkt.

pmf

cdf

pX (x) = P({X = x})

P

pX (ξ)

FX (x) =

P(A) = |Ω|

P(A ∪ B) = P(A) + P(B) − P(A ∩ B)

2.2.1 Axiome von Kolmogorow

Nichtnegativität:

P(A) ≥ 0 ⇒ P : F 7→ [0, 1]

Normiertheit:

P(Ω) = 1 !

∞

∞

S

P

Additivität:

P

Ai =

P(Ai ),

i=1

i=1

wenn Ai ∩ Aj = ∅, ∀i ̸= j

2.2.2 Weitere Eigenschaften

• P(Ac ) = 1 − P(A)

• P(∅) = 0

• P(A\B) = P(A ∩ B c ) = P(A) − P(A ∩ B)

• P(A ∪ B) = P(A) + P(B) − P(A ∩ B)

• A ⊂ B ⇒ P(A) ≤ P(B)

S

Pk

• P( k

i=1 Ai ) ≤

i=1 P(Ai )

5.0.4 Verteilung stetiger Zufallsvariablen

Allgemein: !

T

Q

P

Ai =

P (Ai ) mit Indexmenge I und ∅ =

̸ J ⊆I

i∈J

i∈J

Bezeichnung

Abk.

Zusammenhang

Wahrscheinlichkeitsdichtefkt.

pdf

fX (x) =

Kumulative Verteilungsfkt.

cdf

FX (x) =

dFX (x)

dx

x́

fX (ξ) dξ

−∞

Berechnung von fX (x):

x+ϵ

´

fX (x) = lim 1

fX (ξ) dξ = lim 1

P (x ≤ X ≤ x + ϵ)

ϵ→0 ϵ x

ϵ→0 ϵ

4. Zufallsvariablen

4.1. Definition

X : Ω 7→ Ω′ ist Zufallsvariable, wenn für jedes Ereignis A′ ∈ F′

im Bildraum

ein Ereignis A im Urbildraum F existiert,

sodass ω ∈ Ω| X (ω) ∈ A′ ∈ F

Normiertheit

P

´

!

p(x) + R fX (x) dx = 1

5.1. Mehrdimensionale Verteilungen

4.2. Unabhängigkeit von Zufallsvariablen

Zufallsvariablen X 1 ,···, X n sind stochastisch unabhängig, wenn für jedes

⃗

x = [x1 ,···, xn ]⊤ ∈ Rn gilt:

n

Y

P({X i ≤ xi })

FX 1 ,···,X n (x1 ,···, xn ) =

pX 1 ,···,X n (x1 ,···, xn ) =

fX 1 ,···,X n (x1 ,···, xn ) =

i=1

n

Q

i=1

n

Q

i=1

⃗ ≤⃗

FX 1 ,···,X n (x1 ,···, xn ) = F⃗

(⃗

x) = P({X

x}) =

X

P({X 1 ≤ x1 ,···, X n ≤ xn })

5.1.3 Diskrete Zufallsvariablen:

⃗ =⃗

pX 1 ,···,X n (x1 ,···, xn ) = P({X

x}) (joint probability mass function)

FX (xi )

5.1.4 Stetige Zufallsvariablen:

x

´1 x´n

FX 1 ,···,X n (x1 ,···, xn ) =

···

fX 1 ,···,X n (ξ1 ,···, ξn ) dξn ···dξ1

pX (xi )

fX 1 ,···,X n (x1 ,···, xn ) =

Gleichbedeutend:

n

Q

5.1.1 Mehrdimensionale Zufallsvariable:

⃗ = [X 1 ,···, X n ]T mit Xi Zufallsvariablen

X

5.1.2 Gemeinsame kumulative Verteilungsfunktion:

−∞ −∞

∂ n F⃗ (x1 ,···,xn )

X

∂x1···∂xn

i

i

fX ,Y = fY ,X

(joint probability density function)

5.1.5 Marginalisierung

Prinzip: Lasse alle vernachlässigbaren ZV gegen unendlich gehen.

FX 1 ,···,X m (x1 ,···, xm ) = FX 1 ,···,X n (x1 ,···, xm , ∞,···, ∞)

fX (xi )

i

4.3. Bedingte Zufallsvariablen

Bedingte Wahrscheinlichkeit für Zufallsvariablen:

Ereignis A gegeben:

FX |A (x|A) = P X ≤ x |A

ZV Y gegeben:

FX | Y (x|y) = P X ≤ x | Y = y

fX | Y (x|y) =

pX ,Y (x,y)

pY (y)

fX ,Y (x,y)

fY (y)

=

dFX|Y (x|y)

dx

Randverteilung: Spezialfall der Marginalisierung um aus der mehrdimensionalen KVF die KVF für eine ZV zu erhalten.

FX 1 (x1 ) = FX 1 ,···,X n (x1 , ∞,···, ∞)

Randverteilung der

P Wahrscheinlichkeitsmasse (PMF)

pX 1 (x1 ) =

pX 1 ,···,X n (x1 ,···, xn )

(für diskrete ZV)

x2 ,···,xn

Randverteilung der Wahrscheinlichkeitsdichte (WDF) ( für stetige ZV)

∞

∞

´

´

fX 1 (x1 ) =

···

fX 1 ,···,X n (x1 ,···, xn ) dxn ···dx2

−∞

Homepage: www.latex4ei.de – Fehler bitte sofort melden.

∀x ∈ R

lim

ξ∈Ω′ :ξ≤x

Ereignise A und B sind unabhängig falls:

P(A ∩ B) = P(A) P(B)

⇒ P(B|A) = P(B)

pX | Y (x|y) =

(a ± b)2 = a2 ± 2ab + b2

a2 − b2 = (a − b)(a + b)

(a ± b)3 = a3 ± 3a2 b + 3ab2 ± b3

(a + b + c)2 = a2 + b2 + c2 + 2ab + 2ac + 2bc

• FX (x) ist rechtsseitig stetig:

∀h > 0 : lim FX (x + h) = FX (x)

3.2. Stochastische Unabhängigkeit

a ln(a)

1.5. Binome, Trinome

• FX (x) ≥ 0

x

´ 2 at

(ax−1)2 +1 at

t e dt =

e

a3

´

ax2

1 eax2

xe

dx = 2a

Eigenschaften

• FX (x) ist monoton wachsend

• P({a < X ≤ b}) = FX (b) − FX (a)

i=1

F (x)

5.0.2 Kumulative Verteilungsfunktion (KVF bzw. CDF)

• P({X > c}) = 1 − FX (c)

5.0.3 Verteilung diskreter Zufallsvariablen

Beliebig viele Ereignisse:

P (A

∩···∩

1 ∩ A2 Ak )

P({X 1 ≤ x1 ,···, X n ≤ xn }) =

1.4. Integralgarten

P(A|Bk ) P(Bk )

P

P(A|Bi ) P(Bi )

i∈I

3.1.2 Multiplikationssatz

P(A ∩ B) = P(A|B) P(B) = P(B|A) P(A)

Daraus folgt:

• ∅∈F

• Ai \Aj ∈ F

Tk

•

i=1 Ai ∈ F

∀A′ ∈ F′

FX (x) = P({X ≤ x})

3.1.1 Totale Wahrscheinlichkeit

und Satz von Bayes

S

Es muss gelten:

Bi = Ω für Bi ∩ Bj = ∅, ∀i ̸= j

i∈I

P

Totale Wahrscheinlichkeit:

P(A) =

P(A|Bi ) P(Bi )

Satz von Bayes:

i≥1

|A|

Mögliche Variationen/Kombinationen um k Elemente von maximal n Elementen zu wählen bzw. k Elemente auf n Felder zu verteilen:

5.0.1 Definition

PX (A′ ) = P({ω ∈ Ω| X (ω) ∈ A′ }) = P({X ∈ A′ })

3.1. Bedingte Wahrscheinlichkeit

i∈I

2.2. Wahrscheinlichkeitsmaß P

1.2. Kombinatorik

5. Wahrscheinlichkeitsverteilungen

3. Bedingte Wahrscheinlichkeit und

Unabhängigkeit

von Emanuel Regnath, Martin Zellner, Alexander Preißner, Hendrik Böttcher, Samuel Harder – Mail: [email protected]

−∞

Stand: 9. Februar 2016

1/4

6. Funktionen von Zufallsvariablen

′

′

Ω′′

′

X : Ω → Ω = R und jetzt g :Ω →

P(A′′ ) = P(Y ∈ A′′ ) = P( X ∈ Ω

Ω g(X (ω)) ∈ A′′

=R

g(X ) ∈ A′′ = P( ω ∈

6.1. Transformation von Zufallsvariablen

Berechnung von fY (y) aus fX (x)

g(x) streng monoton & differenzierbar:

−1

dg(x) fY (y) = fX g −1 (y)

dx x=g −1 (y)

g(x) nur differenzierbar:

−1

N

P

dg(x) fY (y) =

mit i ∈ {1, . . . , N }

fX (xi ) dx x=xi

i=1

xi sind Nullstellen von y − g(x) = 0

6.1.1 Beispiel: lineare Funktion

Y = aX + b ⇔ g(x) = ax + b mit a ∈ R\0, b ∈ R:

⇒ fY (y) =

FY (y) =

FX

1

|a|

fX

y−b

a

1 − FX

y−b

7.3. Bernoulliverteilung (p ∈ [0, 1])

7.6. Geometrische Verteilung (p ∈ [0, 1])

7.8. Normalverteilung (µ ∈ R, σ > 0)

Wahrscheinlichkeitsmasse

2 Ereignisse: Erfolg und Misserfolg

p: Wahrscheinlichkeit

k=1

0,

p,

FX (k) = 1 − p

pX (k) = 1 − p k = 0

1

0

sonst

Erster Erfolg eines Bernoulli-Experiments beim k-ten Versuch,

Gedächtnislos

WMF/PMF:

KVF/CDF:

pX [k] = (1 − p)k−1 p, k ∈ N FX [k] = 1 − (1 − p)k , k ∈ N

WDF/PDF:

k<0

0≤k<1

k≥1

y−b

a

E[X ] = p

Var[X ] = p(1 − p)

Erwartungswert

Varianz

E[X ] =

⇒ fZ=X + Y (z) = (fX ∗ fY ) (z) =

Erwartungswert

sonst

∞

´

fX (z − y)fY dy

Var[X ] = np(1 − p)

Erwartungswert

Varianz

n

GX (z) = (pz + 1 − p)

Wahrscheinlichkeitserz. Funktion

7.1. Begriffe

7.5. Poisson-Verteilung (λ ≥ 0)

Gedächtnislos

Eine Zufallsvariable X ist gedächtnislos, falls:

P({X > a + b)}|{X > a}) = P({X > b}),

a, b > 0

Asymptotischer Grenzfall der Binomialverteilung

n → ∞, p → 0, np → λ pX (k) = lim B

n→∞

WMF/PMF:

k

pX [k] = λk! e−λ

7.2. Gleichverteilung

Erwartungswert

k ∈ N0

n, λ

n

Var[X ] =

(b − a)2

Varianz

12

Varianz

GX (z) =

pz

0.4

-1

-3

-2

-1

0.0

−4

−3

−2

−1

0

x

1

fX (x) = √

E(X ) = µ

1 − z + pz

3

2

4

5

Erwartungswert

1

2πσ 2

e

−

Var(X ) = σ

Varianz

−5

−4

(x−µ)2

2σ 2

2

−3

−2

−1

0

x

1

2

3

4

5

x∈R

2 2

jωµ− ω σ

2

φX (ω) = e

Charakt. Funktion

Wahrscheinlichkeitserz. Funktion

Wie geometrische Verteilung für stetige Zufallsvariablen (“Lebensdauer“),

Gedächtnislos

WDF/PDF:

KVF/CDF:

fX (x) = λe−λx

x≥0

FX (x) = 1 − e−λx

x≥0

Schreibweise X ∼ N (µ, σ )

Beispiele: Rauschen, Ort eines Teilchens relativ zu seiner Anfangsposition

bei brownscher Molekularbewegung, abgefahrene Sachen, die man nicht

genauer bestimmen will oder kann

7.8.1 Standartnormalverteilung

ist der Spezialfall X ∼ N (0, 1)

2

1

−x

ϕ(x) = √

e 2

2π

Es gilt außerdem:

1

2

(Y −µ) ∼ N (0, 1)

• Y ∼ N (µ, σ ) ⇒ X =

σ

2

• X ∼ N (0, 1) ⇒ Y = σ X +µ ∼ N (µ, σ )

KVF/CDF:

FX [k] = zu kompliziert

E(X ) =

φX (s) =

-2

(k)

x ∈ {1, . . . , |Ω|}

Beispiele: Wurf einer fairen Münze, Lottozahlen

7.2.2 Stetig (a, b : −∞ < a < b < ∞)

(

0

1

x ∈ [a, b]

x−a

fX (x) = b−a

FX (x) =

b−a

0

sonst

1

2

p2

7.7. Exponentialverteilung (λ > 0)

E[X ] = np

7. Stochastische Standardmodelle

a+b

1−p

Charakteristische Funktion

φX (s) =

1 − (1 − p)eıs

Beispiele: diskrete Dauer bis ein technisches Gerät zum ersten Mal ausfällt,

Anzahl der Würfe bis man eine ”6”würfelt

k ∈ {0, . . . , n}

s n

Charakteristische Funktion

φX (s) = 1 − p + pe

Beispiele: Anzahl der Übertragungsfehler in einem Datenblock endlicher

Länge, Wiederholtes Werfen einer Münze

E[X ] =

Var[X ] =

2

2

Wahrscheinlichkeitsmasse

(n

pk (1 − p)n−k

k

pX (k) = Bn,p (k) =

0

n!

mit n

= k!(n−k)!

k

−∞

7.2.1 Diskret

1 ,

pX (x) = |Ω|

1

p

Φμ,σ (x)

0.2

WDF

Beispiele: Einmaliger Wurf einer (unfairen) Münze

μ = 0, σ 2 = 0.2,

μ = 0, σ 2 = 1.0,

μ = 0, σ 2 = 5.0,

μ = −2, σ 2 = 0.5,

0.6

-3

GX (z) = pz + 1 − p

Wahrscheinlichkeitserz. Funktion

6.2. Summe unabhängiger Zufallsvariablen

Z = X + Y mit X und Y unabhängig.

0.8

0.6

−5

peıs

a<0

0.8

0.0

7.4. Binomialverteilung (p ∈ [0, 1], n ∈ N)

a>0

1.0

μ = 0, σ 2 = 0.2,

μ = 0, σ 2 = 1.0,

μ = 0, σ 2 = 5.0,

μ = −2, σ 2 = 0.5,

0.2

a

KVF/CDF:

φμ,σ (x)

2

0.4

Folgen von Bernoulli-Experimenten

p: Wahrscheinlichkeit

n: Anzahl der Bernoulli-Experimente

1.0

1

λ

Erwartungswert

x<a

x ∈ [a, b]

Var(X ) =

Varianz

1

λ2

φX (ω) =

λ

λ − jω

Charakt. Funktion

Beispiele: Lebensdauer von el. Bauteilen, Zeitdauer zwischen zwei Anrufen

in einem Call-Center

x>b

ejωb − ejωa

E[X ] = λ

Var[X ] = λ

jω(b − a)

Erwartungswert

Varianz

Charakt. Funktion

Beispiele: Winkel beim Flaschendrehen, Phase einer empf. Sinusschwingung

Homepage: www.latex4ei.de – Fehler bitte sofort melden.

λ(s−1)

GX (s) = e

Wahrscheinlichkeitserz. Funktion

Charakteristische Funktion

φX (s) = exp λ(es − 1)

Beispiele: Zahl der Phänomene in einem Zeitintervall, Google-Anfragen in

einer Stunde, Schadensmeldungen an Versicherungen in einem Monat

von Emanuel Regnath, Martin Zellner, Alexander Preißner, Hendrik Böttcher, Samuel Harder – Mail: [email protected]

Stand: 9. Februar 2016

2/4

8. Erwartungswert

9. Varianz und Kovarianz

10. Erzeugende und charakter. Funktionen

11. Reelle Zufallsfolgen

8.1. Definition

9.1. Varianz

10.1. Wahrscheinlichkeitserzeugende Funktion

Eine reelle Zufallsfolge ist ganz einfach eine Folge reeller Zufallsvariablen.

Gibt den mittleren Wert einer Zufallsvariablen an

ist ein Maß für die Stärke der Abweichung vom Erwartungswert

für X : Ω → N0

Var[X] = E (X − E[X ])2 = E[X 2 ] − E[X ]2

8.2. diskrete (reelle) Zufallsvariablen

E[X ] =

X

x P({X = x}) =

x∈Ω′

X

∞

X

X

GX (z) = E[z ] =

k

k=0

xpx (x)

x∈Ω′

für X : Ω → Ω′ ⊂ R

Für Funktionen von Zufallsvariablen:

P

E[Y ] = E[g(X )] =

g(x)pX (x)

9.1.1 Standard Abweichung

p

σ = Var[X ]

Anwendungen

1 dn

pX (n) = P( X = n ) =

[

GX (z)]z=0 ,

n! dz n

9.2. Kovarianz

x∈Ω′

Cov[X , Y ] = E[(X − E[X ])(Y − E[Y ])] = Cov[Y , X ]

mit X : Ω → Ω′ ⊂ R und g : R → R

E[X ] = [

andere Darstellungen:

Cov[X , Y ] = E[X Y ] − E[X ] E[Y ] = Cov[Y , X ]

8.3. stetige Zufallsvariablen

x · fX (x) dx für X : Ω → R

R

Für Funktionen von Zufallsvariablen:

´

E[Y ] = E[g(X )] = g(x)fX (x) dx

R

mit X : Ω → R und g : R → R

Var[X ] = [

Kovarianz mit sich selbst:

Var[X ] = Cov[X , X ]

aus den Definitionsgleichungen:

Cov[α X +β, γ Y +δ] = αγ Cov[X , Y ]

Cov[X + U, Y + W] = Cov[X , Y ] + Cov[X , W] + Cov[U, Y ] +

Cov[U, W]

E[α X +β Y ] = αE[X ] + βE[Y ]

X ≤ Y ⇒ E[X ] ≤ E[Y ]

Beweis mit der Definition und der Linearität des Integrals bzw. der Summe.

Falls X und Y stochastisch unabhängig: E[X Y ] = E[X ] E[Y ]

Achtung: Umkehrung nicht möglich.

Stoch. Unabhängig ⇒ Unkorrelliertheit

E[X ] =

0

∞

P

P(X > k) (diskret)

k=0

n

Y

i=1

i=1

i=1 j̸=i

i

11.2. Random Walk

10.2. Charakteristische Funktion

h

i

ıω X

φX (ω) = E e

,

fX (−x)

9.4. Unkorreliertheit

b r φ(ω)

ω∈R

φX =

n

E[X ] =

Summe von ZV: Z =

wenn ZV normalverteilt (sonst nicht!):

Unkorreliertheit ⇒ stoch. Unabhängigkeit

Z =

bei paarweisen unkorrellierten Zufallsvariablen:

n

n

P

P

Var[

X i] =

Var[X i ]

i=1

1

"

ın

dn

n

X

Pn

dω n

Xi

i=1

E[X Y ] = 0

φZ (ω) =

i=1

Var[Y ]

Eine Zufallsfolge ist stationär, wenn um ein beliebiges k (k ∈ N) zueinander verschobene Zufallsvektoren die selbe Verteilung besitzen.

Im weiteren Sinne stationär (W.S.S.), wenn:

n

Y

φX (ω)

i

i=1

c

,Y

= σ Xσ

mit ρX ,Y ∈ [−1, 1]

X Y

µX (i) = µX (i + k)

rX (i1 , i2 ) = rX (i1 + k, i2 + k) = rX (i1 − i2 )

stationär ⇒ WSS (aber nicht anders herum!)

Definition: Seien X i , i ∈ 1, ..., n, stochastisch unabhängige und identisch verteilte reelle Zufallsvariablen und gelte E[X i ] = µ < ∞ und

V ar[X i ] = σ 2 < ∞. Dann konvergiert die Verteilung der standardisierten Summe

n (X

P

µ)

−

√

Zn =

i=1

9.6. Korrelationskoeffizient

Var[X ]

11.3. Stationarität

ω=0

Xi

⇒

E[X i ] = (2p − 1)δ

V ar[X i ] = 4p(1 − p)δ 2

#

φX (ω)

10.3. Der zentrale Grenzwertsatz

9.5. Orthogonalität

Cov[X ,Y ]

√

ρX ,Y = √

eıωx fX (x) dx

E[S] = µS (n) = n(2p − 1)δ

V ar[S] = σS2 (n) = 4np(1 − p)δ 2

Stoch. Unabhängig ⇒ Unkorrelliertheit

i=1

∞

´

n ∈ N Schritte mit 2 möglichen Bewegungsrichtungen X ∈ {+δ, −δ}

P ({X i = +δ}) = p

n

X

P ({X i = −δ}) = 1 − p

Sn =

Xi

1 , µ (n) = 0

symmetrisch ⇔ p = 2

S

i=1

−∞

Erwartungswert:

wenn gilt:

Erwartungswert µX (n) = E[X n ]

2

2

(n) = V ar[X n ] = E[X 2

Varianzfolge

σX

n ] − E[X n ]

Autokorrelation rX (k, l) = E[X k X l ]

Autokovarianz cX (k, l) = Cov[X k , X l ]= rX (k, l) − µX (k)µX (l)

GX (z)

i=1

wegen der Linearität des Erwartungswerts:

Var[α X +β] = α2 Var[X ]

für die Summe von Zufallsvariablen:

n

n

n P

P

P

P

Var[

X i] =

Var[X i ] +

Cov[X i , X j ]

Cov[X , Y ] = 0 ⇔ E[X Y ] = E[X ] E[Y ]

Spezialfall für X : Ω → R+ :

∞

´

E[X ] =

P(X > t) dt (stetig)

11.1. Verteilungen und Momente

2

GX (z)]z=1 − E[X ] + E[X ]

GZ (z) =

Pfad

⃗

Sn = (Sn , Sn−1 , . . . , S1 ) : Ω(n) → Rn

ω

⃗ n 7→ ⃗

sn (⃗

ωn ) = (sn (⃗

ωn ), sn−1 (⃗

ωn ), . . . , s1 (⃗

ωn )), n ∈ N

Erklärung: Die Abfolge der Realisierungen von S1 bis Sn (also der Pfad

von S) und somit auch jedes einzelne Sk kann als Ergebnis des Ereignisses

ω

⃗ n angesehen werden.

GX (z)]z=1

dz 2

dz 2

Für X i : Ω → N0 , i ∈ 1,P

. . . , n stochastisch unabhängige, diskrete,

n

nichtnegative ZV und Z =

i=1 X i

8.4. Eigenschaften des Erwartungswerts

Linearität:

Monotonie:

d2

GX (z)]z=1

dz

d

2

9.3. Spezialfälle

d

∀n ∈ N0

2

E[X ] − E[X ] = [

ˆ

E[X ] =

Ensemble

Sn : Ωn × Ωn−1 × · · · × Ω1 → R

(ωn , ωn−1 , . . . , ω1 ) 7→ sn (ωn , ωn−1 , . . . , ω1 ), n ∈ N

Erklärung: Jede Realisierung von Sn wird erzeugt durch die Menge (das Ensemble) aufeinanderfolgender Realisierungen X k mit

k ∈ {1, . . . , n}.

|z| ≤ 1

pX (k)z ,

σ

n

d.h E[Z n ] = 0 und V ar[Z n ] = 1, für n → ∞ gegen die Standartnormalverteilung.

Es gilt also:

limn→∞ P(Z n ≤ z) = Φ(z)

Korrelationskoeffizient von X und Y

negativ korreliert ρX ,Y ∈ [−1, 0)

Es gilt: unkorreliert

ρX ,Y = 0

positiv korreliert ρX ,Y ∈ (0, 1]

11.4. Markow-Ungleichung

E[| X |]

P( |X | ≥ a ) ≤

a

11.5. Tschebyschow-Ungleichung

Var[X ]

P( |X − E[X ]| ≥ a ) ≤

a2

11.6. Das schwache Gesetz der großen Zahlen

Sei (X i : i ∈ N) eine Folge reeller, paarweise unkorrelierter Zufallsvariablen mit beschränkter Varianz:

n

1 P (X − E[X ]) → 0

i

i

n

i=1

Für stochastisch unabhängige und identisch verteilte Folgenelemente

mit E[X i ] = E[X] und V ar[X i ] = V ar[X] < ∞ gilt:

n

1 P (X ) → E[X ]

i

i

n

i=1

Homepage: www.latex4ei.de – Fehler bitte sofort melden.

von Emanuel Regnath, Martin Zellner, Alexander Preißner, Hendrik Böttcher, Samuel Harder – Mail: [email protected]

Stand: 9. Februar 2016

3/4

12. Markowketten

(bedingte Unabhängigkeit: Abschnitt 14)

12.1. Markowketten

12.1.1 Allgemein

Eine Zufallsfolge (X n : n ∈ N) heißt Markowkette, falls ∀ ni ∈ N,

i ∈ 1, . . . k mit n1 < · · · < nk gilt:

(X n1 , X n2 , . . . X nk−2 ) → X nk−1 → X nk

⇒ Die Verteilung eines Folgeelements hängt nur vom direkten Vorgänger

ab

pX n

k

| Xn

,X

,...,X n (xnk |xnk−1 , xnk−2 , ..., xn1 )

1

k−1 nk−2

= pX n

k

fX n

k

(xnk |xnk−1 )

| Xn

k−1

| Xn

k−1

,X n

k−2

,...,X n

1

13. Reelle Zufallsprozesse

13.5. Wiener-Prozess (σ > 0)

13.1. Ensemble und Musterfunktion

Als Basis benutzen wir den Random Walk. Durch Multiplikation mit einer

Heaviside-Funktion wird der Random Walk zeitkontinuierlich:

n

n

P

P

Sn =

Xi

⇒

St =

X i u(t − iT )

T >0

• Ein Zufallsprozess kann als Ensemble einer nicht abzählbaren Menge

von Zufallsvariablen Xt mit t ∈ R interpretiert werden.

• Ein Zufallsprozess kann als Schar von Musterfunktionen

X t (ω) : R 7→ R, mit X (ω) als deterministische Funktion von t, mit

einem gegebenen Ereignis ω ∈ Ω interpretiert werden.

(xnk |xnk−1 , xnk−2 , ..., xn1 )

Autokorrelationsfunktion:

rX (s, t) = E[X s X t ]

Hinweis: Bei Integration über rX immer darauf achten, dass s − t > 0.

Bei Bedarf Integral aufteilen und Grenzen anpassen.

n−1

Verbund-WMF:

n

Q

pX 1 ,...,X n (x1 , ..., xn ) = pX 1 (x1 )

pX | X

(xi |xi−1 )

i

i−1

i=2

Zustandsübergangsdicht:

fX n | X

n−1

(xn |xn−1 )

Verbund-WDF:

fX 1 ,...,X n (x1 , ..., xn ) = fX 1 (x1 )

n+1+k

n+k

12.1.3 Chapman-Kologorow Gleichung

2-Schritt-Übergangswahrscheinlichkeit:

pX

| X n (xn+2 |xn ) =

Pn+2

(xn+2 |ξ)pX

(ξ|xn )

pX

n+2 | X n+1

n+1 | X n

ξ∈X

m+l-Schritt-Übergangswahrscheinlichkeit:

pX

| X n (xn+m+l |xn ) =

Pn+m+l

pX

(xn+m+l |xn+m )pX

|X

ξ∈X

n+m+l

n+m

(xn+m |xn )

n+m | X n

12.1.4 Markowketten im endlichen Zustandsraum

pX n (x1 )

p

X n (x2 )

p

⃗n ≜

pn ]i = pX n (xi )

∈ [0, 1]N mit [⃗

.

.

.

pX n (xN )

p11

.

Übergangsmatrix: Π = .

.

pN 1

···

..

Ein Zufallsprozess ist stationär, wenn um ein beliebiges s (s ∈ R)

zueinander verschobene Zufallsvektoren die selbe Verteilung besitzen.

p1N

.

µX (t) = µX (t + s)

∧

rX (t1 , t2 ) = rX (t1 + s, t2 + s)

Daraus folgt mit s = t + τ

rX (s, t) = E[X s X t ] = E[X t+τ X t ] = rX (s − t) = rX (τ )

Im weiteren Sinne zyklisch stationär, wenn:

µX (t) = µX (t + T )

∧

rX (t1 , t2 ) = rX (t1 + T, t2 + T )

stationär ⇒ WSS ⇒ im weiteren Sinne zyklisch stationär (aber nicht

anders herum!)

13.4. Mehrere Zufallsvariablen auf dem selben Wahrscheinlichkeitsraum

Kreuzkorrelationsfunktion:

rX ,Y (s, t) = E[X s Y t ] = rY ,X (t, s)

Kreuzkovarianzfunktion:

cX ,Y (s, t) = rX ,Y (s, t) − µX (s)µY (t) = cY ,X (t, s)

13.4.1 Gemeinsame Stationarität

Zwei Zufallsprozesse auf demselben Wahrscheinlichkeitsraum sind gemeinsam stationär, wenn die einzelnen ZPs jeweils selbst stationär sind und

ihre gemeinsamen Verteilungen verschiebungsinvariant sind.

13.4.2 Gemeinsam im weiteren Sinne stationär

Voraussetzung: X t und Y t sind gemeinsam WSS wenn,

exp

pN N

Übergangswahrscheinlichkeit: pij = pX

(ξ , ξ )

n+1 | X n i j

Spaltensumme muss immer 1 ergeben!

p

⃗n+1 = Π⃗

pn n ∈ N

p

⃗n+m = Πm p

⃗n n, m ∈ N

Eine Verteilung heißt stationär, wenn gilt:

∞

´

h(t − τ )v(τ ) dτ

−∞

Im Frequenzbereich:

W (f ) = H(f )V (f )

2

− w2

V

2σ t

Wt

Ausgang

Vt

Eingang

h(s, t) Impulsantwort

W

Eigenschaften

• Kein Zählprozess!

• P({W0 = 0}) = 1

• hat unabhängige Inkremente → rxy (s, t) = 0

Falls Zufallsprozesse WSS:

• Wt ∼ N (0, σ 2 t), ∀0 ≤ t

Autokorrelationsfkt: rW = E[Ws Wt ] = (h̃ ∗ h ∗ rV )(τ )

mit h̃(τ ) = h(−τ )

• Wt − Ws ∼ N (0, σ 2 (t − s)), ∀0 ≤ s ≤ t

• Wt (ω) ist eine stetige Musterfunktion mit Wahrscheinlichkeit 1

Erwartungswertfunktion.

Varianz

Autokorrelationsfunktion

Autokovarianzfunktion

∞

´

Erwartungswert: µW = µV

h(t) dt

∞

Kreuzkorrelationsfkt: rW,V (τ ) = E[Ws Vt ] = (h ∗ rV )(τ )

15.2. Leistungsdichtespektrum (LDS)

µW (t) = 0

2

σW

(t) = σ 2 t

rW (s, t) = σ 2 min{s, t}

cW (s, t) = σ 2 min{s, t}

13.6. Poisson-Prozess (Nt :∈ R+ )

Beim Poisson-Prozess wird der Zeitpunkt der Sprünge durch ZV modelliert, nicht die Amplitude.

∞

i

P

P

Nt =

u(t − Ti ), Ti =

Xj

Nicht WSS ⇒ Kein LDS

ˆ∞

SV (f ) =

rV (τ )e

−j2πf τ

dτ

i=1

j=1

X t und Y t einzelnd WSS und

rX ,Y (t1 , t2 ) = rX ,Y (t1 + s, t2 + s)

gemeinsam stationär ⇒ gemeinsam WSS (aber nicht umgekehrt!)

Daraus folgt mit s = t + τ

rX (s, t) = E[X t+τ X t ] = rX (τ ) = rX (−τ )

rX (τ ) ≤ rX (0)

rX ,Y (τ ) = E[X t+τ Y t ] = E[Y t X t+τ ] = rY ,X (−τ )

13.4.3 Stochastische Unkorreliertheit

cX ,Y (s, t) = 0 ⇔ rX ,Y (s, t) = µ(s)µ(t),

13.4.4 Orthogonalität

rX ,Y (s, t) = 0, ∀s, t ∈ R

∀s, t ∈ R

b r

b r

b r

rV (τ )

SV (f )

SV,W (f )

rV,W (τ )

∗

rV,W (−τ )

SV,W

(f )

Auf Frequenz bezogene Signalleistung für infitisimales Frequenzband.

SY (f ) = |H(f )|2 SX (f )

SY,X (f ) = H(f )SX (f )

SX,Y (f ) = H ∗ (f )SX (f )

X j ist exponentiell verteilt, Ti ist Gamma-verteilt

i

λ

fTi (t) = (i−1)!

ti−1 e−λt , t ≥ 0

(λt)n

P ({Nt = n}) = n! e−(λt) , ∀n ∈ N, t ∈ R+

Eigenschaften

• ist ein Zählprozess

• ist Gedächtnislos

• hat unabhängige Inkremente

• Nt − Ns ist Poisson-verteilt mit Parameter (λ(t − s) für alle

0≤s≤t

• hat eine Rate λ

• Zeitintervalle zwischen den Inkremetierungen sind unabhängig und identisch exponentialverteilt mit Parameter λ

Erwartungswertfunktion

Varianz

Autokorrelationsfunktion

Autokovarianzfunktion

µN (t) = λt

2

σN

(t) = λt

rN (s, t) = λ min{s, t} + λ2 st

cN (s, t) = λ min{s, t}

14. Bedingte Unabhängigkeit

∈ [0, 1]N ×N

Im Zeitbereich:

w(t) = (h ∗ v)(t) =

−∞

Im weiteren Sinne stationär (W.S.S.), wenn:

fX | X

(xi |xi−1 )

i

i−1

i=2

Eine Markowkette heißt homogen, wenn die Übergangswahrscheinlichkeit

unabhängig vom Index ist

pX

(xn+1 |xn ) = pX

(xn+1 |xn )

n+1 | X n

n+1+k | X n+k

fX

(xn+1 |xn )

| X n (xn+1 |xn ) = fX

|X

n+1

13.3. Stationarität

FXt ,...,Xt (x1 , . . . xn ) = FX

(x1 , . . . xn )

t1 +s ,...,Xtn +s

n

1

n

Q

√

σ 2 T folgt der

Für n → ∞ und T → 0, mit Schrittweite δ =

Wiener Prozess: Wt

15.1. Allgemeines

Zeitlich, Kontinuierlich veränderliche Zufallsvariable X t

Autokovarianzfunktion:

cX (s, t) = Cov(X s , X t ) = rX (s, t) − µX (s)µX (t)

12.1.2 Zustandsübergang

Zustandsübergangswahrscheinlichkeit:

pX n | X

(xn |xn−1 )

i=1

2πσ 2 t

Erwartungswertfunktion:

µX (t) = E[X t ]

= fX n | X n

(xnk |xnk−1 )

k

k−1

i=1

fWt (w) = √ 1

13.2. Verteilungen und Momente

15. Zufallsprozesse(ZP) und lineare Systeme

X

Y

A

B

SY ,X (f )

(

n

Q

i=1

=

(

n

Q

Hi (f ))(

i=1

∗

SX (f ) = SX

(f )

∞

´

Hi (f ))SX (f )

SX ,Y (f )

=

Hi∗ (f ))SX (f )

SY ,B (f ) = (

−∞

n

Q

i=1

m

Q

j=1

&

Gj (f ))∗ SX ,A (f )

∗

SX ,Y (f ) = SY

,X (f ),

SX (f ) = SX (−f ),

∀f ∈ R

∀f ∈ R

2

SX (f ) df = rX (0) = Var[X ] + E[X ]2 = σX

+ µ2

X

SX (f ) ≥ 0,

∀f ∈ R

Momenterzeugende Funktion, Multivariate Normalverteilung, Multivariate reelle Zufallsvariablen und Komplexe Zufallsvariablen waren im WS

2015/16 nicht prüfungsrelevant und werden hier deshalb nicht behandelt.

P.S. Stochastik ♡ dich.

14.1. Bedingte Unabhängigkeit

A und C heißen bedingt unabhängig gegeben B, wenn gilt:

P(A ∩ C|B) = P(A|B) P(C|B) bzw.

P(A|B ∩ C) = P(A|B)

Dann gilt:

pZ | Y ,X (y|y, x) = pZ | Y (z|y)

fZ | Y ,X (z|y, x) = fZ | Y (z|y)

X , Z sind bedingt unabhängig gegeben Y , kurz: X → Y → Z

p

⃗∞ = Π⃗

p∞

Homepage: www.latex4ei.de – Fehler bitte sofort melden.

von Emanuel Regnath, Martin Zellner, Alexander Preißner, Hendrik Böttcher, Samuel Harder – Mail: [email protected]

Stand: 9. Februar 2016

4/4