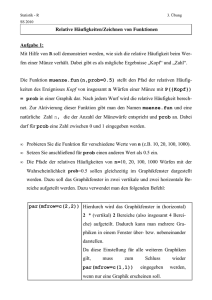

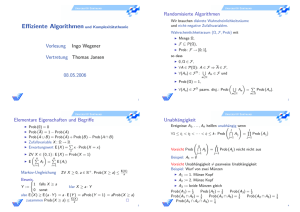

d) ML-Schätzung in Item

Werbung

Psychologische Testtheorie

3. Maximum-Likelihood-Schätzung in Item-Response-Modellen

Die Maximum-Likelihood-Methode

Gegeben sei eine Stichprobe von n Beobachtungen x1 ,...,x n , deren Wahrscheinlichkeitsverteilung von

einem unbekannten Parameter abhängt. Wir schätzen den Parameter so, dass unsere Daten

möglichst plausibel (d.h. die Wahrscheinlichkeit der beobachteten Daten maximal groß) ist.

Vorgehensweise:

1. Wir stellen die Wahrscheinlichkeit der Daten als Funktion des zu schätzenden Parameters

dar:

Lx 1 ,...,x n

n

f x v = Likelihoodfunktion

v 1

Worin f x v probX x v = Wahrscheinlichkeitsdichte der Verteilung

2. Wir bilden den natürlichen Logarithmus der Likelihoodfunktion:

ln L

ln f x v

n

v 1

3. Wir differenzieren ln(L) nach dem unbekannten Parameter und setzen die 1. Ableitung

gleich Null

d ln L

0

d

4. Durch Auflösung der Gleichung nach dem unbekannten Parameter erhalten wir die MLSchätzung ̂

Anmerkung: Da der natürliche Logarithmus eine streng monoton wachsende Funktion ist, hat ln(L)

sein Maximum an der selben Stelle wie L.

1

Psychologische Testtheorie

Eigenschaften von ML-Schätzfunktionen:

ˆ

1. ML-Schätzer sind konsistent: lim n prob

1 , so dass in hinreichend großen

Stichproben der Betrag des Schätzfehlers mit an Sicherheit grenzender Wahrscheinlichkeit

kleiner ist als jede noch so kleine Fehlerschranke 0 .

ˆ L x 1 ,...,x n c (d.h. von

2. ML-Schätzer sind fast immer suffizient (erschöpfend): L x 1 ,...,x n

ˆ

L

unabhängig), so dass der ML-Schätzer ̂ die gesamte in der Stichprobe enthaltene

statistische Information über den zu schätzenden Parameter ausschöpft.

3. ML-Schätzer sind (zumindest asymptotisch, d.h. für n )

normalverteilt,

erwartungstreu: E ̂ , so dass der Parameter im Durchschnitt über viele

Stichproben richtig geschätzt wird, und

2

ˆ Minimum , so dass die Fehlerstreuung des Schätzers minimal

wirksamst: E

klein ist.

4. All diese Eigenschaften besitzen sie aber nur, wenn die Likelihoodfunktion tatsächlich die

Wahrscheinlichkeit eines zufälligen Ereignisses beschreibt.

2

Psychologische Testtheorie

Anwendung der ML-Methode auf die Schätzung der Personen- und Itemparameter in ItemResponse-Modellen:

1. Bei Item-Response-Modellen haben wir es nicht mit n, sondern mit n * k Beobachtungen zu

tun (den Antworten von n Vpn auf k Items) die in einer Antwortmatrix X x vi dargestellt

werden können.

2. Die Zeilen der Antwortmatrix sind die Antwortmuster der Vpn: x v x v1 ,...,x vk

3. Straight forward Anwendung der ML-Methode auf die Antwortmatrix führt zur sog.

unbedingten (oder totalen) Likelihood L X probx v1 ,...,x vk v , welche die

n

v 1

Wahrscheinlichkeit beschreibt, dass genau diese Vpn die Antwortmatrix X produzieren.

4. Diese unbedingte Likelihood hängt von (mindestens) n Personenparametern und

(mindestens) k Itemparametern ab, so dass mit jeder Vergrößerung der Stichprobe (mehr Vpn

oder mehr Items) auch die Anzahl der zu schätzenden Parameter (= mindestens n + k)

wächst.

5. In diesem Fall versagt jedoch die ML-Methode und liefert nicht einmal konsistente

Schätzfunktionen (= Neyman-Scott-Problem).

6. Der Grund dafür besteht darin, dass die unbedingte Likelihood mangels Wiederholbarkeit der

Testung der selben Vpn mit den selben Items gar keine Wahrscheinlichkeit ist.

3

Psychologische Testtheorie

Auswege aus diesem Dilemma:

1. Latent-Class-Modelle

a. Wir teilen die Vpn in h Klassen ein, so dass für alle Vpn, die der selben Klasse

angehören, die selben Antwortwahrscheinlichkeiten pgix probX vi x v g gelten.

b. Die Wiederholbarkeit ist dann innerhalb jeder der Klassen über die Vpn hinweg

gegeben, die derselben Klasse angehören.

c.

Problem: Wir wissen nicht a priori, welcher Klasse eine Vp angehört.

2. Latent-Trait-Modelle: Wir wählen eine zweistufige Vorgehensweise:

a. Zuerst schätzen wir die Itemparameter unabhängig von den Personenparametern.

b. Dann setzen wir die Itemparameter als bekannt voraus und schätzen die

Personenparameter.

c.

Problem: Wie kann das gehen, wo doch L(X) sowohl von Item- als auch von

Personenparametern abhängt?

4

Psychologische Testtheorie

Problemlösungen für Latent Trait Modelle:

Problemlösung No.1: Die bedingte (conditional) ML-Methode:

a. Ist der Score eine erschöpfende Statistik für den Personenparameter, dann ist die

n

n

prob x v1 ,...,x vk v

v 1

v 1

prob x vo v

bedingte Likelihood CL(X) prob{(xv1 ,..., xvk ) xvo }

von den

Personenparametern unabhängig und hängt nur noch von den Itemparametern ab,

und

b. die Wiederholbarkeit ist dann innerhalb jeder der Scoregruppen über die Vpn hinweg

gegeben, die den selben Score haben.

c.

Daher können wir die Itemparameter unabhängig von den Personenparametern

schätzen, indem wir die bedingte Likelihood der Antwortmatrix maximieren (CMLMethode).

d. Vorteil: CML-Schätzer haben all die o.g. wünschenswerten Eigenschaften: sind

konsistent und suffizient sowie asymptotisch normalverteilt, erwartungstreu &

wirksamst.

e. Problem: Die CML-Methode ist nur beim Rasch-Modell anwendbar, weil der Score nur

dann eine erschöpfende Statistik für den Personenparameter ist, wenn die

Itemcharakteristiken der logistischen Funktion folgen.

5

Psychologische Testtheorie

Problemlösung No. 2: Die marginale ML-Methode

a. Wir behandeln die latente Personenvariable als eine Zufallsvariable mit bekannter

Wahrscheinlichkeitsdichte g (z.B. Normalverteilung) und

n

b. maximíeren die marginale Likelihood ML X probx v1 ,...,x vk , welche die

v 1

Wahrscheinlichkeit beschreibt, dass eine Zufallsstichprobe von n Vpn die

Antwortmatrix X produziert (MML-Methode).

c.

Die Wiederholbarkeit ist dann über alle Zufallsstichproben von n Vpn hinweg

gegeben, und

d. die marginale Likelihood hängt nur von den Itemparametern und einer Handvoll von

Parametern ab, welche die Verteilung der latenten Personenvariable beschreiben

(z.B. von Erwartungswert und Varianz der Normalverteilung der latenten

Personenvariable).

e. Vorteil: Die MML-Methode ist auch dann anwendbar, wenn der Score keine

erschöpfende Statistik für den Personenparameter ist (d.h., wenn die

Itemcharakteristiken nicht die Form der logistischen Funktion haben)

f.

Problem: Um die MML-Methode anwenden zu können, müssen wir Zusatzannahmen

treffen, wie die latente Personenvariable verteilt ist (z.B. Normalverteilung). Stimmen

diese Zusatzannahmen nicht mit der Realität überein, kommt es zu einer Verzerrung

der Itemparameterschätzung.

6

Psychologische Testtheorie

Problemlösung No. 3: Äquivalenz der CML und MML-Methode im Rasch-Modell

a. Im Rasch-Modell sind solche Zusatzannahmen nicht nötig. Die Wahrscheinlichkeit mit

der eine zufällig herausgegriffene Vp das Antwortmuster x v1 ,...x vk zeigt

probx v1 ,...,x vk probx v1 ,...,x vk g d

kann im Rasch-Modell in zwei Faktoren zerlegt werden

probx v1 ,...,x vk prob x v1 ,...,x vk x vo probx vo ,

von denen einer – nämlich die Wahrscheinlichkeit probx vo , mit der eine zufällig

herausgegriffene Vp den Score xvo zeigt – unabhängig von den Itemparametern

dargestellt werden kann.

b. Die marginale Likelihood kann daher im Rasch-Modell daher in der Form

n

ML X CL X probx vo

v 1

dargestellt werden und entsprechend ist

lnML X lnCL X lnprobx vo .

n

v 1

c.

Da die Summe auf der rechten Seite von den Itemparametern unabhängig ist, fällt sie

beim Differenzieren weg und die MML-Methode liefert exakt dasselbe Ergebnis wie

die CML-Methode.

7

Psychologische Testtheorie

Problemlösung No. 4: Die gewichtete (weighted) ML-Methode

a. Sind die Itemparameter bekannt (bereits geschätzt), dann können wir in einem

nächsten Schritt für jede Vp ihren Personenparameter schätzen.

b. Dafür können wir aber nicht die Likelihood ihres Antwortmusters maximieren, weil

dann die Wiederholbarkeitsbedingung wieder verletzt wäre (jede Vp beantwortet die

Items ja nur einmal).

c.

Stattdessen stellen wir die ML-Methode gleichsam auf den Kopf und maximieren nicht

die Likelihood des Antwortmusters, sondern die Likelihood des Personenparameters

bei gegebenem Antwortmuster Lv x v1 ,...,x vk .

d. Die Wiederholbarkeit ist dann über jene Vpn hinweg sichergestellt, die dasselbe

Antwortmuster zeigen.

e. Problem: Wegen der Bayes’schen Formel

probB

prob

A

prob B A prob A B

berechnet sich Lv x v1 ,...,x vk nach

L v x v1 ,...,x vk L x v1 ,...,x vk v

probxg,...,

,

x

v

v1

vk

so dass man nun doch noch Annahmen über die Verteilung der latenten

Personenvariable treffen muss.

8

Psychologische Testtheorie

Problemlösungen für Latent-Class-Modelle

Problemlösung No. 5: Membershipwahrscheinlichkeiten

a. Bei der Latent-Class-Analyse ordnen wir die Vpn nicht auf einem latenten Kontinuum

an, sondern die diagnostische Entscheidung besteht darin, dass wir sie einer der h

Klassen zuordnen, in die wir die Vpn einteilen.

b. Dies kann mittels der sog. Membershipwahrscheinlichkeit prob{v g (xv1,..., xvk)}

geschehen, welche die Wahrscheinlichkeit beschreibt, dass eine Vp einer bestimmten

Klasse angehört, wenn sie ein bestimmtes Antwortmuster zeigt.

c.

Diese Membershipwahrscheinlichkeit berechnet sich aus

prob{v g (xv1,..., xvk)}

prob{v g} prob{(xv1 ,..., xvk ) v g}

h

prob{v d} prob{(xv1,..., xvk ) v d}

d1

d. Auf dieser Grundlage ordnen wir jede Vp jener Klasse zu, der sie aufgrund ihres

Antwortmusters mit größter Wahrscheinlichkeit angehört.

e. Vorteil: Die Memberpshipwahrscheinlichkeit jener Klasse, der wir die Vp zuordnen, ist

dann zugleich ein Maß dafür, wie sicher oder unsicher die Zuordnung ist (=

Zuordnungssicherheit).

Durch Berechnung der mittleren Zuordnungssicherheit erhalten wir zugleich ein Maß

für die Reliabilität des Tests.

9

Psychologische Testtheorie

Problemlösung No. 6: Der E-M Algorithmus

a. Da wir bei der Latent-Class-Analyse nicht voraussetzen, dass der Score die gesamte

statistische Information über die Ausprägung der latenten Personenvariable enthält,

gibt es hier keine bedingte Likelihood.

b. Ähnlich wie im Rasch-Modell, kann aber die marginale Likelihood dargestellt werden,

ohne dass Annahmen über die Verteilung der latenten Personenvariable getroffen

werden müssen:

n

k

h

ML ( X) prob{v g} prob{Xvi xvi vg}

v 1 g 1

i 1

c.

Wäre die Klassenzuordnung der Vpn bereits bekannt, dann könnten die darin

vorkommenden Parameter unmittelbar durch Auszählen der entsprechenden relativen

Häufigkeiten geschätzt werden:

p g probv g

ng

n

p gix prob X vi x v g

ngix

ng

d. Wären die Parameter bereits bekannt, dann könnten daraus die erwarteten

Häufigkeiten geschätzt werden.

e g pg * n

e gix p gix * n g

e. Beides ist jedoch nicht der Fall. Deshalb tun wir so, als ob die Parameter bereits

bekannt wären und setzen dafür irgendwelche „Anfangschätzungen“ ein, die man in

der Praxis mittels eines Zufallsgenerators bestimmt.

f.

Aus diesen Anfangschätzungen berechnen wir dann die ihnen entsprechenden

Membershipwahrscheinlichkeiten und aus den Membershipwahrscheinlichkeiten die

erwarteten Häufigkeiten mittels

eg

probv g x v1 ,...,x vk ,

n

v 1

d.h. indem wir die Membershipwahrscheinlichkeiten der jeweiligen Klasse über alle

Vpn aufsummieren, und

e gix

probv g x v1 ,...,x vk

v: x vi x

indem wir die Membershipwahrscheinlichkeiten der jeweiligen Klasse über alle Vpn

aufsummieren, die Item i in Kategorie x beantwortet haben (E-Schritt: Berechnung der

erwarteten Häufigkeiten)

10

Psychologische Testtheorie

g. Dann tun wir so, als ob die erwarteten Häufigkeiten die (unbekannten) tatsächlichen

Häufigkeiten wären, und berechnen daraus verbesserte Schätzwerte:

p g probv g

eg

n

und

p gix prob X vi x v g

e gix

eg

.

(M-Schritt: Maximum-Likelihood Schätzung)

h. Diese verbesserten Schätzwerte werden dann als neue vorläufige Schätzwerte in den

E-Schritt eingesetzt und das ganze Verfahren so lange wiederholt, bis die marginale

Likelihood der Antwortmatrix nicht mehr weiter wächst, also ihr Maximum erreicht hat.

i.

Vorteil: Für jede vorgegebene Klassenanzahl h konvergiert der E-M-Algorithmus

tatsächlich gegen jene Parameterwerte, welche die marginale Likelihood der

Antwortmatrix bei Annahme dieser Klassenanzahl maximieren.

j.

Problem: Wir wissen nicht a priori, wie viele Klassen zur Beschreibung der Daten

angemessen sind.

11

Psychologische Testtheorie

Problemlösung No.7: Bestimmung der Klassenzahl

a. Wir berechnen die Latent-Class-Analyse für 1, 2, 3,… u.s.w. Klassen und schauen,

welche Klassenzahl (d.h. welches LCA-Modell LC1, LC2, LC3,… u.s.w.) die beste

Beschreibung der Daten liefert.

b. Je mehr Klassen wir annehmen, desto größer wird die Likelihood der Antwortmatrix.

c.

Die größtmögliche Likelihood erhalten wir, wenn wir annehmen, dass jedes

Antwortmuster eine Klasse für sich darstellt. Diese Annahme bezeichnet man als

saturiertes Modell.

d. Problem: Wollten wir einfach die Likelihood als Kriterium dafür verwenden, wie gut ein

LCA-Modell die Daten beschreibt, so würden wir uns daher stets für das saturierte

Modell entscheiden.

12

Psychologische Testtheorie

Problemlösung No.8: Informationsmaße

a. Je mehr Klassen wir annehmen, desto mehr Parameter müssen wir aber auch

schätzen.

b. Als „beste“ Beschreibung der Daten wählen wir daher jenes LCA-Modell, das einen

optimalen Kompromiss zwischen

Genauigkeit der Beschreibung der Daten (= große Likelihood) und

Sparsamkeit der Beschreibung (= geringe Parameterzahl)

darstellt.

c.

Dazu bedienen wir uns z.B. des sog. AIC-Index (Akaike’s Information Criterion)

AIC 2 * lnMLX 2 * lnnP

worin n(P) die Anzahl der zu schätzenden Modellparameter ist.

d. Da die Likelihood eine Zahl zwischen Null und Eins ist, ist ihr Logarithmus eine Zahl

zwischen minus unendlich und Null.

e. Indem wir den Logarithmus der Likelihood mit -2 multiplizieren, wird der AIC-Index

umso kleiner, je größer die Likelihood ist (d.h. je genauer das LCA-Modell die Daten

beschreibt).

f.

Zugleich wird der AIC-Index umso kleiner, je weniger Parameter wir schätzen müssen

(d.h. je sparsamer das Modell die Daten beschreibt).

g. Die beste Beschreibung der Daten liefert daher jenes LCA-Modell, dessen AIC-Index

minimal klein ist.

h. Problem: In sehr großen Stichproben, führt der AIC-Index oft zu einer sehr großen

Anzahl von Klassen, die kaum noch interpretierbar sind.

i.

Problemlösung: Dieses Problem kann man lösen, indem man bei großen Stichproben

(Faustregel: n ≥ 1000) die Parameteranzahl stärker gewichtet und sich des sog. BICIndex (Bayes’sches Informationskriterium) bedient, der sein Minimum (oft) schon bei

einer geringeren Klassenzahl hat:

BIC 2 * lnMLX lnn * lnnP

Gewichtet wird die Parameterzahl dabei mit dem Logarithmus des

Stichprobenumfanges n.

13