Fragen

Werbung

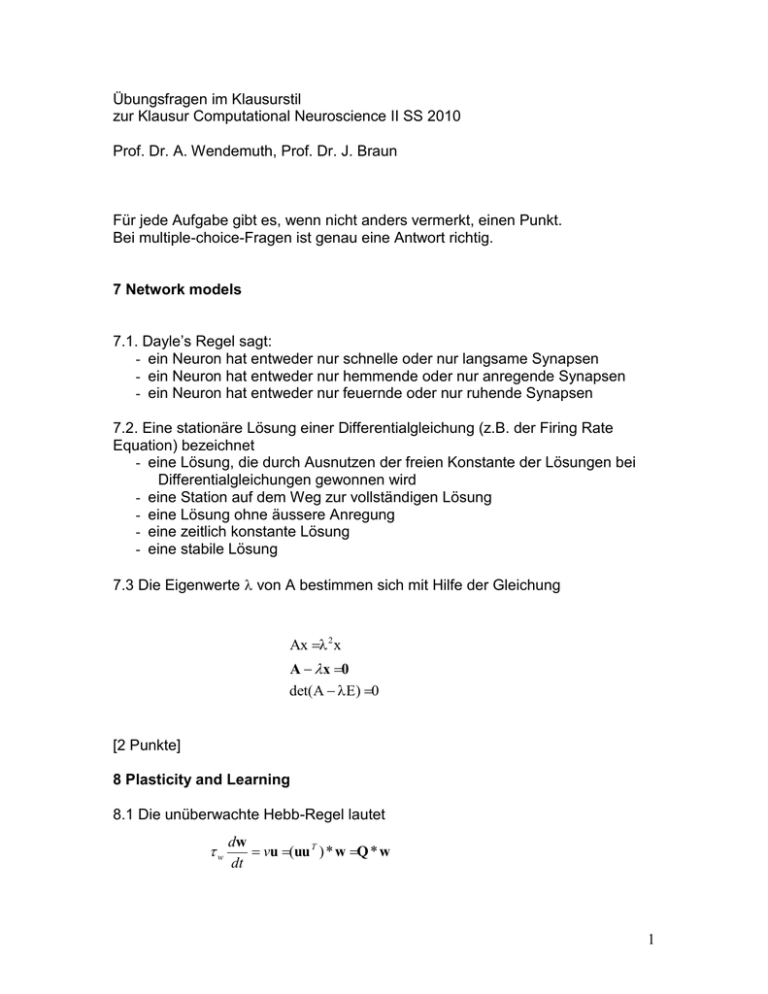

Übungsfragen im Klausurstil zur Klausur Computational Neuroscience II SS 2010 Prof. Dr. A. Wendemuth, Prof. Dr. J. Braun Für jede Aufgabe gibt es, wenn nicht anders vermerkt, einen Punkt. Bei multiple-choice-Fragen ist genau eine Antwort richtig. 7 Network models 7.1. Dayle’s Regel sagt: - ein Neuron hat entweder nur schnelle oder nur langsame Synapsen - ein Neuron hat entweder nur hemmende oder nur anregende Synapsen - ein Neuron hat entweder nur feuernde oder nur ruhende Synapsen 7.2. Eine stationäre Lösung einer Differentialgleichung (z.B. der Firing Rate Equation) bezeichnet - eine Lösung, die durch Ausnutzen der freien Konstante der Lösungen bei Differentialgleichungen gewonnen wird - eine Station auf dem Weg zur vollständigen Lösung - eine Lösung ohne äussere Anregung - eine zeitlich konstante Lösung - eine stabile Lösung 7.3 Die Eigenwerte von A bestimmen sich mit Hilfe der Gleichung Ax 2 x A x 0 det(A E) 0 [2 Punkte] 8 Plasticity and Learning 8.1 Die unüberwachte Hebb-Regel lautet w dw vu (uu T ) * w Q * w dt 1 Der Gewichtsvektor w ist nach langer Lernzeit proportional zum - Eigenvektor von Q mit dem kleinsten Eigenwert - Eigenvektor von Q mit dem grössten Eigenwert - Mittelwert der Eigenvektoren von Q - mit den Eigenwerten i gewichteten Mittelwert der Eigenvektoren ei von Q, d.h. zu e i i i 9 Conditioning and Reinforcement: Verwenden Sie die folgenden Bezeichnungen! - Stimulus u - Belohnung r - kumulierte, noch verbleibende Belohnung R (bei Temporal Difference Learning) - Gewichte w - Schätzwert (Prädiktion) für die Belohnung: v - Lernrate: - Änderung des Gewichtsvektors w 9.1 Lernen mit der Rescorla-Wagner-Regel in differentiellen Zeitschritten (mit der Lern-Zeitkonstanten w) führt zu einer Entwicklung der Gewichte gemäss r | u |2 w(t ) u u 2 a exp( t) w | u | u ist dabei ein zunächst unbekannter Vektor, der senkrecht zu u steht und der aus den Anfangsbedingungen zu ermitteln ist. a ist eine zunächst unbekannte Konstante, die ebenfalls aus den Anfangsbedingungen zu ermitteln ist. Nach sehr langer Lernzeit erhält man die Prädiktion v u * u r au r v u u 2 | u | vr v u* u r 2 10 Representational learning 10.1 Bei einem EM-Verfahren ist: - E= Estimation = Schätzung von Parametern, M = Maximization = Maximieren einer Zielfunktion - E= Estimation = Schätzung von Parametern, M = Maximization = Maximieren der Anzahl der richtigen Zuordnungen - E= Error-reduction = Reduzieren von Fehlern, M = Maximization = Maximieren einer Zielfunktion - E= Error-reduction = Reduzieren von Fehlern, M = Maximization = Maximieren der Anzahl der richtigen Zuordnungen 10.2 Ein mehrstufiges Netzwerk kann durch error backprogation trainiert werden. Dabei gilt folgende Aussage NICHT: - alle synaptischen Gewichte zwischen allen Schichten (layer) werden eingestellt - die internen Repräsentation, d.h. die Aktivitätsmuster der Neuronen in den Zwischenschichten, müssen vorgegeben werden. - Es können lange Perioden während des Lernens auftreten, während derer sich der Fehler an den Ausgängen nicht verringert. Dies kann durch Änderung der Transferfunktionen der Neuronen verbessert werden. - Der Fehler an den Ausgängen konvergiert zu einem lokalen Minimum 3