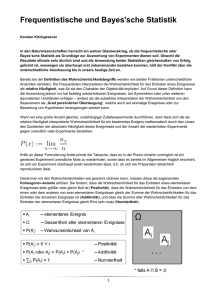

2004_2 - Stochastik in der Schule

Werbung