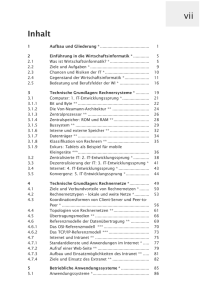

00_Oracle_DWH_Architektur_und Konzepte_Reader_Mai_2011

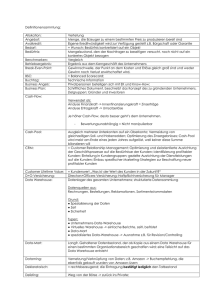

Werbung